다중 생체신호의 2D 스펙트로그램을 이용한 멀티스트림 CNN 기반 사용자 식별 시스템

초록

최근 IoT 기술이 자동차에 접목되어 스마트 카로 발전됨에 따라 스마트 카에 개인 정보가 저장되고 있다. 그러나 기존의 키를 이용한 차량 보안 방법은 분실 및 도난당하거나 복제될 수 있는 문제가 있다. 따라서 높은 보안성과 지속적인 인증으로 차량 보안을 강화할 수 있는 생체신호 기반 사용자 식별 시스템 연구가 필요하다. 본 논문에서는 다중 생체신호에 시간-주파수 분해능이 맞춤형 조정되는 CQT(Constant Q Transform)를 적용하여 다차원 특징을 추출하고, 추출된 특징을 2D 스펙트로그램으로 변환한 뒤 multi-stream CNN(Convolutional Neural Networks)을 이용한 사용자 식별 방법을 제안한다. 실험결과, 단일 심전도를 사용하였을 때 94.5%, 뇌전도 4개 채널을 사용하였을 때 92.1%의 식별 정확도를 보였으며, 다중 생체신호를 이용하였을 때 96.8%로 사용자 식별 정확도가 향상됨을 확인하였다.

Abstract

Recently, personal information is stored in the smart car as the IoT technology is grafted onto the car and developed into a smart car. However, the conventional vehicle security methods using keys have the issue of being lost, stolen, or replicated. Therefore, research on biometric-based user identification systems is needed to enhance vehicle security for high liability by continuous authentication. In this paper, multi-dimensional features are extracted by applying CQT(Constant Q Transform) with time-frequency resolution customized to multiple biosignals, and converting the extracted features into 2D spectrograms, we propose a user identification method using multi-stream CNN(Convolutional Neural Networks). In the experiment results, it was confirmed that using a ECG showed an identification accuracy of 94.5%, using four channels of EEG showed an identification accuracy of 92.1%, and using multiple biometric signals improved the user identification accuracy to 96.8%.

Keywords:

ECG, EEG, CQT, spectrogram, multi-stream CNN, user identificationⅠ. 서 론

최근 무선 센서를 통한 IoT 기술을 자동차에 접목함으로써 운전자 상태 모니터링, 인포테인먼트 조작 등과 같이 운전자에게 편리한 서비스 제공이 가능한 스마트 카로 발전되고 있다[1]-[3]. 그러나 무선 센서로부터 수집된 개인 정보가 스마트 카에 저장되면서 개인 정보 보호 및 차량 도난 예방을 위해 높은 수준의 보안이 요구되고 있다[4]. 기존의 키를 이용하여 차 문을 열고·닫는 방식은 키의 분실 및 도난 문제가 있다. 따라서 고유한 특징을 추출하여 정보화시키는 방식의 사용자 식별 기술이 적용되고 있다[5]. 그러나 지문, 얼굴 등 신체 외부에 노출되어있는 생체정보 역시 위·변조와 같은 위험에 노출되어 있기 때문에 높은 보안성과 지속적인 인증으로 보안을 강화할 수 있는 생체신호 기반 사용자 식별 연구가 필요하다[6].

생체신호는 신체 내부에서 발생하여 개인의 고유한 특징을 가지는 전기적 신호이며, 대표적으로 심전도, 근전도, 뇌전도가 있다[7]. 심전도는 심장의 수축에 따른 전기적 활동을 분석한 것으로 심장의 전기생리학적 요인과 심장의 위치, 크기, 신체적 조건에 의해 개인 고유의 특징을 나타낸다[8]. 근전도는 행동학적 특징에 의해 근육에서 발생하는 신호로 사용하는 근육에 따라 서로 다른 신호 패턴을 나타낸다. 뇌전도 신호는 신경계에서 뇌신경 사이에 신호가 전달될 때 발생하는 전기적 신호로 개인마다 고유한 신경회로망을 가지고 있어 개인의 고유한 특징을 나타낸다[9]. 특히 뇌전도 신호는 개인의 고유한 특징뿐만 아니라 개인의 감정 및 의도를 해석할 수 있는 신호로 맞춤형 서비스 제공이 가능한 장점이 있다[10]. 이러한 생체신호의 서로 다른 신호 패턴 생성과 고유한 특징을 이용하여 사용자 식별 시스템 연구가 활발히 진행되는 중이다[11].

본 논문에서는 기존 비선형 신호인 생체신호에 단차원 특징 추출 방법을 이용한 정확도 개선의 한계를 해결하기 위해 다중 생체신호에 시간-주파수 분해능이 맞춤형 조정되는 2D 특징을 추출하고 multi-stream CNN(Convolutional Neural Networks)을 이용한 사용자 식별 방법을 제안한다. 제안한 방법은 심전도와 뇌전도 신호에 포함된 불필요한 잡음을 제거한 뒤 시간-주파수 분해능이 맞춤형 조정되는 CQT(Constant Q Transform)를 적용하여 다차원 특징을 추출한다. 추출된 뇌전도 신호 각 채널(FZ, C3, PZ, C4)별 특징과 심전도 신호 특징은 2D 스펙트로그램으로 변환한 후 총 5개의 stream으로 신호별 학습이 가능한 multi-stream CNN을 통해 사용자를 식별한다. 공개된 drozy DB를 이용한 사용자 식별 정확도는 단일 심전도 또는 뇌전도 신호를 사용할 때보다 심전도와 뇌전도 신호를 모두 사용할 때 사용자 식별 정확도가 향상되는 것을 확인하였다.

Ⅱ. 관련 연구

본 장에서는 심전도와 뇌전도 신호를 이용한 사용자 식별 시스템에 적용된 기술에 대해 분석한다. 웨어러블 디바이스에서 측정된 심전도와 뇌전도 신호는 질병 인식, 감정 인식, 동작 제어 등 다양한 분야에서 활용되고 있다. 최근에는 위·변조가 어려운 뇌전도 신호를 이용하여 사용자를 식별하는 연구가 활발하게 이뤄지고 있다.

Biran 등[12]은 심전도에 STFT(Short Time Fourier Transform)와 frechet을 사용한 특징 추출 방법에 따른 사용자 식별 정확도를 확인하였다. 이 연구에서는 총 62명의 피험자로부터 취득된 심전도 신호에 STFT를 적용하여 시간-주파수 특징을 추출하고 frechet을 사용하여 해당 이미지의 평균 거리를 계산하여 사용자를 식별하였다. 심전도 신호 기반 사용자 식별 정확도가 96.4%로 Biran 등은 STFT와 frechet 방법을 이용한 사용자 식별 가능성을 확인하였다.

Yang 등[13]은 뇌전도 전극 배치 및 웨이블릿 변환 기반의 사용자 식별 시스템을 제안하였다. 제안한 방법은 109명의 피험자로부터 64채널의 전극을 사용하여 취득된 뇌전도 데이터를 사용하여 테스트되었다. 뇌전도 신호는 wavelet-log-dct를 통해 특징을 추출하였으며, LDA(Linear Discriminant Analysis)를 사용하여 사용자 식별 정확도를 확인하였다. 전극 사이의 거리가 가장 멀리 배치된 4개의 전극(FPZ - T9 - T10 - IZ)을 사용하였을 때 98.24%로 가장 높은 사용자 식별 정확도를 보였다. Yang 등은 웨이블릿 특징을 기반으로 원거리 전극 채널을 사용하였을 때 뇌전도 기반 사용자 식별 정확도가 향상됨을 확인하였다.

Bashar 등[14]은 저비용 웨어러블 디바이스 장비를 이용한 다중생체 식별 방법을 제안하였다. 제안한 방법은 10명의 피험자로부터 심전도와 뇌전도 신호를 취득하고 취득된 데이터는 대역통과 필터를 사용하여 전처리를 진행한다. 특징추출 방법으로는 WPS(Wavelet Packet Statistics)를 사용하여 시간-주파수 특징을 추출한 뒤 SVM(Support Vector Machine)을 통해 사용자 식별 정확도를 확인하였다. 단일 심전도 신호를 이용하였을 때 54.8%, 뇌전도 단일 채널(AF3)을 사용하였을 때 69%의 사용자 식별 정확도를 보였으며, 심전도-뇌전도를 모두 사용하였을 때 85.3%로 Bashar 등은 다중 생체신호를 사용하였을 때 사용자 식별 정확도가 향상됨을 확인하였다.

기존의 심전도와 뇌전도 신호 기반 사용자 식별 연구는 FFT(Fast Fourier Transform)를 사용한 주파수 대역에 따른 특징을 추출한다[15]. 그러나 시간에 대한 연속성이 고려되지 않는 단점을 가지고 있어 시간 흐름에 따른 주파수 분석이 가능한 특징 추출 방법을 이용한 연구가 활발하게 이뤄지고 있다. STFT는 윈도우 길이를 정하여 구간을 나누고 각각 푸리에 변환하여 특징을 추출한다. 구간별 주파수 성분을 분석하기 때문에 시간의 흐름에 따라 변하는 근전도 신호에 적합한 특징 분석이 가능하다[16][17]. CQT는 대역폭이 중심 주파수와 비례적으로 바뀌면서 낮은 주파수에서는 넓은 대역폭, 높은 주파수에서는 좁은 대역폭으로 분석하여 특징을 추출한다. 따라서 낮은 주파수 영역에서는 주파수 해상도, 높은 주파수 영역에서는 시간 해상도가 향상되는 장점이 있다[18]. FFT, STFT, CQT의 수식은 다음 표 1과 같다.

Ⅲ. 제안하는 다중 생체신호 기반 사용자 식별 시스템

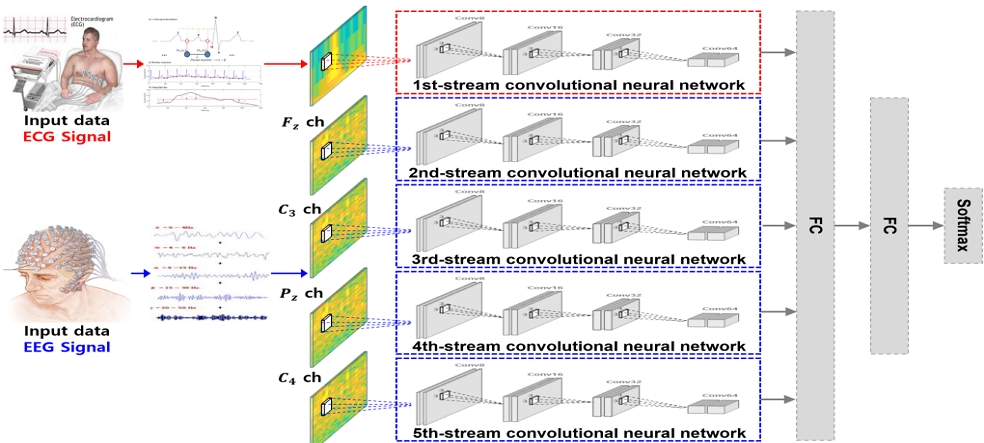

본 논문에서 제안하는 다중 생체신호 기반 시간-주파수 특징 추출 방법 및 multi-stream CNN을 이용한 사용자 식별 방법은 그림 1과 같다. 전처리 과정으로 심전도와 뇌전도 신호에 포함된 잡음은 필터링을 통해 제거한다. 전처리를 마친 심전도와 뇌전도 신호는 시간-주파수 분해능이 신호에 맞춤형 조정되는 CQT를 이용하여 다차원 특징을 추출하고 2D 스펙트로그램으로 변환한다. 변환된 2D 이미지는 multi-stream CNN의 입력 데이터로 사용하며 학습을 통해 사용자를 식별한다.

3.1 시간-주파수 다차원 특징을 이용한 다중 생체신호 특징 추출

심전도 및 뇌전도 신호는 전력선 및 대역 제한을 통한 잡음 제거 후 표 1의 CQT 수식을 적용하여 다차원 특징을 추출한다. CQT는 기존의 STFT의 단점을 보완한 방법으로 대역폭이 중심 주파수와 비례적으로 바뀌면서 시간-주파수 분해능이 quality factor 상수로 신호에 맞춤형 조정되는 장점이 있다.

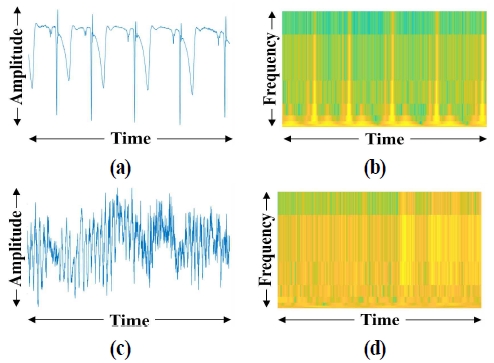

표 1의 CQT 수식에서 k는 주파수 빈 인덱스, l은 시간 프레임 인덱스, ω는 Nk크기의 윈도우 분석, M은 프레임 이동 단계이며 Q는 중심 주파수와 주파수 대역의 비율로 계산되는 상수로, 각 주파수 대역의 크기를 통해 해상도를 조절하는 상수이다. 심전도와 뇌전도 신호에 CQT를 적용하여 시간-주파수 특징을 추출하고 2D 스펙트로그램으로 변환하면 그림 2와 같다.

3.2 다중 생체신호 기반 사용자 식별을 위해 설계된 multi-stream CNN

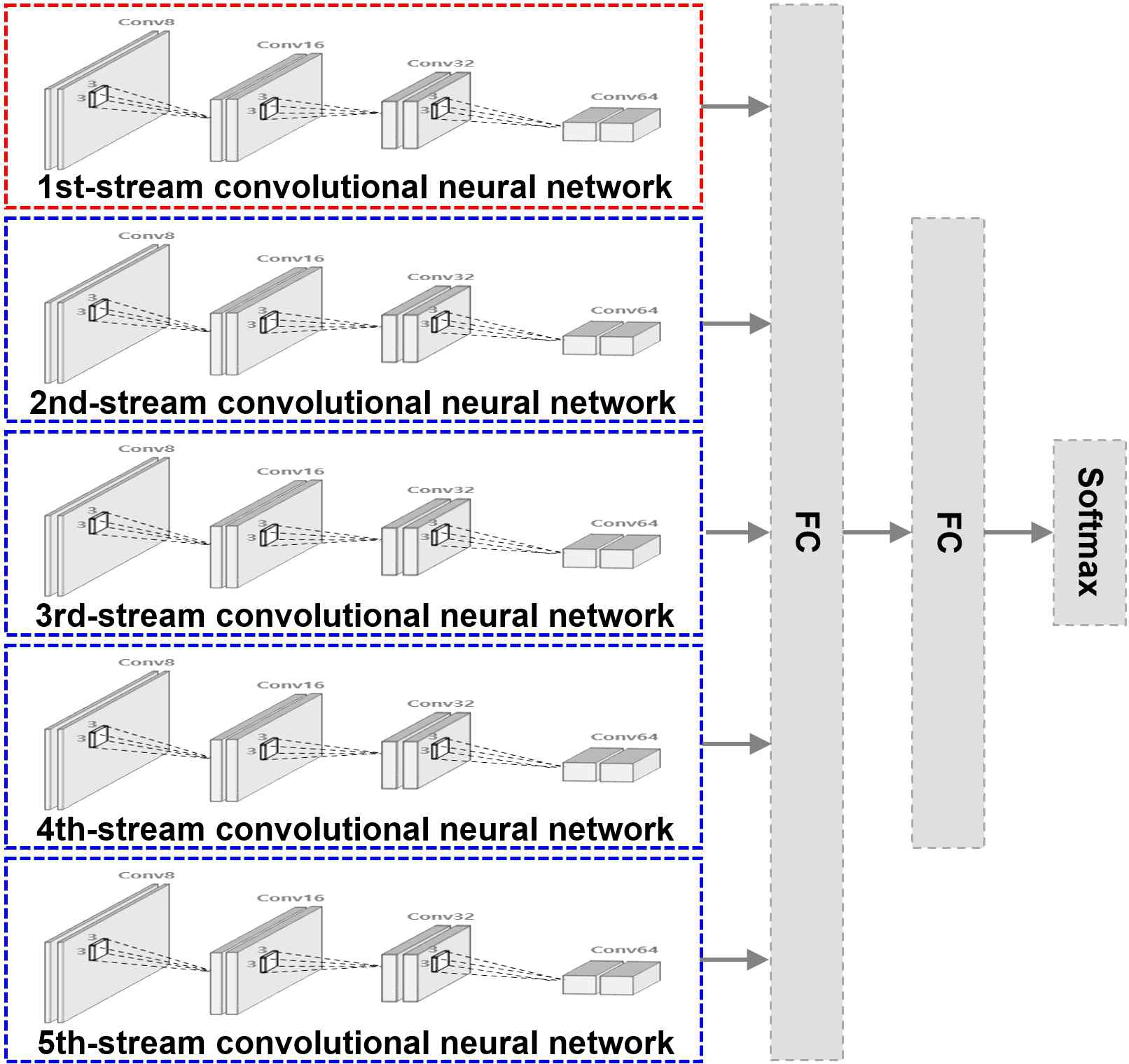

본 논문에서는 다중 생체신호를 이용한 사용자 식별을 위한 방법으로 이미지 입력 기반 딥러닝 방식의 multi-stream CNN을 사용했다. 시간-주파수 특징 기반 2D 스펙트로그램을 입력으로 사용하였으며, 전체적인 네트워크 구조는 그림 3과 같이 구성된다.

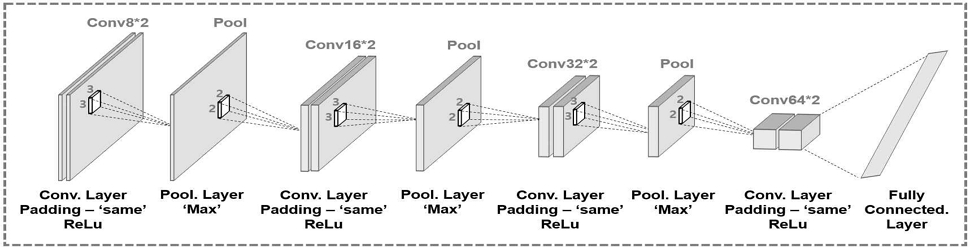

Multi-stream CNN은 총 5개의 stream으로 심전도 신호 학습을 위해 1개의 stream, 4개의 뇌전도 채널을 각각 학습하기 위해 4개의 stream으로 구성했다. 심전도와 뇌전도 신호 학습을 위한 각 stream은 그림 4와 같이 모두 동일하게 구성하였으며, 8개의 컨벌루션 층과 3개의 맥스 풀링 층, 1개의 완전연결 층과 활성함수는 ReLU(rectified linear unit)로 구성하였으며 컨벌루션 층 필터 크기는 3×3으로 설정하고, 풀링 층의 필터 크기는 2×2로 스트라이드는 2로 설정했다.

가중치는 뇌전도 4개 채널과 비례하게 심전도 신호의 가중치를 설정하고 최종적으로는 소프트맥스에 의해 출력층에서 사용자가 식별된다.

Ⅳ. 실험 방법 및 결과

본 논문에서 제안하는 multi-stream CNN 기반 다중 생체신호를 이용한 사용자 식별 시스템의 정확도를 평가하기 위해 심전도와 뇌전도 데이터는 공개된 drozy DB를 사용하였다. 피험자는 총 14명으로 10분 동안 모니터를 응시하여 데이터를 구성했다. 취득한 심전도와 뇌전도 샘플링은 512Hz로 채널은 심전도와 뇌전도 4개 채널(FZ, C3, PZ, C4)을 사용하여 총 5채널로 취득하였다[19]. 각 신호는 60Hz의 전력선 잡음을 제거하기 위해 노치 필터를 적용하였으며, 뇌전도 신호에는 0-250Hz 대역의 밴드패스 필터를 적용하였다.

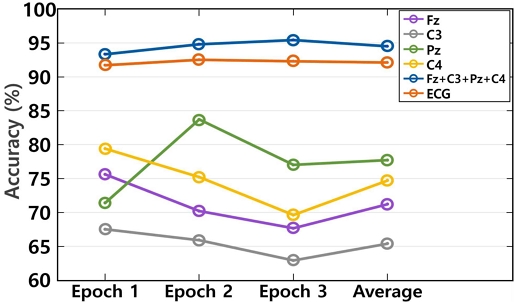

본 논문에서는 심전도와 뇌전도 신호를 각각 2D 이미지로 변환하여 사용자 식별 정확도를 확인한 후 다중 생체신호를 이용한 사용자 식별 정확도를 비교하였다. 실험결과 그림 5와 같이 심전도 신호를 CQT 기반 2D 스펙트로그램으로 변환하였을 때 사용자 식별 정확도는 94.5%로 확인했다. 뇌전도 단일 채널별 평균 정확도는 72.2%이며 2nd-stream, 3rd-stream, 4th-stream, 5th-stream의 4개 CNN을 사용하여 뇌전도 모든 채널을 사용하였을 때 사용자 식별 정확도는 92.1%로 단일 채널을 사용한 것에 비해 19.9% 정확도가 향상되었다.

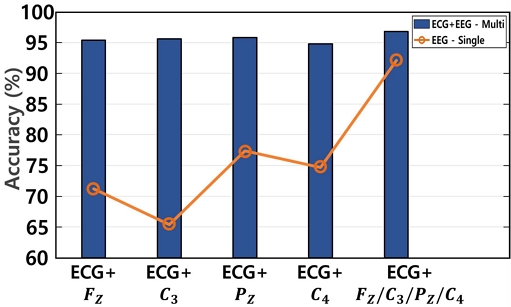

그림 6은 다중 생체신호를 이용한 사용자 식별 정확도를 비교한 그래프이다. 2개의 stream으로 구성한 CNN을 사용하여 심전도와 뇌전도 단일 채널을 입력으로 사용하였을 때 평균 사용자 식별 정확도는 95.4%를 보였다. 5개의 stream을 모두 사용한 CNN을 통해 심전도와 뇌전도 모든 채널을 입력으로 사용하였을 때 사용자 식별 정확도는 96.8%로 가장 우수한 것으로 확인하였다.

표 2는 논문에서 제안한 사용자 식별 방법과 기존 연구의 비교 실험 결과를 나타낸다. Stantos 등[20]은 5명으로부터 취득된 심전도 신호에 Random Forest를 이용하여 95.8%의 사용자 식별 정확도를 보였다. Ma 등[21]은 10명의 피험자로부터 취득된 뇌전도 신호에 CNN을 이용하여 88%의 사용자 식별 정확도를 보였다. Bashar 등[14]은 10명의 피험자로부터 취득된 다중 생체신호에 WPS을 이용하여 시간-주파수 특징을 추출하고 ESVM을 이용하였을 때 85.4%의 사용자 식별 정확도를 보였다.

본 논문에서 제안하는 다중 생체신호 기반 사용자 식별 정확도는 96.8%로 시간-주파수 분해능이 맞춤형 조정되는 다차원 특징 추출 방법 및 각 신호에 따른 학습이 가능한 multi-stream CNN을 통해 사용자 식별 정확도를 개선하였다.

Ⅴ. 결론 및 향후 과제

본 논문에서는 심전도와 뇌전도 다중 생체신호에서 시간-주파수 분해능이 맞춤형 조정되는 CQT를 적용하여 다차원 특징을 추출하고 2D 스펙트로그램으로 변환한 뒤 multi-stream CNN을 통해 사용자를 식별하는 시스템을 제안하였다.

실험결과, multi-stream CNN 기반 다중 생체신호를 이용한 사용자 식별 정확도는 96.8%로 단일 신호를 이용한 사용자 식별 정확도에 비해 2.3% 이상 정확도가 향상되었다. 또한 기존 사용자 식별 연구와 정확도 성능을 비교한 결과 1% 이상 향상되었으며, 다중 생체신호를 사용할 때 사용자 식별 정확도가 향상되는 것을 확인하였다. 향후에는 웨어러블 디바이스를 통해 다중 생체신호를 직접 취득하여 데이터를 구축한 후 다중 생체신호 기반 사용자 식별 시스템을 연구할 계획이다.

Acknowledgments

이 논문은 2017년도 정부(교육부)의 재원으로 한국연구재단의 기초연구사업(No. NRF-2017R1A6A1A03015496)과 2021년도 정부(과학기술정보통신부)의 재원으로 한국연구재단 (No. NRF-2021R1A2C1014033)의 지원을 받아 수행된 연구임.

References

-

Q. Xu, B. Wang, F. Zhang, D. S. Regani, F. Wang, and K. J. R. Liu, "Wireless AI in smart car: how smart a car can be?", IEEE Access, Vol. 8, pp. 55091-55112, Mar. 2020.

[https://doi.org/10.1109/ACCESS.2020.2978531]

-

S. K. Bhoi, P. K. Sahu, M. Singh, P. M. Khilar, R. R. Sahoo, and R. R. Swain, "Local traffic aware unicast routing scheme for connected car system", IEEE Transactions on Intelligent Transportation Systems, Vol. 21, No. 6, pp. 2360-2375, Jun. 2020.

[https://doi.org/10.1109/TITS.2019.2918161]

-

G. H. Choi, K. H. Lim, and S. B. Pan, "Driver Identification System Using 2D ECG and EMG Based on Multistream CNN for Intelligent Vehicle", IEEE Sensors Letters, Vol. 6, No. 6, pp. 1-4, Jun. 2022.

[https://doi.org/10.1109/LSENS.2022.3175787]

-

C. H. Yang, D. Liang, and C. C. Chang, "A novel driver identification method using wearables", 2016 13th IEEE Annual Consumer Communications & Networking Conference, Las Vegas, NV, USA, pp. 1-5, Jan. 2016.

[https://doi.org/10.1109/CCNC.2016.7444722]

-

G. H. Choi, K. Lim, and S. B. Pan, "Driver identification system using normalized electrocardiogram based on adaptive threshold filter for intelligent vehicles", Sensors, Vol. 21, No. 1, pp. 1-17, Dec. 2020.

[https://doi.org/10.3390/s21010202]

-

D. H. Lim, "Personal authentication system using multimodal biometric algorithm", Journal of Korean Institute of Information Technology, Vol. 15, No. 12, pp. 147-156, Dec. 2017.

[https://doi.org/10.14801/jkiit.2017.15.12.147]

-

R. D. Luis-Garcia, C. Alberola-Lopez, O. Aghzout, and J. Ruiz-Alzola, "Biometric identification systems", Signal Processing, Vol. 83, No. 12, pp. 2539-2557, Dec. 2003.

[https://doi.org/10.1016/j.sigpro.2003.08.001]

-

G. H. Choi, E. S. Bak, and S. B. Pan, "User identification system using 2D resized spectrogram features of ECG", IEEE Access, Vol. 7, pp. 34862-34873, Mar. 2019.

[https://doi.org/10.1109/ACCESS.2019.2902870]

-

K. P. Thomas and A. P. Vinod, "Utilizing individual alpha frequency and delta band power in EEG based biometric recognition", 2016 IEEE International Conference on Systems, Man, and Cybernetics, Budapest, Hungary, pp. 4787-4791, Feb. 2016.

[https://doi.org/10.1109/SMC.2016.7844987]

-

A. Bellotti, S. Antopolskiy, A. Marchenkova, A. Colucciello, P. Avanzini, G. Vecchiato, J. A. Madsen, and L. Ascari, "Brain-based control of car infotainment", 2019 IEEE International Conference on Systems, Man and Cybernetics (SMC), Bari, Italy, pp. 2166-2173, Oct. 2019.

[https://doi.org/10.1109/SMC.2019.8914448]

-

J. M. Kim, M. G. Kim, and S. B. Pan, "Study on noise reduction and data generation for sEMG spectrogram based user recognition", Applied Sciences, Vol. 12, No. 14, pp. 7276, Jul. 2022.

[https://doi.org/10.3390/app12147276]

-

A. Biran and A. Jeremic, "Non-segmented ECG bio-identification using short time fourier transform and frechet mean distance", 2020 42nd Annual International Conference of the IEEE Engineering in Medicine & Biology Society, Montreal, QC, Canada, pp. 5506-5509, Jul. 2020.

[https://doi.org/10.1109/EMBC44109.2020.9176325]

-

S. Yang, S. Hoque, and F. Deravi, "Improved time-frequency features and electrode placement for EEG-based biometric person recognition", IEEE Access, Vol. 7, pp. 49604-49613, Apr. 2019.

[https://doi.org/10.1109/ACCESS.2019.2910752]

-

K. Bashar, "ECG and EEG based multimodal biometrics for human identification", 2018 IEEE International Conference on Systems, Man, and Cybernetics, Miyazaki, Japan, pp. 4345-4350, Oct. 2018.

[https://doi.org/10.1109/SMC.2018.00734]

-

D. D. Jayasree, "Classification of power quality disturbance signals using FFT, STFT, wavelet transforms and neural networks - a comparative analysis", International Conference on Computational Intelligence and Multimedia Applications, Sivakasi, India, pp. 335-340, Dec. 2007.

[https://doi.org/10.1109/ICCIMA.2007.279]

-

T. H. Shovon, Z. A. Nazi, S. Dash, and M. F. Hossain, "Classification of motor imagery EEG signals with multi-input convolutional neural network by augmenting STFT", 2019 5th International Conference on Advances in Electrical Engineering, pp. 398-403, Jan. 2019.

[https://doi.org/10.1109/ICAEE48663.2019.8975578]

-

J. M. Kim, G. H. Choi, M. G. Kim, and S. B. Pan, "User recognition system based on spectrogram image conversion using EMG signals", Computers, Materials & Continua, Vol. 72, No. 1, pp. 1213-1227, Feb. 2022.

[https://doi.org/10.32604/cmc.2022.025213]

-

H. Bo, H. Li, L. Ma, and B. Yu, "A constant Q transform based approach for robust EEG spectral analysis", 2014 International Conference on Audio, Language and Image Processing, Shanghai, China, pp. 58-63, Jan. 2014.

[https://doi.org/10.1109/ICALIP.2014.7009757]

-

Q. Massoz, T. Langohr, C. Francois, and J. G. Verly, "The ULg multimodality drowsiness database (called DROZY) and examples of use", 2016 IEEE Winter Conference on Applications of Computer Vision, Lake Placid, NY, USA, pp. 1-7, Mar. 2016.

[https://doi.org/10.1109/WACV.2016.7477715]

-

A. Santos, I. Medeiros, P. Resque, D. D. Rosario, M. Nogueira, A. Santos, E. Cerqueira, and K. R. Chowdhury, "ECG-based user authentication and identification method on vanets", Proc. of the 10th Latin America Networking Conference, pp. 119-122, Oct. 2018.

[https://doi.org/10.1145/3277103.3277138]

-

L. Ma, J. W. Minett, T. Blu, and W. S. Y. Wang, "Resting State EEG-based biometrics for individual identification using convolutional neural networks", 2015 37th Annual International Conference of the IEEE Engineering in Medicine and Biology Society, Milan, Italy, pp. 2848-2851, Nov. 2015.

[https://doi.org/10.1109/EMBC.2015.7318985]

2019년 2월 : 조선대학교 전자공학과(공학사)

2021년 2월 : 조선대학교 전자공학과(공학석사)

2021년 3월 ~ 현재 : 조선대학교 전자공학과 박사수료

관심분야 : 영상처리, 바이오인식

2016년 2월 : 조선대학교 제어계측공학과(공학사)

2018년 2월 : 조선대학교 제어계측공학과(공학석사)

2022년 8월 : 조선대학교 제어계측공학과(공학박사)

2022년 9월 ~ 현재 : 조선대학교 IT연구소 연구원

관심분야 : 임베디드 시스템, 영상처리, 바이오인식

1999년 2월 : 서강대학교 전자공학과(공학사)

2005년 2월 : 한국전자통신연구원 정보보호연구단 생체인식기술 연구팀 팀장

2005년 3월 ~ 현재 : 조선대학교 전자공학과 교수

관심분야 : 영상처리, 바이오인식, VLSI 신호처리