| Home | JKIIT Archives | About the JKIIT | E-SUBMISSON |

Sorry.

You are not permitted to access the full text of articles.

If you have any questions about permissions,

please contact the Society.

죄송합니다.

회원님은 논문 이용 권한이 없습니다.

권한 관련 문의는 학회로 부탁 드립니다.

| [ Article ] | |

| The Journal of Korean Institute of Information Technology - Vol. 22, No. 11, pp. 71-78 | |

| Abbreviation: Journal of KIIT | |

| ISSN: 1598-8619 (Print) 2093-7571 (Online) | |

| Print publication date 30 Nov 2024 | |

| Received 04 Oct 2024 Revised 28 Oct 2024 Accepted 31 Oct 2024 | |

| DOI: https://doi.org/10.14801/jkiit.2024.22.11.71 | |

| 수중 HUD 콘텐츠 평가를 위한 가상 현실 시뮬레이터 설계 | |

이석원*  ; 김미진**

; 김미진** ; 정성오**

; 정성오** ; 강창구***

; 강창구***

| |

| *강릉원주대학교 멀티미디어공학과 교수 | |

| **한국전자기술연구원 VRAR연구센터 연구원 | |

| ***경상국립대학교 컴퓨터공학과 교수(교신저자) | |

Deep-Sea VR Simulator Design for Evaluating HUD Contents | |

Sukwon Lee*  ; Meejin Kim**

; Meejin Kim** ; Sung-Oh Jung**

; Sung-Oh Jung** ; Changgu Kang***

; Changgu Kang***

| |

| Correspondence to : Changgu Kang Dept. of Computer Science and Engineering, Gyeongsang National University, Korea Tel.: +82-55-772-3321, Email: cgk@gnu.ac.kr | |

Funding Information ▼ | |

초록

산업에서 투시형 헤드업 디스플레이(See-thourgh head-up display)는 작업자에게 직관적인 정보 전달을 통해 작업 효율을 높이고 상황에 대한 주의를 주어 안전을 도모하는 역할을 하고 있다. 이러한 HUD의 장점을 수중 작업에도 도입하려는 연구가 진행되고 있다. 하지만 아직 수중 HUD 콘텐츠의 형태 적절성에 관해서는 많은 연구가 이루어지지 않았는데, 이는 수중 실험이 큰 비용을 발생시키기 때문이다. 본 논문에서는 가상현실을 이용하여 물속 환경을 구현하고, 이 위에 가상의 see-through HUD를 배치함으로써 수중 HUD 콘텐츠를 경험해 볼 수 있는 시스템을 제안한다. 이를 통해 사용자가 물 밖에서도 수중 HUD의 콘텐츠 적절성 평가를 할 수 있게 하였다. 우리는 본 논문을 통해 전체 시스템에 대한 구현 방법과 각 구성요소들을 제안하였다.

AbstractIn the industry, see-through HUD(Head-up Display) plays a role in increasing work efficiency and safety by delivering intuitive information to operators. Some researches has tried to apply the advantages of HUDs for underwater work. However, HUD content forms for underwater environments have not been researched for deliverability and effectiveness as conducting experiments underwater incurs significant costs. In this paper, we propose a system that allows users to experience underwater HUD content by using the virtual reality simulator that simulate underwater environments and overlays of HUD. This enables users to evaluate HUD content at a lower cost by experiencing it outside of water. We propose the implementation method for the entire system and its individual components.

| Keywords: head-up display, underwater, diver, user experience, virtual reality |

|

현재 헤드업 디스플레이(HUD, Head-up Display)를 통한 정보 증강은 여러 산업에 분야에서 생산 효율을 상승시키는 역할을 하고 있다[1]-[3]. 특히 증강현실(AR, Augmented Reality)을 이용하여 메뉴얼 증강, 도시정보 시각화 등 많은 분야에 적용되고 있다[4]-[6]. 이와 같은 기술은 HUD에 정보를 시각화함으로써 사용자에게 필요 정보를 즉시 제공하여 업무의 효율성을 높인다. 또한 실시간 정보 제공은 사용자에게 위험한 환경에서 즉각적으로 상황을 파악할 수 있는 장점이 있다. 이 중 잠수사의 수중 임무 환경은 시야 거리가 매우 짧고 착용한 잠수복에 의해 행동이 제약된다. 또한 항상 위험한 환경에 노출되어 있으므로 잠수사들에게 임무나 생명에 필수적인 정보를 직관적으로 전달하는 것은 중요하다. 이를 위해 투과율이 높은 투시형(See-through) HUD를 이용하여 정보를 전달하는 연구가 진행되었고, 제품으로 개발되어 사용되고 있다.

이러한 환경에서 직관적으로 정보를 전달하기 위해서는 HUD에 증강되는 정보가 적절하게 표출되는 방법이 중요하며 이와 관련하여 많은 연구가 진행되어 왔다. David는 정보 전달 시 사용자의 인지적인 측면을 고려한 정보 제공 방법에 대한 연구를 진행하였다[7]. 이 연구에 따르면 복잡한 정보의 표출은 사용자의 인식이나 작업 효율성을 저해하므로, 정보 표출시 그 정보를 받아들이는 사용자의 측면이 고려되어야 한다. 이를 위해서는 제시되는 콘텐츠의 형태를 미리 구현하여 사용자 실험을 거쳐 가장 적절한 형태를 구해야 한다. 하지만 수중 HUD 실험은 환경을 재현하기 어려우므로 실험이 매우 제한되므로 이를 해결하기 위해선 가상 현실에서 수중 환경을 구성하고 콘텐츠 형태를 실험하는 방법이 더 현실적일 것이다.

본 연구에서는 수중 환경에서 증강 가시화를 수행하는 HUD를 가상적으로 모사하는 시뮬레이터(수중 HUD 시뮬레이터)를 만들고 이를 통해 사용자가 체험함으로써 정보 형태 적절성을 평가할 수 있는 시스템을 제안한다. 이 시스템은 수중 환경을 모사하는 환경 시뮬레이터와 잠수사 헬멧에 장착된 HUD를 모사하는 HUD 시뮬레이터, HUD에 표시될 콘텐츠를 제작하고 전송하는 콘텐츠 저작기로 구성되어 있다. 각각의 기능을 설계하고 개발함으로써 수중 HUD 시뮬레이터를 이용한 사용자의 평가를 수행할 수 있게 하였다.

2장에서는 수중 HUD와 사용자 경험(UX, User Experience)을 평가하는 관련 연구를 소개하고 3장에서는 시스템의 구성과 3개의 기능의 상세한 설명을 한다. 또한 이를 구현한 결과를 바탕으로 분석을 진행하고 마지막 4장에서 결론을 짓는다.

증강 및 가상현실기술을 이용하여 몰입감 있는 수중 환경을 재현하는 연구들이 있다. 일반적으로 잠수사는 물속에서 잘 헤치고 나갈 수 있도록 이동 방향과 몸의 방향을 일치시키는 자세를 취한다. Jain은 이러한 자세를 체험자가 취하도록 하여 수중 가상현실 환경에서의 몰입감을 높이는 연구를 진행하였다[8]. 이 연구에서는 사람을 지지할 수 있는 구조물을 만들고 그곳에 팔과 다리를 묶어 공중에 가로로 눕는 자세를 만들었다. 또한 가슴을 지지해 줌과 동시에 부력을 느낄 수 있는 장치를 설치하여 가상 현실 수영 콘텐츠의 몰입감을 상승시켰다.

이 연구는 사용자가 공기 중에서 자세를 잡아 몰입감을 증대시켰다면 이와 다르게, Yamashita는 직접 물속에서 가상 현실을 체험하는 연구를 진행하였다[9]. 이 연구에서는 사각형의 수조를 만들고 안에 물을 채워 사용자가 실제 물에서 가상 현실(VR, Virtual Reality)을 경험하도록 했다. 이러한 환경은 CAVE(Cave Automatic Virtual Environment) 형태의 수조를 만든 것으로 반투명한 수조 외부에 프로젝터를 이용하여 사용자의 눈의 위치에 따라 적절한 가상 콘텐츠를 출력하여 주었다. 눈의 위치를 추적하기 위해 사용자는 동기화된 셔터를 가진 수경과 사용자 머리 위치를 추적하기 위한 마커가 붙은 수영모를 사용하였다. 수조에 설치된 위치 추적 카메라를 이용하여 사용자의 눈 위치를 추적하고 이에 맞춰 생성된 콘텐츠를 프로젝터 빔으로 수조에 투영하였다. 이러한 장치로 체험자는 가상 콘텐츠를 경험하면서도 실제 물에서 수영하는 느낌을 받을 수 있었다.

이와 유사한 연구로 Hatsushika도 실제 물속에서 콘텐츠를 경험하게 하였지만 CAVE 형태가 아닌 헤드 마운트 디스플레이(HMD, Head Mounted Display)를 착용하여 완전한 가상 현실을 경험할 수 있게 하였다[10]. 이 연구에서는 잠수 훈련을 위해 산소 호흡기와 방수 처리된 수중 연결 헤드 마운트 디스플레이(UWHMD, Underwater Wired HMD)를 사용하여 물속에서도 완전 몰입형 가상 현실을 체험할 수 있게 하였다. 이전 연구와는 다르게 공간이 제한된 수조보다 넓은 수영장 형태의 장소도 적용 가능하다는 장점이 있다.

하지만 이러한 연구들은 수중에서 체험하기 위해서 특수한 하드웨어가 필요하다는 단점이 있다. 이와 다르게 Plecher는 가상 현실 기술을 이용해 수중 문화유산(UCH, Underwater Cultural Heritage)을 시뮬레이션하고, 사용자가 집이나 박물관에서 다이빙을 체험할 수 있게 하였다[11]. 이 연구의 콘텐츠는 크로아티아의 벨리키 피루지(Veliki Piruzi) 인근에서 발견된 5세기 로마 상선의 난파선 탐사를 중심으로 한다. 이 연구의 장점은 모듈식 구조를 통해 다른 발굴 현장에도 쉽게 적용할 수 있도록 한다.

증강 및 가상현실 기술을 이용한 수중 환경 관련된 연구들은 현실감 있는 재현으로 수중 환경에서의 훈련 또는 체험에 목적을 두고 있다. 하지만 산업 잠수사들의 수중 작업 환경은 시야 거리가 매우 짧고 부유물들에 의한 위험한 환경에 노출되는 경우가 많으므로 이를 고려하여야 한다. 본 연구에서는 이러한 환경과 유사한 시뮬레이션 환경을 구축하고 HUD를 이용한 정보 전달 기능을 구현함으로써 수중 환경에서의 증강 가시화 시뮬레이션 시스템을 개발한다.

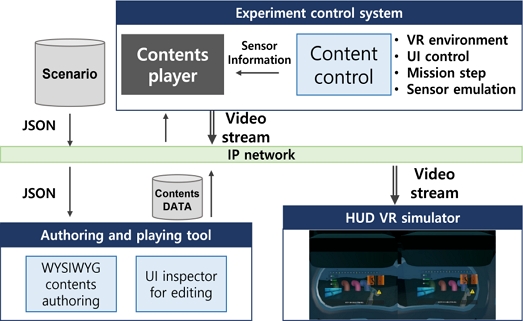

본 연구는 수중 HUD 시뮬레이터의 시스템 설계를 제안하는 것으로 해당 시스템은 HUD에 표시될 콘텐츠의 사용자 경험 평가를 위한 것이다. 이를 위해 수중 HUD 시뮬레이터를 구성하는 주요 요소는 3개이다. 첫 번째 구성요소는 표출할 콘텐츠를 생성하는 콘텐츠 저작도구로 HUD에 표출될 콘텐츠를 설계된 사용자 인터페이스(UI, User Interface)형태에 맞춰 저작하고 결과를 HUD 시뮬레이터로 전송할 수 있다. 여기에서 생성된 콘텐츠는 두 번째 구성요소인 HUD VR 시뮬레이터로 전송되어 사용자에게 표출된다. 마지막 요소로 HUD VR 시뮬레이터의 콘텐츠 표출을 제어하면서 동시에 사용자의 분석 데이터를 취득하는 실험 통제기로 구성되어 있다. 그림 1과 같이 세분화된 구성요소는 VR 시뮬레이터 환경과 실제 HUD 적용 환경간의 전환을 단순화한다. 다음 각 절에서 구성요소에 대해 상세히 기술한다.

Fig. 1.

Diagram of the deep-sea HUD simulator

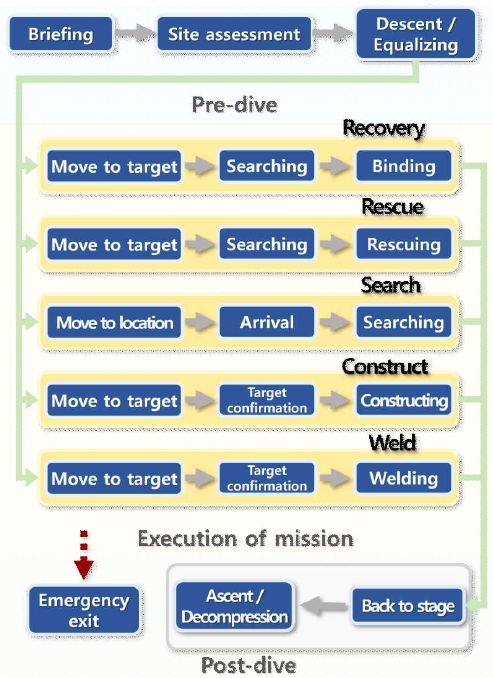

콘텐츠 저작도구는 그래픽 사용자 인터페이스(GUI, Graphical User Interface)를 통하여 수중 HUD에 표현될 콘텐츠를 제작한다. 사용자는 해당 도구를 이용해 수중 HUD 전용 콘텐츠를 작성하며 사용 편의성을 높이기 위해 위지윅(WYSIWYG, What You See Is What You Get) 방식을 도입하였다. 구현하는 콘텐츠는 저작도구에서 제시되는 UI를 이용하여 작성되므로 그 형태가 일정하다. 또한 제공 UI는 실험을 통해 구성된 최적의 형태이므로 생성된 콘텐츠의 품질을 높일 수 있다. 특히 수중 HUD를 사용할 잠수사의 대표적 임무는 몇 가지의 분류될 수 있기 때문에 이를 위한 최적 UI를 구성하는 것은 적합하다. 잠수사들의 대표 임무로 인양, 구조, 탐색, 가설, 용접 5개를 선택하였다. 각 임무는 수행하기 위한 몇 가지 단계로 구성되어 있으며 그 내용은 그림 2와 같다.

Fig. 2.

Examples of the underwater work and its steps

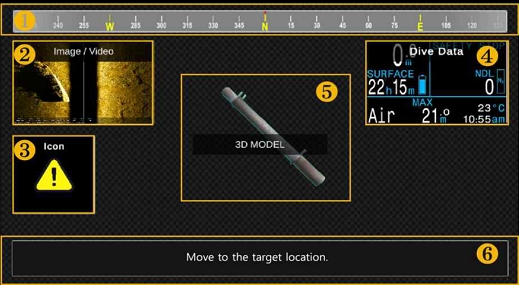

그림 3은 콘텐츠 저작도구를 나타낸 것으로 표시된 번호들은 저작도구의 화면 요소들을 기능에 따라 나누어 놓은 것이다.

Fig. 3.

Underwater work instruction authoring tool

임무 목록(그림 3의 ❶)의 경우 사전 작성된 임무 리스트로 해당 임무를 선택하면 미리 구성된 상세 단계가 단계 목록(그림 3의 ❸)에 출력되게 된다. 사용자는 기존 설정된 단계를 이용할 수도 있으며 새롭게 작성할 수도 있다. 임무 세부 정보 창(그림 3의 ❷)에서는 임무의 설명을 작성하여 이해를 돕고 있다. 사용자가 사용할 UI 요소를 UI요소 창(그림 3의 ❺)에서 선택하여 캔버스 창(그림 3의 ❹)으로 배치하는데, 이때 끌어놓기(Drag and drop) 방식을 이용한다. 저작도구에서 제공되는 UI는 텍스트, 이미지와 영상으로 구성되어 있으며 이를 조합하여 잠수 정보, 지시/긴급 메시지, 나침반, 긴급 아이콘, 2D 이미지/영상, 3D 영상 등의 복잡한 UI 요소를 구성하였다. 만약 UI의 세부 사항을 변경해야 한다면 세부 정보 창(그림 3의 ❻)에서 글자의 크기나 색을 변경할 수 있다. UI 요소가 배치된 캔버스 창의 모습은 최종 HUD에 출력될 모습과 동일한 것으로 그의 형태는 미리보기 창(그림 3의 ❼)에서 확인해 볼 수 있다. 캔버스 창에 UI를 배치한 예시는 그림 4와 같다.

Fig. 4.

Example of UI placement for the canvas window

배치된 UI 요소 중 나침반(그림 4의 ❶)은 HUD의 헬멧의 방위를 나타내어 시야 확보가 어려운 환경에서 방향을 잡는 것에 도움을 준다. 또한 2D 이미지, 영상(그림 4의 ❷)은 사용자의 이해를 돕기 위해 작업 참고 영상이나 작업 지시를 직접 보여준다. 긴급 아이콘(그림 4의 ❸)은 사용자에게 위험한 상황, 예를 들어 공급 공기에 문제가 생기거나 임무가 취소되었을 때, 아이콘 형태로 표현하여 주의를 환기하도록 하였다. 잠수 정보(그림 4의 ❹)는 잠수 시 필수적으로 제공되어야 할 정보(수온, 잠수 시간, 현 시간, 수심, 공기 관련 정보 등)를 HUD에 제공한다. 3D 영상(그림 4의 ❺)은 사용자의 이해를 높이기 위해 작업물의 형태를 3D로 표현한다. 지시/긴급 메시지(그림 4의 ❻)는 사용자에게 지시할 내용을 문자 형태로 전달하여 준다.

이러한 UI들은 크기나 위치를 변경할 수 있으며, 세부정보 창에서 글자 크기나 색, 배경색 등을 변경 가능하다. 이를 통해 각 임무와 단계 별로 가장 적절한 UI를 미리 구성한다.

수중 HUD 시뮬레이터는 HUD에 표시되는 콘텐츠의 사용자 경험을 평가하기 위해 VR 시뮬레이터를 이용한다. 실제 물속에서 콘텐츠를 평가하는 것은 Yamashita 와 Hatsushika 의 연구에서와 같은 특수 장치가 필요한 일이며 사용자 평가를 위해 반복 실험하기는 더욱이 어렵다[9][10]. 또한 물속에서는 실험자에게 상당한 위험이 따른다. 이러한 문제들을 해결하면서 수중 HUD 콘텐츠의 UX를 평가하기 위해 우리는 VR에서 수중 환경을 구성하였다. 이와 같은 결정을 하기 위한 근거는 다음과 같다.

1) R. Currano et al.의 연구[3]의 경우 실제 사용자는 VR HMD를 착용하고 콘텐츠를 경험하는 것이 주된 자극이며 수중에서 실험한 이유는 사용자가 실제로 잠수하는 느낌을 주기 위해서다.

2) 수중 HUD의 개발 목적은 사용자의 수중 체험보다 임무 수행에 정보를 효과적으로 전달하는 것에 있다. 이에 따라 촉각적 정보보다 시각적인 정보가 더 중요하므로 VR로 충분히 유의미한 데이터를 취득할 수 있다.

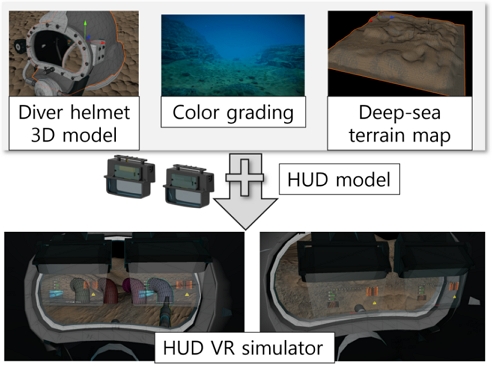

수중 HUD VR 시뮬레이터를 구성하기 위해 그림 5와 같이 구성하였다.

Fig. 5.

Components of the HUD VR simulator

HUD VR 시뮬레이터의 수중 환경을 구현하기 위해 다음과 같이 진행되었다. 우선 심해의 지형을 구현하는 지형 맵(Deep-sea terrain map)을 구성하였다. 이후 수중의 빛 구현을 위한 색상 보정(Color grading) 과정을 수행하는데, 이는 렌더링 후작업(Post-processing)으로 실제 심해 영상을 참고하여 유사하도록 빛의 밝기, 색상의 변화를 모사하고 안개효과(Fog)와 입자(Particle) 효과를 적용하여 실제 수중과 유사한 효과를 내도록 하였다. 이후 잠수사가 실제로 착용하는 헬멧을 3D 메쉬로 제작하고 VR 카메라가 헬멧 안으로부터 밖을 보도록 하여 실제 헬멧을 착용한 것 같은 효과를 주었다. 여기에 수중 HUD 모델을 좌우 카메라 앞에 배치하여 HUD의 화면뿐만 아니라 하드웨어 구조도 같이 체험자 시야에 들어오도록 하였다. 위와 같이 구성하여 사용자는 VR HMD를 이용해 수중 HUD와 출력되는 콘텐츠를 체험해 볼 수 있다.

생성된 콘텐츠는 콘텐츠 재생기(그림 1의 contents player)를 통해 렌더링 되어 HUD VR 시뮬레이터로 전송한다. 이들은 서로 분리되어 있으므로 렌더링 결과를 받기 위해 인코딩과 디코딩 과정을 거치게 된다. 송신부에는 재생기가 있어 저작된 콘텐츠에 따라 이미지를 만들고 인코딩을 수행한다. 이 과정에서 UI 요소에 표출될 정보들은(방위, 잠수 정보, 메시지 등) 영상에 삽입되어야 하는데, 이는 VR 시뮬레이터에서 실험 정보들을 사용한다. 이를 위해 HUD VR 시뮬레이터와 콘텐츠 저작도구, 실험 통제기가 서로 네트워크를 통해 통신하며, 인코딩된 영상도 같은 네트워크를 사용한다. 이는 각 요소를 물리적으로 분리하여 확장성을 높여준다.

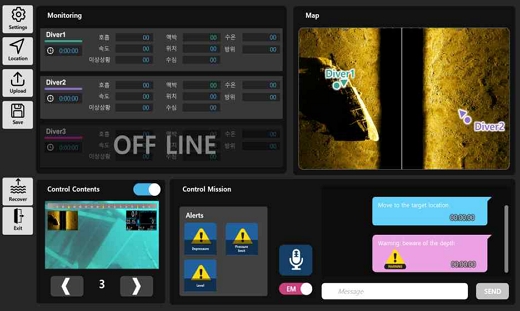

실험 통제기(그림 6)는 저작된 콘텐츠 임무의 단계를 제어하고 사용자의 정보를 HUD에 병합할 수 있도록 정보를 전달하는 기능과 지시/긴급 메시지를 전달하기 위해 텍스트를 입력받고 이를 전달하는 기능, 2차원 지도에 사용자의 위치를 표출하는 기능, 각 센서를 통해 얻어진 정보를 표출하는 기능이 있다. 이런 기능을 통해 실험의 시작과 끝, 각 임무 단계와 상황을 제어하게 된다.

Fig. 6.

Screen of the experiment control tool

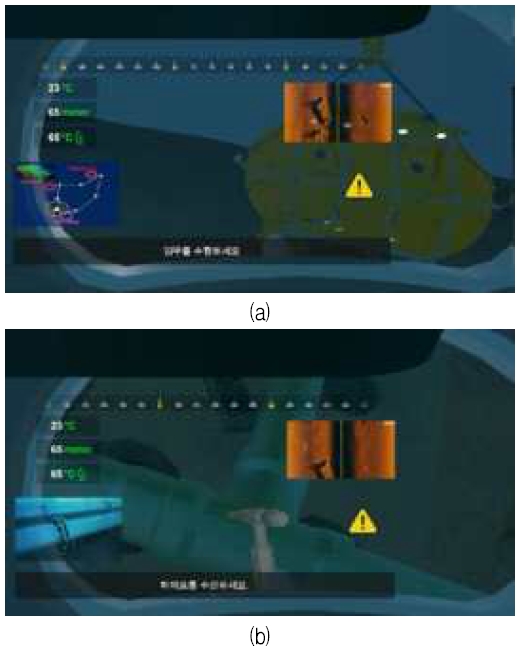

그림 7(a)와 7(b)는 VR HMD에서 표출되는 영상으로 각각 임무를 수행하는 모습이다. 각각 7(a)는 탐색, 7(b)는 용접 임무로 각 필요한 연관 정보들이 UI로 구성돼 있는 모습이다. 임무에 따라 실험 통제기에서 구성된 단계를 표출하도록 제어하며 UI 내 정보를 병합하여 준다.

Fig. 7.

Example screens of HUD VR simulator (a) Exploration mission (b) Welding mission

예를 들어 수온, 수심, 체온, 방위처럼 잠수사 관련 정보와 함께, 목표 지도, 지시 메시지 등 통제소에서 발생시키는 정보가 재생기에서 병합되어 UI에 표시되도록 한다. 사용자는 임무에 해당하는 도구들(용접봉, 렌치 등)을 이용하여야 할 때는 해당 도구들이 컨트롤러와 함께 움직여 사용 가능하다. 그림 8과 그림 9와 같이 콘텐츠의 적절성 평가를 위해 실험 통제소와 저작도구에서 해당 UI에 표출되는 글자 크기나 글자색, 배경색, UI의 배치를 변경하도록 수정이 가능하다. 이를 통해 각 임무별로 가장 적절한 형태를 찾을 수 있도록 하였다.

Fig. 8.

Changing the text color of instruction message (Yellow box)

Fig. 9.

Changing the background color of instruction message (Yellow box)

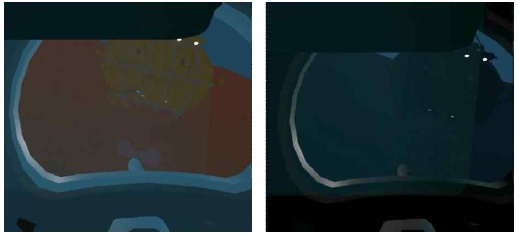

또한 그림 10과 같이 주변 환경의 변화를 시뮬레이션하기 위해 수중 환경의 빛을 조절하거나 시야 거리를 조정도 가능하다.

Fig. 10.

Changing the environment light color and intensity

제안된 시스템을 구성하기 위해 VR HMD로 Meta의 Quest pro를 사용하였으며 무선으로 실시간 영상을 전송하도록 하여 공간 제약을 덜 받도록 하였다. HUD VR 시뮬레이터와 저작도구, 실험 통제소를 구현하기 위해 Unity를 이용하였다. 구현 대상인 HUD의 성능은 시야각 44°로 약 가로 12mm, 세로 4.5mm, 적정 가시거리 15mm이다. 이에 맞추어 HUD를 시뮬레이션하기 위해 해당 HUD의 모델링과 함께 표출되는 영상의 크기도 맞추어 주었다. 이를 통해 사용자는 HUD VR 시뮬레이터로 실제 수중에서 실험하지 않아도 표출되는 콘텐츠의 적절성을 실험할 수 있게 되었다.

See-through HUD는 다양한 산업에 적용되어 사용자의 정보 인식을 도와 작업 능률을 상승시키는 데 많은 역할을 하고 있다. 하지만 수중 작업에서 see-through HUD의 적용은 일부 국가와 제품에서 제한적으로 적용되어 사용되고 있는데, 이는 압력이 높고 밀폐된 특수한 환경이 개발 시 많은 난제를 만들기 때문이다. 그렇다고 수중 HUD의 수요가 적은 것은 아니다. 수중 작업은 특성상 잠수사가 볼 수 있는 시야가 한정적이며 통제선과의 통신은 음성으로만 이루어지는 열악한 환경이다. 이 때문에 HUD에 표시되는 증강 정보에 대한 연구는 필수적이다. 특히 시야가 한정적이고 위험한 환경이므로 전달되는 정보도 이에 맞게 전달되어야 한다.

본 논문은 HUD에 표출되는 콘텐츠 형태의 적합성을 실험하기 위해 HUD VR 시뮬레이터 구성을 제안하였다. 이를 통해 실제 수중 잠수 없이도 사용자의 UX를 측정할 수 있으며, 이를 통해 많은 실험데이터를 확보할 있으므로 실험 데이터에 대한 품질을 높일 수 있다. 제안된 시스템은 콘텐츠 저작도구와 VR HMD를 이용한 시뮬레이터, 실험 통제기로 이루어지며, GUI 방식으로 실험 파라미터를 변경하여 실험 시간을 줄일 수 있게 하였다. 또한 개발되는 시스템은 네트워크를 기반으로 통신하므로 물리적으로 분리되어 있더라도 적용가능하다.

우리가 연구한 시스템의 제한점은 다음과 같다. VR을 착용한 사용자가 움직일 때 수중에 있지 않기 때문에 물에 의한 저항감을 느끼기는 어렵다. 이런 저항감의 차이는 착용자의 인지 능력의 차이를 만들어 실제 수중에서 사용했을 때 실험한 결과와 차이를 만들 수 있다. 또한 VR 환경은 실제와 차이가 있기때문에 인지 차이가 발생할 수 있는 한계점이 있다. 향후 이를 해결하기 위해 더욱 정밀한 환경 구성과 M. Zhang[1]와 같은 하드웨어를 통해 실제 물의 저항감을 느끼도록 하여 정밀한 실험 데이터를 취득할 수 있도록 해결해야 할 것이다.

본 연구는 대한민국 정부(산업통상자원부 및 방위사업청) 재원으로 민군협력진흥원에서 수행하는 민군기술협력사업의 연구비 지원으로 수행되었음 (과제번호 23-CM-DI-11, 심해 잠수사 임무수행을 위한 정보증강 HUD 개발)

References

| 1. | M. Zhang, "Optimization Analysis of AR-HUD Technology Application in Automobile Industry", Journal of Physics: Conference Series, Bijing, China, Vol. 1746, No. 1, pp. 1-5, Jan. 2021. |

| 2. | J. R. A. Betancur, "Design considerations of HUD projection systems applied to automobile industry", Head-and Helmet-Mounted Displays XVII; and Display Technologies and Applications for Defense, Security, and Avionics VI, Maryland, United States, Vol. 8383, pp. 101-108, Apr. 2012. |

| 3. | R. Currano, S. Park, D. Moore, K. Lyons, and D. Sirkin, "Little road driving hud: Heads-up display complexity influences drivers’ perceptions of automated vehicles", Proceedings of the 2021 CHI conference on human factors in computing systems, No. 511, pp. 1-15, May 2021. |

| 4. | D. Kang and S. Kim, "The Cognitive Absorption Level in Product Assembly with AR Manual", Proceedings of KIIT Conference, Daejeon, Korea, pp. 491-494, Jun. 2019. |

| 5. | J. Won and S. Choi, "The Effects of AR(Augmented Reality) Contents on User"s Learning : A Case Study of Car manual Using Digital Contents", Journal of Digital Contents Society, Vol. 18, No. 1, pp. 17-23, Feb. 2017. |

| 6. | G. Lee, A. Dünser, S. Kim, and B. Mark, "CityViewAR: A mobile outdoor AR application for city visualization", 2012 IEEE international symposium on mixed and augmented reality-arts, media, and humanities (ISMAR-AMH), Atlanta, GA, USA, pp. 57-64, Mar. 2013. |

| 7. | L. David, A. M. Feit, and O. Hilliges. "Context-aware online adaptation of mixed reality interfaces", Proceedings of the 32nd annual ACM symposium on user interface software and technology, pp. 147-160, Oct. 2019. |

| 8. | D. Jain, M. Sra, J. Guo, R. Marques, R. Wu, J. Chiu, and C. Schmandt, "Immersive terrestrial scuba diving using virtual reality", Proceedings of the 2016 CHI Conference Extended Abstracts on Human Factors in Computing Systems, California, USA, pp. 1563-1569, May 2016. |

| 9. | S. Yamashita, Z. Xinlei, and R. Jun, "Aquacave: Augmented swimming environment with immersive surround-screen virtual reality", Adjunct Proceedings of the 29th Annual ACM Symposium on User Interface Software and Technology, Tokyo, Japan, pp. 183-184, Oct. 2016. |

| 10. | D. Hatsushika, N. Kazuma, and H. Yuki, "Underwater vr experience system for scuba training using underwater wired hmd", OCEANS 2018 MTS/IEEE Charleston, Charleston, SC, USA, pp. 1-7, Oct. 2018. |

| 11. | D. A. Plecher, L. Keil, G. Kost, M. Fiederling, C. Eichhorn, and G. Klinker, "Exploring underwater archaeology findings with a diving simulator in virtual reality", Frontiers in Virtual Reality, Vol. 3, pp. 1-11, Oct. 2022. |

2019년 2월 : 한국과학기술원 문화기술대학교(공학박사)

2019년 6월 ~ 2024년 9월 : 한국전자기술연구원 선임연구원

2024년 9월 ~ 현재 : 국립강릉원주대학교 멀티미디어공학과 조교수

관심분야 : XR, 모션 캡쳐, 디지털트윈

2019년 2월 : 한국과학기술원 문화기술대학원(공학석사)

2019년 6월 ~ 현재 : 한국전자기술연구원 전임연구원

관심분야 : 증강/가상 현실, 텔레프레즌스

2022년 8월 : 상명대학교 정보보안시스템공학(공학석사)

2012년 10월 ~ 현재 : 한국전자기술연구원 연구원

관심분야 : 증강/가상 현실, 시뮬레이터 시스템, 비전AI

2010년 2월 : 광주과학기술원 정보기전공학부(공학석사)

2017년 8월 : 광주과학기술원 전기전자컴퓨터공학부(공학박사)

2018년 3월 ~ 현재 : 경상국립대학교 컴퓨터공학과 부교수

관심분야 : 컴퓨터 그래픽스, 증강현실, 인공지능