사회적 고립 및 우울증 위험군 조기 발견을 위한 AI 기반 감정 분석 및 전문가 연계 플랫폼 개발

초록

은둔형 외톨이와 같은 정신 건강 위험군의 조기 발견 및 개입을 목표로, 사용자의 일상 기록에 대한 AI 감정 분석을 기반으로 하는 웹 플랫폼을 제안한다. 본 플랫폼은 기존의 비대면 상담 서비스가 사용자가 적극적으로 상담을 신청해야 하는 한계를 극복하기 위해 가볍게 작성하는 일상 기록에 대한 AI 감정 분석 결과로 제한된 전문가 집단이 효율적으로 위험군을 탐지하고 피드백을 제공할 수 있도록 설계 되었다. 감정 분석을 위한 모델은 KLUE-RoBERTa을 Binary Relevance Approach 방식으로 학습시켜 복합적인 감정이 포함된 문장에도 대응할 수 있도록 하였다. 감정 분석 모델의 성능 평가와 실제 실행 화면을 제시하며 플랫폼의 실효성을 평가한다. 접근성이 높은 웹 환경을 통해 사회적 고립 및 우울증 위험군에 대한 조기 발견과 정신 건강 문제 해결에 기여를 할 것으로 기대된다.

Abstract

To facilitate the early detection and intervention of socially withdrawn individuals and those in mental health risk groups such as hikikomori, we propose a web platform based on AI-based sentiment analysis of users' daily records. The platform addresses the limitations of traditional teleconsultation services, which rely on users actively seeking help, by enabling efficient risk group identification and feedback provision through AI sentiment analysis of casually written daily records. The sentiment analysis model was trained using KLUE-RoBERTa with the Binary Relevance Approach, allowing it to handle sentences containing complex emotions effectively. The platform's effectiveness is evaluated through performance assessments of the emotion analysis model and demonstrations of its practical implementation. By leveraging a highly accessible web-based environment, the platform is expected to contribute significantly to the early detection of socially isolated and depression-prone individuals and to the resolution of mental health issues.

Keywords:

sentiment analysis, NLP, social isolation, mental health, KLUE-RoBERTaⅠ. 서 론

최근 청년 계층에서 사회적 고립과 이로 인한 정신 건강 문제가 중요한 사회적 이슈로 부각되고 있다. 이는 취업난, 경제난, 코로나19 팬데믹의 여파, 1인 가구 증가와 같은 다양한 사회적 요인에 기인한다. 특히, 사회적 교류가 가장 활발해야 할 청년층에서 사회적 고립이 증가하는 현상은 더욱 주목받고 있으며, 그 극단적인 형태인 "은둔형 외톨이(Hikikomori)" 현상에 대한 관심도 높아지고 있다. "은둔형 외톨이"는 집에 틀어박혀 장기간 사회 활동을 하지 않는 개인 또는 현상을 의미하며, 이는 한국, 일본을 포함한 동아시아 국가에서 주요 공중보건 문제로 대두되고 있다[1].

연구에 따르면, 사회적 고립은 정신 건강에 부정적인 영향을 미치며 사회적 고립의 극단적인 형태인 "은둔형 외톨이" 계층은 주요 우울 장애의 발생률은 다른 계층에 비해 유의미하게 높은 것으로 나타난다[2]-[4]. 이러한 문제는 다양한 국가에서 중요한 사회적 문제로 인식되고 있으며, 이를 해결하기 위해 정책적 개입이 필요하다는 공감대가 형성되고 있다[5].

"은둔형 외톨이"들은 사회와의 교류를 거부하고 방이나 집에 머무르며, 이로 인해 사회 복지 정책의 사각지대에 놓이기 쉽다. 이러한 특성은 이들의 실태를 정확히 파악하기 어렵게 만들며, 타인과의 교류를 회피하는 성향으로 인해 자신의 정신 건강 상태를 인지하지 못할 가능성이 높다. 이 경우 상담이나 치료가 필요한 시점을 놓치게 될 수 있다.

IT 기술의 발전과 코로나19 팬데믹으로 다양한 비대면 서비스가 연구되었다. 특히, 정신 질환에 대한 사회적 편견이나 시간 부족 등의 이유로 병원이나 기관 방문을 주저하는 사람들이 많아지면서, 전문가와의 비대면 상담에 대한 관심이 높아졌다[6]-[8]. 실제 연구에 따르면, ZOOM과 같은 화상 회의 플랫폼을 활용한 비대면 집단 상담은 대면 상담과 유사한 효과를 보이는 것으로 나타났다[8]. 이러한 비대면 서비스는 상담을 필요로 하지만 접근을 망설이는 사람들에게 보다 쉽게 다가갈 기회를 제공한다. 또한 사회적 교류를 회피하는 계층에게도 심리적 장벽을 낮추어 접근을 용이하게 한다.

그러나 기존의 이러한 솔루션들은 사용자가 상담의 필요성을 스스로 인지하고 적극적으로 신청해야 한다는 한계를 지니고 있다. 이는 자신의 문제를 자각하지 못하는 잠재적 위험군이나 사회적 교류를 극단적으로 회피하는 "은둔형 외톨이"들에게는 충분히 효과적이지 않을 수 있다. 또한, 우울증 진단률이 증가하면서 상담이 필요한 대상자 역시 늘어나고 있어, 빠른 대응이 필요한 위험군에게 피드백과 심층 상담을 우선적으로 제공하는 것이 중요하다. 하지만 기존 솔루션만으로는 제한된 전문가 집단이 이러한 위험군을 조기에 탐지하기에는 한계가 있다.

이러한 한계를 극복하기 위해 본 논문에서는 사용자가 작성한 일상 기록을 AI 감정 분석 모델로 분석하여 우울 정도를 수치화하고, 이를 사용자와 전문가에게 제공하는 플랫폼을 제안한다. 이 플랫폼은 모든 계층이 부담 없이 접근할 수 있도록 설계되었으며, 사용자의 우울 정도와 감정 데이터를 기반으로 전문가가 위험군에 대해 우선적으로 피드백을 제공하거나 상담을 제안할 수 있도록 지원한다. 이를 통해 사회적 고립 및 우울증 위험군에 대한 조기 발견과 효율적인 개입을 가능하게 하고자 한다.

본 논문의 구성은 다음과 같다. 2장에서는 관련 연구를 검토하며, 각 연구의 장점, 한계점을 분석한다. 3장에서는 시스템 구조와 데이터셋 전처리, 모델 디자인에 대해 서술한다. 4장에서는 학습 및 평가 과정, 구현 결과에 대해 구체적으로 설명한다. 마지막으로 5장에서는 결론과 함께 향후 연구에 대해 논의한다.

Ⅱ. 관련 연구

AI 기술의 발전으로 이를 심리 상담 등에 활용하려는 연구가 많이 진행되고 있다. 그 중에는 자연어처리와 딥러닝을 활용한 감정 분석을 정신 건강 치료에 사용하는 것에 대한 연구도 있다.

P. K. Nag et al.[9]은 자연어처리와 딥러닝 기술을 활용하여 의료 텍스트에서 감정을 분석하여 조기 정신 건강 문제를 식별하는 것이 가지는 효과를 연구하였다. 해당 연구에서는 임상 서술, 환자 기록과 같은 의료 텍스트들을 다양한 기법의 모델로 분석하여 해당 분석이 정신 건강 개선에 실제 효과가 있음을 확인하였다. 해당 연구는 AI 기반 감정 분석 기술이 정신 건강 문제에 대한 조기 개입의 도구로 활용될 수 있음을 입증한다.

AI를 통한 정신 건강 개선에 대한 연구 중, Y. G. Song et al.[10]은 우울증 증가에 따른 부정적 감정의 완화를 위한 AI 감성 지능 챗봇을 제안하였다. 이 연구에서는 KR-BERT와 KoGPT2를 앙상블한 기법을 활용해 한국어에 특화된 챗봇을 개발했으며, 이를 통해 사용자에게 공감하며 긍정적 감정을 유도할 수 있도록 설계하였다. 기존의 영어 기반의 챗봇보다 떨어지는 국내의 심리 진단 챗봇을 개선하여 국내 사용자에게 효과적으로 작용할 수 있도록 하였다.

AI 챗봇을 심리 상담에 활용하는 연구 중, S. H. An과 O. R. Jeong[11]은 대면 심리상담을 대체할 수 있는 AI 감정 분석 기반 챗봇을 통한 상담 시스템을 제안했다. GPT-2 모델을 사용한 챗봇이 심리 상담을 수행하고, 해당 결과가 부정적이면 불안 정도 검사와 불안 원인을 검사하는 챗봇으로 이동하는 방식을 사용한다. AI 챗봇에게 실제 유용성이 확인된 심리 분석 척도를 활용한 데이터를 학습시켜 사용자의 상태를 효과적으로 분석할 수 있도록 하였다.

K. Kim et al.[12]은 자연어처리와 기계학습을 활용하여 SNS에 게시된 글에서 사용자의 우울감을 감지하는 시스템을 제안하였다. 이 연구에서는 RNN, LSTM, GRU 등 세 가지 기계학습 모델을 사용하여, 약 1,000 ~ 1,200개의 우울 관련 문장과 그렇지 않은 문장을 학습시킨 뒤 정확도를 비교하였다. 제안된 시스템은 SNS 기반으로 많은 사람이 쉽게 다가갈 수 있어 접근성이 높다는 장점이 있다.

기존의 AI와 정신 건강 관련의 활용 관련 연구들은 AI 챗봇이 직접 상담하며 사용자의 상태를 측정하거나 분석 모델의 정확도 실험에 중점을 두었으며, 상태를 측정하고 공유하는 것 이상의 연계는 고려되지 않았다. AI 챗봇은 높은 접근성을 가졌지만, 정신 건강 문제에 대한 평가의 정확성 및 신뢰성을 보장하기에는 한계가 있다. 하지만 전문가와의 상담은 높은 정확도를 가지지만, 제한된 수로 인해 접근성이 매우 낮다. 이에 본 연구에서는 일상 기록과 같은 감정 표현이 자연스럽게 드러나고 가볍게 접근 가능한 글을 분석 대상으로, 우울의 정도를 수치화하여 전문가에게 제공하고 피드백을 받을 수 있는 플랫폼을 제안한다. 사용자는 시공간의 제약 없이 원하는 때 자신의 일상과 느낀 것을 기록하는 것만으로 AI가 분석한 수치와 전문가의 피드백을 확인할 수 있고, 전문가는 AI가 분석한 수치로 위험군에 속한 사용자에게 우선적으로 피드백을 보낼 수 있다. 이를 통해 AI 챗봇이 내포한 부정확성과 제한된 전문가 수로 인한 낮은 접근성이라는 단점을 극복할 수 있으리라 기대한다.

Ⅲ. 시스템 설계 및 개발

AI 일기 감정 분석 기반 전문가 연계 플랫폼의 전체적인 구조와 개발 내용에 대해 서술한다.

3.1 시스템 구성

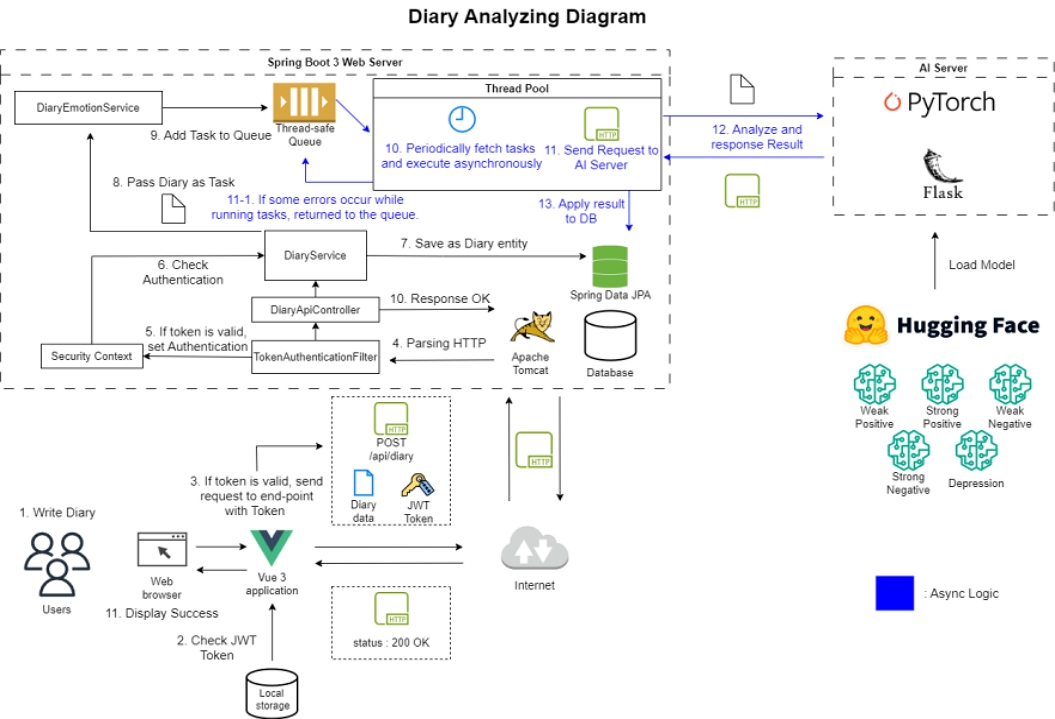

본 논문에서 제안하는 플랫폼은 웹 브라우저에서 구동되는 클라이언트(Client)와 웹 서버(Web server), AI 서버(AI server)로 구성된다. 클라이언트는 사용자의 웹 브라우저에서 구동되며 웹 서버와 사용자 간의 인터페이스로 기능한다. 사용자가 일기를 작성하면 해당 데이터는 웹 서버로 전송되고, 웹 서버는 해당 데이터를 비동기로 AI 서버로 전달한다. AI 서버가 분석 결과를 응답하면 웹 서버가 이를 DB에 반영한다. 해당 일기와 분석 결과는 사용자와 담당 전문가가 클라이언트를 통해 확인할 수 있다. 그림 1은 사용자의 일기 작성부터 분석 결과 반영까지의 과정을 나타낸다.

연산량이 많은 AI 서버의 부담을 줄여 안정성을높이기 위해 폴링(Polling)을 사용하였다. 웹 서버는 사용자의 일기를 받으면 이를 작업으로 구성하여 스레드-세이프(Thread-safe)한 큐(Queue)에 삽입하고, 일정한 간격으로 해당 큐에서 작업을 꺼내어 별도로 존재하는 AI 서버로 HTTP 요청을 보내고 응답을 받는다. AI 서버는 허깅 페이스(Hugging face)에서 로드한 모델로 이를 분석하여 우울한 정도의 수치를 반환하고, 웹 서버가 이를 받아서 DB에 업데이트한다. 이 과정은 다중 접속 환경에서도 높은 안정성을 유지할 수 있게 한다.

3.2 데이터셋과 전처리

본 논문의 학습 데이터셋으로 AI Hub의 ‘웰니스 대화 스크립트 데이터셋’을 활용하였다[13]. 이는 실제 정신건강 상담 기록을 기반으로 구축된 한국어 데이터셋으로, 다양한 대화 의도를 포함하고 있다. 해당 데이터셋에서 감정이 드러나는 문장을 선별하여 라벨링 작업을 수행하였다.

라벨링 작업에는 J. A. Russell[14]의 Circumplex 감정 모델을 참고하여, '강한 긍정', '약한 긍정', '강한 부정', '약한 부정', '우울'의 5개 감정 카테고리를 사용하였다. 감정 분류는 우리가 직접 전체적인 문맥과 발화자의 의도를 고려하여 평가한 뒤, 서로 논의를 거쳐 최종적인 라벨을 결정하는 방식으로 진행되었다. 이후, 데이터셋 불균형으로 인한 성능 저하를 막기 위해 OpenAI의 GPT-3.5-turbo 모델을 활용하여 데이터 증강을 수행하였다. GPT 기반 데이터 증강은 기존 연구에서도 감정 분석 성능 향상에 효과적인 방법으로 제시된 바 있다[15]. 해당 연구를 참고하여 기존 데이터의 내용을 포함한 프롬프트와 각 라벨이 전체 데이터셋에서 차지하는 정도를 고려한 생성 개수 조절을 통해 기존 데이터셋의 품질을 유지하면서 각 라벨의 균형을 맞추었다.

이렇게 확보한 초기 10만 개 이상의 문장에서 코사인 유사도가 임계값을 넘는 문장들을 한 곳에 묶은 후 대표 문장만 남기는 방법으로 유사 문장을 제거하였다. 이는 유사 데이터가 라벨의 분포를 실제보다 부풀려 모델의 일반화 성능을 저하되는 경우를 방지하기 위함이다. 표 1은 정제를 거친 후 최종적으로 확보된 각 라벨 별 문장 데이터 수를 나타낸다.

전처리가 완료된 데이터 셋을 계층화 분할(Stratified split)를 통해 80%의 학습(Training) 데이터와 20%의 평가(Test) 데이터로 나누었다. 계층화 분할은 데이터셋을 분할할 때 각 클래스(라벨)의 비율을 유지하도록 나누는 방식으로, 라벨 불균형으로 인해 학습과 평가에 편향이 생기는 것을 막기 위해 사용하였다.

3.3 모델 디자인

본 논문에서는 감정을 측정하고 분석하기 위한 모델의 구성을 위해 J. A. Rusell[14]이 제안한 Circumplex 모델을 참고하였다. 해당 모델은 감정을 감정가(Valence)와 활성화-비활성화(Arousal 또는 Activation)라는 두 축을 기준으로 하는 원형 배열로 나타내어 구분한다. 예를 들어, "행복"은 높은 감정가와 높은 활성화에 위치하고 "우울"은 낮은 감정가와 낮은 활성화에 위치한다. 이 모델을 참고하여 데이터셋의 라벨을 "강한 긍정", "약한 긍정", "강한 부정", "약한 부정", "우울"의 5가지로 나누었다. 그리고 우울에 가까운 정도에 따라 가중치를 설정하였다.

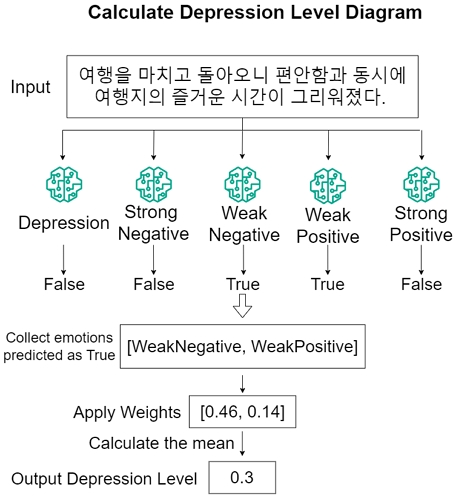

감정 분석을 위한 모델 학습 전략으로는 Binary Relevance Approach를 채용했다. 해당 접근법은 여러 개의 라벨을 각각 독립적인 이진 분류 문제로 취급하여 분석하는 방법으로 단순하면서도 효율적이라는 장점으로 널리 사용된다. 하지만 각 라벨 간의 관계를 제대로 반영하지 못한다는 단점을 가진다. 이에 본 논문에서는 5가지 감정 라벨에 대해 이진 모델을 만들어 입력된 문장에 해당 감정이 드러나는 지를 각각 판별하게 한 후, 여기에 경사하강법으로 결정된 감정 라벨별 가중치를 곱하여 평균을 내어 우울 수치를 산출하는 방식을 제안한다.

초기에는 우울 수치를 정량적으로 계산하기 위해 단순 회귀 모델을 사용하는 것도 고려하였다. 하지만 회귀 모델은 연속된 값을 다루는 특성상 경계를 찾아내는 분류 모델보다 데이터 분포와 이상치, 라벨 불균형에 더욱 민감하고 더 많은 데이터를 요구하는 것이 일반적으로 알려져 있다. 특히, 우울 수치로 라벨링된 데이터는 기존 데이터 셋을 활용하기 어려워 직접 라벨링해야 하기에 회귀 모델에 요구되는 품질을 가지는 데이터를 대량으로 확보하는 것이 상대적으로 어렵다. 또한, 모델이 단일 수치만 반환하는 것은 향후 플랫폼에 기능을 확장할 때에도 불리하다. 따라서 데이터 대량 수집이 용이한 감정 분류 이진 모델들로 문장의 감정들을 출력하고, 여기에 소량의 우울 수치 데이터로 결정된 라벨별 가중치를 적용하여 최종적인 우울 수치를 도출하는 본 접근 방식이 좀 더 낮은 비용으로 향후 기능 확장에 대응하면서 우울 수치 예측 모델을 구성할 수 있다고 판단되어 채택하였다.

그림 2는 모델의 반환 값을 가공하여 우울 수치를 계산하는 예시를 도식화한 것이다. 복합적인 감정이 포함된 문장을 입력받아 분석하는 과정, 가중치를 적용하고 우울 수치를 산출하는 과정을 볼 수 있다.

감정 라벨별 가중치를 구하는 위한 데이터는 복합적인 감정을 포함하는 문장을 중심으로 2,340개의 문장을 선정한 후, Circumplex 모델에 기반하여 직접 우울 수치를 결정하고 라벨링하였다. 이후 해당 데이터에 "감정 목록" 열을 추가하고, 해당 열에 4.1절에서 채택한 모델들로 판별한 각 문장의 감정들을 추가하였다. 이 데이터를 기반으로 경사하강법을 수행하여 가중치를 학습한다.

초기 가중치를 랜덤하게 설정한 뒤, "감정 목록" 열의 감정 라벨에 해당 가중치를 곱한 뒤 평균을 계산한 예측 값과 라벨링된 우울 수치 간의 손실 함수 값이 최소화 되는 방향으로 가중치를 조정하는 방식으로 학습하였다.

손실 함수는 기본적인 평균 제곱 오차(MSE, Mean Squared Error)를 사용하였다. 정의는 식 (1)과 같다. 해당 식에서 y는 라벨링된 우울 수치, 은 각 문장에서 나타난 감정에 가중치를 곱한 뒤 평균을 계산한 값이다.

| (1) |

학습률(Learning rate)은 0.03, 에포크(Epoch)는 2000으로 설정 한 후 학습을 진행하였고, 최종 손실 값은 0.016으로 수렴하였다. 이는 제안한 예측 방식이 낮은 비용으로 구현하였음에도 비교적 안정적으로 우울 수치를 예측한다는 것을 의미한다.

표 2는 최종적으로 각 라벨에 대해 설정된 가중치를 나타낸다.

감정 분석을 위한 기반 모델로는 BERT, RoBERTa, Electra 중 실험을 통해 우수한 성능을 보이는 모델을 선정한다.

RoBERTa 모델은 기존의 BERT 모델에 더 많은 데이터 셋을 학습 시키고 다음 문장 예측(NSP) 제거하는 등의 최적화를 적용한 모델로 다양한 자연어 처리 환경에서 더 높은 성능을 보이는 것으로 연구되었다[16]. 파인 튜닝 안정성이 높고 모델 규모 대비 높은 효율성을 보여준다는 장점을 가진다. 한국어 기반 RoBERTa 모델은 KLUE-RoBERTa를 사용한다. 해당 모델은 RoBERTa를 한국어에 맞게 최적화한 모델이다[17]. BERT와 Electra의 한국어 기반 모델로는 각각 KoBERT와 KoElectra를 사용한다.

Ⅳ. 구현 및 검토

4.1 데이터 학습 및 평가

본 논문에서는 수집한 학습 데이터에 적합한 모델을 탐색하기 위해 위에서 언급한 세 가지 모델에 대해 각각 학습을 수행하였다. Binary Relevance Approach에 따라 각 라벨 별로 이진 분류기를 총 5개 구성하고, 각 분류기가 0~1 사이의 값으로 라벨에 가까운 정도를 반환하게 한다. 학습은 에포크(Epoch) 3, 학습률(Learning rate) 3×10-5, 배치 크기(Batch size) 16으로 진행하였다. 학습을 위한 손실 함수로는 이진 교차 엔트로피 로짓 손실 함수(BCEWithLogitsLoss, Binary Cross-Entropy with Logits Loss)를 사용하였다. 해당 손실 함수의 정의는 식 (2)와 같다. 해당 식에서 y는 실제 라벨, z는 모델의 로짓(logit) 출력, yi는 해당 샘플의 정답 라벨, N은 배치 크기(batch size)를 의미한다. σ(z)는 시그모이드(Sigmoid) 함수로 정의되며 식 (3)과 같이 정의된다.

| (2) |

| (3) |

이진 교차 엔트로피 로짓 손실 함수는 이진 분류의 손실 함수로 주로 사용되는 이진 교차 엔트로피(Binary cross-entropy)에 시그모이드(Sigmoid) 활성화 함수를 결합한 것으로 각각 별도로 적용하는 것보다 수치적으로 안정적이며 계산 효율이 더 높은 장점을 보인다.

학습을 완료한 후 테스트 데이터셋을 통해 예측값과 라벨을 비교하였다. 표 3, 표 4, 표 5는 각각 RoBERTa, Electra, BERT 모델의 테스트 데이터에 대한 성능 평가를 결과를 보여준다. 대부분의 지표에서 RoBERTa 기반 모델이 우수한 성능을 보였기에 최종적으로 Klue-RoBERTa를 선택하였다.

4.2 시스템 데모

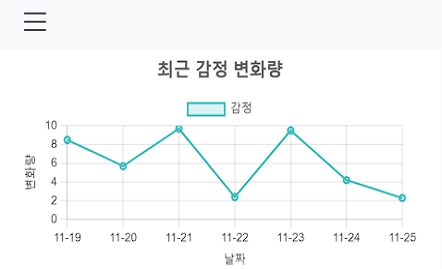

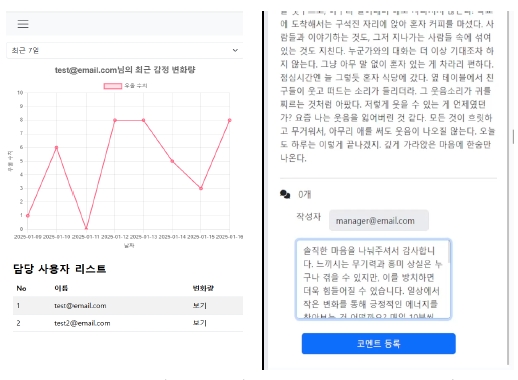

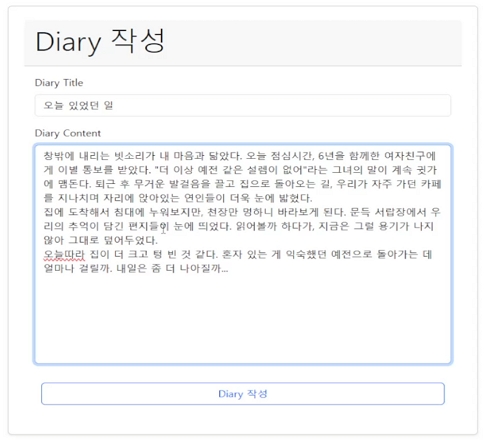

접근성을 높이기 위해 반응형 UI를 적용하여 모바일 기기와 데스크탑 모두에서 사용할 수 있도록 하였다. 그림 3은 사용자가 로그인한 직후 이동하는 홈 페이지를 나타낸다. 최근 작성한 글의 우울 수치를 화면 중앙의 그래프로 한 눈에 볼 수 있으며, 좌 상단의 버튼을 눌러 사이드 바를 열어서 작성 페이지나 목록 페이지로 이동할 수 있다.

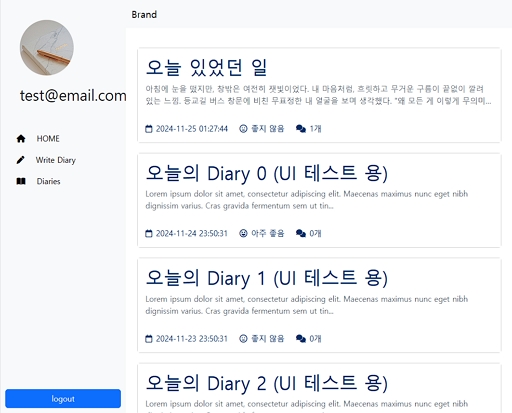

그림 4는 사용자가 작성한 글 목록을 나타낸다. 글의 제목과 내용의 일부, 전문가의 코멘트 개수, 감정 분석 결과를 아이콘으로 확인할 수 있다. 각 항목을 클릭해서 상세 보기 화면으로 접근하면 해당 글의 전체 내용과 전문가가 작성한 피드백을 확인할 수 있다.

그림 5는 전문가가 로그인한 직후 이동하는 홈 화면과 사용자가 작성한 글을 확인하고 피드백을 작성할 수 있는 화면을 나타낸다. 아래 리스트에서 선택한 담당 사용자가 최근 작성한 글의 우울 수치를 그래프로 볼 수 있다. 해당 그래프로 수치가 높은 위험군을 파악할 수 있다. 위험군으로 추정한 사용자의 이름을 리스트에서 클릭하면 해당 사용자가 작성한 글 목록을 확인할 수 있다. 이 목록은 그림 4의 사용자가 보는 글 목록 화면과 같다.

상세보기 화면에서는 전문가가 글의 내용을 참고하여 적절한 피드백을 돌려주거나, 상담이나 치료가 필요하다고 판단할 경우 심층 상담을 제안할 수 있다. 작성한 피드백은 사용자가 자신이 작성한 글 목록 화면에서 확인할 수 있다.

그림 6과 그림 7은 실제 우울 수치를 분석한 예시를 나타낸다. 그림 6에서 글을 작성한 후, 글 목록으로 이동하면 그림 7처럼 분석 결과를 아이콘으로 확인할 수 있다. 해당 수치는 사용자 자신의 그래프와담당 전문가의 그래프에도 적용되어 홈 화면에서 확인할 수 있다. 전문가는 해당 그래프를 참고로 우선적인 피드백이 필요한 사용자를 "담당 사용자 리스트"에서 클릭한 후, 피드백을 작성할 수 있다.

Ⅴ. 결론 및 향후 과제

본 논문에서는 자연어 처리 모델로 사용자의 일상 기록의 감정을 분석하여 위험군을 조기 발견하고 사용자에게 피드백을 전달할 수 있는 플랫폼을 제안하였다. 사용자는 접근성이 높은 웹 환경에서 일상적인 기록을 작성하는 것만으로 AI가 분석한 감정 상태를 한눈에 확인할 수 있으며, 전문가의 피드백도 받을 수 있다. 이는 사회적 고립 계층이나 우울증 위험군이 진입 장벽이 높은 대면/비대면 상담 없이도 정신 건강에 대한 지원을 받을 수 있게 할 것으로 기대된다.

그러나 본 논문에서 제안한 플랫폼에는 몇 가지 한계가 존재한다. 첫째, 감정 분석 결과가 우울 수치로만 제공되어 사용자에게 전달되는 정보가 제한적이다. 문장별 분석 결과와 같은 정보를 추가로 제공하여 사용자 경험을 향상할 필요가 있다. 둘째, 전문가가 위험군을 조기 발견하기 위한 기능이 부족하다. 담당 사용자의 우울 수치가 임계치를 지속적으로 넘을 경우 이메일이나 메신저로 알림을 보내는 기능과 같이 전문가를 보조할 추가적인 수단이 필요하다. 셋째, 감정 분석 모델이 우울 감지에는 우수한 성능을 보이지만 강한 긍정(Strong positive)과 같은 일부 감정 라벨에서 부족한 성능을 보인다. 이는 해당 감정 라벨들에 대한 데이터셋의 품질이 우울(Depression) 라벨의 것보다 뒤떨어지기 때문이다. 향후 연구에서는 ‘감성대화 말뭉치’[18]와 같은 감정 분류용 데이터 셋을 추가로 정제 및 가공하여 라벨 불균형과 떨어지는 품질을 보완하여 모델의 성능을 개선할 것이다.

또한, 제안한 방법론의 유효성과 실제 적용 가능성을 명확히 검증할 필요가 있다. 현재로서는 플랫폼의 개념을 제시하고 설계하여 가능성을 제시한 것에 그친다. 향후 연구에서는 사용자를 대상으로 한 사용성 테스트를 설계수행하여 시스템의 실효성을 정량적으로 평가하며, 이를 통해 수집된 데이터에 대한 통계적 유의성 검정을 실시할 예정이다. 그리고 전문가의 의견을 통하여 실제 정신건강 개선에 기여할 수 있는지를 평가하고, 이를 종합하여 개선 방향을 도출할 것이다.

그 외에 감정 라벨별 가중치를 구하기 위해 사용한 우울 수치로 라벨링된 데이터가 우리의 주관으로 구축되었다는 점도 향후 연구를 통해 우울 수치 산정 기준에 대한 신뢰성 있는 근거를 마련한 후 가중치를 다시 구하여 개선할 필요성이 있다.

References

-

J. C. M. Wong, M. J. S. Wan, L. Kroneman, T. A. Kato, T. W. Lo, P. W. Wong, and G. H. Chan, "Hikikomori Phenomenon in East Asia: Regional Perspectives, Challenges, and Opportunities for Social Health Agencies", Frontiers in psychiatry, Vol. 10, pp. 512, Jul. 2019.

[https://doi.org/10.3389/fpsyt.2019.00512]

-

N. Leigh-Hunt, D. Bagguley, K. Bash, V. Turnet, S. Turnbull, N. Valtorta, and W. caan, "An overview of systematic reviews on the public health consequences of social isolation and loneliness", Public Health, Vol. 152, pp. 157-171, Nov. 2017.

[https://doi.org/10.1016/j.puhe.2017.07.035]

-

M. Hwang and M. Ki, "Association between Social Isolation and Depression among Korean Living Alone", Public Health Weekly Report, Vol. 17, No. 10, pp. 383-403, Dec. 2024.

[https://doi.org/10.56786/PHWR.2024.17.10.1]

-

J. Y. Jung, J. H. An, M. H. Kim, S. H. Park, and J. P. Hong, "Prevalence of Psychiatric Diagnosis and Related Psychosocial Characteristics Among Hikikomori (Social Withdrawal Syndrome) in Korea", Journal of Korean Neuropsychiatric Association, Vol. 62, No. 2, pp. 164-172, Nov. 2023.

[https://doi.org/10.4306/jknpa.2023.62.4.164]

-

N. Goldman, D. Khanna, M. L. E. Asmar, P. Qualter, and A. El-Osta, "Addressing loneliness and social isolation in 52 countries: a scoping review of National policies", BMC Public Health, Vol. 24, No. 1207, May 2024.

[https://doi.org/10.1186/s12889-024-18370-8]

-

J. I. Park and M. Jeon, "The Stigma of Mental Illness in Korea", Journal of Korean Neuropsychiatric Association, Vol. 55, No. 4, pp. 299-309, Nov. 2016.

[https://doi.org/10.4306/jknpa.2016.55.4.299]

-

E. H. Kim, E. S. Lee, and Y. J. Cho, "A Qualitative Study of Client Experience on Non-Face-to-Face Counseling at College Counseling Centers", Korea Journal of Counseling, Vol. 22, No. 2, pp. 85-110, Apr. 2021.

[https://doi.org/10.15703/kjc.22.2.202104.85]

-

Y. S. Oh and E. S. Cho, "Effects and Traits of Online Narrative Group Counseling using Videoconferencing Modality : Comparing with face-to-face Group Counseling", The Journal of the Convergence on Culture Technology, Vol. 6, No. 4, pp. 401-409, Nov. 2020.

[https://doi.org/10.17703/JCCT.2020.6.4.401]

- P. K. Nag, A. Bhagat, R. V. Priya, and D. K. Khare, "Emotional Intelligence Through Artificial Intelligence: NLP and Deep Learning in the Analysis of Healthcare Texts", arXiv:2403.09762, , Vol. 2403, No. 9762, Mar. 2024. https://arxiv.org/abs/2403.09762, .

-

Y. G. Song, M. J. Kyung, and H. Lee, "A BERGPT-chatbot for mitigating negative emotions", Journal of The Korea Society of Computer and Information, Vol. 26, No. 12, pp. 53-59, Nov. 2021.

[https://doi.org/10.9708/jksci.2021.26.12.053]

-

S. H. An and O. R. Jeong, "A Study on the Psychological Counseling AI Chatbot System based on Sentiment Analysis", Journal of Information Technology Services, Vol. 20, No. 3, pp. 75-86, Jun. 2021.

[https://doi.org/10.9716/KITS.2021.20.3.075]

-

K. Kim, J. Moon, and U. Oh, "Analysis and Recognition of Depressive Emotion through NLP and Machine Learning", The journal of the convergence on culture technology, Vol. 6, No. 2, pp. 449-454, May 2020.

[https://doi.org/10.17703/JCCT.2020.6.2.449]

- AI Hub, "Wellness dialogue script datasets", https://www.aihub.or.kr/aihubdata/data/view.do?currMenu=115&topMenu=100&dataSetSn=26, . [accessed: Jan. 13, 2025]

-

J. A. Russell, "A Circumplex Model of Affect", Journal of Personality and Social Psychology, Vol. 39, No. 6, pp. 1161-1178, Dec. 1980.

[https://doi.org/10.1037/h0077714]

-

C. Kim and H. Jung, "GPT-based Data Augmentation Method for Improving Emotion Analysis Model Performance", Journal of KIIT, Vol. 22, No. 1, pp. 61-69, Jan. 2024.

[https://doi.org/10.14801/jkiit.2024.22.1.61]

-

S. Park, et al., "KLUE: Korean Language Understanding Evaluation", arXiv:2105.09680, , May 2021.

[https://doi.org/10.48550/arXiv.2105.09680]

-

Y. Liu, M. Ott, N. Goyal, J. Du, M. Joshi, D. Chen, O. Levy, M. Lewis, L. Zettlemoyer, and V. Stoyanov, "RoBERTa: A Robustly Optimized BERT Pretraining Approach", arXiv:1907.11692, , Jul. 2019.

[https://doi.org/10.48550/arXiv.1907.11692]

- AI Hub, "Emotional conversation corpus", https://aihub.or.kr/aihubdata/data/view.do?currMenu=115&topMenu=100&aihubDataSe=realm&dataSetSn=8, . [accessed: Apr. 01, 2025]

2020년 3월 ~ 현재 : 경상국립대학교 컴퓨터공학과 학사과정

관심분야 : 웹 개발, 인공지능

2020년 3월 ~ 현재 : 경상국립대학교 컴퓨터공학과 학사과정

관심분야 : 자연어 처리, 인공지능

2020년 3월 ~ 현재 : 경상국립대학교 컴퓨터공학과 학사과정

관심분야 : 자연어 처리, 인공지능

2020년 3월 ~ 현재 : 경상국립대학교 컴퓨터공학과 학사과정

관심분야 : 자연어 처리, 인공지능

2010년 2월 : 광주과학기술원 정보기전공학부(공학석사)

2017년 8월 : 광주과학기술원 전기전자컴퓨터공학부(공학박사)

2018년 3월 ~ 현재 : 경상국립대학교 컴퓨터공학과 부교수

관심분야 : 컴퓨터 그래픽스, 증강현실, 인공지능