4D 이미징 센서를 활용한 인공지능 기반 낙상 감지 모니터링 시스템 연구

초록

본 연구에서는 낙상을 효과적으로 검출하기 위해 4D 이미징 레이더 센서와 인공지능(AI) 기반의 비접촉 낙상 감지 시스템을 제안하였다. 이 시스템은 레이더 센서를 통해 추출한 Point Cloud 데이터를 가공하여 신체의 위치와 자세를 분석하며, CNN 모델을 활용한 서기, 앉기, 눕기 등의 자세를 분류한 후 낙상과 천천히 눕는 동작을 구별하기 위해 속도 및 위치 변화를 비교하는 판별 기준을 수립하였다. 이에 대한 결과로는 낙상 감지 정확도 90%, 자세 분류 정확도 98.66%를 달성하였다. 더불어, 웹 기반 인터페이스와 Unity 엔진을 활용한 아바타 시뮬레이션을 통합하여 사용자 친화적인 실시간 모니터링 환경을 제공하고자 하였다. 향후 연구에서는 다양한 환경에서 추가적인 검증을 수행하고, 낙상의 단계를 더욱 세분화하는 한편, 레이더 센서 외에 추가적인 센서를 융합하여 통합 헬스케어 플랫폼으로 발전시킬 필요가 있다.

Abstract

This study, we propose a non-contact fall detection system based on a 4D imaging radar sensor and artificial intelligence (AI) to effectively detect falls. This system processes Point Cloud data extracted from the radar sensor to analyze body position and posture. It classifies standing, sitting, and lying postures using a CNN model and establishes a discrimination criterion by comparing velocity and positional changes to differentiate between falls and slow lying movements. As a result, the system achieved a fall detection accuracy of 90% and a posture classification accuracy of 98.66%. Furthermore, a user-friendly real-time monitoring environment was developed by integrating a web-based interface and an avatar simulation using the Unity engine. Future research should focus on additional validation in diverse environments, further segmentation of fall stages, and integrating additional sensors beyond radar to evolve into a comprehensive healthcare platform.

Keywords:

4D imaging radar sensor, point cloud, CNN model, fall detectionⅠ. 서 론

전 세계적으로 확산하고 있는 인구 고령화로 인한 1인 가구 증가 같은 사회적 변화는 여러 분야에서 문제를 일으킬 뿐만 아니라 다양한 시사점들이 나타나고 있다. 이러한 변화들은 경제, 사회 복지, 주거 환경, 노동 시장 등 여러 측면에서 중요한 영향을 미치고 있으며, 그에 따라 새로운 정책과 기술적 접근이 필요하다는 것을 의미한다[1]. 이러한 사회적 현상은 국가 전체의 의료 복지 비용이 증가할 뿐만 아니라 사회적 비용이 급격히 증가하는 국가적 문제로 대두되고 있다[2][3].

고령자 1인 가구는 배우자 사망, 자녀 독립, 또는 개인의 독립성과 자율성을 보장받기 위한 선택 등으로 증가하고 있는 추세이다[4]. 이런 변화는 개인의 생활 방식에 있어서도 변화가 있지만, 동시에 일상생활에서 사고의 위험에 노출되거나 응급 상황에 적절히 대처하지 못하는 등의 위험성과 불편성도 동반하고 있다. 고령자 1인 가구는 신체적 기능의 저하, 사회적 고립, 그리고 응급 상황에서의 대응 부족 등으로 발생한다. 특히 일상생활에서의 낙상, 질병, 사고 등이 발생할 경우 빠른 대처가 어렵기 때문에 즉각적인 도움을 받을 수 있는 환경과 안전망 구축이 필요하다.

특히 고령자들이 신체 노화로 인한 인지 및 운동 기능 저하로 인한 낙상은 근육량과 근력이 감소하면서 균형을 유지하기 어려워지고, 시력이 약해져 장애물을 인식하는 능력도 저하되며, 관절염 등으로 인해 움직임이 둔화로 발생할 수 있다[5]-[7]. 낙상은심각한 부상이나 사망, 특히 고관절 골절과 같은 부상은 이동성을 크게 제한할 뿐만 아니라 자립성이 감소되고 우울증과 같은 정신 건강 문제를 일으킬 수 있다[8][9].

최근 고령자의 안전을 모니터링하고 낙상 사고 발생 시 즉각적으로 대응할 수 있는 스마트 헬스케어 서비스가 전 세계적으로 중요한 연구 분야로 주목받고 있다. 고령화 사회의 가속화와 1인 가구 증가라는 사회적 변화 속에서 고령자의 안전을 보장하고 삶의 질을 향상시키기 위한 기술적 해결책의 필요성이 대두되고 있는 것이다. 이는 다양한 기술적 장치와 모니터링 시스템을 활용하여 실시간 안전 관리와 위급 상황 발생 시 즉각적인 대응으로 고령자의 삶의 질을 향상시키고 안전을 보장하고자 노력하고 있다[10][11].

낙상 감지 방식은 신체 접촉식과 비접촉식으로 나뉜다. 접촉식 예로는 웨어러블 디바이스를 이용한 낙상 감지는 사용자에게 별도의 센서를 신체에 부착하여 생체 데이터를 지속적으로 모니터링하고 실시간으로 낙상을 감지하는 기술이다[12][13]. 이 과정에서 고령자들은 이질감을 느끼거나 일상생활에서 부자연스러운 활동을 초래하거나 배터리 지속 시간이 제한적이어서 장기간 사용 시 충전이나 교체에 대한 불편하다는 단점이 있다[14][15].

비접촉식 예로는 카메라를 활용한 낙상 감지 기술로, 주변 환경을 실시간으로 카메라를 사용하여 낙상 감지하는 시스템이다[16]-[19]. 카메라를 사용하기 때문에 사용자가 따로 웨어러블 장비를 착용할 필요가 없으며, 일상적인 활동 중에도 자유롭게 사용할 수 있다는 장점이 있다. 그러나 이러한 카메라 기반 서비스는 사생활 침해의 우려가 있을 수 있으며, 특정 환경에서는 조명이나 각도 등 여러 요인에 의해 카메라의 작동이 불안정해질 가능성도 있다는 단점이 있다[20][21].

본 연구에서는 웨어러블 디바이스를 활용한 접촉식 방식의 불편함과 카메라 기반 비접촉식 방식의 사생활 침해 우려를 보완하기 위해 레이더 센서를 활용하여 문제를 해결하기 위한 새로운 접근법을 제안한다. 레이더 센서를 통해 공간 좌표로 구성된 Point Cloud 데이터를 획득하여 사용자의 움직임을 감지함으로써, 일상적인 활동의 자유를 보장하면서도 사생활 침해 문제를 효과적으로 해결하고자 하였다.

레이더 센서는 고주파 신호를 방출한 후 반사된 신호를 분석하여 대상의 위치, 속도, 움직임을 감지하는 비접촉식 센서로, 낙상과 같은 급작스러운 움직임을 신속하고 정확하게 감지하여 감지 정확도를 높일 수 있다. 이 기술은 빛의 유무와 관계없이 신체의 움직임을 감지할 수 있어 다양한 환경에서 안정적으로 작동하며, 사생활 침해 문제를 해결할 수 있는 장점을 가지고 있다.

레이더 센서로부터 획득한 Point Cloud 데이터를 이용하여 사람들의 자세 분류를 위한 패턴 추출은 3차원 데이터를 포함한 공간 정보를 유지한 상태로 학습이 가능한 효율적인 모델 CNN(Convolutional Neural Network)을 이용하였다. CNN의 특징은 공간 불변성(Spatial invariance)을 지니고 있기 때문에 동일한 패턴을 Point Cloud 데이터 내의 위치와 상관없이 다양한 각도나 위치에서 관찰된 사람의 자세를 일관되게 분류할 수 있다. 이러한 연구를 바탕으로 레이더 센서와 CNN 기반 인공지능 모델을 활용한 낙상 감지 모니터링 시스템을 제안하였다.

Ⅱ. 재료 및 방법

2.1 레이더 특성

본 연구에서는 표 1에서 나타낸 Smart Radar System사의 Retina-4sn 레이더를 활용하였다. Retina-4sn은 물체의 위치, 속도, 크기, 높이 등 4차원 정보를 제공하는 고해상도 4D 이미징 레이더로, 물체의 윤곽과 높이를 효과적으로 식별할 수 있는 장점을 가지고 있다. 이러한 특징은 인간의 다양한 자세(서 있는 자세, 앉은 자세, 눕는 자세 등)를 정밀히 분석하는 데 적합하다.

4D 이미징 레이더는 77~81GHz 주파수 대역(고주파 밀리미터파)을 사용하여 높은 해상도와 정확성을 제공하고, 수평, 수직으로 높은 각도 해상도를 통해 정밀한 물체 감지가 가능하다. 이 레이더를 이용하여 사람을 탐지할 경우 거리 12m, 영역 범위 7m × 7m 에서 안정적으로 모니터링이 가능하다. 물체의 윤곽을 상하좌우로 모니터링 방위각과 고도각은 90°(±45°)로 설정되어 있다. 데이터 업데이트 속도는 50msec로, 초당 여러 프레임을 처리할 수 있어 빠르게 변화하는 환경에서도 실시간 대응이 가능하다.

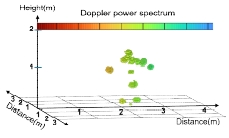

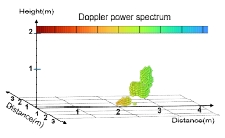

4D 이미징 레이더는 탐지된 물체의 움직임을 분석하고, 이를 3차원 가상 공간에 재배치하여 Point Cloud 데이터를 생성한다. 이 과정은 물체의 위치와 형태를 시각적으로 표현하여 공간적 이해를 돕고 데이터 분석의 효율성을 높인다.

이것은 고해상도 4D 이미징 기술과 빠른 데이터 처리 속도를 통해, 실시간으로 움직임을 탐지하고 다양한 자세를 분석할 수 있는 강력한 도구를 제공한다. 이러한 특성은 낙상 감지와 같은 응용 분야에서 신뢰성 높은 데이터 기반 분석을 지원하며, 안전 모니터링 시스템 개발에 핵심적인 역할을 할 것으로 기대된다.

2.2 실험 환경 및 Point Cloud 데이터 수집

본 연구에서는 레이더를 활용하여 사람의 자세를 분류하는 인공지능 모델을 개발하기 위해, Point Cloud 데이터 수집 과정을 체계적으로 계획하고 실행하였다. 이를 위해 다양한 환경 조건을 반영한 실험 환경을 설계하였으며, 이는 효과적인 데이터 수집뿐만 아니라 실제 활용 상황에서 모델 성능을 최적화하기 위해 필요하다.

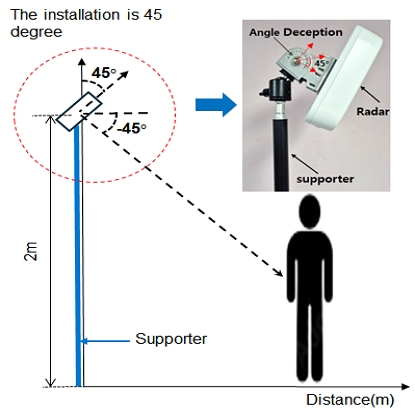

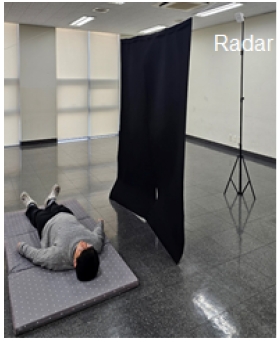

실험은 레이더의 설치 높이, 방향, 기울기, 및 측정 공간의 범위를 최적화하는 것이 중요하다. 본 연구에서는 레이더 성능을 극대화할 수 있는 최적의 데이터를 확보하기 위해, 제조사가 권장한 설치 높이인 2m로 레이더를 그림 1과 같이 설치하였다.

이는 레이더 신호의 수신 각도를 최적화하고 장애물로 인한 간섭을 최소화할 수 있는 조건으로 레이더의 정확성과 신뢰성을 높이는 데 중요한 역할을 하였다. 특히, 2m 높이는 인간의 주요 신체 부위를 정면에서 효과적으로 포착할 수 있는 높이로 상체와 하체의 움직임을 균일하고 효율적으로 감지할 수 있다.

레이더 방향은 감지 대상을 정면으로 조준하여 신호 간섭을 최소화하고, 감지 대상의 움직임을 보다 정밀하게 측정하기 위해 직접 경로에서 오는 신호를 정확히 수신할 수 있도록 설정하였다.

또한, 레이더 기울기는 감지 대상이 레이더 범위의 중심에 정확히 위치하도록 하여 감지 정확도를 높이는 동시에, 신호 반사율을 최적화하여 데이터 손실을 최소화할 수 있는 -45도로 조정하였다. 이러한 기울기는 눕는 자세와 같이 지면에 가까운 동작에서도 충분한 Point Cloud 데이터를 안정적으로 확보할 수 있다. 이 기울기 설정은 기존 연구에서 보고된 경사각 30~60도 범위에서 신호 반사가 가장 효과적으로 이루어진다는 선행 연구의 결과와도 부합하는 것이다[22][23]. 이와 같은 환경 조건은 레이더 데이터의 품질을 극대화하고, 수집된 데이터가 모델 학습에 적합하도록 체계적으로 정제되었다. 이로써 인공지능 모델의 학습 효율성과 성능을 동시에 강화할 수 있다.

본 연구에서는 물체의 움직임을 감지하고 분석하기 위한 3차원 가상 공간의 Point Cloud 데이터를 수집하였다. 이를 위해 레이더 감지 범위를 좌우 3m×정면 7m로 설정하고, 외부 요인에 의한 간섭을 최소화하여 감지 대상의 움직임을 정확히 포착함으로써 품질을 최적화하는 데 중점을 두었다.

먼저, 레이더 감지 범위의 가장자리에서 데이터를 안정적으로 수집할 수 있는지를 평가하기 위해 설정된 감지 범위(좌우 최대 3m, 정면 최대 7m) 내에서 Point Cloud 데이터를 수집하였다. 실험 결과, 좌우 2.5m를 초과하는 범위에서는 데이터 안정성이 감소하는 현상이 나타났다. 감지 거리를 1m에서 7m까지 1m간격으로 증가시키며 Point Cloud 데이터의 점 개수와 밀도를 정량적으로 측정하였다.

표 2에 나탄난 결과를 통해 다음과 같은 특징을 확인할 수 있다. 1~3m 범위에서는 Point Cloud의 점 개수는 한 프레임당 700~1500개이고, 비교적 높은 점 밀도를 유지하고 균일한 데이터의 공간적 분포를 유지하였다. 특히, 2~3m 범위에서는 데이터의 정밀성과 안정성을 모두 확보되어 자세 분류와 같은 신체의 세부적인 움직임을 효과적으로 포착할 수 있는 최적의 위치로 나타났다. 반면, 1m 거리에서는 점 개수와 밀도는 높았으나, 감지 거리가 짧아 하반신 데이터 손실이 빈번하게 발생하여 데이터 품질이 저하되었다. 또한 4~5m 범위에서는 점 간 간격이 불균일해지고 밀도가 점진적으로 감소하였다. 6m 이상에서는 점 개수와 밀도가 급격히 감소하여 데이터 품질이 현저히 저하되었다.

이 실험 결과는 감지 대상과 레이더 간의 거리가 Point Cloud 데이터의 품질과 신뢰성에 직접적인 영향을 미친다는 점을 명확히 보여주고 있다. 따라서, 신뢰성 있는 데이터 수집을 위해 적절한 감지 거리를 설정하는 것이 중요하다.

이러한 실험 설계를 통해 감지 범위 내 데이터 품질 변화를 정량적으로 분석함으로써, 본 연구에서 활용될 인공지능 학습에 적합한 고품질 데이터를 안정적으로 확보할 수 있었다. 이 결과는 레이더 기반 데이터 수집 시스템의 설계 및 최적화에 중요한 기준을 제공하며, Point Cloud 데이터의 활용 가능성을 높이는 데 기여할 것이다.

본 연구에서는 표 3에 제시된 바와 같이, Point Cloud 데이터를 standing, sitting, lying down으로 분류하여 인공지능 학습에 사용하기 위한 자세 데이터를 생성하였다. 또한, 불규칙하거나 명확히 분류되지 않은 동작은 unknown 범주로 분류하여 별도로 관리하였다. 이러한 분류 체계는 데이터의 품질을 유지하고 학습 모델의 정확성을 향상시키는 데 기여한다. 전체적으로 사람의 자세 분류 데이터 구축에서의 Standing은 대상이 서 있거나 걷는 동작을 포함하며, 정적 자세와 동적인 자세 변화를 모두 포함하도록 하였다. Sitting은 대상이 의자에 앉아 있는 상태를 기준으로 수집되었으며, 안정적인 자세뿐만 아니라 앉은 상태에서 발생할 수 있는 미세한 움직임도 포함하였다. Lying down은 평평한 바닥에 누운 상태를 기준으로 수집되었으며, 천천히 눕는 과정을 측정하여 데이터를 확보하였다.

이러한 데이터는 급작스러운 낙상과 자연스럽게 눕는 동작 간의 차이를 효과적으로 구별하는 데 활용할 수 있을 것이다.

이와 같은 데이터 구축으로 낙상 감지에 대한 높은 정확도를 보장하고, 오탐지와 미탐지를 최소화가 가능하다. 데이터 수집은 레이더 센서를 활용하여 30 frame/sec 속도로 진행되었으며, 각 자세에서 50초 동안 데이터를 수집하여 자세당 약 1,500프레임을 확보하였다. 연속적인 동작 측정을 통해 다양한 자세 변화와 특성을 포함할 수 있도록 설계되었다. 구축된 데이터는 자세 데이터의 신뢰성을 강화할 뿐만 아니라, 다양한 환경에서의 일반화를 가능하게 하여 인공지능 모델이 각 자세를 높은 정확도로 분류할 수 있는 견고한 학습 기반을 제공할 수 있을 것이다.

2.3 Point Cloud 데이터 전처리

레이더 센서를 통해 수집된 Point Cloud 데이터를 인공지능 모델 학습에 활용하기 위해서는 체계적인 전처리 과정이 필요하다. Point Cloud 데이터는 위치, 속도, 시간, 도플러 파워와 같은 여러 가지 정보를 포함하는 고차원적이고 복잡한 정보를 가지고 있다. 만약 원시 데이터를 인공지능 학습 모델에 입력할 경우, 과적합(Overfitting)이나 학습 효율 저하와 같은 문제가 발생할 가능성이 높다. 따라서 데이터를 효과적으로 전처리하여 노이즈를 제거하고, 학습 모델에 필요한 핵심 정보를 추출함으로써 학습 성능을 최적화하고 안정성을 확보하는 것이 중요하다.

본 연구에서는 효과적인 학습과 계산 효율성을 확보하기 위해 Point Cloud 데이터 중 자세 분류와 직접적으로 관련된 공간 위치 정보만을 활용하여 데이터 전처리 과정을 수행하였다. 이러한 접근은 인공지능 모델 기반 모니터링 시스템과 실시간 서비스 제공을 위해 데이터 처리 속도를 최적화하는 데 매우 유용하다.

즉, 데이터를 단순화함으로써 학습에 필요한 계산 비용을 줄이고, 모델의 처리 효율성을 향상시켜 실시간 성능을 보장할 수 있다. 이와 같은 전처리 전략은 불필요한 정보로 인한 학습 모델의 복잡성을 줄이며, 동시에 핵심적인 데이터만을 학습에 활용함으로써 모델의 정확성과 실용성을 극대화하는 데 기여할 수 있다.

Point Cloud의 위치 정보는 대상의 행동과 움직임 정도에 따라 샘플 수에 차이가 발생하기 때문에, 모든 데이터를 일정한 길이로 정규화하는 과정이 필요하다. 감지 대상의 행동 패턴이 다양할 경우, Point Cloud에서 생성되는 데이터의 양은 시간에 따라 변동한다. 예를 들어, 빠르게 움직이는 대상은 레이더가 더 많은 포인트를 생성하는 반면, 정적인 상태에서는 생성되는 포인트 수가 감소한다. 이러한 데이터의 불균형은 모델 입력 데이터 간 일관성을 저하시켜, 학습 성능에 부정적인 영향을 미칠 수 있다. 따라서 데이터 정규화와 균형 조정 과정을 통해 학습 데이터의 품질을 개선하고, 모델이 다양한 행동 패턴에 대해 보다 안정적으로 작동할 수 있도록 한다.

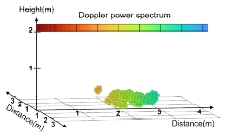

먼저, 모든 데이터를 일정한 길이로 정규화하기 위해, 레이더 센서로부터 각 프레임별로 수집 및 저장된 Point Cloud 데이터를 그림 2(a)와 같이 시각화하였다. 데이터 수집 50초 동안 1,500프레임으로 수집되었다.

Normalization to a constant length data size using zero padding (a) Before zero padding (b) After zero padding

각 프레임에서 수집된 Point Cloud 개수 𝑁은 표 2에서 나타낸 바와 같이 200개~1,500개 범위로 분포한다. 딥러닝 모델에서 입력 데이터는 일정한 크기를 유지해야 하므로 길이가 다른 입력 데이터를 정규화하는 과정이 필요하다. 이를 위해 𝑁=500개 이하인 모든 프레임에 대해 동일한 길이(𝑁=500)로 맞추는 정규화 방식을 뒤쪽 제로 패딩(Back padding) 기법을 활용하였다. 그림 2(b)에 보여준 이 방식은 데이터 길이가 부족한 경우, 부족한 부분을 숫자 ‘0’으로 채워 입력 데이터를 동일한 크기로 조정한다. 이 방법은 원본 데이터에 인위적인 값을 추가하지 않으면서도 모델 학습의 효율성을 높이고, 데이터 일관성을 확보할 수 있다는 장점을 제공한다. 이를 통해 다양한 길이를 가진 Point Cloud 데이터가 딥러닝 모델에 적합하게 변환되어, 학습 및 추론 과정에서 안정성과 성능이 향상될 것으로 기대된다.

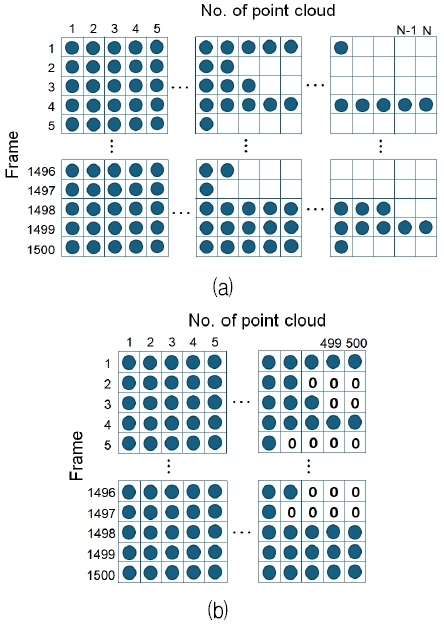

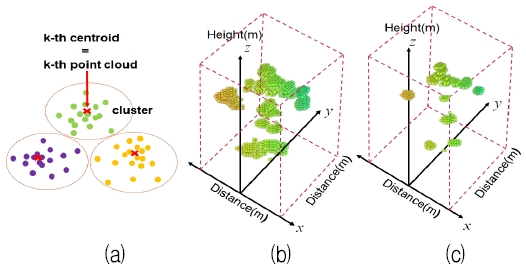

또한, Point Cloud 개수가 𝑁=500개를 초과하는 경우, 데이터를 𝑁=500으로 정규화하기 위해 K-means 클러스터링 알고리즘을 활용하였다. 이 과정에서 Point Cloud 데이터를 𝑘=500개의 클러스터로 나누는 전처리 방법을 그림 3(a)에서 보여주고 있다. 이 방법은 과도한 데이터를 클러스터링하여 각 클러스터의 중심점(Centroid)을 새로운 Point Cloud 데이터로 활용함으로써, 데이터의 핵심 정보를 유지하면서도 포인트 개수를 효과적으로 줄일 수 있다. 이를 통해 학습 데이터의 일관성을 확보하고, 고차원 데이터를 처리하는 딥러닝 모델의 효율성을 높일 수 있다.

Visualization of clusters in 3D point cloud space (a) k-means clustering (b) Visualization of Point Cloud data before clustering (c) Visualization of Point Cloud data after clustering

또한, 이러한 과정은 학습 모델이 다양한 데이터 분포를 효과적으로 다룰 수 있도록 지원하며, 데이터 품질 저하 없이 정규화를 수행할 수 있다는 장점을 제공한다. 결과적으로, 이 방식은 데이터 전처리 단계에서 정밀성과 효율성을 동시에 확보하는 중요한 방법으로 활용될 수 있다.

그림 3(b)는 K-means 클러스터링을 적용하기 전 Point Cloud의 분포를 보여주고 있다. 이 단계에서는 데이터의 밀도와 위치가 불규칙하게 분포되어 있으며, 이것은 인공지능 모델의 효율적인 학습을 저해할 수 있다. 그리고 그림 3(c)는 K-means 클러스터링을 적용하여 새로운 Point Cloud 데이터(𝑁=500)를 적용하여 불규칙성을 해결한 결과를 보여주고 있다. 이 과정을 통해 데이터는 동일한 길이로 정규화되어, 인공지능 모델 학습에 적합한 입력 데이터를 제공할 수 있게 된다.

일반적으로 레이더 신호는 유사한 신체 자세에서도 발생하는 미세한 차이와 신호의 왕복 시간 지연으로 인해 데이터의 수집 순서가 무작위로 나타나는 경향이 있다. 레이더는 신호를 전송한 뒤 반사된 데이터를 수신하여 위치 정보를 계산하지만, 반사 신호의 순서는 대상의 움직임이나 물체와의 거리 변화에 따라 달라질 수 있다.

특히, 신체의 미세한 움직임이나 회전에 의해 반사 신호의 순서가 예측할 수 없는 왜곡을 초래할 수 있으며, 이러한 무작위 데이터 정렬은 학습 모델의 입력 데이터 일관성을 저하시킬 수 있다. 이로 인해, 데이터의 위치 패턴을 학습하는 데 강점을 가진 CNN 모델의 경우, 일관된 패턴을 학습하기 어려워 학습 성능의 저하로 이어질 가능성이 크다.

이를 해결하기 위해 본 연구에서는 순서 왜곡 문제를 해결하고 데이터의 일관성을 확보하기 위해 [24]의 연구에서 제안된 데이터 정렬 방법을 적용하였다. 이 정렬 과정은 데이터의 순서를 재구성하여 학습 모델이 효율적으로 패턴을 학습할 수 있도록 지원하며, 최종적으로 모델의 성능을 향상시키는 데 기여한다. 각 프레임의 Point Cloud 데이터는 3차원 공간에서의 좌표값으로 표현된다. 각 프레임 내의 여러 점들이 Point Cloud를 형성하며, 이는 pi=(xi, yi, zi), i=1, 2, ...,N(여기서 xi, yi, zi는 각 포인트의 공간 좌표)과 같은 형식으로 구성된다.

| (1) |

본 연구에서는 데이터를 체계적으로 정렬하기 위해 Point Cloud 데이터 pi는 식 (1)과 같이 오름차순 정렬을 수행한다.

식 (1)은 세 개의 좌표를 가지는 벡터 (xa, ya, za)와 (xb, yb, zb)간의 사전식 순서를 정의한 표현이다. 즉, 벡터 (xa, ya, za)가 (xb, yb, zb)보다 "작다"는 것을 결정하는 규칙을 나타낸다. 각 데이터 포인트 (xa, ya, za)와 (xb, yb, zb)는 다음과 같은 우선순위를 기준으로 정렬된다. 식 (1)-a 첫 번째 좌표가 작으면, xi 값을 기준으로 오름차순 정렬을 수행하였고, 식 (1)-b 첫 번째 좌표가 같고 두 번째 좌표가 작으면 yi 값을 기준으로 추가 정렬하였다. 마지막으로, 식 (1)-c 앞 두 좌표가 같고 세 번째 좌표가 작으면 zi 값을 기준으로 정렬하여 데이터의 순서를 체계화하였다.

이에 대한 정렬 결과는 표 4(a)의 정렬 전 상태와 표 4(b)의 정렬 후 상태를 나타냈다.

이때, 점들 사이의 실제 거리나 상대적 위치는 변하지 않으며, 단지 입력 순서만 재배치되는 것이다.

이를 통해 Point Cloud 데이터의 순서를 체계적으로 정렬할 수 있으며, 정렬 결과는 데이터의 일관성을 유지하면서 CNN 모델의 입력 순서에 체계를 부여하여 모델이 효과적으로 패턴을 학습하고 성능을 극대화할 수 있도록 돕는 역할을 한다. 본 연구에서 적용한 데이터 정렬 및 길이 균일화 기법은 데이터의 무작위성을 제거하고 일관된 입력 형태를 유지함으로써, 구축된 데이터셋이 높은 학습 정확도와 신뢰성을 보장하도록 하였다.

2.4 인공지능 모델 설계

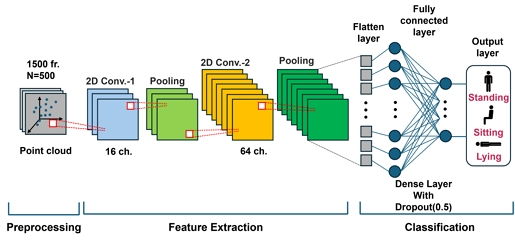

본 연구에서 낙상 감지를 위해 사용되는 3가지 자세(Standing, Sitting, Lying)를 분류하는 CNN 아키텍처는 그림 4에 보여주고 있다. 이는 Point Cloud 데이터의 복잡한 공간적 특징을 효과적으로 학습하도록 설계되었으며, 자세를 높은 정확도로 분류할 수 있는 성능을 제공한다.

CNN의 입력 전처리(Preprocessing) 단계에서는 zero padding, k-means 클러스터링 등을 활용하여 Point Cloud 데이터를 일정한 형태로 정렬하고, 노이즈를 줄이며, 보다 안정적인 인식에 유리한 형태로 변환한다.

특징 추출(Feature extraction) 단계에서는 먼저 변환된 Point Cloud 데이터를 2차원 배열로 매핑한 뒤, 16채널의 첫 번째 2D 합성곱(Convolution) 레이어(2D Convolution-1)를 적용한다. 이를 통해 입력 데이터 내 위치적·공간적 특징을 추출하기 시작한다. 이어 합성곱 레이어를 통과한 특징 맵(Feature map)에 대해 풀링(Pooling)을 수행함으로써 데이터 크기를 줄이고, 불필요한 세부 정보를 제거하면서도 핵심 특징은 유지한다.

다음으로 두 번째 합성곱 레이어에서는 64채널을 적용하여 이전보다 더욱 추상적이고 복잡한 특징을 학습한다. 다시 풀링을 적용해 특징 맵의 차원을 줄이고 연산 효율을 높인다. 이러한 반복적 특징 추출 과정을 통해 기본 패턴이나 단순한 구조적 특징을 학습하고, 갈수록 자세를 구분하는 데 필요한 더욱 복잡한 특징들을 추출할 수 있게 된다. 여기서, 각 합성곱 계층은 활성화 함수로 Leaky ReLU를 사용하여 Point Cloud 데이터에 포함된 음수 값도 효과적으로 처리하며, 이로써 전체 학습 과정의 안정성을 확보한다.

FC(Fully connected) 계층은 추출된 고차원 특징을 종합적으로 파악하며, 이 과정에서 Dropout을 적용해 과적합을 방지한다. Dropout 확률을 0.5로 설정하여 학습 중 일부 뉴런을 무작위로 비활성화함으로써 특정 뉴런에 대한 의존도를 줄이고, 모델이 훈련 데이터에 과도하게 적응하는 것을 막는다. 이를 통해 모델은 테스트 시에도 안정적인 성능을 보이게 된다.

첫 번째 FC 계층은 128개의 뉴런을 포함하며, 이를 통해 추출된 특징을 바탕으로 자세 분류를 위한 토대를 제공한다. 최종 출력 계층은 3개의 뉴런으로 구성되어 Standing, Sitting, Lying이라는 세 가지 자세 클래스에 대한 예측 확률을 제공한다. 이때, 소프트맥스(Softmax) 활성화 함수를 사용하여 각 클래스별 확률 값을 계산하고, 가장 가능성이 높은 클래스를 최종 예측으로 선택한다.

결론적으로, 본 CNN 아키텍처는 Point Cloud 데이터를 효율적으로 처리하고 자세 클래스를 정확하게 분류하기 위해 설계되었으며, 컨볼루션 계층, 활성화 함수, Dropout 등을 적절히 활용하여 모델의 성능과 일반화 능력을 극대화하고자 하였다.

2.5 낙상 감지 비교 분석

본 연구에서의 낙상 감지 판별은 신체를 구성하는 점들의 Point Cloud 데이터, 즉 (x, y, z) 좌표 정보와 해당 점들의 속도 정보를 이용하였다.

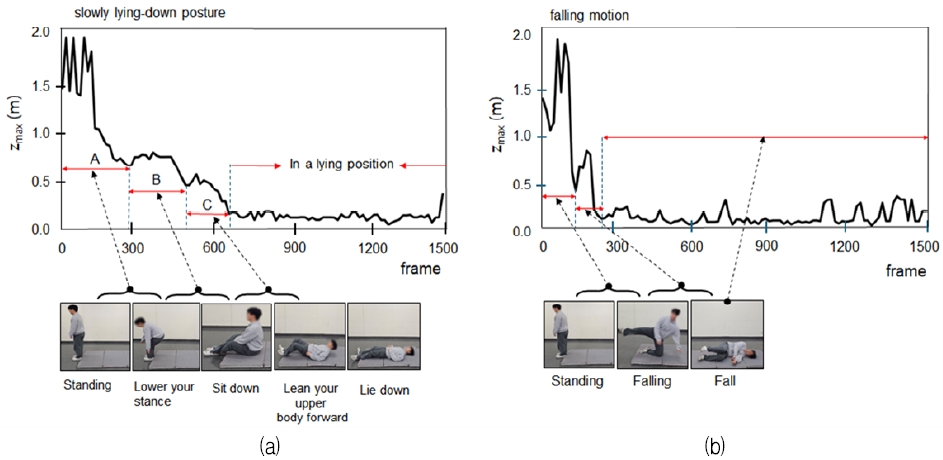

일반적으로 낙상 시에는 지면으로부터 가장 멀리 떨어진 신체 부위(머리의 정수리)의 높이 및 속도 변화가 가장 두드러지게 관찰된다. 그래서 본 연구에서는 정수리(zmax)의 높이와 zmax에서의 속도 변화를 비교·분석함으로써 천천히 눕는 동작과 낙상을 구분하고자 한다.

그림 5는 천천히 눕는 동작과 낙상 시, 시간에 따른 zmax 값의 변화를 비교한 것이다. 그림 5(a)는천천히 눕는 동작(서 있는 자세 → 자세 낮추기(A) → 앉기(B) → 상체를 앞으로 숙이기(C) → 눕기)에서 zmax 값이 점차적으로 감소하는 양상을 보인다. 이 과정에서 ‘서 있는 자세 → 자세 낮추기 → 앉기’ 구간(B)에는 zmax 값이 서서히 줄어들지만, ‘앉기→ 상체를 앞으로 숙이기’ 구간(C)에서는 신체 안정성을 유지하기 위한 의도적인 자세 변화로 인해 zmax 값이 일시적으로 증가하는 현상이 관찰된다. 이는 천천히 눕는 과정에서 신체가 통제된 방식으로 균형을 유지하며 자세를 낮추고 있음을 명확하게 보여준다.

반면 그림 5(b)에서의 낙상 상황에서는 zmax 값이 중간 단계 없이 급격히 하락하는 특성을 보인다. 이는 낙상이 통제되지 않은 상태에서 일어나기 때문에, 짧은 시간 내에 신체가 지면과 급격하게 가까워지며 zmax값 또한 불규칙하고 크게 변동하는 것에 기인한다. 즉, 낙상 동작은 순간적으로 커다란 zmax값 변화 패턴을 나타내며, 이는 정상적인 천천히 눕는 동작과 확연히 차이가 나타나는 중요한 특징으로 활용될 수 있다. 이러한 zmax값의 변화는 정상 동작과 낙상을 판별하는 데 효과적인 지표로 활용될 것으로 기대된다.

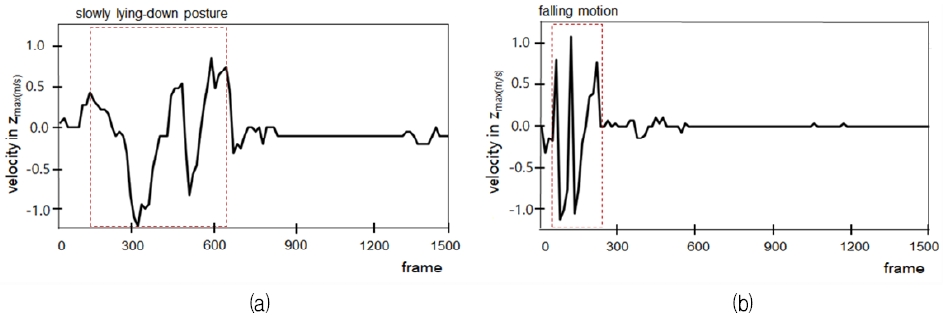

또한, 그림 6은 천천히 눕는 동작과 낙상 동작 간의 신체 속도 변화를 비교한 결과로, zmax에서 관찰되는 속도 변화 패턴 역시 두 경우가 분명히 구분됨을 확인할 수 있었다. 그림 6(a)은 천천히 눕는 상황으로 수백 프레임에 걸쳐 속도 변화 폭이 비교적 완만하고 일정한 패턴을 유지하고 있다. 반면, 그림 6(b)은 낙상이 발생한 상황으로 매우 짧은 시간 내에 속도가 급격하고 불규칙적으로 변하며, 특히 초기 단계에서 큰 변동 폭을 보이는 특성을 나타낸다. 이는 낙상이 통제되지 않은 상태에서 이루어진다는 사실을 의미한다. 이러한 급격한 속도 변화 패턴은 낙상의 물리적 특성을 뚜렷하게 드러내며, 짧은 시간 동안 이루어지는 급격한 속도 변동이 천천히 눕기 동작과 낙상을 구분하는 중요한 기준이 될 수 있음을 보여준다.

본 연구에서 제안한 낙상 감지 판별 방법은 zmax 값의 변화와 속도 변화를 정량적으로 분석함으로써 낙상과 천천히 눕는 동작을 명확히 구분할 수 있음을 확인하였다. 이러한 기준은 단순히 낙상을 감지하는 것에 그치지 않고, 천천히 눕는 동작과 유사한 상황에서 발생할 수 있는 혼동을 최소화함으로써 실시간 낙상 감지 시스템의 정확도를 크게 향상시킬 수 있는 기반을 제공한다.

Ⅲ. 결 과

3.1 자세 분류 모델의 성능 분석 및 평가

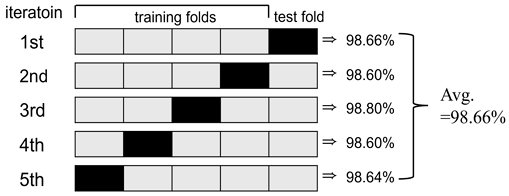

낙상 감지를 위해 사용되는 3가지 자세(Standing, Sitting, Lying)를 분류하는 CNN 모델의 성능을 검증하기 위해 5-Fold 교차 검증을 수행하였다. 그림 7은 5-Fold 교차 검증 과정과 각 반복(Iteration)별 성능 평가 결과를 시각적으로 보여준다.

교차 검증은 주어진 데이터를 5개의 폴드(Fold)로 나누어, 각 반복에서 한 폴드를 테스트용(검정색)으로 사용하고, 나머지 4개의 폴드(회색)를 학습용으로 사용하는 방식으로 진행된다. 각 반복에서의 테스트 폴드는 순환적으로 변경되며, 모든 폴드가 한 번씩 테스트 데이터로 사용된다. 이 과정을 통해 CNN 모델의 평균 성능과 안정성을 측정할 수 있으며, 다양한 데이터 분포에서의 일반화 능력을 평가하는 데 효과적이다.

그림 7에서 볼 수 있듯이, 총 5번의 반복(1st iteration ~ 5th iteration) 동안 테스트 폴드가 순환적으로 변경되며, 각 반복에서 해당 테스트 폴드에 대해 모델의 성능이 평가되었다. 테스트 폴드에 대한 평가 결과, 정확도는 모든 반복에서 일관되게 98% 이상으로 나타났으며, 이는 모델이 데이터 분포에 대해 높은 예측 성능을 보이고 있음을 의미한다.

특히, 그림 7에서 오른쪽 끝에 표기된 각 반복별 테스트 정확도가 이러한 일관성을 보여준다. 5개의 폴드에서 측정된 정확도의 평균은 98.66%로 계산되었으며, 이는 모델이 다양한 데이터 분할에서도 높은 성능과 안정성을 유지하고 있음을 의미한다. 이러한 결과는 제안된 CNN 모델이 낙상 감지와 자세 분류 작업에서 우수한 성능을 발휘하고 있음을 뒷받침한다.

3.2 낙상 감지 알고리즘의 성능 평가

본 연구에서 제안한 낙상 감지 알고리즘을 이용하여 낙상과 천천히 눕는 동작을 분류하는 정확도를 검증하기 위해, 그림 8와 같이 레이더 시스템 정면에 블라인드를 설치하고 낙상 또는 천천히 눕기 동작을 무작위로 수행하는 동안 zmax와 속도 변화를 측정하였다.

10명의 자원자가 각각 눕기(lying)와 낙상(fall) 동작을 무작위로 수행한 결과, zmax값 변화를 기준으로 동작이 주로 일어나는 프레임 수를 측정하였다. 그 결과, 천천히 눕기의 경우 약 80~90프레임 동안 움직임이 관찰되었고, 낙상의 경우에는 약 20~30프레임 사이에서 급격한 변화가 집중적으로 발생하였다.

표 5에 나타낸 바와 같이, ‘눕기 동작’은 10건 모두 'lying'으로 정확히 검출되어 100%의 검출 정확도를 보였지만, ‘낙상 동작’은 10건 중 9건이 정상적으로 'fall'로 검출되었으나, 5번 자원자의 경우 'lying'으로 잘못 검출되는 사례가 1건 발생하였다.

이로 인해 낙상의 검출 정확도는 90%였으며, 전체적으로는 10명의 자원자(눕기 10건 + 낙상 10건) 중 19건을 올바로 검출하여 95%의 정확도를 나타냈다. 또한, zmax의 속도 변화를 관찰한 결과는 천천히 눕기의 경우 80~90프레임에 걸쳐 속도의 순간 변화율 방향이 서서히 변하는 양상을 보였다. 속도 범위 또한 대체로 ±0.8 m/sec 전후로 상대적으로 완만하게 변화하며, 이것은 몸이 서서히 바닥에 닿는 눕기 동작의 특징을 반영한다.

반면, 낙상의 경우 20~30프레임 짧은 시간 동안 속도의 순간 변화율 방향이 급격히 변한다. 속도 범위가 최대 ±2.3 m/sec에 이를 정도로 짧은 구간에서 크게 출렁이며, 이는 낙상 시 갑작스러운 충돌이 발생함을 잘 보여주는 것이다. 표 6의 5번 자원자에서 오검출 사례가 확인되지만, 대체로 낙상 동작은 급격한 속도 변화 패턴을 통해 구분 가능함을 알 수 있다.

Analysis of slowly lying down posture and falling states based on velocity changes observed at zmax and frame data

전체적으로 zmax와 속도 변화에서 천천히 눕기 동작은 100%의 검출 정확도를 보였으며, 낙상의 경우 5번째 자원자에 대해서 낙상을 천천히 눕기로 검출하는 오류가 발생하여 낙상 검출 정확도는 90%의 검출 정확도를 나타냈다. 이 오류는 zmax와 속도 변화가 발생하는 프레임(시간) 수가 다른 자원자에 비교하여 길어 검출 시 오류가 발생하는 것으로 판단된다.

이러한 결과를 종합하면, 눕기는 긴 시간(80~90프레임)에 걸쳐 서서히 변화하는 속도 패턴을, 낙상은 짧은 시간(20~30프레임) 안에 빠르고 큰 속도 변화를 보이는 패턴을 나타내어, 두 동작 간 명확한 구분이 가능함을 확인할 수 있다.

이와 같이 가림막을 사용한 장애물이 있는 환경 실험에서도 레이더 시스템을 이용한 낙상 감지가 높은 정확도를 유지함을 확인함으로써 다양한 사용자 환경에서 낙상 감지 시스템이 효율적으로 적용될 수 있는 실질적인 가능성을 제시하며, 나아가 레이더 기술이 기존 영상 기반 시스템을 보완하거나 대체하는 기술이 될 것으로 보인다.

3.3 낙상 감지 모니터링 시스템

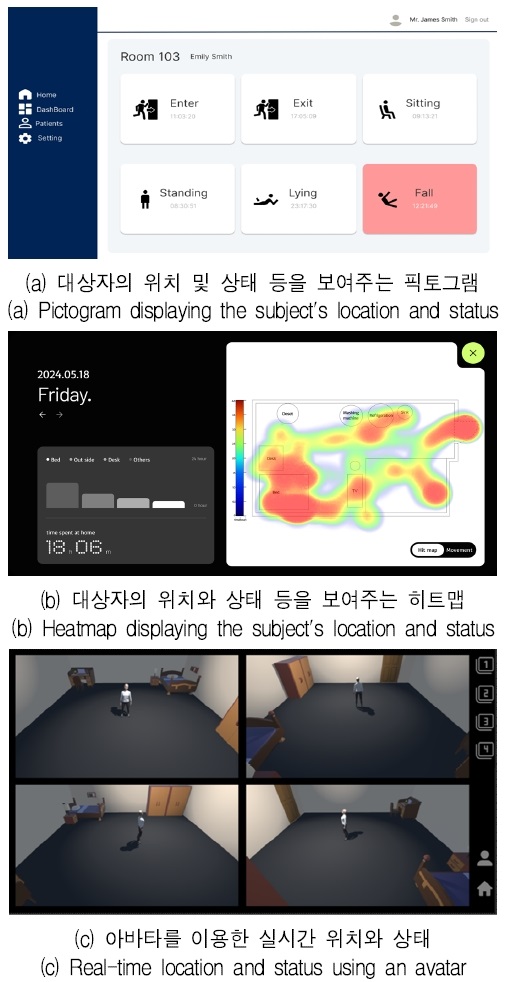

본 연구에서는 인공지능 모델 설계를 기반으로, 세 가지 자세(standing, sitting, lying) 분류 모델과 낙상 감지 알고리즘을 결합하여 레이더 Point Cloud 데이터를 활용한 모니터링 시스템을 개발하였다. 이 시스템은 웹 페이지와 Unity 엔진을 기반으로 구축되었으며, 감지 대상자의 상태를 실시간으로 모니터링하고, 낙상이 발생할 경우 관리자에게 알람을 전달하여 즉각적인 대응이 가능하도록 설계되었다.

웹 기반의 낙상 감지 시스템은 감지 대상자의 정보를 등록하고 조회하며, 실시간으로 대상자의 위치와 상태를 확인할 수 있는 기능을 제공한다. 낙상이 감지되면 시스템은 등록된 비상 연락처로 즉각적인 알림을 전송함으로써 신속한 대응을 지워한다. 특히, 대상자의 위치와 상태는 그림 9 (a),(b)에서 처럼 픽토그램과 히트맵 형태로 시각화하였으며, 이를 통해 대상자의 동선을 직관적으로 파악할 수 있어 건강 이상 징후나 응급 상황을 사전에 예측하는 데 유용하다.

또한 Unity 게임 엔진을 활용하여 개발된 아바타 기반 사용자 인터페이스는 감지 대상자의 실시간 위치와 상태를 직관적으로 확인할 수 있도록 설계되었다. 그림 9(c) 나탄난 것처럼, 아바타는 감지 대상자의 실제 움직임을 반영하면서도 개인의 사생활을 보호할 수 있는 방식을 채택하였으며, 게임 엔진의 특성을 활용하여 추가적인 카메라 설치 없이도 다양한 각도에서 감지 대상의 상황을 확인할 수 있어 사각지대 문제를 효과적으로 해결할 수 있다.

이 시스템은 사용자가 감지 대상자의 상태를 정확하게 파악하고 필요 시 신속하게 조치를 취할 수 있는 환경을 제공한다. 낙상이 발생하면 즉각적인 알림을 통해 긴급 상황에 빠르게 대응할 수 있으며, 카메라 영상 대신 레이더 데이터를 활용하여 개인의 사생활을 보호한다. 또한, Unity 게임 엔진의 확장성을 통해 다양한 사용자 환경과 요구사항에 맞춘 유연한 설계가 가능하다. 결론적으로, 본 연구에서 제안한 시스템은 기존 낙상 감지 기술의 한계를 보완하며, 실시간 모니터링과 응급 대응을 위한 실질적이고 효율적인 솔루션으로 제공할 수 있을 것이다.

Ⅳ. 결 론

본 연구는 레이더 센서와 인공지능 기술을 융합하여 인간의 자세 분류와 낙상 감지를 실시간으로 수행할 수 있는 모니터링 시스템을 제안하고 이를 검증하였다. 특히, 레이더 센서를 활용한 비접촉 방식은 기존 카메라 기반 시스템이 가진 사생활 침해 문제와 웨어러블 기기 사용 시 발생하는 착용 불편함을 효과적으로 해결할 수 있는 가능성을 제시하였다.

본 연구에서 사용된 4D 이미징 레이더는 77~81 GHz 주파수 대역을 사용하며, 짧은 파장을 통해 높은 공간 해상도를 제공하여 사람의 미세한 움직임까지도 정밀하게 감지할 수 있다. 이러한 짧은 파장은 거리와 속도 측정을 더욱 정밀하게 수행할 수 있게 하며, 높은 해상도를 바탕으로 정밀한 물체 감지를 가능하게 한다. 또한, 이 주파수 대역은 옷, 가구, 얇은 벽과 같은 다양한 물체를 투과할 수 있어, 비가시선(non-line-of-sight) 환경에서도 인체 움직임을 효과적으로 감지할 수 있다. 이러한 특성을 가진 레이더를 활용해 일상생활에서의 다양한 인간 자세, 예를 들어 서 있는 자세, 앉은 자세, 눕는 자세 등을 정확히 판별하는 데 사용하였다.

이 연구는 레이더 기반 기술의 실효성을 입증하며, 낙상 감지와 자세 분류와 같은 응용 분야에서 기존 접근법의 한계를 극복할 수 있는 새로운 가능성을 제시하였다.

레이더에서 안정적인 데이터 수집을 위한 실험 결과, 좌우 2.5m를 초과하는 범위에서는 데이터 품질이 저하되어 안정성이 감소하는 것으로 나타났다. 반면, 정면에서의 감지 거리 증가에 따른 데이터 품질 변화와 안정성 평가 결과, 2~3m 범위에서 점 밀도가 데이터의 정밀성과 안정성을 동시에 확보할 수 있는 수준으로 나타났다. 이는 실내 환경에서 인체 자세 분류와 같은 신체의 세부적인 움직임을 효과적으로 포착할 수 있는 적합한 거리임을 의미하는 것이다.

이러한 실험 설계를 통해 감지 범위 내 데이터 품질 변화를 정량적으로 분석함으로써, 본 연구에서 활용될 인공지능 학습에 적합한 고품질 데이터를 안정적으로 확보할 수 있는 기반을 마련하였다.

레이더로부터 획득한 Point Cloud 데이터는 위치, 속도, 시간, 도플러 파워와 같은 다양한 정보를 포함한 고차원적이고 복잡한 구조를 가지고 있다. 이러한 원시 데이터를 인공지능 학습 모델에 직접 입력할 경우, 과적합 또는 학습 효율 저하와 같은 문제가 발생할 가능성이 크다. 그래서 본 연구에서는 효과적인 학습과 계산 효율성을 확보하기 위해, zero padding과 k-means 클러스터링을 활용하여 데이터를 동일한 길이로 정규화하고 데이터를 정렬하여 인공지능 모델 학습에 적합한 입력 데이터로 변환하여 활용하였다.

CNN 인공지능 모델을 활용하여 감지 대상의 현재 상태(Standing, Sitting, Lying)를 분류한 후, 수집된 Point Cloud 데이터에서 zmax의 위치와 zmax에서의 속도 변화를 기반으로 천천히 눕는 동작과 낙상을 구분하는 지표를 도출하였다.

천천히 눕는 경우 zmax 값의 변화는 단계적으로 점진적으로 감소하는 경향을 보였다. 반면에 낙상의 경우 zmax값이 중간 단계 없이 급격히 하락하였다. 이는 천천히 눕는 동작에서 신체가 통제된 방식으로 균형을 유지하며 자세를 낮추는 것을 반영하며, 반대로 낙상에서는 통제되지 않은 상태에서 일어나기 때문에, 짧은 시간 내에 신체가 지면과 급격하게 가까워지면서 zmax값 또한 불규칙하게 나타낸다. 즉, 낙상 동작은 순간적으로 큰 zmax값 변화 패턴을 보여주며, 이는 정상적인 천천히 눕는 동작과 확연히 구분되는 중요한 지표로 활용될 수 있다.

낙상 감지의 성능 검증은 블라인드 테스트 환경에서 수행되었으며, 그 결과 낙상 감지 정확도는 90%, 자세 분류 정확도는 98.66%를 기록하여 신뢰성 있는 감지 기능을 보였다. 이는 레이더 센서의 신호 분석과 인공지능 모델의 학습 과정이 사용자 상태를 효과적으로 분류하고, 낙상을 정확히 감지하는 데 유용하다는 것을 보여주었다. 이러한 성과는 본 시스템이 다양한 환경에서도 안정적으로 동작할 가능성을 제시하며, 향후 가정 환경 및 복잡한 실내 환경에서도 적용이 가능하다는 것을 의미한다.

더불어, 본 시스템은 웹 기반 인터페이스와 Unity 엔진을 활용한 아바타 시뮬레이션을 통합하여 사용자에게 직관적인 시각화와 실시간으로 대응하기 위한 기능을 구현하였다. 웹 인터페이스에서는 감지 대상의 상태를 실시간으로 확인할 수 있을 뿐만 아니라, 기록된 데이터를 활용해 장기적인 건강 상태를 모니터링할 수 있다. Unity 엔진을 활용한 아바타 시뮬레이션은 감지 대상의 실제 움직임을 반영하면서도 프라이버시를 보호하며, 다양한 각도에서 대상자의 상태를 직관적으로 확인할 수 있도록 하였다. 이를 통해 감지 대상자의 상태를 효과적으로 모니터링하고, 건강 관리에 기여할 수 있는 종합적인 솔루션을 구현하였다.

하지만 본 연구는 제한된 실험 환경에서 수행되었기 때문에 가정 환경에서의 충분한 검증 과정이 부족하다는 한계를 보완하기 위한 추가 실험이 필요하다.

첫째, 가정 내 환경은 나무 가구가 있는 거실이나 전자제품이 배치된 주방 등 다양한 요인을 포함하며, 특히 철제 구조물은 레이더 신호를 반사하거나 흡수하여 감지 정확도를 저하시킬 가능성이 있다. 이러한 문제를 해결하기 위해, 다양한 환경에서의 검증 실험과 인체 검출 알고리즘의 보정이 필요하다.

둘째, 현재 시스템은 낙상 감지 이후 일정 시간 동안 움직임이 감지되지 않을 경우 이를 최종 낙상으로 판단하는 방식으로 작동한다. 그러나, 이를 보완하기 위해 정상적인 움직임이 일정 시간 지속될 경우 "낙상 우려 단계"로 분류하거나, 상황에 따라 자동 신고 시스템을 도입하는 등의 낙상 단계 세분화에 대한 추가 연구가 필요하다.

Ⅴ. 향후 과제

향후 연구에서는 본 연구의 한계를 극복하기 위해 시스템을 다양한 환경에서 검증하고, 레이더 신호의 왜곡을 보정할 수 있는 알고리즘을 설계하며, 학습 데이터 세트를 확장하는 작업이 필요하다. 이를 위해 다양한 가정 환경과 사용자 조건을 반영한 데이터를 추가로 수집하고, 이를 학습 데이터로 활용함으로써 인공지능 모델의 일반화 성능을 향상시킬 수 있다.

또한, 레이더 센서 외에 온도 센서, 압력 센서 등을 융합하여 낙상 감지뿐만 아니라 건강 이상 징후를 조기에 감지할 수 있는 통합 헬스케어 플랫폼으로 확장하기 위한 연구가 필요하다. 이러한 연구는 낙상 감지 시스템이 단순히 사고를 감지하는 역할을 넘어, 건강 상태를 모니터링하고 조기에 위험을 경고하는 종합적인 안전 관리 솔루션으로 발전하는 데 기여할 수 있을 것이다.

특히, 고령자 1인 가구의 증가와 같은 사회적 문제를 해결하는 데 중요한 역할을 할 것으로 기대된다. 결론적으로, 본 연구는 실시간 모니터링 시스템의 기술적 가능성을 제시하였으며, 다양한 실제 환경과 고도화된 기술을 반영하여 상용화를 위한 중요한 기초 자료로 활용될 수 있을 것이다.

References

- United Nations Department of Economic and Social Affairs, "Population Division", World Population Prospects 2024. https://www.un.org/development/desa/pd, . [accessed: Feb. 25, 2025]

-

S. Ogura and M. M. Jakovljevic, "Global population aging-health care, social and economic consequences", Frontiers in public health, Vol. 6, pp. 335, Nov. 2018.

[https://doi.org/10.3389/fpubh.2018.00335]

-

S. Harper, "Economic and social implications of aging societies", Science, Vol. 346, No. 6209, pp. 587-591, Oct. 2014.

[https://doi.org/10.1126/science.1254405]

-

J. G. Abell and A. Steptoe, "Why is living alone in older age related to increased mortality risk? A longitudinal cohort study", Age and ageing, Vol. 50, No. 6, pp. 2019-2024, Nov. 2021.

[https://doi.org/10.1093/ageing/afab155]

-

J. R. S. Fhon, et al., "Association between sarcopenia, falls, and cognitive impairment in older people: a systematic review with meta-analysis", Int. J. of environmental research and public health, Vol. 20, No. 5, pp. 4156-4167, Feb. 2023.

[https://doi.org/10.3390/ijerph20054156]

-

M. G. Oytun, et al., "Relationships of fall risk with frailty, sarcopenia, and balance disturbances in mild-to-moderate Alzheimer’s disease", J. of Clin. Neurology, Vol. 19, No. 3, pp. 251-259, May 2023.

[https://doi.org/10.3988/jcn.2022.0219]

-

X. Che, et al., "Association between sarcopenia and cognitive impairment in the older people: a meta-analysis", European Geriatric Medicine, Vol. 13, No. 4, pp. 771-787, Jun. 2022.

[https://doi.org/10.1007/s41999-022-00661-1]

-

S. Kim and E. Kim, "The Effects of Stress and Depression on the Quality of Life in Single Elderly Households", J. Kor. Society for School & Community Health Education, Vol. 19, No. 2, pp. 43-52, Aug. 2018.

[https://doi.org/10.35133/kssche.20180831.04]

-

J.-H. Kim, "Experiences of falling and depression: Results from the Korean Longitudinal Study of Ageing", J. of affective disorders, Vol. 281, pp. 174-182, Feb. 2021.

[https://doi.org/10.1016/j.jad.2020.12.026]

-

L. Z. Rubenstein, "Falls in older people: epidemiology, risk factors and strategies for prevention", Age and ageing, Vol. 35, No. 2, pp. 37-41, Sep. 2006.

[https://doi.org/10.1093/ageing/afl084]

-

X. Wang, J. Ellul, and G. Azzopardi, "Elderly fall detection systems: A literature survey", Frontiers in Robotics and AI, Vol. 7, pp. 1-22, Jun. 2020.

[https://doi.org/10.3389/frobt.2020.00071]

-

J.-G. Cho, "Fall Detection Approach Using Motion Sensors of Smartphone", J. KIIT, Vol. 17, No. 7, pp. 47-54, 2019.

[https://doi.org/10.14801/jkiit.2019.17.7.47]

-

Y. Lee et al., "A real-time fall detection system based on the acceleration sensor of smartphone", Int. J. of Engineering Business Management, Vol. 10, pp. 1-8, Jan. 2018.

[https://doi.org/10.1177/1847979017750669]

-

V.-R. Xefteris, et al., "Performance, challenges, and limitations in multimodal fall detection systems", IEEE Sensors, Vol. 21, No. 17, pp. 18398-18409, Sep. 2021.

[https://doi.org/10.1109JSEN.2021.3090454]

-

M. Villa and E. Casilari, "Wearable Fall Detectors Based on Low Power Transmission Systems", Technologies, Vol. 12, No. 9, pp. 166-196, Sep. 2024.

[https://doi.org/10.3390/technologies12090166]

-

K. D. Miguel, et al., "Home camera-based fall detection system for the elderly", Sensors, Vol. 17, No. 12, pp. 2864-2885, Dec. 2017.

[https://doi.org/10.3390/s17122864]

-

S.-H. Hwang and S. B. Pan, "Fall detection system using the open source hardware and RGB camera", J. KIIT, Vol. 14, No. 4, pp. 19-24, Apr. 2016.

[https://doi.org/10.14801/jkiit.2016.14.4.19]

-

T. Alanazi, K. Babutain, and G. Muhammad, "A robust and automated vision-based human fall detection system using 3D multi-stream CNNs with an image fusion technique", Applied Sciences, Vol. 13, No. 12, pp. 6916-6936, Jun. 2023.

[https://doi.org/10.3390/app13126916]

-

A. Raza, M. H. Yousaf, and S. A. Velastin, "Human fall detection using YOLO: a real-time and AI-on-the-edge perspective", 2022 12th International Conference on Pattern Recognition Systems (ICPRS), Saint-Etienne, France, pp. 1-6, Jun. 2022.

[https://doi.org/10.1109/ACCESS.2019.2941457]

-

L. Ren and Y. Peng, "Research of fall detection and fall prevention technologies: A systematic review", IEEE Access, Vol. 7, pp. 77702-77722, Jun. 2019.

[https://doi.org/10.1109/ACCESS.2019.2922708]

-

G. Koshmak, A. Loutfi, and M. Linden, "Challenges and issues in multisensor fusion approach for fall detection", Sensors, Dec. 2015.

[https://doi.org/10.1155/2016/6931789]

-

H.-W. Kwon, S.-Y. Hong, and J.-H. Song, "Development of radar cross section analysis program for complex structures", J.of the Korean Society of Marine Environment & Safety, Vol. 20, No. 4, pp. 435-442, Aug. 2014.

[https://doi.org/10.7837/kosomes.2014.20.4.435]

-

B. T. Koo, P. J. Park, and S. H. Han, "Trends in Intelligent Radar Technology", Electronics and Tele. Trends, Vol. 36, No. 2, pp. 12-21, Apr. 2021.

[https://doi.org/10.22648/ETRI.2021.J.360202]

-

S. An and U. Y. Ogras, "Mars: mmwave-based assistive rehabilitation system for smart healthcare", ACM Transactions on Embedded Computing Systems (TECS), Vol. 20, No. 5, pp. 1-22, Sep. 2021.

[https://doi.org/10.1145/3477003]

2022년 2월 : 한국폴리텍대학 정보통신공학과(학사)

2024년 2월 : 한국공학대학교 컴퓨터공학과(석사)

2024년 3월 ~ 현재 : 한국공학대학교 컴퓨터공학과 박사과정

2003년 9월 ~ 현재 : ㈜앤트테크놀러지 대표

관심분야 : RF 시스템, 디지털 헬스케어

2024년 2월 : 한국공학대학교 게임공학과(공학사)

2024년 3월 ~ 현재 : 한국공학대학교 바이오헬스융합공학과 석사과정

관심분야 : AI 헬스케어, 딥러닝

2025년 2월 : 한국공학대학교 컴퓨터공학과(공학사)

2025년 3월 ~ 현재 : 한국공학대학교 바이오헬스융합공학과 석사과정

관심분야 : 머신러닝, 딥러닝

2011년 2월 : 연세대학교 의공학부(학사)

2013년 2월 : 한양대학교 생체의공학(석사)

2017년 2월 : 한양대학교 생체의공학(박사)

2023년 9월 ~ 현재 : 한국공학대학교 인공지능학과 조교수

관심분야 : 인공지능(ML/DL), 디지털 헬스케어, EEG, BCI, 생체신호 및 영상처리

2010년 2월 : 한국공학대학교 컴퓨터공학과(학사)

2012년 2월 : 한국공학대학교 컴퓨터공학과(석사)

2024년 8월 : 한국공학대학교 컴퓨터공학과(박사)

2015년 5월 ~ 현재 : ㈜리비전 대표

관심분야 : AI 신호 및 영상처리, AI 헬스 케어

1992년 2월 : KAIST 전기 및 전자공학과(공학사)

1995년 2월 : KAIST 정보 및 통신공학과(공학석사)

2000년 2월 : KAIST 전기 및 전자공학과(공학박사)

2004년 3월 ~ 현재 : 한국공학대학교 컴퓨터공학과 교수

관심분야 : AI 의료 신호 및 영상처리, AI 헬스케어