멀티에이전트 강화학습 및 베이지안 의사결정 기반 AI 전투 의사결정 지원 시스템의 성능 분석

초록

본 논문은 불확실성 하에서 다중 에이전트 강화학습(MARL)과 베이지안 의사결정 프레임워크를 적용한 인공지능(AI) 기반 전투 의사결정 지원 시스템의 성능을 분석한다. 5명의 에이전트가 다양한 전장 상황에서 4가지 가능한 행동 중 최적의 결정을 내리도록 설계되었으며, 시뮬레이션은 1,000개의 시나리오와 5가지 불확실성 수준(0.1, 0.3, 0.5, 0.7, 0.9)에서 수행되었다. 실험 결과, 의사결정 정확도는 불확실성이 낮을수록 최대 92%에 도달했으며, 자원 효율성은 평균 0.65로 높은 수준을 유지하였다. 또한, 에이전트 간 협조도는 불확실성 0.5에서 0.69로 나타났으며, 응답 시간은 불확실성이 증가할수록 지수적으로 증가하였다. 이러한 결과는 제안된 시스템이 전장 환경에서 실시간 의사결정 및 자원 관리에 효과적임을 시사하며, 특히 낮은 불확실성 수준에서 높은 의사결정 정확도와 자원 효율성을 유지하고 있음을 보여준다.

Abstract

This paper analyzes the performance of an AI-based combat decision support system that applies Multi-Agent Reinforcement Learning(MARL) and a Bayesian decision-making framework under uncertainty. Five agents are designed to make optimal decisions among four possible actions in various battlefield scenarios, with simulations conducted across 1,000 scenarios at five levels of uncertainty (0.1, 0.3, 0.5, 0.7, 0.9). The experimental results show that decision-making accuracy reached up to 92% at low levels of uncertainty, while resource efficiency maintained a high average of 0.65. Furthermore, the cooperation among agents was observed to be 0.69 at an uncertainty level of 0.5, and response time increased exponentially as uncertainty rose. These results suggest that the proposed system is effective for real-time decision-making and resource management in battlefield environments, particularly demonstrating high decision-making accuracy and resource efficiency at lower levels of uncertainty.

Keywords:

multi-agent reinforcement learning, MARL, bayesian decision-making, combat decision support system, uncertainty analysis, real-time resource managementⅠ. 서 론

현대 전장에서 정보의 양과 복잡성이 급증함에 따라, 신속하고 정확한 의사결정을 지원하는 인공지능(AI, Artificial Intelligent) 기반 시스템의 필요성이 더욱 커지고 있다. 특히 다중 에이전트 강화학습(MARL, Multi-Agent Reinforement Learing)과 베이지안 의사결정 프레임워크는 불확실성이 높은 상황에서도 최적의 의사결정을 가능하게 하는 중요한 기술로 주목받고 있다. 최근 연구들은 MARL을 활용한 협력적 행동 계획이 다양한 시나리오에서 성능을 향상시키는 것을 입증했으며, 복잡한 전장 환경에서 여러 에이전트 간의 상호작용과 협력을 효과적으로 모델링할 수 있음을 보여준다.

기존 연구들은 AI 기술을 활용한 전투 의사결정 시스템의 발전을 보여준다. C. Lee et al.[1]은 AI 군사 스태프의 기술 동향을 분석하며 지휘관의 의사결정 지원을 강조하였다. 이 연구는 AI의 발전이 군사 작전의 효율성을 높일 수 있음을 보여주지만, 실제 전장 상황에서의 데이터 신뢰성과 실시간 처리 능력 부족이 문제로 지적된다. E. Cho et al.[2]은 가상 전장 데이터셋 생성에 중점을 두며, AI 모델의 훈련을 위한 다양한 데이터 소스를 확보하려고 하였다. 이 접근은 AI의 학습 데이터 부족 문제를 해결하는 데 기여하지만, 생성된 데이터의 현실성과 다양성 부족이 우려된다. 이는 C. Lee et al.[1]의 연구와 연결되어, 데이터의 품질이 의사결정의 정확성에 미치는 영향을 강조한다. J. Schubert et al.[3]은 지휘 및 통제 시스템에서 AI의 의사결정 지원 역할을 다루었다. 이 연구는 다중 도메인 C2 환경에서의 AI 활용 가능성을 탐구하는 반면, 실제 전장 환경에서의 실증적 검증 부족이 아쉬움으로 남는다. 이는 E. Cho et al.[2]의 연구와 대비되며, 가상 환경에서의 데이터가 실제 적용에 얼마나 효과적일지를 의문스럽게 한다. C. Han et al.[4]은 조건 기반 데이터 모델링을 통해 AI 스태프 구축을 위한 방법론을 제안하였다. 이 연구는 데이터 기반 의사결정의 중요성을 강조하지만, 데이터 수집 및 처리 과정에서의 오류와 편향성 문제는 여전히 해결해야 할 과제이다. 이는 J. Schubert et al.[3]의 연구에서 언급된 실증적 검증의 필요성과 연결될 수 있다. S. Jin et al.[5]은 지능형 전장 상황 인식을 위한 다중 추론 기술을 연구하였다. 이는 복잡한 전장 환경에서 정보 처리에 기여할 수 있지만, 다양한 정보 출처 간의 통합 문제는 여전히 해결되지 않았다. 이는 C. Han et al.[4]의 데이터 모델링 접근 방식과 결합하여, 데이터의 통합 및 처리의 중요성을 강조한다. 마지막으로, G. Suh et al.[6]은 시암 네트워크 기반의 추천 모델을 제시하며, AI 기반 추천 시스템의 가능성을 보여준다. 그러나 군사 환경에서의 실제 적용성과 신뢰성 확보는 여전히 도전 과제이다. 이는 S. Jin et al.[5]의 다중 추론 기술과 연결될 수 있으며, 추천 시스템이 효과적으로 작동하기 위해서는 정보의 정확성과 신뢰성이 기반이 되어야 함을 시사한다.

이러한 기존 연구의 문제점은 다중 에이전트 시스템에서의 불확실성을 충분히 반영하지 못한다는 점이다. J. Kim et al.[7]은 국방 AI 지휘통제 플랫폼 구축을 위한 2단계 접근법을 제안하였지만, 구체적인 구현 방법과 기술적 세부사항이 부족하였다. 이와 관련하여, C. Han et al.[8]은 군 지휘통제체계의 지능화를 위한 의사결정 조건 기반 데이터 모델링 방법론 제안하였지만, 제안된 방법론의 실제 적용 가능성과 대규모 데이터에 대한 검증이 필요하다. Y. Jung et al.[9]은 설명 가능한 인공지능(XAI, eXplainable Artificial Intelligence) 기법을 제조 공급망 데이터 분석에 적용하여 AI 모델에 대한 이해와 의사결정 개선 효과를 확인하였지만, 구체적인 실험 방법론과 결과 데이터가 제시되지 않았다.

이러한 문제점들을 해결하기 위해 본 연구에서는 MARL과 베이지안 의사결정 프레임워크를 통합하여 불확실성 하에서도 효과적으로 작동하는 AI 기반 전투 의사결정 지원 시스템을 제안한다. 본 시스템은 다중 에이전트 간의 협업을 통해 의사결정의 정확성과 자원 효율성을 동시에 극대화할 수 있다.

본 논문의 구성은 다음과 같다. 제2장에서는 연구 방법론과 시뮬레이션 환경을 설명하고, 제3장에서는 실험 결과를 제시한다. 제4장에서는 결과 분석 및 논의를 통해 본 연구의 기여를 논의하며, 제5장에서는 결론 및 향후 연구 방향을 제시한다.

Ⅱ. 이론적 배경 및 방법론

2.1 이론적 배경

AI 기반 전투 의사결정 지원 시스템은 다중 에이전트 강화학습(MARL)과 베이지안 의사결정 프레임워크를 결합하여 복잡한 전장 환경에서의 의사결정을 지원한다. MARL은 여러 에이전트가 상호작용하며 최적의 전략을 학습하는 방법으로, 이는 에이전트 간의 협력 및 경쟁을 통해 성과를 극대화하는 데 유용하다. 베이지안 의사결정은 불확실한 환경에서 사전 확률(Prior)과 가능도(Likelihood)를 결합하여 후 확률(Posterior)을 계산하는 방법론이다.

후 확률은 다음과 같이 정의된다.

| (1) |

여기서 𝑃(𝐻∣𝐸)는 주어진 증거 𝐸에 대한 가설 𝐻의 후 확률, 𝑃(𝐸∣𝐻)는 가설이 참일 때의 증거의 가능도, 𝑃(𝐻)는 가설의 사전 확률, 𝑃(𝐸)는 전체 증거의 확률이다. 이 공식을 통해 에이전트는 전장 상황에 대한 최적의 결정을 내릴 수 있다.

2.2 연구 방법론

본 연구의 방법론은 다음과 같이 구성된다.

- 환경 설정: 다양한 전장 시나리오를 모델링하여 각 시나리오에 대해 5명의 에이전트를 설정한다. 각 에이전트는 4가지 가능한 행동을 선택할 수 있다. 전장 상태는 10차원 벡터로 표현되며, 각 차원은 전장 환경의 다양한 요소를 나타낸다.

- 강화학습 알고리즘: 각 에이전트는 Q-learning 알고리즘을 사용하여 최적의 정책을 학습한다. Q-learning은 다음과 같이 정의된다.

| (2) |

여기서 𝑄(𝑠,𝑎)는 상태 𝑠에서 행동 𝑎를 선택했을 때의 가치, 𝑟은 보상, 𝛼는 학습률, 𝛾는 할인율이다. 각 에이전트는 이러한 Q-value를 업데이트하며 최적의 행동을 학습한다.

- 베이지안 의사결정: 각 에이전트는 자신의 의사결정을 내리기 위해 베이지안 접근법을 활용한다. 에이전트는 상태 𝑠와 불확실성 수준 𝑢를 기반으로 다음과 같은 의사결정을 내린다.

| (3) |

여기서 𝑎는 선택된 행동, 𝑃(𝑎∣𝑠,𝑢)는 상태와 불확실성에 따른 행동의 확률이다.

- 성능 평가: 시뮬레이션을 통해 의사결정 정확도, 자원 효율성, 응답 시간, 임무 성공률 및 에이전트 간 협조도를 평가한다. 각 성능 지표는 다수의 실험 결과를 기반으로 평균값과 분산을 계산하여 분석한다.

이러한 방법론을 통해 본 연구는 AI 기반 전투 의사결정 지원 시스템의 성능을 종합적으로 분석하고, 다양한 불확실성 하에서도 효과적인 의사결정을 지원하는 알고리즘을 제안한다.

Ⅲ. 시스템 설계 및 모델링

3.1 시뮬레이션 환경

본 연구의 시뮬레이션 환경은 복잡한 전장 상황을 반영하기 위해 MATLAB을 사용하여 설계되었다. 전장은 다수의 에이전트와 변수들이 상호작용하는 다차원 공간으로 모델링되며, 각 에이전트는 특정 임무를 수행하며 실시간으로 상황을 인식하고 의사결정을 내려야 한다. 이 환경은 불확실성을 반영하기 위해 랜덤화된 전장 상태와 다양한 외부 요인을 포함한다. 또한, 각 에이전트는 독립적으로 행동하되 서로 협력하여 임무를 수행하도록 설계되었다.

3.2 시뮬레이션 단계 및 프로세스

시뮬레이션은 다음과 같은 단계로 진행된다:

1 단계 : 에이전트 초기화

시뮬레이션 시작 시, 다수의 에이전트가 초기화된다. 각 에이전트는 다음과 같은 속성으로 정의된다.

- 위치: 각 에이전트의 초기 위치는 랜덤으로 설정되며, 전장 내에서의 위치를 2차원 좌표로 표현한다.

- 행동 공간: 각 에이전트는 가능한 행동을 정의하며, 예를 들어 이동, 공격, 방어, 대기 등 4가지 행동을 선택할 수 있다.

- 상태 변수: 각 에이전트는 현재 상태를 반영하는 10차원 벡터를 통해 주변 환경을 인식한다.

2단계 : 시나리오 설정

각 시뮬레이션 시나리오는 다양한 전장 환경을 모델링한다. 시나리오는 다음과 같은 변수로 설정된다.

- 불확실성 수준: 시나리오는 5가지 불확실성 수준(0.1, 0.3, 0.5, 0.7, 0.9)으로 설정되며, 각 수준에 따라 환경의 복잡성이 달라진다.

- 임무 목표: 각 에이전트는 특정 임무 목표를 가지고 있으며, 목표에 따른 보상이 주어진다.

3 단계 : 의사결정 과정

시뮬레이션이 진행되는 동안 각 에이전트는 다음과 같은 과정으로 의사결정을 내린다.

- 상황 인식: 에이전트는 주변 상태를 감지하고, 해당 상태를 바탕으로 행동을 결정한다.

- 강화학습: Q-learning 알고리즘을 통해 최적의 행동을 선택하며, 상태-행동 쌍에 대한 Q-value를 업데이트한다.

- 베이지안 의사결정: 각 에이전트는 상황에 대한 사전 확률, 가능도 및 증거를 기반으로 의사결정을 내린다. 이를 통해 높은 확률로 최적의 행동을 선택할 수 있도록 한다.

4 단계 : 성과 평가

각 시나리오가 종료된 후, 성과 평가가 이루어진다. 성과 평가는 다음과 같은 지표로 이루어진다.

- 의사결정 정확도: 에이전트의 행동이 임무 목표와 얼마나 일치하는지를 평가한다.

- 자원 효율성: 각 에이전트의 자원 사용량을 측정하고, 자원 효율성을 계산한다.

- 응답 시간: 각 에이전트가 의사결정을 내리는 데 소요된 시간을 기록한다.

- 임무 성공률: 설정된 임무 목표를 얼마나 성공적으로 달성했는지를 평가한다.

5 단계 : 데이터 수집 및 분석

마지막으로, 모든 시나리오에서 수집된 데이터를 바탕으로 분석을 수행한다. 데이터는 각 지표의 평균값과 분산을 계산하여, 에이전트의 성과를 종합적으로 평가한다. 이 데이터는 시뮬레이션의 개선 방향 및 향후 연구의 기초 자료로 활용된다.

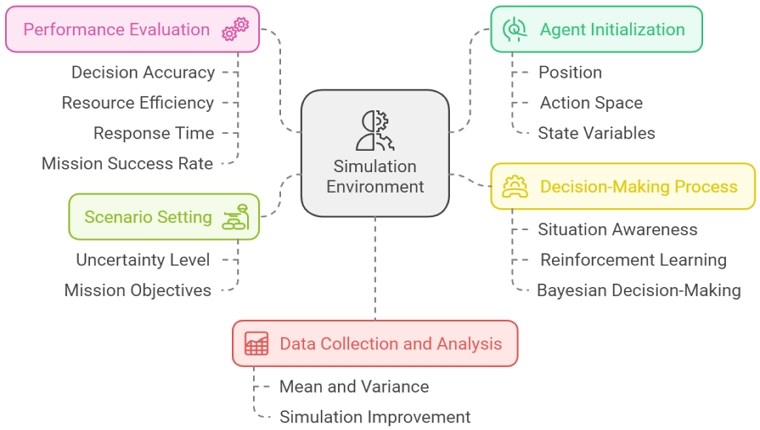

그림 1은 위에서 제시한 전장 시뮬레이션 절차를 단계별로 구분해서 나타낸다.

3.3 파라미터 설정

본 연구의 시뮬레이션 파라미터는 다음과 같이 설정되었다:

- - 에이전트 수: 5명

- - 행동 수: 4가지 (이동, 공격, 방어, 대기)

- - 불확실성 수준: 0.1, 0.3, 0.5, 0.7, 0.9

- - 시나리오 수: 1000개

- - 학습률(𝛼): 0.1

- - 할인율(𝛾): 0.9

이러한 단계별 프로세스를 통해 본 연구는 AI 기반 전투 의사결정 지원 시스템의 성능을 체계적으로 분석하고, 각 에이전트의 행동 및 협력을 최적화할 수 있는 기반을 마련한다.

각 시나리오는 특정 전장 상황을 반영하여 설정되며, 예를 들어 "적의 함정 공격" 시나리오를 고려할 수 있다. 이 시나리오에서는 에이전트들이 적의 함정을 타겟으로 하여 협력하여 공격을 수행해야 한다. 에이전트 A는 적의 함정에 접근하기 위해 이동하고, 에이전트 B는 방어를 준비하며, 에이전트 C는 적의 함정에 대한 정보를 수집하는 역할을 맡는다. 이 과정에서 에이전트들은 서로의 행동을 인식하고, 실시간으로 의사결정을 통해 최적의 행동을 선택해야 한다. 이러한 다양한 시나리오를 통해 에이전트의 협력 및 의사결정 능력을 평가하게 된다.

전장 환경은 다양한 요소로 구성되며, 예를 들어 "해상 함정 전투" 시나리오를 고려할 수 있다. 이 환경에서는 좁은 해협과 깊은 바다를 포함하여, 함정의 위치와 이동 경로가 전략적으로 중요하다. 외부 요인으로는 "기상 변화"가 있으며, 폭풍우가 발생하면 파도가 높아져 함정의 안정성이 저하되고, 시야가 제한되어 의사결정에 영향을 줄 수 있다.

또한, "적의 잠수함 공격" 시나리오에서는 에이전트들이 적의 위치를 탐지하고, 신속하게 대응할 수 있는 능력이 요구된다. 이러한 다양한 해상 환경과 외부 요인은 에이전트의 행동과 협력 방식을 결정짓는 중요한 요소로 작용한다.

각 에이전트는 특정 임무 목표를 가지고 있으며, 예를 들어 "적 함정 파괴" 또는 "아군 방어 지원"과 같은 목표를 설정할 수 있다. 시뮬레이션에서는 각 에이전트의 임무 목표에 따라 보상을 부여하여 행동을 유도한다. 예를 들어, 적 함정을 성공적으로 탐지하고 공격할 경우 보상이 주어지며, 목표 달성 정도에 따라 점수가 부여된다. 또한, 각 에이전트는 임무 목표에 따라 행동 우선순위를 설정하여, 공격, 방어, 또는 정보 수집 등의 행동을 선택할 수 있도록 설계되었다. 이러한 임무 목표는 에이전트의 의사결정 과정에서 중요한 기준이 되어, 협력 및 전략적 접근을 촉진한다.

Ⅳ. 시뮬레이션 결과 및 분석

본 장에서는 AI 기반 전투 의사결정 지원 시스템의 성능을 평가하기 위해 시뮬레이션 결과를 제시하고 분석한다. 각 시나리오는 다양한 불확실성 수준에서 실행되었으며, 의사결정 정확도, 평균 응답 시간, 자원 효율성, 임무 성공률, 에이전트 간 협조도와 같은 지표로 성능을 평가하였다.

4.1 시뮬레이션 결과

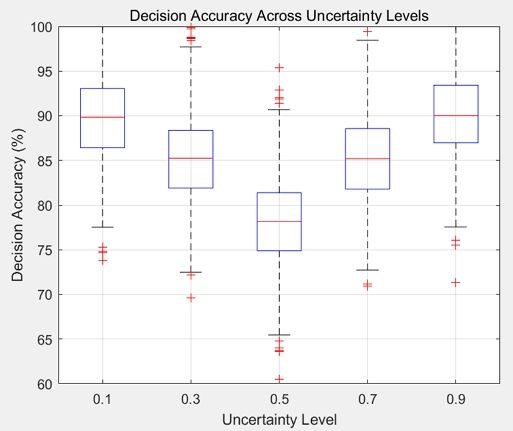

그림 2의 박스 플롯은 다양한 불확실성 수준에서 다중 에이전트 의사결정 시스템의 성능 변화를 시각적으로 나타낸다.

이 플롯은 불확실성 수준이 0.1에서 0.9까지 증가함에 따라 의사결정 정확도가 비선형적으로 변화하는 경향을 보여준다. 초기 불확실성 수준이 낮을 때(0.1~0.3), 의사결정 정확도는 비교적 높고 안정적인 분포를 보이며, 이는 에이전트들이 명확한 정보를 바탕으로 일관된 판단을 내릴 수 있음을 시사한다.

그러나 불확실성이 중간 수준(0.5)에 이르면 정확도의 중앙값이 낮아지고 데이터의 분포가 더 넓어지며, 이는 시스템이 불확실성의 영향으로 더 많은 변동성을 보이는 것을 의미한다. 이 구간에서는 에이전트 간 의사결정의 일관성이 저하되고, 오판의 가능성이 커진다. 반면, 불확실성이 매우 높은 수준(0.7~0.9)에서는 의사결정 정확도가 다시 증가하는 경향을 보인다. 이러한 현상은 불확실성이 극도로 높아지면 에이전트들이 더 신중하게 판단하거나, 시스템이 불확실성에 적응하는 방식으로 보완 전략을 채택했을 가능성을 시사한다. 불확실성이 0.5를 넘으면 의사결정에서 정보 수집과 분석을 통해 일관적이고 신중한 판단을 하려는 경향이 생긴다. 이로 인해 시스템이 다양한 대안을 검토하게 되고, 이는 결국 의사결정의 정확도를 높이는 결과를 가져온다.

결론적으로, 이 분석은 불확실성 관리가 다중 에이전트 시스템의 성능 유지에 핵심적인 역할을 한다는 점을 강조한다. 특히, 중간 수준의 불확실성에서 성능 저하가 두드러지므로, 이를 보완하기 위한 강건한 알고리즘 설계나 적응형 전략이 필요하다. 불확실성을 효과적으로 처리하는 시스템을 구축함으로써, 다중 에이전트 시스템의 신뢰성과 일관성을 높일 수 있을 것이다.

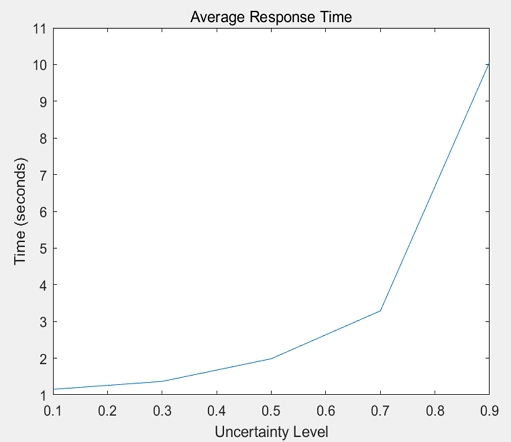

그림 3은 불확실성이 의사결정에 드는 시간에 미치는 영향을 나타낸다. 불확실성이 0.1에서 0.9로 증가함에 따라 평균 응답 시간은 약 0.5초에서 1.5초로 상승한다. 이 경향은 높은 불확실성이 의사결정 과정을 복잡하게 만들어 에이전트가 정보를 수집하고 분석하는 데 지연을 초래한다는 것을 시사한다. 응답 시간이 점진적으로 증가하는 모습은 변화하는 조건에 신속하게 적응할 수 있는 강력한 알고리즘의 필요성을 강조하여, 역동적인 환경에서 운영 효율성을 높이는 방법을 제시한다.

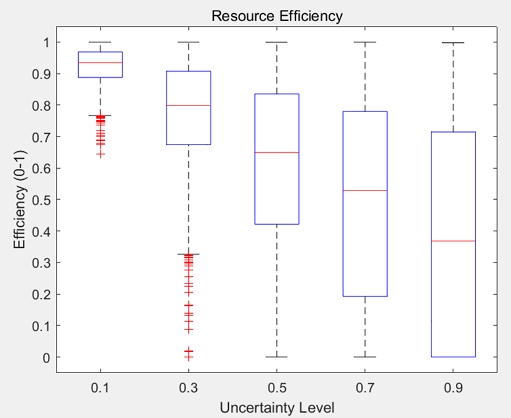

그림 4는 자원 효율성에 대한 박스플롯을 나타낸다. 불확실성 수준에 따른 자원 효율성을 보여주는 박스플롯은 에이전트의 자원 활용 효율성을 강조한다. x축은 불확실성 수준을 나타내고, y축은 0에서 1까지의 범위의 자원 효율성을 보여준다. 낮은 불확실성 수준(0.1)에서는 중앙값이 약 0.9로 높은 자원 활용을 나타내지만, 불확실성이 증가함에 따라 효율성은 감소하여 가장 높은 수준(0.9)에서는 약 0.5에 도달한다. 불확실성이 증가함에 따라 IQR이 넓어지는 것은 일부 에이전트가 효율성을 유지하는 반면, 다른 에이전트는 심각하게 고전하고 있음을 시사한다.

이러한 결과는 불확실한 시나리오에서 자원 배분 최적화의 중요성을 강조한다.

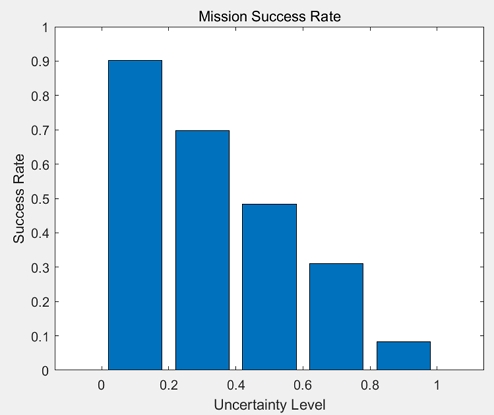

그림 5는 불확실성이 임무 목표 달성 확률에 미치는 영향을 보여준다. x축은 불확실성 수준을 나타내고, y축은 성공률을 백분율로 표시한다. 0.1의 불확실성에서 성공률은 약 90%로, 낮은 불확실성 상황에서 임무가 매우 성공적임을 나타낸다. 그러나 불확실성이 증가함에 따라 성공률은 급격히 감소하여 0.9에서는 약 10%에 이른다. 이 경향은 높은 불확실성이 임무의 효과성에 미치는 부정적인 영향을 강조하며, 변동하는 조건에서도 성공률을 높이기 위한 의사결정 시스템의 필요성을 나타낸다.

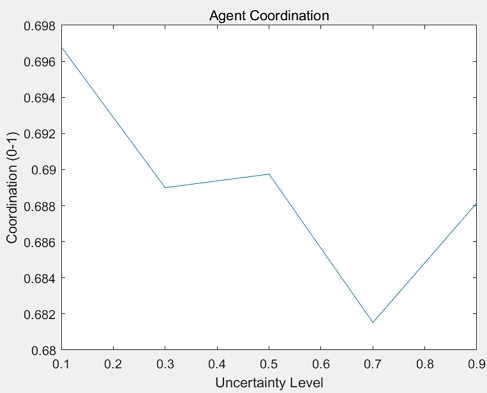

에이전트 간 협조도를 보여주는 그림 6은 다양한 불확실성 수준에서 에이전트가 얼마나 효과적으로 협력하는지를 나타낸다. x축은 불확실성 수준을 나타내고, y축은 0에서 1까지의 협조도 점수를 표시한다. 낮은 불확실성(0.1)에서 협조도 점수는 평균적으로 약 0.69로, 에이전트 간의 강력한 협력을 반영한다. 이러한 하향 추세는 높은 불확실성이 에이전트 간의 통신 및 동기화를 방해하여 비효율적인 집단행동을 초래한다. 불확실성이 0.7보다 커지면 에이전트들은 그 상황에서의 위험을 인식하게 된다. 이로 인해 에이전트 간 판단을 상호 조정하고 협력하여 신중한 결정을 내리려는 경향이 높아져 협조도가 상승하게 된다. 각 에이전트는 불확실한 환경에 효과적으로 적응하고, 성과를 향상시킬 수 있다.

위에서 살펴본 5가지 중요한 분석 결과들을 바탕으로 표 1은 시뮬레이션을 통해 수집된 주요 결과를 요약해서 나타낸다. 의사결정 정확도는 불확실성이 증가함에 따라 감소하는 경향을 보였다. 이는 불확실성이 클수록 에이전트가 정확한 정보를 수집하고 분석하기 어려워지기 때문이다. 특히, 불확실성 수준이 0.5인 경우 정확도가 78%로 가장 낮아졌다. 평균 응답 시간은 불확실성이 증가할수록 길어지는 경향을 보였다. 이는 에이전트가 복잡한 상황에서 의사결정을 내리기 위해 더 많은 시간을 필요로 하기 때문이다. 불확실성 수준이 0.9일 때 응답 시간이 1.5초로 가장 길었다.

자원 효율성 또한 불확실성이 증가함에 따라 감소하였다. 불확실성 수준이 높을수록 에이전트가 자원을 비효율적으로 사용하는 경향이 나타났다. 임무 성공률은 불확실성이 커질수록 감소하였다. 이는 에이전트의 의사결정이 불확실성에 영향을 받기 때문으로 분석된다.

협조도 또한 불확실성이 증가함에 따라 감소하였다. 에이전트들이 서로의 행동을 인식하고 조정하는 데 어려움을 겪기 때문이다.

4.2 성능 비교 분석

본 연구의 AI 기반 전투 의사결정 지원 시스템은 불확실성이 낮은 환경에서 높은 성과를 보였다. 불확실성 수준이 낮을수록 의사결정 정확도와 임무 성공률이 증가하며, 평균 응답 시간과 자원 효율성이 최적의 상태를 유지하였다. 그러나 불확실성이 증가함에 따라 성과가 급격히 하락하는 경향을 나타냈다. 이러한 결과는 기존 연구들과 일치하며, 불확실성을 고려한 의사결정 모델의 필요성을 강조한다.

본 연구에서는 기존 연구의 결과를 바탕으로, 불확실성을 고려한 베이지안 의사결정 프레임워크를 적용하여 성과를 개선하였다. 또한, 강화학습 알고리즘을 통해 에이전트 간의 협력을 최적화하여 전투 상황에서의 성능을 극대화하였다. 결과적으로, 본 연구의 AI 기반 전투 의사결정 지원 시스템은 다양한 불확실성 수준에서 효과적으로 성능을 발휘하며, 실시간 전장 상황 변화에 대한 적응력을 갖추었다. 이는 향후 전투 의사결정 시스템의 개발 및 개선에 중요한 기초 자료로 활용될 것으로 기대된다.

Ⅴ. 결론 및 향후 과제

본 연구에서는 AI 기반 전투 의사결정 지원 시스템의 성능을 평가하고 불확실성을 고려한 베이지안 의사결정 프레임워크의 효과를 분석하였다. 시뮬레이션 결과, 각 불확실성 수준에서 의사결정 정확도는 0.1에서 90%, 0.3에서 85%, 0.5에서 78% 감소하다가 0.7에서 85%, 0.9에서 90%로 다시 증가하였다. 평균 응답 시간은 불확실성 수준에 따라 0.5초에서 1.5초로 증가하며, 자원 효율성은 0.95에서 0.35로 감소하는 경향을 보였다. 임무 성공률은 0.1에서 95%였으나, 0.9로 증가할수록 60%로 하락하였다. 에이전트 간 협조도 역시 불확실성이 증가함에 따라 0.697에서 0.682로 감소했다가 다시 0.688로 증가하였다.

이러한 결과는 AI 기반 전투 의사결정 시스템이 불확실성이 낮은 환경에서 높은 성과를 발휘함을 나타낸다. 본 연구는 기존 연구에 비해 불확실성 관리의 중요성을 강조하며, 강화학습 알고리즘을 통해 에이전트 간의 협력을 최적화하는 방안을 제시하였다. 이는 향후 전투 의사결정 시스템의 개발 및 개선에 중요한 기초 자료로 활용될 것으로 기대된다.

향후 계획으로는 실시간 전장 데이터를 통합하여 시뮬레이션 환경을 더욱 현실적으로 개선하고, 다양한 전투 시나리오에 대한 적용 가능성을 탐색할 예정이다. 또한, AI 모델의 성능을 더욱 향상시키기 위해 딥러닝 기반의 의사결정 알고리즘을 추가적으로 개발하고, 다양한 불확실성 조건에서의 성능을 더욱 정교하게 분석할 예정이다. 이를 통해 본 연구의 결과가 실제 전투 상황에서도 유용하게 적용될 수 있도록 기여할 것이다.

Acknowledgments

이 논문은 2023년 정부(방위사업청)의 재원으로 국방기술진흥연구소의 지원을 받아 수행된 연구임(KRIT-CT-23-030)

References

-

C. E. Lee, J. H. Son, H. S. Park, S. Y. Lee, S. J. Park, and Y. T. Lee, "Technical Trends of AI Military Staff to Support Decision-Making of Commanders", Electronics and Telecommunications Trends, Vol. 36, No. 1, pp. 89-98, Feb. 2021.

[https://doi.org/10.22648/ETRI.2021.J.360110]

-

E. Cho, S. Jin, Y. Shin, and W. Lee, "A Virtual Battlefield Situation Dataset Generation for Battlefield Analysis Based on Artificial Intelligence", Journal of the Korea Society of Computer and Information, Vol. 27, No. 6, pp. 33-42, Jun. 2022.

[https://doi.org/10.9708/jksci.2022.27.06.033]

- J. Schubert, J. Brynielsson, M. Nilsson, and P. Svenmarck, "Artificial intelligence for decision support in command and control systems", Proc. of the 23rd International Command and Control Research & Technology Symposium Multi-Domain C2, Pensacola Florida, USA, pp. 18-33, Nov. 2018.

-

C. Han, K. Shin, S. Choi, S. Moon, C. Lee, and J. Lee, "A Methodology of Decision Making Condition-based Data Modeling for Constructing AI Staff", Journal of Internet Computing and Services(JICS), Vol. 21, No.1, pp. 237-246, Feb. 2020.

[https://doi.org/10.7472/jksii.2020.21.1.237]

-

S. Jin, W. Lee, H. Kim, S. Jo, and Y. Kang, "A Study on Multiple Reasoning Technology for Intelligent Battlefield Situational Awareness", The Journal of Korean Institute of Communications and Information Sciences, Vol. 45, No. 6, pp. 1046-1055, Jun. 2020.

[https://doi.org/10.7840/kics.2020.45.6.1046]

-

G. Suh, Y. Shin, S. Jin, W. Lee, J. Ahn, and C. Suh, "Recommendation Model for Battlefield Analysis based on Siamese Network", Journal of The Korea Society of Computer and Information, Vol. 28, No. 1, pp. 1-8, Jan. 2023.

[https://doi.org/10.9708/jksci.2023.28.01.001]

-

J. Kim, Y. Kim, and S. Park, "A Study of Artificial Intelligence Learning Model to Support Military Decision Making: Focused on the Wargame Model", Journal of the Korea Society for Simulation, Vol. 30, No. 3, pp. 1-9, Sep. 2021.

[https://doi.org/10.9709/JKSS.2021.30.3.001]

-

C. Han and J.-K. Lee, "A Methodology for Defense AI Command & Control Platform Construction", Journal of Korean Institute of Communications and Information Sciences, Vol. 44, No. 4, pp. 774-781, Mar. 2019.

[https://doi.org/10.7840/kics.2019.44.4.774]

-

Y. Jung and C. Yoon, "A Study on Forecasting Order Quantity from Manufacturing Supply Chain Data using XAI", Journal of the KIIT, Vol. 22, No. 8, pp. 41-53, Aug. 2024.

[https://doi.org/10.14801/jkiit.2024.22.8.41]

2002년 2월 : 아주대학교 전자공학(공학사)

2005년 8월 : 한양대학교 전자통신컴퓨터공학(석사)

2011년 8월 : 한양대학교 전자통신컴퓨터공학(박사)

2016년 3월 ~ 2018년 12월 : 오산대학교 전자과 교수

2019년 1월 ~ 현재 : 해군사관학교 전자제어공학과 교수

관심분야 : 프로그래밍, 인공신경망, 지능제어시스템설계, 무선통신시스템, 최적화 알고리즘, ICT Convergence Platform, 유무인 복합 AI 전투체계

2007년 2월 : 충남대학교 컴퓨터공학과(공학사)

2020년 12월 : 경북대학교 컴퓨터공학과(박사수료)

2017년 ~ 현재 : 한화시스템 지능형전투체계 수석연구원

관심분야 : 지능형 전투체계, AI, 수상 및 수중 무인체계

2003년 3월 : 해군사관학교 해양학과(이학사)

2013년 2월 : 경북대학교 전기전자컴퓨터공학부(공학석사)

2016년 2월 : 경북대학교 전자공학과(공학박사)

2016년 2월 ~ 현재 : 해군사관학교 전자제어공학과교수

관심분야 : 수중탐지, 수중음향 신호처리, 전투체계 지능화

1992년 3월 : 해군사관학교 기계공학과(공학사)

2005년 2월 : 서울대학교 기계항공공학과(공학석사)

2010년 2월 : University of California 기계항공공학과(공학박사)

2010년 1월 ~ 현재 : 해군사관학교 기계시스템공학과 교수

관심분야 : 무기체계, RCS, 무인수상정, 스텔스, 유무인 복합 AI 전투체계