딥러닝과 사용자 감정인식 기반의 스마트디퓨저 구현

; Ji-Hwan Pyo*

; Ji-Hwan Pyo* ; Joo-Sung Kim*

; Joo-Sung Kim* ; Woo-Won Choi*

; Woo-Won Choi* ; Jin-Young Hwang*

; Jin-Young Hwang* ; Jin-Han Jung*

; Jin-Han Jung* ; In-Soo Lee**

; In-Soo Lee**

초록

본 논문에서는 사용자의 감정상태를 인식하여 적절한 향을 낼 수 있는 딥러닝 기반의 스마트 디퓨저를 제안한다. 시스템의 전면부에 위치한 카메라센서를 통해 사용자의 얼굴표정을 인식하고, 이를 CNN을 이용한 감정인식모델을 통해 분석하여 결과값을 바탕으로 향을 자동으로 택한다. 또한 감정 유사도를 분석하여 감정의 깊이에 따라 팬의 세기를 제어하며 온습도 상황에 변동에도 일정한 정도의 발향을 위해 온습도 센서를 통해 팬의 동작시간을 조절한다. 동작예시로 행복감정을 인식하여 95.42%의 감정유사도와 25.7℃와 습도 67.3%에서 42초간 동작하였다. 본 논문에서는 스마트 디퓨저의 설계와 동작과정, CNN기반 감정분석모델과 프로토타입 동작실험 및 고찰에 대해 기술한다.

Abstract

In this paper, we propose a deep learning-based smart diffuser that can recognize the user's emotional state and produce an appropriate scent. The system utilizes a camera sensor located at the front to recognize the user's facial expressions. These expressions are analyzed through an emotion recognition model based on CNN, which then automatically selects the fragrance based on the results. Additionally, the system analyzes the similarity of emotions to control the fan's intensity according to the depth of the emotion. It adjusts the fan's operation time through temperature and humidity sensors to maintain a consistent level of diffusion despite changes in environmental conditions. As an example of operation, the happiness emotion was recognized and operated for 42 seconds at an emotional similarity of 95.42% and 25.7℃ and humidity of 67.3%. This paper describes the design and operation process of the smart diffuser, the CNN-based emotion analysis model, as well as the prototype's operation experiments and considerations.

Keywords:

smart diffuser, emotional analysis, CNN, temperature and humidity, facial expression detectingⅠ. 서 론

현대 사회에서 스트레스와 감정 조절에 대한 중요성이 강조되고 있는 가운데, 환경에서 향기는 우리의 감정과 심리적 상태에 큰 영향을 미친다 특히, 향기는 우리의 기억, 정서 및 행동에 직접적인 영향을 미치며, 감정을 조절하는데 중요한 역할을 한다. 이러한 맥락에서, 디퓨저는 각종 환경에서 향기를 효과적으로 전달하여 사용자의 감정을 개선하고 스트레스를 완화하는데 사용된다[1].

그러나, 기존의 디퓨저는 한 가지 향기만을 고정적으로 제공하는 한계가 있다. 이로 인해 사용자는 항상 동일한 향기를 경험하게 되어 감정이나 심리적 상태가 변화할 때 적절한 향기를 선택하기 어려워진다.

이에 반해, 스마트 디퓨저는 사용자의 감정 상태에 맞게 다양한 향기를 선택할 수 있는 장점이 있다. 즉, 디지털 감정인식 기술과의 융합을 통해 스마트 디퓨저는 실시간으로 사용자의 감정을 파악하고, 그에 맞는 다양한 향기를 제공함으로써 사용자가 항상 최적의 향기를 경험할 수 있다. 이를 위해, 심층 학습 알고리즘 중 하나인 합성곱 신경망(CNN, Convolutional Neural Networks)을 활용한 감정인식 기술을 적용하였으며, 이로인해 향기를 사용자의 현재 감정에 맞게 조절할 수 있게 하므로써 사용자가 더욱 개인의 감정상태에 적합한 디퓨저 향기를 경험할 수 있다.

CNN 신경망 모델을 사용하여 사용자의 감정을 실시간으로 인식하고, 이를 기반으로 사용자에게 가장 적절한 향기를 자동으로 선택하여 제공하는 스마트 디퓨저를 설계하고 구현했다. 즉, 스마트 디퓨저 시스템은 기존의 한 가지 향기만을 고정적으로 제공하는 방식을 혁신적으로 변화시키고, 사용자의 감정과 심리적 상태에 맞춘 개인화된 향기 서비스를 제공할 수 있다.

Ⅱ. CNN기반의 감정인식

2.1 합성곱 신경망(CNN)

최근 몇 년간 딥러닝(Deep learning) 기술의 발전은 다양한 분야에서 중요한 역할을 하고 있으며, 특히 감정 인식 분야에서는 딥러닝의 다양한 구조가 적용되고 있다. 감정 인식은 인간의 감정 상태를 정확하게 인식하고 분류하는 기술로, 이는 인간과 기계 간의 자연스러운 상호작용을 가능하게 하며, 많은 실제 응용 가능성을 제시한다[2].

CNN은 합성곱 층(Convolutional layer)을 통해 입력 이미지에서 특징을 자동으로 추출할 수 있는 능력이 강점이다. 감정 인식에서는 얼굴 표정의 세부적인 패턴을 인식하는 데 중요한 역할을 한다. 예를 들어, CNN은 얼굴의 각 부분을 지역적으로 처리하면서 얼굴 표정의 특정 패턴을 효과적으로 감지하고 구별할 수 있다.

CNN은 여러 합성곱과 풀링 층(Pooling layer)을 통해 공간적 계층 구조를 형성한다. 이는 입력 데이터의 공간적 구조를 유지하면서 점진적으로 추상화하여 복잡한 패턴을 학습할 수 있다. 감정 인식에서는 감정 표현의 공간적 변화를 정확히 인식하고 이를 기반으로 감정을 분류하는 데 도움이 된다[3].

대규모 데이터셋에서 CNN은 비교적 적은 수의 매개변수를 사용하여 효율적으로 학습할 수 있다. 이는 감정 인식 모델의 학습 속도를 높이고, 실제 환경에서의 성능을 개선하는 데 기여한다. 또한, 이미지 데이터를 처리하는 데 있어 CNN은 다른 방법들에 비해 더 빠르고 정확한 결과를 제공할 수 있다. 이러한 이유로 딥러닝 모델 중에서 특히 CNN은 이미지 처리에 탁월한 성능을 발휘하여 감정 인식에서 다른 딥러닝 방식보다 유리한 선택으로 자리잡고 있다. 본 논문은 이러한 장점을 바탕으로, CNN을 감정 인식 기술의 핵심 요소로서 제시하고, 감정 인식 기술을 이용하여 감정에 따라 향이 변화하는 디퓨저를 제작했다.

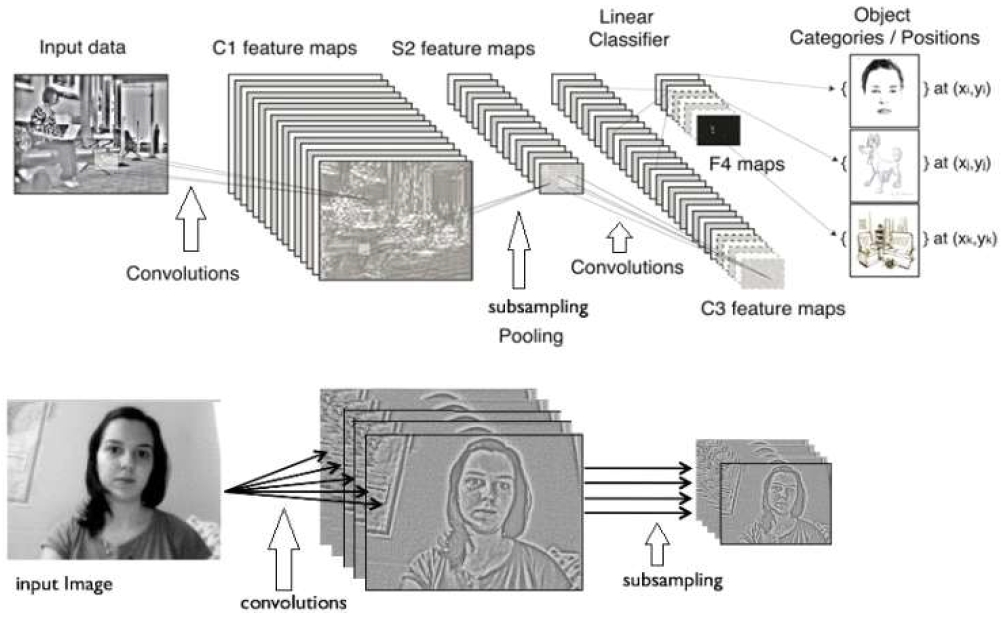

CNN의 구조는 그림 1과 같이 여러 특성 추출 및 축소 단계와 완전 연결층으로 구성되며, 다음과 같은 주요 구성 요소로 이루어져 있다[4].

입력 층(Input layer)은 원본 이미지를 모델에 제공하는 역할을 한다. 이미지는 일반적으로 RGB 채널을 포함하는 3차원 배열(높이, 너비, 채널)로 표현된다. 이 층은 입력 데이터를 받아들여 다음 층으로전달한다[5].

합성곱 층은 이미지에서 특징을 추출하는 핵심 층이다. 이 층의 주요 요소는 필터(커널, Kernel), 스트라이드(Strides), 패딩(Padding)이 있다.

필터(커널, Kernel)는 작은 크기의 행렬로, 입력 이미지의 부분 영역과 합성곱 연산을 수행하여 특성 맵을 생성한다.

스트라이드(Strides)는 필터를 이동시키는 간격을 나타낸다. 스트라이드가 크면 출력 특성 맵의 크기가 줄어든다.

패딩(Padding)은 입력 이미지의 경계에 특정 값을 추가하여 출력 특성 맵의 크기를 조절한다. 주로 '세임 패딩(Same padding)'과 '밸리드 패딩(Valid padding)'이 사용된다.

풀링 층(Pooling layer)은 특성 맵의 크기를 줄여 계산량을 감소시키고 중요한 특징을 강조하는 역할을 한다.

완전 연결층(Fully connected layer)은 추출된 특징을 기반으로 최종 분류를 수행한다. 입력 데이터를 1차원 벡터로 변환하여 각 뉴런과 연결한다.

드롭아웃(Dropout)은 과적합(Overfitting)을 방지하기 위해 훈련 중 일부 뉴런을 무작위로 비활성화하는 정규화 기법이다. 드롭아웃 비율(p)을 지정하여 적용하며, 이는 모델의 일반화 성능을 향상시킨다.

출력층(Output layer)은 모델의 최종 예측 결과를 제공하는 층이다. 분류 문제의 경우 소프트맥스(Softmax) 함수가 사용되며, 각 클래스에 대한 확률 값을 출력한다. 이 층은 모델의 예측 결과를 해석 가능한 형태로 변환한다[6][7].

2.2 감정분석을 위한 CNN 구조

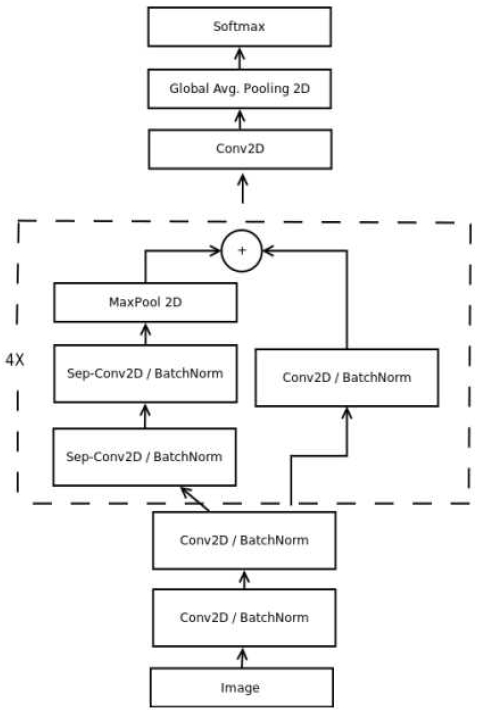

라즈베리파이에서 동작을 위하여 Xception 아키텍처를 기반으로 한 Mini-Xception을 사용한다. Mini-Xception는 잔여 모듈과 깊이별 분리형 컨볼루션(Depth-wise separable convolution)을 결합한 아키텍처이며, 그림 2는 Mini-Xception 구조를 나타낸것이다. 잔여 모듈은 두 개의 연속적인 레이어 간의 원하는 매핑을 수정하여 원래의 특징 맵과 원하는 특징 간의 차이를 생성한다. 그리고 깊이별 분리형 컨볼루션을 사용하여 M개의 입력 채널에 대해 D × D 필터를 적용하고, 그 다음 N개의 1 × 1 × M 컨볼루션 필터를 적용하여 M개의 입력 채널을 N개의 출력 채널로 결합한다.

1 × 1 × M 컨볼루션을 적용함으로써 채널 내에서의 공간적 관계를 고려하지 않고 각 값이 특징 맵에 결합된다. 깊이별 분리형 컨볼루션은 표준 컨볼루션에 비해 1/N + 1/D^2 만큼 매개변수의 계산양을 줄인다. 이러한 레이어는 공간적 교차 상관 관계와 채널 교차 상관 관계를 분리하기 위해 사용된다[8][9].

이 모델은 4개의 잔여 깊이별 분리형 컨볼루션을 포함하고 있으며 각 컨볼루션 뒤에는 Batch Normalization 작업 및 ReLU 활성화 함수가 이어진다. 이를 통하여 입력된 이미지의 특징을 추출한다. 이렇게 추출된 특징은 MaxPool 2D 층을 통해 풀링되어 이미지 크기를 줄이고 계산량을 줄인다. 마지막 레이어는 추출된 특징을 전역 평균 풀링 및 소프트맥스 활성화 함수를 적용하여 예측을 생성한다. 이 모델은 약 60,000개의 파라미터를 가지고 있으며 초기 구현 대비 10배, 원본 CNN 대비 80배 감소하였다. 이를 이용하여 실시간으로 감정인식이 가능하다.

2.3 감정분석을 위한 CNN 학습

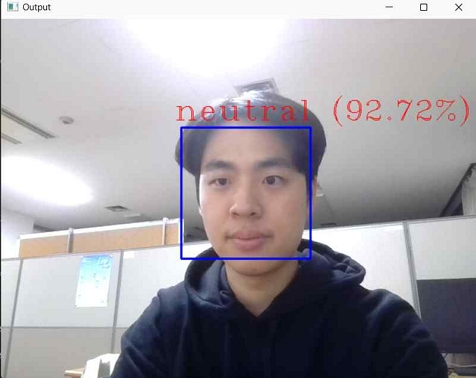

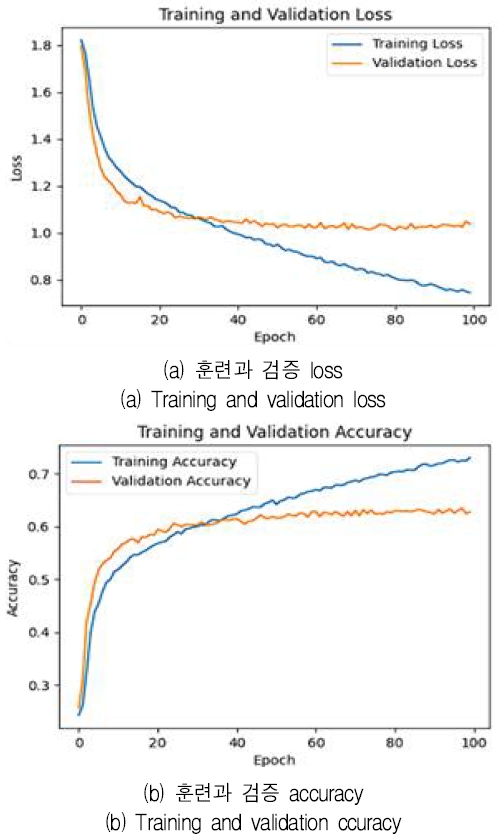

네트워크는 교차 엔트로피 손실 함수와 Adam 옵티마이저를 사용하여 학습한다. 훈련 데이터의 20%를 검증에 사용하는 방식을 사용였으며 네트워크는 배치 크기 128로 100 에포크 동안 학습한다. 이를 통하여 스마트 디퓨저는 5가지의 사람의 감정 즉, 중립(neutral), 슬픔(sad), 분노(angry), 행복(happy) 및 놀람(surprise)을 감지할 수 있다.

학습데이터는 kaggle의 Face expression recognition dataset을 이용하였다. 이 데이터셋은 7개의 클래스에 28,821개의 32x32 흑백 이미지를 학습했다. 작동 부분에서는 7개의 클래스에서 disgust, fear를 제외한angry, happy, neutral, sad, surprise 5개의 클래스만을 출력하도록 설정했다. 그림 3은 카메라로 센싱된 표정의 출력예시로서 중립감정이 인식됨을 알 수 있다.

OpenCV 라이브러리를 이용하여 사용자 감정값과 해당 감정값의 accuracy를 반환하는 함수를 사용하며 감정값을 15초 동안 읽으면서 최초로 100회 인식된 감정값과 해당 감정값의 accuracy를 반환한다.

현 프로젝트에서 사용하는 감정 인식 pre-trained 모델이 분류 가능한 감정 클래스는 angry, disgust, fear, happy, neutral, sad, surprise로 총 7개이지만, 하드웨어의 공간적인 한계점등 여러 가지 제한사항으로 인해 disgust, fear 감정을 neutral 감정으로 통합하여 angry, happy, neutral, sad 및 surprise 등 총 5가지의 감정을 출력한다.

감정인식 CNN 모델은 오픈소스로 Github의 Face_Emotion_Recognition을 참조하였다[10].

본 논문에서는 감정을 인식을 위하여 이미지 분류를 위한 합성곱 신경망의 효과를 입증했다. CNN 모델은 kaggle의 Face expression recognition dataset에서 감정 분류가 가능하다. 또한 Mini-Xception 아키텍처를 사용하여 라즈베리파이5 환경에서 원활하게 작동한다. 향후 추가적인 감정 데이터셋을 사용하여 학습해 더 정확한 감정 분류가 가능할 것이다.

Ⅲ. 스마트 디퓨저 시스템 구현

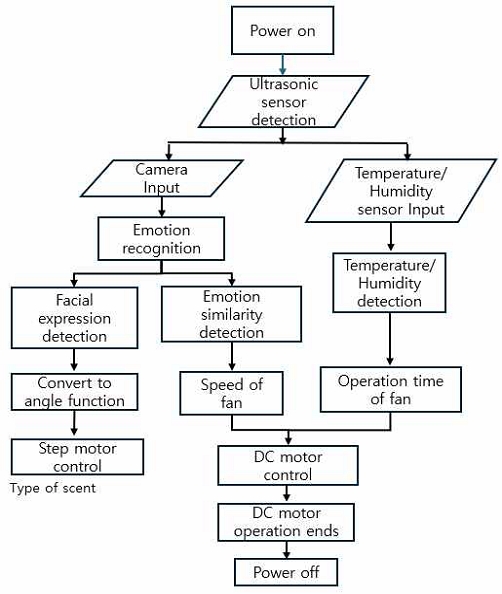

그림 4는 전체 시스템의 순서도를 나타낸 것이다. 입력부는 카메라와 온습도 센서, 초음파 센서로 구성되며 출력부는 DC 팬모터와 스텝모터로 구성된다. 초음파 센서를 통해 사용자의 접근을 감지하면 카메라센서가 동작한다. 카메라센서는 사용자의 얼굴을 인식하고 표정분석을 시작한다. 감정분석에 소요되는 시간은 최대 15초이며 초과시 다시 처음상태로 돌아간다. 동시에 온습도센서의 센싱값이 입력된 표정데이터와 함께 연산부로 전송된다. 이중 표정데이터는 앞서 기술한 CNN 모델을 통해 5가지 감정 중 하나의 상태에 해당하는 값과 그 감정의 유사도값을 출력한다. 본 시스템은 감정유사도값을 활용하여 발향팬의 세기를 제어한다. 감정유사도를 통해 사용자의 감정의 깊이를 판단하고 그 정도가 클 수록 향의 세기를 강하게 하기위해 발향팬의 세기를 빠르게 제어한다. 출력된 1개의 감정은 각도 변수로 전환되어 스텝모터 제어에 사용되며 이를 통해 감정의 상태에 해당하는 향이 발향가능한 상태로 설정된다. 끝으로 온습도값을 바탕으로 팬의 동작시간을 제어한다. 온도가 높거나 습도가 낮을때는 향의 확산이 빠르므로 동작시간을 상대적으로 짧게 설정하고, 그 반대인 경우는 길게 제어하여 외부환경에 상관없이 일정한 정도의 향이 유지되도록 하기 위함이다. 팬 동작시간은 25℃와 습도 50%를 기준으로 현재 온습도와 차에 가중치 각각 -0.5와 0.7을 곱하여 기준동작시간 30초에 더한다. 또한 수동조작모드를 두어 사용자의 임의로 원하는 향을 발향하는것 또한 가능하다. 수동조작모드는 IoT기기처럼 스마트폰 어플리케이션으로 컨트롤 한다.

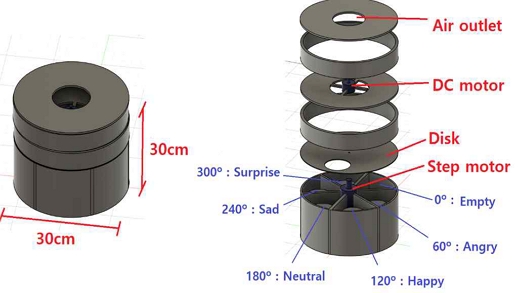

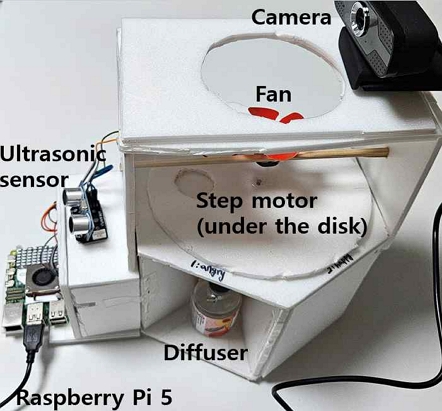

그림 5는 본 기기의 설계이며 향간의 차폐를 위해 각각의 향이 분리되어있다. 스텝모터를 이용하여 상단부 디스크가 돌아가며 단 하나의 향을 선택하는 구조로 동작한다. 또한 전면부에 위치한 카메라모듈, 온습도센서, 초음파 센서로 입력데이터를 센싱한다.

본 기기는 라즈베리파이5 를 메인프로세서로 사용한다. 카메라 센서, 온습도 센서 (DHT 11), 초음파센서(HC-SR04), 스텝모터와 팬모터, 모터드라이버 (L298D)를 활용하여 통신하기 편리하며 이미지 처리에 필요한 연산속도를 충분히 확보할 수 있기 때문이다[11].

또한 이후 진행할 수동모드구현을 위한 IoT통신기능 또한 가능하다. 또한 그림 6은 완성된 프로토타입이며 육각형 구조로, 구동 종료시 발향이 되지 않도록 향이 존재하지 않는 영역이 포함되어있다. 온습도센서 및 모터드라이버는 기기 전면부에 내장되어있으며 상부에는 카메라와 팬모터가 위치해있다.발향 시스템 내부는 총 6칸으로 설계되었으며 표 1 에서는 5가지 각 감정별로 할당된 스텝모터의 동작 각도를 나타낸다. 각도의 기준점은 향이 없는 칸이다. 예를 들면, 감정분석 결과 분노(Angry)로 분석되면 스텝모터가 60° 회전하게 되고, 분노에 해당되는 디퓨저가 발향 된다.

Ⅳ. 실험 및 고찰

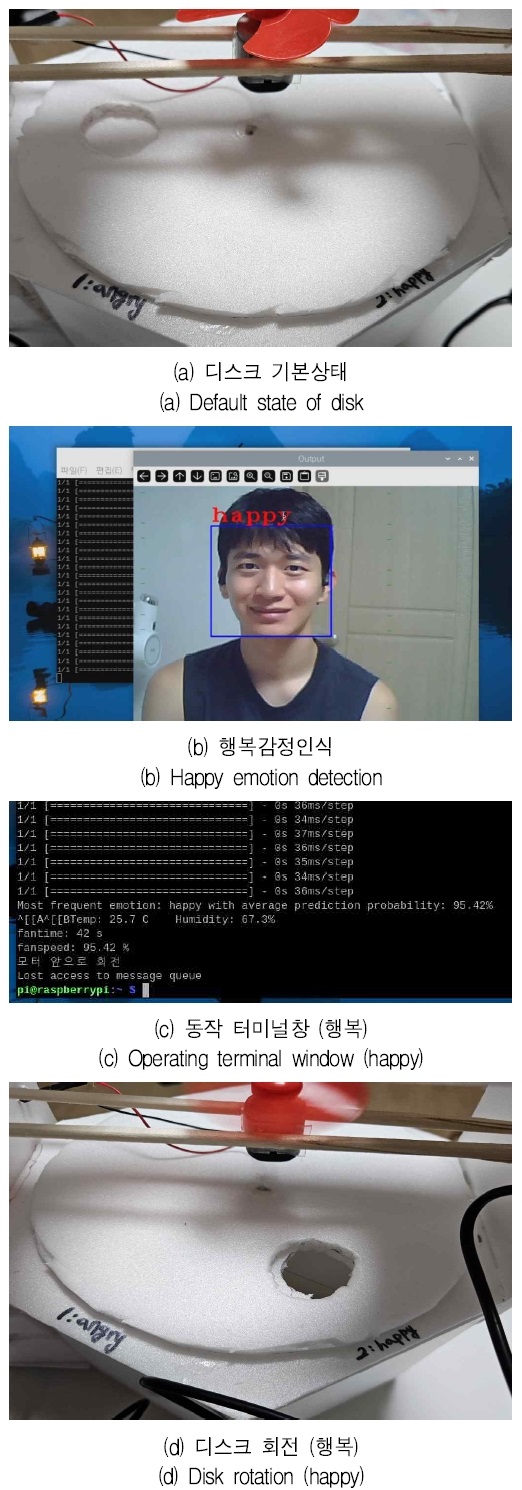

스마트 디퓨저 시스템의 프로토타입 실험은 행복에 해당하는 감정으로 진행되었다. 그림 7은 감정인식 전에 해당하는 기본값으로 디스크가 세팅됨을보 여주고 감정인식 후 행복 감정에 해당하는 향에 맞게 디스크가 회전한 상태를 나타낸다. 또한 그림 7은 전체 동작과정에 해당하는 본 기기의 라즈베리파이 실행 터미널창을 보여주며 감정값, 감정유사도 그리고 온습도 상황에 따라 제어됨을 나타낸다.

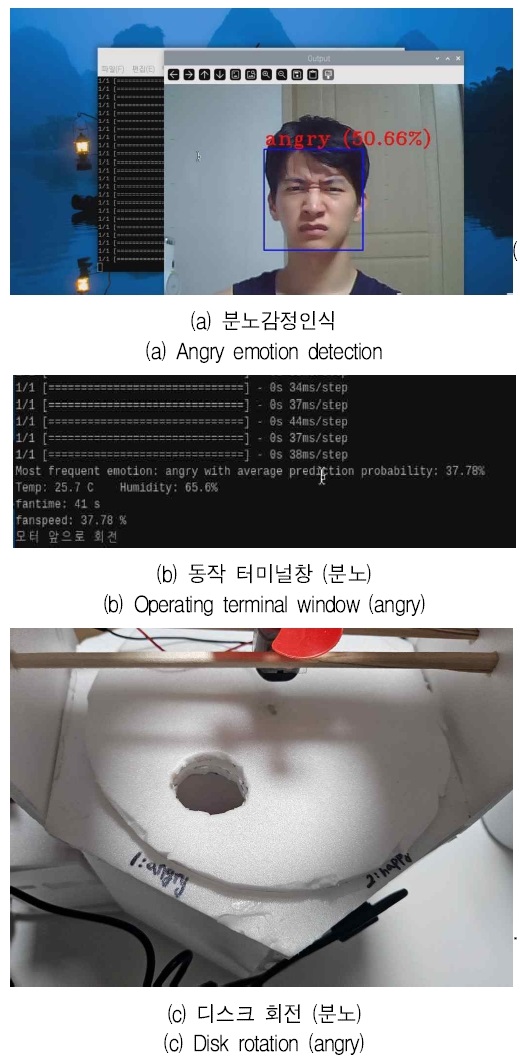

본 시스템은 초음파 센서로 접근을 감지후 카메라가 실행된다. 감정인식을 15초 동안 수행하며 그 과정에서 가장 먼저 100번 인식에 성공한 감정인 행복을 감정값으로 반환하며 이때 유사도값을 평균내어 95.42%라는 감정유사도값으로 설정한다. 이후 현재 온도와 습도는 25.7℃와 67.3%가 측정되었고 42초간 팬이 회전하도록 동작시간이 설정되었다. 팬의 세기는 감정유사도값과 동일하며 최대 속도의 95%로 동작한다. 그러나 분노감정을 인식할 때는 최대 50.66% 정도로 유사도값이 추출되며 이는 행복감정을 인식할 때와 다소 격차가 존재한다.

본 논문에서 구현한 스마트 디퓨저 시스템은 플로우차트 순서에 맞게 동작하고 있으나 각 감정마다 유사도값을 도출할때 최대로 반환되는 값의 차이가 존재한다. 모델 학습 결과인 그림 9 (a)와 (b)를 보면 Validation Loss와 Accuracy가 50 Epoch 부터 Training Loss와 Accuracy가 제법 차이가 나기 시작하여 과적합이 발생한 것으로 판단된다. 특히 행복감정 데이터가 다른 감정에 비해 현저히 많아 모델이 행복에 대한 판단에 치우쳐 다른 감정을 잘 분류하지 못하는 것으로 보인다. 또한 감정의 특징을 추출하기 어려운 데이터가 섞여 있어 모델의 학습을 방해하여 정확도를 낮추는 것으로 판단된다. 이를 해결하기 위해서 계속되는 연구를 통해 소수 클래스인 슬픔과 분노 데이터에 대해 이미지 변환, 텍스트 재샘플링 등의 데이터 증강 기법을 적용하고 Dropout, L1/L2 Regularization과 같은 Regularization 기법을 적용하여 모델의 복잡도를 낮추고 과적합을 방지하고자 한다.

또한, Validation Loss가 더 이상 감소하지 않을 때 학습을 중단하는 Early Stopping 기법을 적용하여 과적합을 방지하고자 하며, 추가적인 모델링 수정을 통해 각 감정 간의 오차 격차를 줄일 계획이다.

Ⅴ. 결 론

Mini-Xception을 아키텍처로 사용한 CNN을 이용하여 저사양 기기에서 실시간으로 감정을 인식할 수 있다. 카메라에 얼굴이 인식되어 이미지가 입력되면 감정 5가지 (중립, 슬픔, 분노, 행복, 놀람) 중에서 1가지를 출력하며 각 클래스에 맞는 감정 유사도를 출력한다. 출력된 데이터를 기반으로 향과 팬의 동작을 제어한다. 특히 감정 유사도값을 바탕으로 감정의 깊이를 파악하고 그에 따라 향의 세기를 조절하고 반복된 감정인식과정을 거쳐 순간적인 값이 아닌 사용자의 현재 상태와 가장 일치하는 향을 선택한다.

스마트 디퓨저는 앞서 서술한 기술들을 통해 사용자의 감정상태에 어울리는 향을 외부환경에 영향받지 않고 적절한 시간과 세기로 발향하며 스트레스와 감정조절이라는 본 연구의 목적을 달성할 수 있을 것으로 기대된다.

그러나 실험과정에서 행복감정을 인식했을때 95.42%의 감정유사도값을 바탕으로 현재 온습도 상황에 맞춰 42초간 동작했으나 분노감정은 37.78% 라는 평균 감정유사도 값이 출력되어 각 감정간의 인식차이가 발생했음을 알 수 있다.

추후 연구과제로는 더 많은 실험 데이터들을 총합하여 각 클래스에 해당하는 감정 각각의 유사도 범위와 더 정확도 높은 감정인식 모델, 감정별로 감정인식 정확도를 개선할 필요성이 있다. 또한 추후 스마트폰 어플리케이션을 통한 IoT 수동조작 기능을 추가 할 예정이다.

Acknowledgments

2024년도 한국정보기술학회 하계종합학술대회에서 금상을 수상한 논문 “딥러닝과 사용자 감정인식 기반의 스마트 디퓨져”[12]을 확장한 것임

References

-

M. Lis-Balchin, "Essential oils and ‘aromatherapy’ their modern role in healing", Journal of the royal society of health, Vol. 117, No. 5, pp. 324-329, Oct. 1997.

[https://doi.org/10.1177/146642409711700511]

-

M. K. Singh, P. Singh, and A. Sharma, "Facial emotion based automatic music recommender system", 2023 International Conference on Sustainable Emerging Innovations in Engineering and Technology (ICSEIET), Ghaziabad, India, pp. 699-703, Sep. 2023.

[https://doi.org/10.1109/ICSEIET58677.2023.10303573]

-

T. H. Kim, C. Yu, and S. W. Lee, "Facial expression recognition using feature additive pooling and progressive fine-tuning of CNN", Electronics letters, Vol. 54, No. 23, pp. 1326-1328, Nov. 2018.

[https://doi.org/10.1049/el.2018.6932]

-

A. Voulodimos, N. Doulamis, A. Doulamis, and E. Protopapadakis, "Deep Learning for Computer Vision: A Brief Review", Comput Intell Neurosci, pp. 7068349, Feb. 2018.

[https://doi.org/10.1155/2018/7068349]

-

Z. Li and F. Liu, "A survey of convolutional neural networks: analysis, applications, and prospects", IEEE Transactions on Neural Networks and Learning Systems, Vol. 33, No. 12, pp. 6999-7019, Dec. 2022.

[https://doi.org/10.1109/TNNLS.2021.3084827]

-

S. K. LokeshNaik, "Real time facial emotion recognition using deep learning and CNN", 2023 International Conference on Computer Communication and Informatics (ICCCI), Coimbatore, India, pp. 1-5, Jan. 2023.

[https://doi.org/10.1109/ICCCI56745.2023.10128259]

-

HaoBiao and D.-S. Kang, "The research of face expression recognition based on CNN using tensorflow", Journal of Advanced Information Technology and Convergence, Vol. 7, No. 1, pp. 55-63, Jul. 2017.

[https://doi.org/10.14801/jaitc.2017.7.1.55]

-

O. Arriaga, M. Valdenegro-Toro, and P. Plöger, "Real-time convolutional neural networks for emotion and gender classification", arXiv:1710.07557, , ICRA 2018, Oct. 2017.

[https://doi.org/10.48550/arXiv.1710.07557]

-

S. A. Fatima, A. Kumar, and S. S. Raoof, "Real time emotion detection of humans using mini-Xception algorithm", IOP conference series: materials science and engineering, Vol. 1042, No. 1, pp. 12-27, Dec. 2021.

[https://doi.org/10.1088/1757-899X/1042/1/012027]

- "Face_Emotion_Recognition_Machine_Learning", https://github.com/kumarvivek9088/Face_Emotion_Recognition_Machine_Learning, [accessed: Aug. 05, 2024]

-

J. H. Park and C. H. Kim, "Analysis of accuracy and computation complexity of bearing fault diagnosis methods using CNN-based deep learning", Journal of Digital Contents Society, Vol. 24, No. 6, pp. 1373-1379, Jun. 2023.

[https://doi.org/10.9728/dcs.2023.24.6.1373]

- W. H. Jang, J. H. Pyo, J. S. Kim, W. W. Choi, J. Y. Hwang, J. H. Jung, and I. S. Lee, "Smart Diffuser based on User's Emotion Recognition and Deep Learning", The Proceedings of the 2024 Summer Conference, Jeju, Korea, pp. 768-771, May 2024.

2018년 3월 ~ 현재 : 경북대학교 전자공학부 학사과정

관심분야 : 임베디드 시스템, 딥러닝, 제어시스템, 계전설계

2022년 3월 ~ 현재 : 경북대학교 전자공학부 학사과정

관심분야 : 컴퓨터비전, 딥러닝, IoT

2019년 3월 ~ 현재 : 경북대학교 전자공학부 학사과정

관심분야 : 임베디드 시스템, IoT

2019년 3월 ~ 현재 : 경북대학교 전자공학부 학사과정

관심분야 : IoT, 임베디드 시스템

2019년 3월 ~ 현재 : 경북대학교 전자공학부 학사과정

관심분야 : 빅데이터

2019년 3월 ~ 현재 : 경북대학교 전자공학부 학사과정

관심분야 : IoT, 제어시스템

1986년 : 경북대학교 전자공학부(공학사)

1989년 : 경북대학교 전자공학부(공학석사)

1997년 : 경북대학교 전자공학부(공학박사)

1997년 3월 ~ 2008년 2월 : 상주대학교 전자 및 전기 공학 교수

2005년 8월 ~ 2007년 1월 : 미국 샌디에고 주립대학교 방문학자

2008년 3월 ~ 2014년 10월 : 경북대학교 전자전기공학부 교수

2014년 11월 ~ 현재 : 경북대학교 전자공학부 교수

관심분야 : 배터리 SOC 및 SOH 추정, 시스템 고장진단 및 고장허용제어, 신경회로망 기반 지능제어, 지능형 센서 시스템