특징 어텐션 기반 지역 제안 증강 및 Teacher-Student 기반 객체 탐지 모델

초록

객체 탐지는 딥러닝 기술의 발전으로 원격 탐사 분야에서 주목받고 있지만 자연 이미지에 기반한 기존 모델은 작은 물체가 포함된 원격 탐사 이미지의 특징을 반영하지 못해 바로 적용했을 때 성능 저하가 발생한다. 본 연구에서는 주석이 없는 데이터셋과 있는 데이터셋을 함께 활용하는 이중 모델 학습 구조를 도입했다. Teacher 모델은 특징 어텐션 기반 지역 제안 증강 모듈을 통해 고품질의 슈도 라벨(Pseudo label)을 생성하고, student 모델은 이를 학습하며, 지수 이동 평균 전략(EMA, Exponential Moving Average)으로 teacher모델을 업데이트한다. 두 개의 원격 탐사 이미지 데이터셋에서 작은 물체가 포함된 이미지를 선별하여 제안한 모델의 성능을 검증한 결과, 기존 모델보다 17.7% 성능이 향상되었다.

Abstract

Object detection, driven by advancements in deep learning, is increasingly important in remote sensing. However, existing methods, based on natural images, often fail to capture the characteristics of small objects in remote sensing images, leading to performance degradation when directly applied. This study proposes a dual-model training framework that combines annotated and unannotated datasets. The Teacher model generates high-quality pseudo labels via a feature attention-based region proposal module, which the Student model learns from, while the Teacher model is updated using an Exponential Moving Average(EMA) strategy. Experimental results on two remote sensing datasets showed a 17.7% performance improvement over existing models.

Keywords:

computer vision, deep learning, object detection, remote sensing imageⅠ. 서 론

최근 몇 년간 원격 탐사 기술의 급속한 발전으로 원격 탐사 분야는 빅데이터 시대로 접어들었다[1][2]. 이런 풍부한 데이터셋을 바탕으로 다양한 목적을 가지고 이미지를 자동으로 분석하고 이해하는 연구가 많이 이루어졌다. 객체 탐지는 대상이 되는 객체의 클래스 분류와 위치 정보를 함께 제공할 수 있어 원격 탐사 이미지를 이해하는 데 기본적이고 필수적인 기술 중 하나로 여겨진다. 특히, 원격 탐사 이미지는 다양한 지질학적 정보를 포함하고 있어 자연재해 모니터링, 도시 계획, 농업 관리 등[3] 여러 분야에서 객체 탐지 연구[4]가 활발하게 진행되었다. 이전 연구들에서 자연 이미지 기반으로 연구된 객체 탐지 모델을 원격 탐사 이미지에 그대로 적용하면 심각한 성능 저하가 발생하는 것이 밝혀졌다[5]. 원격 탐사 이미지들은 자연 이미지에 반해 포괄하는 지역의 범위가 달라 포착된 객체의 크기가 다양하다. 이러한 원격 탐사 이미지의 특징 때문에 결과적으로 작은 물체에 대한 지역 제안(Region proposal) 누락이나 탐지 성능 저하와 같은 어려움이 발생하고 있다.

최근 이미지에 포함된 작은 객체를 탐지하기 위한 연구가 활발하게 이루어지고 있다. J. Wang et al.[6]의 논문에서는 항공 이미지에서 작은 객체를 탐지하기 위해 여러 중심점을 기반으로 해당 객체의 오프셋과 크기를 추정하는 다중 중심점 기반 학습 네트워크를 개발하였다. X. Wu et al.[7]의 논문에서는 적외선 이미지에서 작은 물체를 탐지하기 위해 객체의 다중 레벨 및 다중 규모 표현 학습을 가능하게 하는 UIU-Net을 제안했다. 이러한 방법들은 풍부하고 정교하게 주석이 달린 데이터셋을 기반으로 학습한다. 하지만 작은 객체가 많이 포함된 원격 탐사 이미지들에 경계 상자 주석을 다는 작업은 비용이 많이 들고 시간이 오래 걸린다. 따라서 본 연구에서는 주석이 없는 데이터셋을 학습에 활용함으로써 지도학습을 능가하면서 추가적인 일반화 성능을 내도록 하는 준지도 학습 기법의 하나인 Teacher-Student 구조 학습[8]을 도입한다. 본 학습 방법에서는 먼저 주석이 있는 데이터셋으로 teacher 모델을 학습시킨다. 이후 준지도 학습에서 teacher 모델은 주석이 없는 이미지에 대해 Pseudo label(이하 슈도 라벨)[9]을 생성하고, student 모델은 슈도 라벨을 활용해 학습하면서 모델을 업데이트한다. 원격 탐사 이미지에는 작은 객체가 존재할 뿐만 아니라 비슷한 객체들이 한 이미지 안에 반복되는 경우가 많다. 따라서, 비슷한 객체의 위치 정보를 최대한 추출해 teacher 모델이 고품질 슈도 라벨을 생성할 수 있는 특징 어텐션 기반 지역 제안증강 모듈을 제안한다.

본 논문의 구성은 다음과 같다. 2장에서는 일반적인 객체 탐지 모델이 아닌 원격 탐사 이미지의 고유 특성을 반영하여 탐지 성능을 높이는 제안된 모델 구조를 설명하고, 3장에서는 제안된 방법을 검증할 수 있는 실험 결과를 제시한다. 마지막으로, 4장에서 결론과 추후 연구에 대해 새로운 아이디어를 제시하며 끝맺는다.

Ⅱ. 제안 시스템 구성

2.1 전체 개요

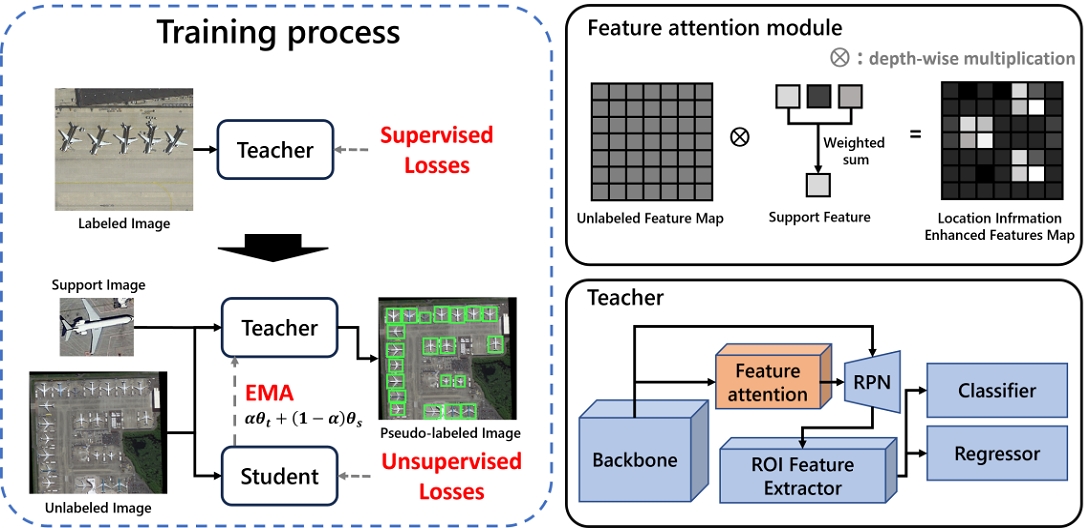

그림 1은 본 연구에서 제안하는 특징 어텐션 기반 지역 제안 증강 모듈과 Teacher-Student 구조를 포함한 전체적인 개요를 나타내고 있다. 본 시스템은 라벨링된 이미지를 활용해 학습하는 단계와 라벨링이 되지 않은 이미지를 활용해 학습하는 단계로 구성되어 있다. 첫 번째는 기존의 지도학습과 마찬가지로 경계 상자와 클래스 주석이 달린 이미지로 기본 모델을 학습시킨다. 다음 단계에서는 라벨링되지 않은 이미지와 각 클래스의 서포트 이미지가 같이 주어져 teacher 모델과 student 모델로 입력된다. 이때 student 모델은 앞의 과정에서 학습된 teacher 모델의 가중치를 사용한다. Teacher 모델은 feature attention[10]모듈이 포함된 구조로 되어 있다. Feature attention모듈은 이미지의 전체 feature map과 support feature 사이에 어텐션을 통해 객체의 위치 정보를 효과적으로 강조하고, 이를 활용해 지역 제안을 증강해 고품질의 슈도 라벨이 생성되도록 한다.

Student 모델이 슈도 라벨로 학습해 파라미터 업데이트가 되고 나면 EMA(Exponential Moving Average)를 적용하여 teacher 모델의 파라미터를 점진적으로 업데이트한다. 이후 2.2장, 2.3장에서는 본 시스템의 주요 부분인 feature attention 기반 지역 제안 증강 모듈과 Teacher-Student 이중 모델 학습 구조에 대해서 상세히 설명한다.

2.2 특징 어텐션 기반 지역제안 증강 모듈

본 장에서는 새로운 클래스 객체에 대한 지역 제안을 증강하기 위한 특징 어텐션 방법을 상세하게 설명한다. 식 (1)은 일정한 크기로 풀링된 support feature끼리의 상관계수를 계산하는 식이고, 식 (2)는 상관계수를 가중치로 사용하여 공통 특성을 최대화하는 support feature 조합을 생성하기 위한 식이다.

| (1) |

| (2) |

pi는 학습된 backbone에 의해 추출되고 일정한 크기로 풀링된 support feature이고, N은 support feature의 개수이다. GAP[11]는 Global Average Pooling 방식으로 출력한 결과이다. 즉 F는 공통 특성을 가장 많이 포함하는 feature가 중심이 되어 조합을 이루고 feature attention을 통해 비슷한 객체의 위치 정보를 강조하기 위해 사용된다.

| (3) |

Fimg는 backbone에 의해 추출된 전체 이미지 feature map이고 ⊗는 깊이 별 곱 기호이다. 식 (3)에 의해 객체의 위치 정보가 강조된 feature map D가 생성되고 나면 지역 제안 네트워크에 전달되어 3×3 컨볼루션 층을 거쳐 객체 존재 여부와 경계 상자 위치가 나온다. 즉, 해당 객체의 위치 정보가 향상된 feature map을 활용하여 해당 부분에 대한 더 풍부한 경계 상자 제안을 얻을 수 있다. Teacher 모델은 이 모듈의 도움을 받아 작은 물체에 대한 지역 제안 누락 문제가 완화되고 고품질의 슈도 라벨을 추출할 수 있다.

2.3 Teacher-Student 이중 모델 학습 구조

본 장에서는 라벨링 되지 않은 데이터를 활용하기 위해 teacher 모델에서 생성된 슈도 라벨을 사용하여 student 모델을 최적화하고, 학습된 student 모델의 가중치를 점진적으로 전달하여 teacher 모델을 업데이트하는 Teacher-Student[8] 이중 모델 학습 방식을 소개한다.

3.1장에서 소개될 데이터셋의 구성 방법에 따라 라벨링이 되어있지 않은 이미지들은 라벨링이 되어있는 이미지들보다 포함된 객체의 크기가 작다. 따라서 teacher와 student 사이의 가중치 상호작용을 통해 두 모델이 모두 지속적으로 최적화되면 작은 객체에 대한 정확도를 향상시킬 수 있다. 감지 정확도가 향상됨에 따라 teacher 모델은 더 정확하고 안정적인 슈도 레이블을 생성하고, 그로 인해 student 모델은 점점 좋은 품질의 슈도 라벨을 활용한 학습이 가능해진다. Student 가중치를 전달하는 EMA식은 식 (4)와 같이 표현된다.

| (4) |

θ는 모델의 가중치를 의미하며 t와 s는 각각 teacher와 student를 의미한다. α는 하이퍼 파라미터로 이전 연구[8]에서 증명된 바와 같이 가장 성능이 좋았던 값인 0.99로 설정된다. 학습이 진행됨에 따라 teacher 모델의 가중치는 점진적으로 업데이트되어, student 모델의 큰 가중치 변동에 더 잘 견딜 수 있게 된다. 이에 따라 잘못된 슈도 라벨이 student 모델에게 주어지더라도 teacher 모델에 미치는 영향이 줄어들게 된다.

Ⅲ. 실 험

3.1 데이터셋 구성 방법

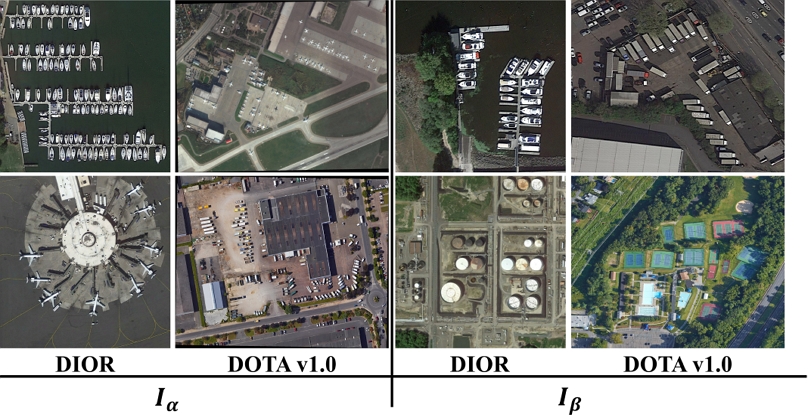

작은 물체가 포함된 데이터셋을 구성하기 위해 DIOR[1]와 DOTA v1.0[12]에서 객체 크기를 기준으로 이미지를 선별하여 크기별로 두 가지 데이터셋을 구성한다.

| (5) |

wi는 객체 상자의 너비, hi는 객체 상자의 높이를 의미하고, W는 이미지의 너비, H는 높이를 의미한다. S(bboxi)는 객체의 상대적 크기를 구하는 함수이다. 식 (6),(7),(8)에 의해 전체 이미지 N개 중에 조건에 해당하는 객체를 가진 이미지를 선별할 수 있다.

| (6) |

| (7) |

| (8) |

∥(•)는 조건에 해당하면 1, 해당하지 않으면 0으로 출력되는 조건부 함수이다. 0.036과 0.055는 이미지의 크기가 800×800이고 객체의 크기 threshold를 850과 2000으로 정했을 때 식 (5)에 의해 계산된 결과이다. 표 1에는 위 수식으로 선별하고 데이터 불균형을 막기 위한 언더 샘플링을 적용한 클래스별 이미지 개수가 나타나 있다. 그림 2 에는 구성한 데이터셋의 샘플 이미지가 표시되어 있다.

3.2 실험 환경

본 연구의 실험은 Window 10 64bit, AMD Ryzen 5 5600x, RAM 16GB, NVIDIA GeForce RTX 2070 SUPER를 사용한 환경에서 Pytorch를 사용하여 진행했다. 3.1장에서 선별된 데이터셋에는 총 6개의 클래스가 포함되어 있다. 클래스는 airplane, ship, vehicle, baseball field, storage tank, tennis court이다. 모델의 안정적인 학습을 위해 최적화 함수로는 SGD 옵티마이저를 사용하였고, 배치 사이즈는 4, 초기 학습률은 0.001로 설정하였다. 이중 모델 구조를 학습시키는 과정에서 teacher 모델에서는 이미지 증강기법을 사용하지 않고, student 모델에서는 회전, 반전, ColorJitter 3가지 증강기법을 적용하였다. 기본 모델의 구조와 student모델은 Faster-RCNN [13]을 사용하였으며 teacher 모델의 구조는 그림 1에 표현되어 있다.

3.3 성능 평가

표 2는 3.1에서 만든 데이터셋 Iα, Iβ에 대해 학습시킨 모델에 대한 객체 탐지 성능표이다. 기본 모델은 Iβ에 대해서 지도학습으로 학습시킨 모델의 결과로 전체 학습 과정에 포함되지만 타 논문[13]의 모델을 3.1에서 구성된 데이터셋에 대해 학습한 결과와 같다. 최종 모델은 그림 1에 표현된 것처럼 Iα에 대해 teacher-student 구조로 추가 학습된 모델의 결과이다. 성능 지표로는 IoU 임계값이 0.5인 mAP(Mean Average Precision)을 사용했고 mAP는 클래스별 AP(Average Precision)의 평균으로 구해진다. AP는 0에서 1까지의 Recall 구간에서 Precision의 평균값으로 계산되며, 아래 식과 같이 나타낼 수 있다.

| (9) |

| (10) |

Ncls는 전체 클래스 개수이다. 결과 표에서 볼 수 있듯이 Iβ에 대해 지도학습으로 학습한 기본 모델의 결과보다 Iα에 대해 teacher-student 구조로 추가 학습된 모델의 성능이 향상된 것을 볼 수 있다. Teacher 모델은 특징 어텐션 기반 지역 제안 증강으로 라벨링이 되지 않은 이미지에 대해 고품질의 슈도 라벨을 제공할 수 있으며, student 모델이 이를 같이 학습함으로써 모델이 더 다양한 정보와 패턴을 학습한다. 최종 mAP는 55.6에서 73.3으로 17.7% 증가했고. 각 클래스에 대해서 전체적으로 객체 탐지 성능이 좋아진 것을 볼 수 있다. 특히, 우리가 제안한 모델은 ship이나 vehicle과 같이 한 이미지에 비슷한 객체가 반복되는 클래스에 대해 더 좋은 성능을 나타내는 것을 볼 수 있다.

표 3은 EMA의 파라미터인 α값에 따른 탐지 성능 비교표이다. α가 0.5일때는 식 (4)에 의해 teacher모델의 가중치를 평균으로 업데이트하는 것과 같다. 표3.에서 볼 수 있듯이 α값이 0.5일 때보다 0.99일떄의 탐지 성능이 높은 것을 알 수 있다. 이는 α가 낮을수록 student의 가중치가 각 반복에서 teacher에 더 큰 영향을 미쳐, 노이즈가 많은 슈도 라벨의 영향을 받을 가능성이 커지기 때문에, 이를 줄일 수 있는 최적의 α 값은 0.99임을 보여준다.

Ⅳ. 결론 및 향후 과제

본 연구에서는 작은 객체를 포함한 원격 탐사 이미지에서 객체 탐지 성능을 올리기 위해 새로운 객체 탐지기 모델을 제안하였다. 라벨링 되지 않은 데이터셋을 추가 학습으로 활용할 수 있는 Teacher-Student 이중 모델 학습 구조를 채택하였고, 이 중에서 teacher 모델에는 고품질의 슈도 라벨을 생성하기 위한 특징 어텐션 기반 지역 제안 모듈을 제안하여 사용했다. 제안된 모듈은 입력된 전체 이미지에서 작은 객체의 위치 정보를 추출하여 활용함으로써 주석이 달리지 않은 이미지에도 teacher 모델이 고품질의 슈도 라벨을 생성할 수 있도록 한다. 제안된 모델을 검증하기 위해 수식에 의해 선별된 크기별 두 데이터셋을 구성하여, 실험을 통해 모델의 효과를 검증하였다. 테스트셋의 실험 결과는 지도학습만 적용한 모델보다 제안된 모듈과 이중 모델 학습 방법을 적용한 모델의 성능이 17.7만큼 증가하여 작은 물체 객체 탐지에 성능 향상을 이뤘다. 하지만 원격 탐사 이미지가 한정적인 구도를 가졌다는 고유한 특성 때문에 객체에서 충분한 특징 추출이 불가하여 클래스에 대한 일반화 성능이 떨어지는 문제가 여전히 존재한다. 이는 클래스 분류 성능에 영향을 끼치므로, 이를 해결할 수 있는 추가적인 연구를 향후 연구로 한다.

Acknowledgments

본 논문은 과학기술정보통신부 및 정보통신기획평가원(IITP)의 지원을 받아 수행중인 “이동형 모바일 환경 인공지능을 활용한 경계감시 시스템 기술개발”(1711193675)의 일부입니다

References

-

K. Li, G. Wan, G. Cheng, L. Meng, and J. Han, "Object detection in optical remote sensing images: A survey and a new benchmark", ISPRS journal of photogrammetry and remote sensing, Vol. 159, pp. 296-307, Jan. 2020.

[https://doi.org/10.1016/j.isprsjprs.2019.11.023]

-

Z. Li, et al., "Deep learning-based object detection techniques for remote sensing images: A survey", Remote Sensing, Vol. 14, No. 10, pp. 2385, May 2022.

[https://doi.org/10.3390/rs14102385]

-

B. H. Y. Alsalam, K. Morton, D. Campbell, and F. Gonzalez, "Autonomous UAV with vision based on-board decision making for remote sensing and precision agriculture", in 2017 IEEE Aerospace Conference, Big Sky, MT, USA, pp. 1-12, Jun. 2017.

[https://doi.org/10.1109/AERO.2017.7943593]

-

J. Kim and S. Lee, "Improvement of Object Detection Performance in Satellite Images using Image Segmentation and Up-scaling", The Journal of Korean Institute of Information Technology, Vol. 22, No. 6, pp. 21-29, Jun. 2024.

[https://doi.org/10.14801/jkiit.2024.22.6.21]

-

Z. Deng, H. Sun, S. Zhou, J. Zhao, L. Lei, and H. Zou, "Multi- scale object detection in remote sensing imagery with convolutional neural networks", ISPRS journal of photogrammetry and remote sensing, Vol. 145, pp. 3-22, Apr. 2018.

[https://doi.org/10.1016/j.isprsjprs.2018.04.003]

-

J. Wang, W. Yang, H. Guo, R. Zhang, and G. S. Xia, "Tiny object detection in aerial images", In 2020 25th international conference on pattern recognition (ICPR), Milan, Italy, pp. 3791-3798, Jan. 2021.

[https://doi.org/10.1109/ICPR48806.2021.9413340]

-

X. Wu, D. Hong, and J. Chanussot, "UIU-Net: U-Net in U-Net for infrared small object detection", IEEE Transactions on Image Processing, Vol. 32, pp. 364-376, Dec. 2022.

[https://doi.org/10.1109/TIP.2022.3228497]

-

Y. C. Liu, et al., "Unbiased teacher for semi-supervised object detection", arXiv:2102.09480, , Feb. 2021.

[https://doi.org/10.48550/arXiv.2102.09480]

- D. H. Lee, "Pseudo-label: The simple and efficient semi-supervised learning method for deep neural networks", Workshop on challenges in representation learning, ICML. Vol. 3, No. 2, pp. 896, Jun. 2013.

- Q. Fan, W. Zhou, C. K. Tang, and Y. W. Tai, "Few-shot object detection with attention-RPN and multi-relation detector", Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, Seattle, WA, USA, pp. 4013-4022, Jun. 2020.

-

M. Lin, Q. Chen, and S. Yan, "Network in network", arXiv:1312.4400, , Dec. 2013.

[https://doi.org/10.48550/arXiv.1312.4400]

-

G. S. Xia, et al., "DOTA: A large-scale dataset for object detection in aerial images", 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, USA, pp. 3974-3983, Jun. 2018.

[https://doi.org/10.1109/CVPR.2018.00418]

-

S. Ren, K. He, R. Girshick, and J. Sun, "Faster r-cnn: Towards real-time object detection with region proposal networks", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 39, No. 6, pp. 1137-1149, Jun. 2016.

[https://doi.org/10.1109/TPAMI.2016.2577031]

2023년 2월 : 인하대학교 컴퓨터공학과(학사)

2023년 3월 ~ 현재 : 인하대학교 대학원 전기컴퓨터공학과 석사과정

관심분야 : 머신러닝, 딥러닝, 컴퓨터 비전, 객체 탐지

2020년 2월 : 인하대학교 컴퓨터공학과(학사)

2022년 2월 : 인하대학교 대학원 전기컴퓨터공학과(석사)

2022년 3월 ~ 현재 : 인하대학교 대학원 전기컴퓨터공학과 박사과정

관심분야 : 머신러닝, 딥러닝, 컴퓨터 비전, 객체 탐지

2021년 8월 : 목포해양대학교 해양안전시스템공학과(박사)

2003년 10월 ~ 현재 : 선박해양플랜트 연구소(KRISO) 해사디지털서비스 연구센터 책임연구원

관심분야 : 해양안전, 해양서비스, e-Navigation

1989년 2월 : 성균관대학교 전기공학과(공학사)

1995년 5월 : Columbia University 전기공학과 전자공학과(공학석사)

2002년 12월: Syracuse University 전자공학과(공학박사)

2006년 9월 ~ 현재 : 인하대학교 컴퓨터공학과 교수

관심분야 : 모바일 컴퓨팅, 인공지능 시스템, 정보검색, 신경 회로망, 멀티미디어 시스템, 유비쿼터스 시스템, 신호처리