이미지 분할과 업스케일링을 활용한 위성 영상 내 객체 탐지 성능 향상 방안

초록

위성은 높은 고도에서 광범위한 지역을 촬영할 수 있다는 장점이 있다. 그러나 위성이 촬영한 영상은 일반적으로 공간 해상도가 낮아 영상 내에 포함된 소형 객체를 탐지하는 것이 쉽지 않다. 이러한 문제를 해결하기 위해 본 논문에서는 영상 분할과 업스케일 기법을 적용해 위성 영상 내에서 객체를 탐지하는 성능을 향상시킬 수 있는 방안을 제안한다. 제안하는 접근방안은 먼저 영상을 작은 크기로 분할하여 영상 내에서 객체가 차지하는 비중을 높이고, 영상 분할 과정에서 발생하는 픽셀 손실을 해결하기 위해 ESRGAN을 활용하여 분할된 영상을 업스케일한다. 성능평가는 YOLOv8을 기반으로 구축된 항공기 탐지모델 2종을 활용하여 실시했으며, 분할 및 업스케일이 적용된 영상에서 객체 탐지 성능이 크게 향상됨을 확인하였다.

Abstract

Satellites have the advantage of being able to take pictures of a wide area at a high altitude. However, satellite images generally have low spatial resolution, making it difficult to detect small objects included in the images. To solve this problem, this paper proposes a way to improve the performance of detecting small objects in satellite images by applying image segmentation and upscale techniques. We first divide the image into small sizes to increase the proportion of objects in the image, and upscale the segmented image by using ESRGAN to solve the pixel loss occurring during the image segmentation. The performance evaluation was conducted using two aircraft models built based on YOLOv8. As a result, it was confirmed that the object detection performance was significantly improved in the images to which segmentation and up-scaling were applied.

Keywords:

satellite image, object detection, YOLOv8, image segmentation, up-scaling, ESRGANⅠ. 서 론

높은 고도에서 촬영되는 위성 영상은 광범위한 지역에 대한 관측을 용이하게 해 주어 산불감시나 지도 제작, 해양 및 지질 관측 등의 환경 모니터링 분야에서 활발하게 활용되고 있다. 그리고 군사작전 측면에서도 위성 영상정보는 적의 이상 징후 판단 및 전장에서의 상황인식 개선을 위한 핵심 수단이기 때문에 최우선으로 활용되고 있다.

한편 우리 군(軍)은 그동안 주로 미국에 의존해 왔던 우주감시 능력을 독자적으로 확보하기 위한 첫 단계로서 한반도를 감시하는 정찰위성 5기(레이더위성 4기, 광학위성 1기)를 발사하는 사업인 425사업을 추진하고 있다. 2025년까지 전력화를 완료할 예정이며, 국방개혁 2.0에서도 우주의 군사적 활용에 대한 중요성을 강조한 바 있다[1].

이처럼 다양한 분야에서 위성 영상에 대한 활용성이 증대되고 우주공간으로 전장이 확대됨에 따라 우주에서의 감시 능력을 확보하려는 시도는 가속화되고 있어, 향후 처리해야 할 영상정보의 양도 크게 증가할 것으로 예상된다. 물론 그에 대응하기 위해 위성 영상 판독 등 관련 기술도 발전할 것이지만, 현 수준에서 공간 해상도가 상대적으로 낮은 위성 영상 내에서 특정 객체를 정확하게 탐지하는 것은 여전히 해결해야 할 과제로 남아 있다.

최근에는 인공지능(AI, Artificial Intelligence) 기술을 활용하여 위성 영상 판독을 보조하기 위한 다양한 기법들이 제시되고 있다. 그러나 광범위한 지역을 포함하는 위성 영상 내에서 객체들은 매우 작게 표시되어 AI 기반의 객체탐지 라이브러리를 활용하는 경우 성능이 현저하게 저하되는 현상이 발생한다. 이러한 문제를 해결하기 위해 선행연구[2]에서는 2종의 알고리즘을 이용하여 25,000×15,000 픽셀(375메가픽셀)의 크기를 가지는 대형 이미지를 대상으로 관심영역을 먼저 식별한 후, 식별된 관심영역을 분할하면서 소형 항공기 객체를 탐지하는 방안을 제안한 바 있다.

본 연구에서는 1024×1024픽셀의 크기를 가지는 위성영상을 대상으로 이미지 분할 및 업스케일링(Up-scaling) 기법을 적용하여 위성영상 내 포함된 소형 객체에 대한 탐지 성능을 향상시키는 방안을 제안하였다. 제안된 접근방법은 먼저 객체가 영상 내에서 차지하는 비중을 높이기 위하여 위성영상을 작은 크기의 영상으로 분할한다. 이어서 영상 분할 과정에서 발생하는 픽셀(Pixel)의 손실을 보상하기 위해 ESRGAN(Enhanced Super-Resolution Generative Adversarial Network)[3]을 활용하여 분할된 영상을 업스케일링한다.

성능평가는 YOLO(You Only Look Once) 시리즈중 YOLOv8[4]을 기반으로 구축된 항공기 탐지모델 2종을 활용하여 실시하였다. 데이터세트는 3종(① 원본 위성영상, ② 위성영상 내에서 객체 비중이 높아지도록 분할한 영상, ③ 픽셀 보정을 위해 업스케일링까지 실시한 영상)으로 구분하여 구축하였으며, 각 데이터세트를 대상으로 객체탐지 성능을 측정하여 비교하였다.

본 논문의 구성은 다음과 같다. 2장에서는 실험에서 사용한 데이터세트를 설명하고, YOLOv8 및 ESRGAN에 대해 살펴본 후 관련 연구를 정리한다. 3장에서는 실험 과정을 설명하고, 4장에서는 실험 결과를 분석한다. 마지막으로 5장에서 연구 결과를 요약하면서 본 연구의 제한사항과 향후 연구 과제들을 제시한다.

Ⅱ. 관련 연구

2.1 위성영상 객체 판독 데이터세트

본 연구에서는 한국지능정보사회진흥원이 운영하는 AI 통합 플랫폼인 AI-Hub를 통해 제공되고 있는 한국항공우주연구원의 위성영상 객체 판독 데이터세트를 사용하였다.

2021년 6월 최초로 개방된 위성영상 객체 판독 데이터세트는 국산 위성인 아리랑 3호 위성을 통해 촬영된 영상으로서, 재난, 환경, 에너지, 자원, 안보, 식량 등 위성영상을 다루는 다양한 분야에서 활용할 수 있도록 5종(관심객체 검출, 건물 윤곽 추출, 도로 윤곽 추출, 구름 추출, 레이더영상 수계 추출)으로 구분하여 제공되고 있다. 본 연구에서는 관심 객체 검출을 위해 제공되는 데이터세트 중 항공기 사진을 포함한 1024×1024픽셀 해상도의 위성영상 50장을 활용해 비교 대상이 될 3종의 데이터세트를 구축하고 실험을 진행하였다. 50장의 위성영상에는 총 861개의 항공기 객체가 포함되어 있다.

2.2 YOLOv8

YOLO 시리즈는 객체탐지에 가장 많이 사용되는 딥러닝 라이브러리로 2015년 처음 공개되었다. 그 중 YOLOv8은 2023년 1월에 Ultralytics 社에서 공개 라이브러리로 발표하였다. 정확성과 속도 측면에서 최첨단 성능을 제공하는 YOLOv8은 광범위한 애플리케이션에서의 다양한 객체탐지 작업에 최적화되어 있는 새로운 기능들이 다수 포함되어 있다.

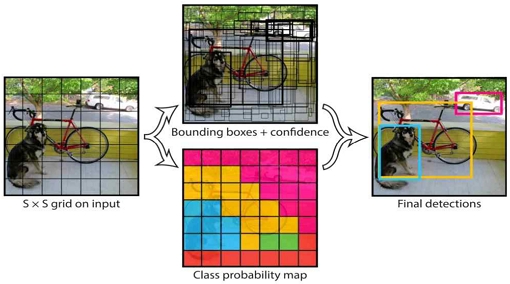

YOLO는 객체 검출 속도를 높이기 위해 그림 1에서 보는 바와 같이 영상을 그리드 셀로 나누고, 각 셀마다 객체의 존재, 종류, 크기, 위치를 한 번에 예측한다. 즉, 객체 식별과 위치 선정을 동시에 수행하는 Single-Stage 모델로서, Two-Stage 모델인 RoI Transformer나 Faster R-CNN 등과 달리 영상 내에서 객체를 한 번에 예측하기 때문에 객체탐지 속도가 매우 빠르다는 장점을 가진다[5][6].

YOLOv8은 YOLOv5와 비교했을 때 크게 5가지 사항들이 개선되었다[4]. 우선 YOLOv5에서는 컨볼루션 계층(Convolutional layer) 중 하나인 C3가 3x3 컨볼루션 필터를 사용하여 처리를 수행하는 반면, YOLOv8는 ‘C2f’ 모듈이 입력 데이터를 2x2 컨볼루션 필터와 1x1 컨볼루션 필터를 사용해서 처리하기 때문에 더욱 경량화되었다. 또한, Decoupled-Head는 YOLOv5의 Head 아키텍처와 달리 다양한 크기의 객체를 탐지하고 처리하는데 더 유연하게 대처할 수 있도록 설계되어 있다. 이 외에도 최첨단 백본 및 넥(Neck) 아키텍처를 사용해 향상된 객체 추출 및 탐지 성능을 보장하고, 다양한 사전학습 모델을 제공하기 때문에 특정한 사례에 적합한 모델을 더 쉽게 찾을 수 있다. 손실 함수 및 샘플 할당 방법 등도 개선되어 이전 시리즈보다 더 높은 정확도와 속도를 제공한다.

이상과 같이 YOLOv8은 신속하고 정확한 객체탐지에 더해 사용자 편의성과 유연성까지 제공한다. 이러한 장점은 비전문가가 대부분이지만 신속하게 정보를 제공해야만 하고, 급변하는 상황에 유연하게 대처할 수 있어야 하는 군사작전환경에서 절대적으로 필요한 요건이기 때문에 본 연구에서는 다양한 CNN 모델 중 YOLOv8을 실험 모델로 선정하였다.

YOLOv8을 활용하여 객체탐지를 시도했던 기존 연구들은 다음과 같다. J. Lee et al.[7]은 YOLOv8을 사용하여 항공기 유도원과 마샬링을 인식하는 알고리즘을 제안하였으며, 시뮬레이션을 통해 UAM의 유도제어가 가능한 것을 확인하였다. F. M. Talaat et al.[8]은 YOLOv8 알고리즘을 기반으로 하여 화재 관련 특징을 실시간으로 감지하는 스마트 화재 감지 시스템을 제안하였다. D. J. Kim et al.[9]은 YOLOv8과 Openpose를 활용하여 CCTV 영상에서 공공장소 흡연자를 효과적으로 검출하였다. Y. Jang et al.[10]은 YOLOv8 기반의 시각장애인용 도로 횡단 보행 보조를 위한 애플리케이션을 구현하였다. 실험 결과 YOLOv8을 활용한 객체탐지로 시각장애인에게 애플리케이션을 통해 간단한 횡단보도 관련 정보제공이 가능함을 확인하였다.

2.3 ESRGAN

ESRGAN은 초해상도(Super-resolution) 분야에서 널리 사용되는 오픈소스 라이브러리로서 딥러닝을 사용하여 이미지의 화질을 개선하는 기술이다[3].

GAN(Generative Adversarial Network)을 기반으로 하는 ESRGAN은 저해상도 이미지를 입력으로 받아 GAN을 사용하여 고해상도 이미지를 생성한다.

이 과정에서 ESRGAN은 GAN의 기본적인 동작 방식과 유사하게 생성되는 가짜 고해상도 이미지와 진짜 고해상도 이미지의 판별을 통해 생성자와 판별자가 서로 경쟁하면서 모델을 학습시킨다.

그리고 ESRGAN은 더 많은 인공신경망 계층을 기반으로 픽셀값을 보정하는 RDB(Residual Dense Block)를 사용하여 이미지를 생성한다. 이러한 방식으로 ESRGAN은 기존 초해상도 기술에 비해 더욱 자연스러운 이미지를 생성한다[11]. 판별자는 단순 진위 여부를 판단하는 것이 아니라 RaGAN(Relativistic average GAN)을 통해 가짜 이미지가 얼마나 더 상대적으로 진짜 이미지 같아 보이는지에 대한 확률을 출력한다.

또한, 초해상화 분야에 처음으로 딥러닝 기술을 적용했던 SRCNN 모델 등과 달리 ESRGAN 모델은 비지도학습 방법이 사용된다[12]. 즉 레이블링되지 않은 데이터의 처리가 가능하다. 따라서 비전문가도 복잡한 처리 작업을 효율적으로 처리할 수 있게 해주어 본 연구의 실험 모델로 선정하였다.

ESRGAN을 활용한 기존 연구들은 다음과 같다. Seungmin Lee[13]은 ESRGAN 모델을 사용하여 위성영상의 초해상화가 가능함을 보이고, 그 성능을 정량적으로 확인하였다. Yoo Suhong et al.[14]은 드론이 촬영한 영상의 해상도 향상을 위해 각종 벤치마크에서 좋은 성능을 보인 EDSR과 SRGAN 모델을 사용하였으며, SRGAN의 성능이 가장 좋은 것으로 확인했다.

Chaewon Lee et al.[15]은 해상도가 매우 떨어지고 육안으로는 식별하기 어려운 차량 번호판을 육안으로 식별 가능한 수준에 도달하도록 복원하였다. Jae-Hyeon Mun et al.[16]은 전기 설비의 안전 상태 정보를 나타내는 저해상도 디스플레이 영상에서의 정보 추출을 위해 ESRGAN 기반의 초해상화를 적용하여 고해상도 영상으로 품질을 개선한 후, 문자 인식기를 통해 정보를 추출하는 방법을 제안하였고, 더 높은 문자 인식률을 얻을 수 있었다.

본 연구에서는 ESRGAN의 가장 최신 버전인 Real ESRGAN 라이브러리를 활용하였다.

Ⅲ. 실험 설계

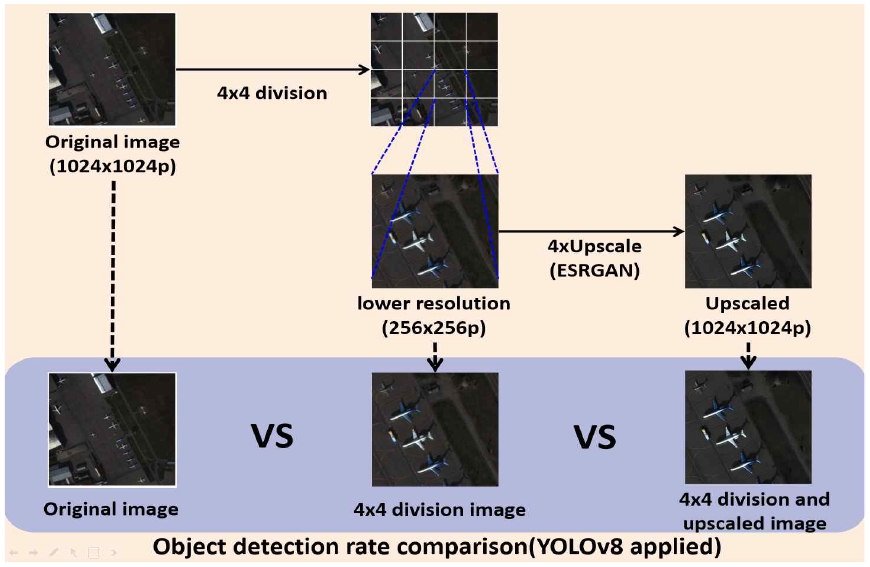

실험은 그림 2에서 보는 바와 같이 원본 위성영상과 4×4 분할만을 적용한 위성영상, 그리고 4×4 분할에 ESRGAN으로 업스케일링까지 추가한 위성영상 등 3종의 데이터세트를 대상으로 사전학습이 완료된 YOLOv8 기반의 항공기 탐지모델 2종을 사용하여 객체탐지 성능을 측정하고 그 결과를 비교하였다.

실험에 사용된 사전학습 모델 2종은 YOLOv8을 기반으로 항공기를 사전학습한 ‘Detect Planes’과 ‘Aero Sat’ 모델이다. 두 모델은 RoboFlow[17]를 통해 제공되는 항공기 사전학습 모델 10종을 대상으로 성능을 평가했을 때 가장 우수한 항공기 탐지 성능을 보인 모델이다.

‘Detect Planes’ 모델은 항공기 및 드론을 이용해 촬영한 항공기 영상 447장을 기반으로 각 영상당 5% 이내의 픽셀 변화를 준 영상 2장을 추가 생성하는 방식으로 데이터세트를 증강하여 총 1,341장의 항공기 영상을 학습하였다. ‘Aero Sat’ 모델 역시 항공기 및 드론으로 촬영한 항공기 영상 1,173장을 기반으로 각 영상당 7% 이내의 회전을 준 영상 2장을 추가로 생성하는 방식으로 데이터세트를 증강하여 총 3,519장의 항공기 영상을 학습하였다.

실험은 다음과 같은 순서로 진행했으며, 각 사전학습 모델별로 실시했다. 먼저 1024×1024픽셀의 크기를 가지는 원본 위성영상에 대해 객체탐지율과 오탐을 확인하였다. 이때, 원본 위성영상은 YOLOv8의 입력 크기에 맞춰서 640×640픽셀의 크기로 변환하여 처리했다.

두 번째 실험은 원본 위성영상을 4×4 그리드로 16등분 분할하여 영상에서 객체가 차지하는 비중을 높여서 실시했다. 이때 분할된 각 영상은 256×256픽셀의 해상도가 저하된 영상 16개로 변환된다.

마지막으로 세 번째 실험에서는 원본 위성영상을 4×4 분할한 이미지를 ESRGAN 라이브러리를 통해 4배 업스케일링하여 손실될 가능성이 있는 픽셀을 보강했다. 결과적으로는 4×4 분할과 업스케일링을 통해 1024×1024픽셀의 크기를 가지는 16개 영상을 활용해 객체탐지율과 오탐을 확인하였다. 모든 실험은 구글에서 제공하는 Colab pro 환경(python 3.10, T4 GPU, 51GB RAM)에서 진행되었다.

Ⅳ. 실험 결과 및 분석

4.1 실험 결과

첫 번째 사전학습 모델인 ‘Detect Planes’를 이용하여 원본 위성영상에 대한 객체탐지를 시도한 결과 총 259개의 객체를 탐지하였다. 그 중 항공기는 243개를 식별해냈으며, 그림 3에서 보는 바와 같이 오인 식별된 객체가 16개 확인되었다.

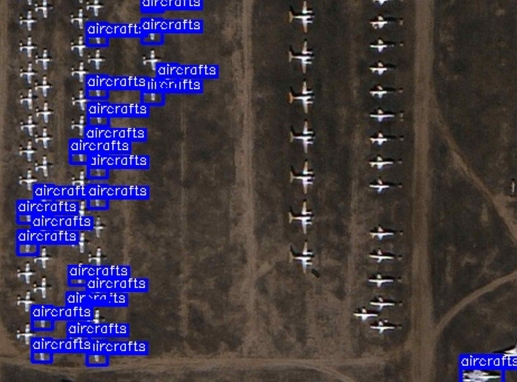

다음으로 원본 위성영상을 4×4 분할로 16등분한 영상에서는 원본 위성영상 대비 2배 이상 증가한 총 522개의 객체가 탐지되었다. 식별된 객체 중 항공기는 471개였고, 오인 식별된 객체는 51개였다.

그림 4, 5는 원본 위성영상에서는 탐지되지 않았던 소형 항공기 객체들이 분할을 통해 영상에서 차지하는 비중이 증가하면서 다수 탐지됨을 보여주고 있다. 이러한 결과는 객체가 영상 내에서 차지하는 비중이 탐지 성능에 크게 영향을 미침을 의미한다.

마지막으로 4×4 분할 영상을 4배 업스케일링한 영상에서는 총 619개의 객체를 식별하였다. 그 중 539개의 객체는 정상적으로 탐지된 항공기였으며, 오인 식별된 객체는 80개로 증가하였다.

세부적인 실험 결과는 표 1에서 확인할 수 있다. 탐지율은 AI-Hub에서 획득한 50장의 위성영상 내에 포함되어 있는 총 861개의 항공기 객체에 대해 정상적으로 탐지된 항공기 수만을 고려하여 산출한 수치이다.

두 번째 사전학습 모델인 ‘Aero Sat’은 원본 위성영상에서 ‘Detect Plane’ 모델보다 더 많은 424개의 객체를 탐지해냈다. 424개의 객체 중 항공기는 390개였으며, 34개는 항공기와 유사하여 오인 식별된 객체로 확인되었다.

4×4 분할로 16등분한 영상에서는 총 491개의 객체를 탐지하였다. 그 중 항공기는 453개이고 오인 식별된 객체는 38개로 나타나 ‘Detect Plane’ 모델 대비 분할된 영상에서의 탐지 성능 증가폭은 크지 않았으며, 오인 식별된 객체 수는 감소하였다. 마지막으로 분할 및 업스케일링한 영상에서는 총 850개 객체가 탐지되었다. 그 중 항공기는 ‘Detect Plane’ 모델 대비 크게 향상된 탐지율을 보이며 706개를 탐지하였다. 그러나 오인 식별된 객체 역시 144개로 크게 증가하는 현상이 함께 발생했다. 세부적인 실험 결과는 표 2에서 보는 바와 같다.

4.2 결과 분석

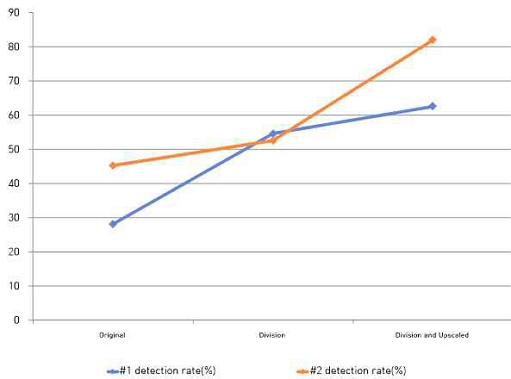

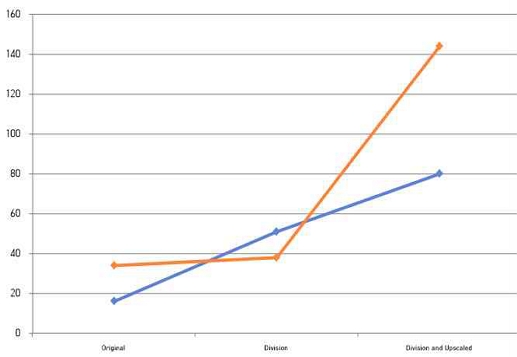

위성영상을 4×4로 분할하여 2종의 YOLOv8 기반 사전학습 모델로 항공기 탐지를 시도한 결과 그림 6에서 보는 것처럼 객체탐지율이 원본 위성영상을 그대로 활용했을 때보다 평균 1.45배 증가하였다. 분할된 각 이미지를 4배 업스케일링까지 적용한 경우에는 원본 위성영상을 그대로 활용한 경우보다 평균 1.96배, 4×4 분할만 적용한 경우보다는 평균 1.34배 정도 객체탐지율이 향상되었다.

그러나 그림 7에서 보는 바와 같이 두 방법 모두에서 오탐이 함께 증가하는 현상이 발생했다. 이와 같이 오탐이 증가하는 현상에 대해 현재 상태에서 정확한 원인을 규명하기는 쉽지 않지만, 일정 부분 유추가 가능한 사항은 있다.

원본 위성영상은 1024×1024픽셀의 크기를 가지는영상 내에 항공기 객체 외에 다수의 항공기와 유사한 것으로 오인할 수 있는 객체들이 함께 존재한다. 그리고 항공기 이외의 객체들은 대부분 그 크기가 객체로 탐지되기 어려울만큼 작아 오탐 역시 크게 발생하지 않았던 것으로 판단할 수 있다.

그와는 반대로 4×4로 분할한 경우에는 개별 객체들이 영상 내에서 차지하는 비중이 증가하여 항공기와 유사한 객체를 항공기로 오인하여 탐지하는 경우가 증가한 것으로 보인다. 그리고, 업스케일링까지 적용한 경우 객체의 크기가 더욱 커져서 원본 위성영상에서는 객체로 탐지되지 않았던 객체들까지도 유효한 객체로서 탐지되는 확률이 증가하면서 오탐이 함께 증가한 것으로 해석할 수 있다.

V. 결론 및 향후 과제

위성영상의 활용 분야가 확대됨은 물론 우주공간으로 전장을 확장하려는 시도가 활발해짐에 따라 위성영상 분석 기술에 대한 관심도 높아지고 있다. 그러나 공간 해상도가 낮은 위성영상 내에서 특정 객체를 정확하게 식별하기는 쉽지 않으며, 최근에는 AI를 적용하여 그러한 문제를 해결하려는 시도가 꾸준하게 진행되고 있다.

이에 본 논문에서는 AI를 기반으로 위성영상 내에서 객체를 탐지하는 모델의 탐지 정확도를 향상시키기 위해 이미지 분할 및 업스케일링 기법을 적용하는 방안을 제안하였다. 먼저 객체가 위성영상 내에서 차지하는 비중을 증가시키기 위해 영상을 작은 크기의 영상으로 분할한 후, ESRGAN을 활용하여 분할된 영상을 업스케일링하였다.

제안된 접근방안에 대한 성능평가는 YOLOv8을 기반으로 항공기 객체에 대한 사전학습을 실시한 ‘Detect Planes’ 모델과 ‘Aero Sat’ 모델을 활용했고, AI 허브를 통해 수집한 항공기 사진을 기반으로 3종의 데이터세트를 구축하여 각각에 대한 객체탐지율 및 오탐을 측정하였다.

실험 결과 원본 위성영상을 그대로 사용한 경우보다 4×4 분할된 영상에서 더 많은 항공기 객체가 탐지되었으며, 4×4 분할에 업스케일링까지 적용한 영상에서 가장 높은 객체탐지율이 나타남을 확인하였다. 그러나 객체탐지율이 증가됨과 동시에 오탐도 증가하는 현상이 발생하였다. 그리고 영상 분할 시 항공기가 온전하게 분할된 영상에 포함되지 못하고 잘릴 경우 대부분 항공기로 탐지되지 않는 문제도 식별되었다.

한편, 성능평가 과정에서는 원본 위성영상은 2×2 분할부터 8×8 분할까지 다양한 크기로 분할하여 실험을 진행하였다. 그 결과 2×2 및 3×3 분할 영상에서는 객체가 차지하는 비중이 충분하게 증가하지 않아 소형 항공기 객체들이 탐지되지 않는 경우가 다수 발생하였다. 반면 5×5 분할 이상의 영상에서는 항공기가 온전한 형태를 유지하지 못하고 분해됨으로 인해 정상적으로 탐지되지 못하는 경우가 상당수 확인되었다. 이러한 결과를 바탕으로 향후 연구에서는 탐지 대상이 되는 위성영상의 크기에 따른 최적 분할 비율을 분석하고, 오탐을 감소시킬 수 있는 보다 효율적인 영상 분할 방법을 모색하기 위해 연구를 확장해 나갈 예정이다.

또한, 현재 연구는 제안하는 접근방법의 적용 가능성을 검증하는 것이 주목적이었기 때문에 자체적으로 모델을 구축하지 않고 항공기에 대한 사전학습이 완료된 모델 2종을 그대로 활용하였다.

향후에는 YOLOv8 또는 2024년 3월에 발표된 YOLOv9를 기반으로 다양한 방식으로 증강된 데이터세트를 적용하여 학습모델을 구축하고 보다 정확한 성능평가를 수행할 예정이다.

References

- The '425 Project' took the first step, 5th term operation goal by 2025, Dec. 2023. https://www.yna.co.kr/view/AKR20231201087400504?input=1195m, [accessed: Feb. 08, 2024]

-

S. B. Yang and S. J. Lee, "Improved CNN Algorithm for Object Detection in Large Images", Journal of The Korea Society of Computer and Information, Vol. 25, No. 1, pp. 45-53, Jan. 2020.

[https://doi.org/10.9708/jksci.2020.25.01.045]

-

X. Wagn, K. Yu, S. Wu, J. Gu, Y. Liu, C. Dong, C. C. Loy, Y. Qiao, and X. Tang, "ESRGAN: Enhanced Super-Resolution Generative Adversarial Networks", Proceedings of the European Conference on Computer Vision (ECCV) Workshops, Mehrdlunich, Germany, Sep. 2018.

[https://doi.org/10.48550/arXiv.1809.00219]

- Ultralytics YOLOv8 Docs, https://docs.ultralytics.com, [accessed: Dec. 07, 2023]

-

J. Redmon, S. Divvala, R. Girshick, and A. Farhadi, "You Only Look Once: Unified, Real-Time Object Detection", Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR), LAS VEGAS, USA, pp. 779-788, May 2016.

[https://doi.org/10.48550/arXiv.1506.02640]

- D. U. Kim, H. R. Ro, W. J. Kim, S. K. Kim, and H. Y. Kwak, "Optimal Model Selection for a Crosswalk Assistance App for theVisually Impaired through Object Detection Model Performance Comparison", Proceedings of KIIT Conference, Jeju, Korea, pp. 666-668, Nov. 2023.

-

J. Lee, S. Cho, and Y. Jeong, "UAM Autonomous Guidance Control Command Generation Through Deep-learning-based Aircraft Marshalling Recognition", Journal of Institute of Control, Robotics and Systems, Vol. 30, No. 2, pp. 86-92, Feb. 2024.

[https://doi.org/10.5302/J.ICROS.2024.23.0193]

-

F. M. Talaat and H. ZainEldin, "An improved fire detection approach based on YOLO-v8 for smart cities", Neural Computing and Applications, Vol. 35, pp. 20939-20954, Jul. 2023.

[https://doi.org/10.1007/s00521-023-08809-1]

-

D. J. Kim, Y. J. Choi, K. M. Park, J. H. Park, J.-M. Lee, K. Hwang, and I. H. Jung, "Detection of Smoking Behavior in Images Using Deep Learning Technology", The Journal of The Institute of Internet, Broadcasting and Communication, Vol. 23, No. 4, pp. 107-113, Aug. 2023.

[https://doi.org/10.7236/JIIBC.2023.23.4.107]

- Y. Jang, D. Park, S.-C. Jeong, and M. Kim, "Implementation of Android Application for Crosswalk Assistance for the Visually Impaired based on YOLOv8", Proceedings of KIIT Conference, Jeju, Korea, pp. 570-573, Jun. 2023.

-

S. Jang and T.-S. Shon, "Quality Improvement and Verification Techniques of Low-Definition Digital Evidence Using Artificial Intelligence Algorithm", Journal of Digital Forensics, Vol. 17, No. 2, pp. 146-155, Jun. 2023.

[https://doi.org/10.22798/kdfs.2023.17.2.146]

-

H. Ha and B.-Y. Hwang, "Enhancement Method of CCTV Video Quality Based on SRGAN", Journal of Korea Multimedia Society, Vol. 21, No. 9, pp. 1027-1034, Sep. 2018.

[https://doi.org/10.9717/kmms.2018.21.9.1027]

- S. Lee, "Application and Performance Evaluation of ESRGAN on Satellite Imagery Super-Resolution", KSAS 2023 Spring Conference, pp. 1365-1366, Apr. 2023.

-

S. Yoo, P. Kim, and J. Youn, "Improving the Spatial Resolution of Drone Images Using a Deep Learning-Based Super-Resolution", Journal of the Korean Society of Surveying, Geodesy, Photogrammetry and Cartography, Vol. 41, No. 6, pp. 651-660, Dec. 2023.

[https://doi.org/10.7848/ksgpc.2023.41.6.651]

-

C. Lee, S. B. Youn, C. W. Cho, H. Hwang, K. Lee, and E. C. Lee, "License Plate Image Enhancement Based on Enhanced Super-resolution Generative Adversarial Networks", Journal of Next-generation Convergence Technology Association, Vol. 6, No. 1, pp. 5-11, Jan. 2022.

[https://doi.org/10.33097/JNCTA.2022.06.01.5]

-

J.-H. Mun, K.-Y. Lee, D.-J. Chae, S.-T. Lim, and H.-J. Song, "A Study on Status Information Extraction of Electrical Installations Tthrough Image Super-resolution based on ESRGAN", The Transactions of the Korean Institute of Electrical Engineers, Vol. 71, No. 10, pp. 1497-1504, Oct. 2022.

[https://doi.org/10.5370/KIEE.2022.71.10.1497]

- Explore the Roboflow Universe, https://universe.roboflow.com, [accessed: Feb. 05, 2024]

2015년 : 해군사관학교 전기전자공학과(공학사)

2023년 ~ 현재 : 국방대학교 컴퓨터공학과 석사과정

관심분야 : 머신러닝, 인공지능, 객체탐지

1992년 : 육군사관학교 컴퓨터공학과(공학사)

1996년 : 연세대학교 컴퓨터공학과(공학석사)

2006년 : 한국과학기술원(KAIST) 컴퓨터공학과(공학박사)

2006년 ~ 현재 : 국방대학교 컴퓨터공학과 교수

관심분야 : 국가 사이버 보안 정책, 침입 탐지 시스템, 모바일 네트워크 보안, 머신러닝, 암호화 이론 및 응용