임베디드 시스템 기반 사과 품질 예측을 위한 최적의 딥러닝 모델 탐색 연구

; Su-Chang Lee**

; Su-Chang Lee** ; Nguyen Bui Ngoc Han***

; Nguyen Bui Ngoc Han*** ; Jin Lee***

; Jin Lee*** ; Gyeong-Ju Kwon****

; Gyeong-Ju Kwon**** ; Jin-Young Kim*****

; Jin-Young Kim*****

초록

본 연구에서는 임베디드 시스템 기반 사과 품질 예측을 위한 최적의 딥러닝 모델 탐색에 관한 연구를 수행하였다. 탐색을 위해 경량 모델 6종을 학습하고 정확도와 추론 속도에 대한 가중평가 하였다. 실제 수집한 사과 품질 이미지 데이터셋을 활용하여 전이학습을 진행하였으며, 그 결과 RegNet-y 모델이 가장 우수한 성능을 보였다. 이를 임베디드 시스템에의 배포하기 위해 최적화 실험을 거쳐, 최종적으로 테스트 데이터셋 2,000장에 대해서 정확도 95.36%와 이미지 당 0.0566초의 추론속도를 달성하였다. 본 연구의 결과는 임베디드 시스템에서 효율적인 딥러닝 모델 활용에 대한 경험적 데이터를 제공하여 실시간 애플리케이션 가능성을 확장한다.

Abstract

This study aimed to identify the optimal deep learning model for apple quality prediction on embedded systems. Six lightweight models were trained and evaluated using a weighted assessment of accuracy and inference speed. Transfer learning was conducted using a collected dataset of apple quality images, and the results showed that the RegNet-y model exhibited the best performance. To optimize the model for deployment on an embedded system, a series of experiments were conducted. The final evaluation on a test dataset of 2,000 images achieved an accuracy of 95.36% and an inference speed of 0.0566 seconds per image. The findings provide empirical data on efficient deep learning model utilization on embedded systems, expanding real-time application possibilities.

Keywords:

deep learning, apple quality prediction, embedded systems, lightweight model, agricultural systemsⅠ. 서 론

현대 식품 산업에서, 제품의 품질 예측은 안전성과 소비자 신뢰도에 직결되는 중대한 과제로 자리 잡고 있다. 특히 농산물과 같은 식품의 경우, 외관을 기반으로 한 품질 분류는 생산과 유통 과정의 핵심적인 단계를 이룬다. 이런 맥락에서 사과의 품질 예측, 즉 정상과 불량을 구분하는 작업은 과거에는 많은 인력과 시간을 소모하는 작업이었다. 그러나 최근 인공지능 기술, 특히 딥러닝의 발전과 함께 ICT가 접목하여 이러한 작업의 자동화가 가능해지고 있다[1].

딥러닝 기술 중 전이학습(Transfer learning)[2]은 소량의 데이터로도 높은 정확도의 품질 예측이 가능하게 하는 주목할 만한 기술이다. 전이학습은 이미 충분한 데이터로 학습된 모델을 새로운 목적에 적용하여 추가 학습을 진행함으로써 학습 과정을 가속화하고 데이터 부족 문제를 해결할 수 있다.

본 연구에서는 임베디드 시스템인 NVIDIA Jetson Nano[3]를 사용해 사과의 품질을 예측하는 모델을 선정하기 위하여 전이학습을 통한 최적의 딥러닝 모델을 탐색한다. Jetson Nano는 고성능 컴퓨팅과 AI 기능을 제공하는 소형 컴퓨팅 기기로, 제한된 자원 환경에서도 고도의 계산 처리를 수행할 수 있는 장점을 가지고 있다. 이를 통해 농업 생산 현장에서 실시간으로 사과의 품질을 예측하는 시스템의 구현이 가능해질 것이다.

기존의 사과 생산에 관한 연구로 가시광/근적외선 스펙트럼을 활용한 사과 과실 산도 예측 모델[4], 품질 등급을 위한 색상 채널 탐색 연구[5]가 있다. 본 연구는 기존과 다르게 품질 등급 예측을 위한 딥러닝 기반 모델 학습이며, 이것은 자체적으로 수집한 부사 이미지 데이터셋을 활용하는 차이점이 있다. 이것은 AI Hub의 공개 데이터셋인 농산물 품질(QC) 이미지 데이터[6]와 다르게 정상의 사과 이미지와 다양한 불량 유형을 포괄적으로 촬영하였다. 이는 모델이 다양한 현실 조건에서 발생할 수 있는 사과의 불량 상태를 정확하게 학습하고 예측할 수 있도록 한다.

본 연구를 통해, 임베디드 시스템을 활용한 실시간 사과 품질 예측 시스템의 구현 가능성을 탐구하고, 농산물 품질 관리 및 선별 공정의 효율성과 정확성을 높이는 방안을 제시하고자 한다. 따라서 본 논문의 주요 목표는 다음과 같다:

(1) 임베디드 시스템에서 운용 가능한 딥러닝 전이학습 모델 분석

(2) 사과 품질 이미지 데이터셋을 활용한 전이학습 및 최적 모델 탐색

(3) 임베디드 환경에서의 모델 성능 평가

본 연구를 통해, 농산물 품질 관리 분야에서 인공지능 기술의 적용성을 검증하고, 농업 생산성 향상에 기여한다. 기존의 수동적이고 시간 소모적인 농산물 품질 검사 방법에 혁신을 제안하며, 실시간으로 높은 정확도의 불량 판정을 가능하게 하는 임베디드 시스템의 구축을 목표로 한다. 본 연구의 중요성은 단순히 기술적 성과를 넘어서, 식품 안전과 공급망 관리에 있어 중대한 영향을 미칠 수 있다는 점에 있다. 실시간으로 품질을 관리함으로써, 농산물의 손실을 최소화하고, 최종 소비자에게 보다 높은 품질의 제품을 제공할 수 있게 된다. 또한, 이 연구는 임베디드 시스템을 활용한 다양한 분야에서의 딥러닝 응용 가능성을 탐색하는 기초가 될 수 있다.

Ⅱ. 본 론

본론에서는 딥러닝의 컨볼루션 뉴럴 네트워크 기반의 전이학습 방법과 경량화 모델의 선정 및 적용 과정을 상세히 설명한다. 이는 임베디드 시스템인 NVIDIA Jetson Nano에서의 효율적인 불량 사과 예측을 위한 기술적 기반을 제공한다.

2.1 컨볼루션 뉴럴 네트워크 기반 전이학습

전이 학습은 이미 대규모 데이터셋을 사용해 사전 학습된 모델을 새롭고 관련된 문제에 적용하는 학습 방법이다. 이 방식은 새 작업의 학습 시간을 크게 단축하면서도, 상대적으로 적은 양의 데이터로도 높은 성능을 달성할 수 있다는 장점을 가지고 있다. 전이 학습 과정은 크게 두 단계로 나뉜다: 사전 학습된 모델의 선택과 이 모델을 타겟 작업에 맞게 미세 조정하는 것이다.

사전 학습된 모델을 선택할 때는 일반적으로 대규모 이미지 데이터베이스인 ImageNet[7]에서 사전 학습된 컨볼루션 뉴럴 네트워크 모델을 사용한다. 이러한 모델들은 다양한 이미지 특성을 인식할 수 있는 능력을 이미 갖추고 있어, 새로운 특정 작업에 적용될 때 기본적인 특성 추출기로 활용한다. 사전 학습된 모델을 선택하는 것은 전이 학습 과정에서 매우 중요한 단계이며, 모델의 성공적인 임베디드 시스템의 배포 및 적용 가능성을 높인다.

사전 학습된 모델을 선정한 후, 이를 특정 목적 작업에 맞게 조정하는 단계가 이어진다. 본 연구에서는 정상 사과와 불량 사과를 구분하는 이미지 분류가 주요 목적 작업이다. 미세 조정 과정에서는 본 연구를 위해 직접 수집한 사과 이미지 데이터셋을 사용하여 모델의 일부를 재학습한다. 이 과정을 통해 모델이 새로운 작업의 특성에 더욱 잘 적응하고, 높은 성능을 발휘할 수 있도록 한다.

본 연구에서는 특히 모델의 마지막 층에 대한 미세 조정을 진행한다. 이 방식은 모델이 사전 학습 과정에서 습득한 일반적인 지식을 유지하면서도, 새로운 작업에 필요한 특화된 지식을 학습하도록 한다. 이를 통해, 사과 이미지 데이터셋에 대한 모델의 예측 능력을 개선하는 효율적인 학습 과정을 수행할 수 있다.

2.2 경량화 모델 선정

임베디드 시스템에서의 AI 모델 운용을 위해서는 모델의 경량화가 필수적이다. 이는 제한된 연산 자원과 메모리를 가진 임베디드 시스템에서 높은 성능을 발휘할 수 있도록 최적화된 모델을 의미한다.

본 연구에서는 이러한 조건을 충족시키기 위해 여러 경량화 모델을 검토하였으며, 특히 컴퓨팅 자원이 매우 제한적인 환경에서도 효율적으로 작동할 수 있는 모델 구조와 알고리즘에 초점을 맞추었다.

(1) MobileNetV3: MobileNetV3[8]는 컴퓨터 비전 작업을 위해 특별히 설계된 경량화 아키텍처이다. 이 모델은 최적화된 레이어와 작은 모델 사이즈를 통해 높은 정확도와 효율성을 제공하며, 모바일 및 임베디드 시스템에서 실시간 작업에 이상적이다.

(2) EfficientNetB0: EfficientNet[9] 시리즈의 B0 모델은 균형 잡힌 스케일링 방법을 사용하여 네트워크의 깊이, 너비, 그리고 해상도를 동시에 조정한다. 이 접근 방식은 작은 모델 사이즈와 빠른 추론 속도를 유지하면서도, 우수한 성능을 달성한다.

(3) FBNet: Facebook에서 개발한 FBNet[10]은 하드웨어 효율성을 최대화하기 위해 네트워크 아키텍처 탐색(NAS[11])를 사용한다. FBNet은 다양한 임베디드 시스템에서 맞춤형으로 최적화할 수 있으며, 특히 모바일 기기에 적합한 고성능을 제공한다.

(4) RexNet: ReXNet[12]은 효율적인 채널 확장과 잔차 연결을 통해 정확도를 개선한 모델이다. 비교적 적은 연산량으로 높은 성능을 제공하며, 이는 임베디드 시스템에서의 사용에 적합하다.

(5) RegNet: RegNet[13] 시리즈는 유연성과 확장성을 제공하는 동시에, 다양한 임베디드 환경에서 효율적으로 작동할 수 있도록 설계되었다. RegNet은 두 가지 주요 계열인 RegNetX와 RegNetY를 포함하는데, RegNetX는 성능 최적화에 중점을 두고 있으며, RegNetY는 효율성과 성능의 균형을 추구한다.

Ⅲ. 최적의 딥러닝 모델 탐색 실험 및 결과

3.1 실험 데이터셋

본 연구에서는 사과의 품질 분류를 위한 딥러닝 모델 개발을 목적으로 하며, 이를 위해 총 13,821장의 사과 이미지를 실험 데이터셋으로 사용하였다. 이 데이터셋은 정상 사과 이미지 6,225장과 불량 사과 이미지 7,596장으로 구성되어 있다.

각 이미지는 다양한 배경과 조명 조건에서 촬영되었으며, 사과의 크기, 색상, 그리고 표면의 결도 다양하다.

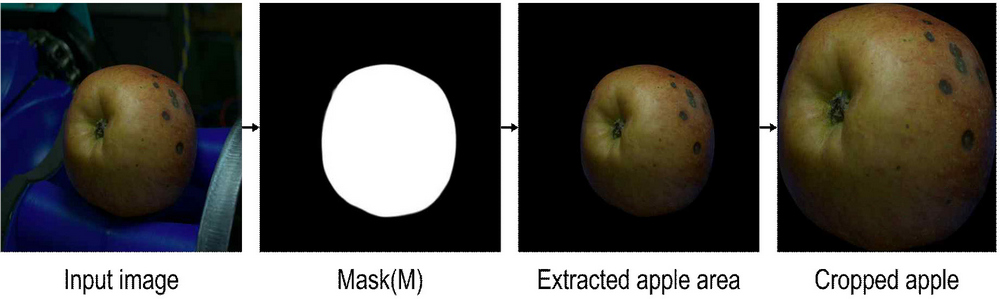

실험의 정확도를 높이기 위해, 사과의 특성만을 집중적으로 학습할 수 있도록 이미지에서 사과 영역만을 추출하는 전처리 과정을 수행하였다. 이 과정은 다음 단계로 구성된다:

(1) U2-Net 모델을 이용한 관심 영역 추출: 사전학습된 분할 모델인 U2-Net[14]을 사용하여 각 이미지에 대한 마스크를 생성하였다. 이 마스크는 이미지 내의 사과 영역을 정확하게 식별하는 데 사용되었다.

(2) 마스크를 통한 영역 추출: U2-Net 모델의 출력값인 마스크를 사용하여 원본 이미지에서 사과 영역을 정확히 추출하였다. 이를 통해 배경과 불필요한 객체들을 제거하고, 사과의 특징을 더욱 명확히 학습할 수 있도록 하였다.

(3) 사과 영역 자르기: 추출된 사과 영역을 기반으로 최종적으로 사과만을 포함하는 영역을 잘라내었으며, 모델 학습에 사용될 이미지 데이터셋을 준비하였다. 이 과정을 통해 데이터의 일관성을 확보하였다.

3.2 실험 설정 및 평가 방법

본 실험을 위해 Ubuntu 20.04.6 LTS 운영 체제를 기반으로 한 시스템에서 수행되었으며, 실험에 사용된 CPU는 Intel Xeon Gold 5120(8코어) 및 NVIDIA의 Tesla V100 SXM2 32GB GPU가 사용되었다. 실험을 위한 구현은 PyTorch 프레임워크를 활용하였다.

다양한 경량화 모델의 성능을 평가하기 위해 공통 실험 설정은 다음과 같다: 초기 학습률은 8e-5로 설정하였으며, 학습은 총 100 에포크 동안 수행되었다. 가중치 감소는 0.05로 설정되었다. 또한, 실험의 재현성을 위해 난수 생성 시드는 1120으로 고정하였다.

실험은 원본 이미지의 정보를 보존하기 위하여 입력 이미지 크기를 키운 512x512과 배치 크기는 128로 지정한 실험1과 작은 이미지 크기로 줄인 368x368 사이즈와 배치 크기는 32로 지정한 실험2로 구분한다.

실험 1과 실험 2의 평가를 위해 정확도(Accuracy)와 추론 속도(Inference speed)를 기반으로 가중평가를 수행한다.

| (1) |

| (2) |

식 (1)의 참양성(TP, True Positives)는 모델이 올바르게 양성으로 예측한 데이터의 수, 참음성(TN, True Negatives)은 모델이 올바르게 음성으로 예측한 데이터의 수를 의미한다. 거짓음성(FN, False Negatives)은 모델이 잘못하여 음성으로 예측한 양성 데이터의 수, 거짓양성(FP, False Positives)은 모델이 잘못하여 양성으로 예측한 음성 데이터의 수를 의미한다. 이에 따른 정확도는 모델의 예측이 실제 정답과 얼마나 잘 일치하는지를 나타내는 지표로, 전체 데이터 중 올바르게 예측된 데이터의 비율이다.

추론 속도는 모델이 입력 이미지 한 장을 처리하고 결과를 출력하는 데 걸린 시간으로 측정된다. 단위는 초(s)이며, 이는 실제 모델의 반응 속도를 평가하는 데 중요한 지표이다.

식 (2)은 가중 평가를 위한 평가 항목으로 정확도와 추론 속도를 8:2 기준으로 설정하였다. 추론 속도는 빠를수록 좋으므로, 이를 역수로 변환한 후 20%의 가중치를 적용하였다. 이는 정확도, 추론 속도는 상충 관계(Trade-off)에서 정확도를 더욱 높게 반영하기 위하여 정확도 80%, 추론 속도 20%의 비율로 점수를 계산하였다.

3.3 최적의 모델 탐색 실험 결과

실험 1과 실험 2에서의 다양한 모델 성능 평가를 통해 사과 품질 예측을 위한 최적의 모델을 탐색한다. 모델 간의 성능 비교는 정확도, 추론 속도에 기반한다.

표 2에 따르면, 실험 1은 512x512 이미지 사이즈를 학습한 결과로 학습한 모델의 평균 정확도 92.06%, 평균 추론 속도 0.0129초이다. 그중 RegNet-x 모델은 정확도 면에서 93.82%로 높은 성능을 보였으며, 추론 시간도 0.0124초로 가장 빠른 속도를 나타냈다. 이는 실시간 응답이 필수적인 임베디드 환경에서 RegNet-x 모델이 매우 효율적임을 시사한다.

표 3에 따르면, 실험 2는 368x368 이미지 사이즈를 학습한 결과로 학습한 모델의 평균 정확도 93.34%, 평균 추론 속도 0.015초이다. 그중 MobileNetV3이 94.26%의 가장 높은 정확도와 0.0123초의 빠른 추론 속도를 기록했다.

최종적으로 임베디드 시스템 배포를 위한 모델을 선정하기 위해서 실험 1, 실험 2에서 학습한 각 모델을 가중 평가점수 계산 방법에 따라서 점수를 재계산하여 평가한다. 그리고 상위 모델 3건을 선택하여 재학습 후 최종평가한다.

표 4는 가중평가 실험 결과로, 가중 평가 점수가 가장 높은 상위 모델 3개는 RegNet-x, RegNet-y, MobileNetV3이다. 가중평가에 따라서 선정한 3개의 모델을 실험 1의 조건과 동일하게 재학습하여 최종적인 최적의 모델을 선정한다.

표 5는 최종적으로 선정한 3개의 모델의 재학습 평가 결과로 테스트 정확도, 추론 속도와 이를 기반으로 계산한 가중평가점수가 있다. 최종적인 평가로 가중평가점수에 따라 RegNet-y가 가장 높은 평가 점수를 달성한다.

3.4 이미지 사이즈 및 데이터 증강에 따른 모델 최적화 실험

실험 1, 2를 통해 이미지 사이즈에 따라서 성능이 다르기 때문에 RegNet-y의 다양한 이미지 사이즈에 따라서 평가가 필요하다. 학습을 위해 이미지 사이즈 224x224, 368x368, 512x512를 각각 사용한다.

표 6에 따르면 이미지 368x368 사이즈가 테스트 정확도가 94.81%로 가장 높으며 512x512 사이즈로 학습한 실험 결과보다 0.1% 높다. 이미지 사이즈가 증가함에 따라 일반적으로 모델의 학습 및 테스트 정확도가 향상되는 경향이 관찰된다. 이는 더 큰 이미지 사이즈가 모델에 더 많은 정보를 제공하여 성능을 향상시킬 수 있음을 시사한다. 다만 임베디드 시스템 환경의 제한적인 연산 처리를 고려하였을 때 512x512는 이미지가 크기 때문에 368x368사이즈를 사용한다. 이를 선택하여 데이터 증강 실험에 사용한다. 데이터 증강 기술이 모델의 일반화 능력을 향상시키는데 중요한 역할을 할 수 있음을 보여준다[16].

실험을 위해 Mixup[17], Cutmix[18]를 각각 50%씩 섞어서 사용하였으며, 학습 효과를 구분하기 위하여 학습 속도를 4e-05, 8e-05로 나누어 평가한다.

실험 결과는 표 7과 같으며, 4e-05의 학습 속도를 설정 할 때 학습 정확도는 0.76% 떨어지지만, 테스트 정확도가 0.75% 높다.

다양한 실험을 통해 RegNet-y의 최적의 성능 도출을 시도하였으며 최종적으로 95.36%의 정확도를 달성한다.

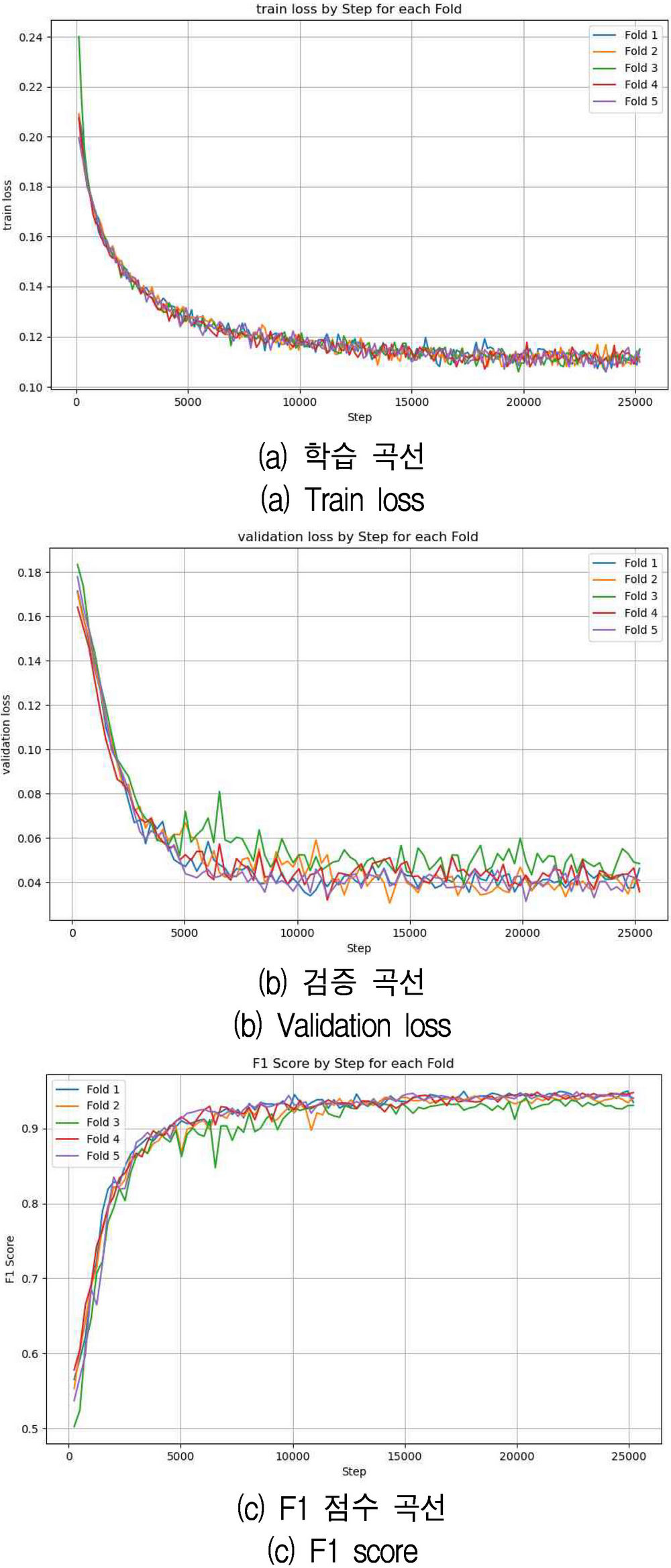

3.5 모델 교차 검증 실험

RegNet-y의 최종적인 성능 검증을 위하여 교차 검증[19]을 수행한다. 교차검증을 수행하는 주요 이유는 모델의 실제 성능 추정 모델을 학습 데이터로만 평가하면 과적합이 발생할 수 있어 실제 성능을 정확히 추정하기 어렵다. 교차검증을 통해 여러 독립적인 데이터 세트에서 모델을 평가함으로써 더욱 신뢰성 있는 성능 추정이 가능하다.

과적합 방지 교차검증 과정에서 모델은 여러 번 학습과 평가를 거치게 되므로, 특정 데이터에 지나치게 최적화되는 과적합 현상을 방지할 수 있다.

이에 따라 5-Fold의 교차 검증을 수행하였으며 실험을 위한 설정은 다음과 같다. 이미지 사이즈 368x368, 배치 사이즈 64, 에포크 200, 학습률 4e-5, 가중치 감소 0.05로 설정한다. 또한 교차 검증 시 데이터 증강 기법인 Mixup, Cutmix를 각각 50%씩 사용한다.

실험의 평가를 위하여 F1 점수는 정밀도와 재현율의 조화 평균이며, 테스트의 정확도를 측정하는 지표이다.

| (3) |

각 폴드 별 F1은 97.26%, 97.31%, 97.21%, 97.46%, 97.46% 이다. 그림 2의 모든 폴드가 비슷한 경향을 보이는 것으로 보아 훈련 데이터가 다양한 하위 집합에서 일관되게 모델에 영향을 주고 있는 것으로 관찰된다. 그리고 검증 손실 그래프는 훈련 손실 그래프와 유사하지만, 훈련 중에 보지 못한 데이터 세트에서의 모델 성능을 나타낸다. 손실이 처음에 급격하게 감소한 후 특정 값 주위에서 진동을 시작하는데, 이러한 현상은 모델이 훈련 데이터에서의 패턴을 학습하고 새로운 데이터에 일반화되고 있음을 나타낼 수 있다.

평균 F1은 97.34%로 주어진 사과 품질 예측 데이터셋에 매우 안정적으로 학습되었고, 좋은 일반화 능력을 가지고 있음을 검증하였다

Ⅳ. 임베디드 시스템 기반 딥러닝 모델 평가

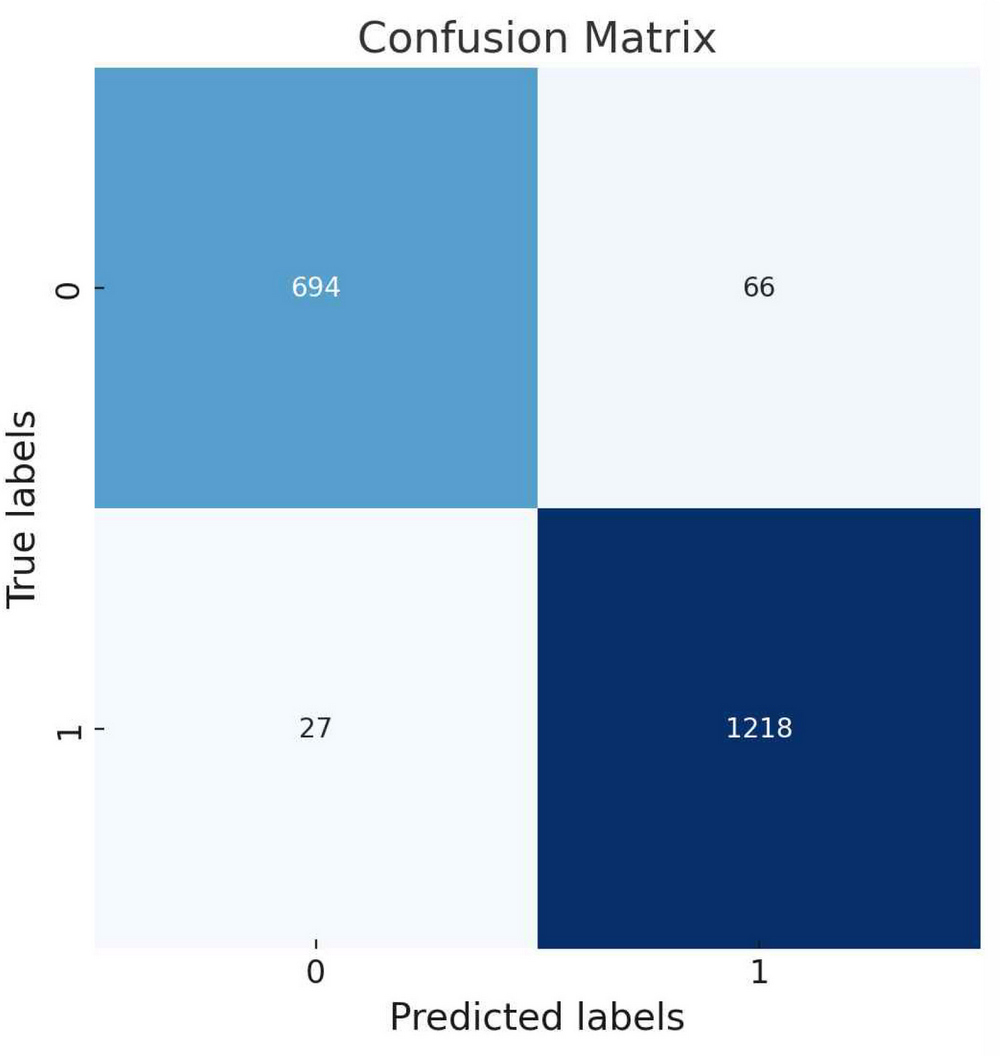

앞서 검증한 RegNet-y모델을 ONNX[20] 형식으로 변환하여 임베디드 보드에 배포하고, 테스트 데이터셋을 사용하여 추론 정확도 및 속도를 평가한다. 본 평가의 목적은 임베디드 시스템에 배포한 RegNey-y 모델의 효율성과 성능을 확인하는 것이다. 테스트 데이터셋 구성은 총 2,000장의 이미지로, 불량 이미지 760장과 양품 이미지 1,240장을 포함한다. 본 데이터셋은 학습에 포함되지 않은 데이터로 구성한다.

이 데이터셋을 사용하여 임베디드 보드에서 모델의 추론을 5회 수행하고 평균 정확도 및 추론 속도를 평가하는데, 이는 ONNX 모델의 이미지 입력 후 출력값 도출까지의 모델의 추론 속도만을 평가한다. 표8의 5회 실험 결과 평균 정확도는 95.36%에 달했으며, 평균 추론 속도는 이미지 당 0.0566초로 측정되었다.

세부적으로, 그림 3의 혼동 행렬에 따르면 배포한 모델은 실제 불량 사과의 694개 모두 정확히 불량으로 분류하는 데 성공하였으며(TN), 실제 정상 중 66개를 잘못하여 불량품으로 분류였다(FP). 반면, 실제 불량 사과 중 27개를 양품으로 잘못 분류하는 실수하였고(FN), 그리고 실제 양품을 1,218개 모두 정확히 양품으로 인식하였다(TP).

이러한 결과를 바탕으로 계산된 모델의 정확도는 전체 이미지 중 정확히 분류된 이미지의 비율로 95.36%를 달성하였다. 정밀도는 모델이 양품으로 예측한 이미지 중 실제로 양품인 것의 비율로, 이 실험에서는 94.86%였다. 재현율은 실제 양품 중 모델이 양품으로 정확히 분류한 비율로, 97.83%를 기록하였다. F1 점수는 정밀도와 재현율의 조화 평균으로, 본 연구에서는 약 96.32%의 높은 점수를 얻었다. 이는 모델이 양품을 예측하는 데 있어서 균형잡힌 성능을 보여주는 지표이다.

Ⅴ. 결 론

본 연구는 임베디드 시스템 기반 사과 품질 예측을 위한 최적의 딥러닝 모델 탐색 연구를 수행하였다. 이를 위해 6개의 경량화 딥러닝 모델을 사용하여 다양한 탐색을 수행하였으며 결론적으로 RegNet-y 모델이 최고의 정확도와 추론 속도를 보였다. 그리고 모델의 최적화 학습을 통해 최종적으로 ONNX모델을 Jetson Nano에 배포하여 테스트 하였다. 테스트 결과 혼동 행렬 기반 평가 지표들에서 배포 모델이 사과 품질 분류 작업에 있어서 균형잡힌 성능을 보여주었다. 또한 매우 빠른 속도로 추론을 수행하는데, 이는 실제 농업 현장에서의 응용 가능성을 시사한다.

결론적으로, 본 연구는 농업용 임베디드 시스템에서 딥러닝 모델의 효율적인 활용에 대해 실증적인 데이터를 제공하며, 향후 임베디드 딥러닝 모델의 최적화, 배포 전략 개발, 그리고 실제 산업 현장에서의 응용을 위한 연구의 기반이 될 것이다.

Acknowledgments

본 연구는 중소벤처기업부의 기술혁신개발사업의 지원에 의한 연구임 [S3294129]

References

- S. Lee, R. Kim, D. Jeong, and D. Park, "Research Trends in the Agricultural Sector Applying ICT Technology", The Journal of The Korean Institute of Communication and Information Sciences, Vol. 39, No. 10, pp. 3-12, Oct. 2022.

-

F. Zhuang, Z. Qi, K. Duan, D. Xi, Y. Zhu, H. Zhu, H. Xiong, and Q. He, "A Comprehensive Survey on Transfer Learning", Proceedings of the IEEE, Vol. 109, No. 1, pp. 43-76, Jan. 2020.

[https://doi.org/10.1109/JPROC.2020.3004555]

- Nvidia Jetson Nano Developer Kit, https://developer.nvidia.com/embedded/jetson-nano-developer-kit, [accessed: Apr. 16, 2024]

- J. Ryu, S. Park, S. Hong, S. Kim, E. Kim, C. Lee, S. Moon, and S. Noh, "Development of an Apple Fruit Acidity Prediction Model Based on Visible/Near-Infrared Semi-Transmittance Spectrum and Artificial Neural Network", Proceedings of the Korean Society for Agricultural Machinery, Vol. 28, No. 1, pp. 167-167, 2023.

-

E.-J. Lee and J.-I. Min, "Explore Influential Color Channels for Quality Classification of Apples Based on CNN", Journal of Digital Contents Society, Vol. 23, No. 8, pp. 1477-1484, Aug. 2022.

[https://doi.org/10.9728/dcs.2022.23.8.1477]

- AI Hub, Agricultural Products Quality (QC) Image, https://aihub.or.kr/aidata/30726, [accessed: Apr. 16, 2024]

-

J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and L. Fei-Fei, "ImageNet: A Large-Scale Hierarchical Image Database", 2009 IEEE Conference on Computer Vision and Pattern Recognition, Miami, FL, USA, pp. 248-255, Jun. 2009.

[https://doi.org/10.1109/CVPR.2009.5206848]

-

A. Howard, M. Sandler, G. Chu, L.-C. Chen, B. Chen, M. Tan, W. Wang, Y. Zhu, R. Pang, V. Vasudevan, Q. V. Le, and H. Adam, "Searching for MobileNetV3", Proceedings of the IEEE/CVF International Conference on Computer Vision, Seoul, Korea, pp. 1314-1324, Oct. 2019.

[https://doi.org/10.1109/ICCV.2019.00140]

-

M. Tan and Q. V. Le, "EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks", Proc. of the 36th International Conference on Machine Learning, pp. 6105-6114, May 2019.

[https://doi.org/10.48550/arXiv.1905.11946]

-

B. Wu, X. Dai, P. Zhang, Y. Wang, F. Sun, Y. Wu, Y. Tian, P. Vajda, Y. Jia, and K. Keutzer, "FBNet: Hardware-Aware Efficient ConvNet Design via Differentiable Neural Architecture Search", Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach, CA, USA, pp. 10734-10742, Jun. 2019.

[https://doi.org/10.1109/CVPR.2019.01099]

-

B. Zoph and Q. V. Le, "Neural Architecture Search with Reinforcement Learning", arXiv preprint arXiv:1611.01578, , Nov. 2016.

[https://doi.org/10.48550/arXiv.1611.01578]

-

S. Xie, R. Girshick, P. Dollár, Z. Tu, and K. He, "Aggregated Residual Transformations for Deep Neural Networks", Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, HI, USA, pp. 1492-1500, Jul. 2017.

[https://doi.org/10.1109/CVPR.2017.634]

-

I. Radosavovic, R. P. Kosaraju, R. Girshick, K. He, and P. Dollár, "Designing Network Design Spaces", Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Seattle, WA, USA, pp. 10428-10436, Jun. 2020.

[https://doi.org/10.1109/CVPR42600.2020.01044]

-

X. Qin, Z. Zhang, C. Huang, M. Dehghan, O. R. Zaiane, and M. Jagersand, "U2-Net: Going Deeper with Nested U-Structure for Salient Object Detection", Pattern Recognition, Vol. 106, pp. 107404, Oct. 2020.

[https://doi.org/10.1016/j.patcog.2020.107404]

- PyTorch, https://pytorch.org, [accessed: Apr. 16, 2024]

-

S. Connor and T. M. Khoshgoftaar, "A Survey on Image Data Augmentation for Deep Learning", Journal of Big Data, Vol. 6, No. 1, pp. 1-48, Dec. 2019.

[https://doi.org/10.1186/s40537-019-0197-0]

-

H. Zhang, M. Cisse, Y. N. Dauphin, and D. Lopez-Paz, "mixup: Beyond Empirical Risk Minimization", arXiv preprint arXiv:1710.09412, , Oct. 2017.

[https://doi.org/10.48550/arXiv.1710.09412]

-

S. Yun, D. Han, S. J. Oh, S. Chun, J. Choe, and Y. Yoo, "CutMix: Regularization Strategy to Train Strong Classifiers with Localizable Features", Proceedings of the IEEE/CVF International Conference on Computer Vision, Seoul, Korea, pp. 6023-6032, Oct. 2019.

[https://doi.org/10.1109/ICCV.2019.00612]

-

T. Fushiki, "Estimation of Prediction Error by Using K-fold Cross-Validation", Statistics and Computing, Vol. 21, pp. 137-146, Mar. 2011.

[https://doi.org/10.1007/s11222-009-9153-8]

- Open Neural Network Exchange, https://onnx.ai/, [accessed: Apr. 16, 2024]

2019년 8월 : 전남대학교 지구환경과학부(이학학사)

2019년 9월 ~ 현재 : 전남대학교 지능전자컴퓨터공학과 석박통합과정(수료)

관심분야 : 인공지능, 설명가능한 인공지능, 지식증류

2015년 : 경북대학교 (공학학사)

2019년 ~ 현재 : 전남대학교 전자컴퓨터공학과 석박사통합과정

2017년 ~ 현재 : 한전KDN 전력ICT기술원

관심분야 : 디지털신호처리, 영상처리, 머신러닝, 딥러닝

2022년 8월 : Saigon University (공학학사)

2022년 9월 ~ 현재 : 전남대학교 지능전자컴퓨터공학과 석사과정

관심분야 : 디지털신호처리, 영상처리, 머신러닝, 딥러닝

2015년 2월 : 전남대학교 (공학학사)

2023년 ~ 현재 : 전남대학교 지능전자컴퓨터공학과 석사과정

관심분야 : 디지털신호처리, 영상처리, 머신러닝, 딥러닝

2015년 2월 : 동신대학교 (공학학사)

2023년 ~ 현재 : 전남대학교 지능정보융합학과 석사과정

2001년 ~ 현재 : ㈜리눅스아이티 대표

관심분야 : 농업시스템, 영상처리, 머신러닝, 딥러닝

1986년 2월 : 서울대학교 전자공학과 (공학학사)

1988년 2월 : 서울대학교 전자공학과 (공학석사)

1994년 8월 : 서울대학교 전자공학과 (공학박사)

1995년 3월 ~ 현재 : 전남대학교 지능전자컴퓨터공학과 교수

관심분야 : 디지털 신호처리, 영상 처리, 머신러닝, 딥러닝