다중 소형 로봇 시스템에서 효율적 환경 정보 융합을 위한 객체 중심 스펙트럼 매칭 기법

초록

본 논문는 다중 로봇 시스템에서 각 로봇이 독립적으로 수집한 환경 정보를 효율적으로 융합하는 방법을 제안한다. 로봇의 작은 크기로 인한 제한된 전력으로 인해 고성능 센서를 사용할 수 없으며, 저성능 센서를 사용할 수 밖에 없다. 이러한 센서들로부터 얻은 데이터를 융합하여 다중 객체의 위치를 수집한다. 수집된 정보는 메쉬 네트워크를 통해 로봇 간 주고 받는다. 그리고 허프 변환과 객체 중심 스펙트럼 매칭 방법을 활용해 두 환경 정보 간의 최적 회전을 추정한다. 데이터 양이 동일하거나 차이나는 시나리오에서 이 두 방법을 비교한 결과, 객체 중심 스펙트럼 매칭 방법이 빠른 수행시간과 높은 정확도를 보여준다.

Abstract

This paper proposes an efficient method for fusing environmental information collected independently by each robot in a multi-robot system. Due to the small size of the robots, high-performance sensors with limited power cannot be used, and low-performance sensors must be used. The data from these sensors are fused to collect the locations of multiple objects. The collected information is exchanged between the robots through a mesh network, and the optimal rotation between the two environmental information is estimated using the Hough transform and the object-centered spectral matching method. Comparing the two methods in scenarios with equal or different amounts of data, the object-centered spectral matching method shows faster computation time and higher accuracy.

Keywords:

multiple small robot systems, information fusion, object-centered spectral matchingⅠ. 서 론

전장 환경에서 현대 기술의 발전은 병력을 대신하여 임무를 수행하는 로봇을 활용하는 패러다임으로 변화를 야기했다. 지상, 바다, 공중 등의 다양한 환경에서 사람을 대신하여 효율적으로 임무를 수행하는 로봇 시스템은 사람과 달리 피로를 느끼지 않아 임무 수행에 제약이 적고 사람이 다칠 위험이 없다. 이러한 이점 때문에 군용 로봇에 대해 연구, 개발이 지속적으로 이루어지고 있다[1]-[4].

그리고 로봇의 크기에 따라 견딜 수 있는 하중이 달라진다. 로봇의 크기가 클수록 많은 하중을 견딜 수 있어 큰 사이즈의 배터리가 장착 가능하다. 이는 가용 전력이 많음을 의미하며, 반면에 소형 로봇 시스템은 적은 하중을 견딜 수 있기 때문에 작은 사이즈의 배터리를 사용할 수 밖에 없다. 그러므로 가용 전력량이 적은 특징을 가지며, 사용되는 전력량에 따라 운용 가능한 시간이 달라지는 특징을 가진다. 또한 소형 로봇 시스템은 좁은 전장 환경에서 하나의 로봇으로 전장 환경 정보를 수집할 수 있지만, 넓은 전장 환경에서는 정보 수집 시간이 오래 걸린다.

넓은 공간에서의 수행 시간이 많이 걸리는 문제점을 해결하기 위해 다수의 로봇을 각각 일정 구역에서 환경 정보를 수집하도록 하는 것이 일반적이다. 앞서 언급했듯이 소형 로봇 시스템은 크기 제한으로 인한 배터리 크기에 제약이 따르며, 전력 소모에 따른 운용 시간에 제한이 생기므로, 센서의 전력 소모량을 고려해야 한다. 그래서 소형 로봇에서 전력을 많이 사용하는 고성능 센서의 사용이 어렵고, 전력을 적게 소모하는 저전력 센서를 사용해야한다. 저전력 센서는 고성능 센서에 비해 동작 범위가 제한적이며, 데이터 왜곡으로 인한 노이즈가 많은 데이터를 얻게 된다.

이러한 문제점은 부정확한 정보를 수집하게 되고, 군집 로봇이 각각 수집한 전장 정보를 융합할 때 공통의 환경 정보에 대해 불일치가 발생하게 되며, 이렇게 누적된 오차로 인해 효율적으로 환경 정보를 융합할 수 없게 된다. 더불어 전체 다중 로봇 환경 정보 융합 시스템의 성능을 저하시킬 수 있다. 따라서 개별 로봇에서 수집한 환경 정보들을 정확하게 수집하고, 전체 환경 정보로 효율적으로 융합할 수 있는 기술이 필요하다.

개별 로봇이 수집한 환경 정보 정보를 융합하기 위해 다양한 방식으로 시도해왔다. 효율적으로 환경 정보를 융합하기 위한 다양한 방식 중 환경 정보의 스펙트럼 데이터를 활용하여 융합하는 방법[5]-[7]과 픽셀 간 비교를 통한 특징을 추출하여 융합하는 방법 등이 과거 연구로부터 제안되었다[8]-[19]. 이러한 방식 대부분은 환경 정보의 크기가 커서 그 정보 그대로 사용하기엔 처리 시간이 오래 걸려, 환경 정보에서 특징 정보를 추출하여 융합을 위한 정보로 사용한다. 이전 연구에서는 허프 변환을 통해 특징 정보를 추출하는 방법으로 전체 환경 정보로 융합을 시도한 연구[8]-[14]와 환경 정보에서 직접적으로 특징점을 계산하여 융합한 연구[15]와 이미지 내에서 객체의 모서리같은 픽셀간의 색상 차이가 나는 지점을 찾아 키포인트를 추출하는 알고리즘을 사용하여, 융합한 연구[16]-[19]가 있다. 허프 변환을 통해 특징 정보를 추출하는 방법은 파라미터 좌표계로 변환을 하므로 파라미터 좌표계의 해상도가 중요하다. 간결한 해상도로 변환하면 정확한 융합 값을 구할 수 없고, 세밀한 해상도로 변환하면 정확한 값을 추정할 수 있지만 처리 시간이 오래 걸리는 단점을 가진다. 그리고 환경 정보의 키포인트를 추출하는 알고리즘은 허프 변환 방법과 마찬가지로 데이터의 크기가 커질수록 오랜 시간이 걸리며, 환경 정보 사이에 비슷한 정보가 부족하면, 환경 데이터 사이의 융합 데이터를 추정할 수 없는 확률이 높아진다.

이러한 문제점을 개선하기 위해서 객체 중심의 스펙트럼 매칭 기법을 제안하고, 이를 통해 각 로봇이 수집한 환경 정보를 효율적으로 융합하는 방법에 관해 연구하였다. 제안 방법은 여러 센서 데이터를 융합하여 추정한 환경 정보에서 같은 객체 이름을 중심으로 상관 관계를 구성한다. 그리고 두 개의 점군 사이의 변환을 찾는 데 사용되는 알고리즘인 ICP(Iterative Closest Point) 알고리즘의 정합 과정 중에서 두 점군 사이의 최적 회전과 이동을 찾는 방법인 SVD(Singular Value Decomposition)를 사용하여 두 환경 정보 사이의 회전과 이동 값을 찾아 개별 로봇이 수집한 환경 정보를 융합하였다.

이러한 방법은 허프 변환 혹은 스펙트럼 매칭 기반 융합 방식에 비해 추가적인 샘플링 작업이 없어 최적의 값을 빠르게 찾을 수 있다는 장점이 있다[20][21].

본 논문은 다음과 같은 순서로 구성된다. 2장에서 환경 정보 융합을 위한 다중 로봇 시스템 좌표계와 스펙트럼 매칭 기반 융합 방법의 문제점에 대해 서술하고, 3장에서 연구를 수행한 전체 시스템에 관해 설명한다. 4장에서는 제안된 방법과 실험 결과를 분석한다. 마지막으로 5장에서 결론과 함께 향후 연구 방향을 제시한다.

Ⅱ. 문제점 기술

2.1 환경 정보 융합을 위한 다중 로봇 시스템 좌표계

다중 로봇 시스템에서 개별 로봇들은 각자의 위치와 방향에 따라 독립적으로 환경 정보를 수집한다. 따라서 수집된 정보들은 각각의 로봇에 따라 서로 다른 좌표계에 있고, 이를 하나의 좌표계 내에서 사용하기 위해 공통의 좌표계로 변환하는 과정이 필요하다.

2.2 허프 스펙트럼 매칭 기반 환경 정보 융합의 문제점

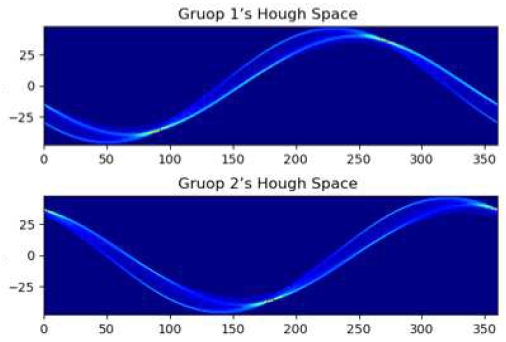

허프 변환(Hough transform)은 특히 직선이나 원 같은 기하학적 형태를 감지하는 데 많이 사용되는 기술이다. 그러나 기울기가 무한대인 직선에 대해 표시를 못 하므로 극좌표를 도입하였다. 이는 허프 파라미터 공간에서 기울기가 무한대인 직선에 대해 표현할 수 있고, 일부 누락된 정보가 있어도 형태를 잘 찾아낼 수 있으며, 회전, 크기 변환 등에 불변하는 특성을 갖는다. 하지만 데이터의 크기에 따라 계산 복잡성이 커지므로 자원 사용량도 증가하는 단점이 있다. 그림 1은 다중 객체 위치 정보를 시각화한 그림이다. 그림 2는 그림 1의 두 그룹의 데이터를 허프 변환하고 시각화한 그림이다. 포인트 집단이 포함하고 있는 특징이 특정 각도의 하나의 점으로 표시된다. 그리고 표 1은 그림 1과 같은 데이터를 가지고, 임베디드 시스템에서 두 그룹의 데이터를 허프 변환 해상도별로 허프 변환을 수행시간을 나타내는 표이다. 허프 변환 해상도를 세밀하게 할수록 정확한 Hough Space 값을 추정할 수 있으나, 수행 시간이 오래 걸린다는 단점이 있다.

Ⅲ. 제안하는 기법

3.1 전체 구조

제안된 방법의 전체 구조는 그림 3과 같이 심층 학습을 이용한 객체 인식, Depth 기반 객체 위치 추정 그리고 객체 중심 스펙트럼 매칭이라는 세 가지 단계로 구성된다. 먼저 심층학습 기반 객체 인식은 각 로봇에서 카메라 센서의 RGB 이미지를 통해 다양한 종류의 객체를 추정한다. 그리고 Depth 기반 객체 위치추정은 앞서 RGB 이미지에서 추정한 객체 Box 정보를 기반한 Depth 이미지에 있는 Depth 정보를 결합하여 해당 객체의 위치를 추정한다. 이러한 방식으로 다중 객체의 위치 정보를 수집하고, 마지막 단계인 객체 중심 스펙트럼 매칭 단계에서 객체의 이름을 중심으로 상관관계를 구성하고, 최적의 회전과 이동 값을 찾아 두 환경 정보를 통합한다. 이 3가지 단계를 통해서 각각의 로봇이 독립적으로 수집한 환경 정보를 효율적으로 융합한다.

3.2 심층학습 기반 객체 인식

심층학습 기반 객체 인식 단계에서는 YOLO(You Only Look Once) 심층학습 프레임워크를 사용하여 그림 4와 같이 로봇에 장착된 카메라로부터 얻은 RGB 이미지를 입력으로 받아 환경에 존재하는 객체를 식별하고 분류한다. YOLO는 실시간 객체 탐지에 특화된 심층학습 모델로서 하나의 RGB 이미지 프레임에서 심층학습 기반의 신경망을 사용하여 동시에 객체의 바운딩 박스와 클래스를 추정할 수 있다. 이런 특징은 로봇이 다양한 환경에서 실시간으로 객체를 인식할 수 있도록 한다.

3.3 Depth 기반 객체 위치추정

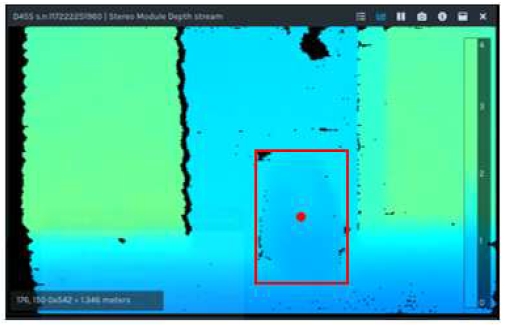

Depth 기반 객체 위치추정 단계에서는 앞서 YOLO 모델을 이용해 추정한 RGB 이미지에서의 객체 바운딩 박스 정보 및 2D 픽셀 좌표를 활용하여 바운딩 박스의 가운데 값을 기준으로 한 Depth 정보를 내부 파라미터와 결합하여, 아래의 수식들을 이용하여 3차원 공간상의 좌표로 추정한다.

| (1) |

| (2) |

여기서 x, y는 탐지된 객체 바운딩 박스의 가운데 있는 점의 좌표이고, fx, fy는 초점 길이는 나타낸다. ppx, ppy는 카메라 렌즈의 중심에서 이미지 센서에 내린 수선의 좌표를 의미하며, depth는 depth 이미지 값을 의미한다.

그림 5와 그림 6은 그림 4에서의 depth 이미지와 로봇 기준 객체 위치 추정 결과를 나타낸다. 그림 4에서 인식된 객체의 위치가 성공적으로 추정됨을 나타낸다. 이렇게 추정된 객체 위치 정보의 정확도를 높이기 위해, 그림 7과 같이 일정한 거리 안에 있는 동일한 객체 클래스의 위치 정보와 평균 값을 구함으로써 단일 관측을 통한 객체 위치보다 정확한 객체의 위치를 구할 수 있다.

그리고 주변 환경에 대한 지도를 만들고, 로봇 기준의 객체 위치를 얻기 위해서 2D SLAM(Simultaneous Localization and Mapping)을 수행한다. 이를 통해 로봇의 좌표를 얻어 이를 기준으로 객체의 위치를 표시할 수 있다.

다중 로봇 시스템에서는 개별 로봇이 앞서 설명한 방법을 독립적으로 사용하여 다중 객체 위치 정보를 수집한다. 이 과정을 통해, 각각의 로봇이 주변 환경에서 객체의 위치를 정확하게 파악할 수 있고, 전체 환경 정보를 얻을 수 있다.

3.4 객체 중심 스펙트럼 매칭

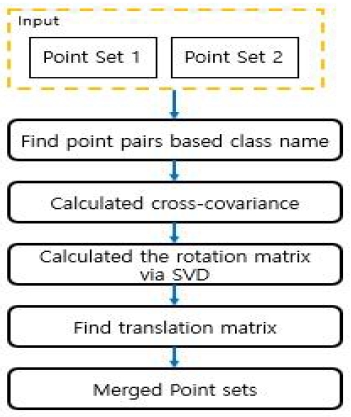

마지막 단계인 객체 중심 스펙트럼 매칭은 개별 로봇이 수집한 다중 객체 정보를 전체 환경 정보로 융합하기 위해 사용된다. 그림 8과 같이 환경 정보 A, B, C를 허프 공간으로 변환했을 때, 객체의 이름도 수집하기 때문에 허프 공간에서 어디에 어떤 객체 위치 정보가 존재하는 지 알 수 있다. 그래서 동일한 객체 이름을 가진 변한된 포인트 정보 사이의 차이를 구하면 쉽게 회전 각도를 추정할 수 있다. 그리고 그림 9와 같이 각 로봇이 수집한 다중 객체 정보를 이용해 객체 이름을 중심으로 한 매칭쌍을 만든다.

그리고 이 매칭쌍을 통해 두 환경 정보 사이의 상관 관계를 구성하고, 이 상관 관계를 바탕으로한 교차 공분산을 계산한다.

| (3) |

| (4) |

| (5) |

| (6) |

계산된 교차 공분산 K는 두 환경 정보 사이의 상관 관계를 나타내며, 이 정보를 이용해 SVD를 사용하여 세 개의 특이 행렬로 분해할 수 있다. 이 특이 행렬의 첫 번째 특이 행렬 U, 세 번째 특이 행렬 VT 의 곱으로 최적의 회전 행렬 R을 추출한다. 이 회전 행렬 R은 두 환경 정보를 가장 잘 일치시키는 회전을 나타낸다. 이 최적 회전 행렬로 두 번째 환경 정보(ps)를 회전한 뒤, 두 환경 정보(pT,pS)의 중심 값을 비교하여 최적의 이동 행렬 T를 구한다. 이 과정을 통해 각각의 로봇이 수집한 다중 객체 정보를 전체 환경 정보로 융합한다. ICP(Iterative Closest Point)의 경우 포인트 집단 사이에서 포인트 정합을 위해 포인트 사이에 관계를 찾을 때 가장 가까운 포인트를 기준으로 상관 관계를 구성하고, 이를 기반으로 최적의 회전, 이동 값을 추정한다. 그리고 기존의 포인트와 이동한 포인트의 차이를 에러로 정의하고, 에러 값이 일정 threshold 값보다 적어질 때까지 상관 관계를 재구성, 포인트 이동과 에러 판단하는 과정을 반복한다. 객체 중심 스펙트럼 매칭 방법은 포인트와 포인트 사이에서 정합하기 위한 최적의 경로를 효율적으로 구할 수 있다.

Ⅳ. 실험 결과

4.1 실험 환경 및 다중 소형 로봇 시스템 구성

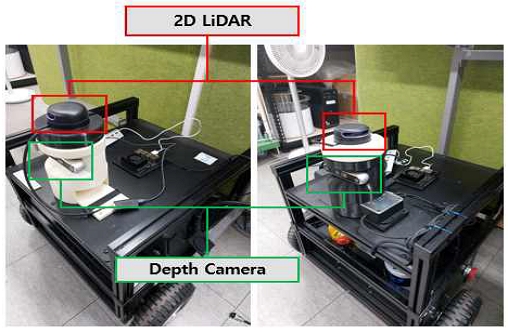

실험은 660×510×263(mm) 크기의 그림 10과 같은 로봇 두 대로 환경 지도 정보를 수집했다.

수집 환경은 그림 11과 같이 가로 약 4m, 세로 약 50m의 넓은 중앙 복도 환경에서 수행되었다. 두 대의 로봇은 효율적으로 전체 환경 정보를 얻기 위해서 서로 같거나 다른 갯수의 객체에 대해 환경 정보를 수집한다. 그리고 서로 다른 방향으로 각각의 로봇들이 움직여 일부 환경 정보를 수집하였다.

수집된 정보는 메시 네트워크를 통해 교환했다. 각각의 로봇은 환경 정보를 수집하기 위해 Depth 카메라와 2D LiDAR(Light Detection and Ranging)를 탑재하고 있다. 이러한 구성은 로봇이 자기 위치 인지 및 객체 위치 추정에 필요한 정보를 수집하는 데 활용된다.

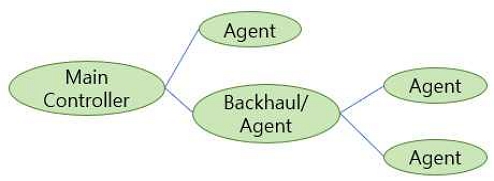

실험에 사용된 메쉬 네트워크는 그림 12, 13에서 보이는 것처럼 메인 중계기와 중간 관리자 역할의 백홀, 그리고 세 개의 에이전트로 구성된다. 메시 네트워크는 여러 개의 독립적인 네트워크를 하나로 연결함으로써 대형 네트워크를 형성한다. 이 구조는 로봇이 단일 네트워크의 연결 범위를 벗어나면 통신이 중단되는 문제를 해결한다. 이 방식을 통해 로봇이 메시 네트워크의 범위 내에서 거리에 상관없이 넓은 공간에서도 원활한 통신이 가능하다.

4.2 객체 인식 및 위치 추정 결과

각 로봇은 중앙 복도에서 SLAM을 수행하며, 주변 환경 지도와 자기 로봇 위치를 추정한다. 이 위치 정보를 기반으로 객체 인식 및 위치 추정에 사용되며, 그 결과는 그림 14 및 그림 15와 같다.

이때, 탐지된 객체의 위치는 빨간 원으로 표시된 파란색 사각형이 의미하고, 삼색 축은 현재 로봇의 위치와 방향을 나타내며, 초록색 선은 로봇이 이동한 경로를 표시한다. 그리고 다양한 시나리오에서 성능을 입증하기 위해, 로봇들이 동일한 객체를 인식하는 경우(Case 1)와 일부 객체만 인식하는 경우(Case 2)로 나누어 실험을 수행했다. 객체 인식 및 추정 결과는 그림 16과 17에서 확인할 수 있다.

4.3 객체 중심 스펙트럼 매칭 결과

두 로봇이 동일한 객체에 대해 수집한 다중 객체 경우(Case 1)와 일부 객체에 대해 수집한 경우(Case 2)에 대해 객체 중심 스펙트럼 매칭 순서는 그림 9와 같다. 객체 중심 스펙트럼 매칭 결과는 그림 18, 19에서 보여주며, 객체 이름을 중심으로 구성된 매칭 쌍을 확인할 수 있다.

4.4 환경 정보 융합 결과

각 로봇이 동일한 객체에 대해 독립적으로 수집한 정보를 융합한 결과를 그림 20에서 보여주고, 일부 객체에 대해 수집한 정보를 융합한 결과를 그림 21에서 보여준다. 두 경우 모두 정확하게 일치하지는 않지만, 두 가지 융합 과정에서 일관된 모습을 보이는 것을 확인할 수 있다. 그림 18, 19의 매칭 상관 관계 기준으로 이동한 두 위치 정보 사이 오차는 표 2와 같다.

| (7) |

| (8) |

추정된 회전 행렬은 식 (7)의 R의 2×2 행렬과 일치하며, 원점에 대한 회전 값을 의미한다. 또한, 이동 행렬은 식 (8)의 T와 같은 2×1 행렬 형태로 추정되며, 두 객체 위치 정보 사이의 X 와 Y 차이를 나타낸다. 이 값을 기준으로 두 번째 객체 위치 그룹을 회전 및 이동이 적용되어 표시된다. 그러나 완벽히 정확하게 두 환경 정보가 융합되지 않았다. 정확하게 융합이 되지 않은 원인은 SLAM의 위치 오류와 Depth 정보의 부정확 때문이다. 저가형 센서의 잡음이 많은 데이터로 인해서 SLAM의 정확도가 떨어지므로, 로봇의 위치가 부정확해질 수 있다. 또한, 카메라의 Depth 값을 RGB의 바운딩 박스 기준 한가운데 픽셀 값을 가져올 때, 객체의 중심이 비어있는 경우 잘못된 값을 얻을 가능성이 있다. 이러한 이유로 객체 위치 추정이 부정확해진다.

4.5 정량적 비교 및 분석

그림 16, 17의 시나리오를 바탕으로 기존 방법인 허프 변환과 제안된 방법인 객체 중심 스펙트럼 매칭 방법의 수행 시간을 여러 플랫폼에서 비교했다. 단, 허프 변환을 통해 회전 추정한 방법은 허프 공간 내에서 특징을 강조하기 위해서 일정 거리 안에 위치한 객체들 사이에 가상지지선(VSL, Virtual Supporting Line)을 추가했다. 그리고 가상지지선을 적용한 정보를 통해 정규화된 허프 변환 결과를 서로 비교한다. 그리고 정규화된 정보를 통해 해상도 범위만큼씩 이동시키며 두 정규화된 허프 변환 정보 사이의 상관 관계를 계산한다. 이때 최대 상관 관계 값을 갖는 지점이 두 정보가 가장 비슷하다는 것을 의미하며, 최적 회전 값을 의미한다. 허프 변환의 특성상 180도를 기준으로 같은 값을 나타내므로, 최댓값이 두 개가 도출된다.

그리고 객체 중심 스펙트럼 매칭 방법과 허프 변환 방법의 수행 시간 성능 비교를 위해 일반적인 임베디드 시스템에서 수행 시간을 측정하였으며, 그 결과는 표 3과 4에 나타나 있다. 표 3과 4 에서의 결과는 그림 15와 16의 데이터를 가지고, 허프 변환의 파라미터, 즉 원점으로부터의 거리와 각도에 대한 측정 해상도를 각각 0.1로 설정했을 때, 거리 해상도를 0.2와 각도 해상도를 0.1로 설정했을 때와 객체 중심 스펙트럼 매칭 방법을 Jetson Nano 그리고 Jetson Xavier NX에서의 수행 시간을 나타낸다.

Computation time comparison of the Hough transform fusion method and object-centric spectral matching method on Jetson Nano

Computation time comparison of the Hough transform fusion method and object-centric spectral matching method on Jetson Xavier NX

허프 변환 해상도를 높게 설정했을 때, Case 1에 비해 데이터양이 적은 Case 2에서 상대적으로 계산 시간이 줄어들었지만, 이는 여전히 실시간 처리를 기대하기에는 어려움이 있어서 각 로봇이 수집한 환경 정보를 융합할 때, 그 시간 동안 로봇은 다른 작업을 할 수 없는 제한 사항이 발생한다. 그리고 거리와 각도 해상도를 줄였을 때, 그 결과 대략 3분의 1수준으로 줄어들었다. 이는 적은 양의 데이터가 허프 변환되기 때문에 Case 1 보다 적은 수행 시간을 보였다. 그리고 표 3과 4의 결과 모두에서 객체 중심 스펙트럼 매칭을 수행 시간이 매우 빠른 것을 알 수 있다. 약 0.01초 수준으로, 추가적인 샘플링 작업없이 단순 연산만을 수행함에 따라 빠른 결과를 보여준다.

표 5는 허프 변환 융합 방법과 객체 중심 스펙트럼 매칭 융합의 결과에 대해 거리 오차를 비교한 것이다. 가까운 두 환경 정보 사이의 평균 거리를 오차로 정의하였다. 그 결과 허프 변환 융합 방법은 허프 파라미터 해상도에 크게 영향을 받지 않는 모습을 보였으며, 객체의 갯수에 따라 다른 융합 결과를 보였다. 서로 개수가 같을 때(Case 1), 상대적으로 정확한 융합 결과를 보였으며, 객체 중심 스펙트럼 매칭 방법은 두 가지 케이스 모두 허프 변환 융합 방법보다 정확한 융합 결과를 보였다.

두 가지 방법 다 어느정도 일관된 융합 결과를 보였으나, 허프 변환 융합 방법은 오랜 시간이 소요되어, 그 시간동안 기다릴 수 밖에 없기 때문에 실시간성을 기대하기 부족하다. 그리고 객체 중심 스펙트럼 매칭이 더 적은 수행 시간으로 허프 변환 방법보다 좋은 정확도의 융합 결과를 보였으며, 객체 중심 스펙트럼 매칭 융합 방법이 다중 로봇 시스템에서 전체 환경 정보를 수집하기에 적합한 결과를 보였다.

Ⅴ. 결 론

본 본문은 다중 로봇에서 수집한 환경 정보를 효율적으로 융합하는 방법에 대해 제안했다. 이는 두 대의 로봇이 서로 독립적으로 환경 정보를 수집하고, 메시 네트워크를 통해 데이터를 송신, 수신하여 허프 변환 방법과 객체 중심 스펙트럼 매칭 방법으로 두 환경 정보 사이의 최적 회전을 추정하는 방식으로 진행되었다. 메시 네트워크 통신 방식을 통해 로봇이 먼 거리에서 통신할 수 있어, 효율적으로 수행할 수 있었다. 그리고 각 로봇이 수집한 데이터양이 같거나 더 적은 시나리오를 통해 객체 중심 스펙트럼 매칭 방법과 허프 변환 방법을 임베디드 시스템에서 비교했다. 그 결과 파라미터를 감소시킨 허프 변환 융합 방법의 임베디드별 수행 시간이 각각 1.515초 와 0.862초로 측정됐으며, 객체 중심 스펙트럼 융합 방법의 임베디드 별 수행 시간은 각각 0.008초로 측정되어 객체 중심 스펙트럼 매칭 방법이 매우 짧은 수행 시간을 보여준다. 그리고 동일한 조건에 대해 객체 중심 스펙트럼 매칭의 오차가 허프 변환 융합 방법의 오차보다 더 정확한 오차를 보였다. 향후에는 매칭 오차를 좀 더 감소시킬 수 있는 방법과 더 복잡한 환경 지도 사이에서 정확하게 융합할 수 있는 방법에 대해서 연구하고자 한다.

Acknowledgments

이 논문은 2022년도 정부(방위사업청)의 재원으로 국방기술진흥연구소의 지원을 받아 수행된 연구임(No. KRIT-CT-22-006-002, 초소형 군집로봇 상황/환경 인지 기술)

References

-

D. Voth, "A new generation of military robots", IEEE Intelligent Systems, Vol. 19, No. 4, pp. 2-3, Jul. 2004.

[https://doi.org/10.1109/MIS.2004.30]

-

B. M. Yamauchi, "PackBot: a versatile platform for military robotics", Unmanned ground vehicle technology VI, Vol. 5422, pp. 228-237, Sep. 2004.

[https://doi.org/10.1117/12.538328]

-

D. L. Hall and J. Llinas, "An introduction to multisensor data fusion", in Proceedings of the IEEE, Vol. 85, No. 1, pp. 6-23, Jan. 1997.

[https://doi.org/10.1109/5.554205]

-

J. Khurshid and H. Bing-rong, "Military robots - a glimpse from today and tomorrow", ICARCV 2004 8th Control, Automation, Robotics and Vision Conference, Kunming, China, Vol 1, pp. 771-777, Dec. 2004.

[https://doi.org/10.1109/ICARCV.2004.1468925]

-

P. Mukhopadhyay and B. B. Chaudhuri, "A survey of Hough Transform", Pattern Recognition, Vol 48, No. 3, pp. 993-1010, Mar. 2015.

[https://doi.org/10.1016/j.patcog.2014.08.027]

-

V. F. Leavers, "Which hough transform?", CVGIP: Image understanding, Vol. 58, No. 2, pp. 250-264, Sep. 1993.

[https://doi.org/10.1006/ciun.1993.1041]

-

J. C. Park and D. S. Kang, "An Algorithm for the Determination of Twisted Rebar using Feature Matching", JKIIT, Vol. 19, No. 2, pp. 21-28, Feb. 2021.

[https://doi.org/10.14801/jkiit.2021.19.2.21]

-

H. C. Lee and B. H. Lee, "Improved feature map merging using virtual supporting lines for multi-robot systems", Advanced Robotics, Vol. 25, No. 13-14, pp. 1675-1696, 2011.

[https://doi.org/10.1163/016918611X584631]

-

H. C. Lee and S. Lee, "Extended Spectra-Based Grid Map Merging With Unilateral Observations for Multi-Robot SLAM", IEEE Access, Vol. 9, pp. 79651-79662, May 2021.

[https://doi.org/10.1109/ACCESS.2021.3083936]

-

H. Lee, "One-Way Observation-based Cooperative Robot Mapping", 2020 IEEE 16th International Conference on Automation Science and Engineering (CASE), Hong Kong, China, pp. 900-905, Aug. 2020.

[https://doi.org/10.1109/CASE48305.2020.9216996]

-

H. C. Lee, Y. J. Cho, and B. H. Lee, "Accurate map merging with virtual emphasis for multi‐robot systems", Electronics Letters, Vol. 49, No. 15, pp. 932-934, Jul. 2013.

[https://doi.org/10.1049/el.2013.1572]

-

H. C. Lee and B. H. Lee, "Enhanced-spectrum-based map merging for multi-robot systems", Advanced Robotics, Vol. 27, No. 16, pp. 1285-1300, Feb. 2013.

[https://doi.org/10.1080/01691864.2013.819609]

-

S. Carpin, "Fast and accurate map merging for multi-robot systems", Autonomous robots, Vol. 25, pp. 305-316, Jun. 2008.

[https://doi.org/10.1007/s10514-008-9097-4]

- H. Jiří, "Map-merging for multi-robot system", Univerzita Karlova, Matematicko-fyzikální fakulta, Jun. 2016. http://hdl.handle.net/20.500.11956/83769, .

-

B. Chen, S. Li, H. Zhao, and L. Liu, "Map merging with suppositional box for multi-robot indoor mapping", Electronics, Vol. 10, No. 7, pp. 815, Mar. 2021.

[https://doi.org/10.3390/electronics10070815]

-

S. A. K. Tareen and Z. Saleem, "A comparative analysis of SIFT, SURF, KAZE, AKAZE, ORB, and BRISK", 2018 International Conference on Computing, Mathematics and Engineering Technologies (iCoMET), Sukkur, Pakistan, pp. 1-10, Mar. 2018.

[https://doi.org/10.1109/ICOMET.2018.8346440]

-

O. Yakovleva and K. Nikolaieva, "Research of descriptor based image normalization and comparative analysis of SURF, SIFT, BRISK, ORB, KAZE, AKAZE descriptors", Advanced Information Systems, Vol. 4, No. 4, pp. 89-101, Dec. 2020.

[https://doi.org/10.20998/2522-9052.2020.4.13]

-

H. -J. Chien, C. -C. Chuang, C. -Y. Chen, and R. Klette, "When to use what feature? SIFT, SURF, ORB, or A-KAZE features for monocular visual odometry", 2016 International Conference on Image and Vision Computing New Zealand (IVCNZ), Palmerston North, New Zealand, pp. 1-6, Nov. 2016.

[https://doi.org/10.1109/IVCNZ.2016.7804434]

-

S. A. K. Tareen and R. H. Raza, "Potential of SIFT, SURF, KAZE, AKAZE, ORB, BRISK, AGAST, and 7 More Algorithms for Matching Extremely Variant Image Pairs", 2023 4th International Conference on Computing, Mathematics and Engineering Technologies (iCoMET), Sukkur, Pakistan, pp. 1-6, Mar. 2023.

[https://doi.org/10.1109/iCoMET57998.2023.10099250]

- B. Bellekens, V. Spruyt, R. Berkvens, and M. Weyn, "A survey of rigid 3d pointcloud registration algorithms", AMBIENT 2014: the Fourth International Conference on Ambient Computing, Applications, Services and Technologies, Rome, Italy, pp. 8-13, Aug. 2014. http://hdl.handle.net/1854/LU-5713477, .

-

S. Ying, J. Peng, S. Du, and H. Qiao, "A Scale Stretch Method Based on ICP for 3D Data Registration", IEEE Transactions on Automation Science and Engineering, Vol. 6, No. 3, pp. 559-565, Jul. 2009.

[https://doi.org/10.1109/TASE.2009.2021337]

2022년 8월 : 금오공과대학교 전자공학부 전자IT융합전공(공학사)

2022년 8월 ~ 현재 : 금오공과대학교 IT융복합공학과 석사과정

관심분야 : SLAM, Swarm robot systems

2019년 2월 ~ 현재 : 금오공과대학교 전자공학부 학사과정

관심분야 : Multi-sensor fusion, object detection and localization

2006년 8월 : 경북대학교 전자전기컴퓨터학부(공학사)

2008년 8월 : 서울대학교 전기컴퓨터공학과(공학석사)

2013년 8월 : 서울대학교 전기컴퓨터공학과(공학박사)

2013년 9월 ~ 2019년 2월 : 국방과학연구소 선임연구원

2019년 3월 ~ 현재 : 금오공과대학교 전자공학부 IT융복합공학과 조교수

관심분야 : SLAM, 자율주행, 인공지능, 알고리즘 가속화