콘크리트 구조물의 이상 탐지를 위한 시맨틱 분할 기반의 데이터 증강 기법

초록

인공지능 및 딥러닝 기술의 발전으로 다양한 분야에서 혁신적인 성과가 이루어지고 있지만, 여전히 제한된 수량과 종류의 데이터셋을 이용하여 모델을 학습시키는 한계점이 존재한다. 본 논문에서는 콘크리트 구조물의 이상 탐지를 위한 시맨틱 분할 기반의 데이터 증강 기법을 제안한다. 제안하는 방법은 시맨틱 분할을 통해 결함 부분을 추출하고, 무작위 위치 선정과 알파 합성을 통해 객체와 배경을 합성하여 다양한 배경과 결함 조합을 포함하는 이미지 데이터셋을 생성한다. 이 방법은 Dice Score와 IoU Score를 사용하여 평가하였으며, 실험 결과 이 방법은 기존의 방법보다 더 높은 성능을 보이고 있어 콘크리트 구조물 결함 탐지 분야에서 실용적으로 적용될 수 있다.

Abstract

Although innovative achievements are being made in various fields due to advances in artificial intelligence and deep learning technologies, there are still limitations in learning models using limited quantities and types of datasets. This paper proposes a Semantic Segmentation based Data Augmentation Techniques for Anomaly Detection of Concrete Structures. The proposed method extracts the defect part through semantic segmentation, and synthesizes objects and backgrounds through random positioning and alpha synthesis to generate an image dataset containing various backgrounds and defect combinations. This method was evaluated using Dice Score and IoU Score, and as a result of the experiment, this method shows higher performance than the existing method, so it can be applied practically in the field of detecting defects in concrete structures.

Keywords:

artificial intelligence, machine learning, data mining, computer vision, image synthesis, image augmentationⅠ. 서 론

인공지능 및 딥러닝 기술의 발전과 확산으로 다양한 분야에서 혁신적인 성과가 이루어지고 있다[1]. 이러한 발전을 기반으로, 복잡한 비주얼 패턴을 인식하거나 분류하는 기술을 개발하기 위해 다양한 이미지 처리를 위한 딥러닝 모델들이 개발되고 있다[2]. 또한, 모델의 성능을 향상시키기 위해 많은 연구와 실험들이 진행되고 있지만, 여전히 모델 학습에 있어 제한적인 수량과 종류의 데이터셋을 이용한다는 한계점이 존재한다. 이로 인해, 데이터 증강(Data augmentation) 기술의 중요성이 점점 더 가중되고 있다. 데이터 증강은 기존의 데이터를 다양한 방법으로 변형하여 새로운 데이터를 생성하는 과정으로, 데이터 부족 현상을 해결하고 모델의 성능을 향상시키기 위해 다양한 분야에서 활용되고 있다. 특히, 전문화된 특수 목적을 위한 이미지 처리 딥러닝 모델들은 학습을 위한 데이터 샘플링의 한계로 인하여, 데이터 증강 기술이 필수적으로 사용되고 있다[3].

J. Yeh[4]은 손가락 정맥 분석을 하는 과정에서 부족한 데이터셋을 증가시키기 위해 이미지 내의 일부 영역을 임의로 잘라내는 방법인 CutOut을 이용한다. 그러나 CutOut은 삭제된 영역에 해당하는 중요한 정보가 손실되어 모델이 해당 객체를 잘 인식하지 못할 수 있는 한계점을 가지고 있다. 또한 Z. Gao[5]는 의류 이미지를 분류하기 위한 과정에서 Random Erasing을 이용한다. Random Erasing은 이미지에서 임의의 영역을 삭제하고 삭제된 영역을 임의의 색상 또는 잡음으로 채우는 방법이다. 이는 모델이 잘못된 영역이나 일부 누락된 영역에 대해서도 강인성을 가질 수 있어 모델의 일반화 능력을 향상시킬 수 있는 장점을 가지고 있다. 그러나 삭제할 영역의 크기와 위치는 무작위로 설정되며, 이는 모델의 학습에 영향을 줄 수 있다. 또한 특정 크기나 위치의 삭제 영역은 모델의 불변성을 제한하거나 특정 객체 또는 패턴을 인식하는 데 어려움이 있다.

본 연구에서는 건축 분야에서 콘크리트 구조물의 이상 탐지를 위한 시맨틱 분할 기반의 데이터 증강 기법을 제안한다. 제안하는 방법은 합성에 필요한 결함 이미지 데이터를 수집하고 합성을 위한 결함 부분을 추출한다. 이를 위해 이미지 내의 각 픽셀을 객체 클래스 레이블에 따라 분류하는 시맨틱 분할을 이용한다. 이후, 정상 데이터를 이용하여 배경 이미지로 설정하고 물체 합성을 위해 이미지 좌표를 사용한다. 배경 이미지 범위 내에서 무작위로 추출한 결함 부분을 합성하고 자연스러운 합성을 위해 알파 합성 방법을 사용하여 이미지 데이터를 증강한다.

본 논문 구성은 다음과 같다. 2장에서 관련 연구인 Semantic Segmentation과 Alpha Blending를 설명한다. 3장에서 콘크리트 구조 이상 탐지를 위한 시맨틱 분할 기반의 데이터 증강 기법 제안 방법을 설명한다. 4장에서 이전 연구들과의 성능 평가를 기술한다. 마지막으로 5장에서 종합적으로 결론을 기술한다.

Ⅱ. 관련 연구

2.1 이미지 분할

이미지 분할(Image segmentation)은 디지털 이미지를 여러 개의 세그먼트로 나누는 프로세스를 의미한다. 각 세그먼트는 이미지 내의 논리적이고 의미론적인 영역을 나타내며, 비슷한 특성을 가진 픽셀들로 구성된다[6]. 해당 프로세스는 크게 세 가지 유형으로 나눌 수 있다. 첫째는 픽셀 기반 이미지 분할로 픽셀의 색상, 밝기, 질감 등의 특성을 기반으로 이미지를 분할한다. 둘째는 엣지 기반 이미지 분할로 이미지 내의 경계선을 검출하여 이미지를 분할한다. 셋째는 영역 기반 이미지 분할로 연속적이고 비슷한 특성을 가진 픽셀의 집합을 영역으로 정의하여 이미지를 분할한다.

시맨틱 분할(Semantic segmentation)은 영역 기반 이미지 분할로 이미지의 각 픽셀을 특정 클래스에 할당하는 과정을 포함한다. 이는 이미지 내에서 같은 종류의 객체를 분류하고 각 객체가 어디에 있는지 동시에 파악하는 방법이다[7]. 시맨틱 분할의 알고리즘에는 여러 가지가 있지만 딥러닝을 이용한 방법이 가장 효과적이며 널리 사용되고 있다.

이중 UNet, SegNet, PSPNet, DeepLab 등이 대표적인 알고리즘이다.

이러한 딥러닝 기반의 이미지 분할 알고리즘 중 하나인 UNet은 적은 양의 훈련 데이터로도 높은 성능을 낼 수 있는 대표적인 방법론으로 적응형 크기의 Convolution과 함께 다운샘플링과 업샘플링 단계를 이용한다[8]. 이는 이미지의 픽셀 단위 정보를 기반으로 고차원 특징을 추출하고 이미지 내의 각 픽셀이 어떤 클래스에 속하는지를 분류한다. 이 과정을 통해 이미지 내의 객체를 픽셀 단위로 정확하게 분리하고 인식할 수 있다.

2.2 객체 이미지 합성

객체 이미지 합성(Object image synthesis)은 여러 이미지를 결합하여 새로운 이미지를 만들거나 완전히 새로운 이미지를 생성하는 프로세스를 의미한다. 이는 객체를 입력 이미지에서 검출하고 새로운 배경에 합성하는 단계로 구성된다[9]. 이러한 합성 방법은 컴퓨터 그래픽스, 인공지능, 머신러닝 등의 분야에서 널리 활용되고 있다. 객체 이미지 합성에는 크게 기하학적 기반 합성과 학습 기반 합성으로 나눌 수 있다. 학습 기반 합성은 딥러닝 기법을 활용하여 대량의 데이터에서 학습을 통해 다양한 스타일과 형태의 합성 이미지를 생성한다. 반면 기하학적 기반 합성은 3D 모델, 텍스처 맵, 렌더링 파라미터 등의 구조적 정보를 활용하여 이미지를 생성하는 방법이다.

알파 블렌딩(Alpha blending)은 객체 이미지 합성에 사용되는 기법 중 기하학적 기반 합성 방법이다. 이는 두 이미지를 자연스럽게 합치는 데 사용되는 기법으로 두 이미지를 합성할 때, 투명도(Alpha) 값을 사용하여 두 이미지의 중첩되는 부분의 색을 결정하는 기술이다[10]. 이미지의 투명도를 조절함으로써 한 이미지를 다른 이미지 위에 자연스럽게 합성하는 데 사용된다. 투명도는 0(완전 투명)에서 1(완전 불투명) 사이의 값을 가지며, 이 값을 사용하여 두 이미지의 픽셀 값 사이에서 가중치를 결정한다. 이후, 결정된 알파 값에 따라 두 이미지의 색상 값을 혼합한다. 알파 값이 높을수록 전경 이미지의 색상이 강조되고 알파 값이 낮을수록 배경 이미지의 색상이 강조된다. 혼합된 색상 값은 최종 이미지의 해당 픽셀에 적용된다. 이 과정을 통해 객체를 배경 이미지에 자연스럽게 합성할 수 있으며 실제와 유사한 다양한 합성 이미지를 생성할 수 있다.

Ⅲ. 콘크리트 구조 이상탐지를 위한 시맨틱 분할 기반의 데이터 증강 기법

3.1 데이터 수집 및 전처리

콘크리트 구조 이상 탐지를 위한 시맨틱 분할 기반의 데이터 증강 기법에서 합성을 하기 위해 결함 이미지와 배경으로 정상적인 콘크리트 정상 표면 이미지를 사용한다. 이를 위해, AI-Hub의 건물 균열 탐지 이미지 데이터를 이용하여 수집을 진행한다[11]. 해당 데이터는 드론과 고화질 카메라를 이용하여 다각도에서 촬영한 콘크리트 균열 데이터이다. 이미지는 직접 촬영 및 기확보된 데이터가 활용되었으며, 이미지에 존재하는 균열의 편차가 심하고 날씨에 의한 이미지 화질이 각기 다르다. 따라서 데이터셋에서 야간에 촬영된 사진과 미세한 균열을 제외하여 선별한 이미지 5,649장을 수집한다. 수집된 이미지는 입력 이미지의 크기를 조절함으로써 작은 이미지 크기는 계산 자원 요구량을 줄이고 더 빠른 학습과 추론을 가능케 하며, 큰 객체와 작은 디테일을 다루기 적합하다. 이러한 이유로 UNet에 사용하기 위한 입력 이미지의 크기를 448×448로 조절한다.

3.2 시맨틱 분할을 이용한 결함 추출

합성에 사용하기 위한 결함 부분을 분할하기 위해 UNet 심층 학습 모델을 사용하여 입력된 이미지 데이터를 픽셀 단위로 분류한다. UNet은 일반적으로 이미지 분할에 주로 사용되며, 구조적으로 인코딩 경로와 디코딩 경로를 포함하고 있다. 인코딩 경로에서는 이미지의 픽셀 정보와 형상 정보를 캡처하며, 디코딩 경로에서는 인코딩에서 얻은 정보를 바탕으로 이미지의 세부적인 픽셀 레이블을 생성한다.

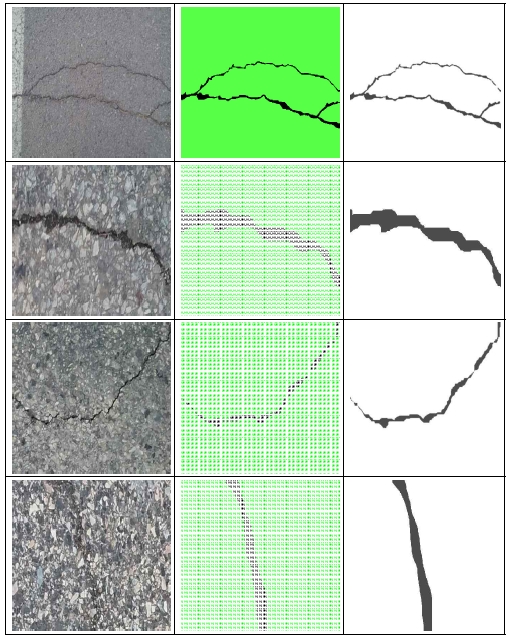

훈련 단계에서 레이블링된 콘크리트 결함 이미지 데이터를 입력받아, 각 픽셀이 결함인지 아닌지를 예측한다. 이를 통해 모델은 이미지 내의 콘크리트 결함 부분과 그렇지 않은 부분을 분류하게 된다. 시맨틱 분할을 통해 얻어진 이미지에서 각 픽셀에 할당된 레이블을 바탕으로 결함 부분을 추출한다. 즉, UNet 알고리즘을 통해 분류된 각 픽셀이 결함인지 아닌지에 따라 이미지를 분리하는 과정을 진행한다. 그림 1은 원본 이미지와 시맨틱 분할 결과, 추출된 결함 이미지를 나타낸다.

그림 1은 원본 이미지로부터 결함을 추출하는 과정을 시각적으로 보여준다. 이 과정에서 우선적으로, 원본 이미지를 입력으로 받아서 시맨틱 분할을 수행하여 이미지 내의 각각의 픽셀이 어떠한 클래스에 속하는지를 결정한다. 본 논문에서 시맨틱 분할된 이미지는 결함 부분과 결함이 아닌 부분이 명확히 구분된 상태로 출력된다.

다음 단계에서는, 시맨틱 분할 이미지에서 결함이 아닌 픽셀들을 제외하여 결함 부분만을 포함하는 새로운 이미지 세트를 생성한다.

이렇게 생성된 이미지 세트는 원본 이미지의 결함 부분만을 집중적으로 보여주며, 결함을 명확하게 인식이 가능하도록 한다.

최종적으로, 추출된 결함 이미지 세트만을 포함하게 되며, 이는 후속 과정에서 배경 이미지에 합성되어 사용된다.

3.3 이미지 좌표를 이용한 무작위 위치 선정

결함이 없는 정상 콘크리트 이미지를 합성의 기본 틀로 설정한다. 이 배경 이미지는 콘크리트 표면의 이상적인 상태를 반영하며, 후속 과정에서 결함을 합성하기 위한 환경을 제공한다. 이후, 배경 이미지 위에 결함 부분을 적절하게 위치시키기 위해 이미지 좌표를 활용한다. 결함 이미지가 배경 이미지의 크기를 초과하여 위치하지 않도록 무작위로 조절하며, 이를 통해 결함 부분이 배경 이미지 내에 위치하도록 한다. 마지막으로, 결함 이미지가 배치될 위치를 무작위로 결정한다. 배경 이미지의 전체 크기와 결함의 크기를 고려하여 가능한 범위 내에서 랜덤하게 위치를 선정한다. 이런 무작위적 배치 방식은 배경과 결함의 여러 조합을 생성하게 해주며 다양한 배치를 통해 학습 데이터의 다양성을 증가시키는 데 중요한 역할을 한다. 식 (1)은 이미지 좌표를 이용한 무작위 합성 위치를 선정하는 식이다.

| (1) |

식 (1)에서 Wb와 Hb는 배경 이미지의 너비와 높이를 나타내며, Wd와 Hd는 결함 이미지의 너비와 높이를 나타낸다. Cx, Cy는 결함 이미지의 중심 좌표를 나타내며, 이는 결함 이미지가 배경 이미지 위에 합성될 위치를 결정하는 데 사용된다. 생성된 Cx, Cy 좌표를 이용하여 결함 이미지를 배경 이미지 위에 놓을 위치를 결정한다. 이를 통해 결함 이미지가 배경 이미지의 경계를 넘어가지 않도록 보장하면서 동시에 결함 이미지를 배경 이미지 내의 무작위 위치에 합성하는 것이 가능하다.

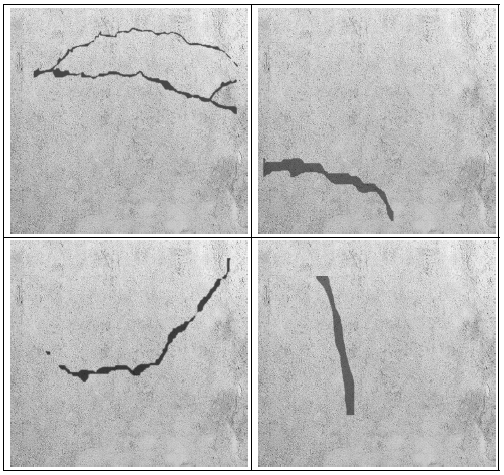

3.4 알파 합성을 이용한 객체와 배경 합성

합성 과정은 생성된 무작위 이미지 좌표를 이용하여 알파 합성을 통해 결함 이미지를 배경 이미지 위에 배치하는 과정으로 이어진다. 알파 합성은 두 이미지를 합칠 때 투명도를 고려하는 기법으로, 이미지가 자연스럽게 겹쳐 록 한다. 결함 이미지의 특정 부분이 배경 이미지와 자연스럽게 합쳐져야 하는 경우, 해당 부분의 알파 채널 값을 조절하여 투명도를 제어할 수 있다. 이를 통해 결함 이미지의 알파 채널을 활용하여 결함 부분이 자연스럽게 배경 이미지 위에 놓일 수 있으며, 결함이 있는 콘크리트 구조물의 이미지가 생성된다. 그림 2는 객체와 배경을 합성한 이미지 결과를 나타낸다.

이후, 합성된 이미지를 저장하고 필요한 이미지 데이터 수만큼 과정을 반복한다. 이렇게 생성된 이미지 데이터셋은 다양한 배경과 결함 조합을 포함하며, 모델이 다양한 상황에 대해 학습을 가능하게 한다.

Ⅳ. 성능 평가

제안한 콘크리트 구조 이상 탐지를 위한 시맨틱 분할 기반의 데이터 증강 기법의 성능 평가를 위해서 본 연구에서는 Dice Score와 Intersection over Union (IoU) Score를 사용한다. Dice Score는 두 데이터 세트의 유사성을 측정하는 통계적 지표로[12], 본 연구에서는 모델이 예측한 분할 영역과 실제 Ground Truth 영역 사이의 유사성을 측정하는 데 사용한다. Dice Score는 0에서 1까지의 값을 가지며, 값이 1에 가까울수록 두 데이터 세트의 일치도가 높음을 의미한다. 다른 성능 지표인 IoU Score는 두 개의 영역이 얼마나 겹치는지를 측정하는 지표로, 객체 검출이나 세분화 작업에서 주로 사용된다[13]. IoU 또한 0에서 1까지의 값을 가지며, 값이 1에 가까울수록 두 영역의 일치도가 높음을 의미한다. 이 두 가지 메트릭은 이미지 분할 작업에서 널리 사용되는 평가 지표들로, 모델의 예측이 실제 Ground Truth와 얼마나 잘 일치하는지를 정량적으로 판단한다. 표 1은 결함 이미지 5,649장을 이용한 UNet과 제안한 방법을 사용하여 11,298장으로 증강한 UNet의 실험 결과이다.

표 1에서와 같이 Baseline과 제안한 기법에서 Dice Score는 0.7177에서 0.8168로 10% 정도 향상된 결과를 보이고 IoU Score는 0.3887에서 0.4493으로 6% 정도 향상된 결과를 보인다.

Ⅴ. 결론 및 향후 과제

이미지 처리 분야에서는 복잡한 비주얼 패턴을 인식하고 분류하는 다양한 딥러닝 모델이 등장했다. 이러한 모델들의 성능 향상은 많은 연구와 실험을 필요로 하지만, 제한된 양과 종류의 데이터셋으로 인해 학습에 제약이 발생하는 한계점에 직면하게 되었다.

본 논문에서는 콘크리트 구조 이상 탐지를 위한 시맨틱 분할 기반의 데이터 증강 기법을 제안하였다. 이 방법은 기존에 겪고 있던 학습 데이터의 한계를 극복하기 위해 만들어졌으며, 이를 통해 다양한 상황에 대해 모델이 학습할 수 있도록 이미지를 증강했다. 제안하는 방법은 원본 콘크리트 이미지와 시맨틱 분할로 추출된 결함 이미지를 무작위로 배치하여 다양한 학습 데이터를 생성하는 방식을 사용하였다. 비교 성능 실험을 통해 제안한 방법이 Dice Score와 IoU Score로 측정된 성능 평가에서 향상된 결과를 보였다. 이를 통해 성능을 효과적으로 높일 수 있음을 보였다.

본 논문에서 제안한 방법을 통해 이미지 처리 분야에서의 딥러닝 모델의 효율성을 높일 수 있다는 점에서 그 중요성을 발견할 수 있다. 또한 다양한 분야에서 데이터 부족 문제에 직면하는 상황에서도 유용하게 적용 가능하다. 그러나 제안하는 방법에서 훈련된 모델이 폐색된 경우와 같이 특정 제약 조건에서 성능이 저하될 수 있는 한계를 찾을 수 있다. 따라서 이러한 한계점을 극복하기 위한 연구를 본 논문의 향후 과제로 한다.

Acknowledgments

본 연구는 산업통상자원부와 한국산업기술진흥원의 “중견기업 DNA 융합산학협력프로젝트”(콘크리트 구조물 인공지능 기반 안전성 평가·관리 시스템 개발)(과제번호 P0024559) 으로 수행된 연구결과 입니다

References

-

H. Yoo and K. Chung, "Deep Learning-based Evolutionary Recommendation Model for heterogeneous Big Data Integration", TIIS, Vol. 14, No. 9, pp. 3730-3744, Sep. 2020.

[https://doi.org/10.3837/tiis.2020.09.009]

-

J.-C. Kim and K. Chung, "Prediction Model of User Physical Activity using Data Characteristics-based Long Short-term Memory Recurrent Neural Networks", TIIS, Vol. 13, No. 4, pp. 2060-2077, Apr. 2019.

[https://doi.org/10.3837/tiis.2019.04.018]

-

Y. K. Han, S. W. Jung, H. J. Kwon, and S. H. Lee, "Pix2pix-based Water Drop Removal Learning using Virtual Data Augmentation", Journal of KIIT, Vol. 20, No. 6, pp. 9-17, Jun. 2022.

[https://doi.org/10.14801/jkiit.2022.20.6.9]

-

J. Yeh, H.-T. Chan, and C.-H. Hsia, "ResNeXt with Cutout for Finger Vein Analysis", In 2021 International Symposium on Intelligent Signal Processing and Communication Systems (ISPACS), Hualien City, Taiwan, pp. 1-2, Nov. 2021.

[https://doi.org/10.1109/ISPACS51563.2021.9650921]

-

Z. Gao and L. Han, "Clothing image classification based on random erasing and residual network", In Journal of Physics: Conference Series, Vol. 1634, No. 1, pp. 1-6, Sep. 2020.

[https://doi.org/10.1088/1742-6596/1634/1/012136]

-

S. Minaee, Y. Boykov, F. Porikli, A. Plaza, N. Kehtarnavaz, and D. Terzopoulos, "Image segmentation using deep learning: A survey", IEEE transactions on pattern analysis and machine intelligence, Vol. 44, No. 7, pp. 3523-3542, Jul. 2022.

[https://doi.org/10.1109/TPAMI.2021.3059968]

-

H. Hu, J. Cui, and L. Wang, "Region-aware contrastive learning for semantic segmentation", In Proceedings of the IEEE/CVF International Conference on Computer Vision, Montreal, QC, Canada, pp. 16291-16301, Oct. 2021.

[https://doi.org/10.1109/ICCV48922.2021.01598]

-

L. Han, H. Liang, H. Chen, W. Zhang, and Y. Ge, "Convective precipitation nowcasting using U-Net Model", IEEE Transactions on Geoscience and Remote Sensing, Vol. 60, pp. 1-8, Aug. 2021.

[https://doi.org/10.1109/TGRS.2021.3100847]

-

F. Zhan, H. Zhu, and S. Lu, "Spatial fusion gan for image synthesis", In Proceedings of the IEEE/CVF conference on computer vision and pattern recognition (CVPR), Long Beach, CA, USA, pp. 3653-3662, Jun. 2019.

[https://doi.org/10.1109/CVPR.2019.00377]

-

L. Zhang, T. Wen, and J. Shi, "Deep image blending", In Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision (WACV), Snowmass, CO, USA, pp. 231-240, Mar. 2020.

[https://doi.org/10.1109/WACV45572.2020.9093632]

- AI-Hub, https://aihub.or.kr, [accessed: May 23, 2023]

-

M. R. Liechti, et al., "Manual prostate cancer segmentation in MRI: interreader agreement and volumetric correlation with transperineal template core needle biopsy", European radiology, Vol. 30, pp. 4806-4815, Apr. 2020.

[https://doi.org/10.1007/s00330-020-06786-w]

-

S. Jia, Y. Song, C. Ma, and X. Yang, "Iou attack: Towards temporally coherent black-box adversarial attack for visual object tracking", In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Nashville, TN, USA, pp. 6709-6718, Jun. 2021.

[https://doi.org/10.1109/CVPR46437.2021.00664]

2020년 3월 ~ 현재 : 경기대학교 컴퓨터공학부 학사과정

관심분야 : 데이터마이닝, 딥러닝, 컴퓨터비전, 인공지능, 빅데이터

2002년 2월 : 단국대학교 토목환경공학과(공학사)

2014년 2월 : 고려대학교 건축사회환경공학부(공학석사)

2015년 9월 ~ 현재 : (주)서영엔지니어링 부장

관심분야 : AI, 빅데이터, BIM, 스마트 건설 엔지니어링

1999년 2월 : 상지대학교 전산학과(이학사)

2011년 8월 : 상지대학교 컴퓨터교육학과(교육학석사)

2019년 8월 : 상지대학교 컴퓨터정보공학과(공학박사)

2020년 7월 ~ 현재 : 경기대학교 콘텐츠융합소프트웨어 연구소 연구교수

관심분야 : 딥러닝, 인공지능, 빅데이터 마이닝

2000년 2월 : 인하대학교 전자계산공학과(공학사)

2002년 2월 : 인하대학교 전자계산공학과(공학석사)

2005년 8월 : 인하대학교 컴퓨터정보공학부(공학박사)

2006년 3월 ~ 2017년 2월 : 상지대학교 컴퓨터정보공학부 교수

2017년 3월 ~ 현재 : 경기대학교 컴퓨터공학부 교수

관심분야 : 데이터 마이닝, 헬스케어, 빅데이터, HCI, 지능시스템, 인공지능, 인공지능, 추천 시스템