시각장애인을 위한 IoT 접목의 음성인식을 이용한 딥 러닝 웨어러블 디바이스

; Byungin Min*

; Byungin Min* ; Dongseob Kim*

; Dongseob Kim* ; Minseong Park*

; Minseong Park* ; Gyuha Hwang*

; Gyuha Hwang* ; YongTae Kim**

; YongTae Kim** ; Jiseung Nam***

; Jiseung Nam***

초록

이 논문은 시각장애인을 위한 IoT 웨어러블 디바이스에 음성인식 기능과 딥러닝 알고리즘의 적용에 관한 연구를 다루고 있다. 이 기술은 시각장애인이 일상생활에서 겪는 어려움 개선을 목표로 한다. 본 논문에서 제안하는 웨어러블 디바이스는 얼굴 인식, 물건(객체) 인식, 글자 인식, 바코드 인식, 지폐 분류 그리고 IoT 월패드 메뉴 인식 기능을 가진다. 우리는 스마트폰 앱과 IoT 웨어러블 디바이스 연동을 통해 해당 기능을 구현하였다. 마이크를 통해 입력된 사용자의 음성 명령은 구글의 음성인식 API를 이용해 인식 및 분석하였고, 카메라를 통해 입력된 이미지는 딥러닝 알고리즘을 통해 분석하였다. 테스트 결과 모든 기능이 90% 이상의 인식률을 보였고, 이러한 기술들은 시각장애인들의 일상생활에 편의를 제공하고 적극적으로 활용될 수 있을 것으로 기대된다.

Abstract

This paper deals with the study of speech recognition and deep learning algorithm apply to IoT wearable devices for people with visual impairment. This technology aims to improve difficulties visually impaired faces in everyday life. The device proposed in this paper has various functions faces recognition, object detection, optical character recognition, barcode recognition, bill classification and IoT wallpad menu recognition. We connect smart phone application and IoT wearable device to implement these functions. Voice commands are analyzed by Google's voice recognition API and anlalyze input images through deep learning algorithm. As a result, We got more than 90% recognition rate from every functions. It is expected that these technologies can provide convenience and actively used in everyday life for visually impaired.

Keywords:

machine learning, deep learning, object detection, IoTⅠ. 서 론

최근 IoT 기술은 사물들과 사람들 간의 상호작용을 더욱 편리하게 만들어주는 기술로 많은 이들에게 편의를 제공하고 있다.

하지만, 동시에 일부 사람들에게는 혜택을 주지 못하는 경우도 있다. 그중에서도 시각장애인들은 IoT 기기의 사용에 불편함과 제한 사항을 경험하고 있으며, 이들을 위한 보조 기술이 필요하다. 이를 위해, 기존의 IoT 기술들을 시각장애인의 사용 환경에 맞도록 개선이 필요하다.

본 논문은 시각장애인들이 일상생활에서 편리하게 사용할 수 있는 음성인식과 딥러닝 알고리즘을 통해 분석 결과를 알려주는 웨어러블 디바이스를 제안한다. 본문에서는 음성 명령 인식에 사용된 음성 인식 기술과 결과 분석에 사용된 딥러닝 알고리즘의 구체적인 구성과 방법, 그리고 사용이 가능한 응용 사례들을 다루었다.

이를 통해, 시각장애인들을 대상으로 하는 보조 기술 개발에 대한 기술적 해결책을 제시하여, 시각장애인들의 삶의 질을 높일 수 있는 IoT 기술 발전에 기여 하고자 한다.

Ⅱ. 인공지능 모델 개발

2.1 월패드 기능 인식 모델

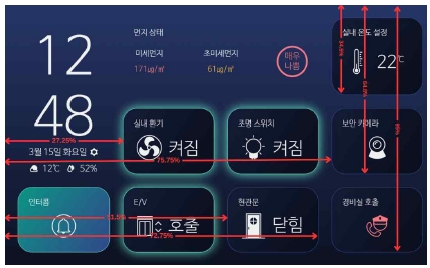

월패드 기능 인식 모델에서는 사용자가 손가락으로 가리킨 기능이 어떤 기능인지를 알려준다. 월패드 기능들의 좌표와 손가락 좌표를 비교하여 기능을 인식하였다. 월패드의 위치 좌표를 구하기 위해 YOLOv5 알고리즘을 이용 하였고, 손가락 좌표를 구하기 위해 Mediapipe hands를 이용하였다.

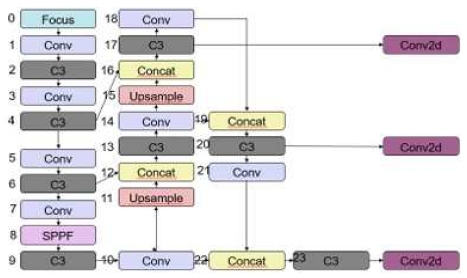

그림 1은 [1]에서 제안된 YOLOv5의 구조이다. YOLOv5는 You Only Look Once의 약자로 처음으로 one-stage-detection 방법을 고안해 실시간으로 Object Detection이 가능한 모델이다. GoogleNet architecture에서 영감을 받았으며 Inception 블록 대신 단순한 컨볼루션으로 구성되어 있다.

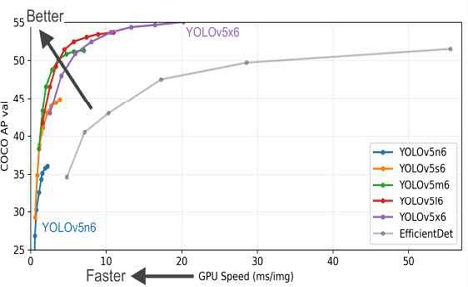

그림 2는 [1]에서 제안된 YOLOv5 알고리즘별 성능을 비교한 그래프이고, YOLOv5 알고리즘의 네트워크의 크기에 따라 v5n, v5s, v5m, v5l, v5x로 나뉘고, 가장 큰모델인 v5x는 네트워크 크기가 커 속도가 느리지만 정확도가 높고, v5n으로 갈수록 정확도가 다소 낮아지는 대신 분석 속도가 증가하는 모습을 보여준다[2].

MediaPipe란 구글에서 제공하는 AI 프레임워크로 비디오형식 데이터를 이용한 다양한 비전 AI 기능으로서 파이프라인 형태로 제공되며 손쉽게 사용할 수 있다.

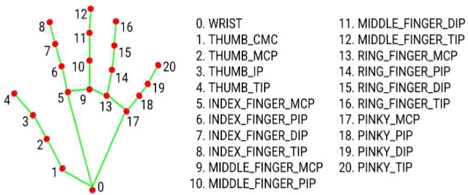

Mediapipe hands란 Mediapipe의 비전 AI 솔루션 중 하나로 전체 이미지에 대해 손을 감지한다. 그림 3은 [3]에서 설명하는 손 랜드마크 모델이다.

손 랜드마크 모델은 2차 분석을 통해 감지된 손 영역 내에서 21개의 3D 손의 좌표에 대한 정확한 키 포인트 위치를 파악할 수 있다. 그림 3은 손의 landmark 좌표들이다. 본 논문에서는 월패드를 가리키는 두 번째 손가락의 끝점의 좌표를 받아와야 하므로 landmark 8번의 좌표를 이용한다.

YOLOv5 모델의 학습 데이터셋은 인식대상 월패드의 영상과 월패드를 가리키는 영상을 여러 각도에서 찍어 10 프레임별로 나누어 이미지로 제작하였다. 라벨링은 월패드의 외각을 최대한 타이트하게 Bounding box로 처리하였으며 하나의 클래스(Tablet)로 라벨링한다.

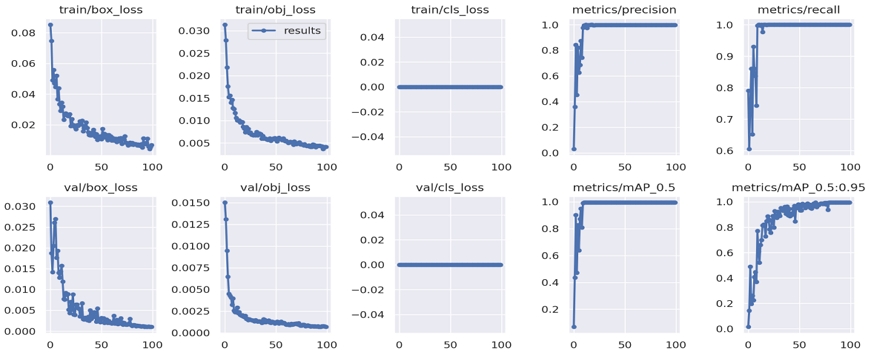

모델 학습 결과 Precision 0.999, Recall 1, mAP50 0.995로 높은 성능으로 완료되었다. 그림 4는 YOLOv5 테스트 결과이다. 태블릿을 가리고 있어도 detection된 Bounding box가 잘 나온 것을 볼 수 있다.

그림 5는 이미지에 따라 월패드의 위치와 크기가 달라지므로 이미지의 월패드의 기능의 좌표를 구하기 위해 전체 이미지에 따른 기능의 위치의 비율을 수치로 구하여 나타낸 것이다.

그림 6는 월패드 기능 인식 테스트 화면이다. 사용자가 월패드의 기능을 가리키고 있는 이미지가 모델에 들어오면 YOLOv5로 월패드의 bounding box의 좌표를 구한다. 그리고 Mediapipe hands로 가리키고 있는 손가락의 끝점 좌표를 구한다.

bounding box의 좌표로 그림 4에 나타낸 기능에 따른 비율로 이미지의 기능의 위치를 좌표로 구한다음 손가락의 끝점 좌표와 비교하여 기능을 나타낸다.

그림 6를 보면 YOLOv5로 태블릿이 0.97의 확률로 detect가 되어 bounding box가 나타나고 손가락도 Mediapipe hands로 감지가 되었으며 좌표 비교를 통해 ‘E/V’라는 기능이 검출된 것을 확인할 수 있다.

그림 7은 월패드 기능 인식 모델에서 다른 학습(Train) 데이터와 검증(Val) 데이터의 손실(Loss) 값과 정밀도(Precision) 그리고 재현율(recall)의 변화를 그래프로 나타낸 것이다. 박스 손실(Box_loss) 값은 학습이 진행되는 동안 우하향으로 진행되고, 정밀도와 재현율은 우상향으로 진행되는 것으로 보아 학습이 정상적으로 진행되고 있음을 보여준다[4].

2.2 지폐 인식 모델

지폐 인식 모델은 앞에서 사용한 YOLOv5 객체 탐지 모델을 기반으로 개발하였으며, 입력된 국내 지폐 4종을 분류하는 것을 목적으로 한다.

초기 단계에서는 지폐 전체를 bounding box로 라벨링하여 학습 데이터를 구축하였으나, 테스트 결과 저조한 분류 성능을 보였다.

결과 분석을 통해 학습한 이미지의 주변 배경 영향으로 인해 부정확한 결과가 도출되는 것을 확인할 수 있었다[5].

이를 개선하기 위해, 이미지의 특징이 되는 부분만 라벨링 해 구축한 학습 데이터로 학습한 모델의 분류 성능이 98%의 높은 정확도를 달성한 것을 사례를 통해 확인할 수 있었고, 해당 방법을 이용해 다시 라벨링을 진행하고 학습 데이터를 구축하였다[6].

학습 모델은 위에 제시한 YOLOv5를 이용해 진행하며, 지폐의 특징적인 부분을 라벨링한 이미지 2,720개를 학습 데이터로 이용한다. 그림 8은 지폐 이미지를 라벨링 한 예시이다.

Learning rate는 0.01, 이미지 크기는 640x640, 배치 크기는 32, optimizer는 SGD, epoch는 100번으로 학습한다. 테스트 데이터셋은 1,200만 화소의 3D Depth 카메라로 다양한 배경에서 촬영한 4종류의 지폐 이미지 297장을 이용해 구성한다.

이미지 데이터를 YOLOv5에서 제공하는 Data augmentation의 색조 조절 기능을 이용하여, 파라미터를 적정한 수준으로 설정 후(hsv_h:0.015, hsv_s:0.7, hsv_v:0.4) 학습한 결과 평균 98% 이상의 정확도를 확인할 수 있었다. 표 1은 지폐 분류 모델의 분류 성능 테스트 결과이다.

2.3 얼굴인식

본 연구의 얼굴 인식 구현을 위해서 CNN모델(MobileNetV3, VGGNet-16), Eigen, Fisher FaceRecognizer 알고리즘, Dlib Face Recognition 모듈을 비교 테스트 하였으며 가장 성능이 좋고 속도가 빠른 Dlib Face Recognition 모듈을 사용했다.

MobileNetV3, VGG16와 같은 CNN모델은 ConvNet 아키텍처의 깊이 측면을 다룬 모델로서 분류 및 현지화 작업에 특화된 모델이다.[7]. 사전학습된 CNN모델 MobileNetV3, VGG16 을 커스텀 얼굴 데이터(4 class)셋을 각각 train(200장), valid (40장)을 통해 학습시켰으나 60%의 정확도도 나오지 않았다.

CNN 모델은 자체 얼굴 이미지뿐만 아니라 얼굴 주변의 배경과 안경 등 외적인 요소에 영향을 많이 받아 정확도가 떨어져서 적합하지 않다고 판단했다.

Eigen, Fisher FaceRecognizer 알고리즘은 먼저 이미지에서 얼굴 부분만을 따로 인식해 주어야 해서 haarcascade 얼굴 검출을 이용했다. 그림 9은 Haar 필터 예시이다. Haar 필터를 거처 추출한 특징값을 바탕으로 이미지를 분류한다.

픽셀을 직접 사용하지 않고 특징값을 사용하는 이유는 특징값이 이미지 픽셀을 인코딩하는 역할이고, 특징값 기반 검출 시스템이 픽셀 기반 시스템보다 훨씬 빠른 점이 있다[8]. 또한, Eigenfaces 알고리즘은 여러 장의 학습데이터를 요구하며, 이미지를 그레이스케일 처리 후 단일벡터를 형성해 고유면을 통해 얼굴을 분별한다[9].

모델은 각 4명의 클래스 당 200장의 이미지로 학습하였으며 인식이 잘 되지 않은 얼굴은 추가데이터를 수집해 학습하여 정확도를 높였다. Eigen FaceRecognizer는 정확도는 94.26%로 나오나 모델의 용량이 2.43 GB이고 추론시간이 19초나 걸렸다.

Fisher FaceRecognizer는 모델용량이 11.6MB이고 추론시간이 0.1초로 Eigen FaceRecognizer보다 빠르나 정확도가 82:00% 밖에 나오지 않았다.

결과적으로 Eigen은 높은 정확도에 비해 모델의 용량이 너무 커서 활용성이 떨어지고, Fisher는 작은 용량과 빠른 추론 시간에 비해 정확도가 낮아서 두 개의 알고리즘은 적절하지 않다고 판단했다.

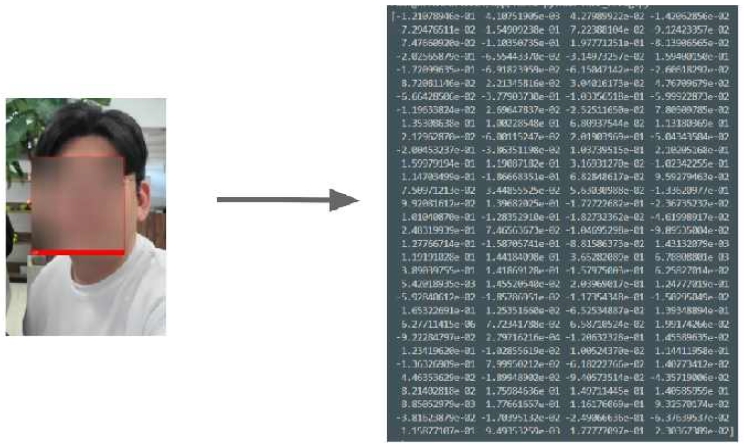

Dlib Face Recognition은 ResNet-34 기반으로 구축된 dlib의 얼굴인식 기술로서 그중에 Face_recognition은 Labeled Faces in the Wild 벤치마크에서 99.38%의 정확도를 보였으며 실시간 카메라 디텍딩도 가능한 모듈이다. 특징으로는 얼굴 이미지에서 128개의 임베딩을 구성하여 얼굴을 정량화한다[10].

테스트한 이미지의 개수는 총 4장(4명)이며 얼굴을 인식하고자 하는 각 사람의 사진 한 장을 폴더에 저장한다. 테스트의 이미지의 이름은 사진 속의 사람의 이름과 동일하게 지정한다.

다음으로 식별하고 싶은 이미지 파일을 넣으면 얼굴인식을 할 수 있다. 그림 10은 식별하고자 하는 얼굴의 128개 인코딩 값을 확인한 것이다. 추출된 128개의 벡터값을 통해 유클리디안 계산 식 (1)으로 폴더에 저장된 얼굴과의 거리가 가장 가까운 얼굴을 동일 인물로 판별한다.

| (1) |

얼굴인식 모듈의 평가는 각 클래스 인물마다 30초 영상을 프레임별로 나누어 프레임별 얼굴이 동일 인물로 판별되는지 확인했다. 평균 160프레임의 이미지 전부 평균 99% 확률로 얼굴인식이 되는 것을 표 2에서 확인할 수 있다.

Ⅲ. 웨어러블 디바이스 HW/SW 개발

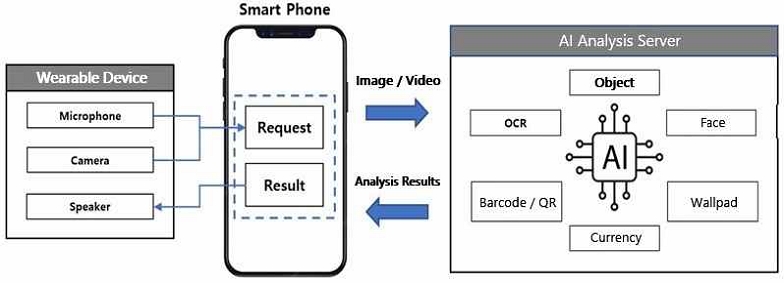

본 논문에서 제안하는 웨어러블 디바이스는 시각장애인이 착용해 사용하는 디바이스이다. 웨어러블 디바이스에 장착된 카메라를 이용해 정면의 화면을 촬영하고, 마이크를 이용해 음성 데이터 인식한다. 웨어러블 디바이스 사양은 표 3에서 확인할 수 있다.

웨어러블 디바이스의 듣기, 말하기 기능을 사용하기 위해 스마트폰 앱과 Bluetooth Pairing을 진행하고, 이미지 촬영 기능을 사용하기 위해 카메라와 스마트폰 앱을 Hotspot으로 연결한다. 웨어러블 디바이스에는 2개의 버튼을 부착했으며, 그림 11과 같다. 왼쪽 버튼은 Bluetooth Pairing 시작, 오른쪽 버튼은 화면 촬영 시작이다.

웨어러블 디바이스는 연결 후 양방향의 송신 및 수신처리가 필요하기 때문에 TCP Socket 통신의 처리를 진행했다. 웨어러블 디바이스는 슬레이브 연결이 들어올 때까지 RestMode로 동작한다. 슬레이브 연결 후, 웨어러블 디바이스의 버튼을 누르거나 애플리케이션에 요청하면 화면 촬영 결과를 애플리케이션에 제공한다.

Ⅳ. 웨어러블 디바이스 연동 앱 개발

웨어러블 디바이스 연동앱은 ‘Talk&Go’로, 웨어러블 디바이스의 이미지, 영상 및 사용자의 음성 데이터를 웨어러블 디바이스로부터 수신하고 딥러닝 알고리즘 분석 결과를 다시 웨어러블 디바이스로 전송하는 중계 서비스 앱이다.

UI, 기기 연결 기능, 센서의 활동 상태 확인 기능, 웨어러블 디바이스와 인공지능 서버의 데이터 송신 / 수신 기능이 있으며(그림 12, 13 참고) 사용자는 앱을 통해 Bluetooth 통신과 Hotspot 연결을 진행하고, 현재 센서의 활동 상태를 확인할 수 있다(그림 13(a)).

애플리케이션 OS의 언어를 English로 변경하면 앱이 영문자로 변경된다(그림 13(b)).

블루투스 검색 활성화 아이콘을 누르면 주변 블루투스 디바이스 검색, 페어링, 연결, 해제 기능 화면으로 이동한다(그림 13(c)).

Talk&Go 앱에서 웨어러블 디바이스를 통해 수신한 사용자의 음성 데이터를 문자로 변환해 준다. 테스트 결과 출력된 문자의 정확도는 90% 이상의 인식률을 보였다.

Ⅴ. 결론 및 향후 과제

이 논문에서 제안하는 웨어러블 장치와 연동된 애플리케이션의 음성인식 기술은 시각장애인들이 겪는 일상생활에서의 어려움을 개선하기 위한 기술로, 구글의 음성인식 API를 이용한 딥러닝 알고리즘을 통해 대상을 분석하여 90% 이상의 인식률을 보였다. 이러한 기술들은 시각장애인들이 일상생활에서 접하는 인물, 지폐, 객체, 바코드, 글자, IoT 장치와 연동한 월패드를 적극적으로 활용할 수 있을 것이다. 본 연구에서 사용된 딥 러닝 모델이 어느 정도의 정확도를 보이긴 하지만, 여전히 개선할 여지가 있습니다. 따라서 향후 연구에서는 더 나은 성능을 보이는 딥 러닝 모델을 개발해 시각 장애인들이 보다 정확하고 신뢰성 있는 서비스를 제공하도록 개선할 예정이다.

Acknowledgments

이 논문은 2022년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구임(No.2022-0-00178, 시각장애인 IoT 접근성 환경을 해소한 음성인식 기반의 AI 웨어러블 디바이스개발)

References

-

G. Jocher, et al., "ultralytics/yolov5: v7.0 - YOLOv5 SOTA Realtime Instance Segmentation", Zenodo, Nov. 2022.

[https://doi.org/10.5281/zenodo.3908559]

-

J. M. Gang, "A Study on Wildlife Detection and Classification Model Using YOLOv5", Journal of Korean Institute of Information Technology, Vol. 20, No. 10, pp. 21-27, Oct. 2022.

[https://doi.org/10.14801/jkiit.2022.20.10.21]

- Mediapipe, "Hand landmarks detection guide", https://developers.google.com/mediapipe/solutions/vision/hand_landmarker, [accessed: Apr. 3, 2023]

-

J. K. Heo, "Implementation of Wheatgrass Mildew Detection Service using Artificial neural network YOLOv5 Algorithm", Journal of the Korean Society of Information Technology, Vol. 20, No. 11, pp. 57-64, Nov. 2022.

[https://doi.org/10.14801/jkiit.2022.20.11.57]

-

J. Ha, K. Park, M. Kim, "A Development of Road Crack Detection System Using Deep Learning-based Segmentation and Object Detection", Vol. 26, No. 1, pp. 93-106, Feb. 2021.

[https://doi.org/10.7838/jsebs.2021.26.1.093]

-

G. A. R. Sanchez, "A Computer Vision-Based Banknote Recognition System for the Blind with an Accuracy of 98% on Smartphone Videos", Journal of The Korea Society of Computer and Information, Vol. 24, No. 6, pp. 67-72, Jun. 2019.

[https://doi.org/10.9708/jksci.2019.24.06.067]

-

K. Simonyan and A. Zisserman, "Very Deep Convolutional Networks For Large-Scale Image Recognition", arXiv:1409.1556, , Sep. 2014.

[https://doi.org/10.48550/arXiv.1409.1556]

-

P. Viola and M. Jones, "Rapid Object Detection using a Boosted Cascade of Simple Features", Proceedings of the 2001 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. CVPR 2001, Kauai, HI, USA, Dec. 2001.

[https://doi.org/10.1109/CVPR.2001.990517]

-

L. Sirovich and M. Kirby, "Low-dimensional procedure for the characterization of human faces", Division of Applied Mathemetics, Brown University, Vol. 4, No. 3, pp. 519-524, 1987.

[https://doi.org/10.1364/JOSAA.4.000519]

- Pyimageserch, "Face recognition with OpenCV, Python, and deep learning", https://pyimagesearch.com/2018/06/18/face-recognition-with-opencv-python-and-deep-learning, [accessed: Apr. 3, 2023]

2015년 8월 : 전남대학교(공학석사)

2011년 2월 ~ 현재 : ㈜아이엠알 수석연구원

관심분야 : IoT, AI, Bigdata, IoT Device, AIoT, Edge

2016년 8월 : 전남대학교(공학석사)

2010년 1월 ~ 현재 : ㈜아이엠알 대표이사

관심분야 : IoT, AI, Bigdata, IoT Device, AIoT, Edge

2009년 8월 : 전남대학교(공학석사)

2019년 1월 ~ 현재 : ㈜아이엠알 수석연구원

관심분야 : IoT, AI, Bigdata, IoT Device

2017년 2월 : 조선대학교 (공학사)

2020년 9월 ~ 현재 : ㈜아이엠알 선임연구원

관심분야 : IoT, AI, Bigdata, IoT Device

2019년 2월 : 성균관대학교(공학사)

2019년 12월 ~ 현재 : ㈜아이엠알 선임연구원

관심분야 : AI, Bigdata, AIoT, Edge

2021년 2월 : 전남대학교(공학사)

2021년 3월 ~ 현재 : ㈜아이엠알 선임연구원

관심분야 : AI, Bigdata, AIoT, Edge

2000년 2월 : 건국대학교(학사)

2017년 3월 ~ 현재 : (주)엠브이아이 대표이사

관심분야 : 시각장애인 자립생활, 시각장애인 웨어러블 디바이스

1986년 : University of Alabama 대학원(공학석사)

1992년 : University of Arizona 대학원(공학박사)

1992년 ~ 1995년 : 한국전자통신연구소, 컴퓨터통신연구실 선임연구원

1993년 ~ 1993년 : 한국과학기술원 전자공학과 대우교수

1999년 ~ 2001년 : 전남대 정보통신특성화추진센터 소장

2008년 ~ 2018년 : 전남대학교 중소기업산학협력센터 소장

1995년 ~ 현재 : 전남대학교 공과대학 컴퓨터공학과 교수

관심분야 :컴퓨터 네트워크, 통신 프로토콜, 병렬처리 스트림서버