드론의 고도와 쓰레기 인식률에 관한 연구

초록

이 논문에서는 드론의 고도와 쓰레기 인식률의 관계성에 대하여 기술한다. 전 세계적으로 쓰레기 문제에 대한 관심이 매우 고조되고 있다. 이러한 쓰레기 문제를 해결하기 위한 가장 기초 단계는 정확한 쓰레기 정보의 수집이다. 이를 위해 드론과 영상 인식 기술을 이용한 연구가 진행되어 왔다. 그러나 영상 데이터는 드론의 고도에 따라 인식률이 달라진다. 따라서 이 논문에서는 정확한 쓰레기 영상 획득을 위해 고도와 인식률의 관계에 대한 연구를 수행한다. 주요 쓰레기를 선정하고 고도에 따른 쓰레기 인식률에 대한 실험을 수행한다. 이를 통해 정확한 영상 데이터를 수집할 수 있는 최적 고도 정보를 산출한다. 이 논문의 결과는 드론을 이용하여 최상의 영상 데이터를 수집하기 위한 다양한 분야에 적용될 수 있다.

Abstract

This paper describes the relationship between the altitude of drones and the trash recognition rate. There is a growing interest in the problem of trash in all over the world. The most basic step to resolve this trash issue is to collect accurate trash information. To resolve the problem, research has been conducted using drones and image recognition technology. However, the recognition rate of image data varies depending on the altitude of the drone. Therefore, this paper conducts the relationship between altitude and recognition rate to obtain accurate trash images. Major trash is selected and an experiment is performed on the trash recognition rate according to the altitude. Through this research, the optimal altitude is produced the optimal altitude information for collecting more accurate image data. The results of this paper can be applied to various fields to collect the best image data using drones.

Keywords:

drone, optimal altitude, trash, image recognitionⅠ. 서 론

전 세계적으로 쓰레기 문제에 대한 관심이 매우 고조되고 있다. 산업이 급속도로 발전하면서 그에 따른 부수적인 결과로 쓰레기의 발생량도 기하급수적으로 증가하고 있다. 이에 따라 우리나라도 쓰레기 문제에 주목하고 있으며 쓰레기 문제를 해결하기 위한 활동들을 점진적으로 확대해 나가고 있다.

쓰레기 문제를 해결하는 방법은 크게 쓰레기 발생을 줄이는 방법과 발생된 쓰레기를 제거하는 것이다. 발생한 쓰레기를 제거하기 위한 국내의 대표적인 활동 중 하나로서, 해양수산부에서 진행하는 해안 쓰레기 모니터링 사업을 예로 들 수 있다[1]. 이 사업은 민간단체를 통해 쓰레기의 분포를 파악하고 제거하는 사업을 진행하고 있다. 그러나 조사 결과는 사람이 직접 조사하기 때문에 쓰레기의 대략적인 수치만 산출하게 되어 가장 기초 단계인 정확한 쓰레기 정보의 수집에 한계점을 지닌다.

상기 예에서 언급하였듯이, 발생된 쓰레기를 제거하기 위해서는 정확한 쓰레기 분포를 확인하여야 한다. 이를 위해 최근 무인기를 이용한 쓰레기 분포에 대한 연구가 진행되고 있으며, 특히 드론과 영상 인식 기술을 이용한 연구가 활발하게 진행되고 있다[2-11]. 그러나 드론은 고도에 의존적으로 인식률이 달라지는 문제점이 발생한다. 즉, 드론으로 촬영한 영상 데이터는 고도가 높아짐에 따라 객체의 크기가 작아지고, 고도가 낮아짐에 따라 영상 데이터가 손실되는 상황이 발생한다.

따라서 이 논문에서는 정확한 쓰레기 영상 획득을 위한 고도와 인식률의 관계를 연구하고 최적의 고도를 산출할 수 있는 방안을 제안한다. 이를 위해, 대표적인 쓰레기 유형을 선정하고 학습 연산을 수행한다. 학습 연산 후 다양한 고도별로 획득된 다양한 쓰레기 영상을 이용하여 쓰레기 인식률에 대한 실험을 수행한다. 실험을 통해 정확도가 개선된 쓰레기 영상을 획득할 수 있는 최적의 고도를 산출한다.

이 논문의 구성은 다음과 같다. 제2장에서는 관련 연구를 소개 및 문제점을 분석한다. 제3장에서는 제안한 연구를 하기 위한 시스템의 구조와 프로세스 흐름에 관해서 기술한다. 제4장에서는 제안한 연구 방안을 구현한 내용을 기술하고 제5장에서는 실험 및 평가에 관해 서술한다. 마지막으로, 제6장에서는 결론 및 향후 연구에 관하여 서술한다.

Ⅱ. 관련 연구

이 장에서는 드론 기반 객체 분류와 쓰레기 분류로 구분하여 본 논문과 밀접하게 관련된 연구의 특징과 주요 문제점을 정의한다. 또한, 정확한 쓰레기 영상 획득에 대한 연구의 필요성을 제시한다.

2.1 드론 기반 객체 분류

[3]은 드론과 딥러닝 알고리즘을 이용한 실시간 해안 쓰레기 모니터링 시스템을 제안한다. 시스템은 자유롭게 원하는 시간과 장소에서 데이터를 취득할 수 있는 드론을 구현하였고, 딥러닝 알고리즘은 객체를 식별하고 그 객체의 영역을 동시에 탐지할 수 있는 Mask R-CNN과 영역 분할에 사용되는 SegNet을 이용한다. 하지만 이 연구에서는 취득한 드론으로 촬영된 영상은 일정한 높이에서 촬영하여 고도에 따른 손실되는 데이터가 생기는 문제점을 지닌다.

[5]는 재난재해 분야 드론 자료 활용을 위한 준 실시간 드론 영상 전처리 시스템 구축에 관한 연구를 수행한다. 드론 영상의 전처리 방법은 드론에서 관측하는 영상을 실시간으로 수신하여 빠르게 실제 지리 정보를 입력하여, 드론 영상 1장 당 30초 이내의 처리 시간을 가지는 연구의 목표에 달성한다. 하지만 이 연구에서의 결과는 드론의 영상이 정확해야만 전처리를 할 수 있다는 한계점을 지닌다.

[6]은 드론을 기반으로 한 보행자 길 안내 시스템을 제안한다. 앱을 제작하고 드론과 연동시켜 길 안내 기능을 구현하였다. 그러나 이 연구에서는 고도에 따라 다른 보행자들의 안전상의 문제와 안내를 받는 방문객을 시야에서 놓치지 않는 최적의 고도를 도출하는 문제점을 지닌다.

[8]에서는 Zooniverse에서 진행하는 The Plastic Tide Project이다. 이 프로젝트는 시민들이 제공한 항공 데이터를 기반으로 Convolution Neural Network(CNN) 합성곱 신경망 기계학습 알고리즘을 이용하여 플라스틱을 감지하는 연구를 수행한다. 하지만 이 프로젝트에서는 시민들이 흔들리거나 영상의 일부분이 손실된 정확하지 않은 영상 데이터를 제공하여 25%라는 낮은 인식률을 보이는 문제점을 지닌다.

[10]은 무인 항공기를 이용하여 해안 쓰레기의 이미지를 획득하고 쓰레기의 양과 상태를 추정할 수 있는 대량의 이미지 자동 처리 시스템을 개발한다. 하지만 이 연구에서 기계 학습의 테스트 셋으로 사용되는 획득된 이미지는 오버랩이 상당하며, 일부 물체가 두 번 나타나는 문제점을 지닌다.

[11]은 드론으로 수집한 데이터를 컬러 필터 및 CNN를 이용하여 작물의 이상을 식별하는 연구를 진행한다. 그러나 이 연구에서는 비행의 고도로 인한 작물의 잎에 대한 세부 상태가 손실되어 잎의 세부 정보를 추출하는 데 문제점을 지닌다.

2.2 쓰레기 분류

[12]은 쓰레기 분리수거 장치를 제안한다. 시스템은 1차적으로 금속 근접 센서를 이용하여 금속 물질과 비금속 물질을 분류한다. 분류된 비금속 물질은 소리 감지 센서를 이용하여 유리병과 플라스틱을 분류한다. 하지만 시스템은 센서를 이용하여 쓰레기를 분류하기 때문에 쓰레기를 하나씩 투입해야 한다. 또한, 센서를 이용하기 때문에 쓰레기 종류의 다양성이 부족하다는 문제점이 발생한다.

[13]은 쓰레기 이미지를 영상처리기법을 이용하여 유리, 종이, 금속, 플라스틱, 판지, 일반 쓰레기로 분류하는 시스템을 제안한다. 딥러닝 알고리즘은 SVM과 CNN을 사용하여 쓰레기를 분류한다. 연구 결과로는 SVM이 CNN보다 더 높은 정확도를 보였다. 그러나 이 연구는 단일 객체에 대한 분류만 진행하였기 때문에 하나로 뭉쳐있는 쓰레기에서는 정확도가 낮은 문제점이 발생한다.

[14]는 Faster R-CNN을 활용하여 뒤섞여 있는 쓰레기를 여러 종류로 분류시키는 연구를 제안한다. 종류는 종이, 일반 쓰레기, 재활용 쓰레기로 나누어 분류한다. 하지만 이 연구에서는 쓰레기의 종류는 3가지로 분류하는 문제점이 있다.

초기의 쓰레기 분류 방법은 센서를 통하여 진행되었고, 현재는 더 나아가 영상처리기법을 적용하여 쓰레기를 분류하는 연구가 진행되고 있다. 하지만 쓰레기 수거의 기초 단계인 정확한 쓰레기 수집 방안에 대한 연구는 이루어지고 있지 않은 문제점이 있다.

Ⅲ. 시스템 구조 및 데이터 수집 프로세스

이 장에서는 제안된 연구를 수행하기 위한 전체적인 시스템 구조 및 드론의 데이터 수집 프로세스를 기술한다.

3.1 제안 시스템 구성

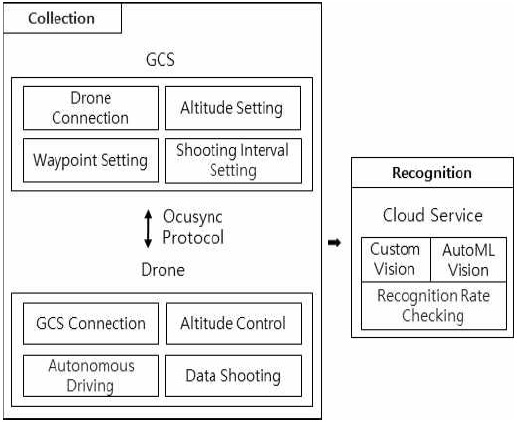

그림 1은 제안 시스템의 구성도를 보여준다. 시스템은 크게 수집 활동 부분과 인식 활동 부분으로 나뉜다.

수집 활동 부분은 세부적으로 GCS(Ground control system, 지상 관제시스템) 영역과 Drone 영역으로 나뉘게 되며, 두 영역은 Drone Connection 모듈과 GCS Connection 모듈을 통해 Ocusync Protocol로 통신한다. GCS 영역은 드론을 제어하는 역할을 한다. Altitude Setting 모듈은 드론의 고도를 설정하는 역할을 수행하고 Waypoint Setting 모듈은 드론의 자율비행 경로를 설정하는 역할을 수행한다. Shooting Interval Setting 모듈은 드론의 자율비행 시 데이터 수집 간격을 설정하는 역할을 수행한다.

Drone 영역은 GCS에서 전달받은 값을 통해 데이터를 수집하는 역할을 한다. 드론은 DJI Phantom 4 Pro V2.0의 하드웨어를 사용하고 연구에 필요한 촬영은 드론에 기본적으로 부착된 카메라를 사용한다. 카메라는 1인치 20MP의 센서가 탑재되어 있으며, 물리적인 기계식 셔터를 이용하여 빠른 비행 속도에서 촬영되는 이미지 왜곡 현상을 최소화한다. 카메라의 해상도는 4:3의 비율로 촬영된다. Altitude Control 모듈은 드론의 고도를 제어하는 임무를 수행하고, Automous Driving 모듈은 GCS에서 전달받은 웨이포인트 경로에 따라 자율비행 기능을 수행한다. 또한, Data Shooting 모듈은 수집 간격에 따라 데이터 촬영 기능을 수행한다.

인식 활동 부분은 데이터 학습 및 분석 기능을 수행하기 위해 클라우드 서비스를 탑재한다. 기계학습 분야에는 AWS의 Amazon Rekognition, Microsoft의 Cumstom Vision, Google의 AutoML Vision, IBM의 Visual Recognition 등이 널리 사용되고 있다. 그 중, Custom Vision과 AutoML Vision은 비교적 저렴한 가격으로 이용할 수 있고 사용자가 원하는 라벨을 지정하여 적은 양의 데이터로 빠르게 모델을 생성하고 데이터를 예측할 수 있다[15]. 특히, Visual Recognition은 자동으로 라벨을 지정하기 때문에 이미지와 맞지 않은 라벨이 지정되었을 경우 인식률이 저하되는 문제점을 지닌다. 따라서 이 논문에서는 비용 및 인식률을 고려하여 Custom Vision과 AutoML Vision을 이용한다.

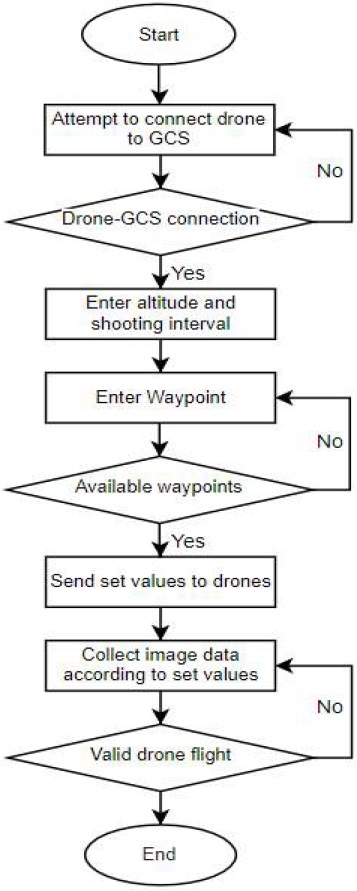

3.2 드론의 데이터 수집 프로세스

그림 2는 데이터를 수집하기 위한 드론의 비행 프로세스를 보여준다. 사용자는 드론의 고도를 설정하기 위해 드론과 GCS의 연결을 시도한다. GCS는 연결 여부를 확인하여 연결이 이루어지면 고도와 데이터 수집 간격을 입력한다. 다음으로는 드론의 비행 경로를 설정하기 위한 웨이포인트를 입력한다. 웨이포인트는 각 점의 거리가 가깝거나 먼 경우에 유효하지 않은 웨이포인트로 인식되어 범위 내로 재입력을 받는다. 웨이포인트가 설정되면 입력한 값을 드론에 전송하여 값에 맞게 데이터를 수집한다.

마지막으로, 웨이포인트의 끝점과 드론의 현재 위치가 일치하면 프로세스는 종료된다.

Ⅳ. 구 현

이 장에서는 제안 시스템의 프로토타입 구현 결과를 기술한다. 구현 환경, 제작된 GCS 앱 화면, 학습 모델 구축 및 수집된 데이터의 인식 화면 등을 보인다.

4.1 구현 환경

이 논문의 구현 환경은 표 1과 같다. 데이터 수집을 위한 GCS와 실험에 사용되는 클라우드 서비스는 Windows 10 Pro 운영체제를 사용하고, GCS를 개발한 언어는 Java이다. 데이터 수집 시 사용한 Mobile OS는 Android 9.0 환경이다. 드론은 DJI Phantom 4 Pro V2.0을 사용한다.

4.2 구현된 GCS 앱

그림 3은 GCS 실행 시 초기 화면을 보여준다. 초기 화면을 통해 드론이 촬영하는 화면을 확인한다. TAKE_OFF 버튼은 드론이 공중으로 떠오르는 역할을 수행하고, LAND 버튼은 드론이 지상으로 착지하는 역할을 수행한다. MAP 버튼은 지도상에서 드론은 제어할 수 있는 화면으로 전환하는 역할을 수행한다.

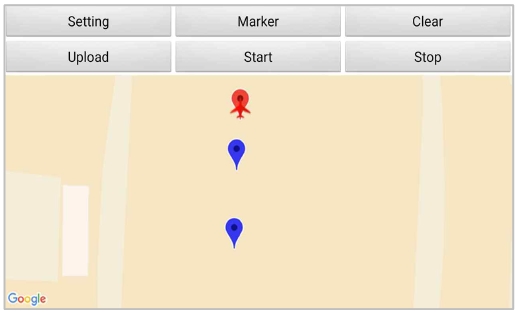

그림 4는 드론의 비행 기능을 제어하는 화면을 보여준다. Setting 버튼은 드론의 고도를 입력받는 다이얼로그 창을, Marker 버튼은 드론의 웨이포인트를 입력받는 다이얼로그 창을 띄워주는 역할을 한다. 웨이포인트가 설정되면 드론의 자율비행 경로를 파란색 마커를 통해 표시된다. Clear 버튼은 드론의 주행 경로를 초기화하는 역할을 수행하고, Upload 버튼은 속도 및 비행 경로를 드론에 전송하는 역할을 수행한다. Start 버튼은 설정한 값에 맞게 드론을 비행하는 역할을 수행하고, Stop 버튼은 비행 중인 드론을 중지시키는 역할을 수행한다.

그림 5는 드론의 고도와 속도를 설정하는 화면을 보여준다. 그림에서 사용자는 Altitude 필드에 원하는 고도 정보를 입력한다. 이 논문에서는 고도를 3m~10m로 제한하여 실험을 수행한다. 최저 고도는 사람의 키를 고려하여 3m로 설정하며, 최고 고도는 드론에 장착된 카메라의 성능을 고려하여 쓰레기의 형태를 식별할 수 있는 10m로 제한한다.

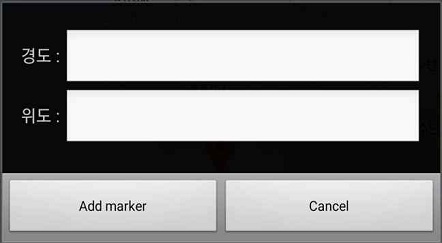

그림 6은 드론의 비행 경로를 설정하는 화면을 보여준다. 비행 경로는 웨이포인트를 통해 결정된다. 웨이포인트는 두 개 이상의 경도와 위도를 입력을 받아 설정된다. 웨이포인트는 거리가 가깝거나 지나치게 먼 경우에는 유효하지 않은 웨이포인트로 인식된다. 따라서, 이러한 점을 고려하여 웨이포인트를 설정한다.

4.3 쓰레기 인식을 위한 학습 모델 구축

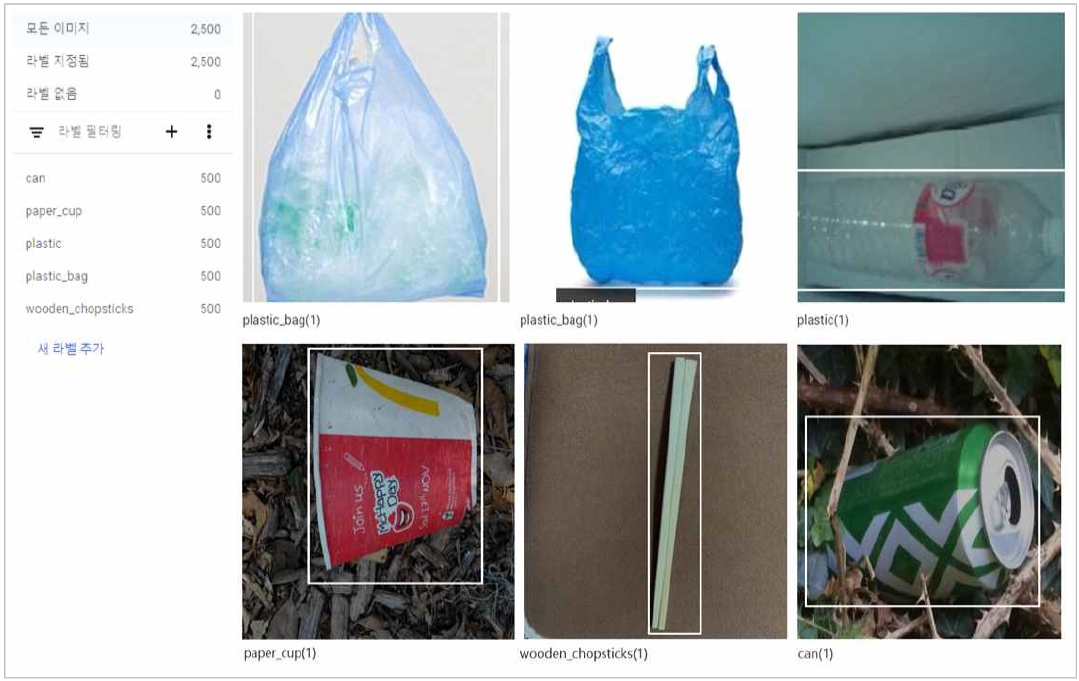

이 논문의 주제인 드론 고도에 따른 쓰레기 인식률을 평가하기 위하여 학습 모델 구축이 요구된다. 이 논문에서는 Microsoft의 Custom Vision과 Google의 AutoML Vision을 사용하여 쓰레기의 인식률을 확인한다. 모델 학습을 위한 라벨은 [16]에서 정의하고 있는 쓰레기 유형 분류를 참조하여 대표적인 5가지를 선정한다. 다시 말해, 합성 수지류에는 비닐봉지와 음료수병, 금속캔에는 음료수 캔, 종이류에는 종이컵, 일반쓰레기에는 나무젓가락으로 총 5가지를 선정하여 라벨링을 수행한다. 학습데이터는 그림 7과 같이 라벨 당 500개의 학습데이터로 모델을 구축하며, 총 2,500개의 학습데이터를 사용한다.

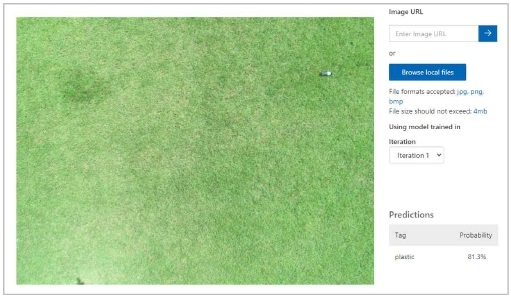

그림 8은 Custom Vision을 이용하여 쓰레기를 인식한 예를 보여준다. Custom Vision은 이미지에 라벨을 부여하여 적은 양의 데이터로 빠르게 모델을 구축하는 특징이 있다.

그림 9는 AutoML Vision을 이용한 쓰레기를 인식한 결과를 보여준다. AutoML Vision은 Custom Vision과 마찬가지로 적은 양의 데이터로 모델을 구축한다. 하지만 AutoML Vision은 물체의 경계를 지정하고 라벨을 부여하여 모델을 구축한다는 차이점이 있다.

Ⅴ. 실험 및 평가

이 장에서는 제안한 연구의 실험 환경 및 실험 결과에 대한 평가에 관하여 기술한다.

5.1 실험 환경 및 실험 요인

실험 장소를 선정하기 위해 [17]의 무인 비행 장치 안전관리 가이드에 따라 비행 금지 구역과 제한 구역을 파악하여 실험 장소는 비행 금지 구역과 제한 구역에 포함되지 않는 학교 내 운동장에서 진행하였다. 운동장은 제한된 공간이 아닌 열린 공간이므로 외부적인 잡음 요소는 고려하지 않는다. 실험 요인은 3가지로 구분된다. 첫째, 쓰레기의 종류로 비닐봉지, 음료수 병, 음료수 캔, 나무젓가락, 종이컵으로 총 5가지로 진행하였다. 둘째, 고도는 3m부터 10m까지 1m 간격으로 총 8가지이다. 셋째, 클라우드 서비스의 종류로 Custom Vision과 AutoML Vision으로 총 2가지이다. 따라서 실험 결과 개수는 총 80가지이다. 마지막으로, 기존 서비스에서 제공하는 서비스를 변경하지 않고 Custom Vision과 AutoML Vision에서 제공하는 딥러닝 모델을 그대로 사용한다.

5.2 실험 결과

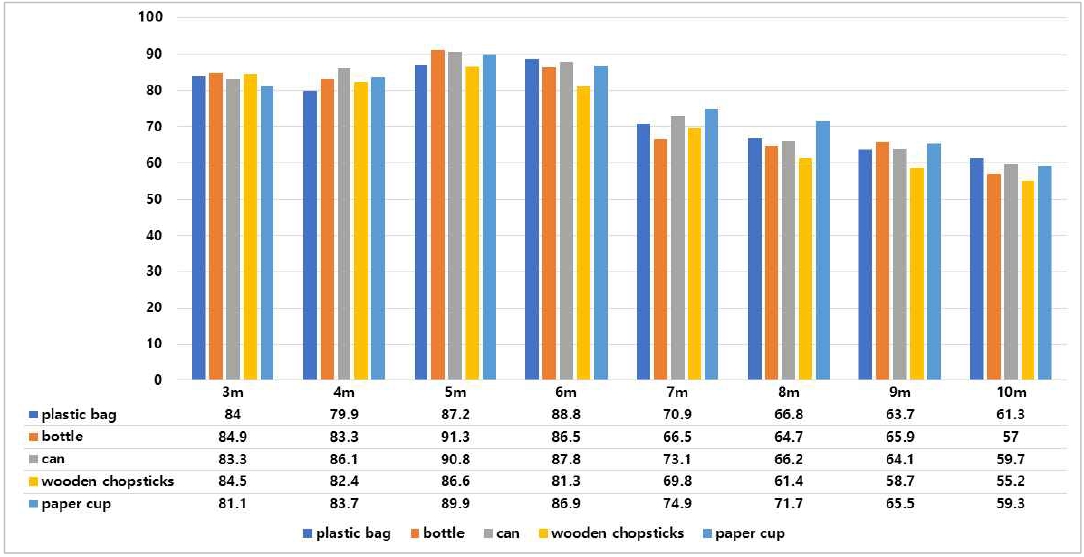

그림 10은 Custom Vision을 이용하여 고도에 따른 쓰레기 인식 결과를 보여준다.

고도에 따른 분석 결과는 고도가 낮을 때 점차 인식률이 증가하는 결과를 보였고, 7m 이상의 고도에서는 인식률이 감소하는 결과를 보였다. 이는 드론과 지상의 거리에 비해 쓰레기의 크기가 작아 낮은 고도에서는 높은 인식률이, 높은 고도에서는 낮은 인식률을 가지는 것으로 보인다. 이를 통해 연구의 목적에 맞게 고도에 따라 드론을 이용한 영상 데이터의 인식률이 달라짐을 확인하였다.

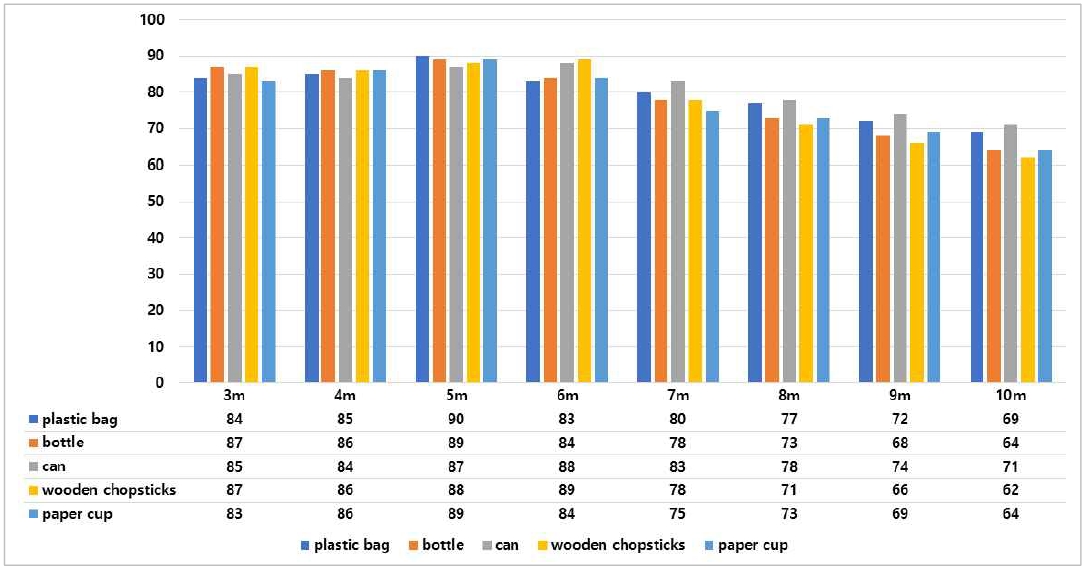

그림 11은 AutoML Vision을 이용하여 고도에 따른 쓰레기 인식 결과를 보여준다.

고도에 따른 인식 결과는 Custom Vision과 동일하게 낮은 고도에서는 높은 인식률을 보였고, 고도가 높은 경우에는 낮은 인식률을 보였다. 또한, 고도 3m부터 6m까지는 인식률이 점차 높아지는 결과를 보였고, 그 이상의 고도에서는 인식률이 낮아지는 결과를 보였다.

표 2는 실험 결과에 대한 종합적인 결과를 보여준다. 결과는, 고도는 5m에서 총 7개의 높은 인식률을 보였고 고도 6m에서는 총 3개의 높은 인식률을 보였다. 이를 통해 인식률의 차이는 미비하지만, 평균적으로 고도 5m가 정확한 쓰레기 영상을 획득하는 데 필요한 드론의 최적 고도로 산출하였다.

실험 전 예상 결과는 높은 고도에서 촬영된 영상보다 낮은 고도에서 촬영된 영상이 인식률이 더 좋을 것이라고 예상하였다. 하지만 실제 결과로는 낮은 고도에서 촬영된 영상보다 높은 고도인 5m와 6m에서 촬영된 영상이 높은 인식률을 보였다. 이는 실험 데이터를 수동으로 확인해본 결과, 인식률이 높은 고도인 5m와 6m에서 촬영된 영상보다 낮은 고도인 3m와 4m에서 촬영된 영상의 품질이 낮음을 확인하였다. 이는 드론의 카메라 성능, 속도 및 외부 요인의 영향으로 판단된다.

인식률을 확인하는 과정에서 쓰레기인 것을 쓰레기가 아닌 것으로 오인식하는 경우가 빈번히 발생하였다. 이는 수동으로 확인한 결과, 실험 데이터의 일부가 촬영 시 빛을 받아 객체의 경계가 모호해져 오인식한 결과로 보인다. 향후 이러한 점을 고려하여 인식률을 향상시킬 수 있는 방안이 필요하다.

5.3 클라우드 서비스별 비교 및 평가

연구의 정확성을 높이기 위해 클라우드 서비스별 비교 및 평가를 진행한다. 모델들의 비교하기 위해 mAP(Mean Average Precision) 성능 지표를 이용한다. mAP는 이진 분류기의 성능 지표로 사용되는 정밀도와 재현율을 이용한 지표이며 객체 검출 알고리즘의 성능을 평가하는데 널리 사용된다.

Custom Vision 모델의 mAP는 95.2%를 확인하였고, AutoML Vision 모델의 mAP는 99.7%로 확인하였다. 그 결과, Custom Vision보다 AutoML Vision이 4.5% 더 높은 mAP의 값을 보였고 이는 AutoML Vision 모델의 성능이 더 우수한 결과를 보인다.

Ⅵ. 결론 및 향후 연구

이 논문에서는 정확한 쓰레기 영상 획득을 위한 고도와 인식률의 관계에 대한 연구를 수행하였다. 먼저 대표적인 쓰레기 유형을 선정하고 학습 연산을 수행하였다. 다양한 고도별로 드론을 이용하여 쓰레기 영상을 수집하였고, 수행된 연산을 통해 수집된 영상 데이터의 인식률을 확인하였고, 실험 및 평가를 통해 5m의 최적 고도를 산출하였다.

향후 연구에서는 실제 환경의 쓰레기를 기반으로 실험 및 평가하는 연구가 필요하다. 또한, 속도가 있는 영상과 없는 영상을 픽셀 단위로 비교하는 알고리즘을 개발하여 드론의 인식률에 영향을 미치는 외부 요인의 영향에 대한 연구가 필요하다.

Acknowledgments

“이 연구는 2019년도 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임 (NRF-2019R1I1A3A01060826).”

References

- Marine Environment Information Portal, https://www.malic.or.kr/inofrmation/monitoring/, . [accessed: Nov. 23, 2020]

-

S. H. Lee and D. W. Lee, "Economic & Technical Trends and Directions of Unmanned Helicopter in Foreign Cases", JAITC, Vol. 7, No. 2, pp. 91-98, Dec. 2017.

[https://doi.org/10.14801/jaitc.2017.7.2.91]

- D. K. Chung, M. H. Lee, H. Y. Kim, and I. P. Lee, "Development of the Real Time Marin Debris Detection System base on the Deep Learning and Drone Image", Proceedings of Korean Society for Geospatial Information Science, pp. 136-138, Nov. 2019.

- Y. D Joo, "Drone Image Classification based on Convolutional Neural Networks", The Journal of the Institute of Internet Broadcasting and Communication(JIIBC), Vol. 17, No. 5, pp. 97-102, Oct. 2017.

- Y. D. Joo, "A Study on the Construction of Near-Real Time Drone Image Preprocessing System to use Drone Data in Disaster Monitoring", The Journal of The Institute of Internet, Broadcasting and Communication (JIIBC), Vol. 18, No. 3, pp. 143-149, Jun. 2018.

-

Y. J. Seo, Y. S. Jin, and T. J. Park, "Navigation System Using Drone for Visitors", Journal of Digital Contents Society, Vol. 17, No. 1, pp. 109-114, Feb. 2017.

[https://doi.org/10.9728/dcs.2017.18.1.109]

- D. K. Shin, M. U. Ahmed, J. W. Kim, and P. K. Rhee, "Open set Object Detection combining Multi-branch Tree and ASSL", The Journal of the Institute of Internet Broadcasting and Communication(JIIBC), Vol. 18, No. 5, pp. 171-177, Oct. 2018.

- The Plastic Tide, https://www.theplastictide.com/, . [accessed: Nov. 23, 2020]

-

D. S. Kim, H. C. Son, J. W, Si, and S. Y. Kim, "Traffic Accident Detection Based on Ego Motion and Object Tracking", JAITC, Vol. 10, No. 1, pp. 15-23, Jul. 2020.

[https://doi.org/10.14801/JAITC.2020.10.1.15]

-

C. Martin, S. Parkes, Q. Zhang, X. Zhang, M. F. McCabe, and C. M. Duarte, "Use of unmanned aerial vehicles for efficient beach litter monitoring", Marine Pollution Bulletin, Vol. 131, pp. 662-673, Jun. 2018.

[https://doi.org/10.1016/j.marpolbul.2018.04.045]

-

G. V. Nardari, R. A. F. Romero, V. C. Guizilini, W. E. C. Mareco, D. M. B. P. Milori, P. R. Villas-Boas, and I. A. D. Santos, "Crop Anomaly Identification with Color Filters and Convolutional Neural Networks", 2018 Latin American Robotic Symposium, 2018 Brazilian Symposium on Robotics (SBR) and 2018 Workshop on Robotics in Education (WRE), Joao Pessoa, Brazil, No. 36, pp. 82-101, Mar. 2020.

[https://doi.org/10.1109/LARS/SBR/WRE.2018.00072]

- D. J. Park, K. E. Park, G. H. Kim, H. E. Ahn, and S. Y. Choi, "Implementation of Automatic Separator Using Arduino UART Communications", Proceedings of Symposium of the Korean Institute of communications and Information Sciences, pp. 836-837, Jan. 2019.

- M. Yang and G. Thung, "Classification of Trash for Recyclability Status", CS229 Project Report 2016, 2016.

- O. Awe, R. Mengistu, and V. Sreedhar, "Final Report: Smart Trash Net: Waste Localization and Classification", arXiv Preprint, 2017.

- AI Compare, http://medium.com/@aicompare/, . [accessed: Jan. 11, 2020]

- Dive Against Debris, http://www.projectaware.org/diveagainstdebris/, . [accessed: Nov. 23, 2020]

- Seoul Regional Aviation Administration, http://www.molit.go.kr/sroa/, . [accessed: Dec. 24, 2020]

2017년 3월 ~ 현재 : 군산대학교 소프트웨어융합공학과 학부생

관심분야 : 사물인터넷, 데이터베이스, 프로그래밍

1997년 2월 : 군산대학교 컴퓨터과학과(이학사)

1999년 2월 : 충북대학교 전자계학과(이학석사)

2004년 2월 : 고려대학교 컴퓨터학과(이학박사)

2005년 3월 ~ 현재 : 군산대학교 소프트웨어융합공학과 교수

관심분야 : 데이터베이스, 데이터 표준화, 빅데이터, 사물인터넷, 지능형 융합 서비스, 엣지컴퓨팅