에지 성분 분석을 통한 정사 위성 영상을 가진 구조물 특징 영역의 정합 성능 추정

초록

위성 영상으로부터 사전 추출된 구조물을 이용해 멀티 모달 정합을 한다고 가정할 때, 본 논문에서는 구조물을 포함하는 특징 영역의 정합 성능(또는 품질)을 추정하는 방법을 제안하여, 정합 수행 전에 고품질 특징 영역을 선별할 수 있도록 한다. 본 논문에서는 GHT(Generalized Hough Transform) 방식과 유사하지만 보다 나은 품질 측정 방법을 다음과 같이 제안한다. 먼저, 래스터화 단계에서 각 구조물 에지 픽셀에 방향각을 설정한다. 그다음, 위성 영상의 에지 픽셀과의 방향 유사도를 합산한다. 마지막으로, 그래디언트 강도와 잠재적인 클러터 에지에 기반하여 합산 결과에 가중치를 준다. 제안한 품질 측정 방법이 유효함을 보기 위해, 특징 영역들의 품질 측정값과 정합 성공률 및 정합 오차의 표준편차 간 상관성을 조사하고, 최상위 품질의 3개 특징 영역의 정합 성공률 평균을 조사한다.

Abstract

Assuming a multimodal registration using the pre-extracted structures from satellite images, This paper proposes a measuring method to estimate matching performance (i.e., quality) of a feature area to select high quality feature areas before the registration. This paper suggests a measuring method which is similar to, but better than GHT(Generalized Hough Transform) as follows. First, during the rasterization, we assign orientations to structure edge pixels. Then, we add-up the orientation similarities with the edge pixels of the satellite image. Finally, we weight the summation based on the gradient magnitudes and the potential clutter edges. To validate the proposed measuring method, we examine the correlation between measured qualities and the registration success rates (also registration error standard deviations) and examine the average registration success rates of the top 3 high quality feature areas.

Keywords:

multimodal registration, satellite image, infrared image, structural feature, generalized Hough transform, feature evaluationⅠ. 서 론

위성 영상 기술의 발달로 서로 다른 센서 영상을 정합하는 것은 활발히 연구되어온 주제 중 하나이다. Lee와 Choi[1]는 SIFT(Scale Invariant Feature Transform)[2] 알고리즘을 수정하여 적외선과 광학 위성 영상 간의 정합 문제를 다루었다. Han과 Choi[3]는 SURF(Speeded Up Robust Features) 방법[4]과 위상상관도[5]를 이용하여 적외선과 광학 영상 간의 정합 문제를 다루었다. 다양한 이종 센서 정합 기법에 대해서는 Kim[6]의 연구를 참고할 수 있다.

본 논문에서는 위성 영상으로부터 사전 추출된 2차원 또는 3차원 구조물(예를 들어 삼각형 메쉬)로부터 이종 센서 영상을 정합하는 방법을 가정한다. 본 논문에서는 대표적인 센서 영상의 하나인 적외선 영상으로 연구 범위를 제한한다. 잘 알려진 SIFT나 SURF기법은 LoG(Laplacian of Gaussian) 필터를 근사하여 경계나 코너가 뚜렷한 점을 기반으로 정합을 수행한다. 구조물을 이용한 정합에서는, 구조물을 구성하는 삼각형 메쉬로부터 바이너리 에지 영상을 이용할 수 있어, 이 방식 역시 궁극적으로 영상의 경계 성분을 이용한 방법이며, 예를 들어 일반화된 허프 변환 정합(Generalized Hough Transform, GHT)[7]이 이를 위해 사용될 수 있다.

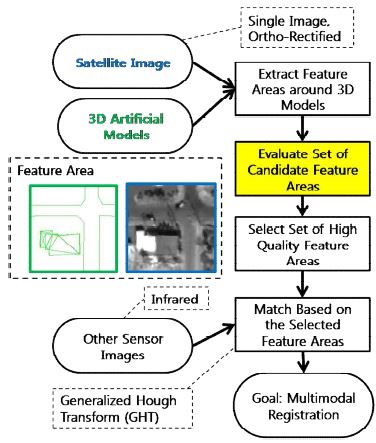

실시간 시스템에서는 영상 전체를 정합하기에 처리시간이 부족하다. 또한 영상 내 구조물의 개수가 많지 않은 경우 잘못된 정합점 개수가 올바른 정합점 개수와 같거나 그보다 많을 수 있다. 따라서 본 논문이 가정하는 정합 방법을 위해서는 구조물을 가진 특징 영역들 중에서 비교적 정합 성능이 높은 것들을 선별해야 한다. 여기서 특징 영역이란, 국소 위성 영상 패치에 대응하여 투영된 3차원 또는 2차원 구조물의 국소 영역을 의미한다. (그림 1 참조) 이종 센서 영상 정합이 아닌 영상 추적 응용에서는 이전 프레임들의 정합 결과를 토대로 특징점의 선별을 수행하는 연구가 있었다[8][9].

본 논문에서는 개별 특징 영역의 정합 성능 추정 방법을 다루고자 한다. 본 논문에서는 추정된 정합 성능을 품질이라고 부르겠다. 구조물을 가진 특징 영역의 정합 성능을 예측하는 개별 특징의 품질 측정 연구는 저자가 아는 한 존재하지 않는다. Gauglitz 등[10]은 특징점 추출 연산자를 평가할 때, 특징점 추출의 재현성(Recall), 전체 정합점 개수 대비 정합이 성공한 정합점 개수 비율로 평가하였으나 개별 특징점의 정합 성능 평가에 초점을 맞추지는 않았다. Bu 등[11]은 SAR(Synthetic Aperture Radar) 영상 정합에 적합한 특징 평가 함수를 유전 알고리즘[12]으로 찾는 연구를 수행하였으나, 구조물을 가진 특징 영역을 다루지는 않았다.

본 논문에서는 정사 위성 영상 및 구조물 국소영역으로 구성된 특징 영역을 이용해, 주어진 특징 영역의 정합 성능을 추정하고자 한다. 본 논문이 다루는 문제를 그림 1에 표현하였다. 뒤에서 다루겠지만, 이에 대한 직관적인 방법은 특징 영역의 구조물 에지를 GHT를 이용해 특징 영역에 대응하는 정사 영상 에지에 정합하여 그 결과 특징 영역 중심점의 누적 값을 해당 특징영역의 품질 값으로 이용하는 것이다. 이 방식은 바이너리 에지의 방향 값에 오차가 생길 경우 정합 성능 추정이 잘못될 수 있는 단점이 있다.

본 논문에서는 에지 방향의 유사도 측정 방법과 이에 대한 가중치를 주어 품질 값이 정합 성능을 잘 반영할 수 있는 품질 측정 방법을 제안한다. 다음 2장에서는 본 논문에서 가정하는 구조물 기반 특징 영역 정합 기법을 소개하고, 특징 영역의 품질 측정 방법을 어떤 측면에서 평가할 지 기술한다. 3장에서는 기본적인 특징 영역 품질 측정 방법을 다루고, 이들의 한계점을 기술한다. 4장은 제안하는 특징 영역 품질 측정 방법을 다룬다. 5장은 실험 결과를 종합하여 제시하며, 6장에서 결론을 맺는다.

Ⅱ. 논문에서 가정하는 구조물 기반 정합 방법과 특징 영역 품질 측정 방법의 평가

2.1 논문에서 가정하는 구조물 기반 정합 방법

먼저, 본 논문이 가정하는 구조물 기반 영상 정합 방법을 기술한다. 이는 다음 단계들로 구성된다.

(단계 1) 구조물의 바이너리 에지 영상 준비 : 이는 일반적인 그래픽스 알고리즘[13]에 따라 구조물이 가진 2차원 또는 3차원 메쉬를 사전에 설정된 회전각 및 스케일로 변환한 후에 래스터화시켜 얻을 수 있다.

(단계 2) 입력 영상(예. 적외선 영상)의 바이너리 에지 영상 준비: 다양한 에지 추출 알고리즘(Canny edge[14], anisotropic diffusion 방법[15], 그래디언트 강도[16]와 임계값을 결합한 방식)을 사용할 수 있으며, 본 논문의 정합 실험에서는 그래디언트 강도와 영상을 분석하여 설정한 임계값에 기반하여 바이너리 에지 영상을 계산한다.

(단계 3) GHT R-table 작성 및 누적 수행: [7]에 따라 참조용 바이너리 에지 영상으로부터 R-table을 작성하고, 입력 영상의 바이너리 에지 픽셀 각각에 대해 (단계 1)에서 설정된 회전각과 스케일을 포함한 일정 범위 내에서 누적 배열의 해당 엔트리 값을 증가시키고, 그 결과로 최대 누적 값을 가지는 엔트리의 변환을 정합의 해로 결정한다[7].

2.2 특징 영역 품질 측정 방법의 평가

특징 영역의 품질 측정값은 해당 특징 영역을 정합에 선택하여 사용하였을 때 실제 정합 성능을 반영하여야 한다. 정합 성공 기준은 실험 영상의 해상도, 정합 알고리즘, 구조물 좌표 오차 등을 감안하였고, 3픽셀 이내로 참값과 일치할 경우 성공으로 판정하였다. 정합 성능은 정합 성공률과 정합 오차의 표준 편차(낮을수록 정합 성능 우수)로 표현될 수 있다. 따라서 본 논문은 정합 성공률과 정합 오차 표준 편차 값이, 측정된 특징 영역의 품질 값과 상관성이 있는지 보기 위해 피어슨 상관계수 값과, 산점도(scatter plot)를 이용한다.

한편, 특징 영역은 주변의 다른 특징 영역과는 동일하지 않은 고유한 특징을 가져야 한다. 이는 입력 영상 대신 정사 위성 영상에 2.1절의 정합 알고리즘을 적용하였을 때, 다음 ATCR(Accepted Target - Clutter Ratio) 값을 이용해 검사할 수 있다.

| (1) |

여기서 Acc(i,j)는 (i,j)위치의 누적 값을 의미한다. C7(i,j)는 (i,j)가 중심인 7×7 영역 내 좌표 집합을 의미한다. 이 7×7 영역 크기는 정합 성공 기준으로부터 설정하였다. (tx,tj)는 C7(x,y)에서 찾은 최대 누적 값의 위치이다. ROI는 (x,y)가 중심인 100×100 영역 내 좌표들의 집합이다. ATCR값이 1보다 작으면 유사한 다른 특징 영역이 ROI안에 존재함을 의미하므로, ATCR값이 1보다 큰 특징 영역을 선별하여 정합에 사용하는 것이 바람직하다. 이 방식은 특징 영역 품질 측정 전에 적용할 수 있다. 논문에서는 이를 품질 측정 방법명 뒤에 '_ATCR1'을 붙여서 나타낸다.

Ⅲ. 기본적인 특징 영역 품질 측정 방법

3장에서는 본 논문이 제안하는 특징 영역 품질 측정 방법을 제시하기 전에 기본적으로 제안할 수 있는 특징 영역 품질 측정 방법을 비교의 목적으로 다룬다. 우선 구조물 없이 정사 위성 영상만으로 특징을 추출하는데 Harris Corner Detector[17]의 Corner Response R 값을 사용해볼 수 있다. 이 경우 R 값은 특징 영역 내 x 및 y축 그래디언트 강도를 기반하여 계산되며, R값이 클수록 해당 특징영역이 x 및 y방향 모두에 대해 밝기 변화가 큼을 나타낸다. 이 방법은 구조물 정보를 사용하지 않기 때문에, 특징 영역 내 구조물이 차지하는 비중이 매우 낮더라도 해당 영상 영역에 높은 대조비를 가진 영역이 존재할 경우 높은 R값을 산출하게 된다.

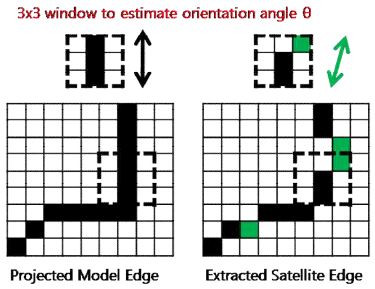

2.1절에서 언급한 방법에서 정합할 입력 영상 대신 정사 위성 영상을 GHT로 정합하고 그 누적 결과 값을 품질로 제시할 수 있다. 본 논문에서는 이 방식을 'GHT_ACC'로 표기하겠다. GHT_ACC 방식은 정합 성능을 어느 정도 반영할 수 있지만 위성 영상의 바이너리 에지 추출 결과에 오차가 있는 경우 취약점이 생긴다. 정사 위성 영상은 신호 감쇄나 회로 잡음으로 에지 추출 결과가 이상적인 직선 형태가 아닌 조금 구부러진 곡선 형태로 나올 수 있다. 그림 2는 이러한 문제를 시각적으로 표현하였다. 그림 2에서 굵은 점선 표시 윈도우 내에서 중심 픽셀의 에지 방향각을 추정하는 경우, 구조물의 바이너리 에지 영상에서는 90°(수평면을 0°로 가정) 방향이지만, 정사 위성 영상에서는 에지 방향각이 90°가 아닐 수 있다. 방향각이 정확히 일치하지 않으면 GHT 방법에서 R-table 조회가 되지 않아 올바른 누적이 되지 않으므로 품질 측정에 오차가 발생할 수 있다.

한편 또 다른 GHT 기반 품질 측정 방법으로 식 (1)의 ATCR값을 사용할 수 있다. 그러나 ATCR이 1보다 큰 값인 경우 더 이상 ATCR값 자체로 특징 영역들의 정합 성능을 변별하기 어려웠다. 본 논문에서는 이 방식을 'GHT_ATCR'로 표기한다.

Ⅳ. 제안하는 품질 측정 방법

4.1 픽셀의 방향각 설정 방법

본 논문에서는 R-table을 사용하는 대신, 특징 영역 내 구조물의 바이너리 에지 픽셀의 에지 방향각과 정사 위성 영상의 바이너리 에지 픽셀의 에지 방향각의 유사도를 반영할 수 있는 픽셀 단위의 매칭을 제안한다.

우선 구조물의 에지 픽셀 방향각 θt (i,j)는 래스터화 이후 바이너리 에지 이미지에서 결정하는 대신 래스터화 단계에서 결정한다. 라인의 양 끝점이 실수 좌표로 기술되므로 구조물 좌표의 정확도만큼 정교하게 방향각을 설정할 수 있다. 단, 양 끝점에서의 방향각은 연결된 에지 개수만큼 여러 각도가 나올 수 있기 때문에, 구현을 쉽게 하기 위해 'Don't Care' 처리하는 것을 제안한다. 한편 정사 위성 영상의 x 및 y축 그래디언트 Gx, Gy[16]를 이용해 위성 영상 내 각 픽셀의 방향각을 와 같이 계산할 수 있다.

4.2 픽셀 단위 방향각 유사도의 합산

4.1절에서 계산한 픽셀 (i,j)의 두 방향각 θp와 θg의 유사도 를 특징 영역 내 매칭된 모든 에지 픽셀에 대해서 합산한다. 여기서 방향각은 90°와 -90°가 같은 의미를 갖기 때문에 |θp - θg|는 값이 적은 방향으로 계산한다(Don't Care 픽셀은 유사도를 1로 처리함). 이 방식을 본 논문에서는 'M1(Method 1)'으로 표기한다. 이에 따르면, (x,y)를 중심으로 하는 특징 영역의 품질은 다음 식과 같이 계산한다.

| (2) |

여기서 P와 E는 각각 특징 영역 내 구조물의 바이너리 에지 픽셀 좌표 집합, 정사영상의 에지 픽셀 좌표 집합이다.

이 방식을 확장하여 픽셀의 근사된 그래디언트 강도 값 G = |Gx| + |Gy|를 정규화하여 가중치로 곱할 수 있다. 이 방식은 'M2(Method 2)'로 표기하고 다음 식과 같이 계산한다.

| (3) |

여기서 정규화된 그래디언트 강도 GN(i,j)는 영상 내 최대/최소 강도 Gmax, Gmin을 이용해 [0,1] 구간의 값으로 계산한다.

| (4) |

더 나아가, 바이너리 에지 추출 결과 대신 정사 위성 영상의 그래디언트 강도 영상을 이용할 수 있다. 바꿔 말하면, 에지 추출 알고리즘으로는 에지 픽셀이 아니라도, GN(i,j)가 0보다 크면 계산하는 방식이다. 이 방식은 'M3(Method 3)'로 표기하고 다음 식과 같이 계산한다.

| (5) |

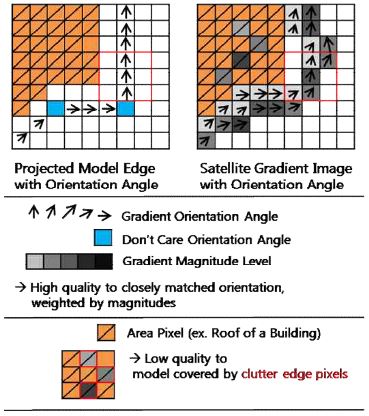

4.3 구조물의 내부 영역이 잡음 에지에 가리는 비율을 이용한 가중치 부여

4.2절까지는 픽셀 단위 유사도 값을 합산하는 방식이다. 더 나아가 이 값에 각 구조물 별로 가중치를 곱할 수 있다. 예를 들어 특정 건물의 지붕이 흙으로 덮여 있거나 수풀에 가리는 경우 구조물의 내부 영역 픽셀에 에지가 추출될 수 있는데, 이 에지는 구조물 에지가 아니므로 정합 오차에 나쁜 영향을 미칠 수 있다. 따라서 특징 영역 내 각 구조물 k가 잡음 에지에 가리지 않는 비율 AWk를 곱하는 방법 'M4(Method 4)'를 제안한다. 본 논문에서는 다음 식과 같이 계산한다.

| (6) |

여기서 N은 특징 영역 안에서 보이는 구조물들의 집합, Pk는 특징 영역 내 구조물 k의 에지 픽셀 좌표 집합이다. AWk는 다음 식과 같이 계산한다.

| (7) |

여기서 Ak는 구조물 k의 내부 영역 픽셀 좌표 집합이다. 그림 3은 본 논문이 제안하는 M4 방법의 개념을 보여준다.

Ⅴ. 실험 결과

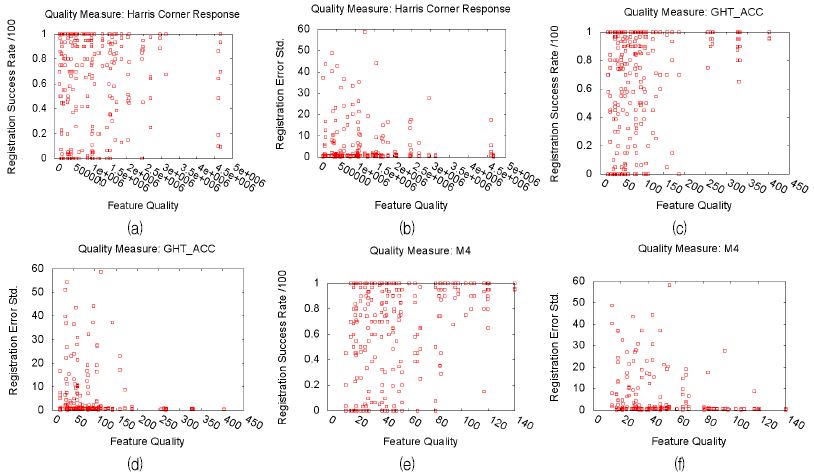

실험에는 헬기 탑재 적외선 센서로 획득한 적외선 영상을 이용하였으며, 이에 대응하는 8개의 정사위성 영상에서 구조물 위주로 특징 영역을 추출하되 서로 분산된 위치에서 10개씩 추출하여 평가하였다. 같은 특징 영역에 대해서는 최대 6가지 다른 시간대의 적외선 영상으로 정합 성능을 계산하였다. 상관 계수 계산에는 총 350개의 품질-정합 성능 쌍이 사용되었다.

특징 영역의 계산에는 Intel(R) Core(TM) i7-4800MQ CPU @ 2.70 GHz 2.70GHz 프로세서가 사용되었다. 정사 위성 영상 크기는 1001×1001에서 1003×1003 픽셀 크기이며, 특징 영역의 크기는 80×80 픽셀 크기로 설정하였다. 표 1은 품질 측정 시간, 품질 값과 정합 성공률 및 정합 오차의 표준편차 간의 상관성을 나타낸다.

M1, M2, M3, M4 방식은 Harris Corner, GHT_ACC 방식보다 강한 상관성과 높은 정합 성공률 평균을 보여준다. M4 방식은 상위 3개 정합성공률 평균이 가장 높지는 않지만, 실험한 다른 방법들 중 가장 강한 상관성을 보여주었다.

그림 4는 3가지 방법에 대한 실험 결과 산점도이다. GHT_ACC의 산점도를 볼 때, 급격하게 정합 성능이 증가하는 구간이 있다. 표 1에서 GHT_ACC 방법이 상위 3개 정합 성공률 평균이 논문에서 제안하는 방법들에 비해 낮다는 점을 고려할 때, 이 구간에서 특징 영역의 변별력이 부족하다고 지적할 수 있다. 참고로, 어떤 지역에서는 품질 값의 분포가 다른 지역에 비해 대체로 낮게 분포할 수 있으므로 품질 값 전 구간에서 상관성이 요구된다. Harris Corner Response R값은 구조물 정보를 사용하지 않기 때문에 상위 품질 값을 가진 특징 영역의 정합 성능이 낮게 나올 수 있었다.

Comparison of quality measuring methods: scatter plots of the qualities and the registration performances

Comparison of quality measuring methods: the process time, the correlation coefficient and the average registration rate of the top 3 feature areas

M4 방식에서 일부 높은 품질을 가진 특징 영역이 낮은 정합 성공률을 보였다. 이는 정합 시 사용한 적외선 영상에서 날씨 영향으로 해당 구조물 특징 영역의 신호 값이 낮았기 때문으로 분석되었다.

Ⅵ. 결론 및 향후 과제

구조물을 가진 특징 영역을 선별하기 위해 개별 특징 영역의 정합 성능(또는 품질)을 추정하는 방법으로서, 본 논문에서는 래스터화 단계에서 구조물 에지 픽셀의 방향각을 설정하고 정사 위성 영상의 에지 픽셀의 방향각과의 유사도를 합산하는 방법을 제안하였다. 이에 더하여 그래디언트 강도와 구조물 내부 영역 내 클러터 에지에 가리지 않는 비율로 가중치를 주는 방법을 제안하였다. 품질 측정 방법의 유효성은 품질값과 정합 성공률 및 정합 오차의 표준편차 간 상관계수 값과, 상위 3개 정합 성공률 평균으로 확인하였다. 향후 과제로서 구조물 특징 영역들의 품질 기반 선별 방법과, 다수 정사 위성 영상을 이용한 특징 영역 품질 평가 방법, 그리고 구조물 기반 특징 영역을 이용한 개선된 정합 알고리즘 연구를 제안한다.

References

- K. H. Lee, and T. S. Choi, "Automatic Registration Method for EO/IR Satellite Image Using Modified SIFT and Block-Processing", Journal of Korea Institute of Information, Electronics, and Communication Technology, 4(3), p174-181, Sep), (2011.

-

D. G. Lowe, "Distinctive image features from scale-invariant keypoints", International Journal of Computer Vision, 60(2), p91-110, Jan), (2004.

[https://doi.org/10.1023/b:visi.0000029664.99615.94]

-

Y. K. Han, and J. W. Choi, "Matching Points Extraction Between Optical and TIR Images by Using SURF and Local Phase Correlation", , Journal of Korean Society for Geospatial Information System, 23(1), p81-88, Mar), (2015.

[https://doi.org/10.7319/kogsis.2015.23.1.081]

-

H. Bay, T. Tuytelaars, and L. Van Gool, "Surf: Speeded up robust features", In European conference on computer vision, p404-417, May), (2006.

[https://doi.org/10.1007/11744023_32]

- C. D. Kuglin, and D. C. Hines, "The phase correlation image alignment method", In Proc. Int. Conference Cybernetics Society, p163-165, Sep), (1975.

- K. Kim, "Survey on Registration Techniques of Visible and Infrared Images", IT CoNvergence PRActice (INPRA), 3(2), p25-35, Jun), (2015.

-

D. H. Ballard, "Generalizing the Hough transform to detect arbitrary shapes", Pattern recognition, 13(2), p111-122, Jan), (1981.

[https://doi.org/10.1016/0031-3203(81)90009-1]

-

H. H. Jeon, J. H. Kim, and Y. H. Ko, "RAFSet (Robust Aged Feature Set)-Based Monocular Visual Odometry", Journal of Institute of Control, Robotics and Systems, 23(12), p1063-1069, Dec), (2017.

[https://doi.org/10.5302/j.icros.2017.17.0160]

-

G. Zhang, and P. A. Vela, "Good features to track for visual slam", In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, p1373-1382, Jun), (2015.

[https://doi.org/10.1109/cvpr.2015.7298743]

-

S. Gauglitz, T. Hollerer, and M. Turk, "Evaluation of interest point detectors and feature descriptors for visual tracking", International Journal of Computer Vision, 94(3), p335-360, Mar), (2011.

[https://doi.org/10.1007/s11263-011-0431-5]

-

Y. Bu, G. Tang, H. Liu, and L. Pan, "Matching suitable feature construction for SAR images based on evolutionary synthesis strategy", Chinese Journal of Aeronautics, 26(6), p1488-1497, Aug), (2013.

[https://doi.org/10.1016/j.cja.2013.07.030]

- D. Goldberg, "Genetic algorithms in Search, optimization, and Machine Learning", Addison-Wesley, p1-412, Jan), (1989.

- A. Edward, and D. Shreiner, "Interactive Computer Graphics: A Top-Down Approach Using OpenGL", Addison-Wesley, p1-719, Jan), (2003.

- J. Canny, "A Computational Approach to Edge Detection", in IEEE Transactions on Pattern Analysis and Machine Intelligence, PAMI-8(6), p679-698, Nov), (1986.

-

P. Perona, and J. Malik, "Scale-space and edge detection using anisotropic diffusion", IEEE Transactions on Pattern Analysis and Machine Intelligence, 12(7), p629-639, Jul), (1990.

[https://doi.org/10.1109/34.56205]

- R. C. Gonzalez, and R. E. Woods, "Digital image processing", Addison-Wesley, p1-716, Jun), (1992.

-

C. Harris, and M. Stephens, "A combined corner and edge detector", In Alvey vision conference, 15(50), p147-151, Aug), (1988.

[https://doi.org/10.5244/c.2.23]

2011년 2월 : 광운대학교 컴퓨터소프트웨어학과(공학사)

2013년 2월 : 한국과학기술원 전산학과(공학석사)

2013년 4월 ~ 현재 : 국방과학연구소 연구원

관심 분야 : 멀티 모달 영상 정합