실외 환경에서의 다중 로봇 시스템을 위한 구체 타겟 기반 LiDAR와 카메라 간의 캘리브레이션 기술

초록

본 논문에서는 다중 로봇 시스템이 운영되는 실외 환경에서 타겟이 손상된 상황에서도 적용 가능한 새로운 구체 타겟 기반 LiDAR와 카메라 간의 외부 캘리브레이션 방법을 제안한다. 카메라의 경우, 작은 크기의 구체 타겟을 효과적으로 추출하기 위해 SAM(Segment Anything Model)을 활용한다. LiDAR의 경우, 구체 타겟에는 평평한 영역이 없어 노이즈가 불가피하므로, 누적된 포인트클라우드에 가중합을 적용하여 정확한 구체 중심을 추출한다. 실험을 통해 카메라와 세 종류의 LiDAR에서 제안된 방법을 평가하였다. 제안한 접근 방식은 타겟이 손상된 상황에서도 강건하게 타겟을 검출하였으며, 정확도 측면에서 기존 방법 대비 재투영 오차에서 평균 92.51%의 성능 개선을 보여줬다.

Abstract

This paper presents a novel spherical target-based LiDAR-camera extrinsic calibration method designed for outdoor environments with multi-robot systems, considering target corruption. For the camera, the Segment Anything Model (SAM) is utilized to extract relatively small size of spherical target. For LiDAR, since noise is inevitable due to absence of flat regions, we apply weighted sum to the accumulated pointcloud. Through experiments, we evaluated our method using three different types of LiDARs and a single camera. The proposed approach robustly detects the target even in the presence of damage and demonstrates superior calibration accuracy compared to existing method.

Keywords:

extrinsic calibration, sensor fusion, field robotics, 3d LiDAR, spherical targetⅠ. 서 론

LiDAR(Light Detection and Ranging) 센서와 카메라 융합 기술은 연구 단계를 넘어 자율 주행[1], 동시적 위치 추정 및 지도 작성(SLAM, Simultaneous Localization and Mapping)[2], 기타 다양한 분야[3]에서 널리 활용되고 있다. 효과적인 센서 융합을 위해서는 각 센서의 좌표계 간 공간적 관계를 정밀히 결정하는 외부 캘리브레이션(Extrinsic calibration) 과정이 필수적이다.

타겟(Target) 기반의 LiDAR와 카메라 간의 외부 캘리브레이션은 명확한 기하학적 해석이 가능한 타겟을 사용하여, 서로 다른 차원의 데이터를 갖는 두 이종 센서 간의 상대적 위치 및 자세를 정의하는 과정이다.

하지만 해당 방법들은 사람의 개입이 필수적이기에 행성 탐사나 방사능 위험 지역과 같은 사람의 접근이 어려운 극한 환경에서는 적용이 어렵다. 이에 본 논문에서는 사람의 개입이 어려운 극한 환경뿐만 아니라, 최소한의 개입이 요구되는 자동화 농장과 같은 환경을 고려하여 센서 이탈이 감지된 로봇이 다른 로봇이 운반하는 타겟을 인식하여 캘리브레이션을 수행할 수 있는 다중 로봇 시스템을 위한 방법론을 제시한다.

다중 로봇을 활용하는 외부 캘리브레이션 시스템 관점에서, 체커보드[4], 다각형 평면[5], 또는 천공 평면[6]을 사용하는 방법들은 타겟의 크기가 크기 때문에 로봇이 운반하기 어려운 경우가 많으며, 또한 평면이기 때문에 시점에 따라 모양이 다르게 검출되어 종종 실용적이지 못하다. 이와 다르게 구체 타겟은 시점의 변화에 따라 관측되는 모양이 일정하고, 로봇이 운반하기 용이하며, 타겟이 손상되더라도 검출에 대한 신뢰성이 유지되기 때문에 야외 환경에서 운용되는 다중 로봇 시나리오에 적합하다.

하지만 대부분의 기존 구형 타겟 기반 접근 방식들은 변인이 통제된 실내에서 크기가 큰 구형 타겟(최소 반지름 25cm)을 사용하여 다중 로봇 관점에서 효용성이 떨어진다[7]-[9]. 또한 LiDAR 데이터에 노이즈가 없고, 카메라 이미지에서 구가 명확하게 보인다는 가정을 전제로 한다. 실제 환경에서는 포인트클라우드(Point cloud)에 상당한 노이즈가 포함되어 있으며, 부분적인 가림 등에 인해 타겟의 검출이 신뢰성 있게 이루어지지 않을 수 있다. 또한 기존 방법들은 타겟 손상에 대한 논의가 이루어지지 않았다.

본 논문에서는 야외 환경과 다중 로봇 시스템을 위한 새로운 LiDAR와 카메라 간의 외부 캘리브레이션 방법을 제안하며, 센서 노이즈와 구체 타겟에 발생할 수 있는 손상을 고려한다. 또한 로봇이 운반할 수 있도록 작은 크기의 구체 타겟을 사용한다. 본 논문의 주요 기여는 다음과 같다:

1. 다중 로봇 활용: 본 논문은 다중 로봇 시스템을 위한 캘리브레이션 시스템을 제안하며, 인간의 개입 없이 이를 수행할 수 있도록 한다.

2. 강건한 검출: 타겟이 손상되기 쉬운 야외 환경에서는 구의 손상이나 변형 가능성이 있기에, 이 경우에도 두 센서에서 구의 기하학적 구조를 신뢰성 있게 추출하는 방법을 제시한다.

Ⅱ. 방법론

2.1 개요

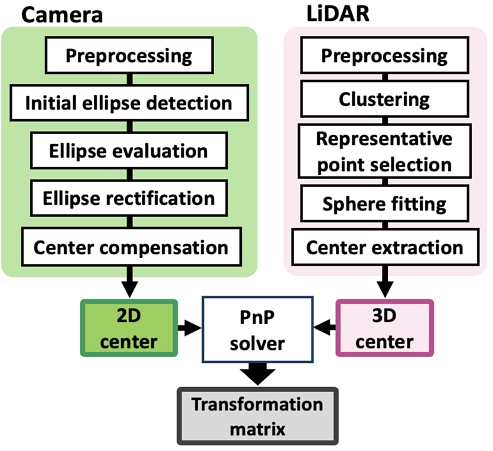

그림 1은 본 논문에서 제안하는 방법론의 파이프라인을 보여준다. 이 과정은 다음과 같이 요약할 수 있다. 카메라에서는 먼저 SAM(Segment anything model)[10]와 Canny edge detection을 적용하여 타겟에 대한 엣지 이미지를 추출한다. 이후 initial ellipse detection을 수행하여 초기 타원을 검출하고, ellipse evaluation을 거쳐 타원이 손상되었는지 파악하고, ellipse rectification을 적용하여 타원을 보정한다. 마지막으로, 구가 이미지에 투영될 시 발생하는 오류를 보정하기 위한 수정 단계인 Center compensation을 수행한다.

LiDAR 데이터의 경우, 먼저 구 영역의 점들을 식별한다. 그 후, 가중합(Weighted sum) 접근법을 사용하여 구 표면상의 점들을 분리하고 구 방정식을 도출한다. 마지막으로, PnP(Perspective-n-Point)를 활용하여 3D-2D 중심 쌍 간의 재투영 오류를 최소화함으로써 외부 파라미터를 추정한다.

2.2 카메라에서의 타원 검출

Preprocessing− 먼저, SAM을 통해 마스크 이미지들을 생성한 후 각 마스크 이미지에 대해 Canny edge detection을 적용한다.

Initial ellipse detection− 이 단계에서는 엣지(Edge) 이미지에서 점을 샘플링하여 타원의 존재 여부를 검사한다. 엣지에서 샘플링에 사용되는 모든 점은 Ps로 표시된다. 만약 손상된 영역에서 점이 샘플링되어 타원 검출에 사용된다면, 손상된 부분은 항상 타원 내부에 위치하므로 검출된 타원은 실제 타원보다 더 큰 이심률을 가져 더 길게 나타난다. 이러한 특성을 고려하여, 감지된 타원 내부의 점들을 반복적으로 Ps에서 제외하면 나머지 점들은 온전한 영역이나 손상이 시작되는 부분에 속하게 된다. Ps에서 남은 점들이 맞춰진 타원 위에 있을 경우, 샘플링된 점들을 Pe로 간주한다. 만약 타원을 찾기 전에 Ps가 소진되면, 엣지 이미지는 유효하지 않은 것으로 간주한다.

Ellipse evaluation− 이 단계에서는 Pe를 각도를 기준으로 나누는 히스토그램을 분석하여 검출된 타원이 손상되었는지 판단한다. Pe가 엣지를 따라 고르게 분포되어 있으면 타원이 온전하고 유효하다고 판단하고, 그렇지 않으면 타원은 손상되었거나 구체 타겟이 아닌 물체로부터 유래한 것으로 분류되어 다음 과정을 진행한다.

Ellipse rectification− 타원이 손상되었다 판단될 경우, Pe가 엣지의 특정 영역들에 몰려있기에 타원이 편향되어 보인다. 이 편향은 손상 정도가 증가함에 따라 더 뚜렷해진다. 이를 바로잡기 위해 에서의 한 점과 몰려있는 각 영역 위의 점들을 사용하여 타원 검출을 반복적으로 수행한다. 만약 정정된 타원 외부에 일정 비율의 Ps가 위치한다면, 타원은 유효하지 않은 것으로 간주한다. 조건을 만족하는 타원이 발견되면, 해당 타원은 유효하다고 간주하며 손상된 구에서 유래한 것으로 판단한다.

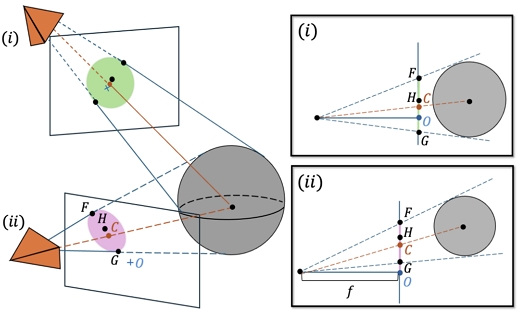

Center compensation− 구가 이미지 평면에 투영될 때, 구의 중심이 이미지 평면의 정확한 중심과 일치하지 않는 한, 구는 타원으로 나타난다. 이에 따라 중심 위치에 대한 오류가 발생하는데 이는 그림 2에서 확인할 수 있다. 이 오류 ϵ는 투영된 타원 중심 H와 실제 중심 C간의 차이를 계산하여 보정된다. 이 과정은 두 가지 경우로 나뉜다: (i) 이미지 평면의 중심이 타원 내부에 있는 경우, (ii) 이미지 평면의 중심이 타원 외부에 있는 경우. 오류 ϵ는 다음과 같이 계산된다.

| (1) |

여기서 점 O는 이미지의 중심, fa는 카메라의 초점거리, 점 F와 점 G는 타원이 장축과 만나는 두 점을 의미한다. 투영된 타원의 중심은 ϵ의 크기만큼 O 방향으로 조정된다.

2.3 LiDAR에서의 타원 검출

Preprocessing− 먼저 통계적 이상 제거(SOR, Statistical Outlier Removal) 알고리즘과 지면 검출 알고리즘을 적용하여 로봇의 점들을 식별한다. 해당 점들을 이미지에 투영한 후, Hough 변환을 활용하여 구체 타겟의 영역을 식별한다.

Clustering & Representative point selection−

LiDAR 측정값은 거리에 따른 감쇠와 입사각에 의해 영향을 받는 제로 평균 가우시안 노이즈(Zero-mean gaussian noise)모델을 따른다고 가정한다.

구형 물체는 중심에서 멀어질수록 입사각이 커지고 노이즈 또한 증가하므로, 노이즈를 고려하지 않고 구를 추정하는 것은 신뢰할 수 없다. 이를 해결하기 위해, 본 방법론은 LiDAR와 타겟을 고정한 상태에서 누적한 데이터에서 신뢰할 수 있는 점들을 식별한다.

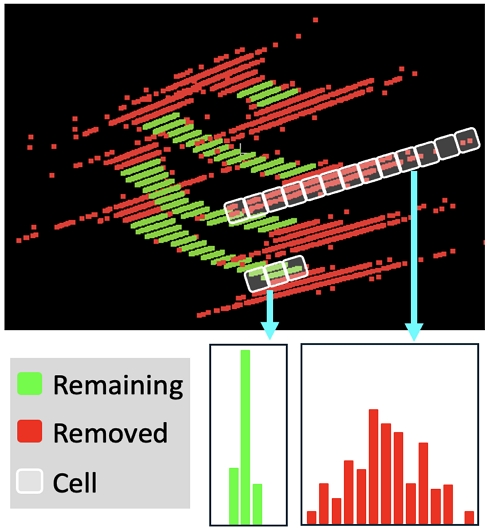

Spinning과 solid-state LiDAR의 경우, 동일한 구 표면 위치에서 반사된 점들이 노이즈로 인해 동일한 광선 방향을 따라 클러스터(Cluster)를 형성한다. 길이가 긴 클러스터는 노이즈가 심한 영역을 의미하기 때문에 제거한다. 남아 있는 각 클러스터에 대하여 동일한 크기의 셀(Cell)로 세분화하고, 각 셀 내 점들의 개수를 센다. 해당 과정은 그림 3에서 보여진다. 길이가 긴 클러스터(빨간색) 내의 점들은 클러스터 내에서 넓게 분산되어 있으며 길이가 짧은 클러스터(녹색)는 분산 정도가 작다.

그 후, 각 클러스터 내에서 셀의 빈도를 기반으로 가중합을 적용하여 대표점 그룹 pr을 생성한다:

| (2) |

여기서 N은 클러스터의 점들의 개수이며 fp는 각 셀에서 점들의 빈도를, pi는 각 셀의 위치를 의미한다. Non-repetitive LiDAR의 경우, 복셀화(Voxelization)을 적용하여 pr을 추출한다.

Sphere fitting & Center extraction− pr 중 네 개의 점들을 조합하여 나온 구의 방정식을 유도한다. 이 방정식은 다음과 같이 나타낼 수 있다:

| (3) |

그 후, 평면을 이루지 않는 조합들을 선택하여, 이 점들로부터 얻어진 구의 방정식을 행렬의 형태로 변환한다. 변환된 식은 다음과 같다:

| (4) |

식 (4)에서 는 구하고자 하는 변수들의 벡터를 의미한다. 이후, 최소제곱법(Least square method)을 사용하여 선형 방정식의 해를 구함으로써 구의 중심과 반지름을 추정한다.

| (5) |

결과적으로 얻어진 구들은 알고 있는 타겟의 반지름을 기준으로 평가되며, 각 중심점의 발생 빈도에 따라 가중합을 적용하여 최적의 중심점을 결정한다.

2.4 결과 도출

이전에 설명한 방법을 사용하여 구의 중심을 추정한 후, 최종 단계에서는 LiDAR와 카메라 간의 변환 행렬 을 결정하는 과정이 포함된다. 이를 위해, LiDAR에서 얻은 3차원 점들과 이에 대응하는 카메라에서의 2차원 점들 사이의 재투영 오류를 최소화하는 최적의 해를 도출하기 위해 Levenberg-Marquardt 최적화 방법을 적용한다:

| (6) |

여기서 는 k번째 LiDAR에서 구의 중심, 는 그에 상응하는 카메라에서 타원의 중심을 의미하며, π는 투영 함수를 의미한다. ρ는 최적화 과정 중 오류를 줄이는 데 쓰이는 robust kernel 변수이다.

Ⅲ. 실험 및 결과

3.1 실험 환경 및 센서 배치

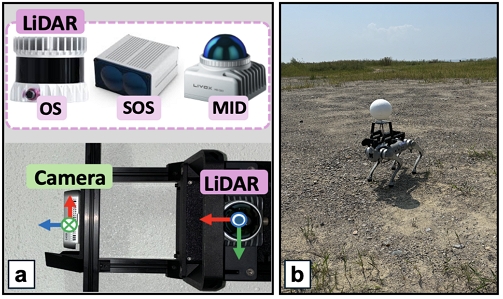

본 연구에서는 그림 4에서 나타난 것처럼 야외 환경에서 서로 다른 세 종류의 LiDAR(Ouster OS1-32, SOSLAB ML-X 120, Livox MID-360)와 한 대의 카메라(Realsense d435i)를 배치하여 본 방법론을 평가하였다. 타겟으로는 반지름 10cm의 스티로폼 구를 로봇 위에 탑재하여 사용하였다. 각 센서 조합마다 10개의 장면을 취득하였다. 결과 비교를 위해 체커보드를 사용한 MATLAB의 LiDAR-camera extrinsic calibration toolbox에서의 결과를 기준으로 삼았다.

3.2 캘리브레이션 결과 정확도 검증

비교 방법론인 [7]은 작은 구를 탐지하는 데 적합하지 않기에, 결과 비교를 위해 SAM에서의 타원 마스크 이미지와 구만 존재하는 LiDAR 데이터를 입력으로 하였으며 이를 [7]*이라 명명한다.

표 1은 각 LiDAR와 카메라에 대한 변환(Translation), 회전(Rotation), 그리고 재투영(Reprojection) 오차를 [7]*과 비교한 결과를 나타낸다. 본 방법론은 모든 평가 지표에서 오차가 감소하는 경향을 보였으며, 특히 재투영 오차가 평균 92.51% 감소하여 보다 정밀한 캘리브레이션 성능을 제공함을 확인할 수 있다.

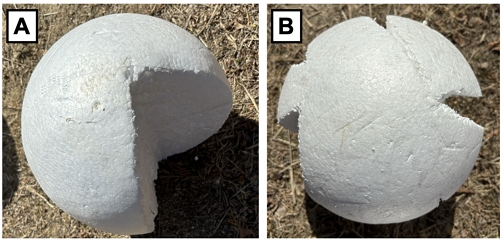

3.3 훼손된 구에서 결과 비교

본 방법론은 손상된 구에 대한 캘리브레이션의 효용성을 평가하기 위한 실험을 수행했다. 그림 5는 실험에 쓰인 두 가지 유형으로 훼손된 구를 나타낸다: Type A는 약 25%가 잘린 구이고, Type B는 여러 개의 스크래치로 덮인 구이다. 표 2는 손상된 두 개의 구에 대한 캘리브레이션 결과를 보여준다. 본 방법론은 타겟의 손상 여부와 관계없이 안정적인 변환 및 회전 값을 도출한 반면, 기존 방법은 캘리브레이션 정확도에서 변환 오차는 최대 21.7cm, 회전 오차는 최대 4.18°까지 발생하였다. 이를 통해 제안한 방법이 타겟 손상 상황에서도 높은 신뢰성을 유지하며 정확한 캘리브레이션을 수행함을 입증하였다.

Ⅳ. 향후 계획 및 결론

본 논문에서는 인간 개입이 어려운 야외 환경에서 구체 타겟을 활용하여 다중 로봇 시스템을 위한 새로운 LiDAR와 카메라 간의 외부 캘리브레이션 방법론을 제시한다.

카메라에서는 SAM과 강건한 타원 검출 알고리즘을 적용하여 로봇이 운반할 수 있도록 기존 방법론 대비 훼손 가능성이 있는 작은 구를 검출할 수 있도록 했다. 또한 LiDAR 데이터에서 구에 대한 상당한 오차가 존재하므로, 이를 고려하여 구의 중심을 정확하게 추출하기 위해 가중합 접근 방식을 도입했다.

실험을 통해 다른 방법론과 비교하여 다양한 센서 종류와 조합에서, 그리고 손상된 구에서도 정확한 캘리브레이션 성능을 입증하였다.

향후 연구에서는 로봇 간의 정보 공유를 통하여 최적의 타겟 배치를 수행하여 캘리브레이션 과정을 자동화하는 방법을 탐색할 예정이다.

Acknowledgments

본 연구는 2024년도 중소벤처기업부의 창업성장기술개발사업(RS-2024-00448695), 스마트 제조혁신 기술개발(R&D)(RS-2024-00448642) 및 2025년도 산업통상자원부의 재원으로 한국산업기술진흥원의 지원을 받아 수행된 연구임(P0017124, 2025년 산업혁신인재성장지원사업)

References

-

D. J. Yeong, G. Velasco-Hernandez, J. Barry, and J. Walsh, "Sensor and sensor fusion technology in autonomous vehicles: A review", Sensors, Vol. 21, No. 6, pp. 2140, Mar. 2021.

[https://doi.org/10.3390/s21062140]

-

X. Xu, L. Zhang, J. Yang, C. Cao, W. Wang, Y. Ran, Z. Tan, and M. Luo, "A review of multi-sensor fusion slam systems based on 3d lidar", Remote Sensing, Vol. 14, No. 12, pp. 2835, Jun. 2022.

[https://doi.org/10.3390/rs14122835]

-

D. M. Tran, N. Ahlgren, C. Depcik, and H. He, "Adaptive active fusion of camera and single-point lidar for depth estimation", IEEE Transactions on Instrumentation and Measurement, Vol. 72, pp. 1-9, Jun. 2023.

[https://doi.org/10.1109/TIM.2023.3284129]

-

Z. Huang, X. Zhang, A. Garcia, and X. Huang, "A novel, efficient and accurate method for lidar camera calibration", 2024 IEEE International Conference on Robotics and Automation (ICRA). Yokohama, Japan, pp. 513-519, Aug. 2024.

[https://doi.org/10.1109/ICRA57147.2024.10611162]

-

Y. Park, S. Yun, C. S. Won, K. Cho, K. Um, and S. Sim, "Calibration between color camera and 3d lidar instruments with a polygonal planar board", Sensors, Vol. 14, No. 3, pp. 5333-5353, Mar. 2014.

[https://doi.org/10.3390/s140305333]

-

J. Zhang, Y. Liu, M. Wen, Y. Yue, H. Zhang, and D. Wang, "L 2 v 2 t 2 calib: Automatic and unified extrinsic calibration toolbox for different 3d lidar, visual camera and thermal camera", 2023 IEEE Intelligent Vehicles Symposium (IV), Anchorage, AK, USA, pp. 1-7, Jul. 2023.

[https://doi.org/10.1109/IV55152.2023.10186657]

-

T. T´oth, Z. Pusztai, and L. Hajder, "Automatic lidar-camera calibration of extrinsic parameters using a spherical target", 2020 IEEE International Conference on Robotics and Automation (ICRA), Paris, France, pp. 8580-8586, Sep. 2020.

[https://doi.org/10.1109/ICRA40945.2020.9197316]

-

G. Zhang, K. Wu, J. Lin, T. Wang, and Y. Liu, "Automatic extrinsic parameter calibration for camera-lidar fusion using spherical target", IEEE Robotics and Automation Letters, May 2024.

[https://doi.org/10.1109/LRA.2024.3397072]

-

J. K¨ummerle, T. K¨uhner, and M. Lauer, "Automatic calibration of multiple cameras and depth sensors with a spherical target", 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Madrid, Spain, pp. 1-8, Oct. 2018.

[https://doi.org/10.1109/IROS.2018.8593955]

-

A. Kirillov, et al., "Segment anything", Proceedings of the IEEE/CVF International Conference on Computer Vision, Paris, France, pp. 4015-4026, Oct. 2023.

[https://doi.org/10.48550/arXiv.2304.0264]

2023년 3월 ~ 현재 : 인하대학교 전기컴퓨터공학과 석사과정

관심분야 : 동시적 위치추정 및 지도작성(SLAM), 이종 센서 캘리브레이션

2023년 3월 ~ 현재 : 인하대학교 전기컴퓨터공학과 석박통합과정

관심분야 : 동시적 위치추정 및 지도작성(SLAM), 다중 로봇

2024년 8월 ~ 현재 : 인하대학교 전기컴퓨터공학과 석박통합과정

관심분야 : 보행로봇 상태추정, 단일 및 다중 로봇 동시적 위치추정 및 지도작성(MRSLAM)

2015년 2월 : 한국과학기술원 전기공학과(석사)

2020년 2월 : 한국과학기술원 건설 및 환경공학과/로보틱스(박사)

2020년 2월 : 영남대학교 로봇공학과 조교수

2021년 2월 ~ 현재 : 인하대학교 전기공학과 조교수

관심분야 : 동시적 위치추정 및 지도작성(SLAM), 공간 인공지능