딥러닝 기반 1종 가축 전염병 모니터링 및 추적 시스템

초록

본 연구는 농가의 안전을 강화하고 가축 전염병 확산을 방지하기 위해 Jetson Nano 기반의 실시간 위험 요소 모니터링 및 추적 시스템을 제안한다. 이 시스템은 YOLOv7 모델을 활용하여 사람과 차량을 탐지하고, 탐지된 객체를 객체 관리 알고리즘으로 전달한다. 객체 관리 알고리즘은 사람과 차량의 객체를 추적·관리하며, 차량에 번호판 정보가 없을 경우 YOLOv8 모델을 사용한 번호판 인식 알고리즘을 통해 정보를 업데이트한다. 성능 평가 결과, Jetson Nano에서 사물 탐지 모델과 번호판 인식 모델은 각각 FPS 18.7, mAP@50 94.3%와 FPS 14.3, mAP@50 98.6%를 기록하였다. 본 시스템은 농장 출입 상황을 효과적으로 모니터링하며, 가축 전염병 확산 방지에 기여할 수 있는 실시간 대응 도구로 활용될 수 있다.

Abstract

This study proposes a real-time risk factor monitoring and tracking system based on Jetson Nano to strengthen the safety of farmers and prevent the spread of livestock infectious diseases. This system uses the YOLOv7 model to detect people and vehicles and delivers the detected objects to an object management algorithm. The object management algorithm tracks and manages objects of people and vehicles and updates the information through the license plate recognition algorithm using the YOLOv8 model if there is no license plate information in the vehicle. As a result of the performance evaluation, in the Jetson Nano, the object detection model and the license plate recognition model recorded FPS 18.7, mAP@50 94.3%, and FPS 14.3, mAP@50 98.6% respectively. This system effectively monitors the farm access situation and can be used as a real-time response tool that can contribute to the prevention of the spread of livestock infectious diseases.

Keywords:

disease tracking, object detection, smart farm, jetson nano, YOLOⅠ. 서 론

1종 가축전염병은 국가적 차원에서 강력한 방역과 관리가 요구되는 고위험성 질환으로, 발생 시 감염 가축의 대규모 살처분이 불가피하여 국내 축산업 전반에 심각한 경제적·환경적 피해를 초래한다[1][2]. 대표적인 고위험성 질환으로는 아프리카 돼지 열병(ASF, African Swine Fever), 조류인플루엔자(AI, Avian Influenza), 그리고 구제역(FMD, Foot-and-Mouth Disease)이 있으며, 이들 질병은 높은 치사율과 빠른 전파력을 특징으로 하여 효과적인 방역 대책 및 확산 방지 전략 수립이 필요하다[3][4]. 특히 축산 농가에 출입하는 인력 및 차량은 감염 경로를 복잡하게 형성하여 질병 전파 위험도를 크게 높이며, 결국 집단 폐사를 시키는 원인으로 지목 된다[2]. 이러한 상황 방지하기 위해 농가 내부로 유입되는 사람과 차량의 추적과 관리 체계가 구축되어 왔다. 기존 축산 농가에서는 수기 출입 기록 관리, RFID(Radio Frequency IDentification) 기반 자동 출입기록 관리 시스템 도입, GPS(Global Positioning System)를 활용한 차량 위치 추적 등을 통한 역학조사 방식이 시도되어 왔다[5][6]. 그러나 수기 기록 방식은 기록 관리의 효율성 및 정확성에 한계가 있으며, RFID 나 GPS 기반 시스템은 정확도가 높으나 추가 장비 설치와 이에 따른 비용 상승, 그리고 장비를 설치해야만 인식이 가능하는 문제가 있다.

본 논문에서는 딥러닝 기반 1종 가축 전염병 모니터링 및 추적 시스템을 제안한다. 구체적으로, 카메라를 통해 사람, 차량과 번호판 인식에 최적화된 YOLO(You Only Look Once) 기반 객체 탐지 알고리즘을 적용하고, 객체 추적 기법을 통해 식별된 객체를 출입 관리 시스템을 구축하였다. 또한 설치 비용 절감 및 현장 적용성을 극대화하기 위해 소형·저전력 특성을 지닌 Nvidia Jetson Nano 장비를 활용한다. 본 연구를 통해 축산 농가 현장에서 인력 및 차량의 이동에 따른 질병 전파 위험을 실시간으로 분석·관리함으로써, 가축전염병 확산 방지에 대한 예방적 조치를 강화하고 궁극적으로 국내 축산업의 안전성과 지속가능성 확보에 기여할 수 있을 것으로 기대한다.

본 논문의 구성은 다음과 같습니다. 2장에서는 관련 연구로서 YOLO 모델의 특징과 객체 추적 기법인 DeepSORT 알고리즘을 소개한다. 3장에서는 제안하는 임베디드 기반 위험 요소 탐지 시스템의 구조를 설명하고, 4장에서는 시스템에 적용된 딥러닝 모델을 상세히 다룬다. 마지막으로 5장에서는 본 연구의 결론과 향후 연구 방향을 제시한다.

Ⅱ. 관련 연구

2.1 YOLO 모델 특징

CNN(Convolutional Neural Networks) 기반 딥러닝 기술의 발전으로 1-Stage와 2-Stage 탐지기로 나뉘며 발전했다[7]. 대표적인 2-Stage 탐지기인 R-CNN 계열은 객체의 위치를 먼저 추정한 후 각 영역에서 카테고리를 분류하며, 1-Stage 탐지기는 위치 추정과 분류를 동시에 수행하여 더 빠른 추론 속도를 가진다[8]. 1-Stage 탐지기의 대표적인 모델인 YOLO 모델의 네트워크는 Backbone과 Neck 구조로 구성된다. Backbone은 이미지의 주요 특징을 추출하고, Neck은 다양한 크기의 객체를 탐지할 수 있도록 이 특징들을 결합하는 역할을 한다[9]. YOLO의 각 버전은 이 구조를 개선하며 성능을 점진적으로 향상시켜 왔습니다. YOLOv7은 Backbone에 E-ELAN (Extended Efficient Layer Aggregation Network)을 적용하여 레이어 간 특징 결합을 최적화하고, Neck에 PANet (Path Aggregation Network)을 추가하여 크기별 객체 처리 성능을 더욱 향상시켰다[10]. YOLOv8은 YOLO 시리즈 최초로 anchor-free 방식을 채택하여 모델을 단순화했고, 개선된 CSPNet(Cross Stage Partial Net)을 Backbone에 적용하여 복잡한 장면에서도 높은 정확도로 객체를 탐지할 수 있다[11].

2.2 DeepSORT

객체 추적 성능은 주로 MOTA(Multi-object Tracking Accuracy)를 통해 평가되며, False Positive, False Negative, Identity Switches를 종합적으로 고려해 정확도를 측정한다[12]. SORT(Simple Online and Realtime Tracking)는 칼만 필터와 헝가리안 알고리즘을 기반으로 한 실시간 추적 기법으로, 간단하고 빠르지만 유사한 객체가 겹치거나 가려지는 상황에서는 추적 성능이 저하되는 문제가 있다[13].

이를 보완하기 위해 DeepSORT는 객체의 appearance 정보를 신경망 기반 특징 벡터로 매칭하는 방식을 도입하여 MOTA를 대폭 개선하였다. 사람 추적에서 DeepSORT는 긴 시간 동안 일관된 추적이 가능하며, ID 변경 횟수를 45% 줄여 기존 SORT 대비 더 나은 성능을 보여주었다.

Ⅲ. 임베디드 기반 위험 요소 탐지 시스템

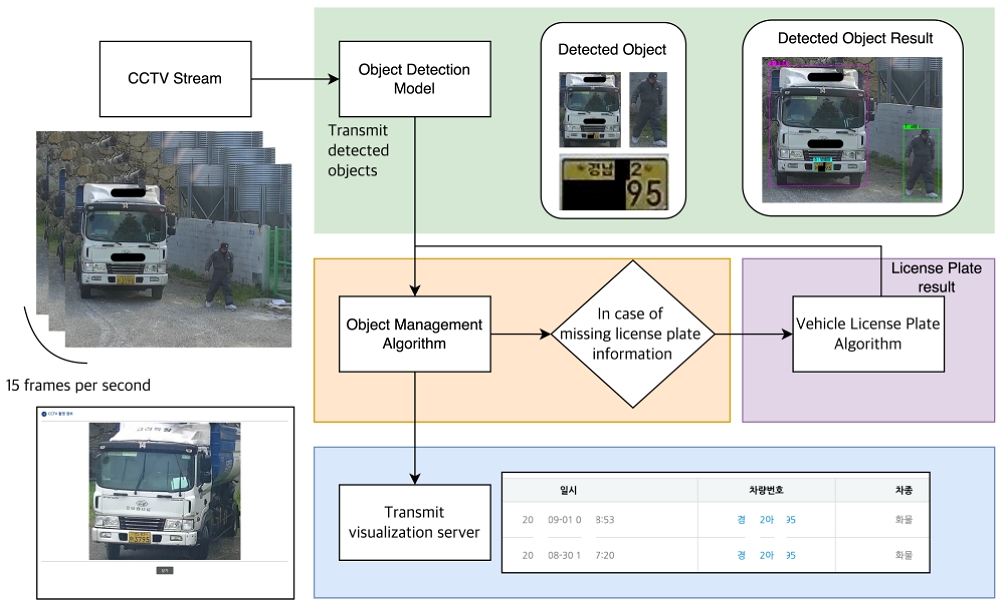

본 논문에서는 임베디드 기반 위험 요소 인식 시스템을 구축하기 위해 사물 탐지 모델, 번호판 분류 알고리즘, 객체 관리 알고리즘을 개발하였다. 개발한 모델은 Jetson Nano와 같은 리소스 제약 환경에서도 안정적으로 작동할 수 있도록 TensorRT를 활용해 최적화를 하였다. 이러한 시스템은 CCTV(Closed Circuit Camera)로부터 입력된 영상을 통해 축사에 출입한 사람과 차량을 실시간 모니터링 후 시각화 서버에 전송하여 농장 출입 상황을 실시간으로 관리한다. 시스템의 전체 과정은 그림 1과 같다.

본 실험에서는 축사 출입구 근처에 CCTV를 설치하여 사람과 차량의 출입을 모니터링한다. CCTV는 초당 30프레임의 영상을 수집하지만, 출입하는 객체의 최대 속도(시속 30km)를 고려하여 1초에 15프레임 단위로 영상을 처리한다. 영상이 입력되면, YOLO 기반의 사물 탐지 모델이 사람, 번호판, 그리고 5종의 차량을 포함한 7가지 객체를 탐지한다.

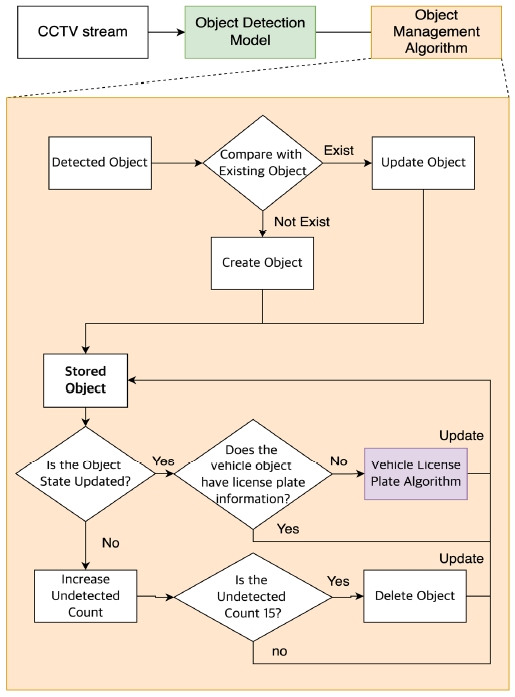

탐지된 객체 정보는 객체 관리 알고리즘에 전달되어, 매 프레임 유사한 객체는 단일 객체로 식별하고 관리한다. 동일한 객체가 다수의 프레임에서 중복 등록되는 문제를 방지하기 위해 DeepSORT를 기반으로 알고리즘을 설계하였으며, 이를 통해 식별의 정확성을 유지하고 관리 데이터를 최적화할 수 있다. 차량에 번호판 정보가 없을 경우, 차량과 번호판이 얼마나 겹치는지 계산하고, 겹침이 기준을 넘으면 번호판 정보를 업데이트하기 위해 차량 번호판 인식 알고리즘에 번호판을 입력으로 한다. 또한, 프레임 단위로 객체 상태를 주기적으로 확인해 일정 횟수 동안 미탐지된 객체는 자동으로 삭제함으로써 추적 데이터의 정확성과 효율성을 유지한다. 객체 정보에 대한 과정은 아래 그림 2와 같다.

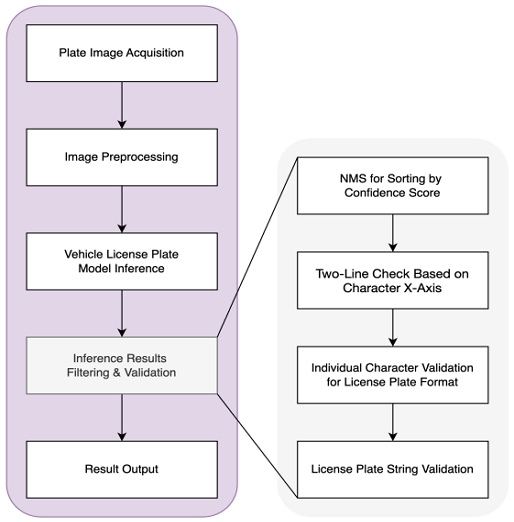

차량 번호판 인식 알고리즘은 차량 번호판 이미지를 입력받아 번호판 문자열을 추출하는 과정으로, 전처리, 추론, 필터링, 검증 단계를 거친다. 입력된 이미지는 모델에 적합한 형식으로 변환된 후 번호판 문자와 같은 객체를 탐지하며, 신뢰 점수를 기준으로 NMS(Non-Maximum Suppression)를 적용하여 중복된 객체를 줄인다. 이후, 남은 문자들의 x축 위치를 분석하여 번호판이 한 줄인지 두 줄인지 확인하고, 각 문자가 번호판 규격에 맞는지 개별적으로 검증하여 형식에 맞지 않는 문자는 교체 또는 삭제한다. 마지막으로, 전체 번호판 문자열의 유효성을 확인한 후 최종 결과를 반환한다. 차량 번호판 인식 알고리즘에 대한 흐름도는 그림 3과 같다.

Ⅳ. 실 험

4.1 사물 탐지 모델 실험 및 평가

사물 탐지 모델(#1) 데이터는 총 7가지로 분류한다. <자동차관리법시행규칙 2조>에 따라 차량을 승용차, 승합차, 화물차, 특수차, 이륜차 5개와 번호판, 사람을 포함한 2개로 분류한다. 데이터의 수집은 돈사 내 주간 및 야간 CCTV 및 드론 촬영 데이터(5,614장), 웹 크롤링(1,616장), 공개 데이터(25,798장) 를 바탕으로 데이터 증강 기법 중 이미지 플립, 여러 이미지를 합성하는 방법 등을 사용하여 생성한 데이터 103,800장을 포함하여 총 136,828장을 학습에 사용했다.

본 연구에서는 사물 탐지 모델은 사람, 차종에 맞는 차량과 번호판 7가지를 탐지하는 모델로 구성하며, Jetson Nano와 같은 임베디드 환경에서 실시간 추론이 원활하게 이루어질 수 있도록 YOLOv7-tiny, YOLOv8n 두 가지 경량화 모델을 비교했습니다. 각 모델의 추론 속도(Frame Per Second, FPS)는 제안한 시스템에서 전처리와 후처리는 병렬 쓰레드로 동작하므로, 추론 과정에서의 계산 성능을 기준으로 측정하였다. 또한, 모델의 지표는 mAP(Mean Average Precision) 중 mAP@50, mAP@75, F1 score를 사용한다.

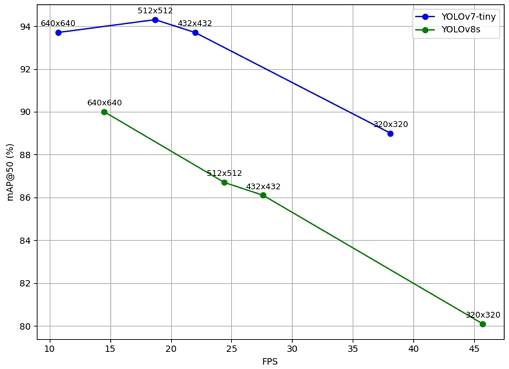

모델선정기준은 Jetson Nano 환경에서 실시간 처리를 보장하기 위해 FPS가 15 이상일 때 가장 높은 정확도를 보이는 모델이다. 이 기준에 따라YOLOv8n 모델이 최종적으로 선정하였다.

Jetson Nano 환경에서 수행한 실험 결과는 위 표 1과 같다. YOLOv7-tiny은 이미지 크기가 512 × 512 일 때 mAP@50 94.3%, mAP@75 84.1%, 그리고 F1 score 87.6% 기록했으며, FPS는 18.7으로 Jetson Nano 환경에서 실시간 처리요건을 충족하여 선정하였다. 아래 그림 4는 모델에 입력 크기에 따른 FPS와 mAP@50 변화를 시각적으로 나타낸다.

4.2 차량 번호판 모델 실험 및 평가

차량 번호판 인식 모델의 학습을 위해 주간 및 야간 CCTV 및 드론 촬영 데이터, 임의의 숫자·문자 조합을 생성한 데이터, 그리고 번호판에 사용되는 글자체를 기반으로 생성한 문자열과 번호판도 합쳐 데이터셋 구성한다. 생성한 번호판 데이터셋은 2003년부터 2024년까지 발급된 각 번호판 양식을 반영하여 년도 별 번호판 데이터를 추가한다. 데이터셋은 총 90개 클래스로 구성되며, 이는 숫자 10개(0~9), 문자 44개(가, 나, 다 등), 지역 명 34개(서울, 대전, 부산 등)와 테두리 1개로 구성한다. 총 93,714장의 이미지가 수집 및 생성되었으며, 이 중 실제 번호판 데이터 1717장과 생성한 문자열 12,000장과 생성된 번호판 79,997장을 포함합니다. 데이터는 학습 70%, 검증 20%, 평가 10%의 비율로 분할하여 사용하였으며, 검증 및 평가 과정에서는 수집한 실제 데이터만을 활용해 모델의 성능을 평가한다. 번호판 탐지 모델의 성능 지표는 모델의 추론 속도인 FPS와 성능 지표인 mAP@50을 기준으로 비교한다.

위 표 2는 YOLOv7은 mAP 98.7%와 FPS 5.1로 성능이 높으나, 실시간 처리에는 다소 제한이 있다. 반면, YOLOv8은 mAP 98.6%와 FPS 14.3로 YOLOv7과 비슷한 정확도를 나타내며 처리속도는 2배이상 빠르다. 이처럼 YOLOv8은 높은 mAP@50과 안정적인 FPS를 통해 농장과 같은 열악한 환경에서도 번호판 인식을 신속하고 정확하게 수행할 수 있다. 이에 따라 본 연구에서는 YOLOv8 모델로 번호판 인식 모델을 구축한다.

Ⅴ. 결론 및 향후 과제

본 연구에서는 저비용 카메라와 Jetson Nano를 활용한 딥러닝 기반 임베디드 위험 요소 인식 시스템을 제안하고, 이를 통해 가축 질병 확산 방지 및 방역 체계 강화를 위한 접근법을 제시한다. 제안된 시스템은 YOLO v7 모델을 활용한 사물 탐지 모델과 YOLO v8s 모델을 기반인 차량 번호판 인식 알고리즘으로 구성되며, 두 모듈은 효율적인 객체 관리 알고리즘에 의해 통합적으로 운영된다.

객체 관리 알고리즘은 사물 탐지 모델을 통해 탐지된 객체인 사람, 차량을 실시간으로 추적하며, 탐지된 객체 중 번호판 정보가 없는 경우, 차량 번호판 이미지를 차량 번호판 인식 알고리즘으로 전달한다. 차량 번호판 인식 알고리즘은 번호판을 탐지하고 차량 객체 정보에 번호판 정보를 업데이트하여 객체 정보가 일관되게 추적할 수 있도록 설계되었다.

이를 통해 시스템은 다양한 환경에서 객체 탐지와 번호판 인식을 효과적으로 수행하며, 객체의 상태와 위치를 지속적으로 관리할 수 있다.

한돈혁신센터 테스트베드에서의 검증 결과, 본 시스템은 실제 농장 환경에서도 안정적으로 작동하며, 실시간 탐지를 기반으로 가축 질병 예방과 방역 활동의 효율성을 크게 향상시킬 수 있음을 확인하였다. 특히, 제안된 시스템은 농가에서 쉽게 도입 가능하며, 비용 대비 높은 효과를 제공함으로써 국가 방역 체계 강화와 축산업의 안정성 및 생산성 향상에 기여할 수 있다.

향후 연구에서는 모델 성능을 더욱 개선하고, 다양한 환경에서도 시스템이 안정적으로 작동할 수 있도록 확장 연구를 진행할 예정이다. 이를 통해 농가 현장에서의 실제 활용성을 극대화하고, 가축 질병 관리를 위한 기술적 기반을 지속적으로 강화해 나갈 것이다.

Acknowledgments

본 결과물은 농림축산식품부 및 과학기술정보통신부, 농촌진흥청의 재원으로 농림식품기술기획평가원과 재단법인 스마트팜연구개발사업단의 스마트팜다부처패키지혁신기술개발사업의 지원을 받아 연구되었음(421042-04)

References

-

J. Rushton, P. K. Thornton, and M. J. Otte, "Methods of economic impact assessment", Revue scientifique et technique (International Office of Epizootics), Vol. 18, No. 2, pp. 315-342, Jun. 1999.

[https://doi.org/10.20506/rst.18.2.1172]

-

B. Noh, Z. Xu, J. Lee, D. Park, and Y. Chung, "Keyword Network Based Repercussion Effect Analysis of Foot-and-Mouth Disease Using Online News", Journal of Korean Institute of Information Technology, Vol. 14, No. 9, pp. 143-152, Sep. 2016.

[https://doi.org/10.14801/jkiit.2016.14.9.143]

-

S. Nampanya, L. Rast, and P. A. Windsor, "Assessment of farmer knowledge of large ruminant health and production in developing village-level biosecurity in northern Lao PDR", Transboundary and emerging diseases, Vol. 57, No. 6, pp. 420-429, Dec. 2010.

[https://doi.org/10.1111/j.1865-1682.2010.01168.x]

-

S. Costard, B. Wieland, and L. K. Dixon, "African swine fever: how can global spread be prevented?", Philosophical transactions of the Royal Society of London. Series B, Biological sciences, Vol. 364, No. 1530, pp. 2683-2696, Sep. 2009.

[https://doi.org/10.1098/rstb.2009.0098]

-

M. Jeong, I.-H. Jang, and Y. Choe, "Network Analysis of Swine Farms and Slaughters: Based on Automobile GPS Data", Journal of the Korean Cartographic Association, Vol. 19, No. 1, pp. 69-79, Apr. 2019.

[https://doi.org/10.16879/jkca.2019.19.1.069]

-

H.-J. Kim, H.-S. Jun, and B. K. Yu, "Developement of a RFID Enterance Control System for Biosecurity of Pig Farm", Journal of the Korea Contents Association, Vol. 20, No. 3, pp. 31-40, Mar. 2020.

[https://doi.org/10.5392/JKCA.2020.20.03.031]

-

Z. Zou, K. Chen, and J. Ye, "Object Detection in 20 Years: A Survey", Proc. of the IEEE, Vol. 111, No. 3, pp. 257-276, Mar. 2023.

[https://doi.org/10.1109/JPROC.2023.3238524]

-

A. Bisht, K. Ravani, and S. Tiwari, "Indigenous Design of a Traffic Light Control System Responsive to the Local Traffic Dynamics and Priority Vehicles", Computers & Industrial Engineering, Vol. 171, pp. 108503, Sep. 2022.

[https://doi.org/10.1016/j.cie.2022.108503]

-

J. Redmon, S. Divvala, and A. Farhadi, "You Only Look Once: Unified, Real-Time Object Detection", Proc. of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA, Vol. 1, pp. 779-788, Jun. 2016.

[https://doi.org/10.1109/CVPR.2016.91]

-

Junhee Lee, Jisang You, and Kyoungson Jhang, “Marine Ship Detection based on Enhanced YOLOv7 for Unmanned Surface Vehicles”, The Journal of Korean Institute of Information Technology, Vol. 22, No. 2 pp. 9-20, Feb. 2024

[https://doi.org/10.14801/jkiit.2024.22.2.9]

- D. Reis, J. Kupec, and A. Daoudi, "Real-Time Flying Object Detection with YOLOv8", arXiv preprint, arXiv:2305.09972, , May 2023. https://arxiv.org/abs/2305.09972, .

-

N. Wojke, A. Bewley, and D. Paulus, "Simple Online and Realtime Tracking with a Deep Association Metric", Proc. of the IEEE International Conference on Image Processing (ICIP), Beijing, China, pp. 3645-3649, Sep. 2017.

[https://doi.org/10.1109/ICIP.2017.8296962]

-

A. Bewley, Z. Ge, and B. Upcroft, "Simple Online and Realtime Tracking", Proc. of the IEEE International Conference on Image Processing (ICIP), Phoenix, AZ, USA, pp. 3464-3468, Sep. 2016.

[https://doi.org/10.1109/ICIP.2016.7533003]

2024년 8월 : 국립한밭대학교 컴퓨터공학과(공학사)

2024년 8월 ~ 현재 : 한국전자통신연구원 위촉연구원

관심분야 : 머신러닝, 사물인터넷, 엣지 컴퓨팅

2018년 2월 : 서울시립대학교 건축공학(공학사)

2020년 2월 : 서울시립대학교 건축공학(공학석사)

2023년 8월 : 서울시립대학교 건축공학(공학박사)

2023년 8월 ~ 현재 : 한국전자통신연구원(박사후연수연구원)

관심분야 : 건물 에너지, 실내 환경 모델링, 스마트팜, 딥러닝

1999년 : 경북대학교 전자공학과(학사)

2001년 : 경북대학교 전자공학과(석사)

2012년 : 충남대학교 전파공학과(박사)

2001년 ~ 현재 : 한국전자통신연구원 책임연구원

관심분야 : 머신러닝, 사물인터넷, 엣지 컴퓨팅