정밀한 다중언어 OCR을 위한 파이프라인

초록

본 논문에서는 효과적인 다중언어 OCR(Optical Character Recognition)을 수행하기 위한 최적의 파이프라인을 제안한다. 기존 연구들은 단일 언어 데이터를 대상으로 OCR을 수행해 왔다. 이 과정에서 이미지는 먼저 탐지 모델에 입력되어 영역을 식별 후, 이 영역을 인식 모델로 전달하여 텍스트 문장을 추출한다. 하지만 이 방식은 단일 언어 OCR 네트워크에 국한되어 있어, 다양한 언어에 대한 데이터는 처리하지 못한다는 한계가 있었다. 이에 본 논문에서는 각 언어에 대한 특성을 고려한 언어 분류 모델을 기존 모델에 통합하고, 이를 기반으로 언어별 독립적 인식 모델을 구성한 다중언어 OCR이 가능한 방법론을 개발하였다. 제안하는 파이프라인은 실험을 통해 다중언어 데이터에 대해 정량적 및 정성적으로 우수한 성능을 확인하였다.

Abstract

This paper proposes an optimal pipeline for effective multilingual Optical Character Recognition(OCR). Previous research has focused on performing OCR on single-language data. In this process, images are first input into a detection model to identify regions, which are then passed to a recognition model to extract text sentences. However, this approach is limited to single-language OCR networks and cannot process data in various languages. To address this limitation, we integrated a language classification model, which considers the characteristics of each language, into the existing model and developed a methodology for multilingual OCR by constructing independent recognition models for each language. The proposed pipeline was experimentally validated, demonstrating superior quantitative and qualitative performance on multilingual data.

Keywords:

deep learning, computer vision, optical character recognition, transformerⅠ. 서 론

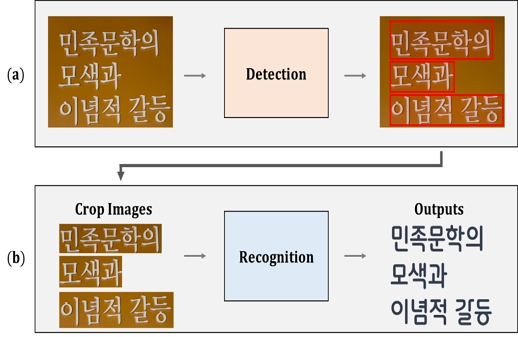

한 이미지에서 각각의 텍스트의 문장을 인식하는 것(OCR, Optical Character Recognition)은 컴퓨터 비전에서 오랫동안 관심의 대상이 되어왔다. 최근 딥러닝의 발전으로 다양한 환경에서 OCR이 높은 정확도로 감지 및 인식이 가능하게 되었으며 특히 자율 주행, 도로의 표지판 인식, 문서 인식 등의 분야에서 많은 연구 관심을 이끌고 있다. 이러한 OCR의 일반적인 접근 방식은 서로 다른 두 가지 하위 문제로 분할하고, 파이프라인으로 연결한다[1]-[7]. 먼저, 입력 이미지를 그림 1(a)에서와 같이 텍스트 탐지 모델에 입력하여, 이미지 텍스트를 다각형의 형태의 크롭 이미지들로 반환한다. 그 후에, 크롭 이미지들을 그림 1(b)와 같이 텍스트 인식 모델에 입력하여 각각 크롭 이미지들을 최종적인 텍스트의 문장으로 변환한다.

위와 같이 탐지 및 인식의 두 가지 단계로 나누어 각각의 네트워크를 따로 구성하고 연결하는 파이프라인으로 한 이미지에서 각각의 텍스트에 대한 문장을 인식하는 OCR을 성공적으로 가능하게 되었다.

하지만 이러한 방식은 대부분 영어 데이터를 기반으로 한 단일 언어 OCR 네트워크로 구성되어 있으며, 다양한 언어에 대한 데이터가 입력으로 주어졌을 때 각각 언어의 특성을 고려하지 못해 정밀한 OCR을 할 수 없다는 제한점이 있다[7]-[9]. 최근에는 도로의 표지판, 문서, 자막 등의 데이터에서 그림 2와 같이 다중언어가 혼합된 경우가 많고, 이에 따라 단일 언어에 대한 네트워크를 구성하는 것을 넘어 다중언어를 정밀하게 처리할 수 있는 OCR 네트워크 개발에 대한 필요성이 대두되고 있다[10].

이에 본 논문에서는 각 언어의 특성을 적절하게 고려하고, 다중언어를 정밀하게 처리할 수 있는 최적의 파이프라인을 제안한다. 본 논문에서 제안하는 파이프라인의 핵심은 기존 탐지 모델에서 탐지된 크롭 이미지를 바로 인식 모델에 입력하는 것이 아니라, 두 단계 사이에 각 이미지의 언어를 분류하는 모델의 추가하는 것이다. 이 언어 분류 모델을 통해 각 크롭된 이미지에 대한 각각의 언어를 분류함으로써, 크롭 이미지들이 언어별로 독립적인 텍스트 인식 모델을 구성할 수 있다. 예를 들어, 한국어 영어 두 개의 언어가 있다면 텍스트 인식 모델은 언어별 독립적으로 구성되어 2개가 된다. 이러한 구조로 텍스트 인식 모델은 언어별 집중 학습이 이루어지고, 세 가지 단계로 구성된 다중언어 파이프라인(텍스트 탐지, 언어 분류, 언어별 독립적인 텍스트 인식)을 구성함으로써, 기존 다중언어 OCR에 대한 제한점을 해결하였다.

Ⅱ. 관련 연구

딥러닝이 발전함에 따라 OCR의 연구 또한 활발하게 발전되고 있다.

일반적인 접근 방식은 탐지와 인식 두 가지 하위 문제로 나누어 진행하는 방식으로 대부분의 연구가 진행되고 있으며, M. Fujitask[2]는 사전 훈련된 생성형 언어 모델을 활용하고, Transformer의 디코더만 사용하여 텍스트를 성공적으로 인식하였다. J. Chen et al.[3]은 텍스트에 중점을 둔 프레임워크인 Scene Text Telescope로 초고해상도 이미지를 생성하는 방법을 제안하였다. D. Yu et al.[4]은 RNN 기반 방법을 사용하여 의미 정보를 모델링하고 정확한 이미지 텍스트를 인식하기 위해 GSRM(Glocal Semantic Reasoning Module)을 도입하였다. C. Luo et al.[5]은 이미지에서 불규칙한 텍스트를 정정하기 위해 Multi-Object Rectified Attention Network를 제안하였고, 불규칙한 장면을 모두 정규화 시켰다. B. Shi et al.[6]은 이미지 흐림, 불균일한 조명 및 문자 등의 제약을 극복하기 위해 기존의 ASTER(Attentional Scene Text Recognizer with Flexible Rectification) 네트워크를 통합하여 저품질 텍스트 이미지에 더 강력한 네트워크를 구성하였다[7].

이처럼 최근 OCR에 대한 많은 연구가 이루어지고 있지만, 주로 단일 언어에 대해서 탐지 및 인식에 초점이 맞추어져 있다. 이러한 단일 언어에 대한 OCR 네트워크에 다른 언어를 대입하면, 언어별 특징 때문에 인식 정확도가 급격하게 감소한다[11]. 최근 한 문서 이미지 내에 여러 언어가 혼재된 경우는 더러 있으며, 이러한 경우에 기존 네트워크를 사용하기엔 제한점이 존재한다.

따라서, 다중언어가 포함된 이미지에서도 OCR을 정확히 인식할 수 있는 네트워크가 필요하다.

Ⅲ. 제안된 네트워크

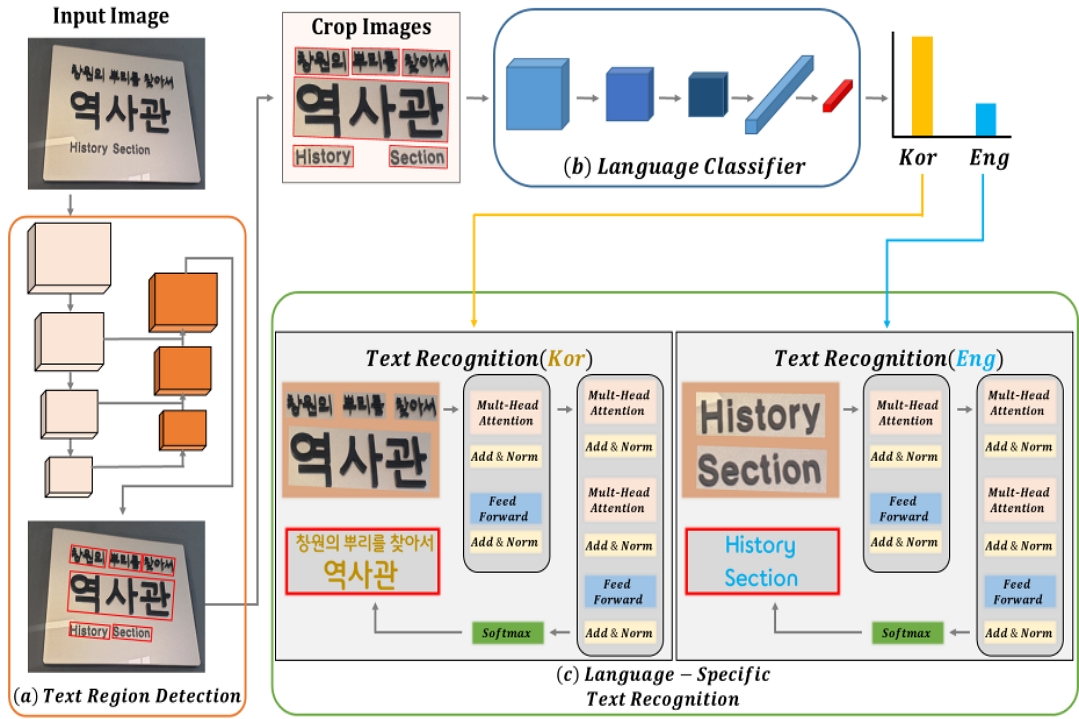

본 논문에서는 기존 단일 언어 중심의 네트워크 아키텍처를 넘어서 정밀한 다중언어 처리가 가능한 최적화된 파이프라인을 제안한다. 이 파이프라인은 세 가지 주요 단계로 구성된다:

텍스트 영역 탐지: 먼저, 그림 3(a)와 같이 이미지 내의 텍스트 영역을 식별하기 위해 객체 탐지(Object detection) 모델을 사용한다. 여기서 이미지는 텍스트가 포함된 영역별로 크롭된다.

Optimized pipeline structure for multilingual optical character recognition (a) Text region detection, (b) Language classifier, (c) Language-specific text recognition

언어 분류: 크롭된 텍스트 이미지들은 그림 3(b)에서 보여지는 바와 같이 언어 분류 단계로 전달된다. 이 단계에서는 각 텍스트 이미지가 한국어 또는 영어 인지를 결정하기 위해 이미지 분류를 수행하는 딥러닝 네트워크(Backbone)가 활용된다.

언어별 텍스트 인식: 마지막으로, 그림 3(b)에서 분류된 텍스트 이미지들은 각각 독립적으로 그림 3(c)의 텍스트 인식 모델에 입력된다. 이 단계에서는 각 이미지로부터 텍스트의 문장을 추출하여 반환한다.

위 과정은 한국어와 영어 두 가지 언어에 대한 예시이며, 언어의 개수에 따라 언어 분류 모델(Backbone)의 레이블 수와 언어별 텍스트 인식 모델의 수를 증가시킴으로써 다양한 언어로 쉽게 확장할 수 있다. 이렇게 각 언어에 맞춰 독립적으로 설계된 텍스트 인식 모델은 서로 다른 가중치를 적용함으로써, 학습의 수렴 속도와 최적화 과정을 가속화하는 이점을 가진다.

본 논문을 통해 제시된 파이프라인은 다양한 언어를 효과적으로 처리할 수 있는 OCR 인식 기능을 구현함으로써, 기존의 단일 언어 중심 방법론의 한계를 극복하였다. 이 파이프라인은 다양한 언어 환경에 유연하게 적응할 수 있는 능력을 제공하며, 언어별로 특화된 모델과 가중치를 적용함으로써 이미지 내 텍스트 처리의 정확도와 효율성을 크게 향상시키는 데 중요한 역할을 한다.

Ⅳ. 실 험

본 논문에서 제안된 다중언어 텍스트 인식 네트워크에 대한 성능 평가를 위해, 다양한 소스에서 수집된 데이터 세트를 활용한다. 이 데이터 세트는 생활, 문화, 공공, 동영상 번역 자막에서 추출된 것으로 한국어, 영어, 중국어, 일본어로 총 네 가지 언어로 구성되어 있다. 수집된 데이터는 중복 제거, 개인정보 검사, 라벨링의 정확을 고려하여 철저히 정제되었고, 약 400K개의 학습 샘플, 약 40K개의 검증 샘플로 구성되어 있다. 제안된 파이프라인의 성능 평가의 지표로 F1-Score를 사용하여, 이러한 방법을 통해 본 파이프라인의 범용성과 정확성을 심도 있게 검증하고자 한다.도 있게 검증하고자 한다.

먼저, 제안된 파이프라인에서 첫 번째 텍스트 영역 탐지에 사용된 모델은 현재 OCR에서 높은 정확도와 프레임 속도(FPS)를 가지는 FAST를 사용한다[12].

다음으로, 언어 분류 모델은 한국어, 중국어, 영어, 일본어 4가지 언어의 분류 작업을 수행한다. 이를 위해, 총 5가지 백본 네트워크(ResNet, Vision Transformer, EfficientNet, InternImage, ConvNext)들의 파라미터 및 정확도에 대해 비교 실험을 진행하였으며, 표 1은 이에 대한 결과이다[13]-[17].

정확도 수치는 ViT(Vision Transformer)가 96.2%로 가장 높은 성능을 기록하였다. 하지만, 4가지 언어에 대한 단순한 분류 작업이므로, 모든 모델에 대한 성능 차이는 ViT와 비교했을 때 순서대로 0.4%, 0.3%, 1.4%, 0.2% 차이로 대개 비슷하다. 본 논문에서는 이 비슷한 정확도 사이에 압도적으로 낮은 파라미터를 가져 가장 좋은 Trade-Off 관계에 있는 ResNet을 언어 분류 모델로 선정하였다.

마지막으로, 언어별 텍스트 인식 모델로 장기 의존성을 가져 시계열 분석에 장기 의존성 처리 능력을 갖춘 Transformer 계열의 Encoder와 Decoder를 활용한다[18]. Transformer Encoder의 모델로는 Transformer 구조의 효율성을 유지하면서도 처리 속도를 향상시키기 위해 Shifted Window 기법을 적용한 Swin Transformer 모델을 사용하였다.

반면, Decoder 부분에는 심플한 Transformer Decoder 구조를 채택하여 전체 모델의 성능과 효율성을 균형 있게 조율하였다[19].

표 2는 위와 같이 구성된 파이프라인과 기존 파이프라인의 한국어, 영어, 중국어, 일본어로 구성된 다중언어 데이터 세트에서의 비교 실험이다.

Comparative experiments with the addition of existing pipelines and language classification models for the proposed pipeline

제안된 파이프라인은 기존 모델보다 F1-Score 기준 12.4% 성능 향상을 확인할 수 있다. 기존 OCR 모델은 언어 탐지 모델에서 크롭된 텍스트 문장을 인식하는 모델에서 언어에 대한 구분이 명확하지 않다. 그러므로 인식 과정에서 언어에 대한 모호성이 생기고 언어별 정밀한 OCR을 하지 못한다는 제한점이 존재한다. 반면, 이미지 분류 모델을 추가한 파이프라인은 인식 과정에서 언어에 대한 모호성이 생기지 않아 다중언어 OCR에 적합하다는 것이 실험 결과로 입증되었다.

본 논문은 이러한 정량적인 결과뿐만 아니라, 그림 4와 같이 시각적인 결과도 볼 수 있다. 그림 4는 한국어, 영어, 중국어, 일본어로 4가지 언어가 혼용된 데이터에 대해 OCR을 수행한 것이며, 모든 언어에 대해 정밀한 탐지 및 인식을 가능하게 함을 볼 수 있다.

위와 같이 정량적 및 정석적인 결과로 미루어 보아 기존 파이프라인에서 언어 분류 모델을 추가한 것과 각 언어별 텍스트 인식 모델을 독립적으로 구성한 것이 다중언어 OCR의 정밀한 인식을 위한 측면에서 더 유리하다는 것을 알 수 있다.

V. 결 론

본 논문에서는 탐지 및 인식의 파이프라인으로 이루어져 단일 언어 OCR에만 초점이 맞추어져 있는 기존 네트워크에 언어 분류 모델을 추가함으로써 효과적인 다중언어 OCR을 가능하게 하였다. 언어 분류 모델은 다중언어 데이터 세트에 대해 여러 백본 모델의 파라미터 및 정확도에 대한 비교 실험으로 최적의 언어 분류 모델을 선정하였으며, 각 언어에 따른 독립적인 언어별 텍스트 인식 모델을 구성함으로써 더욱 정밀한 다중언어 OCR이 가능하게 되었다. 본 논문에서 총 4가지의 언어에 대해서만 실험을 진행하였으나 다른 추가적인 언어에 대해서도 독립적인 언어별 인식 모델을 추가로 구성함으로써 쉽게 확장할 수 있는 유연성이 있다.

Acknowledgments

본 논문은 2024년도 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 기초연구사업이며(No. 2022R1A6A1A0305295413)임

References

-

S. Kim, J. Park, S. kim. Y. Na, and Y. Jang, "Multi-book Label Detection Model using Object Detection andOCR", ArXiv preprint ArXiv:2308.15996v1, , Journal of KIIT, Vol. 21, No. 2, pp. 1-8, Feb. 2023.

[https://doi.org/10.14801/jkiit.2023.21.2.1]

-

M. Fujitask, "DTrOCR: Decoder-only Transformer for Optical Character Recognition", ArXiv preprint ArXiv:2308.15996v1, , Aug. 2023.

[https://doi.org/10.48550/arXiv.2308.15996]

-

J. Chen, B. Li, and X. Xue, "Scene Text Telescope: Text-Focused Scene Image Super-Resolution", in Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition(CVPR), Nashville, TN, USA, pp. 12026-12035, Jun. 2021.

[https://doi.org/10.1109/CVPR46437.2021.01185]

-

D. Yu, X. Li, C. Zhang, T. Liu, J. Han, J. Liu, and E. Ding, "Towards Accurate Scene Text Recognition with Semantic Reasoning Networks", in Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition(CVPR), pp. 12113-12122, Jul. 2020.

[https://doi.org/10.48550/arXiv.2003.12294]

-

C. Luo, L. Jin, and Z. Sun, "MORAN: A Multi-Object Rectified Attention Network for scene text recognition", Pattern Recognition, Vol. 90, pp. 109-118, Jun. 2019.

[https://doi.org/10.48550/arXiv.1901.03003]

-

B. Shi, M. Yang, X. Wang, P. Lyu, C. Yao, X, and X. Bai, "ASTER: An Attentional Scene Text Recognizer with Flexible Rectification", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 41, No. 9, pp. 2035-2047, Sep. 2019.

[https://doi.org/10.1109/TPAMI.2018.2848939]

-

Z. Qiao, Y. Zhou, D. Yang, Y. Zhou, and W. Wang, "SEED: Semantics Enhanced Encoder-Decoder Framework for Scene Text Recognition", in Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition(CVPR), pp. 13528-13537, Jul. 2020.

[https://doi.org/10.48550/arXiv.2005.10977]

-

M. Jaderberg, K. Simonyan, A. Vedaldi, and A. Zisserman, "Reading text in the wild with convolutional neural networks", International journal of computer vision, Vol. 116, pp. 1-20, May 2015.

[https://doi.org/10.48550/arXiv.1412.1842]

-

D. Karatzas, L. G. Bigorda, A. Nicolaou, S. Ghosh, A. Bagdanov, M. Iwamura, J. Mataas, L. Neumann, V. R. Chandrasekhar, S. lu, F. Shafait, S. Uchida, and E. Valveny, "ICDAR 2015 competition on Robust Reading", International Conference on Document Analysis and Recognition (ICDAR), Tunis, Tunisia, pp. 1156-1160, Aug. 2015.

[https://doi.org/10.1109/ICDAR.2015.7333942]

-

A. Risnumawan, P. Shivakumara, C. S. Chan, and C. L. Tan, "A robust arbitrary text detection system for natural scene images", Expert Systems with Applications, Vol. 41, No. 18, pp. 8027-8048, Dec. 2014.

[https://doi.org/10.1016/j.eswa.2014.07.008]

-

Z. Qiao, Y. Zhou, D. Yang, Y. Zhou, and W. Wang, "Multilingual OCR Research and Applications: An Overview", in Proc. of the International Workshop on Multilingual OCR, Washington, USA, pp. 1-8, Aug. 2013.

[https://doi.org/10.1145/2505377.2509977]

-

Z. Chen, J. Wang, W. Wang, G. Chen, E. Xie, P. Luo, and T. Lu, "FAST: Faster Arbitrarily-Shaped Text Detector with Minimalist Kernel Representation", ArXiv preprint ArXiv:2111.02394, , Nov. 2021.

[https://doi.org/10.48550/arXiv.2111.02394]

-

K. He, X. Zhang, S. Rsn, and J. Sun, "Deep Residual Learning for Image Recognition", in Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition(CVPR), Las Vegas, USA, pp. 770-778, Jun. 2016.

[https://doi.org/10.48550/arXiv.1512.03385]

-

A. Dosovitskiy, L. Beyer, A. Kolesnikov, D. Weissenborn, X. Zhai, T. Unterthiner, M. Dehghani, and M. Minderer, "An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale", in Proc. of International Conf. on Learning Representations(ICLR), pp. 770-778, Las Vienna, Austria, May 2021.

[https://doi.org/10.48550/arXiv.2010.11929]

-

M. Tan and Q. V. Le, "EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks", in Proc. of International Conf. on Machine Learning(ICML), Long Beach, USA, pp. 6105-6114, Jun. 2019.

[https://doi.org/10.48550/1905.11946]

-

W. Wang, J. Dai, Z. Chen, Z. Huang, Z. Li, X. Zhu, X. Hu, T. Lu, L. Lu, H. Li, X. Wang, and Y. Qiao, "InternImage: Exploring Large-Scale Vision Foundation Models with Deformable Convolutions", in Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition(CVPR), Vancouver, Canada, pp. 14408-14419, Jun. 2023.

[https://doi.org/10.48550/arXiv.2211.05778]

-

Z. Liu, H. Mao, C. Y. Wu, C. Feichtenhofer, T. Darrell, and S. Xie, "A ConvNet for the 2020s", in Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition(CVPR), Louisiana, New Orleans, pp. 11976-11986, Jun. 2022.

[https://doi.org/10.48550/arXiv.2201.03545]

-

A. Vaswani, N. Shazeer, N. Parmar, J. Uszkoreit, L. Jones, A. N. Gomez, L. Kaiser, and I. Polosukhin, "Attention Is All You Need", in Proc. of the Conf. on Neural Information Processing Systems(NIPS), Long Beach, USA, pp. 6000-6010, Dec. 2017.

[https://doi.org/10.48550/arXiv.1706.03762]

-

Z. Liu, Y. Lin, Y. Cao, H. Hu, Y. Wei, Z. Zhang, S. Lin, and B. Guo, "Swin Transformer: Hierarchical Vision Transformer using Shifted Windows", in Proc. of the IEEE/CVF International Conf. on Computer Vision (ICCV), pp. 10012-10022, Jul. 2021.

[https://doi.org/10.48550/arXiv.2103.14030]

2023년 : 인제대학교 컴퓨터공학부(공학사)

2022년 ~ 현재 : 포항공과대학교 인공지능연구원 연구부 연구원

관심분야 : Object detection, Monocular depth estimation, Semantic segmentation

2010년 : 성균관대학교 전기전자컴퓨터공학과(공학박사)

2011년 ~ 2015년 : 대구 경북 과학 기술원 IT 융합 연구부 선임연구원

2015년 ~ 2015년 : 동서대학교 컴퓨터공학부 조교수

2016년 ~ 현재 : 포항공과대학교 인공지능연구원 연구부 연구부장

관심분야 : Computer vision, Face recognition, Deep learning

1996년 : Georgia Institute of Technology 컴퓨터공학(공학박사)

2016년 ~ 2020년 : 포항공과대학교 정보통신연구소 소장

1988년 ~ 현재 : 포항공과대학교 컴퓨터공학과 교수

관심분야 : AI, IoT, Action recognition, Indoor positioning

2020년 ~ 2020년 : 포항공과대학교 PMC 연구실 연구원

2020년 : 부산대학교 전자공학과(공학석사)

2020년 ~ 현재 : 포항공과대학교 인공지능연구원 연구부 연구원

관심분야 : Data restoration, DL/ML, Image processing, Signal processing