로봇 작업장 환경의 작업자 안전 시스템 개발

초록

공장의 생산 라인에 다양한 로봇들이 점점 더 적용됨으로 로봇 작업 환경에서 작업자의 안전이 더 중요하게 고려되고 있다. 본 연구는 이러한 작업 공간에 대한 실시간 모니터링을 통하여 작업자 안전을 제공할 수 있는 안전 시스템의 개발을 목표로 하였다. 안전 시스템의 구현은 여러 대의 카메라를 여러 방향에 설치하여 사각지대 없이 작업 환경을 실시간으로 촬영하였으며 실제 상황에서의 물체 검출에 많이 쓰이는 YOLO 알고리즘을 사용하여 작업자에 대한 검출을 수행하였다. 본 논문에서는 검출 위치 마스크와 작업 영역 마스크 설정 방법을 제시하고 이를 이용한 안전 감지 방법을 제안하였다. 로봇 작업 환경을 구성하고 획득한 영상을 통하여 작업자 검출 성능을 평가하였고 실제 작업 환경에서의 감지 성능을 확인하였다. 여러 대의 카메라를 사용하는 경우, 구현된 시스템은 보다 안정적으로 작업자의 안전을 제공하였다.

Abstract

Various robots are increasingly being applied to production lines in factories, and the human safety is considered more important in robot work-places. This study aimed at developing a safety system that can provide the human safety through real-time monitoring of work-places. The safety system was implemented by installing multiple cameras in multiple directions to capture the working environment in real time without blind spots, and the detection of human was performed using the YOLO algorithm, which is widely used for object detection in real situations. This paper presents methods for setting the position mask and the zone mask, and proposes a method of safety detection using the settings. The robot work environment was configured, the performance to detect human was evaluated through the acquired images and the performance of the safety system was confirmed. In the case of using multiple cameras, the implemented system provided human safety more reliably.

Keywords:

safety system, robot safety system, human safety, YOLO, YOLO v2, deep-learning, CNNⅠ. 서 론

최근에 인공지능의 발전과 더불어 공장 작업 환경에서 작업자의 안전을 위한 시스템이 작업 환경에 따라 부분적으로 감지 센서 등을 활용해 이루어지던 부분에서 카메라와 인공지능을 활용하여 전반적인 작업 환경으로 확장되어지고 있다. 공장 작업 환경 내의 작업자의 안전을 확인하기 위하여 우선 작업자를 인식해야 하며 이를 위하여 카메라를 통하여 영상을 촬영하고 영상에서 컴퓨터 비전을 통하여 작업자를 인식하거나 딥러닝 기반으로 작업자를 인식하여야 한다.

기존의 알고리즘은 영상내의 특징 기반으로 하여 물체를 검출하는 방법으로 SIFT(Scale Invariant Feature Transform)나 HOG(Histogram of Gradient) 알고리즘 등이 있으나 검출 성능에서 한계를 가지고 있다[1][2]. 기존 알고리즘의 한계를 극복하기 위하여 딥러닝 기법을 사용하여 성능의 한계를 보완하는 연구로 이어졌다[3]. 하드웨어의 발전과 딥러닝 기술의 발전으로 등장한 R-CNN(Region-CNN) 알고리즘은 영상의 후보영역을 만들고 이에 대한 CNN을 사용하여 분류하는 알고리즘이다[4]. 이는 객체 검출(Object detection)을 다중 레이블 분류(Multiple label classification)과 바운딩 박스 회귀(Bounding box regression)으로 정의 할 수 있으며 어떤 물체가 있는지 분류하고 분류된 객체의 바운딩 박스(Bounding box)를 파악하는 위치 식별(Localization) 과정으로 검출하게 된다. 이러한 검출 과정을 한 번에 수행하는 검출기로 YOLO나 멀티스케일 특징 계층과 앵커박스(Anchor box)를 사용한 SSD가 있으며, 두 번에 나눠서 처리하는 R-CNN 계열 검출기로 나누어진다[5][6]. 속도 및 성능 향상을 위한 ROI(Region of Interest) Pooling과 Selective Search 기법을 사용한 Fast R-CNN이나 여기에 다양한 바운딩 박스를 가진 앵커박스를 도입한 Faster R-CNN이 있다[7][8]. 그리고 객체 매스킹을 하기 위하여 FPN(Feature pyramid network)과 ROI align 기능이 추가된 Mask R-CNN이 있다[9].

공장 작업 환경은 다양한 분야에서 공장 자동화 및 무인화를 위하여 로봇을 산업 현장에 매우 빠르게 적용하고 있다. 이로 인하여 로봇 작업을 지원하는 작업, 로봇 작업과 연계되는 작업, 또는 로봇을 유지/보수하는 작업 등으로 작업자의 역할이 확장되어지고 있다. 따라서 로봇의 작업 환경 내의 작업자 안전이 매우 중요하게 고려되어지고 있으며 이를 위한 시스템들이 개발되어지는 추세이다.

본 논문에서는 로봇 작업 환경 내의 작업자 안전에 대한 실시간 모니터링 시스템으로 실시간 작업 안전을 제공할 수 있는 안전 시스템의 개발을 목표로 하였다. 구현된 안전 시스템은 사각지대를 피하기 위하여 여러 대의 카메라를 여러 방향에 설치하여 작업환경을 촬영하였으며 YOLO v2 알고리즘을 사용하여 작업자를 검출하였고 검출된 작업자의 작업 안전 영역 침범 여부를 판단하여 로봇에 신호를 보내는 방법으로 안전 시스템을 구성하였다. 로봇 작업 환경을 구성한 환경에서의 실험을 수행하였으며 작업자의 작업 동작 및 작업 안전 영역 침범에 대한 검출 유/무에 대한 판별로 안전 시스템의 성능을 평가하였다. 2장에서는 작업자 검출에 사용되는 일반적인 YOLO 알고리즘과 이의 원리에 대해 서술하고, 3장에서는 구현된 시스템의 구조, 작업자에 대한 검출 위치에 대한 설정 방법, 작업 안전 영역 설정 방법에 대하여 기술하였다. 4장에서는 실제 제품 구성을 위한 사양을 구성하고 안전사고를 방지하기 위하여 검출 시간 0.5초를 기준으로 정하여 적용 가능한 YOLO 알고리즘의 성능을 확인하였다. 로봇 작업 환경을 구성한 환경에서의 실험을 통하여 작업자의 작업 동작 및 작업 안전에 대한 작업자 검출 성능을 평가하였다. 작업 환경 영상에 대한 YOLO v2, YOLO v3 및 로봇 클래스를 추가하여 학습한 YOLO v2+에 대해 로봇 작업 환경에서의 작업자 검출 성능을 비교하였다. 또한 구현된 시스템은 작업자 안전 감지를 안정적으로 수행하는 것을 확인하였다. 이어서 5장에서는 구현된 안전 시스템에 대한 평가 및 결론을 내리고 향후 과제에 대해 기술하였다.

Ⅱ. YOLO 알고리즘

최근에는 딥러닝 기반 물체 검출 방법의 발전으로 높은 성능의 영상 인식을 보여주고 있으며 대표적인 CNN(Convolution Neural Network) 알고리즘에대한 다양한 연구가 이어지고 있다.

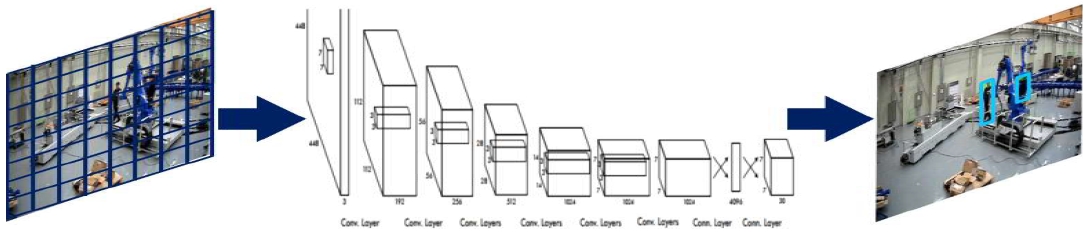

YOLO(You Only Look Once) 알고리즘은 객체 후보들에 대한 분류 정보의 중복처리에 파이프라인 구조를 가지고 각 개별 요소들이 각각 학습되므로 연산량이 많은 문제를 단일 망에서 처리되도록 연구들이 진행되었다. YOLO 알고리즘의 동작을 간략하게 그림 1에 나타내었다. YOLO 알고리즘은 바운딩 박스(Bounding box) 예측 방식으로서 동작은 우선 입력이미지를 격자(Grid)로 분할하고, 격자 셀을 기반으로 객체를 탐지한다. 객체의 중심이 격자 셀(Grid Cell)에 맞으면 격자는 객체를 탐지했다고 표기하고, 각 격자 셀은 B개의 바운딩 박스와 각 바운딩 박스에 대한 신뢰 값(Confidence score)를 예측한다. 각 격자 셀은 바운딩 박스 외에도 클래스 확률을 예측하고 NMS(Non-Max Suppresision)을 거처 최종 바운딩 박스를 선정한다.

YOLO v1의 경우, 속도가 매우 빠르고 YOLO는 이미지 전체를 사용함으로 인하여 제한된 영역을 사용하는 Fast R-CNN에 비해 배경이미지를 잘못 인식하는 오류를 줄였다. 전체 이미지에 대해 학습함으로 좋은 성능을 보인다. 그러나 각 격자 셀은 하나의 클래스만 예측하기 때문에 객체가 겹쳐있다면 문제가 발생한다. 새로운 독특한 형태의 바운딩 박스의 경우 정확한 예측이 어려운 단점을 가진다.

YOLO v1이 2016년 발표된 이후로 성능을 개선하고 속도를 높인 YOLO v2가 2017년 발표되었으며 YOLO v3는 네트워크 구조와 학습방법을 개선하여 객체 검출의 정확도와 속도를 모두 개선하였다. 이후 지속적인 연구가 이어졌으며 YOLO v8에서 통합 프레임워크 구축으로 이어졌다[10].

Ⅲ. 제안된 작업 안전 시스템

본 논문에서는 실제 로봇 작업 환경에 적용할만한 시스템을 목표로 작업자의 작업 안전을 확보하기 위한 안전 시스템을 구현하였다. 우선 로봇 작업 환경에서의 기구물 간섭 등에 대한 미검출 상황을 피하기 위하여 여러 대의 카메라로 다양한 각도에서 촬영하여 작업자를 검출함으로써 작업자 안전을 최대한 확보할 수 있도록 하였다.

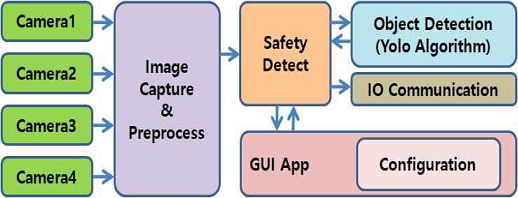

제안된 작업 안전 시스템의 구조는 그림 2에 나타내었다. 그림 2를 살펴보면 최대 4대의 카메라로부터 영상을 획득하고 이 획득한 영상에 대한 작업자의 로봇 작업영역 접근 상태를 판단하는 안전 검출을 수행하고 검출 결과에 대한 IO 통신을 하게 된다. IO 통신의 경우, 직접적인 IO 입출력 신호를 전달하거나 설비/로봇과 통신으로 IO 신호를 전달하게 된다. 안전 검출에서 작업자를 검출하는 알고리즘은 검출 정확도가 높고 실시간 검출을 위해 속도가 빠른 YOLO 알고리즘을 사용하였다. 그리고 안전 검출을 위한 영역 설정은 어플리케이션에서 GUI 환경에서 설정하게 된다.

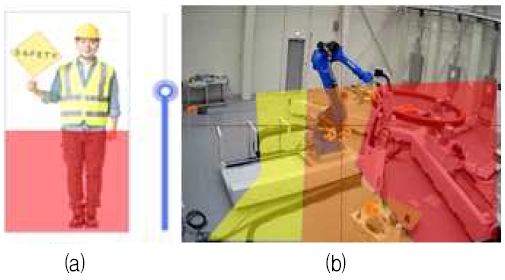

그림 3은 GUI 환경에서 기본적인 위치 마스킹 및 영역 마스킹 설정을 보여준다. 위치 마스킹은 검출된 작업자의 영역에서 작업자 위치로 반영할 범위를 마스킹한 것이고 영역 설정은 작업자의 위험지역을 마스킹 한 것이다.

그림 3(a)는 스크롤바를 이용하여 바운딩 박스의 하단부의 범위 영역을 지정하였으며 그림 3(b)는 3단계 영역을 설정한 것으로 영상에 대한 매스킹이나 폴리곤 영역을 그려서 지정한 알람 영역, 경계 영역, 및 비상 영역을 설정한 것이며 설정되지 않은 영역은 안전 영역이라고 할 수 있다. 작업자의 위치가 검출된 영역에 맞는 IO 통신을 하게 된다.

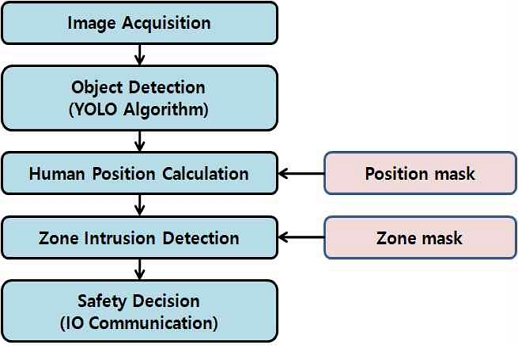

그림 4는 안전 검출 방법을 나타낸 것으로 작업자 검출은 시스템 성능에 맞추어 적절한 YOLO 알고리즘을 적용하여 수행한다. 검출된 객체 중에 작업자에 대한 검출을 목록화하고 이 목록에 대한 검출 위치는 설정된 위치 마스크를 적용하여 위치 영역으로 얻어진다. 작업자 검출 위치와 위에 설정된 위험 영역의 침범을 검사하게 된다. 안전 결정에서 영역 침범이 발생하면 가장 높은 단계의 침범을 우선하여 결정하고 이에 따른 IO 통신을 수행하게 된다.

구현된 시스템의 성능 평가는 이진 분류의 예측 오류가 얼마인지 혹은 어떠한 유형의 예측 오류가 발생하는지를 나타내는 지표이며, 실제 클래스와 예측 클래스에 대한 TN(True Negative), FN(False Negative), FP(False Positive), TP(True Positive)로 나타낸 오차행렬을 사용하였다. 오차행렬에 대한 정밀도(Precision) 및 재현율(Recall)을 식 (1)과 같이 나타낼 수 있다.

| (1) |

검출 결과에 대해 Confidence 임계값에 따른 정밀도-재현율 변화를 살펴보면, 임계값이 낮으면 정밀도가 낮아지고 재현율이 올라간다. 그러나 임계값이 높으면 정밀도가 높아지고 재현율이 낮아짐을 알 수 있다. 즉, 정밀도와 재현율은 상대적인 지표를 가지고 있음을 알 수 있다. 따라서 두 가지 지표를 모두 고려한 성능 지표로 AP(Average Precision)을 계산하여 검출 성능을 평가하게 된다.

AP의 계산은 Confidence 임계값에 따른 정밀도와 재현율로 정밀도-재현율 그래프를 나타낼 수 있으며 이 그래프의 면적을 AP라고 하며 이를 다음과 같이 나타낼 수 있다.

| (2) |

여기서 N은 그래프의 면적을 구하기 위하여 나누어진 영역 개수이다. P(k)는 k번째 영역의 정밀도 값이고 ΔR(k)는 k번째 영역의 재현율 폭 값이다.

성능 평가는 실제 로봇 작업 환경에서 획득한 영상에 대한 작업자의 검출 유무만을 판단하고 검출 성능으로 AP를 측정하였다. 여러 대의 카메라를 사용함으로 하나의 카메라가 가지는 작업자 검출 성능을 상호 보완함으로 작업자 감지 능력을 개선하게 된다.

Ⅳ. 구현 및 고찰

제안된 시스템의 목표는 실제 현장에 적용하기 위한 제품 기준으로 시스템의 사양을 정하였다. 시스템의 CPU는 Intel i9-10885H CPU @ 2.4GHz로 GPU는 NVIDIA Geforce 1650Ti 프로세서로 선정하였다.

그리고 메모리는 DDR4 16G를 설치하고 저장장치 SSD 256G를 설치하였다. OS는 Window 10이며 CUDA 10.2 라이브러리와 CUDNN 7.6.5가 설치되었다.

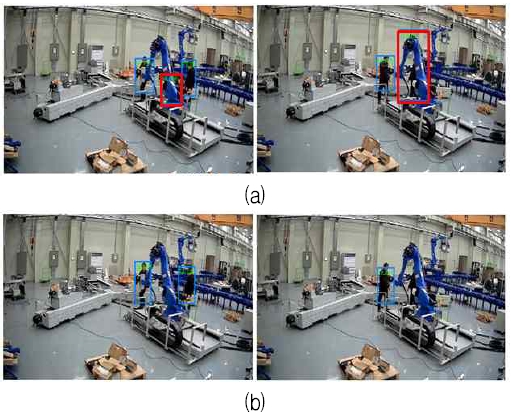

적용된 YOLO 알고리즘은 공개된 YOLOv2와 YOLO v3를 사용하였다. 그리고 자체적으로 로봇 클래스를 추가하여 학습한 YOLO v2+는 150장 정도의 로봇 영상을 임의로 구성하여 VOC 2007+2012 데이터 셋과 함께 학습하여 적용하였다. 그림 5에 학습용으로 사용된 로봇 영상들에 대한 예를 나타내었다. 그리고 기존의 YOLO v2와 새로 학습한 YOLO v2+에 대한 검출 결과를 그림 6에 나타내었다.

YOLO v2에서 로봇을 사람으로 검출한 바운딩 박스(적색)이 YOLO v2+에서 더 이상 검출되지 않는 것을 확인할 수 있다.

구현된 시스템에서 획득한 영상에 대해 YOLO v2, YOLO v3, YOLO v2+를 적용한 경우, 처리 시간은 평균적으로 89.2[ms], 266.7[ms], 103.5[ms]가 소요되는 것을 확인하였다. YOLO v3 는 여러 대의 카메라에 대해 500[ms]이하의 실시간 응답이 어려워보이지만 YOLO v2는 가능하다.

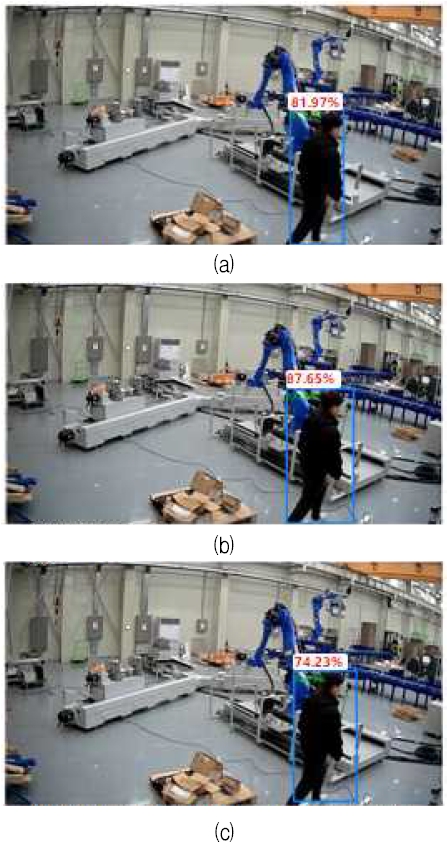

성능을 평가하기 위하여 작업자 2명이 로봇에 접근하여 로봇 작업영역에서 대기하는 시나리오의 영상으로는 500[ms]마다 녹화하여 YOLO v2, YOLO v3, YOLO v2+에 대해 적용하였으며 검출 실험을 그림 7에 나타내었다.

우선 작업자가 기구물에 간섭되었지만 조금 보이는 경우와 간섭되어 구분이 어려운 경우, 전자는 작업자가 있는 것으로 후자는 작업자가 없는 것으로 가정하였다. 그리고 작업자가 있는 위치에 대해 잘못된 박스 영역을 가진 중복 검출은 오검출로 처리하고 간섭영역을 많이 가진 잘못된 검출도 역시 오검출로 판단하였다. 그리고 2분간 녹화된 60장의 영상에 적용하여 각각의 AP를 계산하였다. YOLO v2 및 YOLO v3는 각각 0.76, 0.97로 나타났으며 YOLO v2+는 0.80로 나타났다.

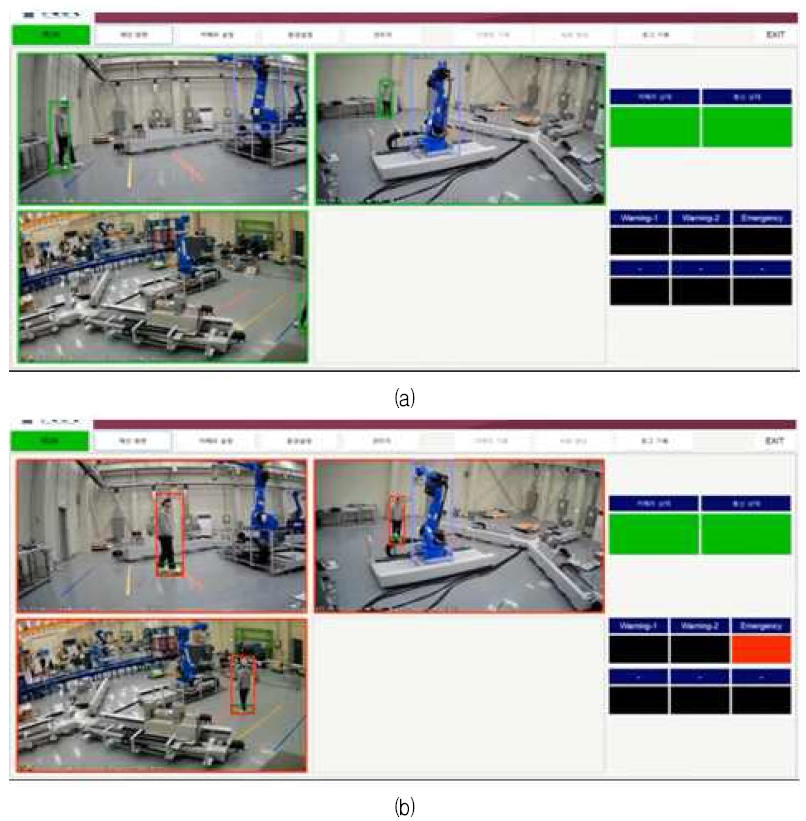

제안된 시스템은 실제 로봇 환경과 유사한 실험 환경에서 다양한 작업자의 움직임에 대해 실험하였고, 상호 보완된 시야를 가지는 여러 대의 카메라를 사용하여 실험을 진행하였다. 그림 8은 구현된 시스템에서 안전 영역에서 작업자 감지와 위험 영역에서 작업자 감지를 수행하는 상태를 나타낸 것이다. 설정된 영역에 진입하는 다양한 작업자의 움직임에 대해 작업자를 성공적으로 모두 감지하였다. 로봇의 전/후방에 설치된 2대의 카메라만 적용한 100회 이상의 실험에서도 위험 지역의 작업자 감지를 모두 성공함으로 구현된 시스템이 작업자 안전을 안정적으로 제공함을 확인할 수 있었다.

Ⅴ. 결 론

본 논문은 로봇 작업환경에서 작업자의 안전을 확보하기 위한 안전 시스템을 구현한 것으로 기구물 간섭 등의 사각지대를 피하기 위하여 여러 대의 카메라를 여러 방향에 설치하여 작업 환경을 실시간으로 촬영하였으며 최근에 많이 사용되는 YOLO 알고리즘을 통하여 작업자 검출을 수행하였고 검출된 작업자에 대한 검출 위치 설정 방법, 작업 안전 영역 설정 방법 등을 제안하였다.

로봇 작업 환경을 구성한 환경에서의 실험을 통하여 YOLO 알고리즘의 검출 성능을 평가하였다. YOLO 알고리즘의 VOC 2007+2012 데이터 셋에 대한 검출 성능과 실제 현장에 대한 작업자 검출 성능을 비교하여 확인할 수 있다. 구성된 실험 환경에서 다양한 작업 움직임에 대한 감지 실험을 통하여 제안된 시스템은 작업 안전을 안정적으로 제공함을 확인하였다.

작업 환경에서 로봇을 작업자로 오검출하거나 작업자에 대한 적절하지 않은 박스 영역을 가진 중복 검출 등의 문제점도 확인하였다. YOLO 알고리즘에 클래스 수 및 다양한 작업 현장에 맞는 학습 데이터들을 재구성하여 기존의 검출 성능을 개선하기 위한 연구를 이어가고자 한다.

Acknowledgments

이 연구는 금오공과대학교 대학 연구 과제비로 지원되었음(2022~2023)

References

-

Y. Feng, X. An, and X. Liu, "The application of scale invariant feature transform fused with shape model in the human face recognition", 2016 IEEE Advanced Information Management, Communicates, Electronic and Automation Control Conference (IMCEC), Xi'an, China, pp. 1716-1720, Oct. 2016.

[https://doi.org/10.1109/IMCEC.2016.7867511]

-

O. Deniz, G. Bueno, J. Salido, and F. D. Torre, "Face recognition using Histograms of Oriented Gradients", Pattern Recognition Letters, Vol. 32, No. 12, pp. 1598-1603, Sep. 2011.

[https://doi.org/10.1016/j.patrec.2011.01.004]

-

J. Kim, "A Study on the Performance Improvement of Pallet Positioning System using Deep Learning", Journal of KIIT, Vol. 19, No. 8, pp. 11-16, Aug. 2021.

[https://doi.org/10.14801/jkiit.2021.19.8.11]

-

R. Girshick, J. Donahue, T. Darrell, and J. Malik, "Region-based Convolutional Networks for Accurate Object Detection and Segmentation", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 38, No. 1, pp. 142-158, Jan. 2016.

[https://doi.org/10.1109/TPAMI.2015.2437384]

-

J. Redmon, S. Divvala, R. Girshick, and Ali Farhadi, "You Only Look Once: Unified, Real-Time Object Detection", 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pp. 779-788, Jun. 2016.

[https://doi.org/10.1109/CVPR.2016.91]

-

W. Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C. Y. Fu, and A. C. Berg, "SSD: Single Shot MultiBox Detector", 2016 European Conference on Computer Vision (ECCV), Vol. 9905, pp. 21-37, Sep. 2016.

[https://doi.org/10.1007/978-3-319-46448-0_2]

-

R. Girshick, "Fast R-CNN", 2015 IEEE International Conference on Computer Vision (ICCV), pp. 1440-1448, Dec. 2015.

[https://doi.org/10.1109/ICCV.2015.169]

-

S. Ren, K. He, R. Girshick, and J. Sun, "Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 39, No. 6, pp. 1137-1149, Jun. 2017.

[https://doi.org/10.1109/TPAMI.2016.2577031]

-

K. He, G. Gkioxari, P. Dollar, and R. Girshick, "Mask R-CNN", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 42, No. 2, pp. 386-397, Feb. 2020.

[https://doi.org/10.1109/TPAMI.2018.2844175]

-

M. Hussain, "YOLO-v1 to YOLO-v8, the Rise of YOLO and Its Complementary Nature toward Digital Manufacturing and Industrial Defect Detection", Machines, Vol. 11, No. 7, p. 677, Jun. 2023.

[https://doi.org/10.3390/machines11070677]

1996년 2월 : 금오공과대학교 전자공학과(공학사)

1998년 2월 : 금오공과대학교 대학원 전자공학과(공학석사)

2016년 2월 : 금오공과대학교 대학원 전자공학과 (공학박사)

2017년 9월 ~ 현재 : (주)신세계엔지니어링 연구소장

관심분야 : 컴퓨터비전, 영상처리, 임베디드, 자동화

2022년 2월 : 호서대학교 융합기술학과(공학사)

2023년 8월 ~ 현재 : 호서대학교 대학원 나노융합기술학과 공학석사과정

2019년 6월 ~ 현재 : (주)아라 대표이사

관심분야 : 로봇, 경영학, 자동화, 안전 시스템

1992년 2월 : 금오공과대학교 전자공학과(공학사)

1996년 2월 : 금오공과대학교 대학원 산업경영학과(경영학석사)

2010년 2월 : 금오공과대학교 대학원 산업경영학과(경영학박사)

2016년 ~ 2017년 : 3D 프린팅 산업협회장

2014년 ~ 현재 : 금오공과대학교 IT융합학과 교수

관심분야 : 산업조직, HRD, 리더십, 3D 프린팅