키넥트를 활용한 동작 인식 기반 전시 콘텐츠 제작 기법

초록

본 논문은 전시를 체험하는 관람자들이 기획자의 의도와 작품에 대해 몰입할 수 있도록 동작 인식 기술을 활용하여 인터랙티브 전시 콘텐츠를 제작하였다. 관객이 동작 인식 기술을 통해 작품의 의도를 충분히 체험하였는지를 확인하기 위해 전시 콘텐츠를 구현하고 관객의 체험 전, 후의 설문조사를 통해 이를 검증하고자 하였다. 전시 콘텐츠는 관객의 동작을 인식하기 위해 Kinect V2 센서를 사용하였고, Unity를 이용하여 동작 인식 정보를 활용하여 전시 콘텐츠를 제작하였다. 구현된 전시 콘텐츠를 통해 관객의 체험 전, 후를 비교 설문조사를 수행하였고, 수행된 설문조사를 통해 체험 후 관객의 전시 콘텐츠에 대한 긍정적인 반응이 향상된 것을 확인하였다.

Abstract

This paper produces interactive exhibition contents using motion recognition technology so that visitors experiencing the exhibition can immerse themselves in the planner's intentions and works. In order to confirm whether the audience fully experienced the intention of the work through motion recognition technology, exhibition contents were implemented and verified through surveys before and after the audience's experience. Exhibition contents was created using the Kinect V2 sensor to recognize the behavior of the audience, and using Unity, exhibition contents was produced using motion recognition information. Through the implemented exhibition contents, a comparative survey was conducted before and after the audience's experience, and the survey conducted confirmed that positive responses to the audience's exhibition contents after the experience were improved.

Keywords:

Kinect, unity, interactive media art, motion recognitionⅠ. 서 론

4차 산업혁명은 디지털 혁명을 기반으로 개인만이 아닌 사회, 기업, 경제 등 모든 것들이 다양한 과학기술과 융합하며 그들의 패러다임 전환을 유도한다. 최근의 예술은 시공간적 경계를 뛰어넘어 문화 소통의 영역을 확장하고 있다. 디지털 영상기술과 결합하거나 인공지능을 활용하여 빠른 속도로 문화창작의 범위를 넓히고 있으며, 시간적·공간적·경제적 접근성을 확대함으로써 서로 다른 표현과 소통 방식의 융합이 이루어지고 있다[1].

이러한 바탕으로 발생한 인터랙티브 미디어아트는 사용자와 작품 사이를 소통할 수 있는 새로운 방식의 전시 체험을 제시한다. 미디어아트 전시 콘텐츠 기획자는 기획 의도에 따라 작품을 제작하고, 관객은 작품 속 담긴 의미를 상호작용을 통해 알게 된다[2][3]. 동작 인식 기술은 이러한 전시 콘텐츠에서 기획자의 의도를 관객의 행동에 따라 다양한 형태로 표현할 수 있으므로 상호작용을 효과적으로 구현할 수 있다[4][5]. 따라서 본 논문에서는 동작 인식 기술을 통해 미디어아트에서 작품의 의도와 방향을 관객이 더 몰입할 수 있는 전시 콘텐츠를 구현하고자 한다.

본 논문에서 사용자의 움직임을 추적하는 Kinect V2 센서와 동작 인식과 미디어 융합을 위해 필요한 여러 효과를 구현하고 보여줄 수 있는 Unity를 중심으로 동작 인식 기반 인터랙티브 미디어아트 전시 콘텐츠 제작 기술을 제안한다. 또한, 본 동작 인식 기술을 실제 전시에 적용하여 사용자들에게 설문조사를 통해 기술이 관객의 전시 관람에 긍정적 영향을 줄 수 있음을 검증한다.

Ⅱ. 관련 연구

2.1 동작 인식 전시 사례 연구

동작 인식 기반 전시 콘텐츠는 주로 영상기술과 함께 관객의 움직임에 따른 시각적, 청각적 요소가 적용된다. 이를 적극적으로 사용한 몇 가지 미디어아트 사례를 살펴보고, 그 특징을 분류하여 본 논문에서 구현할 동작 인식 전시 콘텐츠에 적용한다.

그림 1은 한창민과 유선웅으로 구성된 인터랙티브 미디어 아티스트 그룹 하이브(HYBE)가 제작한 <Iris>라는 작품으로 센서를 통해 관객의 움직임을 포착하여 원형 패턴으로 영상을 송출하는 미디어 캔버스 작품이다[6]. 이 작품은 빛과 관련된 주변 환경의 특성이 모두 반영되는 수용성과 포괄성이 높은 작품이며, 그 공간에 자리한 사람들의 모습을 비춘다는 점에서 거울이라는 특성도 가지게 된다.

그림 2의 리메오 리(Rimeo Lee)의 작품 <Return to me>로 작가 자신의 감정을 센서를 통해 인터랙티브 영상 작품으로 표현한다[7]. 영상 배경의 선들은 시계의 초침처럼 회전한다. 회전하는 선들 앞으로 관객이 지나가면 시간 간격을 두고 잔상을 남기며 관객의 형태가 나타난다. 형체의 색과 잔상들을 통해 현대인의 우울한 심리 상태를 나타내고 있다.

그림 3은 미국의 아티스트 골란 레빈(Golan levin)이 제작한 단편 조각 전시로 몸짓과 그림자로 만들어지는 인터랙티브 미디어 아트이다[8]. 관람자가 본인 손이나 머리를 사용하거나 두 명이 함께 이어진 형태를 만들어내면 소리가 발생한다. 이 작품은 인식하지 못하고 있던 공간을 인식할 때 창조력이 발생한다는 의미를 내포하고 있다.

앞에서 언급한 사례인 Iris(2012), Return to me(2019), Interstitial fragment processor(2007)들을 각각 사례 1, 사례 2, 사례 3으로 구분하고 작품들의 동작 인식을 활용하여 표현된 방식을 분석하고 이를 본 논문의 전시 콘텐츠에 적용할 수 있는 방안을 설명한다.

표 1의 사례 1에서 표현방식은 카메라를 통해 관객의 움직임을 포착하여 해당 공간과 관객의 모습을 원형 패턴의 이미지로 나타낸다. 이 방식을 발전시켜 관객의 실루엣을 단순히 비추는 것이 아니라 동작 인식이 가능한 3D 아바타로 변경하여 적용하고자 한다.

사례 2는 배경의 회전하는 선들 앞으로 관객이 지나가면 관객의 동작을 따라 잔상이 나타난다. 이 방식을 변형하여 작품 공간 안에 관객을 따라 나타난 3D 아바타가 관객의 동작에 따라 잔상이 생기도록 표현한다. 사례 3은 관객의 특정 행동이 수행되었을 때 특정 효과음을 나타내는 방식으로 표현되지만 이를 바탕으로 제작할 전시 콘텐츠에서는 관람자의 동작을 인식하는 3D 아바타의 행동에 따라 특정 분위기에 맞는 배경 음악을 재생하고자 한다.

2.2 동작 인식 적용 기술

동작 인식 기반 전시 콘텐츠 제작을 위해 Microsoft 사의 Kinect V2 센서를 사용하여 관람자 정보를 획득하며, 획득된 정보를 바탕으로 Unity 엔진을 사용하여 다양한 상호작용 표현을 구현한다.

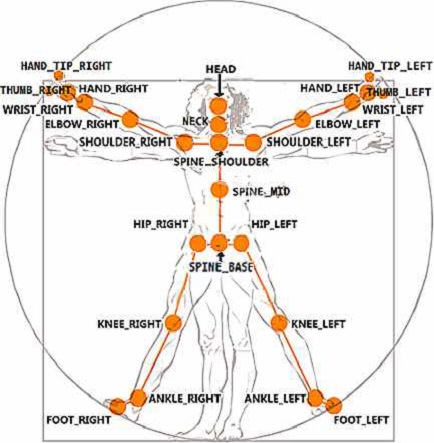

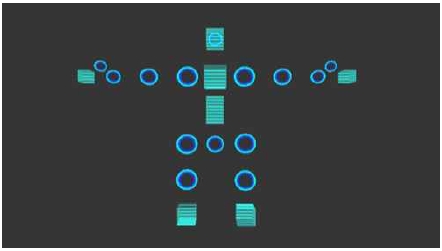

Kinect V2는 Xbox 용도로 개발된 동작 인식 센서로 초당 30프레임으로 사용자의 행동을 그림 4와 같이 25개 부위로 구분해 추적한다[9][10]. Kinect 내 컬러 카메라와 적외선 카메라를 이용하여 관객의 위치, 깊이 및 관절 골격 정보를 통한 3차원 행동 정보를 파악할 수 있다[11]. Kinect V2을 Windows와 연결하기 위해 Kinect for Windows SDK 2.0를 사용하여 하드웨어를 연결해야 한다. Kinect에서 파악하는 정보를 사용하여 미디어아트를 제작하기 위해 Unity 엔진을 사용한다.

Unity 엔진은 실시간 인터랙티브 콘텐츠 플랫폼으로 게임뿐만 아니라 운송 및 제조, 영화, 애니메이션, 설계, 건축 등 다양한 몰입콘텐츠 환경 제작을 가능하게 하는 개발 도구이다. Unity에서 제작하는 가상 환경은 랜더링, 명암조절 등의 기능들을 사용할 수 있으며, Asset Store를 통해 다양한 그래픽, 이펙트, 소스코드, 사운드 등을 적용할 수 있다[12]. Kinect V2에서의 입력 값을 Unity로 전송하기 위해 Kinect plug-in for Unity SDK를 Unity 프로젝트에 Import를 적용한다. 적용된 프로젝트 샘플을 통해 수신할 수 있는 실시간 정보 연동 및 전송받은 입력 값을 토대로 영상과 음악 데이터를 출력할 수 있는 상호작용 시스템을 적용할 수 있다.

2.3 동작 인식 상호작용 적용

Kinect V2와 Unity를 활용하여 관람자들이 작품을 몰입할 수 있도록 영상 및 음악 데이터의 상호작용을 적용한다. 그림 5의 3D 아바타는 Kinect를 통해 인식한 관객의 동작을 나타낼 수 있는 가상환경 내 3D 모델이다. 이 아바타는 Unity 내 3D Object로 Joint position에 Body Source Manager 스크립트를 적용하여 전체적인 움직임을 제어할 수 있도록 제작한다. 다음 각각에 맞는 Joint를 Kinect가 전송하는 Joint 정보와 연결하면 관객의 움직임을 따라 움직이는 아바타가 구성된다. 아바타는 홀로그램 형태를 나타내는 Shader와 외곽선을 강조한 Shader를 적용하여 관객 그대로의 모습이 아닌 인간 형상을 추상적으로 표현한다. 이는 아바타가 특정 인물의 모습을 통해 정해진 형태가 아닌 내면의 모습을 의미한다.

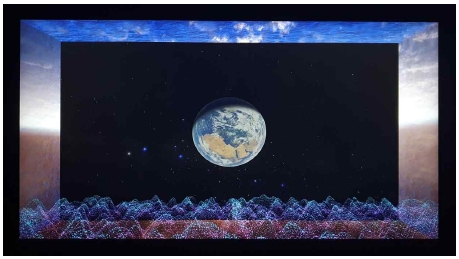

아바타의 뒤쪽 공간에 Plane을 생성하여 Render Texture와 Material을 적용하고, Video Player 스크립트를 적용하여 미리 준비된 영상을 삽입하면 Plane과 Video Player가 서로 연동되어 Plane에 영상이 나타난다. 추가 스크립트를 적용하여 키패드 1번을 누를 시 영상이 재생되고 2번을 누를 시 일시 정지되고 3번을 누를 시 영상이 처음으로 돌아갈 수 있도록 구현한다. 따로 조작하지 않는 한 그림 6과 같이 3개의 연속된 배경 영상이 관객이 작품을 체험할 때 동작 인식 전과 후에 반복 재생된다.

Kinect 센서가 관객을 인식하면 영상의 중심에서 특정 공간이 생성되며, 그림 7과 같이 바닥을 제외한 벽과 천장은 Shader를 이용하여 빨려 들어가는 느낌을 추가하고 바닥은 Particle system 및 Particle 배열을 만들어 위치를 할당하고 Loop를 추가하여 추상적인 공간에 있는 느낌을 표현한다.

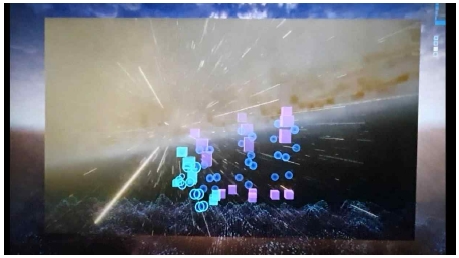

형성된 특정 공간 속에서 관객이 작품과 상호작용 후에는 그림 8과 같이 관객이 지나간 곳에 생기는 잔상 효과를 나타낸다. 잔상 효과는 관객을 따라 움직이는 아바타의 이전 시간대의 위치 데이터를 저장하여 일정 시간에 따라 반복적으로 나타나게 구현한다.

3D 아바타의 Renderer를 Skinned Mesh Renderer로 변경한 뒤, Bake Mesh를 사용하여 임의의 Mesh 데이터에 굽는다. 이후 새로운 Mesh로 렌더링하면 잔상의 형상이 나타나게 된다.

청각적 표현을 위해 특정 구역의 Position x의 값을 정하여 3D 아바타가 x의 값을 지날 시 배경 음악이 재생할 수 있도록 Audio 스크립트를 구현한다.

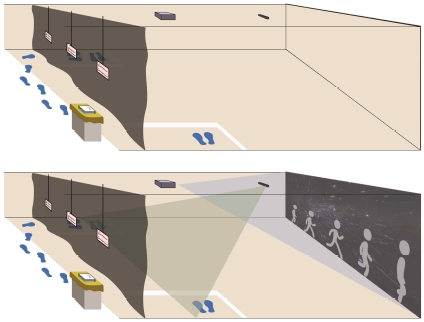

Ⅲ. 동작 인식 기반 전시 콘텐츠 구현

적용된 동작 인식 상호작용을 바탕으로 관객이 기획자의 의도와 작품에 대해 몰입할 수 있는 전시 콘텐츠를 중점으로 세부내용을 기술한다. 본 전시 콘텐츠의 내용은 동작 인식을 바탕으로 관객 자신의 행동을 보여주는 3D 아바타와의 상호작용을 통해 자신이 겪었던 힘들었던 경험 및 감정을 떠올리고 체험하는 동안 잠시 치유할 수 있는 시간을 가질 수 있는 내용으로 제작되었다. 본 전시 콘텐츠의 사용 기기는 Kinect V2, 빔프로젝터, 노트북, 스피커를 사용한다. 관객의 동선을 방해하지 않도록 그림 9와 같이 Kinect V2(초록), 빔프로젝터(파랑), 노트북을 천장에 설치한다. 상단 부분에서 하단 관객을 추적하기 위해 Kinect를 기울어서 설치하므로 Unity 내 가상 환경도 기울어진 각도에 따라 같이 Rotation을 회전시켜 주어야 센서의 정확성이 올라간다. 빔프로젝터는 사다리꼴 모양으로 비추어지기 때문에 키노트 조정 및 노트북과 빔프로젝터 간 화면 비율의 조정이 필요하다. 전시장 내부에 빔프로젝터가 비추는 벽을 중심으로 관객의 대기 위치 및 체험 위치를 테이프로 표시하여 관객이 관람할 수 있는 위치를 알 수 있게 표시한다.

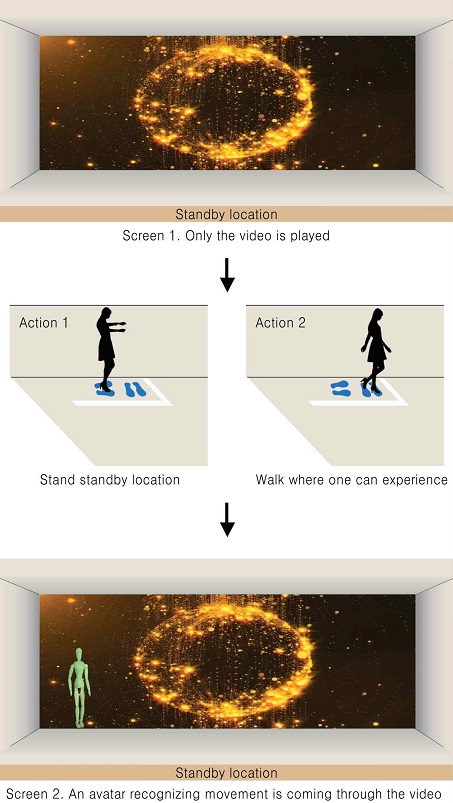

본 전시 콘텐츠는 한 명씩 체험하는 것을 기준으로 기획이 되었으므로 여러 명의 관객을 추적하는 것을 방지하기 위해 Kinect 센서 내 가장 가까이 있는 관객 한 사람만을 추적하도록 구현한다. 그림 10과 같이 표시된 대기 위치에 선 후 관객이 앞으로 움직이면 관객의 움직임을 따라 하는 상호작용이 가능한 아바타가 영상에 나타난다. 관객이 작품 내 과거의 공간 속에 들어온 것을 의미한다.

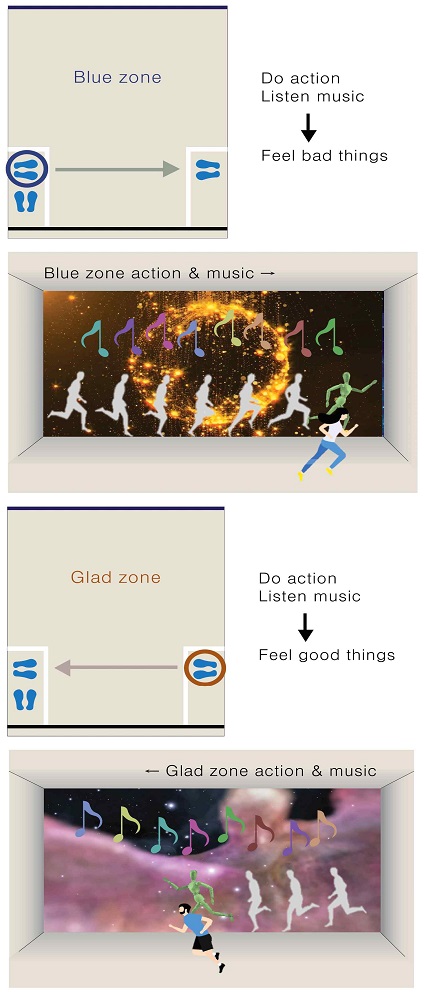

그림 11과 같이 전시 공간 내부에는 슬픔, 아픔 등 기억을 체험하는 Blue Zone과 기쁨과 즐거움 등의 기억을 체험하는 Glad Zone으로 2가지의 체험 구역이 존재한다. 각 Zone에 표시된 위치에서 관객은 재생되는 음악에 따라 자신의 감정에 따른 자유 동작을 행동할 수 있다. 예를 들어 Blue Zone은 천천히 걷다가 주저앉는 행동을 하거나 Glad Zone에서 가볍게 뛰기 등을 행동으로 표현할 수 있다.

스크린을 기준으로 왼쪽에서 오른쪽으로 움직일 때는 Blue Zone으로 변경되며 재생되는 음악은 낮고, 어두운 저음의 효과음이 있는 A music이 무작위로 재생된다. 마찬가지로 오른쪽에서 왼쪽으로 움직일 때는 Glad Zone으로 변경되며 밝고, 높은 고음의 여러 개의 효과음이 있는 B music이 무작위로 재생된다. 음악들은 단순한 음계나 인공적인 소리가 아닌 자연의 소리, 아이가 우는 소리 등이 적용되어 관객을 몰입시킬 수 있게 된다.

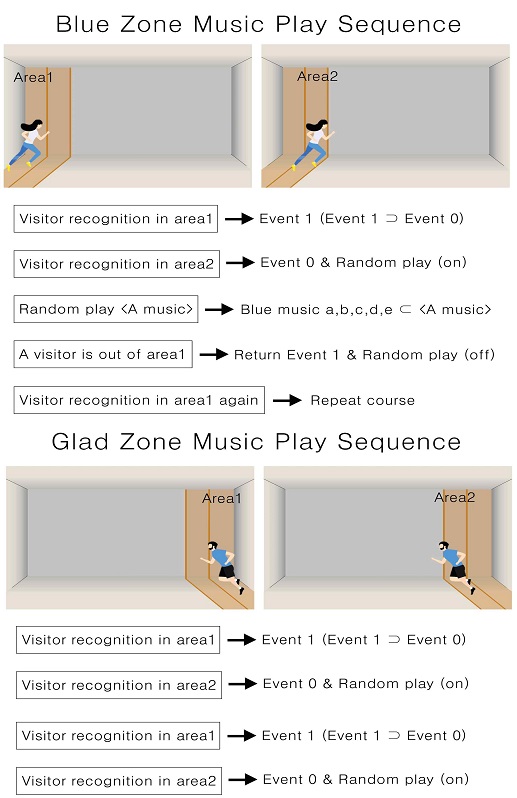

그림 12를 보면 Blue Zone의 Area 1에 있을 때 Event는 1이 되고 정해진 Area 2에 있을 때 Event는 0으로 변경된다. Event 0으로 변경될 때, A music이 재생된다. 관객이 Area 2를 벗어나 앞으로 이동하면 Event 0은 다시 Event 1로 변경된다. 만약 관객이 Area 1로 되돌아 이동하면 Event가 초기화되어 앞의 과정을 반복하여 음악이 재생된다. Glad Zone도 같은 원리로 음악이 적용된다.

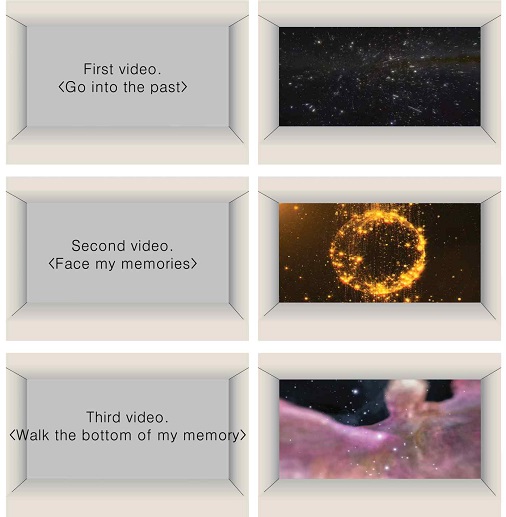

관객이 동작을 행동하면 동작 센서에 의해 사람을 인식하여 천장의 빔프로젝터를 통해 벽에 관객이 행동하는 자유 동작들이 잔상 형태로 실시간으로 나타난다. 그 잔상 뒤의 배경에는 그림 13처럼 3개의 영상이 반복 재생된다. 첫 번째 영상은 지구에서 점점 멀어져 우주로 올라가는 모습의 영상으로, 자기 자신의 자아가 현실에서 빠져나와 과거로 빨려 들어가는 것을 의미한다. 두 번째 영상은 많은 점과 선이 서로 이어진 상태의 영상으로, 과거로 빨려 들어온 자아가 자신의 수많은 감정과 기억들이 서로 이어진 모습을 보게 되는 것을 의미한다. 세 번째 영상은 아름다운 우주 속 한 곳을 입체적으로 보여주는 영상으로, 여러 기억 중 하나의 기억으로 들어가 다양한 색을 가진 감정들로 다져진 바닥을 걷게 되는 의미를 담고 있다.

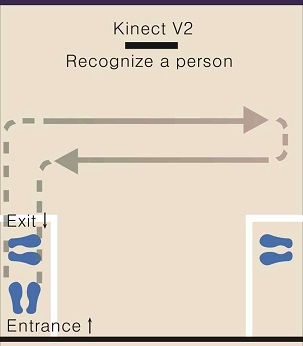

관객의 동선은 그림 14와 같다. Kinect 카메라가 관객 한 명을 인식해야 하므로 입구는 한 곳으로 표시하여 한 명씩 전시를 관람할 수 있도록 한다. 전시장의 입구 및 공간 배치, 크기, 원활한 작품 관람 방향을 위해 동선은 Blue Zone 구역이 있는 왼쪽으로 들어가서 Glad Zone 구역이 있는 오른쪽으로 이동하면서 체험하고 다시 Blue Zone 구역이 있는 왼쪽으로 체험하면서 입구로 다시 나가는 순서로 방향을 배치한다.

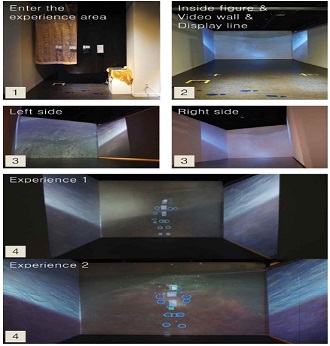

그림 15는 설명한 작품에 대한 실제 전시 환경을 나타낸다. 1번은 작품의 출입구 모습이며 작품에 대한 설명과 체험 방법 등을 표시한다. 2번은 작품의 내부모습이다. 체험 표시 라인과 빔프로젝터가 투사하는 영상이 있으며 표시 라인에 서게 되면 Kinect 카메라가 작동하여 동작을 인식한다. 3번은 작품의 좌, 우측에 나타나는 영상으로 관객이 입체적인 효과를 보여준다. 4번은 작품의 정면을 관객이 체험할 때 나타나는 모습을 보여준다.

Ⅳ. 동작 인식 기반 전시 콘텐츠 설문조사

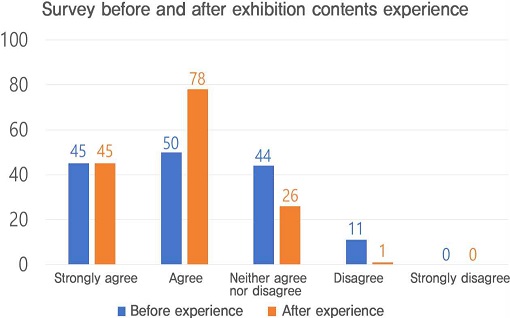

본 논문은 동작 인식 기능을 적용한 전시 콘텐츠의 긍정적 반응에 대한 분석을 위해 제작된 <Re : the past> 작품을 기준으로 설문조사를 시행하였다. 2020년 12월 2일부터 9일까지 일주일간 50명이 참여한 설문조사는 전시 콘텐츠 체험 전의 3가지 질문과 체험 후의 3가지 질문을 5단계 리커트 척도를 바탕으로 ‘매우 그렇다.’, ‘그렇다.’, ‘보통이다.’, ‘그렇지 않다.’, ‘매우 그렇지 않다.’ 5가지 항목으로 설문조사를 수행하였다.

표 2는 전시 콘텐츠 체험 전 설문조사로 A. <평소에 자신의 힘든 과거 기억을 떠올린 적이 있나요?>, B. <평소에 힘든 과거 기억으로 인해 마음속이 어지러웠거나 아픈 감정을 느낀 적 있나요?>, C. <전시 콘텐츠를 통해 힘든 과거 기억을 떠올리고 마음의 평안을 얻을 수 있다고 생각하나요?>라는 질문에 위와 같은 반응을 보인다. 표 3은 전시 콘텐츠 체험 후 설문조사로 A. <본 전시 콘텐츠를 통해 자신의 힘든 과거 기억을 떠올렸나요?>, B. <본 전시 콘텐츠를 통해 힘든 과거의 기억과 그 감정이 느껴졌나요?>, C. <본 전시 콘텐츠를 통해 힘든 과거의 기억을 떠올리고 마음의 평안을 얻는 데 도움이 되었나요?>라는 질문에 위와 같은 결과를 보인다.

표 2와 표 3을 비교하면 전시 체험 전의 관객들의 과거 기억에 대한 A 문항의 대답이 전시를 체험 후 그렇지 않은 대답이 줄어든 것을 확인할 수 있다. 마찬가지로 과거의 기억 때문에 힘들었던 경험에 대한 B 문항의 설문도 그렇지 않다는 비율이 줄어들어 긍정적인 결과를 확인할 수 있다. 마지막으로 전시 콘텐츠를 통해 마음의 평안을 얻는 경험에 대해서 긍정적인 반응이 늘어난 것을 확인할 수 있다.

그림 16은 작품 체험 전과 후의 설문조사의 전체 수치를 막대 그래프로 정리한 그림이다. 그래프에서 표시된 것과 같이 과거의 기억을 떠올리며 그때의 감정을 느끼는 긍정적 반응이 작품 체험 전보다 작품 체험 후기 더 높다는 것을 확인할 수 있다.

설문조사를 통해 얻을 수 있는 결과로 동작 인식 기술을 활용한 미디어아트 전시 콘텐츠가 기획자의 표현 의도대로 관객이 체험한 것으로 볼 수 있다.

Ⅴ. 결 론

본 논문에서는 <Re : the past> 인터랙티브 미디어아트 전시 콘텐츠를 바탕으로 동작 인식 기술의 방법을 통한 관객의 작품에 대한 몰입성을 제안하였다. 관객과의 상호작용 중심으로 구현하기 위해 Kiniect V2와 Unity를 이용하여 관객의 동작을 추적하고 3D 아바타를 통해 관객의 움직임을 영상으로 표현하는 전시 콘텐츠 제작 기술을 제안하였다. 이를 바탕으로 전시를 통해 과거 기억의 회상과 마음의 평안을 얻기를 바라는 기획자의 의도를 전시 콘텐츠에 적용하였다. 전시를 수행하고 관객의 설문조사를 토대로 기획자의 의도가 관객에게 충분히 체험하였음을 검증하였다. 관객의 체험 전, 후 설문조사를 토대로 전시 콘텐츠에 대한 부정적인 인식이 개선되었음을 확인하였다. 그러나 ‘그렇다’라는 긍정적 수치는 상승했으나, ‘매우 그렇다’라는 인식은 높아지지 않은 한계점을 보인다. 이는 동작 인식 기술을 이용한 시각적 표현 방법에서 관객이 높은 몰입감을 체험하기에 어색한 부분이 있었던 것으로 파악하였다. 기술적으로는 장기적으로 전시할 때 저장하고 처리해야 할 사용자 데이터가 증가함에 따라 영상의 재생과 반응속도가 저하되는 문제점이 나타났다. 또한, COVID-19로 인해 전시 공간의 제약이 발생하였고, 전시 콘텐츠를 많은 관객이 체험하지 못하여 설문조사의 양적 요소가 적어진 것에 아쉬움을 느낀다.

향후 연구에서는 실험 측정을 정량적 평가인 관객의 설문조사 항목에 더해 정성적 평가인 관객이 작품과 상호작용할 때 발생하는 상호작용 횟수를 측정할 수 있는 시스템을 개발하여 명확한 결괏값을 나타내고자 한다. 또한, 관객의 몰입성의 향상을 위해 Kinect V2를 활용한 동작 인식 전시 콘텐츠 제작을 VR, AR과 같은 가상현실 기술들과 접목하여 수행할 예정이다. 이번 논문의 설문조사 결과는 동작 인식 기술을 사용하는 미디어아트 전시 콘텐츠 제작에 있어 관객의 다양한 행동 패턴에 따른 기술 연구에 또 다른 발판과 과제가 될 것이다.

Acknowledgments

이 논문은 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No.NRF-2020R1F1A1073866)

References

-

E. S. Yi and S. Y. Kim, "A Study on KOPIS for Performing Arts Industry of the era of 4th Industrial Revolution", The Korean Society of Science & Art, Vol. 28, pp. 227-242, Mar. 2017.

[https://doi.org/10.17548/ksaf.2017.03.28.227]

- J. J. Myun and J. Y. Sohn, "A study on the Emotional Communication of Interactive Media Art and Audience -a focus on the affects of exhibition interpretation medium-", Science of Emotion and Sensibility, Vol. 14, No. 3, pp. 415-424, Sep. 2011.

- H. Xuan and K. S. Nam, "A Study on Case Analysis on Interactive Media in Exhibition Space - Around the Exhibition in Seoul", Proceeding of Conference on Korean Institute of Interior Design, Vol. 18, No. 1, pp. 296-299, May 2018.

-

O. H. Cho and W. H. Lee, "A Study on the Implementation of Gesture Recognition System applying to Interactive Media Art", Journal of Digital Design, Vol. 12, No. 2, pp. 123-130, Apr. 2012.

[https://doi.org/10.17280/jdd.2012.12.2.012]

-

E. C. Ha and S. J. Yu, "Interactive Contents System Using Kinect Camera", Journal of KIIT, Vol. 18, No. 7, pp. 111-119, Jul. 2020.

[https://doi.org/10.14801/jkiit.2020.18.7.111]

- http://www.kinetica-museum.org/artists/members/hybe, [accessed: Dec. 24, 2020]

- http://munhaknews.com/?p=25820, [accessed: Dec. 25, 2020]

- https://www.ted.com/talks/golan_levin_art_that_looks_back_at_you/transcript?language=ko, [accessed: Dec. 25, 2020]

-

Yang, Lin, et al, "Evaluating and improving the depth accuracy of Kinect for Windows v2", IEEE Sensors Journal, Vol. 15, No. 8, pp. 4275-4285, Aug. 2015.

[https://doi.org/10.1109/JSEN.2015.2416651]

- Song, Miao, et al, "Applications of the Illimitable Space System in the context of media technology and on-stage performance: a collaborative interdisciplinary experience", 2015 IEEE Games Entertainment Media Conference (GEM), Toronto, ON, Canada, pp. 1-8, Jan. 2015.

-

A. R. Kim and S. Y. Rhee, "An Extraction Method of Meaningful Hand Gesture for a Robot Control", Journal of Korean Institute of Intelligent Systems, Vol. 27, No. 2, pp. 126-131, Apr. 2017,

[https://doi.org/10.5391/JKIIS.2017.27.2.126]

- https://unity.com, [accessed: Dec. 26, 2020]

2021년 2월 : 창원대학교 문화테크노학과 학사

관심분야 : 컴퓨터비전, 증강/가상현실, 게임제작

2016년 2월 : 경상대학교 미술교육학과 학사

2020년 9월 : 창원대학교 문화융합기술협동과정 석사과정

관심분야 : 컴퓨터비전, 증강/가상현실, 게임제작

2003년 8월 : 고려대학교 전자정보공학(공학사)

2006년 2월 : 연세대학교 생체인식공학(공학석사)

2011년 2월 : 연세대학교 전기전자공학(공학박사)

2011년 ~ 2012년 : LG전자기술원 미래IT융합연구소 선임연구원

2012년 ~ 2013년 : 연세대학교 전기전자공학과 연구교수

2013년 ~ 2016년 : 제주한라대학교 방송영상학과 조교수

2016년 ~ 2019년 : 동명대학교 디지털미디어공학부 부교수

2019년 9월 ~ 현재 : 창원대학교 문화테크노학과 부교수

관심분야 : 컴퓨터비전, 증강/가상현실, HCI