수정된 MobileNet을 이용한 과일의 결점 분류 알고리즘

초록

포장된 과일들 안에 결점이 있는 과일(결점과)이 포함되어 있으면, 과일의 상품성을 낮추는 치명적인 요인이 된다. 현재, 결점과의 분류는 사람이 직접 육안으로 선별하고 있으나, 이것은 객관성의 부족 및 농촌인구 감소가 문제시 되고 있다. 이와 같은 문제점을 해결하기 위하여 영상처리를 이용하여 결점과를 분류하는 방법이 제안되었다. 그 후, 영상 분류 방법을 개선시킨 컨볼루션 신경망(Convolutional Neural Network : CNN)을 이용하는 연구가 진행되고 있다. 최근에는 연산 성능이 낮은 디바이스에서도 CNN을 사용할 수 있도록 MobileNet이 제안되었으나, 이 방법으로 결점과를 분류할 경우, 정상 과일(정상과)을 결점과로 인식하는 경우가 발생하고 있다. 따라서 본 논문에서는 실제 산업 현장에서 사용하고 있는 고속 과일 선별기에 적용하여 결점과를 검출할 수 있는 수정된 MobileNet 알고리즘을 제안하고, 성능 평가를 통하여 제안한 알고리즘의 유용성을 입증하고자 한다.

Abstract

The presence of one or a few defective fruits in a fruit package reduces the commercial value of the fruit. Currently, defected fruits are being sorted by naked eyes. However, the lack of objectivity by the conventional sort method and decrease in farming population are becoming problems. Various image processing methods have been introduced to overcome these problems. The convolutional neural network (CNN), an enhanced image processing method, provides an efficient solution for sorting the defective fruits. Recently, MobileNet has been proposed to incorporate CNN in a device with low arithmetic performance. Nevertheless, when it is used to sort defective fruits, there is a possibility of identifying good fruits as defected ones. Therefore, the thesis proposes a revised MobileNet algorithm that can be applied to a high-speed fruit sort machine that is being used in the industry as of now. Moreover, it is to prove the usefulness of the proposed algorithm through a performance evaluation.

Keywords:

fruit quality, defect classification, camera, MobileNet, deep learningⅠ. 서 론

포장이 되어 있는 과일 안에 결점과가 있게 되면, 과일의 상품성을 크게 낮추는 치명적인 요인이 된다. 현재, 과일을 선별하여 포장하는 선별장에서는 이와 같은 결점과를 사람이 직접 눈으로 확인하여 분류하는 육안선별 작업을 수행하고 있다. 그러나 육안선별은 작업하는 사람마다 결점 판단 기준이 서로 다르기 때문에 선별 객관성이 부족하게 된다. 또한 최근 농촌의 노동인력 감소로 인해 인력 충당이 매우 어려운 실정이다. 이와 같은 문제점을 해결하기 위해서 카메라를 이용해 취득한 영상의 특징 분류를 수행하여 결점과를 분류하는 알고리즘이 제안되고 있다[1].

초기의 결점과 분류 알고리즘은 과일의 정상영역과 결점영역이 서로 다른 광학적 성질을 가진다는 것을 바탕으로 촬영된 영상에서 처리 영역을 찾기 위해 밝기 영상의 보정, 윤곽선 강조, 특징 추출 등의 영상처리를 수행하여 결점과를 분류하는 방식을 이용하였다[2]. 그 후, 2012년 AlexNet[3]이 공개되면서 컨볼루션 신경망(Convolutional Neural Network : CNN)을 이용하여 획기적으로 영상 분류 성능을 개선하는 방법들이 제안되었다[4]-[7]. 이와 같은 CNN 영상처리 기술을 과일의 결점과 분류 방법에 적용하여 망고스틴[8]의 결점을 찾거나 녹색 커피[9]의 결점을 분류하는 연구가 진행되고 있다. 최근에는 높은 정밀도를 가지는 CNN들이 제안되었지만, 신경망이 깊어 연산량과 파라메터 수가 많아 고성능 GPU(Graphics Processing Unit)와 대용량의 메모리를 가진 컴퓨터를 요구하고 있다. 그러나 과일을 선별하는 선별장과 같은 저성능 PC에서도 CNN을 이용할 수 있도록 정확도를 높이고, 연산량을 줄이는 경량화 알고리즘에 대한 연구도 많이 진행되고 있다[10]-[13].

대표적인 경량화 알고리즘으로는 기존의 2차원 컨볼루션을 채널 단위로 합성하는 Depthwide 컨볼루션과 채널의 결과를 합성하는 Pointwide 컨볼루션으로 구성된 Depthwise separable 컨볼루션으로 변경하여 연산량과 파라메터 수를 개선한 MobileNet[13]이 있다. 이 방법을 과일의 결점과를 분류하는 알고리즘에 그대로 적용하면, 정상 과일(정상과)을 결점과로 인식하는 오류가 발생하게 된다.

따라서 본 논문에서는 이와 같은 문제점을 개선하기 위하여 실제 산업 현장에서 사용하고 있는 고속 과일 선별기에 적용하여 결점과를 검출할 수 있는 수정된 MobileNet을 제안하고자 한다. 제안하는 알고리즘은 기존의 MobileNet에서 사용한 Depthwise separable 컨볼루션에 잔여(Residual) 블록을 추가하고, 영상의 공간 크기를 줄이는 과정을 맥스 풀링(Max pooling)으로 변경하는 방식이다. 제안한 알고리즘의 성능을 평가하기 위하여 기존의 대표적 CNN인 AlexNet[3], GoogLeNet[5], MobileNet[6]과 감귤의 결점과 분류 실험을 통하여 제안한 알고리즘의 유용성을 확인하고자 한다.

Ⅱ. 이론적 배경

2.1 CNN

CNN은 영상에서 객체 분류, 검출, 분할 등 영상 인식 분야에 가장 많이 사용되고 있는 딥 러닝(Deep learning)분야 중 하나이다. 이 CNN은 공간 정보를 유지하는 특성을 가진 컨볼루션으로 구성되어 학습 효율성이 높은 장점을 가지고 있다.

컨볼루션은 가중치 필터를 일정 간격으로 이동하면서 각 입력 채널에 상응하는 원소끼리 곱하고 그 값을 더한 결과를 출력에 순차적으로 저장하는 방식이다. 즉, RGB로 구성된 영상을 3×3 필터, 이동간격(Stride)을 1로 하였을 때, 컨볼루션은 식 (1)과 같이 정의할 수 있다.

| (1) |

여기서 O는 출력, K는 필터, F는 입력을 나타내고 있고, i, j는 필터의 가로, 세로 길이를 나타내고 있다. 또한, x, y는 입력과 출력의 가로 및 세로 길이를 나타내고 c는 입력의 채널, n은 출력 채널을 나타낸다. 이와 같은 컨볼루션 조합으로 구성된 영상 분류의 대표적인 CNN은 AlexNet, GoogLeNet, ResNet 등이 있다.

AlexNet은 2012년도에 공개된 CNN으로 딥러닝의 가능성을 성능으로 입증하면서 영상 분류를 획기적으로 개선하였다. 이 AlexNet은 컨볼루션, 풀링 그리고 마지막에 완전 결합을 거처 결과를 출력하는 방식이다. 또한 ReLU 활성화 함수, LRN(Local Response Normalization)정규화, 드롭아웃(Dropout) 방식을 적용하였고 연산에 GPU를 활용하면서 대용량의 연산을 고속으로 수행할 수 있도록 설계하였다.

GoogLeNet은 2014년도에 공개된 CNN으로 신경망에 폭의 개념을 가진 인셉션(Inception) 구조를 도입하여 성능을 개선한 방식이다. 인셉션 구조는 입력에 1×1 컨볼루션, 3×3 컨볼루션, 5×5 컨볼루션 등, 크기가 다른 컨볼루션과 풀링을 병렬로 여러 개 적용하여 그 결과를 결합하는 방식이다. 현재 인셉션 구조는 계속 변형, 발전시켜 다양한 인셉션 모듈이 제안되고 있다. 또한 GoogLeNet은 22개의 계층(Layer)을 가지고 있어 8개의 계층을 가진 AlexNet보다 2배 이상 깊은 구조를 가지고 있다.

ResNet은 2015년도에 공개된 CNN으로 신경망에 잔여 구조를 도입하여 성능을 개선하였다. ResNet에서는 신경망이 깊어짐에 따라 발생하는 학습 저하를 막기 위해서 지름길(Shortcut Connection)을 통해서 파라미터 없이 바로 연결되는 구조를 도입하였다. 연산의 관점에서 덧셈이 추가되는 형태로 문제를 단순화하였다.

2.2 Mobilenet

기존의 CNN을 이용한 방식은 영상 인식 분야에서 뛰어난 성능이 입증되었지만, 알고리즘의 학습과 테스트를 위해 많은 연산이 소요되어 고성능 GPU와 대용량의 메모리를 가진 디바이스가 필수적이다. 이와 같은 문제점을 해결하기 위하여 컨볼루션 필터를 변경하는 방법 중 하나인 MobileNet이 제안되었다. MobileNet은 기존의 컨볼루션을 Depthwise separable 컨볼루션으로 신경망을 구성하였다.

Depthwise separable 컨볼루션은 기존의 컨볼루션을 인수분해하는 개념으로 컨볼루션에서 필터처리 하는 Depthwise 컨볼루션과 합산 처리를 하는 Pointwise 컨볼루션 두 단계로 구성된다. Depthwise 컨볼루션은 입력 데이터의 모든 채널에 각각의 채널에 맞는 싱글 필터 연산 처리를 수행하여 결과를 출력한다. Pointwise 컨볼루션은 1×1 컨볼루션으로 구성되고, Depthwise 컨볼루션을 통해 출력된 결과를 합산 처리하여 결과를 출력하는 방식이다. 만약, RGB로 구성된 영상을 3×3 필터, 이동간격을 1로 하여 Depthwise separable 컨볼루션을 한 결과는 식 (2), (3)과 같이 정의할 수 있다.

| (2) |

| (3) |

여기서 는 Depthwise 컨볼루션의 출력, K는 Depthwise 컨볼루션의 채널별 싱글 필터, F는 입력을 나타낸다. 또한, O는 Pointwise 컨볼루션의 출력, 는 1×1 컨볼루션의 필터를 나타낸다. 이와 같이 기존의 3×3 컨볼루션을 Depthwise separable 컨볼루션으로 변경할 경우, 약 8~9배 정도 연산량이 감소하게 된다[13].

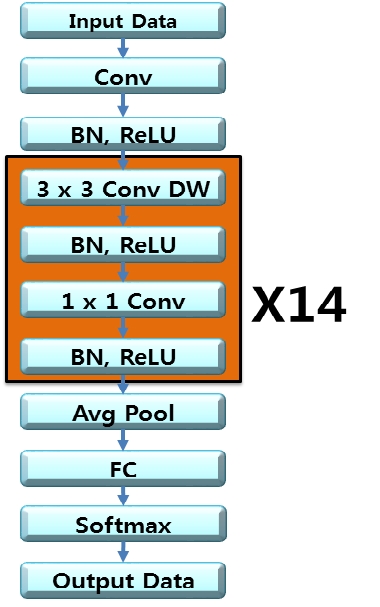

그림 1은 Depthwise seprable 컨볼루션으로 구성한 MobileNet의 구조를 나타내고 있으며, MobileNet은 총 28계층으로 구성되어 있다. 첫 번째 계층에 위치한 기존의 컨볼루션을 제외하고는 Depthwise separable 컨볼루션을 이용하여 신경망을 구성하였다.

그림 1에서 Conv는 기존의 3×3 컨볼루션의 계층, 3×3 Conv Dw는 Depthwise 컨볼루션 계층, 1x1 Conv는 Pointwise 컨볼루션 계층, Avg Pool은 평균 풀링 계층, FC는 완전결합 계층, Softmax는 소프트맥스 활성화 계층을 의미하고 있다. 컨볼루션을 사용하는 각 계층은 배치 정규화(BN, Batch Normalization)와 ReLU 활성화를 적용하고 있다. 입력영상의 영상의 공간 크기를 줄이는 과정은 컨볼루션 계층과 Depthwise 컨볼루션에서 이동간격을 이용하여 수행한다. 영상의 공간 크기를 줄이는 과정은 마지막 Avg Pool 전에 공간적인 사이즈를 1로 줄여 1000×1024사이즈의 데이터가 된다. 이 데이터를 완전결합 계층과 소프트맥스 계층을 통해 입력영상의 분류를 결정한다.

이와 같이 구성한 MobileNet의 연산량을 AlexNet과 GoogLeNet의 연산량과 비교하면 표 1과 같다.

표 1에 제시한 것과 같이 AlexNet은 약 7억2000만개의 연산량을 가지고 있고 약 6000만개의 파라메터 수를 가지고 있다. 반면, GoogLeNet은 약 15억5000만개의 연산량을 가지고 있고 680만개의 파라메터 수를 가지고 있다. 마지막으로 MobileNet은 약 5억 6900만개의 연산량을 가지고 있고 약 420만개의 파라메터 수를 가지고 있다. 즉, 영상 분류에서 유사한 성능을 가진 MobileNet은 AlexNet에 비해 약 20%의 연산량과 약 93%의 파라메터 수가 감소되었고, GoogLeNet에 비해서는 약 63%의 연산량의 감소 및 파라메터 수는 약 38% 감소되었다.

Ⅲ. 수정된 MobileNet 제안

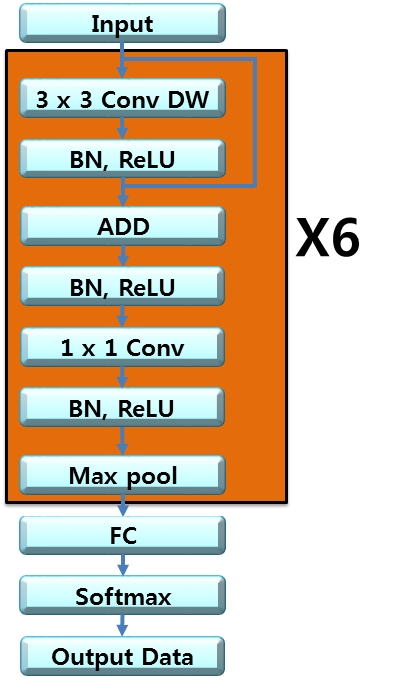

본 논문에서는 앞에서 논한 문제점들을 해결하기 위하여 기존의 MobileNet을 수정하여 과일의 결점과 분류 성능이 우수한 알고리즘을 제안하고자 한다. 제안하는 수정된 MobileNet을 그림 2에 제시한다.

그림 2에 제시한 것과 같이 입력받은 영상은 우선 첫 번째로 3×3 Depthwise 컨볼루션을 수행한다, 두 번째로 배치 정규화와 ReLU 활성화 작업을 수행한다. 세 번째로 기존의 ResNet에서 사용하고 있는 잔여 구조 개념을 도입하여, 원 영상 입력데이터와 두 번째 과정에서 얻어진 결과 값을 더(Add)하는 “Shortcut Connections” 과정을 추가하여 구성한다. 이와 같이 구성한 이유는 가중치를 안정적으로 학습할 수 있으므로 입력의 작은 변화에도 민감하게 반응하고, Shortcut Connection의 구현에 덧셈 연산만 추가됨으로 연산량과 파라메터 수가 많이 필요하지 않은 장점을 가지고 있기 때문이다. 따라서 기존의 MobileNet에서 사용하고 있던 Depthwise 컨볼루션의 식 (2)를 제안하는 알고리즘의 식으로 표현하면, 식 (4)와 같이 나타낼 수 있다.

| (4) |

네 번째로 식 (4)를 이용하여 처리되어진 데이터는 다시 배치 정규화와 ReLU 활성화를 거처, 1×1 컨볼루션으로 구성된 Pointwise 컨볼루션으로 처리한다. 이 때, Pointwise 컨볼루션은 Depthwise 컨볼루션을 통해 출력된 결과를 합산 처리하여 결과를 출력하는 방식이므로 입력영상의 채널 수를 조절하고 있다. 이 때, 채널수의 조절은 처음에 3채널을 32채널로 확장하고, 그 다음 두 배씩 채널을 증가하여 마지막에 1024개의 채널이 되도록 한다. 또한, Pointwise 컨볼루션도 다른 계층과 마찬가지로 배치 정규화와 ReLU 활성화를 수행한다. 이렇게 수행되는 Pointwise 컨볼루션은 영상의 가로, 세로 방향 공간의 크기를 줄이는 과정을 수행하게 된다.

다섯 번째로 기존의 MobileNet에서는 이동간격이 2인 3×3 컨볼루션을 이용하여 영상의 공간 크기를 줄이는 과정을 수행하고 있으나, 제안 알고리즘에서는 이동간격이 2인 2×2 맥스풀링을 적용하고 있다. 지금까지 논한, 다섯 가지 과정을 6회 반복 수행한다.

여섯 번째로, 6회 반복 수행에서 얻어진 결과를 완전결합 계층에 입력하여 처리한다. 이 완전결합 계층은 제안 알고리즘의 마지막 계층으로 정상과와 결점과를 판별하는 수치를 계산한다.

일곱 번째로 계산된 결과 값들은 소프트맥스 활성화 계층을 통하여 각각 0~1 사이의 값이 출력된다. 이 과정에서 얻어진 정상과, 결점과에 대한 확률 값을 이용하여 판별한다.

Ⅳ. 실험 및 결과 고찰

4.1 영상 취득 시스템 및 실험 방법

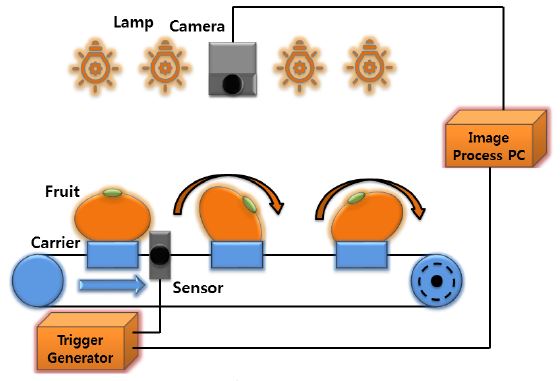

제안하는 알고리즘의 성능을 평가하기 위한 과일의 영상 취득 시스템은 그림 3과 같다.

그림 3에서 카메라는 Basler사의 제품으로 촬영된 영상을 RGB 데이터로 변환하여 PC에 전송하는 역할을 하고, 영상 취득 시, 사용한 조명은 LED 전구로 과일의 영상 취득에 필요한 광량을 제공할 수 있는 것을 이용하였다. 캐리어는 영상을 취득할 과일을 놓아두는 장치로 이동하면서 과일을 회전시킬 수 있는 구조로 설계되어 있어, 이동하는 과일의 모든 부분의 표면 영상을 취득할 수 있다. 트리거 생성부는 캐리어가 센서에 감지될 때, 과일의 영상을 촬영하는 시기를 결정하는 역할을 한다. PC는 카메라에서 취득한 영상을 받아 데이터를 저장한다.

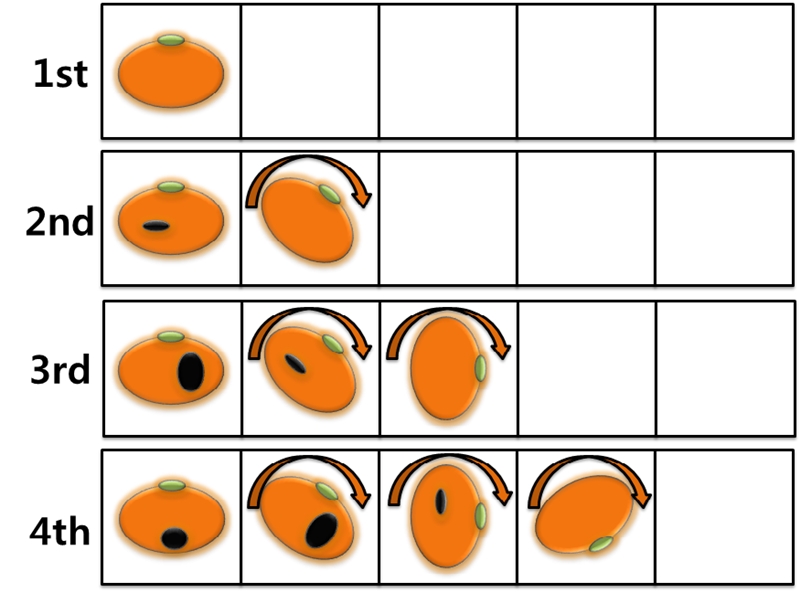

이와 같은 영상 취득 시스템을 이용하여 과일의 영상을 취득하는 과정을 그림 4에 제시하였다.

그림 4는 선별기 이동방향에 따라 움직이는 과일의 영상을 취득하고 있는 과정을 나타내고 있는 것으로 캐리어에 위치한 과일이 이동할 때, 회전하면서 일정한 간격으로 영상이 취득된다. 즉, 센서가 캐리어를 감지할 때부터 이동하는 과일을 촬영하고 있기 때문에 항상 일정한 위치에서 과일의 영상이 취득된다.

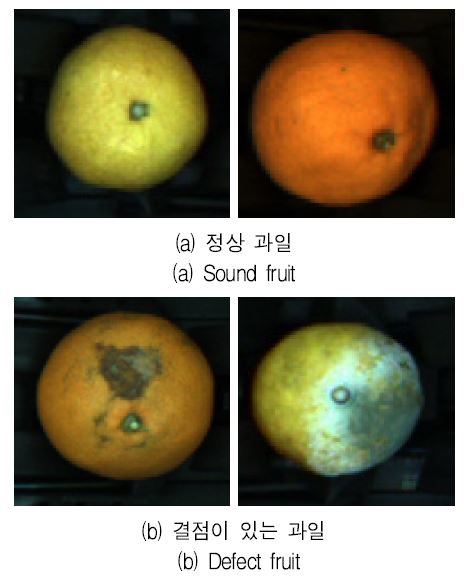

이 시스템을 이용하여 취득한 과일의 영상은 그림 5에 제시한 것과 같이 224×224 사이즈의 영상이다.

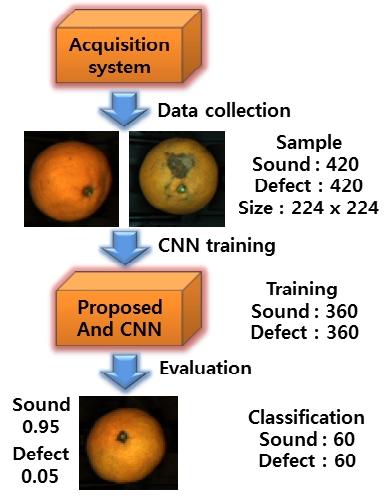

이와 같이 취득한 과일 영상을 이용하여 성능을 평가하기 위한 실험 과정은 그림 6과 같다.

그림 6에 제시한 것과 같이 실험에 사용된 과일(감귤)의 영상은 제주도 서귀포에서 수확된 노지 감귤 840개를 이용하였고, 영상 840개 중, 420개는 정상과, 420개는 결점과의 영상이다. 그 다음, 840개의 영상 중, 정상과 영상 360개와 결점과 영상 360개로 구성된 720개의 영상을 이용하여 제안한 알고리즘과 기존 알고리즘(AlexNet, GoogleNet, MobileNet)들의 가중치 학습을 하였다. 마지막으로 정상과 영상 60개와 결점과 영상 60개로 구성된 120개의 영상으로 학습한 알고리즘들의 성능을 평가하였다.

4.2 실험 결과 및 분석

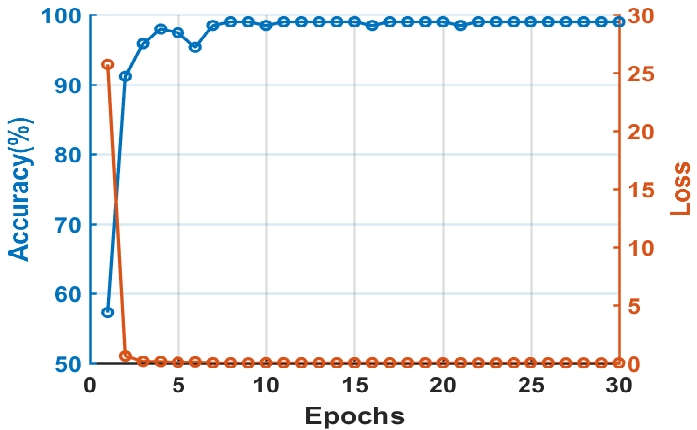

학습에 사용한 최적화 방법은 확률적 경사 하강법(Stochastic Gradient Descent : SGD)를 이용하였고, 배치 사이즈는 32, epoch은 30회를 수행하였다. 제안한 알고리즘의 학습 성능 수행 결과를 그림 7에 제시하였다.

그림 7에서 가로축은 학습의 반복 횟수(Epochs)를 나타내고, 왼쪽 세로축은 정확도(Accuracy)를 나타내고, 오른쪽 세로축은 손실률(Loss)를 나타내고 있다. 이 결과를 보면, 제안 알고리즘으로 학습을 수행한 최고 성능의 정확도는 98.96%이고, 10회 반복 이후에는 약 99%의 정밀도로 수렴하는 것을 알 수 있다. 최소 손실률은 0.03이고, 10회 반복 이후에는 약 0.03의 손실률로 수렴하는 것을 알 수 있다.

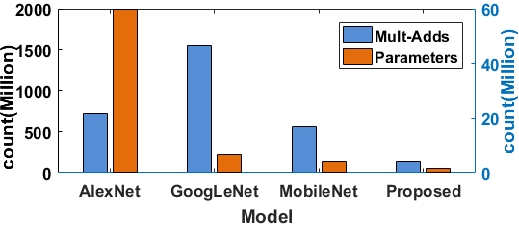

또한, 제안하는 알고리즘과 기존의 대표적인 CNN 알고리즘인 AlexNet, GoogLeNet, MobileNet의 곱셈과 덧셈 수와 파라메터 수를 비교한 결과를 그림 8에 나타내었다.

그림 8에서 가로축은 알고리즘의 종류를 나타내고, 왼쪽 세로축은 연산량을 나타내고 오른쪽 세로축은 파라메터 수를 나타낸다. 그림 안에서 파란색 막대그래프는 연산량을 나타내고, 주황색 막대그래프는 파라메터 수를 나타내고 있다. 이 비교 결과에서 AlexNet의 연산량은 7억2000만개, 파라메터 수는 6000만개, GoogLeNet의 연산량은 15억5000만개이고, 파라메터 수는 680만개였다. MobileNet의 연산량은 5억6900만개, 파라메터 수는 420만개였다. 제안한 알고리즘의 연산량은 1억4400만개, 파라메터 수는 170만개였다. 제안 알고리즘과 다른 알고리즘에 비해 연산량이 적은 MobileNet과 비교하여 볼 때, 연산량은 약 75%, 파라메터 수는 약 60% 감소된 것을 확인하였다.

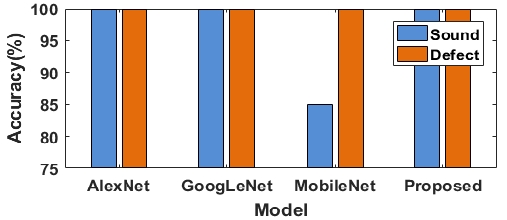

마지막으로 제안한 알고리즘과 기존 대표적인 CNN 알고리즘인 AlexNet, GoogLeNet, MobileNet을 이용하여 감귤의 결점과 분류 성능 실험을 수행하였다. 각 알고리즘의 학습은 제안한 알고리즘의 학습과 동일한 조건으로 수행하였고 각 알고리즘의 학습률은 모두 약 99%였다. 각 알고리즘에 대한 감귤의 결점과 분류 성능 실험 결과를 그림 9에 제시하였다.

그림 9에서 가로축은 알고리즘의 종류를 나타내고 있고, 세로축은 정밀도를 나타내고 있다. 또한 그림 안에서 파란색 막대그래프는 정상과의 정확도를, 주황색 막대그래프는 결점과의 정확도를 나타내고 있다.

이 결과를 보면, 많은 연산량과 파라메터 수를 가지고 있는 AlexNet과 GoogLeNet 의 경우, 정상과, 결점과 판별 성능이 모두 100% 분류가 되는 것을 확인하였다. 반면, 연산량과 파라메터 수를 경량화한 MobileNet의 경우, 결점과는 100% 분류하였으나, 정상과의 경우에는 15%를 결점과로 분류하는 오류를 발생하였다. 마지막으로 본 논문에서 제안한 알고리즘의 경우, 정상과 결점과 모두 100% 분류되었다. 이것을 보면, 제안한 알고리즘이 연산량과 파라메터 수가 많은 기존의 AlexNet, GoogLeNet과 동일한 선별 성능을 보유하고 있다는 것을 확인할 수 있었다. 따라서 제안한 알고리즘이 결점과 분류 시, 높은 정밀도로 선별할 수 있고, 연산량 및 파라메터 수가 대폭 감소되어 우리나라 과일 선별기에 적용 가능한 방법임을 확인하였다.

Ⅴ. 결 론

결점과를 분류하기 위한 기존의 CNN들은 연산량과 파라메터 수가 너무 많아 선별기에 적용하기 어렵다는 문제점을 가지고 있고, 최근에 제안된 연산성능이 낮은 디바이스에서도 사용할 수 있는 MobileNet이 제안되었지만, 선별기를 이용하여 과일의 결점과를 분류할 경우, 정상 과일을 결점이 있는 과일로 인식하는 문제점이 발생하고 있었다.

따라서 본 논문에서는 이러한 문제점을 해결하고, 실제 산업 현장의 고속 과일 선별기에 적용하여 결점과를 검출할 수 있는 수정된 MobileNet 알고리즘을 제안하였다. 제안한 알고리즘의 유용성을 입증하기 위하여 우선 제안한 알고리즘과 기존의 알고리즘 중, 연산량과 파라메타 수가 제일 적은 MobileNet의 연산량과 파라메터 수를 비교 평가하였다. 그 결과, 제안 알고리즘의 연산량은 1억4400만개, 파라메터수는 170만개로 MobileNet과 비교하여 연산량은 약 75%, 파라메터 수는 약 60%의 감소되어 알고리즘의 유용성을 확인하였다. 또한, 제안한 알고리즘을 이용하여 실제 감귤 표면을 촬영하여 취득한 영상으로 결점과 분류 성능 평가를 수행한 결과, 100% 문제없이 분류되는 것을 확인하였다. 따라서 현재 우리나라에서 사용하고 있는 고속 과일 선별기에 제안한 알고리즘을 적용하여 결점과를 판별할 수 있다는 것을 입증하였다.

금후에는 제안한 알고리즘을 적용하여, 실시간으로 결점과를 분류할 수 있는 시스템을 구현할 예정이다.

References

-

J. Blasco, N. Aleixos, and E. Moltó, "Machine Vision System for Automatic Quality Grading of Fruit", Automation and Emerging Technologies, Vol. 85, No. 4, pp. 415-423, Aug. 2003.

[https://doi.org/10.1016/S1537-5110(03)00088-6]

-

J. M. Yoon and H. Y. Kim, "Defect Detection Algorithm of the Mandarin Using Shape Based Lightness Correction Model", Journal of Korean Institute of Information Technology, Vol. 14, No. 4, pp. 195-201, Apr. 2016.

[https://doi.org/10.14801/jkiit.2016.14.4.195]

- A. Krizhevsky, I. Sutskever, and G. E. Hinton, "Imagenet classification with deep convolutional neural networks", Advances in neural information processing systems, Vol. 25, No. 2, pp. 1097-1105, Jan. 2012.

-

H. Biao and D. S. Kang, "The Research of Face Expression Recognition based on CNN using Tensorflow", Journal of Advanced Information Technology and Convergence, Vol. 7, No. 1, pp. 55-63, Jul. 2017.

[https://doi.org/10.14801/jaitc.2017.7.1.55]

-

C. Szegedy, W. Liu, Y. Jia, P. Sermanet, S. Reed, D. Anguelov, D. Erhan, and A. Rabinovich, "Going deeper with convolutions", Proc. of IEEE Conf. on Computer Vision and Pattern Recognition, Boston, MA, USA, pp. 1-9, Jun. 2015.

[https://doi.org/10.1109/CVPR.2015.7298594]

- K. He, X. Zhang, S. Ren, and J. Sun, "Deep Residual Learning for Image Recognition", Proc. of IEEE Conf. on Computer Vision and Pattern Recognition, Las Vegas, USA, pp. 770-778, Jun. 2016.

-

Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun, "Identity mappings in deep residual networks", European Conference on Computer Vision, Ålborg, Denmark, pp. 630-645, Jul. 2016.

[https://doi.org/10.1007/978-3-319-46493-0_38]

-

L. M. Azizah, S. F. Umayah, S. Riyadi, C. Damarjati, and N. A. Utama, "Deep learning implementation using convolutional neural network in mangosteen surface defect detection", 2017 7th IEEE International Conference on Control System, Computing and Engineering (ICCSCE), Penang, Malaysia, pp. 242-246, Nov. 2017.

[https://doi.org/10.1109/ICCSCE.2017.8284412]

-

Carlito Pinto, Junya Frukawa, Hidekazu Fukai, and Satoshi Tamura, "Classification of Green Coffee Bean Images Based on Defect Types Using Convolutional Neural Network", 2017 International Conference on Advanced Informatics, Concepts, Theory, and Applications (ICAICTA), Denpasar, Indonesia, pp. 16-18, Aug. 2017

[https://doi.org/10.1109/ICAICTA.2017.8090980]

- F. N. Iandola et al., "SqueezeNet: AlexNet-Level Accuracy with 50x Fewer Parameters and < 0.5MB model size", arXiv:1602.07360v4, Nov. 2016.

-

X. Zhang et al., "ShuffleNet: An Extremely Efficient Convolutional Neural Network for Mobile Devices", arXiv:1707.01083, Dec. 2017.

[https://doi.org/10.1109/CVPR.2018.00716]

-

B. J. Kim, "Improved Deep Learning Algorithm", Journal of Korean Institute of Information Technology, Vol. 8, No. 2, pp. 119-127, Dec. 2018.

[https://doi.org/10.14801/JAITC.2018.8.2.119]

- Andrew G. Howard, "MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications", arXiv:1704.04861, Cornell University Library, Apr. 2017.

2012년 ~ 현재 : ㈜에스엔피시스템 재직중

2013년 ~ 현재 : 청주대학교 전자공학과 (박사과정) 재학중

관심분야 : 신호처리, 비파괴센서, 과일선별기

2013년 9월 : 동북대학교(일본) 정보과학연구과 (공학박사)

2013년 9월 ~ 2015년 8월 : 청주대학교, 한국교통대학교 시간강사

2015년 9월 ~ 현재 : 청주대학교 전자공학과 교육전담 조교수

관심분야 : 음향, 오디오, 신호처리

1996년 3월 : 동북대학교(일본), 정보과학연구과 (공학박사)

1997년 ~ 현재 : 청주대학교 전자공학과 교수

관심분야 : 음향, 영상신호처리, 3차원 입체음향, 전기음향