스켈레톤 매핑을 이용한 3D 애니메이션 콘텐츠 생성 시스템

초록

본 논문에서는 3D 카메라를 이용하여 사람의 얼굴 표정과 몸의 동작을 따라하는 3D 콘텐츠의 애니메이션을 생성하는 시스템을 제안하였다. 제안된 시스템은 3D 모델의 스켈레톤을 매핑을 하여 사람뿐만 아니라 임의의 형태의 3D 모델에 대한 애니메이션 생성이 가능하다. 또한 눈과 입은 메쉬 기반이던 기존과 달리 스켈레톤 기반으로도 표현이 가능하도록 하였고, 몸의 동작과 본의 동작범위가 일치하지 않아도 보상을 통해 유용한 애니메이션 생성이 가능하도록 하였다. 사람, 호랑이, 토끼에 대한 3D 애니메이션 콘텐츠를 생성하는 실험을 수행하였다. 실험 결과를 통해 사람 형태의 콘텐츠뿐만 아니라 호랑이나 토끼의 3D 콘텐츠 동작에 대한 애니메이션도 생성할 수 있고, 얼굴 표현에 대한 애니메이션 생성도 가능함을 확인하였다. 또한, 토끼 귀에 본을 추가하고 보상을 통해 동작을 제어할 수 있음을 확인하였다. 따라서 제안된 애니메이션 생성 시스템은 3D 모델의 형태에 관계없이 다양한 애니메이션 콘텐츠 제작에 유용하게 이용될 수 있다.

Abstract

In this paper, we proposed a platform for producing a 3D animation that controlled by human motion and facial expressions using 3D camera. The proposed platform is capable of generating a 3D animation of humanoid or any other 3D models by mapping its skeleton to the human body’s. We also expressed a movement of eyes and mouth by controlling the added skeleton in face‘s mesh. The motion in animation can be compensated even if the skeleton of body and the 3D objects do not match each other. Experimental results showed that it could be produced the 3D animations of tiger, rabbit and humanoid contents and their face also could be expressed. It was also possible to control a motion of rabbit ears by compensation. Therefore, the proposed system can be used in the production of animation of the 3D model efficiently.

Keywords:

skeleton mapping, 3D contents, animation production, virtual reality, depth cameraⅠ. 서 론

최근 VR(Virtual Reality) 또는 AR(Augmented Reality) 등 새로운 기술들이 등장함에 따라 디지털 콘텐츠의 중요성이 새롭게 부각되고 있다. 이로 인하여 3D 콘텐츠의 수요가 크게 증가되고 있다[1]. 또한, 스마트폰 등에서 이를 위해 3D 카메라가 내장된 제품이 출시되고 있다. 따라서 3D 콘텐츠 제작이 용이한 시스템이나 프로그램 개발을 위한 기술이 더욱 요구되고 있다. 또한 고가의 장비가 요구되었던 모션 캡처 분야에서도 일반적으로 사용하는 3D 카메라, 3D 디스플레이를 활용하여 유용한 콘텐츠 제작이 가능하게 되었다. 이와 같이 3D 컨텐츠는 HMD(Head Mounted Display)를 이용한 가상현실 서비스나 VR기기들의 보급으로 보편적으로 사용되고 있다[2]. 더불어 다양한 하드웨어의 보급과 3D 콘텐츠의 보급으로 인하여 이들 콘텐츠의 연속적인 동작으로 구성된 애니메이션 콘텐츠도 필요하다.

모션 캡처에는 기계식, 자기식, 광학식 등 다양한 방식이 있다[3][4]. 장비나 센서를 필요로 하는 기계식, 자기식, 그리고 광학식은 고가이며, 신체에 부착하여야 하는 단점이 있다. 이에 비해 3D 카메라를 이용하는 방식은 특정한 센서나 마커를 부착하지 않고 처리될 수 있는 이점을 가지고 있다. 마이크로소프트의 3D 카메라인 키넥트는 저렴한 가격에 이용할 수 있는 상용 제품이다. 사람의 골격이나 얼굴 표정은 키넥트의 3D 정보인 깊이(Depth) 정보와 비전 기술을 활용하여 얻을 수 있다[5]. 이는 가상의 특징 포인트를 비전 처리를 통해 추출할 수 있고, 이들의 변화를 추적함으로써 움직임에 대한 정보를 얻을 수 있기 때문이다. 또한 이들로부터 가상의 관절 포인트 및 이들의 조인트도 얻을 수 있다[6].

반면, 디지털 3D 콘텐츠는 3D 정보를 갖고 있는 메쉬(Mesh) 및 메쉬의 움직임을 제어하기 위한 본(Bone)으로 구성되어 있다. 이 콘텐츠는 본을 이동시킴으로써 콘텐츠의 움직임을 표현할 수 있다[7]. 인간뿐만 아니라 동물들의 움직임도 마찬가지로 본을 중심으로 표현할 수 있다[8]. 또한 가상공간에서 크기가 다른 임의의 3D 콘텐츠의 움직임도 본을 이용하여 표현할 수 있다[9]. 이와 같이 가상의 공간에서의 콘텐츠의 움직임은 프로그래밍에 의한 가상의 애니메이션 동작을 표현될 수 있다[10]. 이와는 다르게 가상의 디지털 콘텐츠의 동작이 프로그래밍이 아닌 사람의 행동에 따라 제어된다면 가상의 애니메이션 콘텐츠는 다양하게 제작될 수 있다[11]. 키넥트를 이용한 기존의 애니메이션은 아바타처럼 사람의 스켈레톤과 1:1로 정합시킬 수 있는 3D 콘텐츠의 애니메이션으로 한정하여 생성되었다.

따라서 본 논문에서는 3D 카메라를 이용하여 사람의 동작이나 표정에 대한 정보를 얻고 이를 가상의 3D 콘텐츠의 다양한 매핑을 통해 애니메이션을 생성하는 시스템을 제안한다. 제안된 시스템은 사람의 동작과 표정에 대한 특징 포인트를 추출하고 스켈레톤간의 매핑으로 이들의 움직임이 디지털 콘텐츠의 동작에 반영되도록 한다. 이 때 사람 형태가 아닌 3D 콘텐츠의 본은 보정을 통하여 보완하여야 한다. 그리고 3D 콘텐츠의 본을 이용하여 눈이나 입의 움직임도 매핑하고, 이를 3D 애니메이션 콘텐츠를 생성하는 데 사용할 수 있도록 한다. 따라서 제안된 시스템은 마커나 센서 등 추가적인 장비가 필요하지 않아 비교적 저가의 3D 카메라를 이용하여 3D 콘텐츠의 행동과 얼굴 동작 등의 애니메이션 동작을 제어할 수 있도록 한다.

Ⅱ. 3D 동작 애니메이션 콘텐츠 생성

2.1 제안된 시스템의 구성

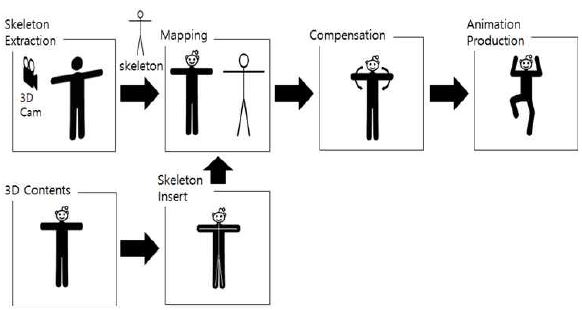

제안된 시스템은 그림 1과 같이 3D 카메라와 3D 콘텐츠를 입력으로 하고, 이들의 스켈레톤을 추출, 매핑 및 보상을 거쳐 3D 애니메이션을 생성한다. 3D 카메라는 외부의 영상을 캡처하여 깊이 정보를 얻을 수 있다.

본 논문에서는 RGB 센서와 깊이 정보를 얻을 수 있는 키넥트 v2를 이용하였다. 그리고 3D 콘텐츠는 툴을 이용하여 콘텐츠에 본을 추가하여 움직임에 대응할 수 있도록 제작한다. 즉, 3D 콘텐츠는 메쉬와 본을 포함하는 3D 모델이며, 3D 카메라로부터 얻는 사람의 동작을 이용하여 애니메이션을 생성하는 대상이다.

또한 사람의 스켈레톤과 3D 모델의 본을 매핑하는 작업을 수행하는 과정이 필요하다. 사람의 스켈레톤은 3D 모델의 본을 움직여 애니메이션을 생성하는데 요구된다.

이 때 사람 형태를 갖는 3D 콘텐츠는 스켈레톤과 쉽게 본을 맵핑하여 애니메이션을 얻을 수 있지만 사람이 아닌 3D 콘텐츠는 관절의 구조와 회전 가능 범위가 달라 보정을 해야 의미 있는 애니메이션 콘텐츠를 얻을 수 있다.

2.2 3D 콘텐츠의 구성

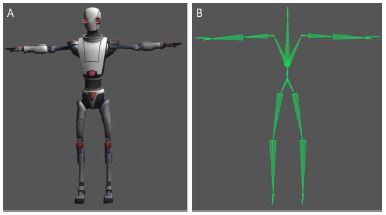

전술한 바와 같이 3D 모델은 메쉬, 본, 그리고 텍스처(Texture)로 이루어져 있다고 하였다. 이를 그림 2에 도시하였다. 메쉬는 모양 및 형태를 나타내는 3D 모델의 기하학적인 정보이고, 본은 메쉬 내부에 있으며, 3D모델의 메쉬와 함께 움직이도록 하는 골격이다. 이를 통해 3D 모델은 메쉬를 쉽게 제어하며 애니메이션을 제작할 수 있다. 이는 인간의 뼈와 근육이 살과 연결되어 있는 것과 같이 메쉬에 본을 붙여서 3D 모델을 움직일 수 있도록 만든 것이다.

가상의 3D 콘텐츠는 본을 내부에 추가함으로써 본의 움직임에 따른 전체 콘텐츠의 움직임을 제어할 수 있다. 3D 콘텐츠는 일반적으로 유니티, 언리얼 엔진과 같은 게임엔진의 도움을 받아 제작할 수 있다.

사람이나 특정한 동물과 같이 본의 위치가 구조적으로 정해져 있는 경우에 본 구조 전체를 스켈레톤이라 하며, 스켈레톤의 관절 부분을 조인트라고 한다. 일반적으로 3D 모델은 본의 조인트를 제어하여 메쉬와 본을 움직이는 방식으로 3D 콘텐츠의 움직임을 제어한다.

2.3 스켈레톤 추출

사람의 동작은 3D 카메라로부터 스켈레톤에 대한 정보를 얻어야 한다[12]. 스켈레톤은 사람의 움직임을 제어하기 위해 관절과 조인트를 서로 연결한 3D 모델의 골격의 전체 형태이다. 3D 오브젝트의 움직임은 스켈레톤의 연결 강도와 조인트의 개수의 영향을 받는다. 스켈레톤의 조인트가 많을수록 더 자세한 움직임 표현이 가능하다.

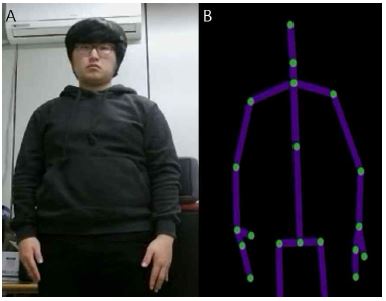

그림 3은 키넥트를 이용하여 추출된 사람의 스켈레톤의 한 예를 나타낸 것이다. 일반적으로 사람의 스켈레톤은 21개의 조인트와 20개의 조인트를 연결한 본으로 이루어진 구조이다[13]. 조인트는 우리가 알고 있는 인간의 골격구조에 맞춰 척추, 허리, 왼쪽 손목, 오른쪽 손목, 왼쪽 팔꿈치, 오른쪽 팔꿈치, 왼쪽 어깨, 오른쪽 어깨, 머리, 왼쪽 무릎, 오른쪽 무릎, 왼쪽 발꿈치, 오른쪽 발꿈치를 기반으로 구성된다. 이들의 위치에 따라서 콘텐츠의 동작이 나타난다.

2.4 스켈레톤 매핑

스켈레톤 매핑은 사람의 스켈레톤과 컨텐츠의 본을 매핑하는 과정이다. 본은 연결 강도에 따라 메쉬에 영향력을 미친다. 따라서 스켈레톤과 본의 매핑만으로도 메쉬의 움직임을 제어할 수 있다. 이는 사람의 스켈레톤의 동작과 대응하는 것으로 동물이나 사람의 3D 모델에 적용하여 3D 모델의 동작을 표현하는 방법이다. 사람과 유사한 스켈레톤 구조를 가진 모델은 사람의 스켈레톤을 1:1 매핑하여 3D 모델의 애니메이션을 생성할 수 있지만, 그렇지 않은 3D 동물 모델은 사람의 스켈레톤과 본의 적절한 매핑을 통해 애니메이션을 생성할 수 있다. 특히 토끼인 경우, 팔의 움직임으로 토끼 귀와 매핑시켜 애니메이션을 표현할 수도 있다.

2.5 보상

스켈레톤 매핑 과정에서 사람의 스켈레톤과 다른 구조이거나 또는 매핑에 따라 동작 범위가 다른 경우에는 그 동작범위에 대한 차이를 보상하여야 한다. 3D 콘텐츠에서 360도로 회전하는 것은 가능하지만, 사람은 360도로 관절을 회전하지 못하기 때문이다. 또한 조인트의 위치가 다르거나 크기가 다른 경우에도 보상을 통해 올바른 표현이 되도록 해야 한다.

Ⅲ. 3D 얼굴 표정 애니메이션 콘텐츠 생성

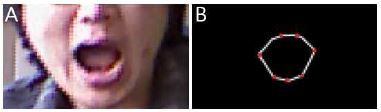

일반적으로 컴퓨터 비전 기술에서 얼굴의 표현은 콘텐츠의 메쉬를 이용하여 표현하고 있다. 말하기와 표정 등 얼굴의 메쉬 표현은 얼굴 리깅(face rigging) 등에 응용되고 있다. 그림 4는 Kinect를 사용하여 휴먼 모델의 메쉬를 추출한 것을 보여주고 있다. 이는 얼굴에 대한 특징 점을 중심으로 한 메쉬의 구조를 보여준다. 한 예로 사람의 얼굴은 86개 포인트를 추적하여 사람의 눈썹, 눈, 코, 입, 그리고 턱의 움직임에 대한 정보를 얻어 표현한다.

그러나 본 논문에서는 메쉬와 본으로 구성된 3D 콘텐츠의 애니메이션 동작을 표현하려고 한다. 이는 기존의 콘텐츠에 메쉬뿐만 아니라 본이 추가되어야 가능하다. 일반적으로 사람의 스켈레톤은 미리 정의되어 동작에 대한 표현이 가능하지만, 사람의 눈이나 입은 스켈레톤이 아니라 근육에 따라 움직임이 표현된다. 따라서 본 논문에서는 스켈레톤을 추가하고 본과의 매핑으로 동작을 제어하고자 한다. 동작은 3D 콘텐츠의 새로운 본을 심을 위치와 개수에 따라 달라질 수 있다.

따라서 얼굴의 동작 표현은 눈이나 입 등에 가상의 본을 추가하고, 이들의 움직임으로 표현될 수 있다. 이 때 본은 관절의 회전과 이동이 아닌 근육의 움직임을 표현하기 위해 사용한다. 얼굴의 본은 리깅을 통해 움직임이 필요한 위치에 조인트를 추가하여 사용한다. 눈꺼풀 또한 이들과 연동되기 위해서는 눈 근처에 본을 추가하고 눈을 뜨고 감을 수 있도록 한다. 마찬가지로 입을 움직이기 위해서는 입술 주변에 본을 추가하여야 한다.

3.1 얼굴 스켈레톤 추출

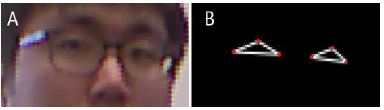

먼저, 카메라로부터 입력된 영상에서 얼굴에 대한 스켈레톤이 정의되어야 한다. 이 스켈레톤은 본과 매핑이 가능하며, 콘텐츠의 동작을 제어할 수 있다. 스켈레톤은 영상처리 기술을 이용하여 추출될 수 있다. 먼저, 눈은 눈의 양끝과 위쪽 눈꺼풀을 특징 점으로 추출이 가능하다. 추출된 특징 점들이 많을수록 정밀한 애니메이션 표현이 가능하다.

그림 5는 이들을 나타낸 것이다. 그리고 입은 입 양끝과 윗입술의 좌우 최고점, 아랫입술의 중심점과 좌우 최저점을 추출함으로써 얻을 수 있다. 이 특징 점은 그림 6에서 붉은색으로 나타내었으며, 이들을 연결하여 얼굴 부분의 스켈레톤으로 한다.

3.2 3D 콘텐츠 제작

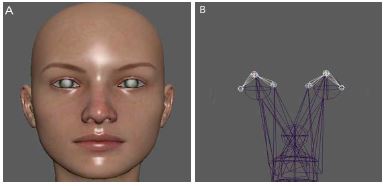

지금까지의 얼굴은 주로 메쉬의 움직임으로만 표현하였고, 이로 인해 메쉬 특징 정합 기술이 이용되었다. 본 논문에서는 메쉬로 구성된 콘텐츠에 본을 추가하여 본의 움직임으로 얼굴을 표현하고자 한다. 얼굴 콘텐츠에 눈에 대한 본을 추가한 결과를 그림 7B의 흰 선으로 표시하였다.

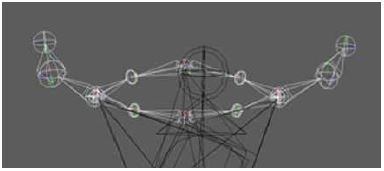

또한 입은 입술과 뺨의 움직임에 따라 그 동작이 표현된다. 그림 8은 입술을 따라 본을 추가시킨 것이며, 추가된 본과 매핑을 통해 입의 동작을 표현할 수 있다.

그리고 생성된 본은 다른 3D 모델의 본에 재사용이 가능하다. 즉, 본이 메쉬에 영향을 미치는 연결 강도는 본의 재사용으로 쉽게 흉내 낼 수 있다. 예를 들어 사람의 걷는 동작은 만들어진 본을 로봇의 걷는 동작을 표현하기 위해 사용될 수 있다. 기본적으로 동물 3D 모델의 얼굴은 사람 모델과 마찬가지로 눈, 코, 입으로 구성되어 있기 때문이다. 그러나 동작이 사람과 다른 동물은 이에 대한 본이 추가되어야 하는 경우도 있다[4][5]. 제안된 시스템에서는 호랑이와 토끼 콘텐츠에 본을 추가하여 애니메이션을 생성하였다. 3D 호랑이 콘텐츠에는 머리를 중심으로 오른쪽 눈, 왼쪽 눈, 턱에 본을 추가하였다. 이를 그림 9에 도시하였다.

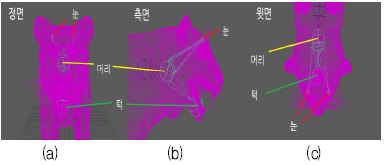

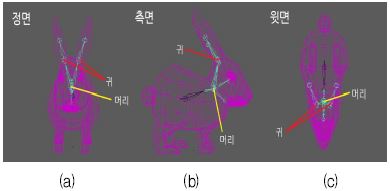

3D 토끼 콘텐츠에는 오른쪽 귀, 왼쪽 귀에 본을 추가하였고, 그림 10은 정면, 측면, 윗면에서 바라본 모습 각각 도시한 것이다.

Ⅳ. 실험 및 결과

제안된 애니메이션 생성 시스템은 얼굴과 몸의 동작을 나누어 실험을 하였다. 또한 서로 다른 본의 형태를 갖는 구조에도 적용할 수 있음을 확인하기 위해 호랑이와 토끼 컨텐츠에 그림 9와 10과 같이 본을 추가하여 스켈레톤 매핑을 실험하였다.

먼저, 사람과 동일한 스켈레톤 구조를 갖는 콘텐츠에 애니메이션 동작을 실험하였다. 그림 11은 이에 대한 결과를 도시한 것으로서 사람의 동작에 따라 애니메이션이 자연스럽게 생성되었다.

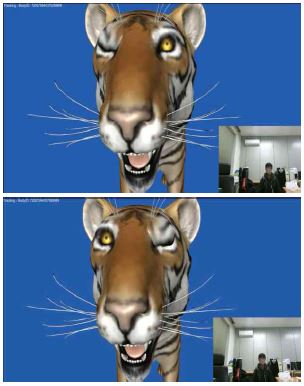

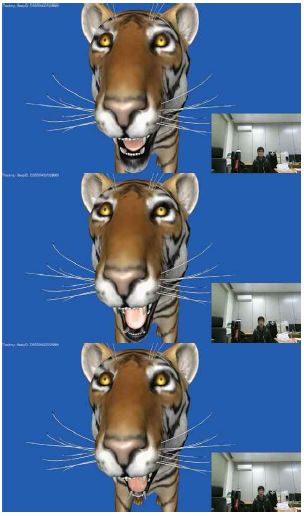

다음은 얼굴에 대한 입과 눈의 동작을 실험하였다. 그림 12에 그 결과를 도시하였다. 본 논문에서는 간단한 스켈레톤만으로 얼굴 동작을 표현하였지만, 스켈레톤을 수정한다면 정밀한 동작을 갖는 애니메이션 생성도 가능하다.

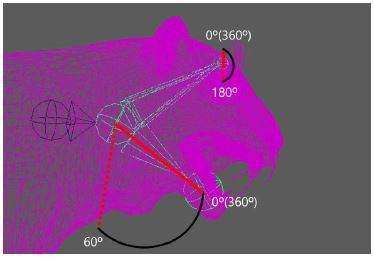

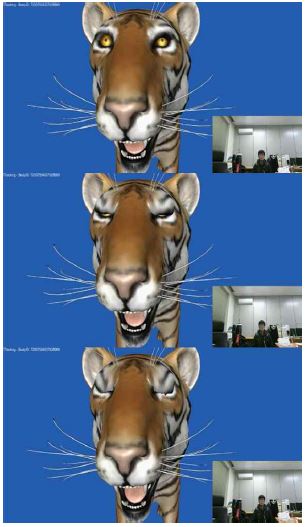

호랑이 얼굴 콘텐츠에 제안된 시스템을 적용하여 실험하였다. 이 경우에는 사람의 입의 동작 범위와 호랑이의 입의 범위가 달라 보상이 필요하였다.

표 1에 눈과 턱의 움직임에 대한 보상 결과를 나타내었다. 호랑이는 눈을 뜨고 있고, 입을 약간 벌린 상태를 초기상태로 설정하였다.

그림 13은 움직임 보상에 따른 추가된 본을 다시 나타낸 것이다. 호랑이 얼굴은 사람 얼굴에서 눈과 입의 동작을 이용하여 애니메이션을 생성하였다. 호랑이 모델의 입을 움직이기 위해 턱의 x 축과 y 축을 회전하지 못하도록 고정하고 z 축만 약 60˚까지 회전할 수 있도록 회전범위를 지정하였다. 또한 3D 호랑이 콘텐츠가 눈을 감고 뜰 수 있도록 왼쪽 눈과 오른쪽 눈도 각각의 x 축, y 축을 회전하지 못하도록 고정하고 z 축만 180˚까지 회전할 수 있도록 회전 보상 범위를 지정하였다.

그림 14에서 16은 회전 보상을 적용한 3D 호랑이에 제안된 시스템을 적용하여 애니메이션을 생성한 결과이다. 그림 14는 오른쪽/왼쪽 눈 동작에 대한 애니메이션을, 그림 15는 호랑이 입 동작을, 그림 16은 두 눈에 대한 동시 동작에 대한 애니메이션 결과를 도시한 것이다. 호랑이 얼굴에 적용된 애니메이션 생성 시스템은 잘 동작됨을 확인하였다.

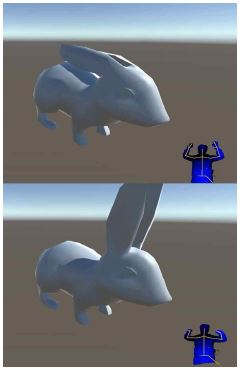

마지막으로 사람 손의 동작을 이용하여 3D 토끼의 귀를 제어하는 실험을 하였다. 가상의 동물 3D 콘텐츠의 움직임을 표현하기 위해서 사람이 동물의 움직임을 흉내를 내어

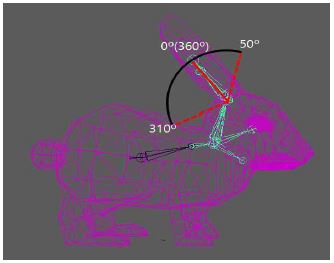

표현하는 경우가 있다. 예를 들어 토끼가 귀를 쫑긋 거리는 모양은 사람이 손목과 팔을 움직이는 동작으로 표현될 수 있다.토끼의 목에서부터 귀에 이르는 부분까지 그림 17과 같이 본을 추가하였다. 토끼는 머리, 왼쪽 귀, 그리고 오른쪽 귀로 구성되어 있다. 토끼 귀는 회전 중간 지점에 오도록 초기상태를 설정하였다. 토끼의 애니메이션은 팔꿈치와 손의 동작을 이용하여 생성하였다.

이를 위하여 표 2와 같은 회전 보상이 필요하다. 회전 운동은 원을 따라 이루어지며, 3D 토끼 모델의 귀는 사람 손의 모션으로 왼쪽 귀 스켈레톤의 z 축을 0도에서 50도 범위, 310도에서 360도 범위 내에서만 동작하도록 제한하면 된다. 이 때 x 축과 y 축은 고정시켰다. 그림 18은 토끼 귀의 애니메이션 결과를 도시한 것이다.

실험을 통해 제안된 시스템이 사람의 스켈레톤 구조뿐만 아니라 호랑이나 토끼의 3D 콘텐츠의 동작을 제어하여 애니메이션을 생성할 수 있음을 확인하였다. 뿐만 아니라 얼굴 동작에 대한 애니메이션도 스켈레톤을 추가함으로써 생성이 가능함을 확인하였다. 따라서 제안된 애니메이션 생성 시스템은 다양한 다량의 애니메이션 콘텐츠 제작에 이용할 수 있는 플랫폼으로 사용될 수 있음을 확인하였다.

Ⅴ. 결 론

본 논문에서는 3D 카메라를 이용하여 사람의 얼굴과 몸의 동작으로 다양한 3D 콘텐츠의 애니메이션을 생성하는 시스템을 제안하였다. 제안된 시스템은 사람의 동작 정보에 따라 스켈레톤 구조가 같거나 달라도 스켈레톤 매핑에 의해 애니메이션 생성이 가능함을 확인하였다. 특히, 얼굴의 경우, 메쉬뿐만 아니라 본을 추가하여 애니메이션 동작이 가능함을 확인하였다. 그리고 눈과 입의 동작은 얼굴에 스켈레톤을 새롭게 추가하여 이들을 보상하여 다양한 애니메이션이 가능하다는 것을 알았다. 특히 입은 턱 관절 스켈레톤을 추가함으로써 가능하였다. 실험 결과를 통해 사람 형태의 콘텐츠뿐만 아니라 호랑이나 토끼의 3D 콘텐츠 동작에 대한 애니메이션도 생성할 수 있고, 얼굴에 대한 애니메이션 생성도 가능함을 확인하였다. 토끼 귀에 본을 추가하고 보상을 통해 동작 제어도 가능하였다. 제안된 애니메이션 생성 시스템은 3D 모델의 형태에 무관하게 다양한 애니메이션 콘텐츠를 제작할 수 있으며, 3D 모델의 스켈레톤이 다양하고 복잡할수록 더 정밀한 애니메이션 콘텐츠 제작이 가능하다.

Acknowledgments

이 논문은 부산대학교 기본연구지원사업(2년)에 의하여 연구되었음

References

-

B. C. Cho, "Success Factor of 3D Movie 'Avatar' and the Possibility Analysis of the Korean 3D Contents", Journal of the Korea Contents Association, 10(9), p137-145, Sep), (2010.

[https://doi.org/10.5392/jkca.2010.10.9.137]

- E. J. Cha, and J. Y. Han, "Virtual Reality contents : a full sensorial experience", Journal of the Korea Institute of Spatial Design, 11(5), p9-17, Oct), (2016.

- M. G. Lee, S. G. Park, G. P. Park, S. U. Yang, and B. R. Lee, "Technical Trend of Motion Capture", Electronics and telecommunications trends, 22(4), p35-42, Aug), (2007.

-

Yeong-Hyeon Byeon, Myung-Won Lee, and Keun-Chang Kwak, "A Trend Analysis of Motion Capture Systems for Sports Motion Analysis", The Journal of Korean Institute of Information Technology, 11(5), p191-201, May), (2013.

[https://doi.org/10.14801/kiitr.2013.11.5.191]

-

J. S. Shin, K. R. Ko, and S. B. Pan, "Automation of Human Body Model Data Measurement Using Kinect in Motion Capture System", The Journal of Korean Institute of Information Technology, 12(9), p173-180, Sep), (2014.

[https://doi.org/10.14801/kitr.2014.12.9.173]

-

Z. Zhang, "Microsoft Kinect Sensor and Its Effect", IEEE MultiMedia, 19(2), p4-10, Feb), (2012.

[https://doi.org/10.1109/mmul.2012.24]

-

K. W. Sok, M. Y. Kim, and J. H. Lee, "Simulating biped behaviors from human motion data", ACM, Transactions on Graphics, 26(3), p107-115, Aug), (2007.

[https://doi.org/10.1145/1276377.1276511]

- J. W. Song, M. You, J. H. Kim, J. S. Yang, and J. Y. Noh, "A Study on Optical Motion Capture Process of Quadruped Animals and Motion Retargeting Pipeline of Quadruped Characters", The Korean Journal of animation, 11(5), p162-179, Dec), (2015.

-

S. L. Delp, and J. P. Loan, "A computational framework for simulating and analyzing human and animal movement, in Computing in Science & Engineering, 2(5), p46-55, Sep/Oct), (2000.

[https://doi.org/10.1109/5992.877394]

-

Wan-Bok Lee, Dong-Lyeor Lee, Seuc-Ho Ryu, and Tae-Jun Choi, "Digital Character Motion Using Motion Capturing System", Journal of the Korea Contents Association, 7(8), p109-116, Aug), (2007.

[https://doi.org/10.5392/jkca.2007.7.8.109]

-

J. H. Kang, B. J. Shin, S. B. Kwon, and S. J. Kim, "A Skeleton 3D Animation Modeling of Bird Flapping by Using Motion Capture", Journal of Korean Institute of Information Technology, 15(1), p151-158, Jan), (2017.

[https://doi.org/10.14801/jkiit.2017.15.1.151]

-

S. H. Kim, "Realtime 3D Human Full-Body Convergence Motion Capture using a Kinect Sensor", Journal of Digital Convergence, 14(1), p189-194, Jan), (2016.

[https://doi.org/10.14400/jdc.2016.14.1.189]

- Microsoft Developer Network Tracking Users with Kinect Skeletal Tracking, https://msdn,microsoft.com/en-us/library/jj131025.aspx [accessed: Feb. 16, 2018].

2016년 8월 : 부산대학교 IT응용공학과 졸업(공학사)

2018년 2월 : 부산대학교 IT응용공학과 졸업(공학석사)

관심분야 : 의료영상처리, 머신러닝, 딥러닝

1996년 8월 : 경북대학교 전자공학과(공학박사)

1997년 3월 ~ 현재 : 부산대학교 IT 응용공학과 교수

관심분야 : 신호 및 영상처리, 머신러닝, VR/AR, 스마트 카메라