Vive 트래커와 3D 프린팅을 활용한 VR 수공구 재해예방 콘텐츠

초록

산업현장 작업은 높은 위험성을 내포하며, 전통적인 교육 방법만으로는 현장의 복잡한 위험 요소와 상황을 충분히 이해하는 데 한계가 있다. 이 연구는 Vive 트래커(Tracker)를 활용하여 유니티(Unity) 기반의 VR(Virtual Reality) 수공구 재해예방 콘텐츠에서 사용할 수 있는 도구 개발과 그 효과성을 중심으로 탐구하였다. Witmer와 Singer가 제안한 실재감 설문지를 사용하여 VR 컨트롤러, 핸드 트래킹, 트래커를 이용한 도구 조작 제안 방법 세 가지의 실재감 수준을 측정한다. 실험을 통해, 트래커를 이용한 도구 조작 제안 방법이 VR 컨트롤러 방법이나 핸드 트래킹 방법보다 높은 실재감을 보였다. 제안 방법을 통해 사용자는 가상환경에서 물리적 도구를 사용하는 것처럼 느끼며, VR 경험의 현실감을 크게 향상하였다.

Abstract

Industrial workplaces inherently has been exposed high risks, and traditional training methods are limited in fully understanding the complex hazards and situations on site. This study investigates the creation and effectiveness of Unity-based VR hand tool accident prevention tools using Vive Trackers. It assesses presence levels with Witmer and Singer's presence questionnaire. Comparing three different methods: VR controllers, hand tracking, and tool manipulation using Vive Trackers. The experiment showed that the tool manipulation method using trackers offers a higher level of presence than VR controllers and hand tracking. This allows users to feel as though they are using physical tools in a virtual environment, significantly enhancing the realism of the VR experience.

Keywords:

vive tracker, 3D printing, unity, VR education, VR simulationⅠ. 서 론

산업현장에서의 작업은 그 특성상 다양한 위험 요소를 내포하고 있다. 이러한 위험 요소로 인한 사고는 심각한 부상, 심지어 사망까지 초래할 수 있어, 안전교육의 중요성이 강조되고 있다. 전통적인 교육 방법은 이론적인 지식 전달에 중점을 둔 반면, 현장의 복잡성과 위험 요소를 체계적으로 이해하는 데에는 한계가 있다. 이를 극복하기 위해 최근 VR(Virtual Reality) 기술이 안전교육에 도입되기 시작하였다[1-3]. VR은 사용자에게 현장과 유사한 체험을 제공함으로써 더 깊은 이해와 경험을 쌓게 해준다. 이러한 기술을 사용하면, 현장에서 발생할 수 있는 다양한 상황을 안전하게 재현할 수 있다[4]. 또한, VR은 현장에서 경험하기 어려운 다양한 시나리오를 쉽게 테스트할 수 있다. 사용자는 동일한 상황을 여러 번 반복해 볼 수 있으므로 학습 효과를 높일 수 있다. 전통적인 교육 방법의 한계를 극복하기 위한 혁신적인 방법으로 각광받고 있다[5].

최근 실감 효과를 주기 위해 3D프린팅과 VR 결합 연구가 진행되고 있다. 3D 프린팅 기술의 도입으로, 특정 목적이나 사용자의 요구에 부합하는 맞춤형 도구나 물체의 제작이 가능해졌다[6][7]. 이러한 커스텀 제작의 장점은 다양한 산업 분야에서 특별히 맞춤화된 VR 응용 프로그램의 개발에 큰 기회를 제공한다. 3D 프린팅과 VR을 함께 활용함으로써, 프로토타이핑과 시뮬레이션 과정이 빠르게 이루어진다[8]. 이는 제품이나 서비스의 개발 및 테스트를 전통적인 방식보다 효율적으로 진행하게 해준다. 실제 물체로부터 얻는 물리적인 반응과 가상환경의 유연성을 함께 활용함으로써, 사용자는 전보다 현실적이면서도 다양한 상호작용 경험을 누릴 수 있게 된다[9].

3D 모델링된 도구를 사용하는 것에 더해 트래킹 기술을 통해 사물이나 인체를 인식하는 여러 모델의 연구가 진행 중이다[10]. 일반 도구에 트래킹 장치를 부착할 경우, 물건의 측정과 그 특징을 모두 가상환경에 적용하기 어렵다. 이는 실제 물체와 가상환경의 물체가 상호작용에서 발생하는 물리적 반응의 정확성이 낮아질 수 있다. 따라서 실제와 가상환경 간의 상호작용을 개선하기 위해, 3D 모델링과 실제 출력한 물건의 비율을 똑같이 출력해야 한다. 따라서 3D 프린팅을 활용하여 사용자가 더 현실적인 물리적 반응을 경험할 수 있게 출력물을 가상과 실제가 동일한 크기로 사용한다. 이런 특징은 실제 도구를 사용할 때 발생하는 위험성과 비용을 낮출 수 있다.

본 연구에서는 유니티(Unity)를 사용하여 VR 기반의 수공구에 의한 재해예방 시스템을 설계한다. 사용자는 VR 컨트롤러, 핸드 트래킹, Vive 트래커(Tracker)를 부착한 도구 조작 제안 방식을 각각 체험한다. 체험 후 설문조사를 통해 각 조작방식을 통해 실재감이 어떻게 느껴졌는지를 실험 결과를 통해 확인한다.

Ⅱ. 관련 연구

2.1 VR 컨트롤러

VR 컨트롤러는 가상현실 환경 내에서 사용자의 움직임과 상호작용을 추적하고 전달하는 장치로, 가상 세계에서의 직접적인 조작이나 상호작용을 가능하게 한다. 이러한 컨트롤러는 대개 모션 센서, 버튼, 터치패드, 진동 모터 등을 탑재하여 사용자에게 더욱 풍부하고 직관적인 경험을 제공한다[11]. VR 컨트롤러의 반응성 및 정확성은 사용자가 VR 환경에서 느끼는 몰입감에 큰 영향을 미친다. 따라서 VR 시스템의 핵심 구성요소 중 하나로 간주되며, 다양한 모양과 크기로 제작되어 각 VR 플랫폼과 호환성을 갖추고 있다[12].

2.2 VR 핸드 트래킹

핸드 트래킹은 사용자의 손 움직임을 통해 사용자와 컴퓨터 간 상호작용을 가능하게 하는 제스처 인식 기술의 한 종류이다[13]. 이 기술은 컨트롤러를 활용한 방법에 비해 더 직관적으로 작동한다. 오브젝트를 터치하는 동작에서 문제점을 보이지 않았지만, 물체를 잡거나 이동시킬 때 오브젝트와 충돌 문제로 인해 수정이 필요하다. 이를 해결하기 위해 엄지와 검지가 붙었을 때 오브젝트가 손에 고정되는 핀치 기능을 사용한다.

핸드 트래킹은 손을 머리 뒤로 넘길 때와 같은 큰 움직임에서는 카메라의 인식 범위를 벗어나 손을 추적할 수 없는 문제가 발생한다. 컨트롤러 없이 핸드 트래킹으로 상호작용하는 것은 매우 직관적이나, 두 손이 겹치는 경우 UI 창을 선택하거나, 물체를 잡는 동작 등에서의 정확성이 VR 컨트롤러보다 성능이 낮은 편이다.

2.3 Vive 트래커

트래커는 VR 하드웨어 세트 중 하나로, 사용자의 움직임을 정밀하게 추적하도록 설계되었다[14]. 이 장치는 물체나 사용자의 몸 부위에 부착하여 실시간으로 위치 및 움직임 정보를 컴퓨터나 VR 시스템으로 전송한다. 이를 통해 사용자는 더욱 몰입감 있는 가상현실 경험을 얻을 수 있으며, 다양한 응용 분야에서 활용이 가능하다. Vive 트래커는 일반적으로 사용자의 팔과 다리, 허리 등 사용자의 신체 관절 부위에 장착하여 모션을 캡처하는 기능으로 사용된다. 다만, 도구를 직접 들어야 트래커와 연결된 사물과 상호작용을 할 수 있으며, 사용할 수 있는 트래커의 개수가 제한되어 있는 단점이 있다. 표 1은 VR 컨트롤러, VR 핸드 트래킹, Vive 트래커의 특징과 단점을 요약하였다.

Ⅲ. 시스템 제안

3.1 시스템 구현

VR 환경을 제작하기 위해 유니티 3D 엔진을 활용하여 각 시스템 기능을 구현한다. 유니티에서 컨트롤러를 연동하기 위해 패키지 매니저를 통해 VR을 통합하여 사용할 수 있는 XR Interaction toolkit을 이용한다[15]. 패키지 안에 있는 Complete XR Origin Hands Set Up 프리팹(Prefab)을 통해 컨트롤러를 씬(Scene) 화면으로 불러온다. 컨트롤러를 통해 잡을 오브젝트는 XR Grab Interactable 컴포넌트를 적용하여 컨트롤러의 그랩 버튼을 통해 잡을 수 있도록 설정한다.

핸드 트래킹 기능은 VR 디바이스의 전면 카메라를 통해 정면에 있는 손을 인식하여 추적하는 기능이다. 유니티 XR Interaction toolkit에는 VR기기 개발자들이 손 추적 데이터에 접근할 수 있는 XR Hands 패키지를 제공한다. XR Hands를 이용하여 잡기 위해 이전 컨트롤러와 마찬가지로 오브젝트의 컴포넌트로 XR Grab Interactable을 적용한다. 이때 컴포넌트의 속성으로 Use Dynamic Attatch를 체크하여 다양한 부분에서 오브젝트를 잡도록 설정한다. Select Mode에서 Multiple을 적용하여 양손으로 물체를 잡을 수 있도록 설정한다.

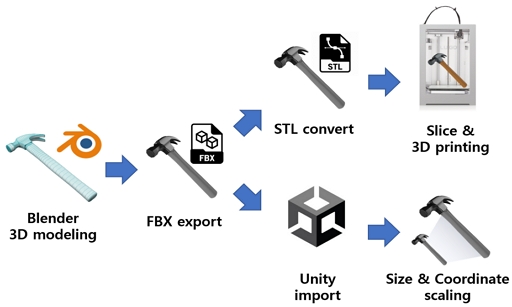

그림 1은 Vive 트래커, 유니티, 그리고 3D 프린팅을 함께 활용하여 가상 물체를 구현한 시스템의 개요다. Vive 트래커 2.0은 HTC의 VR 제품군 중 하나로, 물리적 객체나 사용자의 움직임을 정밀하게 추적할 수 있는 장치이다. 이 장치는 무선으로 작동하며 블루투스(Bluetooth) 연결을 통해 Vive 시스템과 통신할 수 있다. 특히 여러 개의 Vive 트래커를 동시에 사용할 수 있어, 복잡한 움직임과 다양한 물체의 위치를 동시에 추적할 수 있다.

수공구 3D 모델링은 블렌더(Blender) 소프트웨어를 통해 제작한다. 이때, 실제 사물의 크기와 블렌더의 3D 모델과 유니티의 3D 모델을 동일한 좌표계로 통일시켜야 한다. 통일시키지 않았을 경우, 블렌더에서 모델링한 파일이 유니티에서 다른 방향으로 위치하는 문제가 발생한다. 유니티는 Z축이 앞뒤, X축이 양옆, Y축이 위아래인 왼손 좌표계 및 Y Up 방식을 사용하고 있으며, 블렌더는 오른손 좌표계 및 Z Up 방식을 사용하고 있다. 따라서 일반적으로 FBX 포맷의 파일을 내보내면 크기와 좌표가 서로 맞지 않게 된다. 따라서 내보내기 옵션에서 스케일링을 FBX 단위 축적으로, 좌표계를 Z Forward, Y Up으로 설정하면 해당 문제를 해결할 수 있다.

3D 모델링을 완료하면 유니티로 불러오기를 통해 씬 화면으로 불러온 뒤, 실제 수공구의 크기와 동일하게 설정한다. 유니티의 1unit 단위는 실제 공간에서 1m를 의미하므로 이를 계산하여 가상과 실제 오브젝트의 크기를 조정한다. 크기가 조절된 물체를 FBX Expoter SDK를 통해 FBX 파일로 추출한다. 추출된 파일을 3D 프린트하기 위해 STL 파일로 변환시킨다. 이때, 이 물체에 트래커를 쉽게 부착할 수 있는 부분인 전용 마운트나 클립 같은 장치를 포함시켜 출력한다. 트래커의 주요 역할은 해당 물체의 위치와 방향을 VR 환경에서 실시간으로 추적하는 것이기 때문에, 정확한 위치의 부착이 필수적이다. Vive 트래커 2.0의 소켓은 1/4인치 UNC(Unified National Coarse) 나사산 마운트 홀 규격으로 표준 삼각대 마운트와 동일한 규격을 가지고 있다. 이를 기준으로 볼트가 들어가 고정할 수 있는 부분을 추가하여 출력한다.

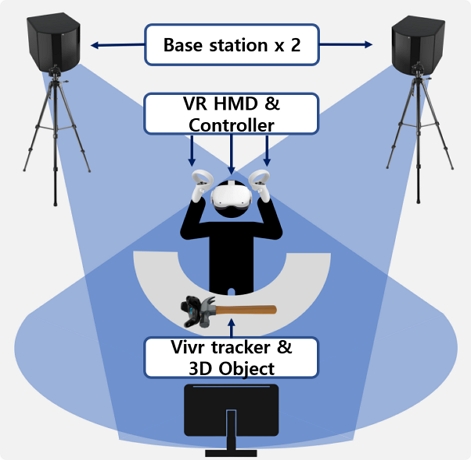

그림 2는 Vive 트래커가 가상환경에서 적용할 수 있도록 준비된 환경을 보여주는 그림이다. Vive 트래커는 트래커를 공간에서 추적할 수 있는 전용 베이스 스테이션을 2대 설치해야 한다. 베이스 스테이션은 Lighthouse 추적 기술을 기반으로 사용자의 물리적 공간 내에서 레이저 패턴을 방출하여 Vive 트래커 및 다른 VR 디바이스의 위치와 방향을 정밀하게 파악한다. 베이스 스테이션을 설치할 때는 가능한 높은 위치와 사용자의 뒤쪽에서 두 대각선 모서리에 설치하는 것이 추적 효율을 높일 수 있다.

그 후, 유니티 프로젝트를 통해 HTC Vive SDK, SteamVR 플러그인을 프로젝트에 불러오기를 한다. 설계했던 3D 모델을 유니티 환경에 가져와, Vive 트래커의 위치 및 회전 값을 해당 모델에 연결한다.

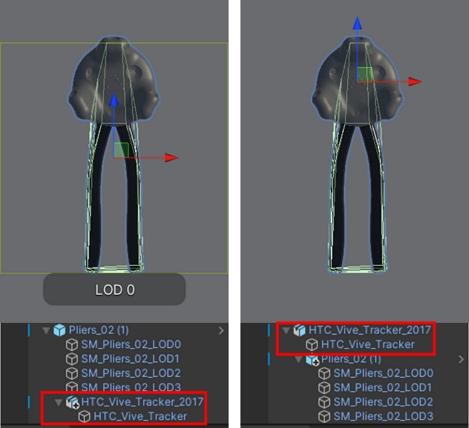

주의할 점으로 트래커의 위치를 피봇(Pivot)으로 설정할 수 있도록 가상공간에서 정확하게 위치시켜야 한다. 그림 3의 왼쪽 그림은 피봇이 오브젝트 중앙에 위치한 상태이며, 오른쪽은 피봇 기능을 추가하여 트래커 설치 위치에 중심이 변경된 그림이다. 유니티에서 피봇 자체를 변경할 수 있는 기능이 없으므로, 최상위 오브젝트로 피봇을 위치시키고 그 자식 오브젝트로 따라오는 오브젝트를 적용시킨다. 이를 통해 실제 Vive 트래커의 움직임이 유니티 환경 내의 3D 모델에 동기화된다.

3.2 재해예방 콘텐츠 구현

그림 4는 VR 콘텐츠에서 구현해야 할 요소를 순서대로 나열한 그림이다. 이를 바탕으로 유니티에서 현실감 있는 3D 환경을 설계하며, 공간의 구조, 기계들을 시각화하여 실제 작업장과 유사한 환경을 재현한다. 위험 요소를 가상으로 체험할 수 있는 시뮬레이션 공간을 제작하고, 각각의 시나리오를 통해 사용자가 현실과 유사한 반응을 경험할 수 있도록 설계한다. 더불어, VR 내에서의 상황별 대응이 가능한 대화형 교육 모듈도 개발하여 사용자의 선택에 따라 결과나 피드백이 달라지는 시나리오를 구성한다.

그 후, 개별적으로 개발된 각 VR 기기의 SDK 기능을 하나로 통합하며, VR 환경 내 원활한 작동을 위해 성능 최적화 작업을 수행한다. 초기 사용자 그룹을 대상으로 시스템 테스트를 수행하고, 그 과정에서 받은 피드백을 바탕으로 부족한 부분을 수정하여 시스템을 완성한다.

Ⅳ. 실험 체계

4.1 실험 측정

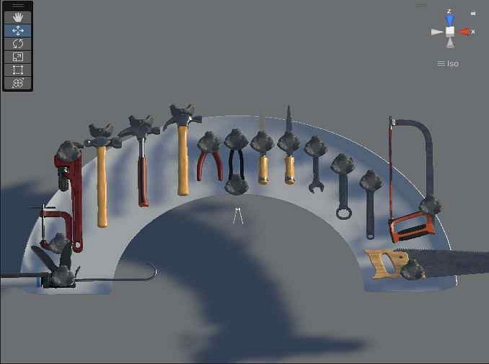

이 연구의 목표는 VR 산업현장 교육 콘텐츠에서 컨트롤러 조작, 핸드 트래킹 조작, 트래커 도구 조작 제안 방법이 실제로 얼마나 실재감을 상승하는지를 검증하는 것이다. 실험을 위해 Unity 2019.9.3f1 버전과 Meta Quest 2 기기를 사용하여 가상현실 애플리케이션을 개발했다. 애플리케이션 개발에는 유니티 에셋 스토어에서 제공하는 그래픽 리소스 및 블렌더 모델링을 활용하였다. 그림 5는 도구 조작을 위해 제작된 수공구 15개가 놓여진 가상환경 모습이다. 수공구는 종류에 따라 드라이버, 펜치, 스패너, 커터칼, 줄, 톱, 가위, 망치, 끌, 플라이어, 렌치, 클램프 등 다양한 도구를 배치한다.

본 연구는 2005년 Witmer와 Singer가 제안한 실재감 설문지인 PQ(Presence Questionnaire) 버전 3을 사용하여 실재감 수준을 측정하고, 이를 분석하여 가상환경 내 도구 사용 기능에 따른 가상현실 경험의 질을 평가하고자 한다[16][17].

설문 문항은 참여 (Involvement), 감각 충실도 (Sensory fidelity), 적응/몰입 (Adaptation/Immersion), 인터페이스 품질 (Interface quality) 항목으로 구성되며, 7점 척도(1점 매우 그렇지 않다, 7점 매우 그렇다)로 평가된다. 제어, 반응성, 자연스러움, 참여도, 시각적 및 청각적 몰입 등 다양한 측면(factors)을 평가한다. 아래 표 2에서 PQ의 각 항목들을 확인할 수 있으며, 본 실험에서 포함되지 않는 청각적 설문 문항인 13, 14, 15번 문항은 이번 설문에서 제외한다. 또한 불성실 응답을 탐지하기 위한 역채점 문항으로 27, 28, 29번을 사용한다.

피실험자 선정 과정에서는 산업현장에서의 작업 경험이 없는 총 60명의 20~30대 참가자를 모집하였다. 60명의 참가자들은 총 세 가지의 방법으로 교육 콘텐츠를 체험한다. 첫 번째는 VR 컨트롤러 장비를 이용하며, 두 번째는 핸드 트래킹 조작 기술을 활용하며, 세 번째는 Vive 트래커를 활용한 조작 기술을 통해 교육을 받는다. 교육 과정에서 모든 참가자들은 산업현장에서 수공구를 이용할 때 발생할 수 있는 다양한 위험 요소 상황들과 그에 대응하는 방법들에 대해 학습한다.

실험 시나리오는 수공구 위험요인 및 안전대책을 VR 환경에서 교육받은 후, 조립 수공구, 절단 수공구, 타격 수공구, 고정 수공구 총 4가지의 위험요인 및 안전대책 학습을 3가지의 방법으로 수행한다. 사용자는 각 수공구의 올바른 사용법과 잘못된 사용법을 확인하며, 사용 방향과 수공구 작업 자세에 의한 유해 요인, 건강장애, 주의사항, 스트레칭 방법 등의 교육을 체험한다.

실험은 사용자들이 각 10분간 가상공간 체험 후 30분의 휴식 시간 동안 VR 환경에서의 실재감과 관련된 설문조사를 시행한다. 설문이 종료된 이후에는 참가자들의 체험 방식에 대한 반응과 의견을 수집하는 피드백을 진행하고 결과를 확인한다.

4.2 실험 결과

표 3은 실험 결과를 나타내는 도표이다. 각 분야의 평균 점수는 순서대로 참여 3.69, 3.57, 4.44, 감각 충실도는 3.29, 3.70, 4.35, 적응/몰입은 3.88, 3.74, 4.45 인터페이스 품질은 3.95, 4.13, 4.97의 값이 나타났으며, 총 평균은 3.70, 3.78, 4.55로 나타났다. 관찰치가 26개이고 세 개의 방법이므로 ANOVA(Analysis of Variance) 테스트를 실시하여 세 방법 간에 통계적으로 학습효과 평균에 차이를 비교한다.

표 4는 ANOVA 분석을 SPSS로 진행한 결과이다. F값이 51.665이며 유의확률의 유의수준인 0.05보다 작기에 세 가지의 방법의 참가자들 간의 점수에 평균차이가 있음을 알 수 있다.

표 5는 Scheffe의 사후검정 결과이다. 동질적 부분집합 표를 보면 VR 컨트롤러와 핸드 트래킹이 한 집단으로, Vive 트래커가 한 집단으로 묶어 차이를 보인다. 또한 2번 집단의 참가자 점수가 1번 집단에 비해 비교적 높다. 이를 통해 Vive 트래커를 사용한 제안 방법의 점수가 가장 높게 나타난 것을 확인할 수 있다. 사후 설문지를 통해 Vive 트래커를 활용한 도구 사용의 설문 결과 사용자는 가상공간에서의 위험 요소를 체계적으로 이해할 수 있었다는 반응을 보였다. 특히 사용자가 실제 도구를 사용하는 경험과 VR에서의 시뮬레이션 된 도구 사용 경험이 유사하게 체험하는 것으로 높은 몰입감을 느낀 것으로 확인된다. 사용자들은 실제 도구를 사용함으로써 더욱 현실적인 피드백을 경험하고, 이를 통해 가상공간에서의 위험 요소를 보다 체계적으로 이해할 수 있었다. 본 연구의 결과를 통해 VR 교육 콘텐츠에서 실물을 이용한 도구의 사용법이 사용자의 실재감에서 더 효과적임을 확인할 수 있었다.

반면, VR 컨트롤러를 사용한 경우에는 진동을 통한 촉각적 피드백이 제공되며, 트리거 버튼 및 그랩 버튼을 통해 대상과 정확한 상호작용을 할 수 있었다. 이를 통해 3가지의 점수 중 감각 충실도가 가장 높은 것으로 나타났다. 핸드 트래킹의 경우 컨트롤러와 Vive 트래커 도구처럼 촉각 정보를 얻을 수 없으며, 주로 시각적 및 청각적 피드백에 의존하여 실물 도구를 사용하는 경험에 비해 참여도 측면에서 낮은 점수를 보였다.

Ⅴ. 결 론

산업현장에서 하는 여러 작업들은 많은 위험 요소를 내포하고 있어, 산업현장 가상 교육의 중요성이 대두되고 있다. 전통적인 교육 방법은 현장의 복잡성과 위험 요소를 완전히 전달하는 데 한계가 있다. 본 연구에서는 유니티를 활용하여 VR 기반의 교육 시스템을 개발하였고, 세 가지의 조작 방법을 통해 각 도구의 효과를 실험적으로 검증하였다.

결과적으로, Vive 트래커를 사용한 조작 도구는 사용자에게 직접적인 경험을 제공함으로써 도구에 대한 더 깊은 이해와 실재감을 체험하였다. 단순히 기존의 VR 컨트롤러만을 사용하는 것을 넘어서, 다양한 물체를 추적 장치로 변환함으로써 사용자에게 다양한 상호작용 경험을 제공할 수 있게 된다. 이는 VR의 사용자 인터페이스의 확장을 가능하게 한다. 또한, 3D 프린팅과 VR을 결합하여 개발 및 검증 과정에서 비용과 시간을 크게 절약하였다.

이러한 결과를 바탕으로, 유니티 기반의 VR 교육 시스템은 산업현장에서의 교육, 그리고 다양한 분야에서의 교육에 활용될 큰 잠재력을 가지고 있음을 확인하였다. 다만, 본 연구에서 진행한 ANOVA 설문조사의 응답자가 60명으로 실험 결과의 양적 부분에서 한계가 나타났다. 추후 연구에서는 다양한 시나리오와 교육 방법을 통합하여 시스템의 범용성과 효과를 더욱 향상시킬 계획이다. 또한, 모수 대비 적절 샘플링 비율 및 설문 참여자의 다양성을 확보하여 반영할 계획이다.

Acknowledgments

본 과제(결과물)는 2023년도 교육부의 재원으로 한국연구재단의 지원을 받아 수행된 지자체-대학 협력기반 지역혁신 사업의 결과입니다(2021RIS-003)

References

-

H. Park and C. Koo, "Effect of virtual reality-based construction safety education on the learning performance of construction workers - Using CAMIL theory -", Korean journal of construction engineering and management, Vol. 23, No. 3, pp. 104-115, May 2022.

[https://doi.org/10.6106/KJCEM.2022.23.3.104]

-

R. H. Lee and K. T. Gae, "Study on Building a VR-based Rotorcraft Pre-flight Inspection and Start/Stop Procedure Training System", Journal of KIIT, Vol. 21, No. 11, pp. 193-201, Nov. 2023.

[https://doi.org/10.14801/jkiit.2023.21.11.193]

-

S. W. Shin, H. M. Lee, H. S. Moon,and S. T. Chung, "Multi-player Contents for Upper Limb Rehabilitation based on VR", The Journal of The Institute of Internet, Broadcasting and Communication, Vol. 19, No. 3, pp. 115-120, Jun. 2019.

[https://doi.org/10.7236/JIIBC.2019.19.3.115]

-

J. H. Lee and S. H. Chang, "Emergency situation safety education training VR content model design", Journal of Digital Contents Society, Vol. 22, No. 1, pp. 41-49, Jan. 2021.

[https://doi.org/10.9728/dcs.2021.22.1.41]

-

J. Chae, "Study on firefighting education and training applying virtual reality", Fire Science and Engineering, Vol. 32, No. 1, pp. 108-115, Feb. 2018.

[https://doi.org/10.7731/KIFSE.2018.32.1.108]

-

S.-H. Kim, J.-H. Park, J.-Y. Park, and S.-G. Kim, "Fabrication of custom assistive devices for VR controllers using FDM 3D printing", Vol. 28, No. 2, pp, 107-114, Jun. 2023.

[https://doi.org/10.29279/jitr.2023.28.2.107]

-

Y. H. Heo and S. H. Kim, "Design Process Suggestion of Vibrotactile Interface applying Haptic Perception Factor Analysis", The Journal of The Institute of Internet, Broadcasting and Communication, Vol. 21, No. 5, pp. 79-87, Oct. 2021.

[https://doi.org/10.7236/JIIBC.2021.21.5.79]

-

G. N. Go, S. M. Ryu, W. S. Kyoo, and S. H. Nam, "A haptic controller exterior design for VR prototyping system", Journal of Next-generation Convergence Information Services Technology, Vol. 7, No. 2, pp. 237-246, Dec. 2018.

[https://doi.org/10.29056/jncist.2018.12.10]

-

Y.-W. Lee, "The current situation and prospect of safety education contents based on VR", Journal of the Korea Institute of Information and Communication Engineering, Vol. 24 No. 10, pp. 1294-1299, Oct. 2020.

[https://doi.org/10.6109/jkiice.2020.24.10.1294]

- S. G. Jeon, S. W. Paik, U. Y. Yang, and K. S. Han, "Investigating human factors in VR control modality in a firefighting training context", The Journal of Korean Institute of Next Generation Computing, Vol. 16, No. 5, pp. 91-105, 2020.

-

D. R. Kim, D. Y. Lee, and J. J. Na, "Development of VR content based on a touchless interface using hand tracking - game of curing a human body <Robot Doctor VR>", Journal of Korean Society of Media and Arts, Vol. 20, No. 1, pp. 29-44, Feb. 2022.

[https://doi.org/10.14728/KCP.2022.20.01.029]

- Vive, https://www.vive.com/kr/support/wireless-tracker/category_howto/tracker.html, [accessed: Dec. 13, 2023]

- Unity, https://docs.unity3d.com/Packages/com.unity.xr.interaction.toolkit@1.0/manual/index.html, [accessed: Dec. 13, 2023]

-

C.-J. Chae, J.-W. Lee, J.-K. Jung, and Y.-J. Ahn, "Effect of virtual reality training for the enclosed space entry", Journal of the Korean Society of Marine Environment & Safety, Vol. 24, No. 2, pp. 232-237, Apr. 2018.

[https://doi.org/10.7837/kosomes.2018.24.2.232]

-

D. H. Chung, "Effects of visual and tactile elements on game users' experiences in virtual reality games", Korea Institute of Design Research Society, Vol. 8, No. 2, Jun. 2023.

[https://doi.org/10.46248/kidrs.2023.2.44]

-

B. G. Witmer and M. J. Singer, "Measuring presence in virtual environments: A presence questionnaire. Presence", Presence: Teleoperators and Virtual Environments, Vol. 7, No. 3, pp. 225-240, Jun. 1998.

[https://doi.org/10.1162/105474698565686]

-

B. G. Witmer and M. J. Singer, "The factor structure of the presence questionnaire", Presence: Teleoperators & Virtual Environments, Vol. 14, No. 3, pp. 298-312, Jun. 2005.

[https://doi.org/10.1162/105474605323384654]

2016년 2월 : 경상대학교 미술교육학과(학사)

2022년 2월 : 창원대학교 문화융합기술협동과정(공학석사)

2022년 3월 ~ 현재 : 창원대학교 문화융합기술협동과정 박사과정

관심분야 : 컴퓨터비전, 증강/가상현실, 실감콘텐츠

2006년 2월 : 연세대학교 컴퓨터공학과(공학석사)

2011년 2월 : 연세대학교 컴퓨터공학과(공학박사)

2016년 3월 ~ 현재 : 강남대학교 소프트웨어응용학부 교수

관심분야 : 가상현실, 증강현실, 모바일컴퓨팅, 기계학습, HCI

2003년 8월 : 고려대학교 전자정보공학(공학사)

2006년 2월 : 연세대학교 생체인식공학(공학석사)

2011년 2월 : 연세대학교 전기전자공학(공학박사)

2011년 ~ 2012년 : LG전자기술원 미래IT융합연구소 선임연구원

2012년 ~ 2013년 : 연세대학교 전기전자공학과 연구교수

2013년 ~ 2016년 : 제주한라대학교 방송영상학과 조교수

2016년 ~ 2019년 : 동명대학교 디지털미디어공학부 부교수

2019년 9월 ~ 현재 : 창원대학교 문화테크노학과 부교수

관심분야 : 컴퓨터비전, 증강/가상현실, HCI