OLED 패널 결함 검출을 위한 데이터 생성 시스템과 RCNN 기반의 결함 검출 적용 연구

초록

최근 딥러닝을 이용한 객체 검출 알고리즘이 다양한 분야에 적용되고 있다. 이로 인해 각 분야에서는 비전 기술을 이용한 시스템을 연구하기 시작했다. 새로운 연구들은 성능 개선과 성과가 나타나고 있다. 네트워크 분야의 활발한 연구에도 불구하고, 새로운 분야에 딥러닝을 적용하기 위해서는 문제 해결을 위한 데이터를 정의하고 생성하는 연구와 작업이 필요하다. 본 연구는 OLED 패널 결함에 대해 정의하고 학습하기 위한 가상의 데이터 획득 시스템을 구현했다. 구현된 시스템으로부터 생성된 각 패널 이미지 데이터는 전처리 후에 결함을 유형별로 라벨링하여 검출 모델 학습에 적합한 데이터 세트를 생성한다. 이후 RCNN 기반의 객체 검출 알고리즘에 적용하여 결함 검출 모델을 학습하여 98.4%의 검출율을 확인하였다.

Abstract

Recently, object detection algorithms using deep learning have been applied in various fields. So, there are many improvements and achievements through research of vision system in each field. In order to apply deep learning to the relevant field, it is necessary to define problem and generate proper dataset. In particular, it is difficult to obtain sufficient data of OLED panel defects due to the high cost of OLED panels. This study is to define OLED panel defects, and build virtual data acquisition system for learning. In each generated image data for defect detection, defects were classified and labeled by defect types. After that, the data were applied to the RCNN-based object detection algorithm to learn the defect detection model of the OLED panel and evaluate its performance.

Keywords:

deep learning, data building, object detection, defect detectionⅠ. 서 론

많은 산업 분야와 생활환경 속에서 사용자들은 디스플레이 디바이스를 사용한다. 작게는 모바일과 같은 소형 디바이스에서부터 각종 모니터와 대형 스크린 디바이스까지 디스플레이의 수요는 계속해서 커지고 있다. 이런 디스플레이의 핵심 모듈인 패널 분야는 폴더블, 롤러블과 같은 차세대 형태를 비롯해 다양한 방향으로 개발되고 있는 성장성이 높은 분야이다.

유기발광 다이오드(OLED,Organic Light Emitting Diode)는 LCD에 비해 경량화가 용이하고, 명암비가 뛰어나기 때문에 디스플레이 디바이스에서 점차 주류가 되었다. 또, 디스플레이 디바이스가 지속적으로 연구 개발 되고 사용처가 늘어나면서 중요 모듈인 OLED 패널의 결함 검사에 대한 수요도 증가할 것으로 예상된다. 기존에 비전 시스템을 통한 결함 검사는 해당 패널을 특정 위치에 정확히 위치하여 위치기반의 결함 검출이 많이 사용되었다. 하지만 검사 장비가 높은 정밀도를 요구하며 오차 발생 시 많은 비용이 발생한다[1].

한편, 딥러닝으로 인한 이미지 내의 객체 검출 기술이 비약적인 발전을 하면서 다양한 분야에 적용되고 있다. 하지만 새롭게 적용되는 분야에서는 해결하기 위한 문제에 대한 명확한 정의와 모델 학습에 필요한 충분한 데이터 세트가 필요하다.

본 연구에서 수행한 OLED 패널에 대한 결함 검사는 패널 내의 결함 화소를 검출한다. 결함 검출을 위해서 패널의 여러 유형에 대한 결함을 정의하고 그에 맞는 결함이 있는 패널로 데이터 세트를 생성하여야 한다. 하지만 필요한 여러 유형의 결함을 가진 패널을 획득하기 어려울 뿐 아니라 OLED 패널의 높은 비용으로 인해 모델 학습을 위한 실물의 패널 데이터세트를 획득하기 어렵다. 그래서 본 연구에서는 이미지 획득 센서와 전처리를 이용한 데이터 생성 시스템을 구현하고 객체 검출 알고리즘을 이용한 객체 검출 모델 적용을 제안한다.

2장은 결함 검출을 위해 적용되는 모델의 기반인 RCNN 기반의 객체 검출 알고리즘에 대해 살펴본다[2]. 3장은 결함 검출을 위한 데이터 생성 시스템 및 학습을 위한 데이터 세트를 구현한다. 이어서 4장에서는 3장에서 제안한 데이터세트를 RCNN 기반의 결함 검출 모델에 적용하고 성능을 평가한다. 5장은 본 연구에 대한 결론과 향후 연구 방향을 제시한다.

Ⅱ. 객체 검출 알고리즘

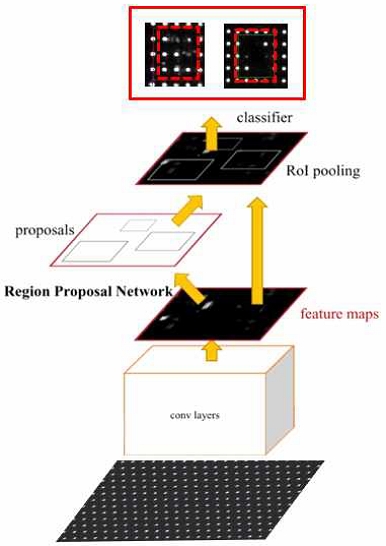

객체 검출 알고리즘은 이미지 정보에서 특정 객체에 대한 정보를 검출하는 기술로 해당 객체의 위치정보와 분류 정보를 획득하는 기술이다. 객체 검출 알고리즘은 정보 획득 방법에 따라 크게 두 가지로 분류된다. 첫 번째로 박스(Bounding box)기반으로 객체를 검출하여 정보를 획득하는 방식이고, 두 번째는 영역 분할을 이용한 객체 검출 방식이다. 최근에 연구되는 박스 기반의 객체 검출 알고리즘은 주로 RCNN과 YOLO에서 시작되어 개발되었다[2][3]. RCNN은 입력 이미지의 특정 픽셀들에서 여러 크기와 모양의 박스를 추출하여 해당 영역을 객체로 제안한다. 제안된 영역들은 RPN(Region Proposal Network)를 통해 학습되고 객체의 위치 정보와 분류정보를 획득한다[4].

앞서 기술한 두 번째 객체검출 방식인 영역기반 객체 검출(Semantic segmentation)은 이미지 내의 픽셀들의 분류 값 정보를 획득한다.

대표적으로 FCN과 DeepLab을 기반한 모델을 기반으로 연구되고 있다[5][6]. 본 연구에서는 RCNN 기반의 영역 검출 알고리즘을 사용하여 OLED 결함 검출 모델에 적용한다.

Ⅲ. 데이터 생성 시스템

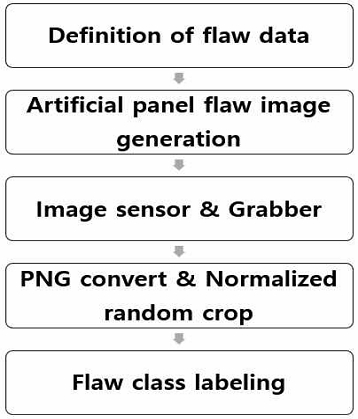

3.1 OLED 패널 결함 분류

데이터를 생성하기 이전에 OLED 패널에서 검출해야할 결함에 대한 정의와 분류가 필요하다. 검출 결함은 화소 누락(Open 결함), 화소 연결(Short 결함), 줄 빠짐(Line out 결함), 이물 결함(Foreign body) 4가지 유형으로 분류하였다.

화소 누락은 패널의 화소가 누락된 영역으로 패널의 특정 화소가 개방된 상태의 결함이다. 패널 내에 인접한 3화소 이상이 누락되었을 때 화소 누락 결함으로 검출한다. 화소 연결은 패널의 화소가 서로 연결된 상태로 패널 화소 간 단락, 혹은 패널의 빛번짐으로 인한 결함이다. 줄 빠짐은 OLED 패널 증착 시 증착 마스크 불량으로 인한 줄 빠짐 현상이다. 마지막으로 이물 결함은 4-5 화소 이상의 폭으로 서형을 띄거나 불규칙한 패턴을 가진 결함으로 검사 시 패널 위에 있는 이물을 가정한다.

3.2 데이터 획득 장비 및 부품

학습을 위한 데이터를 생성하기 위해서는 OLED 패널의 결함 데이터가 필요하다. 하지만 OLED 패널의 비용이 높을 뿐 아니라, 다양한 결함을 지닌 패널을 확보하기도 어렵다. 이런 데이터 획득의 어려움을 극복하기 위해 패널에 가상의 결함 이미지를 출력하여 결함 데이터를 생성한다. 결함 이미지는 화소 누락, 줄 빠짐, 이물 결함 3가지 유형의 결함이 포함되어 OLED 패널에 출력된다.

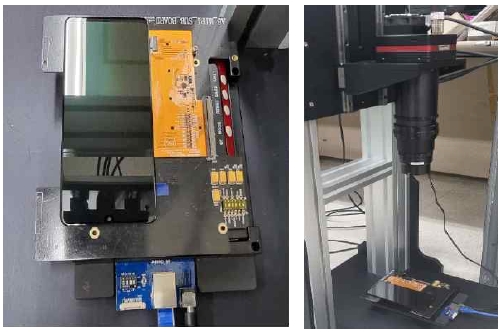

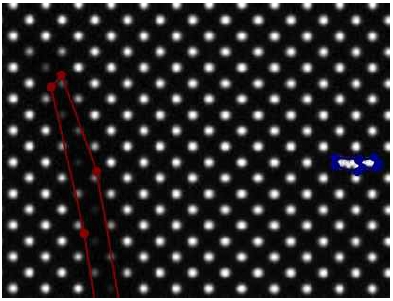

가상의 결함이 출력되는 OLED 패널에서 화소의 결함 정보를 손실 없이 획득하기 위해서 고해상도 카메라와 프레임 그래버가 사용된다. 카메라 센서 모델은 IMX411-VC-151MX 모델이며 14192× 10640 해상도와 모노타입으로 이미지를 획득할 수 있다[8]. 디바이스들을 이용하여 패널(1080× 2400)을 약 50배율 이상의 이미지(그림 4)로 획득한다.

3.3 가상 결함 패널 이미지 생성 및 획득

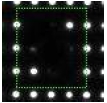

OLED 패널과 동일한 화소의 이미지를 생성하여 가공의 결함을 부여한다. 위에서 기술한 4가지 결함 유형에 대해 다양하게 변화를 주어 충분한 결함 데이터를 획득해야 한다. 다양한 결함데이터를 위해 패널 해상도와 동일한 임의의 결함 이미지들을 생성한다. 화소누락 결함은 해당 영역 광도를 0으로 설정하고 동일하게 줄 빠짐 결함은 해당 라인의 광도를 0으로 생성한다. 생성된 가상 결함 이미지는 그림 2의 패널 출력 디바이스로 그림 3의 결함 이미지를 출력한다. 출력된 이미지는 2절에서 기술한 디바이스를 통해 50배율 이상의 이미지로 획득하여 데이터로 사용된다.

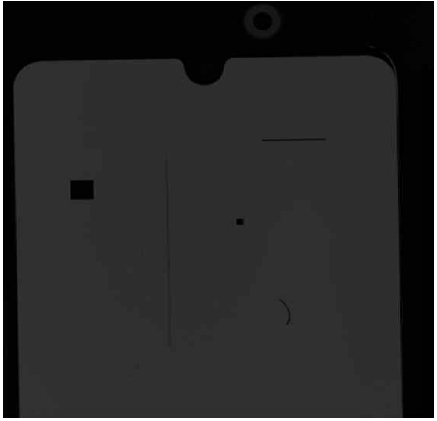

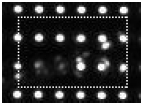

그림 3의 생성된 예시 이미지에서는 화소 누락(Open 결함)과 줄 빠짐 2가지 유형의 결함이 생성되었고 출력 OLED 패널에 출력되는 것을 볼 수 있다. 결함 이미지가 출력되는 패널을 2절에서 기술한 디바이스로 획득하면 14192×10640 해상도의 이미지(그림 4)를 획득한다.

3.4 패널 이미지 변환 및 전처리

획득한 이미지는 1억 5천만 화소 이상으로 각 화소의 특징 정보를 손실 없이 보유한다. 하지만 고화질로 획득한 로우 이미지는 RCNN 기반 객체 검출 모델의 입력에 적합하지 않다.

그림 4는 초고해상도인 원본 이미지를 축소하여 출력한 이미지로 OLED 패널의 상단부가 촬영되었다.

객체 검출 알고리즘을 적용하여 결함 검출 모델을 학습하기 위해 결함 이미지에 대한 특징 정보가 손실되지 않을 정도의 고배율 이미지가 필요하다. 또한 RCNN 기반의 결함 검출 모델 학습을 위한 이미지는 네트워크에 적합한 해상도여야 한다. 두 가지 조건을 충족하기 위해 우선 3절의 시스템을 이용하여 획득한 원본 이미지를 png 파일로 변환한 후에 정규화를 수행한다.

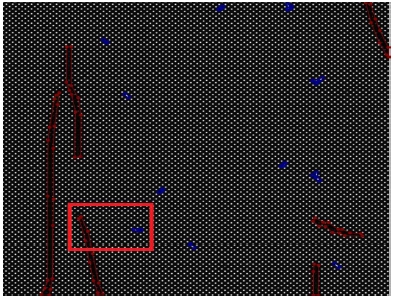

전처리된 패널 이미지는 원본 이미지의 패널 코너 내부의 무작위 픽셀을 중심으로 무작위 1024 × 1024의 크기로 크롭하여 정보 손실이 없는 원본 이미지의 일부를 학습 모델에 적용한다.

3.5 생성 데이터 세트

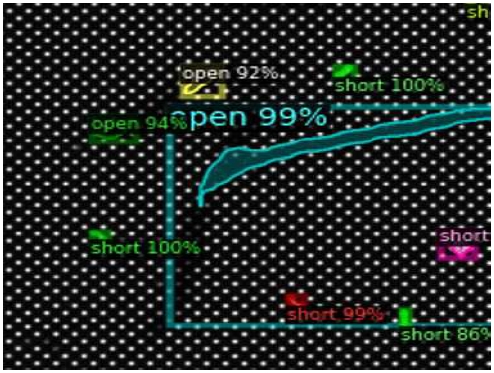

학습을 위한 데이터세트는 4가지 유형의 결함이 라벨링된 데이터로 단일 이미지 내에 임의의 유형의 결함들이 포함된다. 결함 유형 중에 화소 누락, 줄 빠짐, 이물 결함 3가지 유형은 획득한 이미지에서 라벨링한다. 하지만 화소연결(Short) 결함은 인접한 화소 간 라인의 쇼트로 인해 해당 화소들의 신호 중첩으로 발생하는 빛 번짐이기 때문에 다른 3가지 유형의 결함과 같은 방법으로 획득할 수 없다. 따라서 크롭된 이미지에서 인접 화소간의 신호 중첩을 직접 구현한다. 그 이후 그림 6, 그림 7은 결함이 라벨링 되어 학습 데이터에 사용될 이미지 예시이다.

Ⅳ. 결함 검출 실험 및 결과

데이터 세트는 240개의 1024×1024 이미지로 구성되고 학습 데이터 세트로 204개의 이미지, 테스트 데이터 세트로 36개의 이미지를 사용한다.

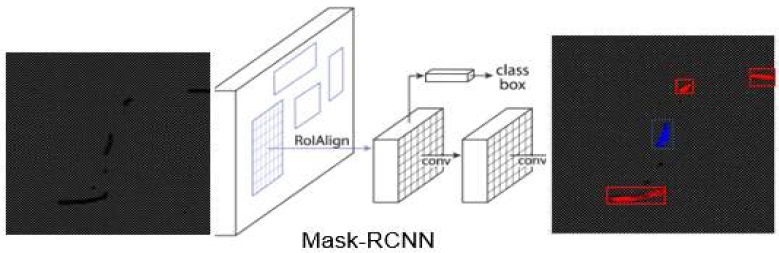

박스 기반의 Faster-RCNN을 기반으로 한 모델에서 RPN(Region Proposal Network)이 추천하는 RoI에 분할 마스크를 예측하는 mask-branch를 추가하여 그림 8과 같이 영역기반으로 화소 단위 객체 정보를 추정한다.

네트워크 학습은 mask threshold를 기본 0.7에서 0.5로 검출 빈도를 올렸다. 학습율은 0.00025에서 점차적으로 0.0001로 변동하였다. 일반적인 검출 모델은 ResNet-101이 기반 네트워크로 적용된다. 하지만 ResNet-101은 layer가 깊어질 때 성능이 떨어지며 표 2와 같이 연산 속도도 느려진다[7]-[9].

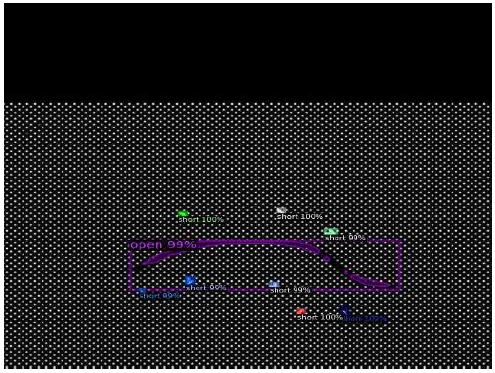

테스트 데이터는 생성된 데이터 세트에서 무작위의 36개의 이미지를 선택했다. 해당 네트워크로 검출한 결함은 그림 9와 출력된다. 그림 10에서 각 결함의 클래스가 구별되는 것을 확인 할 수 있다. 테스트 결과의 결함 유형 별로 결함 객체의 수와 객체 검출 성능은 표 3과 같다. 검출율은 실제 이미지 내의 결함 객체의 수 대비 결함 검출 모델이 검출한 검출 수로 평가하였다. 화소 누락 결함 유형에서 1건의 오탐(False positive)이 발생했고, 나머지 오류는 미탐(False negative)이었다. 전체 검출율은 총 결함 객체 375개 기준 98.4%이다.

Ⅴ. 결 론

OLED 디스플레이는 지속적으로 발전하고 수요가 증가하고 있다. 본 논문에서는 OLED 패널 결함학습을 위한 높은 비용 문제를 해결하고자 가상 결함 이미지를 생성하여 적합한 센서와 디바이스를 이용한 시스템으로 대체하였다. 그리고 객체 검출 네트워크를 학습시키기 위해 패널 결함에 대해 정의하고 결함유형을 분류하여 데이터 세트를 생성하였다. 생성된 결함 데이터 세트는 4가지 유형의 결함 객체를 포함한 이미지로 구성된다. 정의된 결함을 검출하기 위해 생성된 데이터를 RCNN 기반의 객체 검출 알고리즘을 적용하였다. 생성된 데이터로 학습한 OLED 패널 결함 검출 모델은 98.4%의 검출율을 얻었다. 그러나 데이터 세트에서 볼 수 없는 기타 결함과 화소 증착으로 인한 암점에 대한 충분한 테스트 데이터가 필요하다고 판단된다. 향후, 해당 데이터를 재정의 하여 보완하고 결함 유형을 더 세분화하여 OLED 패널의 결함 검출 모델을 개선을 기대한다.

Acknowledgments

이 논문은 중소기업벤처부의 재원으로 중소기업기술정보진흥원의 지원을 받아 수행함(S3141550)

References

- withsystem, OLED Panel Pattern inspection, http://www.withsystem.co.kr/sub/product03.html, [accessed: Sep. 26, 2022] http://www.visionsystech.com, [acessed: Oct. 06, 2022]

-

R. Girshich, J Donahue, T. Darrell, and J. Malik, "Rich feature hierarchies for accurate object detection and semantic segmentation", 2014 CVPR, Oct. 2014.

[https://doi.org/10.1109/CVPR.2014.81]

-

J. Redmon, S. Divvala, R. Girshick, and A. Farhadi, "You Only Look Once: Unified, RealTime Object Detection", 2016 CVPR, May 2016.

[https://doi.org/10.1109/CVPR.2016.91]

-

R. Girshick, "Fast R-CNN," 2015 IEEE (ICCV), pp. 1440-1448, 2015.

[https://doi.org/10.1109/ICCV.2015.169]

-

J. Long, E. Shelhamer, and T. Darrell, "Fully Convolutional Networks for Semantic Segmentation", 2015 CVPR, Mar. 2015.

[https://doi.org/10.48550/arXiv.1411.4038]

-

L. Chen, G. Papandreou, F. Schroff, and H. Adam, "Rethinking Atrous Convolution for Semantic Image Segmentation", 2017 CVPR, Dec. 2017.

[https://doi.org/10.48550/arXiv.1706.05587]

- Viosion System Technology, LLC. Products, http://www.visionsystech.com, [acessed: Oct. 06, 2022]

-

K. Simonyan and A. Zisserman, "Very Deep Convolutional Networks for Large-Scale Image Recognition", 2015 CVPR, Apr. 2015.

[https://doi.org/10.48550/arXiv.1409.1556]

-

K. He, X. Zhang, S. Ren, and J. Sun, "Deep Residual Learning for Image Recognition", CVPR, Dec. 2015.

[https://doi.org/10.48550/arXiv.1512.03385]

2015년 2월 : 서강대학교 전자공학과(공학사)

2019년 2월 : 서강대학교 영상대학원 영상공학과(공학석사)

2019년 3월 ~ 현재 : 서강대학교 아트엔테크놀로지학과 미디어공학 박사과정

관심분야 : 컴퓨터 비전, 딥러닝, 데이터설계

1992년 2월 : 경북대학교 전자공학과(공학사)

1994년 2월 : 포항공과대학교 전자공학과(공학석사)

2000년 2월 : 포항공과대학교 전자공학과(공학박사)

2003년 3월 ~ 현재 : 서강대학교 교수

관심분야 : 컴퓨터 비전, AR, 딥러닝