해충 분류를 위한 양방향 멀티스케일 특징 퓨전 기반의 피라미드 비전 변환기

초록

해충은 작물을 가해하여 생산량 감소와 품질 저하를 수반한다. 따라서 해충 피해를 최소화하기 위해서는 해충 종류에 따른 방제 작업을 적기에 실행하는 것이 중요하다. 기존의 해충 분류는 경험이 풍부한 농부나 전문가의 육안에 의해 감별되었다. 이는 많은 시간과 비용을 요구하므로 무인 기반의 해충 분류 기술이 필요하다. 따라서 이 논문에서는 해충 영상 분류를 위한, 양방향 멀티스케일 특징 퓨전 방식을 새롭게 제안하고자 한다. 특히, 기존의 PVT 모델의 스케일 취약성 문제를 보완하고자, PVT 백본에서 추출된 멀티스케일 특징을 양방향으로 4가지의 퓨전 방식을 적용하고자 한다. 실험 결과를 통해, 가장 성능이 높은 퓨전 방식을 도출하고 제안한 양방향 멀티스케일 특징 퓨전 방식이 해충 영상 분류 성능을 개선할 수 있음을 선보이고자 한다.

Abstract

Pests damage crops, thereby resulting in reduced production and quality. In order to reduce the damage of pests, it is important to timely implement pest control according to various types of pests. Existing pest classification is identified by the naked eye of an experienced farmer or expert. This requires considerable time and cost, so an unmanned pest classification technology is needed. In this paper, a new bidirectional multiscale feature fusion method for pest image classification is proposed. In particular, in order to supplement the scale vulnerability of the existing PVT model, the multi-scale features extracted from the PVT backbone are applied bidirectionally by four fusion methods. Through the experimental results, the fusion method with the highest performance is derived and it is shown that the proposed bidirectional multiscale feature fusion method can improve the pest image classification performance.

Keywords:

pest classification, bidirectional fusion, multiscale features, attention model, vision transformerⅠ. 서 론

해충은 과수나 작물을 가해하여 생산성 감소와 품질 저하를 수반한다. 따라서 해충을 조기에 발견하고 해충 종류와 개체수에 따른 살포 작업을 통해 작물 피해를 최소화할 필요가 있다. 이런 방제 시스템을 운용하기 위해서는 해충 종류를 신속·정확하게 감별할 수 있는 기술적인 요구사항을 해결해야 한다. 종전의 해충 감별 방식은 경험이 풍부한 농부나 전문가의 시각적 판단에 의존했다. 그러나, 농가의 고령화로 이런 전문 예찰 인력이 부족한 실정이다. 또한 기후 변화와 외래해충의 유입으로 해충의 종류가 다양화되고 있다. 이런 방제 시스템의 현안을 해결하기 위해서는 무인으로 해충의 종류를 감별할 수 있는 해충 인식 기술 개발이 필요하다.

해충 인식 기술은 카메라로 촬영된 영상정보에서 해충의 종류를 예측하는 영상 인식 기술이 대세를 이루고 있다. 특히 딥러닝의 출현 이후, 영상 인식 기술이 상당한 진보를 거듭하고 있다. 최근 영상 인식 분야에서 딥러닝 모델은 어텐션 기능 개발에 주력하고 있다. 대표적인 모델로는 SqueezeNet[1], VT(Vision Transformer)[2], PVT(Pyramid VT)[3] 등이 있다. 특히, PVT는 패치 임베딩(Patch embedding)과 위치 임베딩(Position embedding)을 적용해서 추출된 특징맵에 어텐션 기능을 적용함으로써, 기존의 VGG[4]이나 ResNet[5]보 다 영상 인식률 측면에서 상당한 개선을 이루었다. 그러나, PVT 모델에서도 여전히 개선할 여지가 있다. 해충 영상의 경우 해충의 크기가 다양하고 촬영거리에 따라 해충 스케일이 가변된다. 이런 문제를 해결하기 위해서는 멀티스케일 특징 추출 및 퓨전 방식이 필요하다. 이 논문에서는 PVT의 각 단계에서 출력된 멀티스케일 특징맵을 추출하고 퓨전하는 양방향 멀티스케일 특징 퓨전 기반의 PVT 모델을 개발하고자 한다.

제안한 BMFF-PVT(Bidirectional Multiscale Feature Fusion PVT)는 기존의 PVT와는 다음과 같은 차이점을 가진다. 첫째, 기존의 PVT는 패치 임베딩, 위치 임베딩 그리고 어텐션으로 구성된 각 블록에서 생성된 특징맵을 다음 단계의 입력으로만 활용한다. 반면 제안한 BMFF-PVT는 각 단계에서 생성된 멀티스케일 특징맵을 분류의 정확도를 높이고자 퓨전하는데 활용한다. 둘째, 제안한 BMFF-PVT에서는 멀티스케일 특징맵을 퓨전할 때, 하향식(Top down)과 상향식(Bottom up) 방향으로, 즉 양방향으로 특징 정보를 전달한다. 그리고 원소별 합(Elementwise sum), 연결(Concatenation), 파이어(Fire) 블록, 공간 축소 어텐션(SRA, Spatial-Reduction Attention), 총 4가지 퓨전 방식을 적용하여 구별력이 높은 특징으로 변환한다. 따라서 이 논문의 실험 결과를 통해 제안한 BMFF-PVT가 기존의 PVT보다 해충 분류의 인식률을 제고하는데 더 효과적임을 확인하고자 한다. 그리고 4가지의 멀티스케일 퓨전 방식에서 가장 우수한 성능을 갖춘 양방향 멀티스케일 퓨전 방식을 도출하고자 한다.

본 논문은 기존 PVT의 스케일 취약성의 문제점을 보완하기 위해서 PVT 백본에서 출력된 멀티스케일 특징맵을 양방향으로 결합하는 4가지 퓨전 방식과 아키텍처를 추가하였고, 가장 성능이 우수한 BMFF-PVT 기법을 도출하였다. 또한 제안한 모델의 우수성을 검증하기 위하여 공개 해충 데이터 셋인 IP102[6]를 사용하여 성능을 평가하였다.

Ⅱ. 해충 분류를 위한 딥러닝 모델

해충 분류를 위해 가장 접근하기 쉬운 방식은 기존의 이미지넷에 학습된 딥러닝 모델에 전이학습(Transfer learning)을 적용하는 것이다. 전이학습이란 해충 데이터 셋을 사용해서 사전 학습된 모델을 재학습하는 과정을 말한다. 대표적인 영상 분류 모델로는 VGG16[4], ResNet50[5], SqueezeNet[1], PVT[3] 등이 있다.

2.1 VGG16 모델

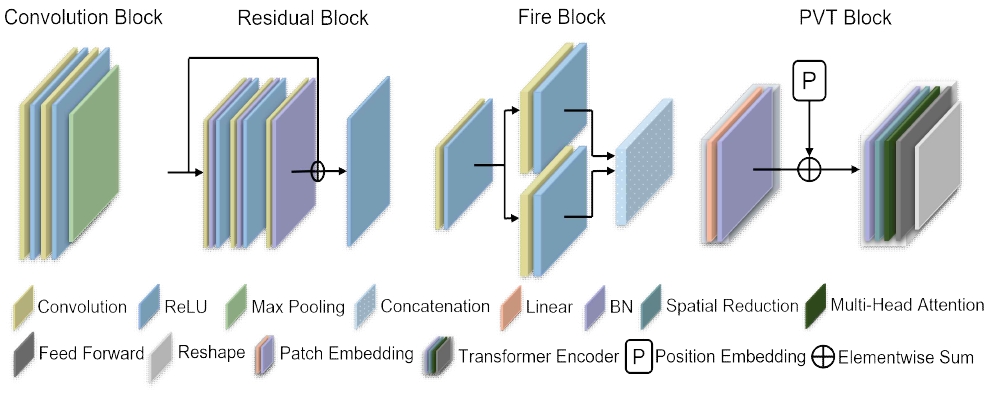

VGG16[4]은 13개의 합성곱 블록(Convolution block)과 3개의 완전 연결 레이어(Fully connected layer)로 구성된 신경망이다. 딥러닝의 초기 모델로서, 합성곱, 최대 풀링(Max pooling), 활성화(Activation) 레이어를 연속적으로 깊이 쌓기만 해도 우수한 결과를 얻을 수 있었다. 그림 1의 맨 좌측은 합성곱 블록의 구조를 보여주고 있다. 모든 합성곱 레이어에서 필터의 크기가 3x3이며 활성화 함수로는 정류선형 유닛(ReLU, Retified Linear Unit)을 사용하였다. 모델 구조가 간단하지만 우수한 성능을 제공하고 있다. 영상 분류 분야의 성능 평가를 위해 지금까지도 베이스 모델로 비교되고 있다.

2.2 ResNet50 모델

ResNet50[5]은 50개의 계층으로 구성된 합성곱 신경망(CNN, Convolution Neural Network)이다. 그림 1의 두 번째는 ResNet50의 기본 모듈인 잔차 블록(Residual block)에 해당한다. 잔차 블록은 합성곱, 배치 정규화(BN, Batch Normalization), ReLU 레이어로 구성되어 있다. 그리고 역전파(Backpropagation) 과정에서 기울기 소실 문제를 해결하고자, 스킵 연결(Skip connection)을 도입했다. 즉, 그림 2에서 보듯이, 입력 값과 잔차 값을 더하는 방식으로 설계되었다. 스킵 연결은 역전파 동안에 오차를 손실 없이 다음 레이어로 전달해 주는 역할을 한다.

2.3 SqueezeNet 모델

SqueezeNet[1]은 파이어 블록(Fire block)을 사용하여 어텐션 기능을 모델링한 초창기 모델이다. 그림 1에서 보듯이, 파이어 블록은 2개의 합성곱 레이어를 사용한다. 하나는 1×1 필터의 크기를 다른 하나는 3×3 필터의 크기를 사용한다. 1×1 필터의 값은 채널의 중요도에 대한 가중치를 의미하고 3×3 필터의 값은 공간 영역에서의 중요도에 대한 가중치를 반영한다. 파이어 블록은 간단한 구조이지만, 채널과 공간 어텐션 기능을 모델링함으로써 영상 인식률 향상을 유도할 수 있다.

2.4 PVT 모델

PVT[3]는 합성곱 신경망을 사용하지 않고 패치 임베딩, 위치 임베딩 그리고 SRA로 구성된 가장 최근에 소개된 어텐션 모델이다. 그림 1의 맨마지막에 는 PVT 블록이 제공되고 있다. 패치 임베딩은 입력 영상을 패치 단위로 분할하여 특징 공간으로 매핑하는 과정이고 위치 임베딩은 패치의 위치 정보를 삽입하는 과정을 말한다.

그리고 SRA는 특징 벡터 간의 유사도에 따라 가중치를 계산하여 입력 특징 벡터를 갱신하는 과정을 말한다. 즉, SRA 과정을 통해 중요도가 높은 특징 벡터가 학습되고 이를 통해 특징의 구별력이 증가하여 최종 인식률 성능을 개선할 수 있다.

III. 제안한 BMFF-PVT 모델

3.1 제안한 접근 방법

PVT는 각 블록에서 출력된 특징맵을 다음 블록의 입력으로만 사용한다. 이는 기존의 PVT는 멀티스케일 퓨전 방식이 배제되어 있고 객체 스케일 변화에 강인한 특성을 보유하지 못함을 의미한다. 이런 PVT의 단점을 보완하고자, 이 논문에서는 양방향 멀티스케일 특징 퓨전 방식인 BMFF-PVT를 제안하고자 한다.

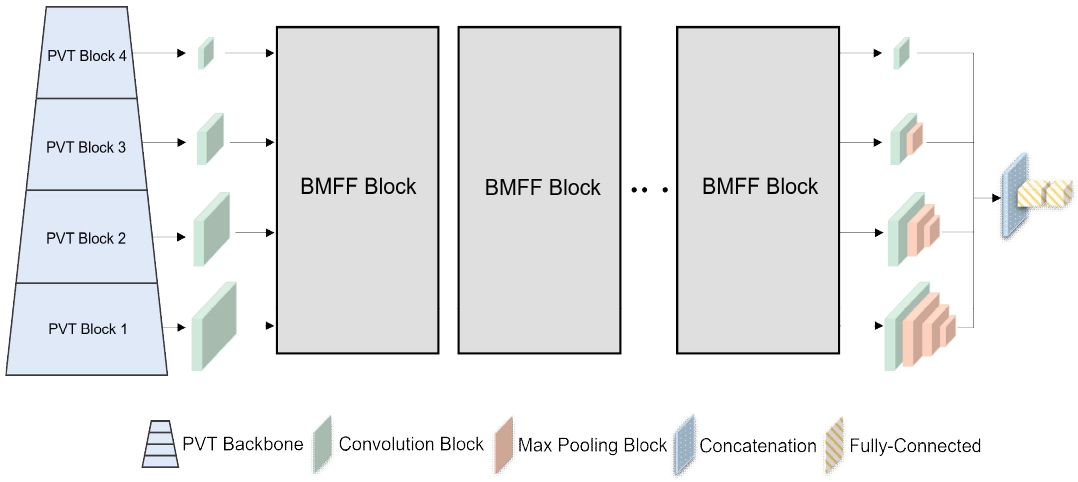

그림 2는 제안한 해충 분류를 위한 BMFF-PVT의 아키텍처를 보여주고 있다. 기존의 PVT와 비교해서, PVT 백본에서 멀티스케일 특징을 추출하고 BMFF 블록을 통해서 양방향으로 멀티스케일 특징을 결합하는 것이 큰 차이점이다. BMFF-PVT 백본에서 출력된 특징맵은 7×7, 14×14, 28×28, 56×56 크기를 갖는다.

그림에서 F4, F3, F2, F1으로 표기되었다. 이 멀티스케일 특징맵은 이후 BMFF 블록을 N번 통과하면서 양방향으로 퓨전된다. 제안한 BMFF-PVT에서는 4종류의 퓨전 방식을 고려하고자 한다. 즉, 원소별 합, 연결, 파이어 블록, SRA, 총 4가지 퓨전 방식을 적용하고자 한다. 이를 통해, BMFF-PVT에서 가장 우수한 양방향 멀티스케일 퓨전 방식을 도출하고자 한다.

3.2 원소별 합 기반 BMFF 블록

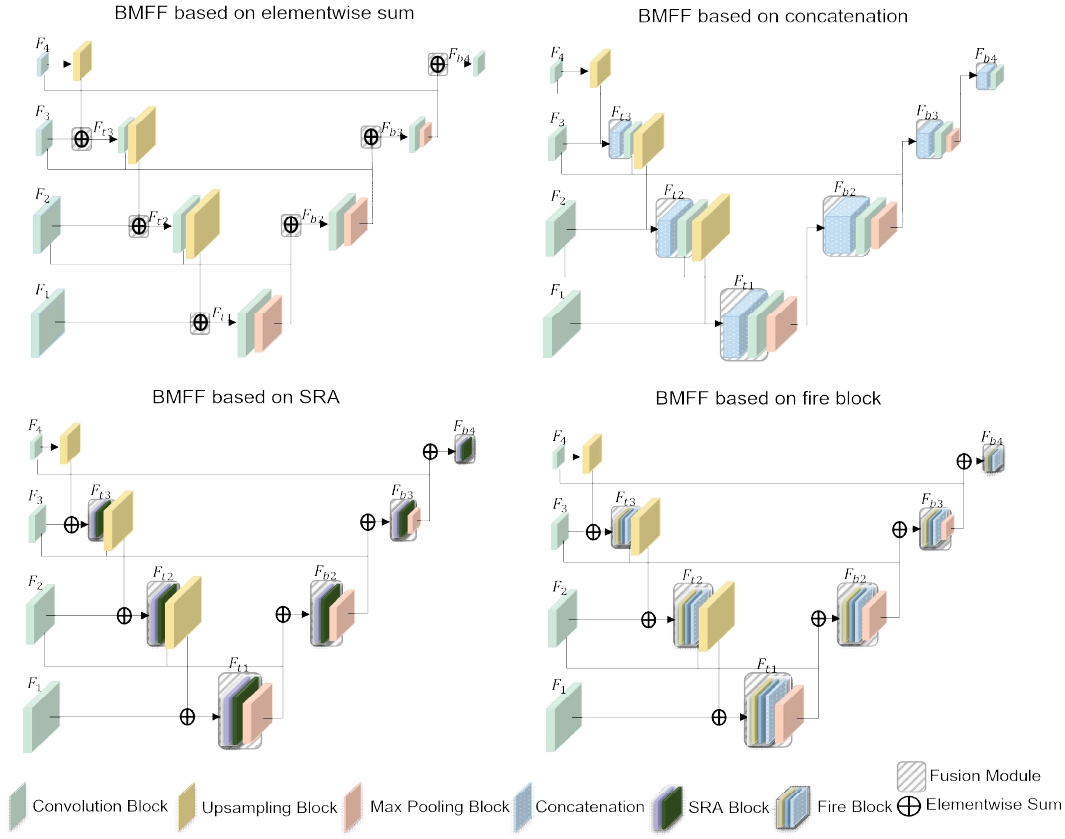

그림 3의 좌측 상단은 원소별 합 기반의 BMFF 블록을 보여준다. 원소별 합 BMFF 블록은 백본에서 출력된 멀티스케일 특징맵인 F4, F3, F2, F1를 입력으로 받아 합성곱 블록을 통해 256개의 채널로 동일하게 변경한 후, 하향식과 상향식 퓨전을 연달아 적용한다. 첫째, 하향식 퓨전에서는 먼저 F4 특징맵을 업샘플링한 후, F3와 원소별 합 연산을 통해 퓨전한다.

Proposed bidirectional multiscale feature fusion blocks; elementwise sum, concatenation, fire, SRA(clockwise)

그리고 퓨전된 Ft,3를 다시 합성곱과 업샘플링 블록을 통과한 후 F2와 퓨전한다. 그리고 퓨전된 Ft,2는 동일한 과정을 거친 후 F4과 퓨전된다. 둘째, 상향식 퓨전에서는 하향식 퓨전의 역과정이 적용된다. 퓨전된 Ft,1은 합성곱 블록을 통과한 후, 최대 풀링 블록을 통해 특징맵의 크기를 F2와 같아지도록 조절한다.

그리고 입력 특징맵인 F2와 원소별 합 연산을 통해 Fb,2를 생성한다. 상향식 퓨전에서는 이 과정을 반복하면서 최종 Fb,3와 Fb,4를 생성한다. 다음 단계의 원소별 BMFF 블록은 이전 단계의 BMFF 블록의 상향식 퓨전에서 생성된 특징맵, 즉 합성곱 블록을 통과한 특징맵을 입력으로 받아서 동일한 과정을 반복한다.

3.3 연결 기반 BMFF 블록

연결 기반 BMFF 블록은 원소별 합 BMFF 블록과 동일한 방식으로 동작한다. 즉, 양방향으로 멀티스케일 특징 퓨전을 진행한다. 다만, 퓨전 모듈(Fusion module)에서 적용되는 퓨전 방식에서 차이가 있다. 그림 3의 우측 상단은 연결 기반 BMFF 블록을 보여주고 있다. 그림에서 보듯이, 연결 기반 BMFF 블록은 퓨전 모듈에서 원소별 합 연산이 아닌 연결 레이어를 통해 특징 퓨전을 수행한다.

3.4 SRA 기반 BMFF 블록

그림 3의 좌측 하단은 SRA 어텐션 기반 BMFF 블록이다. 상단에 위치한 원소별 BMFF 블록과 거의 동일한 것을 볼 수 있다. 다만, 합성곱 블록 대신 SRA가 적용된다는 것이 차이점이다. SRA는 PVT에서 도입한 어텐션 모듈이고 다음과 같이 수식으로 표현된다.

| (1) |

| (2) |

여기서 Q, K, V는 쿼리(Query), 키(Key), 값(Value)을 의미하고 SRA의 입력 특징맵에 해당한다. 그리고 , , , 는 학습될 파라미터인 선형 변환 행렬이다. 식 (1)에서 h는 헤드(Head)의 개수이고 dH는 헤드의 차원이며 C/h로 정의된다. C는 특징맵의 채널 수이고 H와 W는 특징맵의 세로와 가로 길이이다. fc는 채널 축 방향의 연결(Concatenation) 함수이고 fa는 어텐션을 구현하는 함수이다.

| (3) |

| (4) |

fa에서는 쿼리와 키에 선형변환을 적용한 q와 k의 내적 연산을 통해 유사도 행렬을 만든 후, v 값을 조정한다. 유사도 행렬을 [0-1] 범위의 가중치로 만들기 위해 소프트맥스 함수를 적용했다. 그리고 SRA에서는 특징맵의 가로와 세로 길이가 큰 경우에도 유사도 행렬 연산이 가능하도록 재배열 함수를 적용한다.

식 (3)에서 는 입력 특징맵이며 R은 특징맵의 가로 및 세로 길이의 감소 비율을 나타낸다. 즉, Reshape 함수에서는 입력 특징맵의 공간 영역의 크기를 HW/R2로 줄이고 채널은 R2C만큼 늘여준다. 는 학습될 선형 변환 행렬이고 Norm은 레이어 정규화(Layer normalization)를 의미한다. SRA에 대한 더 자세한 사항은 참고문헌[3]에 기술되어 있다.

3.5 파이어 기반 BMFF 블록

그림 3의 우측 하단은 파이어 기반 BMFF 블록이다. 그림에서 보듯이, 퓨전 블록에서 파이어 연산이 적용되는 것을 볼 수 있다. 즉, 원소별 합 BMFF와는 달리, 합성곱 블록 대신 파이어 블록을 적용한다. 2.3절에서 이미 언급했듯이, 파이어 블록은 두 종류의 합성곱 필터를 도입하기 때문에 공간·채널 어텐션을 반영했다고 볼 수 있다. 반면 SRA는 공간 영역에 따른 가중치를 유사도 행렬 기반으로 계산하기 때문에 공간 어텐션으로 해석할 수 있다.

참고로 그림 3에서 합성곱 블록은 그림 1의 합성곱 블록과 동일하며, 최대 풀링 블록은 최대풀링+합성곱+BN+ReLU로 구성되고 업샘플링 블록은 업샘플링+합성곱+BN+ReLU로 구성된다.

IV. 실험 및 결과

4.1 실험 환경

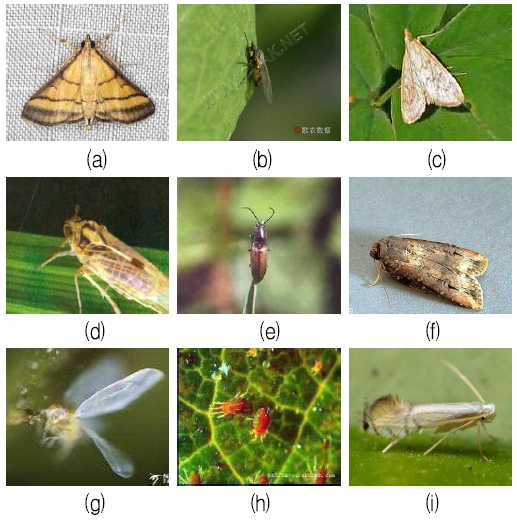

해충 영상 분류 실험을 위해, 공개 해충 데이터셋인 IP102[6]를 사용했다. IP102 데이터셋은 총 102개의 부류로 구성되어 있고 65,534장의 영상을 포함한다. 이 중에서 애벌레와 같이 해충 영상과 관련이 없거나 글자, 자연 배경 사진 등의 부적합한 영상은 제거하였다. 그래서 총 86개의 부류로 구성된 35,379장의 해충 영상을 사용했다. 그림 4는 이 연구에서 사용된 해충 영상의 예시를 보여주고 있다. 해충의 모양이 유사하면서도 다양한 것을 볼 수 있다. 특히 해충의 스케일에 따라 해충 인식이 어려울 수 있음을 확인할 수 있다. 훈련 영상과 테스트 영상의 비율은 7:3이고 학습에 사용된 배치 크기는 10으로 설정했다. 그리고 에폭(Epochs)은 90, 학습률은 0.0001, 최적화 기법은 Adam[7] 옵티마이저를 적용했다. 제안한 BMFF-PVT에서 퓨전 블록의 개수는 3으로 고정했다. 딥러닝 프레임워크는 Pytorch를 사용했고 윈도우 운영체제에서 2080Ti GPU 2개로 구성된 워크스테이션에서 학습과 테스트를 진행했다.

4.2 정량적 평가

평가척도로 영상 분류에서 널리 사용되는 정인식률(CRR, Correct Recognition Rate)을 사용했다[8]. 정인식률은 전체 테스트 영상 개수에서 옳게 분류한 영상 개수의 비율을 말한다. 성능 비교를 위해, VGG16[4], Resnet50[5], SqueezeNet[1], PVT[3]를 채택했다. 표 1은 정량적 평가 결과인 CRR 수치를 보여주고 있다. 표에서 보듯이, 기존 모델 중에서 PVT가 가장 성능이 우수하다. 이는 기존의 ResNet50, VGG16, SqueezeNet 모델에 비해, 어텐션 기능이 한 층 더 강화되어 이러한 성능을 달성한 것으로 분석된다. 그러나, 최첨단 모델인 PVT도 제안한 BMFF-PVT 모델에 비해 성능이 떨어진다.

표에서 보듯이, 제안한 원소별 합 기반 BMFF-PVT는 PVT에 비해 CRR이 약 0.5%가 증가했고, 연결과 파이어 기반 BMFF-PVT는 약 1.4%가 개선된 것을 알 수 있다. 특히 제안한 SRA 기반 BMFF-PVT는 CRR이 약 1.7%나 증가된 것을 볼 수 있다. 이는 SRA의 멀티스케일 퓨전 기법이 원소별 합, 연결, 파이어 기법보다도 더 효과적임을 말해준다. SRA는 학습 과정에서 특징의 중요도를 반영할 수 있기때문에 더 우수한 성능을 유도한 것으로 분석된다. 그러나 제안한 SRA 기반 BMFF-PVT는 양방향 멀티스케일 퓨전 블록을 추가하기 때문에 기존의 PVT보다는 계산속도가 느리다. 제안한 SRA 기반 BMFF-PVT 계산 시간은 4.744(ms)이며 기존 PVT의 계산 시간은 3.123(ms)이다. 그러나 제안한 BMFF-PVT는 기존의 PVT에 비해 정인식률을 더 개선할 수 있는 장점이 있다.

V. 결 론

본 논문은 해충 분류를 위한 양방향 멀티스케일 특징 퓨전 기반의 BMFF-PVT를 새롭게 제안하였다. 특히, 기존 PVT의 스케일 취약성 문제를 보완하고자, PVT 백본에서 출력된 멀티스케일 특징맵을 양방향으로 결합하는 4가지 퓨전 방식과 아키텍처를 제시하였다. 실험 결과를 통해서, SRA 기반의 퓨전 방식이 원소별 합, 연결 및 파이어 퓨전 방식보다 더 우수한 성능을 가짐을 확인하였다.

또한, 제안한 양방향 멀티스케일 퓨전 방식이 기존 PVT의 영상 분류 성능을 개선할 수 있음을 검증하였다. 제안한 양방향 멀티스케일 퓨전 기법은 비단 PVT뿐만 아니라 다양한 영상 분류 백본에도 적용할 수 있을 것으로 기대된다.

Acknowledgments

본 성과물은 농촌진흥청 연구사업(과제번호: PJ01630302)과 한국연구재단 (과제번호: No.2020R1A2C1010405)의 지원에 의해 이루어진 것임

References

-

F. N. Iandola, S. Han, M. W. Moskewcz, K. Ashraf, W. J. Dally, and K. Keutzer, "SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and <0.5MB model size", arXiv: 1602.07360, [cs.CN], Nov. 2016.

[https://doi.org/10.48550/arXiv.1602.07360]

-

A. Dosovitskiy, L. Beyer, A. Kolesnikov, D. Weissenborn, X. Zhai, T. Unterthiner, M. Dehghani, M. Minderer, G. Heigold, S. Gelly, J. Uszkoreit, and N. Houlsby, "An image is worth 16x16 words: Transformers for image recognition at Scale", arXiv:2010.11929, [cs.CV], Oct. 2020.

[https://doi.org/10.48550/arXiv.2010.11929]

-

W. Wang, E. Xie, X. Li, D. P. Fan, K. Song, D. Liand, T. Lu, P. Luo, and L. Shao, "Pyramid vision transformer: A versatile backbone for dense prediction without convolutions", In Proc. IEEE/CVF International Conference on Computer Vision, pp. 548-558, Oct. 2021.

[https://doi.org/10.1109/ICCV48922.2021.00061]

- K. Simonyan and A. Zisserman, "Very deep convolution networks for large-scale image recognition", In Proc. International Conference on Learning Representation, May. 2015.

-

K. He, X. Zhang, S. Ren, and J. Sun, "Deep residual learning for image recognition", In Proc. IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, pp. 770-778, Jun. 2016.

[https://doi.org/10.1109/CVPR.2016.90]

-

X. Wu, C. Zhan, Y. K. Lai, M. M. Cheng, and J. Yang, "IP102: A large-scale benchmark dataset for insect pest recognition", In Proc. IEEE International Conference on Computer Vision and Pattern Recognition, Long Beach, USA, pp. 8787-8796, Jun. 2019.

[https://doi.org/10.1109/CVPR.2019.00899]

- D. P. Kingma and J. Ba, "Adam: A method for stochastic optimzation", In Proc. International Conference on Learning Representation, San Diego, USA, May 2015.

-

H. J. Yu, C. H. Son, and D. H. Lee, "Apple leaf disease identification through region-of- interest-aware deep convolutional neural network", Journal of Imaging Science and Technology, Vol. 64, No. 2, pp. 20507-1-20507-10, Jan. 2020.

[https://doi.org/10.2352/j.imagingsci.technol.2020.64.2.020507]

2019년 3월 ~ 현재 : 군산대학교 소프트웨어학과 학사과정

관심분야 : 컴퓨터 비전, 영상처리, 딥 러닝

2002년 2월 : 경북대학교 전자전기공학부(공학사)

2004년 2월 : 경북대학교 전자공학과(공학석사)

2008년 8월 : 경북대학교 전자공학과(공학박사)

2017년 4월 ~ 현재 : 군산대학교 소프트웨어학과 부교수

관심분야 : 컴퓨터 비전, 영상처리, 기계학습, 딥 러닝