YOLOv5를 활용한 야생동물 탐지 및 분류 모델에 대한 소고

초록

YOLOv5 모델을 이용한 인공지능 분류 모델은 기존의 이미지 분류 모델인 이피션뎃(EfficientDet), 이피션넷(EfficientNet), YOLOv4 등보다 성능이 우수함에도 모델 활용 사례가 부족한 실정이다. 실험실이나 연출된 상황에서 야생동물을 촬영한 이미지를 분류하는 모델은 해상도, 각도, 조도, 기상상황이 천차만별인 실제 상황과 달라 기존에 제안된 연구가 갖는 한계도 존재한다. 본 연구는 최근 차량이 운행하는 길에 야생동물이 출몰하여 로드킬을 발생시키는 사고를 줄이는데 기여할 수 있다. 해당 사고는 야생동물이 다치거나 죽는 일 외에도 차량 파손 및 인명 피해를 일으킨다. 이 글은 야생동물을 육안 대비 우수한 수준으로 탐지하여, 사고를 예방하는 서비스 개발에 핵심 역할을 하는 욜로 5 모델링 기법을 적용하여 우수한 성능을 확인하였다.

Abstract

Although the AI classification model using the YOLOv5 model has better performance than the existing image classification models such as EfficientDet, EfficientNet, and YOLOv4, there are few model use cases. The model for classifying images of wild animals in a laboratory or staged environment differs from the actual situation in which resolution, angle, illuminance, and weather conditions vary widely, so there are limitations in existing studies. This study can contribute to reducing the number of roadkill accidents caused by wild animals appearing on the road of recent vehicles. In addition to the injury or death of wild animals, the accident causes vehicle damage and human casualties. This article confirmed the excellent performance by applying the YOLO 5 modeling technique, which plays a key role in the development of a service that detects wild animals at a superior level compared to the naked eye and prevents accidents.

Keywords:

YOLOv5, wild animals, object detection, learning data, deep learning, feature mapⅠ. 서 론

야생동물 개체 수 및 이동 경로 조사 수단으로 CCTV 외 이동식 영상 카메라를 활용하고 있다. 야생동물 도메인 전문가와 영상촬영팀이 직접 촬영된 영상을 확인하면서 종판독과 개체수 조사를 진행하여 노동집약적인 분야이다. 특히, 야생동물의 출몰지역이 평지보다는 임야 또는 산악지대가 대부분이고 야행성 동물은 주로 야간에 활동하여 야간 촬영역시 필수적이다. 따라서, 야생동물의 특성상 급접촬영이 어렵고 야간 촬영이 이루어지는 경우에 사람의 육안에 의존한 영상 촬영과 판독으로 야생동물의 정확한 개체수 파악이 어려운 실정이다.

일반인들에게 드러나는 야생동물 중 상당수는 도로 위에서 로드킬로 희생되고 있다. 이런 현상을 방지하기 위하여 도로에 생태통로를 구성하였으나 그 효과는 미비하다.

따라서, 야생동물을 탐지하는 역할을 인공지능이 대체할 수 있다면 불필요한 노동력을 절감하고 연구의 정확도를 높여 야생동물 연구 및 조사에 활용될 수 있을 것이다.

이 글에서는 야생동물의 개체 파악 및 로드킬 방지를 위하여 필요한 야생동물 객체탐지 기법으로 YOLOv5 모델을 적용하여 다음장과 같이 방법과 내용으로 연구하였다.

Ⅱ. 본 론

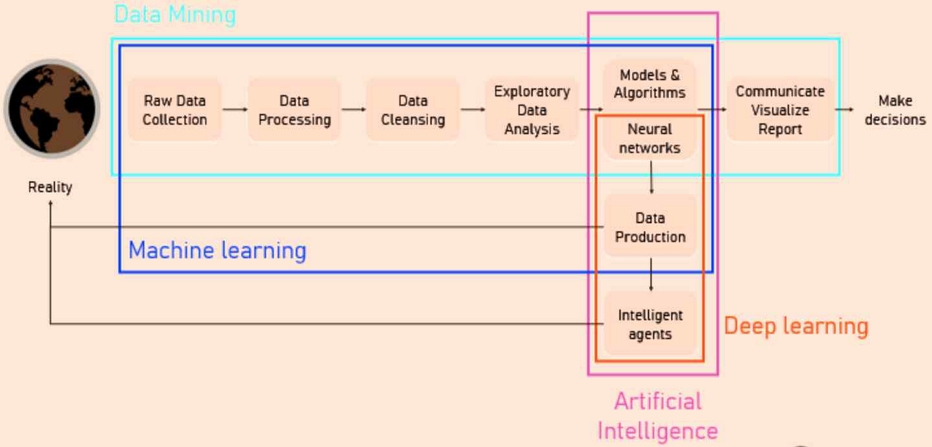

본 연구는 인공지능 모델을 구성하기 위하여 수집, 정제, 가공, 학습의 과정을 수행하였다.

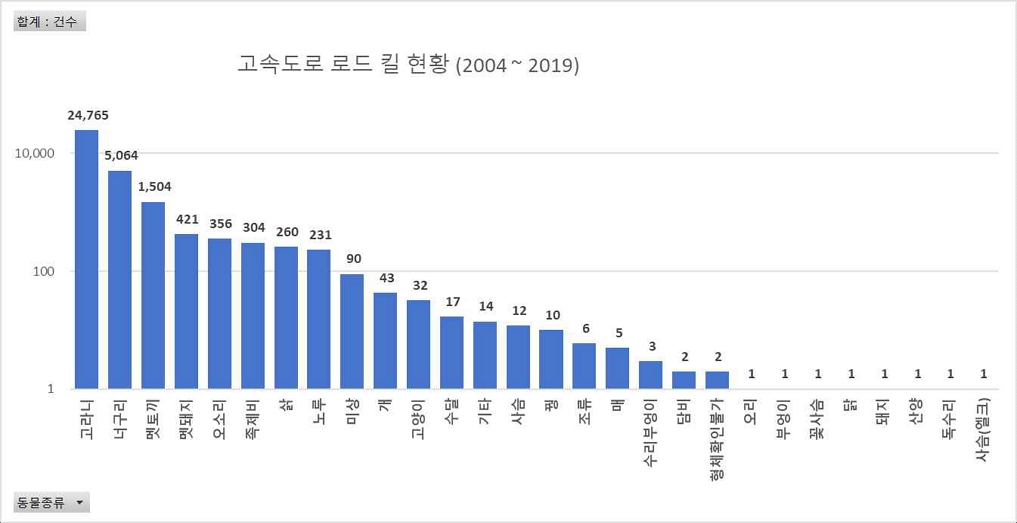

YOLOv5 모델 적용 전 학습데이터셋 구축에 주요 11종은 다음과 같다.

그림 1 중 개체는 고라니, 너구리, 노루, 다람쥐, 멧돼지, 멧토끼, 반달가슴곰, 왜가리, 족제비, 중대백로, 청설모 이미지 데이터 11을 대상으로 하였다. 종선정 기준은 로드킬, 천연보호종을 대상으로 우선 선정하였으며, 수집이 어려운 멸종위기종은 제외하였다.

학습데이터 셋 구축 과정은 AI 학습에 적합하도록 데이터의 목적성, 획득가능성, 정확성, 신뢰성, 다양성 및 균일성, 개인정보 등의 법률적 문제까지 고려하여 구성하였다[1].

본 연구에서 사용한 모델 YOLOv5는 Backbone과 Head 부분으로 그림 2와 같이 구성된다. Backbone은 이미지로부터 Feature map을 추출하는 부분이고 Head는 추출된 Feature map을 바탕으로 물체의 위치를 찾는 구조이다[2].

본 연구에서 객체 선정은 군집 생활을 할 경우 다수의 객체가 될 수 있고 빠르게 이동하기 때문에 대상 모델로서 적합하다고 판단하였다.

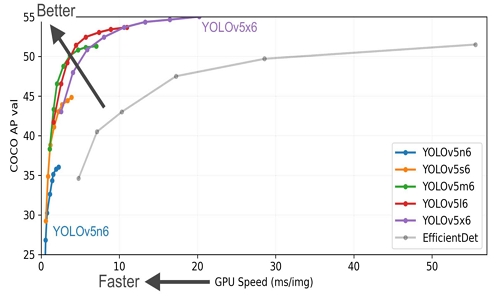

그림 3은 YOLOv5 알고리즘을 네트워크의 크기에 따라 v5n, v5s, v5m, v5l, v5x로 나뉘고, 가장 큰 모델인 v5x 네트워크 크기가 크고, 속도가 느린 대신 정확도가 높고, v5n으로 갈수록 정확도가 다소 낮아지는 대신 속도가 증가하게 됨을 보여준다[4].

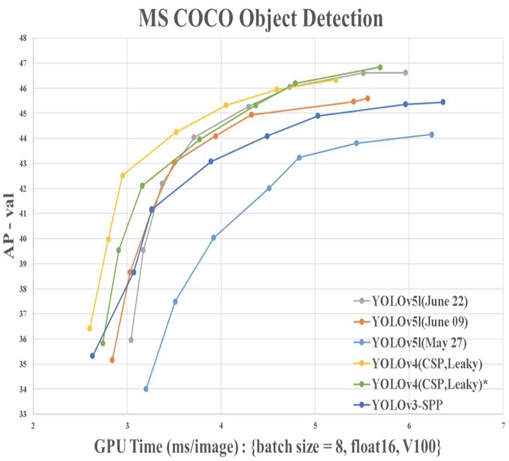

YOLOv5 모델의 가장 큰 장점은 ‘용량이 상대적으로 적으며 V4와 유사한 성능’으로 그림 4와 같다. 향후 본 연구의 결과물이 실제 장비에 적용될 경우 상대적으로 용량이 적은 모델을 활용하는 것이 유리하다고 판단하였다[5]. 이 글의 이미지를 추출하기 위하여 활용한 동영상은 초당 30프레임 기준의 카메라 성능을 가정하여 진행하였다. 촬영된 동영상에서 1초 단위의 30장 이미지 중 2개의 이미지를 수작업으로 추출하고 수집된 데이터를 대상으로 일괄적으로 중복성 검사를 수행하여 중복이미지를 삭제하는 방식으로 전처리 (데이터 정제)하였으며 이를 위해 표 1과 같은 구축 툴을 활용하였다.

주간 데이터는 RGB, 야간데이터는 IR 카메라로 촬영되었으며 이미지는 JPG 형식으로 변환하여 저장하였다. 데이터 수집 장비는 디지털카메라, 스마트폰단말기, 무인센서CCTV를 활용하여 표 2와 같은 장비로 수집하였다.

2.1 데이터 가공 및 분할

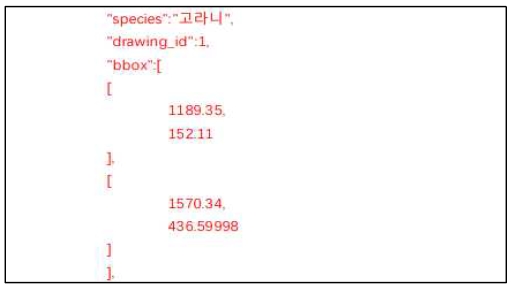

YOLOv5 모델을 활용하기 위한 가공 방식은 바운딩박스와 라벨링을 그림 6과 같이 적용하였다. 그림 5와 같이 수집된 이미지를 대상으로 바운딩박스 좌표와 라벨링 정보를 JSON 파일로 저장하였으며 저작도구를 활용하여 가공하였다.

데이터 학습 정확도를 위해서 데이터 가공시 의미정확성을 의미하는 바운딩 박스의 정확도는 95% 이상을 목표로 진행하였다. 데이터셋 분할은 학습, 검증, 시험 데이터로 분할하여 그 비율은 8:1:1로 진행하였다. 학습데이터의 수량은 표 3과 같이 구성하였다[6].

상대적으로 너구리, 반달가슴곰, 족제비의 데이터 수량이 기타 종과 비교하여 상대적으로 낮게 수집되었으며 고라니, 멧돼지의 데이터 수량이 가장 많이 수집되었다. 외형적으로 유사한 종으로 볼 수 있는 너구리와 족제비, 고라니와 노루는 비교종과 유사한 수량을 학습하였다. 또한 전체 데이터를 대상으로 비교하였을 때 특정한 종의 학습 수량이 많지 않도록 통계적 다양성을 검토하여 수집하였다[7]. 주, 야간 비율은 야행성과 주행성으로 구분하여 야행성 동물은 야간 데이터의 비율을 상대적으로 높게 수집하였다.

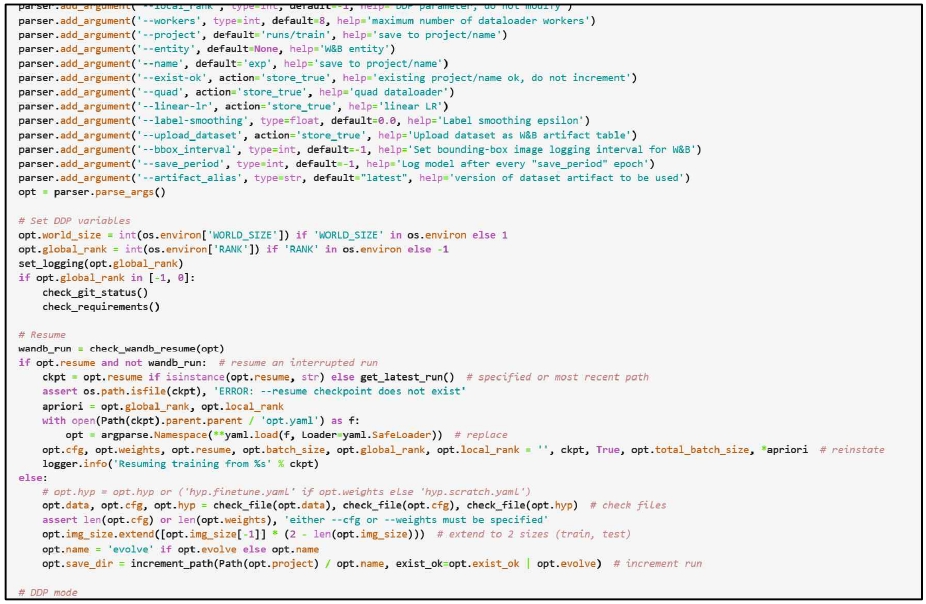

2.2 학습율과 알고리즘 그리고 시스템

표 4와 같이 학습 데이터의 시스템은 Ubuntu 18.04, 32GB Memory, Geforce RTX3090 24GB로 구성되었다. 학습 데이터를 학습, 테스트, 유효성평가 등에 활용한 언어는 Python을 사용하였다. 학습율인 epoch는 24로 진행하였다. 학습모델은 YOLOv5m로 하였다.

2.3 학습결과

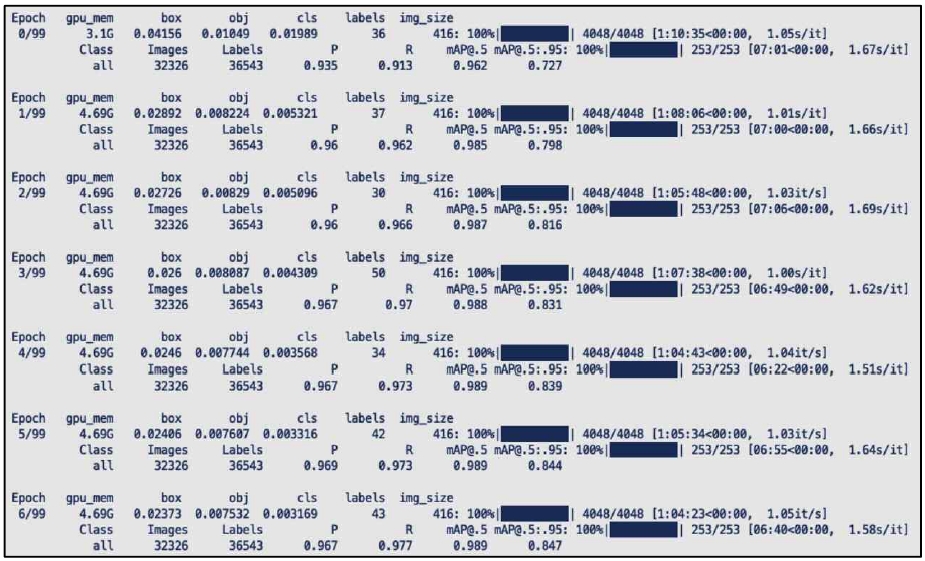

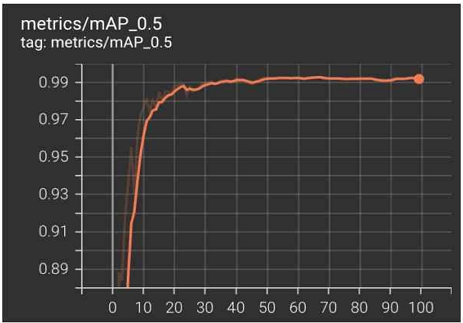

그림 7과 같이 학습율, 배치 사이즈를 조정하면서 데이터를 학습하였다. 학습 결과 최종 모델의 유효성 지표(mAP)은 그림 9와 같이 0.911이 나왔다.

표 5의 종별 결과를 검토하면 상대적으로 멧돼지와 반달가슴곰, 중대백로, 청설모의 탐지율이 높게 나왔으며 노루, 너구리의 탐지율이 낮게 기록되었다. 총학습 시간은 약 100시간 소요되었다. 그림 8, 10, 11은 학습결과를 도출하는 과정을 보여준다.

2.4 문제점 및 개선방향

본 연구 결과 및 과정을 통해 다음과 같은 문제점과 개선 방향을 도출할 수 있었다. 첫째, YOLOv5 모델을 이용한 야간데이터의 JPG 변환 과정에서 IR카메라의 원시데이터 특성이 반영되지 않았을 가능성을 검토해볼 필요가 있다. 픽셀당 변수로 색상 변수가 있다. 해당 색상 변수의 RGB와 IR 이미지 데이터는 상이하여, JPG 변환을 위한 방법론을 추가로 제시한 후속 연구가 필요하다. 이를 위해서는 해당 색상 변수에 대한 실험데이터를 축적할 필요성이 있다[8].

둘째, 카메라 모듈에 인공지능 모델을 탑재할 경우 제한적인 장비 사양으로 인해 모델의 용량이 최소화되어야 한다. 그러나 높은 성능을 얻기 위해 데이터 학습량을 늘릴수록 모델의 용량이 증가하는 한계가 있었다. 그러므로 실험 상황에서 활용한 연구 결과를 상용화하기 위해서는 적정한 성능치와 비교분석된 학습량이 추후 제시되면 상용화에 도움을 줄 것으로 기대된다[9].

Ⅲ. 결 론

이 글은 야생동물의 주, 야간 데이터를 동시에 학습시켰을 경우가 다른 연구과 차별성을 갖는다. 실제 정확도 측면에서 YOLOv5 모델은 야간과 주간에 따른 정확도가 크게 하락하지 않아 실제 상용화 과정에서 해당 결과를 참고할 수 있을 것으로 사료된다. 특히, 특정 영상은 객체가 빠르게 이동한 야간 이미지였다. 이 경우 육안으로는 야생동물의 종판별과 종식별이 쉽지 않다. 그러나 본 연구에서 수행한 학습 결과, 야간 영상에서도 비교적 우수한 객체 탐지 성능을 확인 할 수 있었다.

본 연구 결과 중 주목할 부분은 다수의 유사한 객체가 존재하는 경우 해당 객체를 구체적 수준(종 판별)으로 탐지했다는 점이다. 예를 들어 그림 10, 11과 같이 야생동물 중 외형적으로 유사한 종에 대한 탐지 결과를 보면 다음과 같다. 우선 너구리와 오소리, 고라니와 노루의 경우 외형적으로 구분되는 특징이 분명하지만 다양한 촬영환경에서 외형적 특징이 육안으로는 식별이 불가능하다.

또는 야생동물 전문가라할지라도 구분하기 위해서 많은 시간이 소요되는 이미지들을 수집하여 학습 후 정확도를 측정하였다. 본 연구에서 활용한 모델은 대부분 유사한 외형의 종도 구분을 탐지했으며 기초모델과 학습 후의 모델에 동일한 이미지를 입력하였을 경우 다른 결과값을 보여주었다. 육안으로 식별이 어려운 부분을 모델이 수행하는 것을 증명하였다. 향후 야간에 촬영된 이미지를 대상으로 YOLOv5m 모델을 활용한 객체탐지 연구를 통해 불특정 다수의 야생동물이 실시간으로 동시에 빠르게 이동하는 경우에도 탐지가 가능할 것으로 판단된다.

후속 연구로 다른 종류의 영상 장비(저, 중, 고 품질)를 주간/야간/눈/비/안개 등 기상 상황에 독립적이면서 실시간으로 빠르게 이동하는 야생동물을 수십종, 수십여 마리를 동시에 탐지하고 추적하는 응용 서비스 개발에 기반 연구 자료로 활용될 수 있을 것으로 기대된다.

References

- "Data quality management guidelines for AI learning v1.0", Ministry of Science and ICT, NIA, TTA. Feb. 2021.

- "2021 AI Reliability Framework", Ministry of Science and ICT, TTA. 2022.

- Alex Konduforov, "Data Science vs Machine Learning vs AI vs Deep Learning vs Data Mining: Know the Differences", altexsoft, Jan. 2021. URL: https://www.altexsoft.com/blog/data-science-artificial-intelligence-machine-learning-deep-learning-data-mining/, [accessed: Oct. 05, 2022]

- ultralytics(Github), https://github.com/ultralytics/yolov5.hleen-jocher, , Aug. 2022.

-

Xingkui Zhu, Shuchang Lyu, Xu Wang, and Qi Zhao, "TPH-YOLOv5: Improved YOLOv5 Based on Transformer Prediction Head for Object Detection on Drone-Captured Scenarios", Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV) Workshops, Aug. 2021.

[https://doi.org/10.48550/arXiv.2108.11539]

-

Jin-Gu Kim, Ji-Hun Kang, Kyoung-Cheol Choi, Woong-Ki Jang, Ho-Jin Ha, Kwang-Suk Lim, Byeong-Hee Kima, and Yong-Jai Parka, "Development of a Normal/Abnormal RBC Detection Algorithm using YOLOv5", Journal of the Korean Society of Manufacturing Technology Engineers 31:2, pp. 94-100, Mar. 2022.

[https://doi.org/10.7735/ksmte.2022.31.2.94]

- Inhee Hong, Sumin Lee, Soonho Jang, and Jongho Yoon. "Smart traffic signal solution for the visually impaired(smart traffic light and receiver)", Korea Information Processing Society, Nov. 2021.

-

Sung-Hyuk Jang, Sang-Hee Lee, Yong Choi, Tae-Hyeong Kim, and So-Young Shin. "Design of a Potato Yield Monitoring System Using Deep-Learning", Journal of Korea Academia-Industrial cooperation Society(JKAIS), Vol. 23, No. 5, pp. 217-224, May 2022.

[https://doi.org/10.5762/KAIS.2022.23.5.217]

- Farnoosh Heidarivincheh, Majid Mirmehdi, and Dima Damen, "Detecting the Moment of Completion: Temporal for Localising Action Completion", Computer Science Department, University of Bristol, Bristol, BS8 1UB, UK, Oct. 2017.

1999년 2월 : 고려대학교(경영석사)

2005년 8월 : 고려대학교 정보보호대학원(공학박사)

2020년 8월 : 동국대학교 국제정보보호대학원 대우교수

2021년 4월 ~ 현재 : 극동대학교 해킹보안학과 교수

관심분야 : 인공지능, 블록체인, 융합보안, 산업보안