스마트폰 녹음 여부 검출을 위한 딥러닝 기반 오디오 포렌식

초록

최근 범죄에 사용되는 오디오 데이터는 휴대성이 편리한 스마트폰을 이용하여 녹음하는 경우가 대부분이다. 따라서 방대한 오디오 데이터들 중에서 스마트폰을 이용하여 녹음된 오디오 데이터만 검출하는 것은 포렌식 분석을 위해 유의미하다. 본 논문에서는 CNN 모델을 기반으로 오디오 데이터에 대해 스마트폰 녹음 여부를 검출하기 위한 포렌식 알고리즘을 제안한다. 입력 오디오를 10초 단위 세그먼트로 분할하여 Mel-Spectrogram 특징을 추출하고, CNN 모델에 적용하여 학습과 평가를 통해 스마트폰 녹음 여부를 검출하였다. 자체적으로 수집한 오디오 데이터를 사용하여 실험을 수행하였고, 그 결과 세그먼트 단위로 94.98% 및 전체 오디오에 대해 95.40%의 스마트폰 녹음 여부 검출 정확도를 달성하였다.

Abstract

Most of audio data used in recent crimes is mostly recorded through portable smartphones. Therefore, it is meaningful for forensic analysis to detect only audio data recorded using the smartphone among vast amounts of audio data. In this paper, based on a CNN model, we propose a forensic algorithm to detect whether or not audio data is recorded by a smartphone. Mel-spectrogram features were extracted by dividing the input audio into 10-second segments and applied to a CNN model that detects smartphone recording through training and testing. Experiments were conducted using the audio data collected by ourselves, and as a result, we achieved 94.98% detection accuracy for each segment and 95.40% detection accuracy for the entire audio.

Keywords:

audio recording device forensics, mel-spectrogram, convolutional neural network, smartphoneⅠ. 서 론

개인용 컴퓨터의 디스크 용량 증가와 저장, 분석되어야 하는 방대한 양의 데이터는 포렌식 수집과 분석 시간을 점점 더 요구하고 있다. 디지털 포렌식의 주요 문제 중의 하나는 분석해야 하는 데이터의 양이 증가하는 것이다[1]. 이에 따라 고속으로 대용량 데이터를 처리하여 제한된 수사 시간을 고려한 고속 디지털 포렌식 기술이 등장하고 있다[2].

오디오 데이터도 주요 분석 대상이며, 빅데이터화된 데이터들을 조사, 분석하는 과정에서 효율성을 높일 수 있는 방안 마련이 시급하다. 오디오 분류에 대해 많은 연구가 진행되어 왔고, 빅데이터화된 데이터를 처리하기 위해 딥러닝을 적용하여 연구한 사례도 많다[3]. 하지만 기존 연구에서 진행된 분류의 세분화 깊이와 정확도는 포렌식 분야에서 유의미하게 사용하기가 어려운 수준이다.

최근 범죄에 사용되는 대부분의 오디오 데이터는 전문적 녹음 장치를 사용하기보다는 휴대성이 편리한 스마트폰을 사용하는 것이 다수이기 때문에, 방대한 오디오 데이터에서 스마트폰을 이용하여 녹음된 오디오 데이터만을 검출하는 것은 유의미하다.

따라서 본 논문에서는 딥러닝을 이용하여 오디오 데이터가 스마트폰을 이용하여 녹음되었는지 판별하기 위한 포렌식 알고리즘을 제안한다. 음성, 악기 등 오디오 데이터의 콘텐츠와 무관하게, 오디오 데이터에 포함된 스마트폰 녹음의 특징을 활용하여 판별할 수 있도록 하였다.

본 논문의 구성은 다음과 같다. 2장에서는 기존 CNN(Convolutional Neural Network) 기반 오디오 분류 모델과 기존 포렌식에서 딥러닝 적용 사례를 설명한다. 3장에서는 제안하는 CNN 기반 스마트폰 녹음 여부 판별 포렌식 알고리즘을 설명하고, 4장에서는 실험 및 분석 결과를 제시한다. 마지막으로 5장은 결론, 한계점 및 향후 연구를 기술한다.

Ⅱ. 관련 연구

국내외에서 딥러닝을 사용해 포렌식의 목적으로 기기 분류를 하는 연구들이 활발히 진행되고 있다. 다양한 접근 방식이 있는데, 오디오 녹음 장치의 흔적을 배경 잡음으로부터 식별하여 포렌식을 위한 특징으로 활용하는 경우가 많다.

잡음은 오디오 녹음 장치의 고유한 지문 흔적으로 간주 될 수 있기 때문에, 이 특성을 검출해 디지털 추적이나 장치 식별에 사용할 수 있다.

Qi 외는 잡음을 고유한 특성으로 사용해 특징 벡터를 얻고, 딥러닝을 활용하여 기기 식별을 진행하여 평균 93% 정확도를 달성하였다[4]. Zeng 외는 웹 미디어 포렌식 분야에서 효율적인 다중 기능 융합 소스 기록 장치 식별 방법으로 기록 장치를 효율적이고 편리하게 식별할 수 있도록 End-to-end 및 Attention 매커니즘을 기반으로 하는 기술을 제안하였다. 정확도가 평균 97%의 높은 정확도를 가지며, 학습 시간도 기존에 비해 크게 단축되었다[5].

Qamhan 외는 음성에서 환경과 마이크 특징의 자동 추출을 위해 심층 신경망인 CNN과 CRNN을 사용하여 LSTM이 있는 Spectrogram 기능을 사용하였다. 3가지 다른 환경에서 마이크 분류에 대한 배경 소음 영향을 연구했고, CRNN과 양방향 LSTM 모델의 장점을 결합해 약 98% 성능을 달성했다[6].

현재 오디오 포렌식 분야에서는 모바일 기기의 대중화로 인해 오디오의 모바일 기기를 판별하는 연구도 진행되고 있다. Daniel and Carol은 특징 추출을 사용하여 모바일 기기를 특정 모델별로 분류하는 연구를 수행하였다[7]. 최근에는 Naini 외는 CNN-LSTM 모델을 기반으로 Dual Attention Pooling 네트워크를 설계하여 녹음 장치 분류에서 94.56%의 성능을 달성하였다[8].

모바일 기기 모델을 분류하는 것은 오디오 포렌식 분야에서 의미가 있지만, 이러한 기술을 사용하려면 방대한 오디오 데이터에서 모바일 장치로 녹음한 오디오를 분류해내는 게 우선이다. 특히, 수사 시간은 무한하지 않기 때문에, 데이터양이 증가할수록 정해진 시간에 수사를 끝내기가 어려워진다.

따라서, 빅데이터화된 오디오 데이터 속에서 스마트폰으로 녹음한 데이터만을 검출하는 것은 유의미하며, 관련 연구가 진행된 사례가 많지 않아서 본 논문에서 제안하는 기술은 오디오 포렌식 모바일 장치 분류 분야 등에서 유용하게 활용할 수 있다.

Ⅲ. 제안하는 스마트폰 녹음 여부 검출 오디오 포렌식 알고리즘

본 절에서는 CNN 모델을 이용하여 방대한 오디오 데이터 중에서 스마트폰 녹음 여부를 검출하는 포렌식 알고리즘에 대해 제안한다. 기존 연구에 대하여 모델을 확장하고 최적화하였으며 방대한 실험과 분석을 통하여 신뢰성을 향상하였다[9].

먼저 입력된 오디오 파일에 대하여 스마트폰 녹음 여부 검출 포렌식 알고리즘의 전반적인 동작을 설명하고, 각 세그먼트로 구분된 오디오 파일에 대해 데이터 전처리와 세그먼트 단위로 스마트폰 녹음 여부 검출을 위한 CNN 모델을 기술한다.

3.1 스마트폰 녹음 여부 검출 포렌식 알고리즘

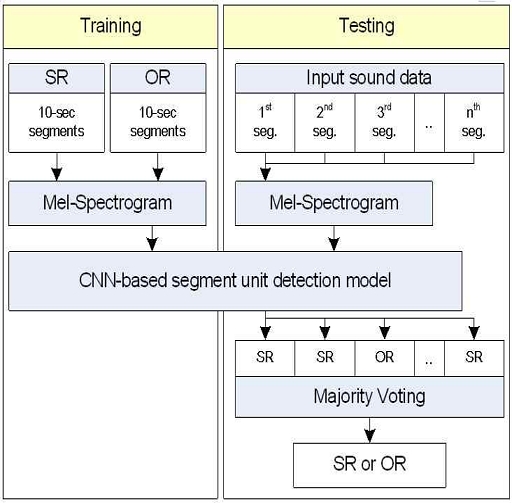

본 논문에서 제안하는 입력된 오디오 파일에 대하여 스마트폰 녹음 여부 검출 포렌식 알고리즘의 대략적 구조를 그림 1에 도시하였고 학습(Training) 과정과 평가(Testing) 과정으로 구성이 되어 있다.

학습 과정에서는 입력되는 오디오 데이터의 길이가 다양하므로, 먼저 입력 오디오를 10초 단위의 세그먼트로 분할하고 각 세그먼트에 Mel-Spectrogram을 추출하여 CNN 모델을 학습하였다.

평가 과정으로는 먼저 입력되는 전체 오디오를 10초 단위의 세그먼트로 분할하고, 학습 과정과 동일하게 각 세그먼트에 대하여 데이터 전처리를 통하여 Mel-Spectrogram을 추출한다. CNN 모델을 이용하여 세그먼트 단위로 스마트폰 녹음(SR) 또는 기타기기 녹음(OR)으로 분류한다. 전체 오디오에 대하여 각 세그먼트 단위로 분류를 수행한 후에 빈도수를 기반으로 최종적으로 해당 오디오의 스마트폰 녹음 여부를 검출한다.

3.2 데이터 전처리

2차원 데이터인 이미지에 적합한 CNN 모델을 오디오에 적용하기 위해서는 1차원 데이터인 오디오를 CNN 모델에 적합한 입력으로 만드는 전처리가 필요하다. 데이터 전처리에서는 1차원 시간 도메인 데이터를 주로 심리 음향에 기반을 둔 주파수 도메인의 오디오 특징 데이터를 추출한다. 특히, 시간 도메인에 대하여 중첩하여 특징 데이터를 추출하여 2차원 데이터로 변환한 후 이를 이미지로 간주하고 CNN 모델을 학습하는데, 이러한 방식이 효과적으로 오디오에 적용될 수 있는 것이 여러 연구를 통해 알려져 있다[4].

입력한 오디오 데이터를 16,000 Sampling rate로 변환하고, 10초 단위 세그먼트로 분할하였다. 특징 추출을 통해 오디오를 이미지로 변환한 309×128 크기의 패치 데이터가 CNN 모델의 학습과 평가를 위해 사용된다. 오디오 데이터의 전처리를 위해서는 Spectrogram에 인간 청각 특징을 활용하는 멜 필터(Mel-filter)를 적용해서 얻어진 Mel-Spectrogram을 사용하였다. 이는 Spectrogram보다 크기가 작아서 학습 속도에 유리하며, 주파수끼리 상관하기 때문에 도메인이 한정적인 문제에서 좋은 성능을 보인다.

이와 같은 데이터 전처리를 통한 Mel-Spectrogram 추출 과정으로 오디오 세그먼트는 309×128×1 크기의 모델의 입력 데이터가 되고, 학습, 검증, 평가 데이터 세트 모두에 적용하였다.

3.3 세그먼트 단위 판별 CNN 모델

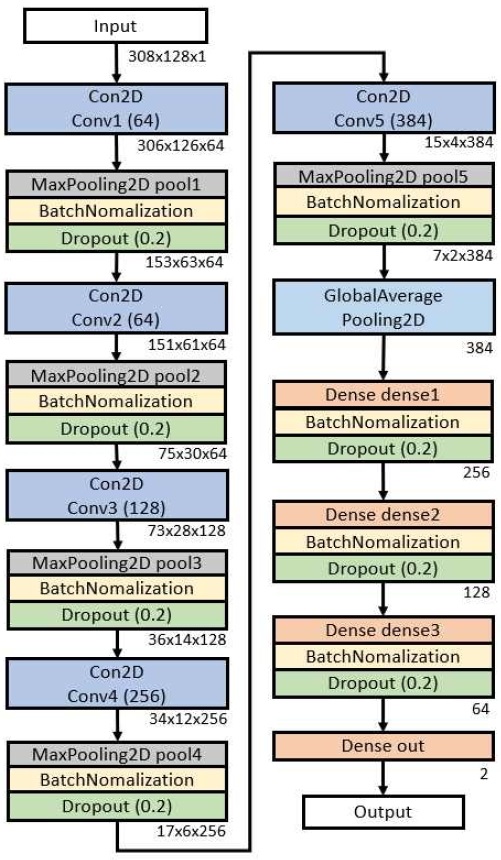

각 세그먼트 단위로 스마트폰 녹음 여부를 판별하기 위한 CNN 모델의 내부적인 구조를 그림 2에 도시하였다.

컨볼루션 계층은 5계층(Conv1~Conv5)으로 구성되며, 3x3 크기 커널로 컨볼루션을 수행한다. 각 컨볼루션 수행 후에는 Max pooling을 통해 특징을 1/2로 줄인다. 그 후에 과적합 문제를 해소하기 위해 배치 정규화(Batch nomalization)과 드롭아웃(Drop-out) 처리를 수행하며 비율은 0.2를 사용하였다.

컨볼루션 계층에서의 처리 결과는 전연결 계층(Dense1~Dense3)에 입력된다. 전연결 계층의 결과는 스마트폰 녹음과 기타기기 녹음에 대한 확률로서 큰 값을 갖는 것을 판별 결과로 사용하였다.

Ⅳ. 실험 결과 및 분석

4.1 실험 데이터셋

제안한 알고리즘의 실험을 위해서 오디오 데이터셋을 YouTube 영상과 스마트폰 등으로 자체적으로 수집하여 구축하였다. 온라인 등에 공개된 오디오 데이터셋의 경우에는 해당 오디오 데이터셋을 어떤 장치를 사용하여 수집하였는지 명확하지 않아 사용하지 않았다.

구축한 데이터셋을 스마트폰 녹음(SR)과 기타기기 녹음(OR)의 두 클래스로 구분하여 사용하였다. SR 및 OR 데이터는 회의, 일상 대화, 전화 녹음, 노래, 영화 등 음성 데이터와 동물 소리, 자연 소리, 악기 소리 등 비음성 데이터를 포함하여 딥러닝 모델이 콘텐츠에 대한 의존성을 갖지 않도록 데이터를 다양하게 구성하였다. 특히, SR 데이터의 경우 OR 데이터에 해당하는 Youtube 영상을 재생한 후 스마트폰으로 녹음하여 구축함으로써 SR과 OR 데이터가 유사한 오디오 콘텐츠를 포함하도록 함으로써 콘텐츠 특성에 따라 구분되지 않도록 하였다.

4.2 세그먼트 단위 판별 CNN 모델 학습 성능

표 1에 나타낸 것과 같이 실험을 위해서 SR과 OR 클래스에 대하여 각각 16,499장 및 9,602장의 오디오 데이터를 사용하였으며, 학습 데이터와 검증 데이터의 비율은 0.9:0.1로 설정하였다.

전체 오디오 데이터 26,051개 중 23,441개의 데이터를 학습에 사용하였고 2,605개의 데이터를 모델 학습 추세 및 과적합을 분석하는데 사용하였다.

표 2에 SR 클래스 수집을 위한 장치들과 기종별 학습 데이터를 나타내었다. 스마트폰으로 LG, Samsung, Apple 제품을 사용하였으며, 각 브랜드 별로 1개, 4개, 3개 모델을 활용하였고, 총 2,247개, 6,595개, 7,607개의 학습 데이터를 수집하였다.

제안하는 모델은 Tensorflow와 관련 API를 이용해 구현하였고, 학습 과정에서 지연 로딩 방식을 사용해 학습에 필요한 데이터만 GPU 메모리에 로딩해 메모리 공간 여유를 확보하도록 하였다.

모델 학습 파라미터로 학습률은 1-3, 가중치 감쇠는 1-1로 설정하였다. 손실 함수는 이진 크로스 엔트로피를 사용하고, 최적화 함수는 Adam optimizer를 사용하였다. 학습은 64 배치 사이즈에 최대 100 Epoch로 진행하였고, 10 epoch 동안 검증 데이터의 손실값에 변화가 없을 때 조기 종료하도록 하였다.

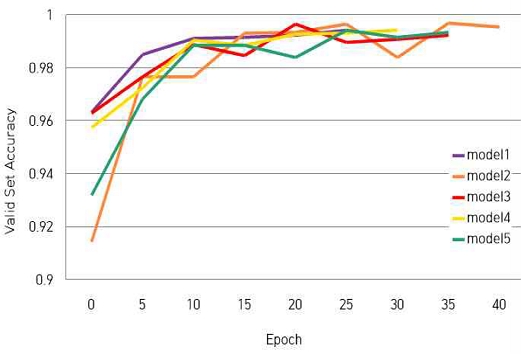

그림 3에는 학습 및 검증 데이터를 사용해 제안하는 모델에 대하여 총 5번의 학습을 진행하여 나온 학습 정확도 추세를 5 Epoch 단위의 그래프로 도시하였다.

표 3에는 5개의 모델 중 정확도의 평균값이 가장 높은 모델인 model 1의 각 Epoch에 따른 학습과 검증 정확도와 손실률의 추세를 나타내었다. 14 Epoch에서 손실률이 0.014로 가장 작았고, 최대 99.57%의 정확도를 달성하였다.

4.3 세그먼트 단위 판별 CNN 모델 성능 분석

세그먼트 단위에 대해 CNN 모델을 이용한 2종 분류로 스마트폰 녹음(SR)과 기타기기 녹음(OR) 클래스의 확률값을 계산하고 최대 확률값을 갖는 클래스를 기준으로 분류하는 성능을 분석하였다.

학습된 모델의 세그먼트 단위 성능 분석에 사용된 평가 데이터를 표 4에 나타내었다. 이 데이터는 학습과 검증에 사용되지 않은 독립적인 데이터이다.

제안한 모델로 세그먼트 단위에 대해 평가 데이터에 대하여 정확도 분석한 결과를 표 5에 정리하였고 평균적으로 94.975% 정확도를 달성하였다. OR 클래스는 높은 정확도를 보이나, SR 클래스의 경우는 상대적으로 낮은 정확도를 보였다.

4.4 전체 오디오에 대한 알고리즘 성능 분석

제안하는 스마트폰 녹음 여부 검출을 위한 알고리즘에 대하여 실제 오디오 파일에 대한 성능 분석을 위해 약 3~5분 길이의 스마트폰 녹음 오디오와 기타기기 녹음 오디오 파일인 2가지 분류로 SR 클래스는 130개와 OR 클래스는 132개씩 사용하였다.

표 6에 SR 클래스의 브랜드 학습 데이터를 나타내었다. LG, Samsung, Apple의 각 브랜드별로 1개, 3개, 4개 장치를 사용하였고 총 20개, 40개, 70개의 평가 데이터를 수집하였다. 특히, 같은 모델에 대해서도 여러 개의 제품을 사용하였고, 모델명 옆에 사용한 제품 수도 괄호로 표시하였다.

특히, 학습에 사용하지 않은 Galaxy A32, Galaxy A90, iPhone SE2, iPhone 12 Mini, iPhone 13 Pro와 같은 스마트폰 모델을 포함함으로써 모델에 의존적인 특성을 갖지 않고 있는 것도 분석하였다.

입력 오디오에 대해 3.1절에서 설명한 것과 같이 빈도수를 계산해 각 세그먼트에 대해 클래스 분류를 수행하고 실제 클래스와 예측 클래스의 일치 여부로 성능 분석을 진행하였다.

표 7에는 그림 3에서 설명한 5개 모델에 대하여 전체 오디오 파일 분류 실험의 평균 정확도를 나타내었다. Model 1의 평균 정확도가 95.4%로 가장 높게 나타났다.

Ⅴ. 결론 및 향후 과제

최근 범죄에 사용되는 오디오 데이터는 전문적인 녹음 장치를 사용하기보다는 휴대성이 편리한 스마트폰을 사용하는 것이 대부분이기 때문에, 방대한 오디오 데이터에서 스마트폰 녹음 데이터만 검출하는 것은 포렌식에서 유의미하다.

본 논문에서는 딥러닝을 이용하여 다양한 오디오 데이터에서 스마트폰으로 녹음한 오디오 데이터를 검출하기 위한 포렌식 알고리즘을 제안하였다. 제안하는 방법에서는 CNN 모델을 이용하여 스마트폰 녹음 여부를 검출하였으며, 실험을 통하여 세그먼트 단위의 판별 정확도가 94.98%, 전체 오디오에 대해서 95.40% 정확도를 달성하였다.

추후 연구에서는 세그먼트 단위 검출을 위해 CNN 모델보다 이미지 상에 존재하는 결함을 감지하는데 있어서 뛰어난 성능을 보여주는 모델들을 도입한다면 성능이 향상되어, 전체 알고리즘의 정확도가 향상될 것으로 판단된다.

Acknowledgments

This work was supported by the Basic Science Research Program through the National Research Foundation of Korea (NRF) funded by the Ministry of Education (2020R1F1A1057742).

References

-

A. Guarino, "Digital forensics as a big data challenge", Proc. of the 2013 Securing Electronic Business Processes, pp. 197-203, Jan. 2013.

[https://doi.org/10.1007/978-3-658-03371-2_17]

- K. Kim and D. Hong, "High Speed Digital Forensics Technique", KIISC Review, Vol. 19, No. 5, pp. 45-51, 2009.

- W. J. Jang, H. W. Yun, S. H. Shin, and H. C. Park, "Audio Genre Classification based on Deep Learning using Spectrogram", Proc. of the Korean Society of Broadcast Engineers Conf, pp. 90-91, Jun. 2016.

- S. Qi, Z. Huang, Y. Li, and S. Shi, "Audio recording device identification based on deep learning", Proc. of the IEEE Int. Conf. on Signal and Image Processing, pp. 426-431, Aug. 2016.

-

C. Zeng, D. Zhu, Z. Wang, Z. Wang, N. Zhao, and L. He, "An end-to-end deep source recording device identification system for Web media forensics", Int. J. of Web Information Systems, Vol. 16, No. 4, Aug. 2020.

[https://doi.org/10.1108/IJWIS-06-2020-0038]

-

M. A. Qamhan, H. Altaheri, A. H. Meftah, G. Muhammad, and Y. A. Alotaibi, "Digital Audio Forensics: Microphone and Environment Classification Using Deep Learning", IEEE Access, Vol. 9, pp. 62719-62733, Apr. 2021.

[https://doi.org/10.1109/ACCESS.2021.3073786]

- G. R. Daniel and Y. E. W. Carol, "Automatic acquisition device identification from speech recordings", Proc. of the 2010 IEEE Int. Conf. on Acoustics, Speech and Signal Processing, pp. 1806-1809, Mar. 2010.

-

A. R. Naini, B. Singhal, and P. K. Ghosh, "Dual Attention Pooling Network for Recording Device Classification Using Neutral and Whispered Speech", Proc. of the 2022 IEEE Int. Conf. on Acoustics, Speech and Signal Processing, pp. 8487-8491, May 2022.

[https://doi.org/10.1109/ICASSP43922.2022.9747700]

- S. J. Eom, H. S. Kim, and H. Y. Lee, "Smartphone recording detection forensics using deep learning", Proc. of KIIT Conf., pp. 526-528, 2021.

2022년 7월 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 (학사과정)

관심분야 : 영상 처리, 딥 러닝, Web Service

2022년 7월 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 (학사과정)

관심분야 : 영상 처리, 딥 러닝

1997년 : 성균관대학교 정보공학과 (공학사)

1999년 : KAIST 전산학과 (공학석사)

2006년 : KAIST 전자전산학과 (공학박사)

2008년 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 교수

관심분야 : Digital Forensics, Image Processing, IoT