의료 영상 시스템에서 다중 연쇄 U-Net 모델을 이용한 개선된 췌장 영역 분할 탐지

초록

의료 영상은 사람의 체내 장기를 관찰하고 질병을 진단하기 위해 영상 분석이 필수적으로 요구되는데 다양한 영역 중 크기가 작고 다른 장기에 겹쳐진 췌장은 의료 이미지에서 정확한 위치를 찾기가 어렵다. 본 논문에서는 기계 학습을 통해 복부 이미지에서 췌장의 위치를 보다 정확하게 분할할 수 있는 다중 연쇄 U-Net (MCU-Net) 모델을 제안한다. 제안하는 모델은 최종 계층의 여러 U-Net 구조를 다양한 크기의 패치와 연쇄 결합한 모델이며, 앙상블, 패치 크기에 따른 다양한 실험을 통해 가장 효과적인 MCU-Net을 제안한다. 선행 연구들과의 비교 실험 결과, 제안하는 다중 연결 U-Net 모델의 정확도는 91.6%로 기존 U-Net 모델보다 정확도가 약 2% 더 높은 것으로 나타났다.

Abstract

Medical images require image analysis to observe human organs and diagnose diseases, and it is difficult to find an accurate location in medical images for the pancreas overlapped with other organs and smaller among various areas. In this paper, we propose a multi-chain U-Net (MCU-Net) model that can more accurately segment the position of the pancreas in abdominal images through machine learning. The proposed model is a model that chain-combines several U-Net structures in the final layer with patches of various sizes, and proposes the most effective MCU-Net through various experiments with ensembles, patch sizes. Comparative experiments with previous studies show that the accuracy of the proposed multi-connected U-Net model is 91.6%, about 2% higher than that of the existing U-Net model.

Keywords:

pancreas segmentation, image processing system, deep learning, artificial intelligenceⅠ. 서 론

CT나 MRI와 같은 의료 영상은 사람의 체내 장기를 관찰하고 질병을 진단하기 위해 영상 분석이 필수적으로 요구되는데 체내 장기 중 췌장은 크기가 작고 위장의 뒤쪽 십이지장과 연결된 위치적 특징 등으로 인해 탐지 난이도가 매우 높다. 췌장은 췌장암이나 췌장염과 같이 치사율과 위험성이 높은 병변이 발견되기에 정확한 진단이 필수적인데 전공의사도 분석을 할 때 시간이 오래 걸리고, 정확도도 상대적으로 낮은 편에 속하는 장기다. 최근에는 딥러닝(Deep learning)과 컴퓨팅 성능 향상으로 인해 CT나 MRI와 같은 의료 영상에서 인체 장기를 CNN(Convolutional Neural Networks) 모델 기반의 딥러닝 시스템을 이용해 분할(Segmentation)이나 부피(Volume)를 측정하는 지능 정보 시스템이 많이 개발되고 있다.

CT나 MRI와 같은 의료 영상에서 CNN 모델 기반 딥러닝 시스템을 이용해 인체 장기를 분할할 때, 폐나 안구 혈관 같은 인체 조직은 98% 이상으로 잘 분할된다[1][2]. 그러나 췌장은 U-net[3], Attention U-Net[4], RSTN[5] 등 다양한 딥러닝 모델을 이용한다 하더라도 분할 성능 정확도가 90%도 넘지 못하고 있다[6]. 따라서 본 논문에서는 다양한 패치 크기의 U-Net 구조를 다중 연쇄 결합(Concatenation)하여 췌장 분할 성능을 향상시킬 수 있는 새로운 MCU-Net(Multiple Concatenated U-Net) 모델을 제안한다. 제안하는 MCU-Net 모델은 각 필터의 크기가 다른 U-Net 모델들을 마지막 단계에서 하나로 연쇄 결합하여 췌장을 분류한다.

Ⅱ. 관련 연구

췌장 분할을 위한 초기 연구는 통계적 모델을 쓰거나 다중 아틀라스(Multi-atlas) 기법을 사용했다[7]. 그런데 아틀라스 기법은 분할하고자 하는 대상 이미지가 훈련했던 아틀라스의 형태와 다른 경우 분할 정확도가 낮아지는 한계점이 있다[8]. 반면, 기계 학습의 CNN 모델을 발전시킨 U-Net, Attention U-Net, RSTN은 췌장 분할 정확도가 아틀라스 기법에 비해 모두 크게 향상되었다. 그 중 U-Net은 적은 이미지 셋을 효과적으로 사용하여야하는 biomedical segmentation application 영역에 활용을 위해 Up-sampling과 Skip Architecture을 적용하여 구현한 것이며, biomedical segmentation application 뿐만아니라 image Segmentation을 위한 다양한 영역에서 다방면으로 사용[9]되고 있으며, 가장 우수한 효과를 보인다.

입력 이미지로부터 특정 기관 및 세포를 분할하는 U-Net 모델은 U자 형태의 네트워크를 구성한다. 이때, 수축 경로(Contracting path)과 확장 경로(Expanding path)를 통해 이미지의 사소한 부분은 배제되고 특징이 되는 부분은 유지 전달한다. U-Net 모델을 기반으로 한 Attention U-Net 모델은 기존 U-Net 시스템에 비해 특징에 집중하는 개념인 AG(Attention Gate)를 추가한 모델로, U-Net에서 이미지의 특징 정보를 게이트를 통해 선택적으로 유지한다. AG로 훈련된 모델들은 특정 작업에 유용한 두드러진 특징을 강조하면서 입력 이미지의 관련 영역을 억제하는 방법을 암묵적으로 학습한다. 이로써 모델 민감도와 예측 정확도를 높였고, 패치 단위로 영역을 탐지해서 훈련 속도 또한 빠른 편이다. 이외에도 R-CNN과 같이 2단계 학습을 진행하는 RSTN은 신장, 비장, 췌장 등의 몸의 작은 장기들을 분리하는 방법을 제시했다. 이 방법은 첫 번째 단계에선 찾고자 하는 장기의 위치를 찾고, 두 번째 단계에서는 장기 식별을 수행하여 영역을 분할한다. 그러나 RSTN은 지나치게 긴 학습 시간을 요구하며, 탐지 정확도 결과들 중 췌장 탐지에 대한 성능이 다른 영역에 비해 낮은 것을 확인할 수 있다. 가장 좋은 성능 또한 모델의 미세조정을 통한 결과이기에 췌장 탐지에 RSTN 제안 방식이 효과적이지 않음을 확인하였다. 따라서 본 논문에는 보다 높은 정확도를 보일것이라고 사료된 다양한 패치 크기를 가지는 U-Net 모델을 연쇄 결합하여 췌장 분할 성능을 향상하는 MCU-Net모델을 제안한다.

Ⅲ. MCU-Net 모델

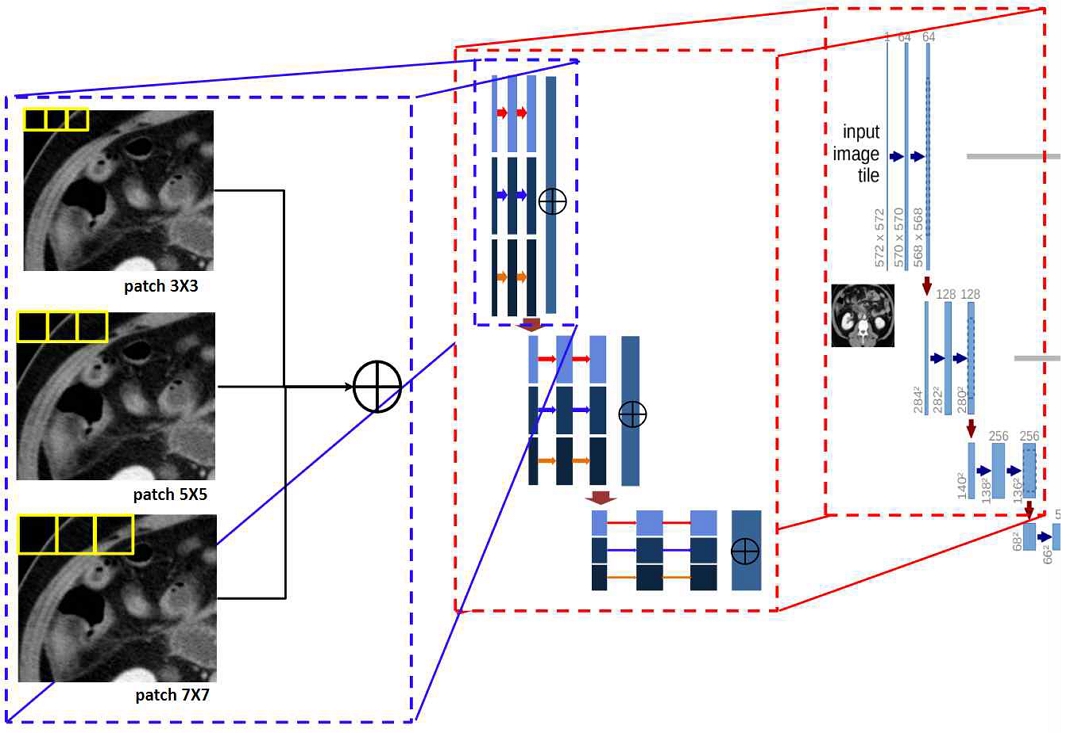

제안하는 MCU-Net 모델은 서로 다른 패치 크기를 가지는 U-Net 모델을 연쇄 결합한 구조이다. 탐색이 끝난 곳을 다시 탐색하는 필터 슬라이딩(Filter-sliding) 기반 특징 탐색 방식과 달리 패치 기반 탐색 방식은 지정된 간격인 스트라이드(Strides)만큼 건너뛰면서 입력데이터를 순회하기 때문에 CNN과 달리 중복된 영역에 대한 특징 탐색을 줄임으로써 학습 속도의 향상을 가져왔다. 그러나 패치 기반탐색 방식은 스트라이드만큼 건너뛰며 탐색하기 때문에 맥락 정보 손실이 일어나게 되는데 이를 보완하기 위해서 본 논문에서는 Faster-RCNN[10] 모델의 anchor box와 같이, 다양한 크기의 패치를 갖는 U-Net 모델을 마지막 단계에서 결합함으로써 영상의 특징을 다양한 관점으로부터 추출하여 정보 손실을 줄인다.

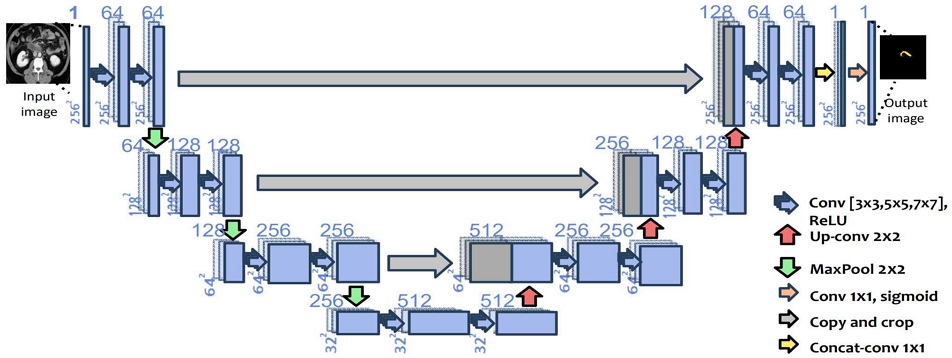

MCU-Net 모델은 그림 1에서 볼 수 있듯 서로 다른 크기의 패치를 가진 U-Net 들을 마지막 단계에서 서로 결합한 후 활성화 함수를 통해 예측된 값을 출력한다. MCU-Net 모델은 다양한 패치 크기에 의한 결괏값을 동시에 고려했기 때문에 단일 패치 모델인 U-Net에 비해 더 많은 context 정보를 얻는다. MCU-Net 모델은 입력 이미지 I를 패치 크기가 서로 다른 n개의 U-Net 중 i번째 U-Net인 Li을 통해 특징 벡터를 입력으로 사용하고 이러한 특징 벡터들을 연결한 특징 벡터인 U를 통해 전체 영상 중에서 췌장 영역을 탐지하여 결과 이미지인 O를 출력한다. 추출한 특징들이 결합된 U는 식 (1)과 같이 나타낼 수 있으며, U를 통해 탐지한 췌장 영역은 활성화 함수인 Softmax를 통해 결과 이미지 O를 출력한다.

| (1) |

그림 2는 본 논문에서 제안하는 MCU-Net 모델에서 패치 크기가 각각 (3,3), (5,5), (7,7)인 U-Net 3개를 결합한 구조를 보여주고 있다. 각 컨볼루션(Convolution)에서는 ReLU 활성화 함수 사용했으며, 수축 경로에서는 2x2 max pooling을 사용했다. 매 계층을 내려갈 때마다 down sampling을 하여 채널 개수를 2배씩 늘렸다. 확장 경로에선 수축 경로 과정에서 줄어든 크기를 다시 키워야 하므로 2x2 up-convolution이 사용했고, 채널 개수는 반으로 줄였다. 회색 계층은 특징맵(Feature map)의 복사본을 의미한다. 해당 구조에서 마지막 계층에선 각 U-Net들을 256x256x1로 1x1 convolution하고 이를 연쇄 결합한다. 채널 개수는 진행된 U-Net의 개수인데, 여기에서는 패치 크기가 다른 3개의 U-Net을 연결했기 때문에 채널 개수는 3이 된다.

손실 함수로는 다이스 계수(Dice coefficient)를 사용했다. 다이스 계수는 예측 영역과 실제 영역이 얼마나 일치하는지 그 비율을 나타내는 지표로써 예측 영역 X와 실제 영역 Y가 일치할수록 1에 가까운 값이 출력되고, 예측 영역이 실제 영역과 일치하지 않을수록 0에 가까운 값이 출력된다. 따라서 다이스 계수가 0이면 전혀 일치하지 않는다는 의미이고, 계수가 1이면 완전히 일치한다는 뜻이다.

IV. 실 험

실험에서는 췌장 분할에서 널리 사용되는 Pancreas-CT set [11]을 이용해 모델 학습 및 평가를 진행하였으며, 모델의 구조 변화에 따른 정확도를 정략적으로 평가하기 위해서 해당 데이터 셋을 사용하였다. Pancreas-CT set은 NIH(National Institutes of Health Clinical Center)에서 공개되었으며, 총 82개의 3D 복부 Pancreas CT scans 이미지로 이루어져 있다.

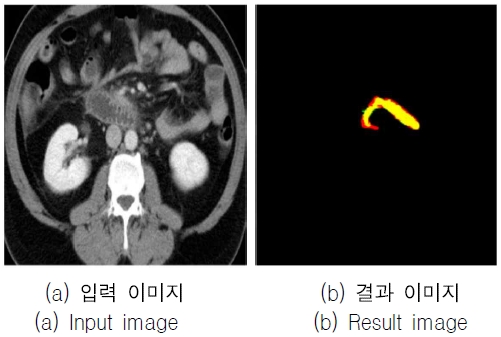

그림 3은 실험에 사용된 이미지 중 하나를 발췌한 것이며, 피실험자의 구성은 53명의 남성과 27명의 여성으로 구성되며, 연령은 18~76세까지 다양하다. 영상의 해상도 및 크기는 512x512 픽셀 크기이며 이미지 간 두께 차이는 1.5mm~2.5mm이다. 데이터 크기는 총 10.2GB이며 이미지 개수는 총 19,328장이다.

본 논문에서는 이 set을 4개의 부분 집합(Fold)으로 나누어 교차 검증했으며, 학습 데이터를 부분적으로 나누어서 Fold 방법을 활용한 학습을 진행하여 학습 과정에 검증 데이터를 사용함으로써 효과적인 학습을 진행하였다. 학습 모델 구현은 U-net 기반 모델[12]을 위한 코드를 기반으로 하였다. 실험에 사용된 Python 버전은 2.7.12이며, 모델은 Python 기반의 딥러닝 라이브러리인 Tensorflow(ver. 2.1.0), Keras(ver. 2.0.8)을 사용하여 구현했고, RAM 16GB와 그래픽카드 Geforce GTX 2080ti가 설치된 Ubuntu 16.04 LTS에서 실험을 수행하였다. 그 외 부가적인 라이브러리로는 numpy(ver. 1.14이상), pandas, matplotlib 등이 있다. 실험에 사용된 하이퍼 파라미터의 경우, 학습 반복 횟수(Epoch)는 10, 학습율(Learning rate)는 1e-5, 최적화 함수는 Adam을 사용하였다.

표 1은 실험 환경을 종합하여 나타낸 표이다. 실험은 앙상블, 패치 크기의 변화를 적용한 정략적인 성능을 파악하기 위해 고정된 초매개변수를 사용하였으며, 제안하는 방법에서는 Epoch을 10 이상으로 진행할 경우 과적합(Overfitting) 현상이 나타나 10까지만 학습하였다. 그리고 학습율은 1e-5에게 가장 좋은 성능을 보였다. 마지막으로 다른 초매개변수는 딥러닝 학습에서 널리 사용되는 값을 차용하여 사용하였다.

표 2는 U-Net 모델을 기반으로 여러 변경을 추가한 경우의 정량적 성능을 나타내고 있다. 제안하는 MCU-Net 모델은 U-Net의 패치를 결합하는 것과 앙상블을 중점으로 U-Net을 변형하여 다방면으로 실험을 진행하였고, 이러한 실험의 결과 분석에 정확도를 가장 중요한 기준으로 생각하여 실험을 진행하였다. 표에서 M1 모델은 기존에 설계되어 있던 U-Net 기반의 모델을 췌장 분류에 접합시킨 U-Net 모델[13]이고 M2 모델은 패치 크기가 같은 2개의 U-Net을 앙상블한 모델이다. M2 모델에서 패치 크기를 통일시키지 않을 경우 Training case에서 약 83%정도로 기존 모델에 비해 정확도가 3%정도 낮게 나왔으며, Test case에선 측정이 불가능할 정도로 정확도가 낮아진다. 따라서 M2 모델에서는 앙상블 성능을 높이기 위해 패치 크기를 (3,3)로 통일시켰다. M3 모델은 3개의 U-Net을 앙상블한 모델이고 패치 크기는 모두 (3,3)이다. M4 모델은 2개의 U-Net으로 구성된 다중 연쇄 U-Net 모델로써 각각의 패치 크기는 (3,3), (5,5)이다. M5 모델의 경우 총 3개의 U-Net으로 구성된 다중 연쇄 U-net모델로써 각각의 패치 크기는 (3,3), (5,5), (7,7)이다. 학습 속도를 비교해 보면 M1이 가장 빠르고 M2, M4가 그 다음으로 빠르다. 마지막으로 M3와 M5가 가장 느리다. 이는 얼마나 많은 모델들을 통합하는가에 의해 결정된 것으로 패치 크기에 따른 모델의 개수가 많을수록 학습 속도는 다소 늘어난다.

표에서 알 수 있듯이 부분 집합에 따라서 학습의 정확도의 차이가 발생할 수 있음을 보인다. 앙상블을 적용한 M3 모델의 경우 큰 정확도의 향상은 없었으며, 첫 번째 fold에서는 오히려 정확도가 낮아졌다. 이에 반해 본 논문에서 제안하는 M5 모델은 모든 부분 집합에 대해서 정확도가 높아진 것을 확인할 수 있다.

표 3에서 Attention U-Net, RSTN의 정확도가 U-Net 보다 낮은 성능을 보이는 데, 본 연구에서의 실험은 제한된 환경에서 진행되었기에 초매개변수의 영향으로 인해 최고의 성능을 나타내지는 않은 것으로 분석된다. 또한 표 3은 선행 연구들과 제안하는 MCU-Net 모델에 대한 췌장 분할 성능을 비교하여 나타낸 실험 결과이다. 비교 대상 연구로 Recurrent Saliency Transformation Network 모델, U-Net 모델, Attention U-Net 모델을 췌장 분할에 적용하여 그 성능을 측정하였다.

실험에서 Attention U-Net보다 제안하는 방법이 성능이 더 나은 이유는 Attention U-Net이 단일 크기의 패치를 하나 사용하는 반면 제안하는 방법은 서로 다른 패치 크기를 가지는 U-Net 모델의 결과값을 마지막 단계에서 연쇄 병합하여 다양한 결과를 취합했기 때문으로 분석된다. 실험 결과에서 알 수 있듯이 본 논문에서 제안하는 MCU-Net 모델이 다른 선행 연구들에 비해 가장 좋은 성능을 보여 주었다. 학습 속도를 비교해 보면 Attention U-Net 모델과 U-Net 모델이 가장 높았고, 그 다음으로 제안하는 MCU-Net 모델의 학습 속도가 높았다. 마지막으로 RSTN 모델의 학습 속도가 가장 낮았으며, 정량적 비교는 향후 연구를 통해 진행할 예정입니다.

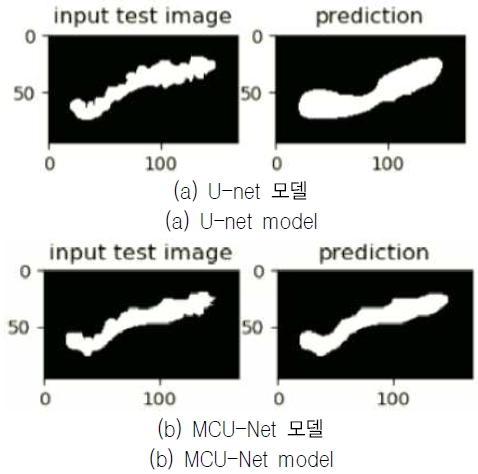

그림 4는 U-net과 MCU-Net 모델의 결과를 이미지를 통해 정성적으로 보여 주고 있다. 이를 통해 제안하는 MCU-Net 모델이 기존 U-net 모델에 비해 췌장 영역을 더 잘 분할함을 눈으로 확인할 수 있다. 그림 4의 이미지는 각 모델에서의 결과 중 가장 잘 나온 것이라고 생각되는 이미지를 정성적으로 표현한 것이며, 모델의 정확도는 표 3의 DSC 수치를 기준으로 하였다.

Ⅴ. 결 론

본 논문은 영상에서 췌장을 분할하기 위해 패치 크기가 서로 다른 U-Net 구조를 결합한 MCU-Net 모델을 제안하였다. 제안하는 모델의 정확도는 그림 3, 표 3을 통해 알 수 있듯 정성적, 정량적으로 알 수 있으며, 약 91.6%로 다른 학습 모델들보다 높은 성능을 보였다. 췌장은 장기 중에서도 특히 탐지난이도가 높다. 따라서 MCU-Net은 췌장뿐만 아니라 다른 장기의 분류 문제에서도 좋은 결과를 보일 것이라 예상된다.

향후 연구로는 U-Net이 아닌 다른 모델에 다중 결합을 적용했을 때 더욱 성능이 나아질 수 있는 분야가 무엇인지 찾고 그 결과를 정량적으로 분석해 볼 예정이다.

Acknowledgments

본 연구는 경기도의 경기도 지역협력연구센터 사업의 일환으로 수행하였음. [GRRC경기2020-B04, 영상 및 네트워크 기반 지능정보 제조 서비스 연구]

References

-

M. Z. Alom, M. Hasan, C. Yakopcic, T. M. Taha, and V. K. Asari, "Recurrent Residual Convolutional Neural Network based on U-Net (R2U-Net) for Medical Image Segmentation", arXiv preprint arXiv:1802.06955, , 2018.

[https://doi.org/10.1109/NAECON.2018.8556686]

- L. Li, M. Verma, Y. Nakashima, H. Nagahara, and R. Kawasaki, "IterNet: Retinal Image Segmentation Utilizing Structural Redundancy in Vessel Networks", IEEE/CVF Winter Conference on Applications of Computer Vision, pp. 3656-3665, 2020.

-

O. Ronneberger, P. Fischer, and T. Brox, "U-net: Convolutional Networks for Biomedical Image Segmentation", International Conference on Medical Image Computing and Computer-Assisted Intervention, 2015.

[https://doi.org/10.1007/978-3-319-24574-4_28]

- O. Oktay, J. Schlemper, L. L. Folgoc, M. Lee, M. Heinrich, K. Misawa, and D. Rueckert, "Attention U-net: Learning Where to Look for the Pancreas", arXiv preprint arXiv:1804.03999, , 2018.

- Q. Yu, L. Xie, Y. Wang, Y. Zhou, E. K. Fishman, and A. L. Yuille, "Recurrent Saliency Transformation Network: Incorporating Multi-stage Visual Cues for Small Organ Segmentation", IEEE Conference on Computer Vision and Pattern Recognition, 2018.

- Y. Liu and S. Liu, "U-net for Pancreas Segmentation in Abdominal CT Scans", IEEE International Symposium on Biomedical Imaging, 2018.

-

R. Wolz, C. Chu, K. Misawa, M. Fujiwara, K. Mori, and D. Rueckert, "Automated Abdominal Multi-organ Segmentation with Subject-specific Atlas Generation", IEEE Transactions on Medical Imaging, Vol. 32, No. 9, 2013.

[https://doi.org/10.1109/TMI.2013.2265805]

-

M. Oda, N. Shimizu, H. R. Roth, K. I. Karasawa, T. Kitasaka, K. Misawa, and K. Mori, "3D FCN Feature Driven Regression Forest-based Pancreas Localization and Segmentation", In Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support, pp. 222-230, 2017.

[https://doi.org/10.1007/978-3-319-67558-9_26]

- Changgeon Lee, Iljoo Kim, A method for predicting the future state of fluids using Attention U-Net neural networks, Vol. 37, No. 3, pp. 3-15, 2021.

- S. Ren, K. He, R. Girshick, and J. Sun, "Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks", Advances in neural information processing systems, Vol. 28. 2015.

- H. Roth, A. Farag, E. B. Turkbey, L. Lu, J. Liu, and R. M. Summers, "Data from Pancreas-CT", The Cancer Imaging Archive, 2016.

- https://github.com/snapfinger/pancreas-seg

- Y. Liu and S. Liu, "U-Net for Pancreas Segmentation in Abdominal CT Scans", IEEE international symposium on biomedical imaging, 2018.

- https://github.com/twni2016/OrganSegRSTN_PyTorch

2022년 2월 : 경기대학교 컴퓨터공학부

2022년 3월 ~ 현재 : 경기대학교 컴퓨터과학과 석사과정

관심분야 : 인공지능/머신러닝, Computer Vision, 네트워크, 통신시스템

2021년 2월 : 경기대학교 컴퓨터과학과

2021년 3월 : 경기대학교 컴퓨터과학과 석사과정

관심분야 : 인공지능/머신러닝, Medical, 네트워크, 통신시스템

1997년 2월 : 서강대학교 컴퓨터과학과

2000년 3월 : KAIST 전산학과(공학석사)

2005년 3월 : KAIST 전산학과(공학박사)

2007년 2월 : 삼성전자 통신연구소 책임연구원

2007년 3월 ~ 현재 : 경기대학교 컴퓨터공학부 교수

관심분야 : 통신시스템, 네트워크