이종 객체 검출과 중복 라벨링 방식을 활용한 데이터 자동생성 및 객체 인식률 개선 연구

초록

현재 화재와 같이 데이터 수집이 제한된 특수한 경우에는 직접 데이터를 수집하거나, 데이터 증강 방식 등을 활용하여 데이터를 수집한다. 그리고 수집한 데이터는 수작업으로 라벨링을 진행하고 있다. 본 논문에서는 이를 개선하기 위해 CCTV나 동영상을 통하여 인식된 화재 데이터를 이종 객체 검출 및 Fine-tuning 방식을 활용하여 자동 라벨링 한 후 학습까지 자동 진행하게 하였다. 그리고 인식률 개선을 위해서는 중복적 라벨링을 적용한 통합 학습 방식과 객체 검출 IOU의 차이를 이용한 이미지 데이터의 선별적 적용 방식을 적용하였다. 그 결과 자동 데이터 생성은 초기 데이터 5,565개에서 10,885개로 약 95% 정도 화재 데이터가 증가하였으며, 인식률은 mAP@0.5 기준으로 64.9%에서 77.3%로 약 12.4% 정도의 개선된 결과를 얻었다.

Abstract

Currently, in special cases where data collection is limited, such as fire, fire data is collected directly or data is collected using a data augmentation method. And the collected data is being manually labeled. In order to improve this, this paper automatically labels fire data recognized through CCTV or video using heterogeneous object detection and fine-tuning methods, and then automatically proceeds to training. In addition, in order to improve the recognition rate, an integrated learning method with overlapping labeling and a selective application method of image data using the difference in object detection IOU were applied. As a result, automatic data generation increased by about 95% from 5,565 to 10,885, and the recognition rate was improved by about 12.4% from 64.9% to 77.3% based on mAP@0.5.

Keywords:

CNN, deep learning, darknet, deepStreamⅠ. 서 론

딥러닝 기술은 이미 보편화된 기술이 되었다. AI에 관심이 있는 사람이라면 자신의 어플리케이션을 딥러닝 모델을 사용해 여러 기능을 넣을 수 있다. 그러나 딥러닝 인식률 향상을 위해서는 반드시 빅 데이터가 필요한데 화재, 연기, 불꽃과 같이 공개된 데이터가 제한된 사항에서는 직접 화재 시험을 재현하거나 데이터 증강을 통하여 데이터를 확보할 수밖에 없다. 그리고 수집된 데이터를 라벨링 하는 작업 또한 많은 시간과 인력이 필요하다. 이런 조건으로 학습된 AI는 실제 시장에 바로 적용하면, 랩 환경과 달리 많은 오검출과 미검출이 있어 실제 시장 상황에 맞게 재학습을 위한 추가 데이터 확보가 요구된다.

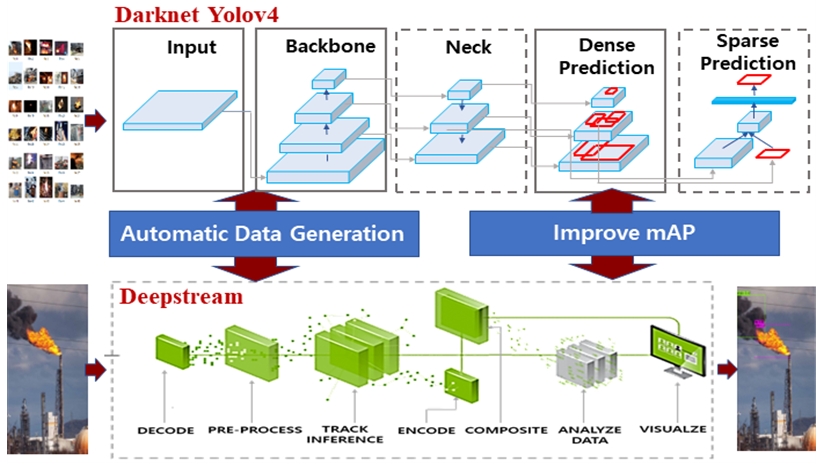

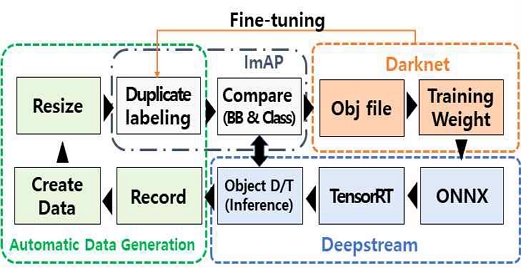

이를 개선하기 위해 정부에서는 AIhub 구축 사업을 통하여 AI 학습에 필요한 다양한 데이터를 제공하고 있다[1]. 하지만 이 데이터 역시 일정 수준까지는 빠른 접근이 가능하나 현장 대응을 위해서는 오검출, 미인식에 대한 문제는 여전히 개발자의 몫으로 남아있다. 그래서 본 논문에서는 이종 객체 검출 및 중복 라벨링 방식을 적용하여 자동 데이터 생성 및 인식률 개선을 위한 방안을 제안한다. CCTV를 통하여 인식된 화재에 대하여 자동 라벨링 이후 학습까지 완료되며, 인식률 개선을 위해서는 DeepStream[2]의 객체 인식 mIOU와 Class를 Darknet[3]과 비교하여 차이가 있는 경우에 데이터를 확보하고 재학습을 진행하게 하였다. 그림 1은 이종 객체 검출 기반 자동 데이터 생성 개념도이다.

Ⅱ. 관련 이론

2.1 DeepStream 이해

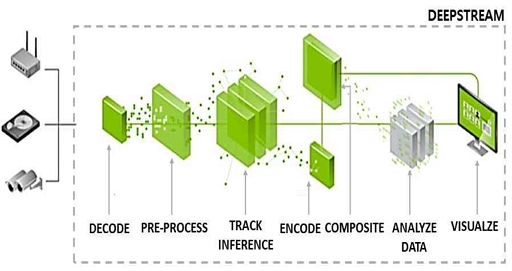

DeepStream은 영상분석에서 딥러닝 분석이 가능하도록 NVIDIA에서 제작한 스트리밍 분석 툴킷으로 Pipeline 기반 공개 오픈소스 멀티미디어 프레임워크이다. DeepStream의 특징은 NVIDIA Jetson 플랫폼이나 GPU 환경에서 실행되며 스트리밍 데이터(USB 카메라, 동영상 파일, RTSP 지원 CCTV) 등을 입력으로 사용하며 다양한 비디오 분석 솔루션의 기반으로 사용하고 있다[2].

특히 GPU 가속을 통해 GPU 사용량을 극대화하여 한 개의 GPU로 여러 카메라를 실시간으로 동영상 프레임 처리 및 분류가 가능하다. 본 연구에서는 다중 카메라 추론용으로 사용되면서, 동시에 여러 대의 카메라를 이용하여 화재 객체 탐지용으로 사용되는 DeepStream을 활용하여 시험을 진행하였다. DeepStream은 라이브러리를 추상화하여 개발자가 모든 개별 라이브러리를 배울 필요 없이 쉽게 비디오 분석 파이프라인을 구축할 수 있도록 한다[2].

PyTorch 및 TensorFlow와 같은 기본 프레임워크에 모델을 배포하거나 다중 GPU, 다중 스트림 및 일괄 처리 지원 옵션과 함께 높은 처리량의 추론을 위해 NVIDIA TensorRT를 사용하여 최상의 성능 달성할 수 있다. 하지만 인식률은 여러 카메라를 실시간 스트리밍을 구현하다 보니 Darknet보다 떨어진다. 그림 2에는 DeepStream SDK의 기본 구조를 표시하였다.

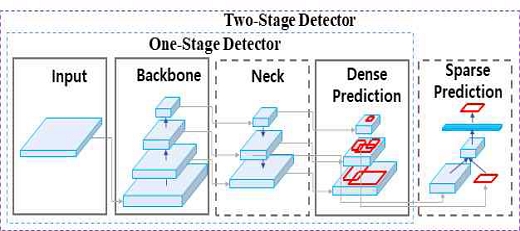

2.2 Darknet Yolov4

Darknet은 Joseph Redmon이 독자적으로 개발한 신경망 프레임워크(Neural network framework)로서 DNN(Deep Neural Network)들을 학습시키고 실행시킬 수 있는 프레임워크다[3][4]. C, Python으로 작성된 오픈 소스로 연산이 빠르고 CPU 및 GPU 연산을 지원한다[5]. Yolov4는 지금까지 Yolo 1~3가 실시간 물체 검출보다는 대부분 권장 시스템으로 활용되고 있어 이를 해결하고자 개발되었으며, 실시간 객체 검출을 Single GPU로도 가능하게끔 설계하였다. 이때 백본으로 CSPDarknet53을 사용하였으며 최근 학계에서 발표된 여러 기술들을 테스트하여보고 최상의 성능이 나오는 것을 적용하였다.

BOF(Back od Freebies)와 BOS(Back of Specials)가 대표적이다. BOF는 전처리 및 학습 단계에서 학습 효율이 증가하는 것을 말하며, BOS는 후처리 공정 및 추론에서 효율이 높아지는 것을 말한다. 그리고 추가된 새로운 아이디어로는 네 개의 학습 이미지를 섞는 독자적인 Data augmentation 방법인 Mosaic, CmBN은 CBN을 변형시킨 버전으로 Cross mini-Batch Normalization을 의미한다. SAM에서 Spatial-wise attention을 Point-wise attention으로 변형한 것이며, PAN에서 Shortcut connection을 concatenation으로 대체하는 방식을 제안하였다[6]. 그림 3에는 Darknet Yolov4의 동작 방식을 표시하였다.

2.3 데이터 증강

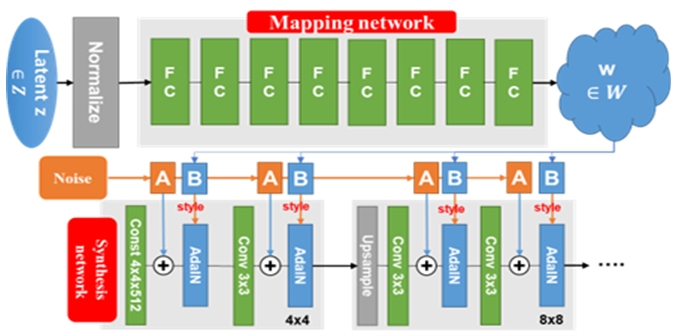

딥러닝 모델 학습을 위해 필요한 데이터를 확보하기 위한 여러 기법의 하나인 데이터 증강 기법은 소량의 학습 데이터에 인위적인 변화를 주어 새로운 학습 데이터를 대량 확보하는 방식을 의미한다. 현재는 서로 다른 이미지 데이터를 서로 겹치게 하거나, 상하좌우로 뒤집거나, 필요한 부분을 자르는 방식으로 새로운 영상 데이터를 확보하는 데이터 리샘플링 방법이 주로 사용되고 있다[7].

최근 발표된 논문 중에는 이미지를 합성/생성할 수 있는 GAN 기법을 통해 존재하지 않는 데이터를 새로 재생성된 이미지를 활용하여 딥러닝 모델을 학습함으로써 다량의 학습데이터를 확보하며, 기존 데이터 증강과는 달리 학습 데이터의 분포 영역을 크게 확장하여 소규모 데이터만으로 모델의 정확도를 향상하는 DA-FSL(Data Augmentation based Few-Shot Learning) 기법까지 발전하였다[7]. 그림 4는 DA-FSL 작동 방식을 도식화하였다.

Ⅲ. 제안한 방법

3.1 이종 객체 검출

본 연구는 Deepstream yolov4와 Darknet yolov4의 객체 검출의 정확도 차이에서 연구가 시작되었다. Darknet yolov4는 DarkNet53을 백본(Backbone)으로 사용하며, C로 프로그램 되었기 때문에 속도가 빠르고 CPU, GPU를 모두 지원하도록 구성되어 있다[6].

하지만 데이터 세트를 학습시킬 때는 GPU를 사용할 정도로 무거운 알고리즘이다. 반면 최신 학계의 우수한 딥러닝 기법을 적극적으로 활용하여 모델을 설계하고, 학습시켜 정확도와 속도 측면에서 성능을 크게 끌어올렸다[8]. Deepstream yolov4의 경우는 NVIDIA DeepStream 5.0에 Yolo-v4를 설치하고 사용하는 것으로 다채널 RTSP 스트리밍을 활용하여도 화면의 끊김이나 딜레이 없이 동시에 다채널 객체 검출이 가능하다. 하지만 객체 검출 성능은 Darknet보다는 객체 인식 부분에서 떨어지는 게 사실이다. 반면 Darknet은 객체 검출 면에서는 성능이 좋으나 한 개 RTSP 카메라 동영상만 적용하여도 간혹 화면 딜레이가 발생한다[9]. 그래서 그림 4와 같이 Darknet yolov4에서는 초기 데이터로 학습만을 진행하고, Deepstream yolov4에서는 학습 결과 값인 Weight를 활용하여 객체 검출 추론을 진행한다. 화재와 같이 학습 데이터가 절대적으로 부족한 경우에는 1만 장 이상의 데이터를 라벨링 하는 것도 많은 시간과 인력을 필요로 한다. 설사 라벨링이 완료되어도 학습 후 객체 검출 추론 결과는 현장에 따라 다른 경우가 많아, 이를 보완하고자 그림 5와 같이 이종 객체 검출 방식을 제안한다.

3.2 자동 데이터 생성(Automatic data generation)

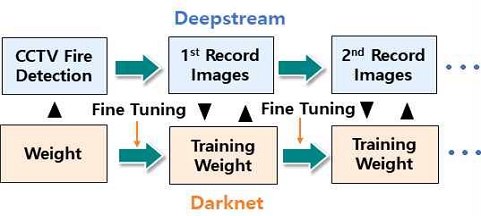

그림 6에는 자동 데이터 생성 계층 구조를 도식화했다. Darknet에서 학습으로 생성된 초기 Weight 값을 활용하여 Deepstream 추론에 사용하며, Fine-tuning을 통하여 추가 생성된 Weight값을 이용하여 Deepstream에서 화재로 검출된 녹화 동영상에 대하여 라벨링 및 재학습용으로 사용한다. 이렇게 초기 Weight 값을 바로 활용하지 않고 Fine-tuning 값을 활용하는 이유는 Deepstream과 Darknet 인식률의 차이를 좀 더 크게 두어 보다 향상된 객체 검출 및 라벨링에 활용하기 위해서이다[10].

그리고 1차 라벨링 및 학습이 완료되면, 1차 Weight 값을 활용하여 Deepstream 추론에 적용한다. 이렇게 개선된 추론 결과를 이용하여 추가 화재 검출 시 1차 대비 향상된 화재 검출이 가능하게 된다.

Darknet은 weight 값의 성능 향상을 위하여 2차 Fine-tuning을 진행하며, 추가 생성된 Weight를 활용하여 Deepstream에서 화재로 검출된 2차 녹화 동영상에 대하여 라벨링 및 재학습용으로 활용된다. 이렇게 생성된 추가 Weight를 활용하여 3, 4차를 반복하면 원하는 다양한 화재(특수 환경) 데이터를 자동 생성으로 데이터 수집이 가능하게 된다. 그리고 학습까지 자동으로 이루어져 바로 현장 적용이 가능한 수준까지 계속 진화한다.

3.3 인식률 개선(Improve mAP)

ADG(Automatic data generation)를 활용하여 데이터 생성이 자동으로 이루어진 이후 가장 중요한 이슈는 오동작이다. 이를 개선하기 위하여 다음 2가지 방법을 제안한다. 첫째는 중복적 라벨링을 적용한 통합 학습 방식이며, 둘째는 객체 검출 IOU의 차이를 이용한 이미지 데이터의 선별적 적용이다[11].

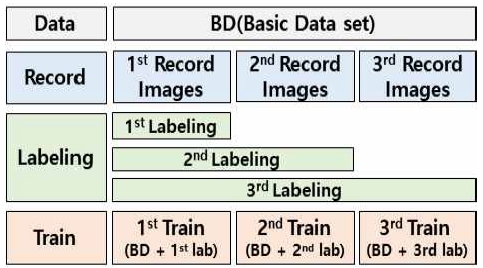

그림 7에는 중복적 라벨링을 적용한 통합 학습 방식을 도식화하였다. Deepstream에서 검출된 화재 데이터에 대한 녹화된 동영상을 이미지 라벨링 처리 시 BD(Basic Data)를 제외한 신규 생성 라벨은 항상 최종 학습된 Weight를 이용하여 전체를 재 Labeling 한 후 BD와 같이 학습하는 방식이다. 이렇게 하면 항상 최종 학습된 Weight 값이 전체 라벨링에 적용되어 객체 인식률 향상에 도움이 된다. BD를 재 라벨링에 추가하지 않은 이유는 개발자가 직접 라벨링과 Class를 적용하였으므로 오인식이 없다고 가정을 하고 이를 적용하지 않았다.

둘째, 객체 검출 IOU의 차이를 이용한 이미지 데이터의 선별적 적용으로 화재 오탐률 개선 목적으로 적용된다. Deepstream에서 인식한 BB(Bounding Box)와 Class를 Darknet을 기준으로 BB의 IOU 및 Class를 서로 비교하여 적용하는 방식이다[12]. Darknet의 Class나 IOU가 Deepstream의 Class와 IOU가 차이가 나는 경우에만 데이터로 활용하는 것이 특징이다. 객체 검출 IOU의 차이를 이용한 이미지 데이터의 선별적 적용은 데이터가 어느 정도 확보 가 이루어진 이후 오인식 방지를 위한 시스템 안정화 목적으로 활용하는 선택적 기술이다.

Ⅳ. 실험 방법 및 결과

이종 객체 검출과 중복 라벨링 방식을 활용한 데이터 자동 생성 및 객체 인식률 개선 실험은 CPU: AMD Ryzen 7 3700X 8-Core Processor 3.6 GHz, GPU: NVIDIA GeForce RTX 8000TI, RAM 32GB 컴퓨터 환경에서 실험을 진행하였다[8]. 초기 데이터 세트는 표 1에 표시된 것과 같이 Kaggle, 인터넷 및 자체 DA-FSL 방식을 통한 증강 방식 등을 통하여 화재, 연기, 불꽃 이미지 데이트 세트를 확보하였다.

초기 라벨링 및 학습이 완료된 화재 데이터를 기준으로 1, 2차에 걸쳐 이종 객체 검출 및 중복 라벨링 방식을 적용하여 표 2와 같이 3가지 조건으로 비교 실험하였다.

결과는 표 2, 표 3에 각기 표시하였다. 테스트 결과 초기 데이터 대비 Loss는 1.60% 감소하였으며, mIOU는 14.19% 증가하였고, mAP@0.5는 12.3% 초기 데이터 대비 개선된 결과를 얻었다. 이 결과치는 Fine-tuning 기준이며, Train은 기존 Weight 값을 학습한 결과이며, Fine-tuning은 Train Weight 값을 한 번 더 학습한 결과치이다[11].

그리고 표 3에는 이종 객체 검출 방식을 활용한 데이터 자동 생성 결과인 데이터 증가 수량을 표시하였다. 실험 결과, max_batches = 80,000 기준으로 초기 5,565개 대비 95% 정도 증가한 10,895개를 획득한 결과를 얻었다.

표 4에는 초기 학습 결과에 따라 라벨링이 완료된 화재 데이터를 기준으로 1, 2차에 걸쳐 이종 객체 검출 및 중복 라벨링 방식이 적용된 데이터 BB (Bounding Box)와 Class 성능 향상을 테스트한 결과를 표시하였다.

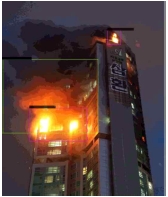

표 5에는 초기 학습 데이터 세트 기준으로 자동 데이터 생성 이후 1차 학습 결과 및 2차 학습 결과에 따른 Class 및 라벨링 변화를 포인트별 주요 성능 차이를 그림으로 표시하였다. image_2에서 BD 학습 시에는 연기와 불이 모두 연기로 라벨링 되었고, 1차 학습에서는 연기와 연기+불을 연기로 2번 라벨링 되었으며, 2차 학습에서는 연기만을 정확히 라벨링 하였다. 다만 불에 대해서는 BD 학습 시는 2개의 불을 모두 라벨링 하지만 1, 2차 학습에서는 큰불 하나만 라벨링 하였다. Image_5에서는 BD 학습 시에는 화재만 정확히 BB하고 연기에 대해서는 라벨링이 이루어지지 않았다. 반면에 1차 학습에서는 연기와 하늘을 같이 라벨링이 되었으며, 2차 학습에서는 연기와 불을 정확히 구분하여 라벨링이 이루어 진 것을 볼 수 있다. Image_7에서 BD 학습 시에는 우측 위의 어두운 부분을 연기로 인식했지만, 1차 학습에서는 연기를 우측 아랫부분만 정확히 인식하였다. 반면에 좌상단의 불을 중복 라벨링 하였다. 2차 학습에서는 연기와 불을 모두 정확히 라벨링 하였으며, BD와 1차 학습에서는 중앙 아래 화재를 인식했지만 2차 학습에서는 중앙 부분을 화재로 인식하였다.

참고로 테스트에 활용된 이미지들은 학습을 진행하지 않은 일반 이미지를 인터넷에서 무작위로 선정하여 실험한 결과이다. 실험은 여러 이미지 중 7가지 이미지만을 테스트한 결과를 표시하였다. 그리고 초기 학습 데이터 세트 대비 class는 큰 변화가 없으나 BB의 크기와 위치 등은 많은 차이를 보인다. 자세한 내용은 표 5에 표시하였다.

Ⅴ. 결 론

본 논문에서는 화재와 같이 데이터 수집이 어려운 특수한 환경에서의 이미지 데이터 획득과 라벨링의 어려움을 해결하고자 이종 객체 검출(Darknet, Deepstream 활용)과 중복 라벨링 방식을 적용한 데이터 자동 생성 및 객체 인식률 성능 향상 알고리즘을 제안하였다. 실험 결과 데이터 자동 생성 방식을 통하여 기존 초기 데이터 수량 5,565개 대비해서 10,885개로 약 95% 정도 자동 생성되었으며, 중복적 라벨링을 적용한 통합 학습 방식을 통하여 mAP@0.5는 기존 64.9%에서 77.3%로 약 12.4% 정도의 개선된 연구 결과를 얻었다. 현재도 계속 학습을 진행 중이며 추가 성과가 나오는 시점에 추가 논문을 발표하도록 하겠다.

Acknowledgments

이 논문은 2017 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No.2017R1D1A1B04030870)

References

- AI Hub data, https://aihub.or.kr, , [accessed: Apr. 10. 2022]

- Nvidia develop : Nvidia Deepstream SDK, https://developer.nvidia.com/deepstream-sdk, , [accessed: Apr. 10. 2022]

- J. Redmon. Darknet: Open source neural networks inc, http://pjreddie.com/darknet/, , 2013-2016, [accessed: Apr. 10. 2022]

- Changjin Koo and Jong-Chan Kim, "Multi-camera Implementation of Darknet YOLO Object Detector", Proceedings of KIISE Conference, pp. 1499-1501, Jun. 2021.

-

W. Jang, H. Jeong, K. Kang, N. Dutt, and J. -C. Kim, "R-TOD: Real-Time Object Detector with Minimized End-to-End Delay for Autonomous Driving", 2020 IEEE Real-Time Systems Symposium (RTSS), pp. 191-204, 2020.

[https://doi.org/10.1109/RTSS49844.2020.00027]

- Alexey Bochkovskiy, Chien-Yao Wang, Hong-Yuan, and Mark Liao, "YOLOv4: Optimal Speed and Accuracy of Object Detection", Computer Vision and Pattern Recognition (cs.CV), arXiv: 2004. 10934, , Apr. 2020.

-

Hye-Youn Lim, Jun-Mock Lee, and Dae-Seong Kang, "A Method for Improving Learning Convergence Curve and Learning Time of DA-FSL Model using Knowledge Distillation", The Journal of Korean Institute of Information Technology 18, pp. 25-32, Oct. 2020.

[https://doi.org/10.14801/jkiit.2020.18.10.25]

-

Jong-Sik Kim and Dae-Seong Kang, "A Study of Real-time Semantic Segmentation Performance Improvement Using Three-pathway mDAPPM", The Journal of Korean Institute of Information Technology 19, pp. 9-17, Jul. 2021.

[https://doi.org/10.14801/jkiit.2021.19.7.9]

-

Changqian Yu, Changxin Gao, Jingbo Wang, Gang Yu, Chunhua Shen, and Nong Sang, "BiSeNet V2: Bilateral Network with Guided Aggregation for Real-time Semantic Segmentation", Computer Vision and Pattern Recognition (cs.CV), https://arxiv.org/abs/2004.02147, , Apr. 2020. Recognition, pp. 3051-3068, Sep. 2021.

[https://doi.org/10.1007/s11263-021-01515-2]

-

Simon Kornblith, Jonathon Shlens, and Quoc V. Le, "Do Better ImageNet Models Transfer Better?", Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pp. 2661-2671, Jun. 2019.

[https://doi.org/10.1109/CVPR.2019.00277]

-

Shang-Hua Gao, Ming-Ming Cheng, Kai Zhao, Xin-Yu Zhang, Ming-Hsuan Yang, and Philip Torr, "Res2Net: A New Multi-Scale Backbone Architecture", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 43, pp. 652-662, Aug. 2019.

[https://doi.org/10.1109/TPAMI.2019.2938758]

- Jiwoong Choi, Dayoung Chun, Hyun Kim, and Hyuk-Jae Lee, "Gaussian YOLOv3: An Accurate and Fast Object Detector Using Localization Uncertainty for Autonomous Driving", Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV), pp. 502-511, Sep. 2019.

1991년 2월 : 부경대학교 전자공학과(공학사)

2020년 9월 ~ 현재 : 동아대학교 전자공학과 박사과정

관심분야 : 영상처리, AI

1994년 5월 : Texas A&M 대학교 전자공학과(공학박사)

1995년 ~ 현재 : 동아대학교 전자공학과 교수

관심분야 : 영상처리, AI, 패턴인식