병렬 병합 구조를 이용한 기상 데이터의 예측률 향상을 위한 딥러닝 모델

초록

본 연구는 딥러닝 기본모델인 DNN, LSTM, BiLSTM, 1D-CNN 등으로, 예측의 성능을 향상하기 위해, 중간층을 병렬로 병합하는 구조를 제안하였다. 제안모델 1은 동일한 기본모델을 병렬 병합한 구조이고, 제안모델 2는 서로 다른 모델의 병렬 병합한 구조이다. 각 모델의 평가는 RMSE와 MAE로 10회 실험에 대한 평균값이다. 제안모델 1에서 가장 좋은 예측률을 보인 BiLSTM2의 RMSE는 0.064이다. 제안모델 2의 RMSE는 DC(DNN-CNN), LC(BiLSTM-CNN), DLC(DNN-BiLSTM-CNN) 등 모든 모델이 0.054였다. 이처럼 제안모델 2가 12.8%의 성능 향상을 보였다. 제안모델 2가 서로 다른 모델의 장점을 유지하면서 많은 파라메터로, 예측률을 향상할 수 있게 하는 모델임을 확인할 수 있었다.

Abstract

In this study, using deep learning basic models DNN, LSTM, BiLSTM, and 1D-CNN, to improve prediction performance, we proposed a structure in which hidden layers are merged in parallel. Proposed model 1 is a parallel merging structure of the same basic model, and Proposed model 2 is a parallel merging structure of different models. The evaluation of each model is the average value for 10 experiments with RMSE and MAE. The RMSE of BiLSTM2, which showed the best prediction rate in Proposed Model 1, is 0.064. The RMSE of Proposed Model 2 was 0.054 for all models including DC (DNN-CNN), LC (BiLSTM-CNN), and DLC (DNN-BiLSTM-CNN). As such, Proposed Model 2 showed a performance improvement of 12.8%. It was confirmed that Proposed Model 2 is a model that can improve the prediction rate by using many parameters while maintaining the advantages of different models.

Keywords:

deep neural network, long short term memory, convolution neural network, ResNet, InceptionⅠ. 서 론

딥러닝(Deep learning)은 예측, 분류, 의사결정, 분석, 추론 등 다양한 분야에서 인간의 능력을 능가하는 수준으로 진화하고 있으며, 실세계에 사용할 수 있도록 다양한 모델을 끊임없이 연구 개발하고 있다. 딥러닝은 사람의 두뇌 구조를 모방하여 만든 인공신경망(ANN, Artificial Neural Network)을 기초로 하고 있다. ANN은 입력 데이터의 특성에 따라, 은닉층 수가 많아지거나, 은닉층의 노드 수가 많으면, 활성화 함수와 과적합에 의해 성능이 저하되는 문제점이 있다.

딥러닝은 DNN(Deep Neural Network), LSTM(Long Short Term Memory), CNN(Convolution Neural Network)을 기본으로, 입력 데이터의 특징에 따라 예측 모델을 적용한다[1]-[6]. DNN은 ANN의 깊은 중간층 문제를 해결하여, 중간층을 늘려서 학습결과를 향상하는 딥러닝 기법이다. LSTM은 반복적이고 순차적인 시계열 데이터학습에 특화된 모델이며, 내부에 순환구조가 들어있다는 특징이 있다. DNN과 LSTM은 데이터에서 지식을 추출하는 학습이라면, CNN은 데이터에서 특징을 추출하여, 패턴을 파악하는 구조이다. CNN은 텍스트 데이터에서 특징을 추출하는 1D CNN과 영상 데이터에서 특징을 추출하는 2D CNN이 있다.

본 연구는 신경망의 중간층 깊이를 줄이고, 중간층을 병렬로 구성하여, 중간층 깊이에 의한 예측률이 저하되는 문제점을 최소화하는 방법을 제안한다. 제안모델은 Inception 모델에서 여러개의 네트워크를 병렬로 연결하여, 성능을 향상하는 방법을 응용하였다[7]-[8]. 본 연구는 기본모델, 제안모델 1, 제안모델 2 등 3가지 모델로 실험하였다. 기본모델은 DNN, LSTM, BiLSTM(Bidirectional LSTM), 1D CNN 등이며, 제안모델 1은 기본모델을 병렬로 하여, 학습 파라메터 수를 늘린 구조이다. 제안모델 2는 기본모델과 제안모델 1에서 가장 성능이 우수한 모델로, 서로 다른 모델을 병렬로 연결하여, 학습 파라메터 수를 늘린 구조이다. 제안모델은 모델을 병렬로 구축하기 위해 케라스(Keras)의 함수형 API를 사용하였다,

본 논문은 2장에서 딥러닝 모델과 병렬모델에 관해서 서술하였다. 3장에서 제안모델과 실험방법을 서술하였으며, 4장에서 실험결과 및 성능평가를 하였다. 최종적으로 5장에서 결론 및 향후 과제에 대해서 나타냈다.

Ⅱ. 인공신경망과 딥러닝

2.1 딥러닝 모델

DNN은 입력층, 중간층, 출력층으로 나뉘며, 입력 데이터가 입력층에 입력되며, 3층 이상의 중간층으로 구성되고, 예측된 결과값이 출력층에 출력된다. 또한, 예측된 결과값은 실제값과 오차를 구하고, 역전파(Back-propagation) 알고리즘을 이용해 오차를 줄이는 학습을 하여 예측값이 실제값에 접근한다.

LSTM은 DNN을 병렬로 타임스탬프(Time stamp)만큼 연결한 모델이다. 각 타임스탬프는 DNN과 동일하게 입력층, 중간층, 출력층으로 구분된다. 중간층은 노드의 결과값을 출력층으로 보내면서, 동시에 다음 타임스탬프의 중간층 입력으로 보내는 특징을 갖고 있다. LSTM은 이전에서 학습한 결과를 다음 학습에 이용하기 때문에, 시계열 데이터에 대한 예측에 효과적이다. BiLSTM은 두 개의 LSTM으로 구성된 모델로서, 하나는 입력을 순방향으로, 다른 하나는 역방향으로 진행하면서 학습한다. BiLSTM은 시계열 데이터에서 양방향으로 처리하기 때문에, 사용할 수 있는 정보의 양을 효과적으로 증가시켜, 예측을 개선할 수 있다.

CNN은 영상 분야에 탁월한 성능을 보이는 신경망으로 합성곱층(Convolution layer)과 풀링층(Pooling layer)으로 구성된다. CNN의 대표적인 모델은 LeNet, AlexNet, VGG-16, ResNet, Inception 등이 있다[9]-[14].

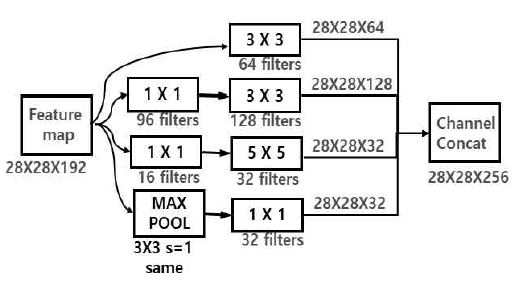

ResNet 모델은 깊은 중간층에 의해, 경사가 소실되거나 증가하는 문제를 해결하기 위하여, 일부 층을 뛰어넘는 shortcut 개념을 이용하였다. Inception 모델은 입력 특성맵을 다양한 커널과 필터 그리고 풀링의 조합으로 출력 특성맵을 생성하는 구조이다. 그림 1에 Inception 모델에 대해서 나타냈다.

그림 1에서 28×28×192의 입력 특성맵에서 1×1, 3×3, 5×5 커널과 다양한 필터의 조합에 의해 128×28×256의 출력 특성맵을 생성하는 모델을 보여준다. Inception은 문제점인 계산 비용을 줄이기 위해, 1×1의 합성곱 연산을 사용하여, 10배 정도의 연산량을 줄일 수 있다.

1D CNN은 자연어 처리에 많이 사용하며, 단어의 임베딩 벡터를 입력으로 하여, 합성곱층 그리고 풀링층으로 구성된다. 임베딩 벡터는 단어의 종류와 의미 그리고 각 단어 간 유사성이 내포된 벡터로서, 벡터 구성은 단어 수와 각 단어에 대한 벡터로 구성된다. 1D 합성곱에서 커널 너비는 임베딩 벡터의 차원과 동일하게 설정되기 때문에, 커널의 높이가 커널의 크기라고 간주한다. 따라서 커널이 2D 합성곱 연산과는 달리 높이 방향으로만 스트라이드(Stride) 한다.

2.2 기본모델과 병렬모델

기본모델은 한 가지 모델로만 구축된 모델이다. 즉, DNN, LSTM, BiLSTM, 1D-CNN으로만 구축하였다. 표 1과 2에 기본모델에 대해서 나타냈다.

모든 기본모델은 기상요소인 10개의 입력으로 하였으며, 출력은 1개의 예측값이다.

DNN1은 4개의 중간층으로 각 레이어에 128개의 노드로 구성하였다. LSTM과 BiLSTM은 중간층을 2층으로 각 층의 노드수는 128개로 하였다.

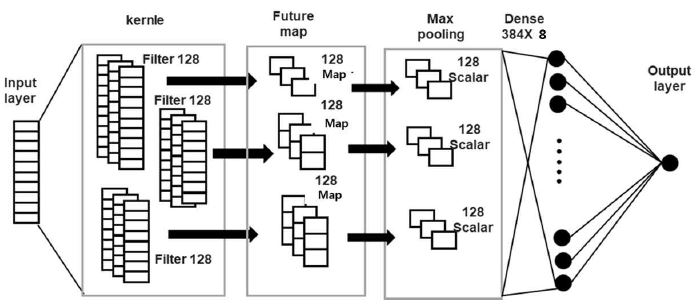

CNN1은 높이가 10이며, 너비가 1인 커널에 대해서, 128개의 필터를 사용하였으며, 풀링층을 거쳐 128개의 스칼라 값이 8개의 노드에 전 결합하고, 최종적으로 1개의 출력층에 전 결합하였다. CNN2는 높이가 8, 9, 10이며, 너비가 1인 커널을 128개의 필터를 이용하며, 풀링층을 거쳐 384개의 스칼라 값이 8개의 노드에 전 결합하고, 최종적으로 1개의 출력층에 전결 합하였다. 그림 2에 CNN2 구조에 대해서 나타냈다.

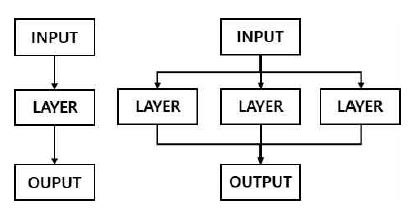

병렬모델은 동일한 모델 또는 서로 다른 모델을 병렬로 층을 구축하는 방법이다. 기본모델은 순차적으로 중간층을 구성하면 되지만, 병렬모델은 각 기본모델로 중간층을 구성하고, 모델의 결과를 연결해야 한다. 그림 3에 기본모델과 병렬모델에 대해서 나타냈다.

기본모델은 기본적으로 중간층을 깊게 하는 경우, ReLU나 시그모이드 활성화 함수에 의해 학습률이 저하된다. 병렬모델은 이러한 단점을 줄이기 위해 중간층을 줄이고 학습을 위한 노드 수를 늘림으로써 더욱 높은 학습효과를 얻을 수 있다.

본 연구에서 기본모델과 병렬모델은 케라스의 함수형 API를 이용하여 구축하였다.

Ⅲ. 제안 예측모델

본 연구는 단기 일사량 예측을 위해, 인공신경망 모델을 병렬로 하여, 성능이 향상된 예측 모델을 제안한다. 일사량 데이터는 서울 기상청의 2017년 1월 1일부터 2019년 12월 31일까지의 시간당 기상정보를 사용하였다. 입력 데이터는 현재시간의 기온, 강수량, 습도, 증기압, 현지기압, 해면기압, 일조량, 적설량, 전운량, 일사량 등 10개의 기상요소이며, 실제 데이터는 다음 시간의 일사량이다. 본 연구에서 사용한 전체 샘플 수는 26280개이다. 실험에 사용한 데이터는 다소 적은 데이터양으로 기본모델로 중간층을 깊게 할 경우, 과적합에 의해 예측률이 감소할 수 있다. 따라서 제안모델은 중간층의 깊이를 낮추고 영상처리 모델인 Inception 모델에서 다수의 커널을 병렬로 연결 개념에 착안하여, 모델의 성능을 향상하는 방법을 제안하였다. 본 연구의 제안모델은 모두 병렬모델이며, 제안모델 1과 제안모델 2로 구성된다.

3.1 제안모델 1

제안모델 1은 기본모델의 중간층을 출이고, 병렬로 연결하여 구축하였다. 즉, DNN, LSTM, BILSTM을 병렬로 연결하여, 결과를 전 결합(Fully Connect)하여 1개의 출력층으로 구성하였다. 표 3에 제안모델 1에 대해서 나타냈다.

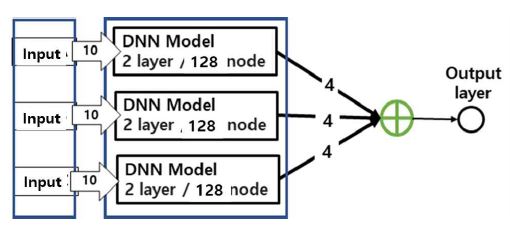

DNN2는 2개의 중간층으로 각 층에 128개의 노드로 구성된 2개의 DNN을 병렬로 구성하였다. 각 DNN은 4개의 출력으로 구성되어 있으며, 출력을 모두 연결하여, 8개로 구성된 노드를 1개의 출력층과 전 결합하였다. DNN3는 DNN2에 병렬로 DNN을 하나 더 추가한 것이다. DNN2와 DNN3은 중간층을 하나 더 추가하여 3층으로 구성된 모델이다. 그림 4에 DNN3의 구조에 대해서 나타냈다.

그림 4에서 DNN3은 동일한 10개의 기상요소가 입력으로 하여 각 모델에서 4개의 출력으로 하였으며, 총 12개의 출력을 연결하여 하나의 출력값으로 구성함을 나타냈다.

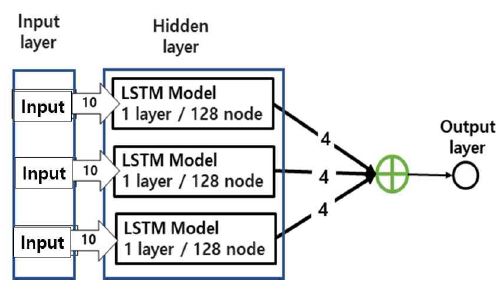

LSTM2는 2개의 LSTM을 병렬로 구성하였다. 각 LSTM은 중간층을 1층, 노드수는 128개로 하였으며, 4개의 출력으로 구성되어 있으며, LSTM의 출력을 모두 연결하여 8개로 구성된 노드를 1개의 출력층과 전 결합하였다. LSTM3은 LSTM2에 병렬로 LSTM을 하나 더 추가한 것이다. 그림 5에 LSTM3 구조에 대해서 나타냈다.

그림에서 LSTM3은 동일한 10개의 기상요소가 입력으로 하여 각 모델에서 4개의 출력으로 하였으며, 총 12개의 출력을 연결하여 하나의 출력값으로 구성함을 나타내었다. BiLSTM은 은닉층의 타임스탬프를 양방향 LSTM으로 수정한 것으로, 시계열 데이터 예측성능을 비교 평가하기 위한 것이다.

3.2 제안모델 2

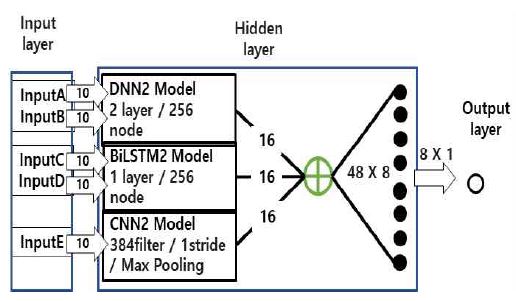

제안모델 2는 기본모델과 제안모델 1에서 오차율이 낮은 모델을 선택하여, 서로 다른 모델을 병렬로 연결하였다. 제안모델 1에서 좋은 오차율을 보인 모델은 DNN2와 BiLSTM2 그리고 기본모델의 CNN2이다. 제안모델 2는 다음과 같이 4개의 모델로 구성되어 있다.

- 1. DL 모델 : 제안모델 1에서 가장 오차율이 좋은 DNN2와 BiLSTM2을 병렬로 연결한 것이다.

- 2. DC 모델 : 제안모델 1에서 가장 오차율이 좋은 DNN2와 기본모델의 CNN2를 병렬로 연결한 것이다.

- 3. LC 모델 : 제안모델 1에서 가장 오차율이 좋은 BiLSTM2와 기본모델의 CNN2를 병렬로 연결한 것이다. DC와 LC의 출력은 DL과 동일하다.

- 4. DLC 모델 : 제안모델 1에서 가장 오차율이 좋은 DNN2와 BiLSTM2 그리고 기본모델의 CNN2를 병렬로 연결한 것이다.

표 4에 제안모델 2에 대해서 나타냈다.

DL. DC, LC 모델은 각 모델의 출력은 8개이며, 총 16개의 스칼라 값이 출력되며, 8개의 노드에 전 결합 하였으며, 이를 1개의 출력층에 전 결합하였다. DLC 모델은 각 모델의 출력은 8개이며, 총 24개의 스칼라 값이 출력되며, 8개의 노드에 전결 합하였으며, 이를 1개의 출력층에 전 결합하였다. 그림 6에 DLC 모델에 대해서 나타냈다.

Ⅳ. 실험 및 성능평가

본 실험은 윈도우 10 환경에서 Anaconda, Python 3.6, Tensorflow 2.6.0, Keras 2.6.0을 사용하였다, 모든 모델의 학습 알고리즘은 SGD(Stochastic Gradient Descent)를 사용하였으며, 학습률은 0.001, 배치 크기는 10으로 하여, 100번 반복 학습하였다. 모든 모델의 활성화 함수는 ReLU를 사용하였다.

4.1 실험 데이터

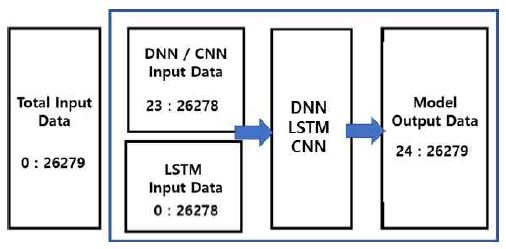

제안모델은 모델마다 입력 데이터의 형태가 다르기 때문에, 입력 데이터의 매칭이 필요하다. LSTM 데이터 구축 시 24번째 샘플까지 타임스탬프에 입력되는 데이터이며, 25번째 샘플의 일사량이 실제 데이터이다. 따라서 DNN과 CNN의 23개 데이터를 삭제해야만 LSTM의 실제 데이터와 일치하기 때문이다. 표 5와 그림 7에 입출력 데이터 형식에 대해서 나타냈다. 실제 데이터는 실험에서 사용한 샘플 수이고, 입력 데이터는 입력층에 입력되는 샘플이며, 출력 데이터는 출력층에 입력되는 실제 값으로, 파이선의 슬라이싱 형태로 나타낸 것이다. 총 샘플 수는 26280으로서, DNN과 CNN의 입력 샘플 수는 26257개이고, LSTM의 입력 샘플 수는 26280개이다. 또한, 실제 데이터의 샘플 수는 26257개이다.

실험의 학습 데이터는 21864이고, 테스트 데이터는 4393개이다. 기상요소는 데이터의 크기가 모두 다르기 때문에, 데이터의 범위를 일치시켜야 한다. 또한, 딥러닝은 입출력 데이터의 크기가 작아야 학습이 효과적이기 때문에, 기상요소를 0과 1 사이로 정규화하였다. 모델의 성능을 평가는 RMSE(Root Mean Square Error)와 MAE(Mean Absolute Error)를 사용하였다.

| (1) |

| (2) |

| (3) |

식 (1)에서 max(d)와 min(d)는 각 열 데이터에서 가장 큰 값과 가장 작은 값이며, di는 각 셀의 데이터이다. 또한, 식 (2)와 (3)에서 x는 실제값이고 x’은 예측값을 의미한다.

4.2 실험결과

실험결과는 소수점 이하 3자리까지 나타내었다. 학습시간은 BiLSTM3이 가장 길었으며, 학습 파라메터 수는 BiLSTM1이 가장 많았다. 학습시간과 파라메터 수는 정비례 관계하지 않았으며, 모델의 구조에 관계가 작용하였다. 즉 DNN1은 다소 많은 학습 파라메터를 가졌으나, 오히려 학습시간은 제일 짧았다. 대부분 LSTM이 타임스탬프의 길이 때문에, 학습시간이 길었다.

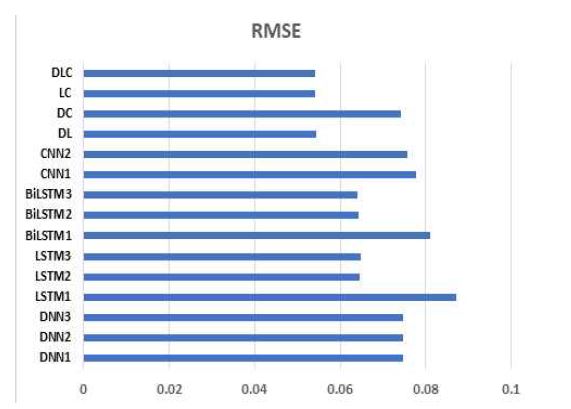

실험결과, DNN2의 RMSE는 0.075, BiLSTM2의 RMSE는 0.064, CNN2의 RMSE는 0.076으로 제안모델 1에서 가장 좋았다. 제안모델 2는 제안모델 1에서 가장 좋은 RMSE를 가진 DNN2, BiLSTM2, CNN2 등 서로 다른 모델을 병렬로 연결하여 실험하였다. 표 6에 전체 실험결과를 나타냈다.

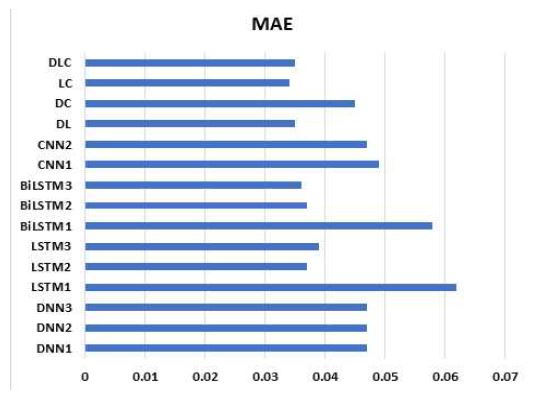

그림 8과 9에 실험결과 RMSE와 MAE 그래프를 보였다.

실험결과, 기본적으로 오차율이 높은 DNN과 CNN을 병렬로 연결한 DC를 제외하고는 제안모델 2의 성능이 우수했음을 알 수 있다.

제안모델 2에서 DL은 RMSE가 0.054, LC는 0.054 그리고 DLC는 0.054 등으로 동일모델에서 가장 좋은 BiLSTM2보다 성능이 좋았다. 그림 8과 9에서 제안모델 2의 DL, LC, DLC 모델의 성능이 우수함을 알 수 있다. 실험결과 기본모델보다 제안모델 2가 12.8%의 성능 향상을 얻을 수 있었다.

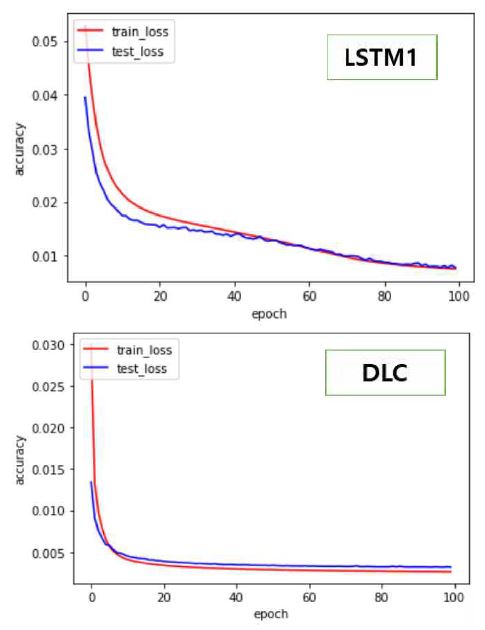

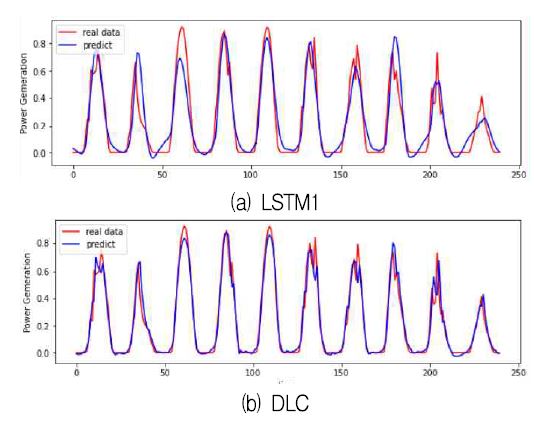

그림 10과 11에 기본모델에서 가장 성능이 안 좋은 LSTM1과 가장 성능이 좋은 제안모델 2인 DLC에 대한 오차 그래프와 10일간 실제값과 예측값 그래프를 나타냈다.

그림 10을 통해 제안모델인 DLC가 안정적으로 학습함을 알 수 있다. 또한, 그림 11을 통해 제안모델이 우수한 예측을 함을 알 수 있다. 실험결과 다음과 같은 결과를 얻을 수 있었다.

- 1. 학습시간과 파라메터 수는 정비례 관계하지 않았으며, 모델의 구조에 영향을 받았다.

- 2. 기본모델 중 LSTM은 예상처럼 시계열 데이터인 기상 데이터에 대해서 좋은 예측률을 보였다.

- 3. 병렬모델인 제안모델 1은 학습 파라메터가 증가함에도 과적합이 없이 비슷하거나 좀 더 우수한 모델로서 증명되었다.

- 4. 제안모델 2는 많은 파라메터로 학습하였음에도 과적합 없이 기본모델과 제안모델 1보다 좋은 결과를 얻었다.

- 5. 기본적으로 예측률이 낮은 DNN과 다른 모델들과의 연결인 제안모델 2에서 DNN과 병렬로 연결했음에도, DC 모델을 제외하고는 기본모델과 제안모델 1보다 우수한 예측결과를 보였다.

Ⅴ. 결론 및 향후 과제

본 연구는 예측 모델의 성능을 향상하기 위해, 낮은 중간층의 다른 기본모델을 병렬로 병합하는 구조를 제안하였다. 제안모델은 깊은 은닉층에 의한 기울기 감소로 모델의 성능을 저하하는 문제점을 제거하고, 더욱 많은 학습 파라메터로 학습하여, 모델의 성능을 향상하기 위함이다.

실험결과, 제안모델 2가 향상된 예측률과 안정된 학습결과를 보였다. 이것은 제안모델 2가 서로 다른 모델의 장점을 유지하면서 많은 파라메터로, 예측률을 향상할 수 있게 하는 모델임을 알 수 있었다. 딥러닝은 지도학습이기 때문에, 데이터의 질이 중요하지만, 동일한 데이터에서 더욱 우수한 딥러닝 모델의 구축이 중요함을 알 수 있다. 향후, 제안모델을 응용하여, 다양한 데이터에 대해서 보다 안정적이고 향상된 예측 딥러닝 모델에 관한 지속적인 연구를 진행할 예정이다.

References

-

Y. LeCun, Y. Bengio, and G. Hinton, "Deep learning", Nature, Vol. 521 No. 7553, pp. 436-444, May 2015

[https://doi.org/10.1038/nature14539]

-

L. Deng and D. Yu, "Deep learning: methods and applications", Foundations and Trends in Signal Processing, Vol. 7, No. 3-4, pp. 197-387, Jun. 2014.

[https://doi.org/10.1561/2000000039]

-

X. Si, C. Hu, and J. Zhang, "A Review of Recurrent Neural Networks : LSTM Cells and Network Architectures", Neural computation, Vol. 31, No. 7, pp. 1235-1270, Jul. 2019.

[https://doi.org/10.1162/neco_a_01199]

-

H. T. Nguyen, G. H. Yu, S. Y. Na, J. Y. Kim, and K. S. Seo, "Pavement Crack Detection and Segmentation Based on Deep Neural Network", Journal of Korean Institute of Information Technology, Vol. 17, No. 9, pp. 99-112, Sep. 2019.

[https://doi.org/10.14801/jkiit.2019.17.9.99]

-

Y. J. Nam and H. H. Jo, "Prediction of Weekly Load using Stacked Bidirectional LSTM and Stacked Unidirectional LSTM", Journal of Korean Institute of Information Technology, Vol. 18, No. 9, pp. 9-17, Sep. 2020.

[https://doi.org/10.14801/jkiit.2020.18.9.9]

-

S. Albawi, T. A. Mohammed, and A. Z. Saad, "Understanding of a Convolutional Neural Network", International Conference on Engineering and Technology (ICET), IEEE, Antalya, Turkey, pp. 1-6, Aug. 2017.

[https://doi.org/10.1109/ICEngTechnol.2017.8308186]

- C. Szegedy, S. Ioffe, V. Vanhoucke, and A. Alemi, "Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning", Thirty-first AAAI conference on artificial intelligence, California, USA, pp. 4278-4284, Feb. 2017.

-

S, Pouyanfar, S. C. Chen, and M. L. Shyu, "An efficient deep residual-inception network for multimedia classification", IEEE International Conference on Multimedia and Expo (ICME). IEEE, Hong Kong, China, pp. 373-378, Jul. 2017.

[https://doi.org/10.1109/ICME.2017.8019447]

- S. Targ, D. Almeida, and K. Lyman, "Resnet in resnet: Generalizing residual architectures", arXiv preprint arXiv : 1603.08029, , Mar. 2016.

-

C. Szegedy, V Vanhoucke, S. Ioffe, and J. Shlens, "Rethinking the Inception Architecture for Computer Vision", Proceedings of the IEEE conference on computer vision and pattern recognition, pp. 2818-2826, Jun. 2016.

[https://doi.org/10.1109/CVPR.2016.308]

- J. J. Kim, Y. H. You, and C. B. Kim, "Radiation Prediction Based on Multi Deep Learning Model Using Weather Data and Weather Satellites Image", Journal of Advanced Navigation Technology, Vol. 25, No. 6, pp. 569-575, Dec. 2021.

-

A. El-Sawy, E. B. Hazem, and M. Loey, "CNN for handwritten arabic digits recognition based on LeNet-5", In International conference on advanced intelligent systems and informatics, Cairo, Egypt, pp. 566-575, Oct. 2016.

[https://doi.org/10.1007/978-3-319-48308-5_54]

- F. N. Iandola, S. Han, M. W. Moskewicz, K. Ashraf1, W. J. Dally, and K Keutzer, "SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and< 0.5 MB model size", arXiv preprint arXiv:1602.07360, , Nov. 2016.

-

A. Sengupta, Y. Ye, R. Wang, C. Liu, and K. Roy, "Going Deeper in Spiking Neural Networks: VGG and Residual Architectures", Frontiers in neuroscience, Vol. 12, No. 95, Mar. 2019.

[https://doi.org/10.3389/fnins.2019.00095]

1986 2월 : 단국대학교 전자공학과 졸업(공학사)

1989년 2월 : 단국대학교 전자공학과 (공학석사)

2009년 2월 : 인천대학교 컴퓨터공학과(공학박사)

1994년 ~ 현재 : 가천대학교 IT대학 컴퓨터공학과 교수

관심분야 : 데이터 마이닝, 딥러닝, 사물인터넷, 에너지 변환