MobileNet을 이용한 사람 음성 구간의 오디오 축약 방법

초록

다양한 스마트 기기에서 오디오 정보들을 수집하고 활용하는 응용들이 개발되고 있다. 방대한 오디오 중에서 사람 음성은 중요한 정보로 오디오에서 음성 구간만 축약하는 것은 유용하다. 본 논문에서는 MobileNet을 사용하여 오디오에서 비음성 구간들을 제외한 음성 구간만을 축약시키는 방법을 제안한다. 입력 오디오를 3초 단위 세그먼트로 구분하고, MFCC 특징을 추출하여 사람 음성 판별에 활용하였다. 특히, 기존에 많이 사용되는 CNN 모델은 구조가 깊어져서 연산량이 증가하는 문제가 있어서, 연산량 최적화에 중점을 둔 MobileNet을 활용하였다. 국내외 여러 데이터셋과 자체적으로 수집한 오디오를 사용하여 실험을 수행하였고, 그 결과 세그먼트 단위로 93.92% 음성 검출 정확도와 전체 오디오에 대해 88.05%의 축약 정확도를 달성하였다.

Abstract

Applications for collecting and utilizing audio information from various smart devices are being developed. Human voice is important data among vast amounts of audio, and it is useful to deduct only voice activity segments from audio. This paper proposes a method to contract only voice activity segments excluding non-speech segments using MobileNet. Input audio is divided into 3 second segments and MFCC features are extracted and used for voice detection. A CNN model widely used in the past has a problem of increasing the amount of computation due to its deep structure. Therefore, MobileNet focused on optimizing the amount of computation is used. Experiments were performed using domestic and foreign datasets and audio collected by ourselves. As a result, we achieved the voice detection accuracy of 93.92% for each segment and the reduction accuracy of 88.05% for the entire audio.

Keywords:

audio deduction, voice activity detection, classification, MFCC, mobileNet, deep learningⅠ. 서 론

최근 오디오 관련 서비스가 증가하면서 일상생활에서도 다양한 스마트 기기에서 오디오 정보를 활용하고 있다. 특히, 다양한 오디오 중에서 음성 데이터는 중요한 정보로서 다양한 기업에서 음성 AI를 개발하여 서비스를 제공하고 있다. 다양한 음원 소스로부터 생성되는 정보를 포함하고 있는 오디오에서 음성 구간을 올바르게 검출하는 것은 음성 인식 성능을 향상할 수 있고, 음성 정보만 추출하여 저장하거나, 포렌식 보안 분야의 분석에서 매우 중요하다.

음성 구간의 식별을 위해 통계학적 방법이 사용되었지만, 딥러닝을 접목하여 정확도를 향상하는 연구도 이루어졌다. 그러나 정확도 향상을 위해 계산 복잡도를 증가시키는 경우가 많아지며 하드웨어 리소스 요구 또한 증가하는 문제점이 있다. 따라서, 최근에는 스마트 기기에 적용하기 위해 다양한 네트워크 혹은 모델의 변형을 시도하거나, 모델 학습과 사용에 드는 연산량을 축소하여 효율성을 높이는 연구도 진행되고 있다.

본 논문에서는 다양한 오디오에서 비음성 요소를 제외하고 음성 구간만을 검출하여 오디오를 축약하는 방법을 제안한다. 특히, 휴대용 기기에도 적용할 수 있도록 복잡도를 최소화하고 정확도를 확보한 CNN 기반 MobileNet 모델을 변형하여 음성 구간 검출을 수행하였다[1]. 국내외 오디오 데이터셋과 자체적으로 수집한 오디오를 사용하여 실험을 수행하였고 제안한 방법의 우수성을 보였다.

본 논문의 2절에서는 음성 구간 검출과 관련한 관련 연구들을 제시하고, 3절에서 제안하는 오디오 축약 방법을 설명한다. 4절에서 실험 결과를 제시하고 5절에서 논문의 결론을 짓는다.

Ⅱ. 관련 연구

음성 인식, 화자 인식, 음성 합성 등 오디오 응용 분야에서 음성 활동 감지(VAD, Voice Activity Detection) 연구가 진행되어 왔다. 기존 연구들은 오디오 분석을 위해 특징을 나타낼 수 있는 다양한 지표들을 추출해 통계학적 모델을 구축하여 검출하였으나, 최근에는 CNN, RNN, LSTM 등 딥러닝 모델을 결합하여 검출하려는 연구가 이루어졌다.

Sohn 등은 Decision-Directed 방법을 이용하여 판별 규칙을 최적화하고, HMM을 이용하여 VAD를 수행하여, G.729B VAD와 비교하여 환경 잡음에도 불구하고 검출 오류율을 최대 40% 축소하였다[2]. Moattar와 Homayounpour는 Spectral Flatness와 단기간 에너지와 같은 단기 특징을 이용한 VAD 방법을 제안하였다. 다양한 데이터셋에서 평균 84.74% 정확도를 달성했다[3].

Li 등은 소음 강도 및 빈도로 음성과 비음성을 구별하는 인간의 청각 특징을 활용하여 음성 주파수에 대한 인간의 masking 효과를 CNN 인코더에 적용한 모델을 개발하고, Aurora 데이터셋에 대해 AUC 기준 94.0% 정확도를 달성했다[4]. Wilkinson과 Niseler는 제한된 환경에서 VAD 성능 개선을 위해 end-to-end 방식으로 훈련한 CNN과 BiLSTM를 통합한 구조를 제안하고, AVA-Speech 데이터셋에 대해 TPR(True Positive Rate) 기준 96.8% 정확도를 보였다[5]. Sehgal과 Kehtarnavaz는 모바일 환경에서 실시간 VAD를 위해 풀링 계층과 크기 축소를 통해 경량화한 CNN 모델을 사용하여 오디오 검출 지연을 13ms까지 축소하고 리소스 최적화를 달성했다[6]. Jia 등은 1D 시간 채널에 separable 컨볼루션을 이용한 end-to-end 딥러닝 모델로 기존 CNN 모델보다 파라미터 수를 줄이고, 모델 용량과 연산량을 최소화하였으며, AVA-speech 데이터셋을 이용해 TPR 기준 85.8% 정확도를 달성했다[7]. Chang 등은 LSTM 모델의 saturation 문제를 해결하기 위해 CNN 모델에 dilated convolution, gated activiation과 residual connection 기법을 적용한 VAD를 제안하였고, False accept 오류율을 LSTM 모델보다 0.99%, 기존 CNN 모델보다 4.09% 개선했다[8].

Ⅲ. MobileNet을 이용한 사람 음성 구간의 오디오 축약 방법

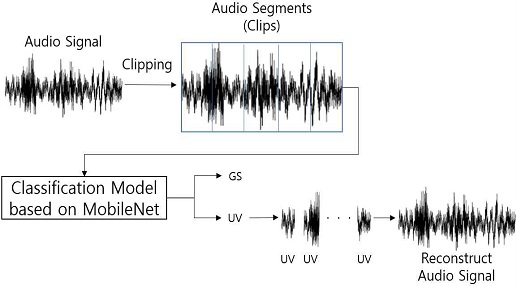

사람 음성 구간을 감지해 오디오를 축약하는 방법의 전반적인 순서를 그림 1에 도시하였다. 입력 오디오를 3초 세그먼트 단위로 분할하고, 분할된 각 세그먼트를 특징 벡터화하여 MobileNet기반 음성 감지 모델의 입력으로 사용한다.

이 모델을 통해 각 세그먼트를 일반 사운드(GS, General Sounds)와 사람 음성(UV, User Voices)로 분류한다. 마지막으로 GS로 분류된 세그먼트들을 제외하고 UV로 분류된 세그먼트들만을 이용하여 음성 구간만 존재하는 오디오로 재구성하여 축약을 수행한다.

3.1 MFCC 특징 추출

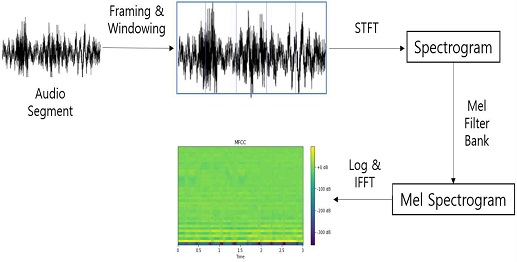

MobileNet 기반 음성 감지 모델을 위한 하드웨어적인 한계를 극복하고, 효율적인 학습을 위하여 입력 데이터의 전처리 과정을 그림 2에 도시하였다.

다양한 채널로 구성된 오디오 데이터를 모노 채널의 16,000 Sample rate로 변환하고, 오디오 파일을 3초 길이의 세그먼트 단위로 분할하였다.

각 세그먼트에 대해 주파수 성분을 얻기 위해 프레임이 50% 겹치도록 윈도우 크기를 1024, 홉 사이즈를 512로 적용한 후 단기간 푸리에 변환을 사용해 Power Spectrum을 추출하고 시간축 변화에 따라 각 윈도우에서의 Spectrum을 활용해 2차원으로 표현되는 Spectrogram을 획득한다[9].

그 후에 Mel Filter Bank를 이용한 Mel-Scale 연산으로 Mel Spectrogram을 추출한다. Mel Spectrogram은 달팽이관 특성을 이용하여 계산한 값으로 저주파에 민감하고, 고주파에 둔감한 특성을 표현한다. 이때, 주파수 대역은 80~7600Hz 범위의 성분을 고려하고 Mel Filter Bank 계수로는 39를 사용하였다.

기본적으로 소리는 배음 구조로서 이를 분석하기 위해 Mel Spectrogram에 로그 함수를 취하고 고속 푸리에 역변환을 사용해 소리의 고유한 특징을 나타내는 수치인 MFCC를 추출한다.

이와 같은 MFCC 추출 과정을 통해 오디오 세그먼트는 92×39×1 크기의 모델의 입력 데이터가 되고, 훈련, 검증, 평가 데이터셋 모두에 적용하였다.

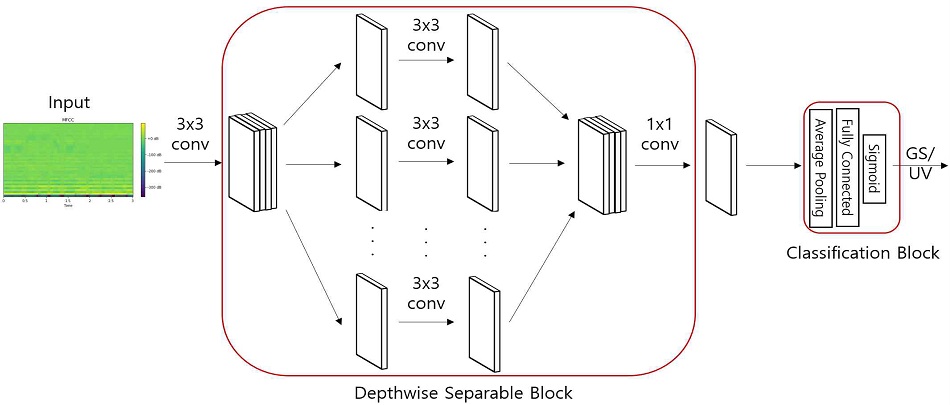

3.2 MobileNet을 이용한 음성 감지 모델

사람 음성 구간 감지를 위하여 MobileNet을 이용한 모델 구조를 그림 3에 도시하였다. MobileNet은 일반적인 Convolution 연산을 거친 뒤, 연속적인 Depthwise Separable Convolution 연산을 진행하는 구조로 구성된다[10].

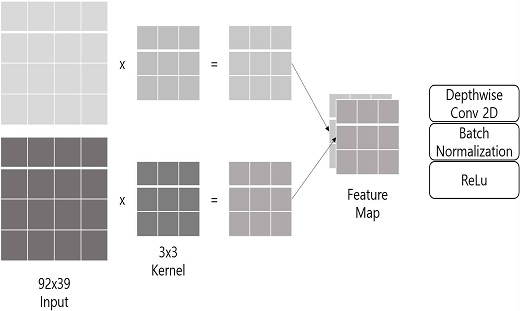

Depthwise Separable Convolution은 Depthwise Convolution과 Pointwise Convolution이 결합된 구조로 채널의 출력값이 하나로 합쳐지는 특징을 갖고 있는데, 이는 공간 방향 특징과 채널 방향 특징을 모두 고려하여 네트워크를 경량화하는 기법이다. 입력 데이터에 대해 일반적인 컨볼루션 연산과 유사하게 동작하지만, 필요한 파라미터 수와 연산량에서 차이를 보인다. 일반적인 컨볼루션 연산은 한 개의 커널을 모든 채널에 연산하지만 Depthwise Separable Convolution은 그림 3과 같이 한 개 특징맵을 생성하는데 더 적은 파라미터 수와 연산량을 갖는다.

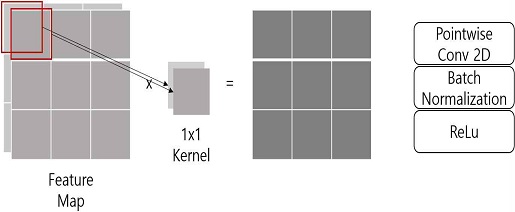

그림 4와 같이 Depthwise Convolution Layer는 3x3 커널 크기의 컨볼루션, 배치 정규화, ReLU 활성화 함수를 통해 공간 방향으로 각 단일 채널에 대한 컨볼루션 연산을 진행한다.

모든 채널이 아닌 단일 채널에 대해서만 연산을 수행하고 채널 결과가 하나로 병합되지 않고 각각 특징맵으로 생성하여 연산량을 크게 경량화시킬 수 있다.

그림 5와 같이 Pointwise Convolution Layer는 1x1 커널 크기의 컨볼루션, 배치 정규화, ReLu 활성화 함수를 통해 Depthwise Convolution이 생성한 Feature Map들을 조절해 다채널 입력 데이터를 더 적은 채널로 임베딩한다. 공간적인 특성은 추출하지 않은 상태로 각 채널들에 대한 연산만을 수행하기 때문에 출력 결과의 크기는 변하지 않으며 채널의 수를 조절할 수 있다.

Ⅳ. 실험 결과 및 분석

4.1 실험 데이터셋

실험을 위한 데이터셋은 Google Audio Set, Korean Conversational Speech Corpus[11], OpenSLR Seoul Corpus[12], AI Hub 한국인 대화 음성[13], IRMAS Dataset[14], GTZAN Dataset[15], Urban Sound Dataset[16], ESC Dataset[17] 등 공개 데이터셋과 Youtube 영상, 스마트폰, 녹음기 등으로 직접 수집한 데이터를 사용해 구축하였다.

구축한 데이터셋은 GS와 UV의 두 클래스로 구분하였다. GS 클래스는 자연 소리, 악기 소리, 동물 소리, 백색 소음 등 음성이 포함되지 않은 데이터로 구성하였고, UV 클래스는 TV 방송 음성, 영화 음성, 노래 음성, 전화 녹음, 강의 녹음 등 음성이 포함된 데이터로 구성하였다.

4.2 MobileNet 기반 음성 감지 모델 학습

실험에서 각 클래스의 사용한 훈련 데이터와 검증 데이터의 비율은 0.9:0.1로 표 1에 MobileNet 모델의 훈련에 사용된 데이터 수를 나타내었다. 전체 데이터 267,934개 중 241,140개의 데이터를 학습에 사용하였고 26,794개의 데이터를 모델 학습 추세 및 과적합을 분석하는데 사용하였다.

MobileNet 모델은 Tensorflow와 관련 API를 이용해 구현하였고, 학습 과정에서 지연 로딩 방식을 사용해 학습에 필요한 데이터만 GPU 메모리에 로딩해 메모리 공간 여유를 확보하도록 하였다.

실험은 Intel i9-11900(8C 16T) CPU 및 64GB RAM, Nvidia RTX 3090 GPU 환경에서 진행하였다. 모델 학습 파라미터로 학습률은 1-3, 가중치 감쇠는 1-4로 설정하였다. 손실 함수는 이진 크로스 엔트로피를 사용하고, 최적화 함수는 Adam Optimizer를 사용하였다. 학습은 256 배치 사이즈에 최대 100 epoch로 진행했으며, 7 epoch 동안 검증 데이터의 손실값에 변화가 없을때 학습이 종료하도록 하였다.

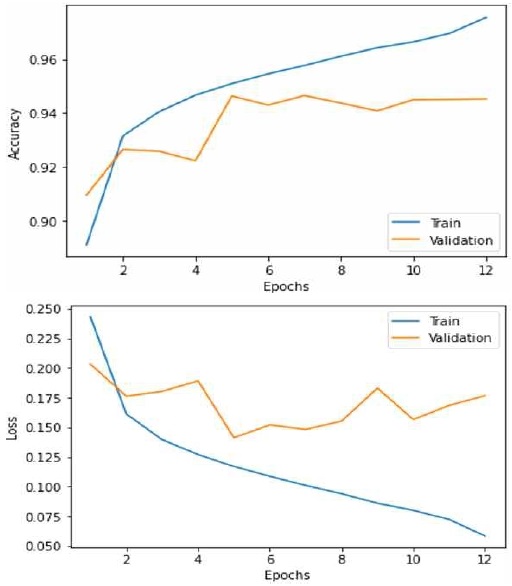

그림 6에는 제안한 음성 감지 모델에 대해 학습 및 검증 데이터를 사용해 훈련하는 과정에서 학습 정확도 및 손실 경향을 epoch 단위로 나타낸 그래프를 도시하였다. 또한, 검증 데이터를 기준으로 훈련 과정에서의 경향을 분석해 손실이 가장 작은 최적 epoch에서의 성능을 표 2에 나타내었다.

4.3 MobileNet 기반 음성 감지 모델 성능 분석

세그먼트 단위에 대해 MobileNet 모델을 이용한 2종 분류로 GS와 UV 클래스의 Sigmoid 확률값을 계산하고 최대 확률값을 갖는 클래스를 기준으로 분류 성능을 분석하였다.

학습된 모델의 세그먼트 단위 성능 분석에 사용된 평가 데이터의 개수를 표 3에 나타내었다.

표 4에는 MobileNet 모델과 일반적인 CNN 모델을 이용해 평가 데이터에 대한 정확도 분석 결과를 나타내었다. MobileNet 모델은 평균 93.92% 정확도를 보였고, 일반적인 CNN 모델의 평균 정확도 보다 0.08% 낮지만, 모델 연산에 사용되는 파라미터 개수가 CNN 모델과 비교해 약 28.49 백만 개 경량화되어 효율적인 것을 알 수 있다.

4.4 제안한 오디오 파일 축약 방법 성능 분석

MobileNet 음성 감지 모델을 이용한 제안하는 오디오 축약 방법의 실제 오디오 파일에 대한 성능 분석을 위해 약 3분 길이의 한국어 뉴스, 영어 뉴스, 한국 영화, 전화 통화 녹음, 가요 음원 파일인 5가지 분류로 각 5개씩 사용하였다. 또한 각 오디오에 대하여 3초 단위로 세그먼트를 구분하여 사람이 실제 클래스를 직접 판별하여 정확도를 비교하였다.

전체 입력 오디오에 대해 각 세그먼트에 대해 클래스 분류를 수행하고 실제 클래스와 예측 클래스의 일치 여부로 성능 분석을 진행하였다. 표 5에는 제안하는 축약 방법에 음성 감지를 위해 MobileNet 모델과 일반적인 CNN 모델을 적용해 각 범주별 평균 정확도를 정리하였다. 연산을 경량화한 MobileNet 모델을 적용한 축약 방법도 평균 88.05% 정확도를 보여 일반적인 CNN 모델을 적용한 것과 유사한 성능을 보이는 것을 알 수 있다.

영어 뉴스, 한국어 뉴스 및 전화 통화 녹음에 대해서는 평균적으로 UV의 검출이 잘 이루어져 오디오 파일이 높은 정확도로 축약되는 것이 보이나, 가요 음원에 대해서는 비교적 감소한 정확도를 보이고 한국 영화에 대해서는 다른 분류들과 달리 많이 감소한 정확도를 보였다. 영화나 음원 같은 경우에는 음성 외에 다양한 배경 오디오가 혼재되어 있어서 성능이 낮게 나타나는 것으로 보인다.

Ⅴ. 결론 및 향후 과제

최근 일상생활에서 다양한 스마트 기기에 음성을 활용한 시스템에 대한 기술 개발 및 연구가 활발하게 진행되고 있다.

본 논문에서는 공개된 데이터셋과 자체적으로 구축한 데이터셋을 사용해 오디오 데이터에서 음성 및 비음성 구간을 감지하여 음성 구간만 축약하는 방법을 제안하였다. 특히, 일반적인 CNN 모델의 연산량을 최소화한 MobileNet 모델을 사용하여 휴대용 기기에서도 적용할 수 있도록 하였고, 실험을 통해 전체 오디오 파일에 대해 효율적으로 축약된 음성 오디오를 생성할 수 있음을 보였다.

추후 연구에서는 MobileNet 모델 신경망보다 음성에 더욱 최적화된 모델을 도입한다면 영화나 음원 같이 오디오가 혼재된 경우에도 성능을 향상하여 축약 정확도 향상이 가능할 것으로 판단된다.

Acknowledgments

This research was supported by Kumoh National Institute of Technology(2021)

References

- A. Howard, M. Zhu, B. Chen, D. Kalenichenko, W. Wang, T. Weyand, M. Andreetto, and H. Adam, "MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications", arXiv:1704.04861, .

-

J. Sohn, N. Kim and W. Sung, "A statistical model-based voice activity detection", IEEE Signal Processing Letters, Vol. 6, No. 1, pp. 1-3, Jan. 1999.

[https://doi.org/10.1109/97.736233]

- M. Moattar and M. Homayounpour, "A simple but efficient real-time Voice Activity Detection algorithm", Proc. of the 17th EUSIPCO, Glasgow, UK, pp. 2549-2553, Aug. 2009.

- N. Li, L. Wang, M. Unoki, S. Li, R. Wang, M. Ge, and J. Dang, "Robust Voice Activity Detection Using a Masked Auditory Encoder Based Convolutional Neural Network", Proc. of the IEEE ICASSP, Toronto, ON, Canada, pp. 6828-6832, Jun. 2021.

-

N. Wilkinson and T. Niesler, "A Hybrid CNN-BiLSTM Voice Activity Detector", Proc. of the IEEE ICASSP, Toronto, ON, Canada, pp. 6803-6807, Jun. 2021.

[https://doi.org/10.1109/ICASSP39728.2021.9415081]

-

A. Sehgal and N. Kehtarnavaz, "A Convolutional Neural Network Smartphone App for Real-Time Voice Activity Detection", IEEE Access, Vol. 6, pp. 9017-9026, Feb. 2018.

[https://doi.org/10.1109/ACCESS.2018.2800728]

-

F. Jia, S. Majumdar, and B. Ginsburg, "MarbleNet: Deep 1D Time-Channel Separable Convolutional Neural Network for Voice Activity Detection", Proc. of the IEEE ICASSP, Toronto, ON, Canada, pp. 6818-6822, Jun. 2021.

[https://doi.org/10.1109/ICASSP39728.2021.9414470]

-

S. Chang, B. Li, G. Simko, T. Sainath, A. Tripathi, A. Oord, and O. Vinyals, "Temporal Modeling Using Dilated Convolution and Gating for Voice-Activity-Detection", Proc. of the IEEE ICASSP, Calgary, AB, Canada, pp. 5549-5553, Apr. 2018.

[https://doi.org/10.1109/ICASSP.2018.8461921]

-

S. Kopparapu and M. LaxmiNarayana, "Choice of Mel Filter Bank in Computing MFCC of a Resampled Speech", Proc. of the IEEE ICASSP, Kuala Lumpur, Malaysia, pp. 121-124, May 2010.

[https://doi.org/10.1109/ISSPA.2010.5605491]

- B. H. Choi, J. J. Lee, H. T. Han, Y. U. Choi, W. S. Cho, and H. Y. Lee, "Voice Activity Detection Model of Human based on MobileNet", Proc. of KIIT Fall Conference, Jeju, Korea, pp. 523-525, Nov. 2021.

- Magic Data Korean Conversantional Speech Corpus, "https://magichub.com/datasets/korean-conversational-speech-corpus/, ".

-

W. Yun, K. Yoon, S. Park, J. Lee, S. Cho, D. Kang, and J. Kim, "The Korean Corpus of Spontaneous Speech", Phonetics and Speech Sciences, Vol. 7, No. 2, pp. 103-109, Jun. 2015.

[https://doi.org/10.13064/KSSS.2015.7.2.103]

- AI Hub Korean Conversation Voice, "https://aihub.or.kr/aidata/7968, ".

- J. Bosch, J. Janer, F. Fuhrmann, and P. Herrera, "A Comparison of Sound Segregation Techniques for Predominant Instrument Recognition in Musical Audio Signals", Proc. of the ISMIR, pp. 559-564, 2012.

- GTZAN Genre Collection Database, "http://marsyas.info/download/data_sets, ".

-

J. Salamon, C. Jacoby, and J. P. Bello, "A dataset and taxonomy for urban sound research", Proc. of the ACM MM, Orlando Florida USA, pp. 1041-1044, Nov. 2014.

[https://doi.org/10.1145/2647868.2655045]

-

Piczak and J. Karol, "ESC: dataset for environmental sound classification", Proc. of the 23rd ACM MM, Brisbane Australia, pp. 1015-1018, Oct. 2015.

[https://doi.org/10.1145/2733373.2806390]

2017년 2월 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 학사과정

관심분야 : 이미지/자연어 처리, 딥러닝

2017년 3월 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 학사과정

관심분야 : 이미지 처리, 딥러닝

2017년 2월 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 학사과정

관심분야 : 이미지/영상 처리

1997년 : 성균관대학교 정보공학과 (학사)

1999년 : KAIST 전산학과 (공학석사)

2006년 : KAIST 전자전산학과 (공학박사)

2008년 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 교수

관심분야 : Digital Forensics, Image Processing, IoT