소성가공 분야에서 인공지능을 이용한 절단면 이물질 검출

; Jeong-Min Park**

; Jeong-Min Park** ; Su-Min Lee***

; Su-Min Lee*** ; In-Hee Hong***

; In-Hee Hong*** ; Seong-Kyu Kim****

; Seong-Kyu Kim**** ; Won-Gok Lee*****

; Won-Gok Lee***** ; You-Seok Bae**

; You-Seok Bae**

초록

뿌리산업(소성가공산업)의 노후된 운영 방식은 전문인력 고령화, 생산현장 노하우 전수 어려움, 비숙련인력의 생산성 저하, 육안검사 기반 시스템의 비 정확성 및 품질 저하 등의 문제를 야기한다. 4차산업혁명과 맞물려, 인공지능을 적용하여 스마트 팩토리 구축으로 위의 문제들을 해결하는 것이 추세이다. 본 논문에서는 소성가공분야 단조 공정의 결함 발생을 줄이기 위해 객체검출 알고리즘 Faster-RCNN, SSD, Yolo의 특성을 분석하고, 알고리즘을 사용하여 절삭 면 이물질 검출 기법을 구현하였다. 또한, 소성가공 단조 공정에서 Faster-RCNN, SSD, Yolo를 사용한 절삭 면 이물질 검출 결과의 정확도와 mAP(mean Average Precision)을 비교하여 소성가공산업 분야에 최적화된 스마트 팩토리 구축 가능성을 입증하였다.

Abstract

The aging operation method of the root industry (plastic processing industry) causes problems such as aging of professional personnel, difficulty in transferring know-how at production sites, decreasing productivity of unskilled workers, inaccuracy and quality of visual inspection-based systems. In line with the fourth industrial revolution, it is a trend to solve the above root industry problems by establishing a smart factory applying artificial intelligence technology. In this paper, cutting surfaces foreign material detection techniques are implemented through artificial intelligence object detection to reduce the occurrence of defects in forging processes in the plastic processing field. In addition, acurancy and mean Average Precision (mAP) were compared with the detection results of Fast-RCNN, SSD, and Yolo to prove the possibility of establishing a smart factory optimized for the plastic processing industry.

Keywords:

drone, flight algorithm, air pollution, arduinoⅠ. 서 론

소성가공이란 재료에 물리적인 힘을 가해 소성변형을 일으켜 재료를 원하는 형상으로 변형시키는 공정이다. 소성가공의 종류에는 공정방식에 따라 인발, 압출, 압연, 단조 등이 있으며, 가공 온도를 기준으로 열간가공과 냉간가공 등으로 구분할 수 있다. 본 논문의 연구 분야인 냉간단조 공정은 금속을 상온의 고체 상태에서 압력을 가해 제품을 만드는 것을 말한다. 냉간단조의 공정은 크게 환봉(원재료)의 절단, 전처리 과정, 프레스 및 금형으로 나눌 수 있다. 본 논문에서는 소성가공 냉간단조의 절단 공정 이후 생산된 환봉 절단면에서의 이물질 검출 기술을 연구 진행 중이다.

소성가공 냉간단조 전처리 공정의 쇼트피닝(Shot peening)은 금속/비금속의 쇼트볼(Shot ball)이라는 미세한 강구를 고속으로 금속의 표면에 투사하는 것인데, 이때 부품표면 근처에서 충돌에 따른 소성변형이 생기고 이로 인해 부품표면 및 그 하부에는 잔류 압축 응력이 걸리게 된다. 하지만, 쇼트피닝은 금속의 표면 정도를 떨어뜨리고 사용한 쇼트가 환경오염을 유발하며, 형상이 복잡하거나 부품의 내면에 적용이 곤란한 단점을 지니고 있다. 최근 이런 단점을 해소하기 위한 여러 대안 피닝 방법들이 연구 개발되고 있다[1].

대표적인 대안 피닝 기술은 레이저 피닝, 전자기 피닝 등으로 기존의 강구를 이용한 쇼트피닝보다 최대 10배 깊이까지 압축 잔류 응력을 생성시킬 수 있어 대상물의 피로 강도가 현저히 상승하게 된다. 기존의 강구를 이용한 쇼트피닝은 대상물의 표면이나 예리한 부위를 손상시켜 절단 봉 이물질을 제거할 필요가 없었다. 그러나 레이저, 전자기 피닝 기술을 사용 시 피닝부 표면에 직접적인 변형이 없으므로 이물질이나 얼룩 등 불량을 유발할 수 있는 물질의 제거가 되지 않는다[2].

최신 대안 피닝 기술의 발전에 맞춰 세척이나 녹 제거의 필요성 여부를 비전 센서로 수집한 절단면의 빅데이터를 이용하여 유의미한 데이터를 뽑아내거나 이를 AI(Artificial Intelligence)가 판독 후 예측하면 생산성의 향상과 품질의 표준화를 달성할 수 있다. 또한, 소성가공은 뿌리 산업으로 기능인력에 대한 의존도가 타 제조업종에 비해 높은 편이며, 고령화가 지속해서 진행 중이기 때문에, 본 연구를 통한 스마트 도제 시스템의 적용이 시급하다.

이에, 본 논문에서는 객체검출 알고리즘 Faster-RCNN, SSD, Yolo의 특성을 분석하고, 절삭 면 이물질 검출 기법을 구현하였다. 본 논문은 서론, 관련 연구, 이물질 검출을 위한 신경망 학습, 결론 및 향후 과제 순으로 기술되었다. 관련 연구 장에서 절단 봉 데이터 수집 방법과 이물질 정의, 이물질 후보영역 검출을 위한 이미지 전처리 방법을 기술하며, 이물질 검출을 위한 신경망 학습 장에서 각 객체 검출기 특성과 학습 결과 분석 내용을 기술한다.

Ⅱ. 관련 연구

2.1 절단 봉 데이터 수집, 이물질 정의, 개발환경

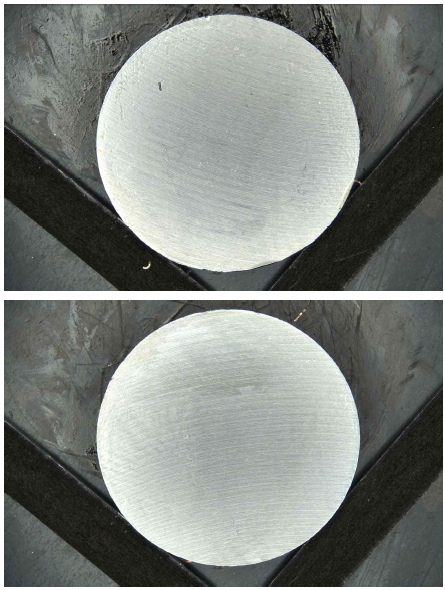

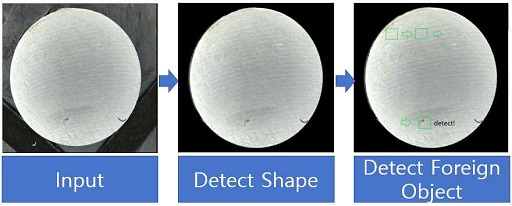

RAW Data(비가공 데이터, 6024×4024픽셀, ARW형식) 700장을 기반으로 이물질을 검출하였다. 그림 1은 수집된 데이터 이미지를 보여주고 있다.

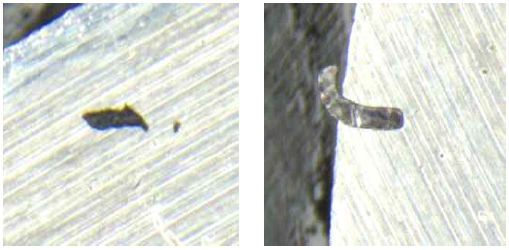

이물질 정의는 두 가지로, 절단 공정에서 절단 시 열을 최소화하기 위한 미스트 오일(절삭유)를 분사하기 때문에 미스트 오일로 인해서 절삭 시 생성되는 조각, 그리고 열린 공간에서 작업을 진행하기 때문에 미스트 오일로 인해서 공기 중에 부유해서 있던 환봉 성질이 아닌 다른 물질을 이물질로 정의하였다. 이와 같은 이물질이 제거되지 않을 시 생산품의 품질은 보증될 수 없다. 그림 2는 이물질의 예시를 보여주고 있다.

수집한 데이터에서 입력 이미지에 비해 작은 크기의 이물질을 검출하기 위해서는 전처리 과정을 통해 작은 크기의 이물질 후보영역을 검출해야 한다. 학습에 사용된 총 데이터는 700장이며, 검출된 이물질 후보영역은 300×300픽셀의 이미지 1070장이다. 구현과 학습에 사용한 환경은 표 1과 같다.

2.2 이물질 후보영역 검출을 위한 이미지 전처리

객체 검출기 모델들은 큰 이미지 내 작은 객체에 대한 성능이 낮다는 공통적인 한계점을 가지고 있다. 최근 MS-COCO 데이터 세트에 대해 높은 정확도를 보이는 CBNET의 경우에도 작은 객체에 대한 mAP(mean Average Precision)가 35.5%이지만 다른 크기 객체(큰 객체, 중간 객체)의 성능은 각각 66.7%, 55.8%로 20% 이상의 차이를 보인다[3]. 작은 객체에 대한 성능이 낮은 이유는 입력 이미지 크기와 관련이 있다.

특징 추출 모델은 딥러닝 네트워크에서 학습해야 할 매개 변수 수를 줄여 계산효율을 높여주고 강건한(Robustness) 특징을 추출하기 위해 네트워크를 깊게 만든다. 네트워크가 깊어질수록 상대적으로 수용 영역은 넓어져 작은 객체에 대한 특징(Feature) 정보가 왜곡되거나 소실 되어 성능이 하락하게 된다. 또한, 작은 객체는 큰 객체에 비해 바운딩 박스가 작으므로 작은 오차에도 IoU(Intersection over Union) 임계값을 넘지 못해 부정 샘플로 학습될 확률이 높다.

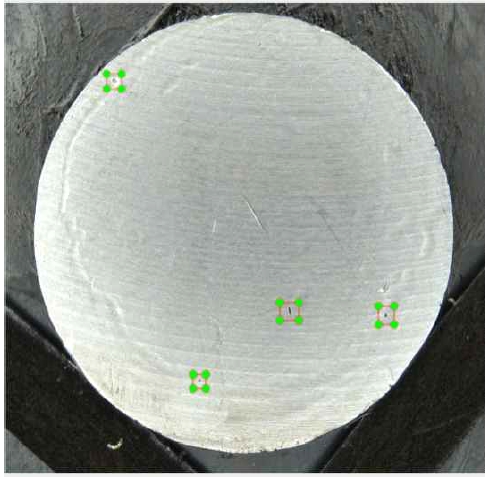

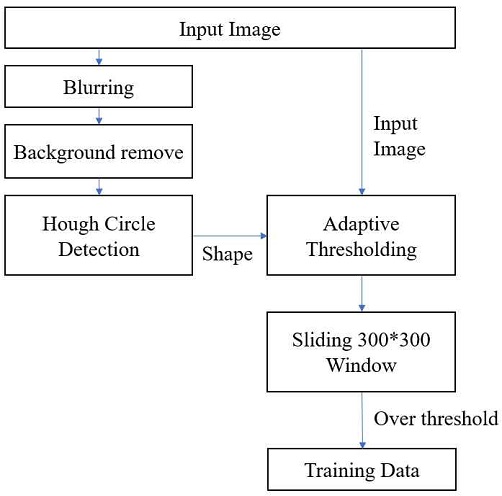

검출하고자 하는 절단 봉 이물질의 크기는 그림 3에서 보이는 이미지처럼 입력 영상 해상도와 비교하면 매우 작다. 이에 따라 작은 객체의 특징 정보를 살릴 수 있도록 영상처리 기법을 사용하여 작은 크기의 300×300픽셀 이물질 후보영역을 검출하는 전처리 과정을 먼저 진행하였다. 그림 4는 훈련 데이터의 제작을 위한 전처리 과정을 보여주고 있다.

이물질 후보영역 검출과정은 절단 봉 외경 검출과 이물질 후보영역 탐색의 두 가지로 나뉜다. 절단 봉 외경 검출과정은 이진화(Thresholding), 블러링(Blurring), 배경 제거, 모양 인식(Hough circle detection)으로 이루어져 있다. 절단 봉 외경 검출이 끝나면 검출된 외경 안에서 histogram 분석 후 중간값을 취하는 Otsu’s Binarization 기법으로 적응형 이진화(Adaptive thresholding)를 진행한다. 그 후 이진화 된 영상에서 슬라이딩 윈도우(Sliding Window) 기법을 사용하여 임계값(Threshold) 이상이며 10픽셀 이상의 크기의 이물질 후보영역을 검출한다. 그림 5는 검출 예시를 그림으로 보여준다.

2.3 훈련 및 테스트 데이터 생성

앞서 진행한 영상처리 과정으로 총 700장의 이미지 데이터(6024×4024)에서 1070장의 이물질 후보 영역(300×300)을 추출하였다.

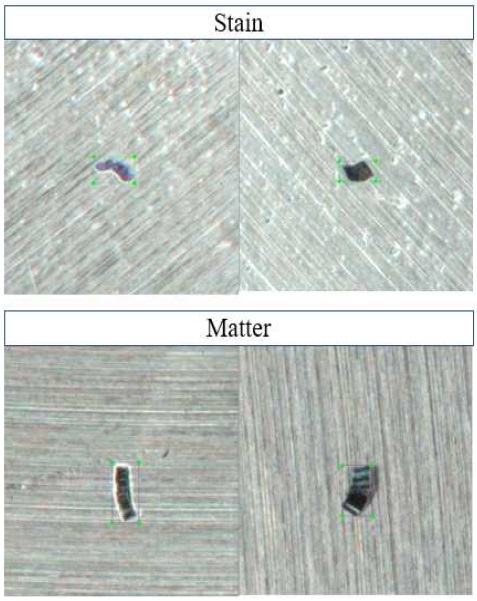

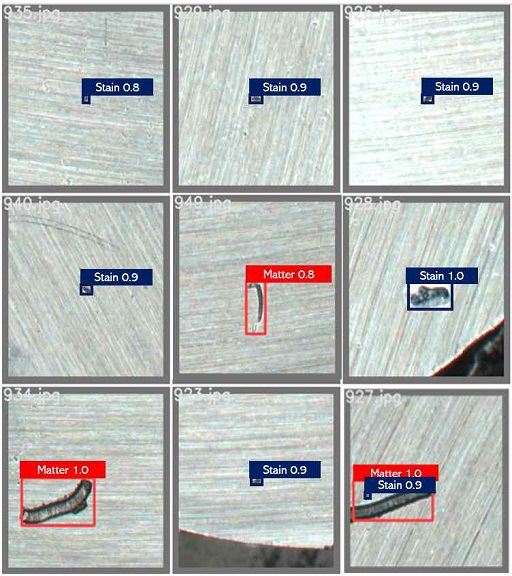

추출된 학습 데이터에서 이물질인 부분은 라벨링 툴 LabelImg를 사용하여 YOLO 학습용과 CNN 학습용 PascalVOC으로 나누어 라벨링 하였으며 이물질이 아닌 것은 라벨링 하지 않았다[4]. 라벨링에 사용한 Class는 그림 6과 같이 Stain과 Matter가 있다.

Stain은 얼룩과 세척이 필요한 경우로 보이는 이물질, Matter는 공정 중 떨어져 나갈 것으로 보이는 이물질로 정의하였다. 라벨링 결과는 Stain 1023개, Matter 272개로 집계되었다. 라벨링 되지 않은 배경 이미지는 50장이다. 같은 조건에서 Training, Validation, Test를 할 수 있도록, 각 Training Data, Validation Data, Test Data의 Stain:Matter 클래스의 비율이 약 5:19가 되도록 배분하였다. Train: Validation: Test의 비율은 8:1:1로 표 2와 같다.

Ⅲ. 이물질 검출을 위한 신경망 학습

3.1 이물질 검출에 사용한 Deep Learning 신경망

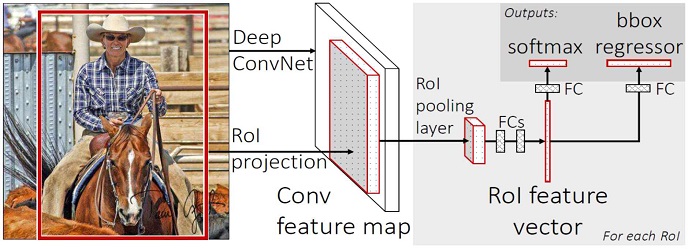

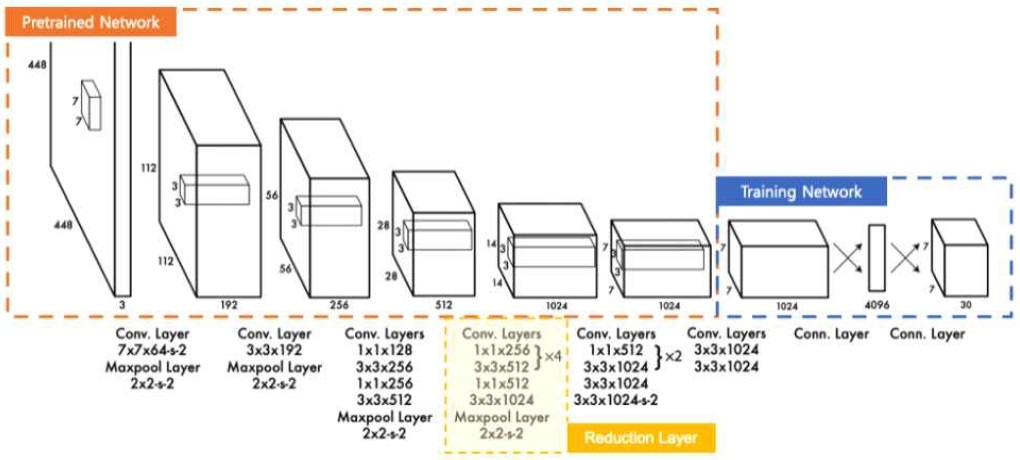

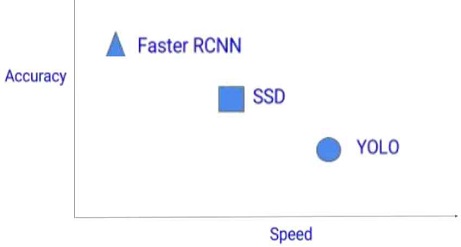

Fast-RCNN의 선택적 탐색(Selective Search) 대신 PRN(Region Proposal Network)을 더한 모델로 기능 맵 추출 과정과 후보영역 생성을 일련의 네트워크에서 수행한다. 이전에 CNN(Convolutional Neural Network) 모델과 비교하여, 장점으로 작은 사물을 포함한 물체에 대한 인식률이 높다는 점이 있다. 단점으로 연구에 사용한 다른 두 개의 모델에 비해 속도가 느리다는 점이다. 그림 7은 Faster-RCNN의 구조이다.

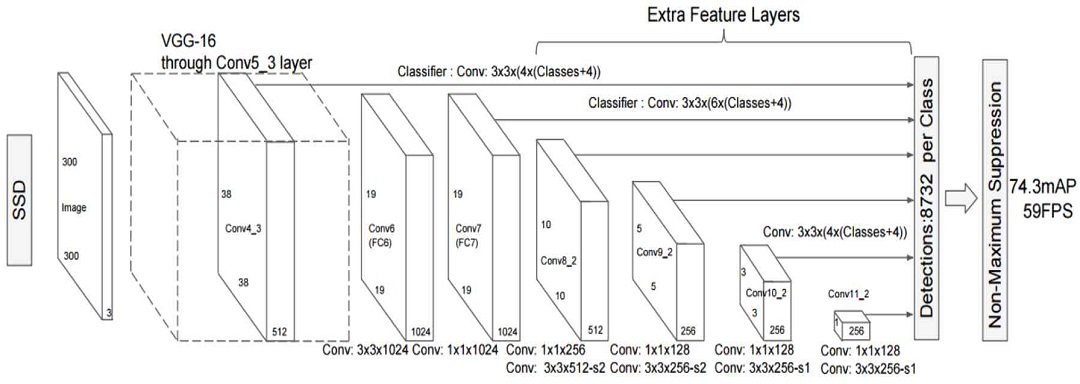

비교적 부족한 Yolo V1의 정확도를 개선하고자 등장한 모델이다. Faster RCNN의 장점과 Yolo의 장점을 모두 취하려 한 모델로 Yolo와 같은 Single Shot Detector이다. SSD는 VGG19 네트워크를 Feature 추출기로 사용하며 비교적 빠르고 비교적 정확하며 계산량이 적다는 특징이 있다. 그림 8은 SSD의 구조이다.

YOLO(You Only Look Once) 계열 모델 중 가장 정확도가 높은 편이며 객체 인식 속도가 빠르고 사용이 쉽다는 장점이 있다. 물체의 위치를 찾는 과정(Regional proposal)과 물체를 분류하는 과정(Object classification)이 하나로 합쳐진 One-Stage 모델이다. 일정 Ground Truth 이상에서 IoU 기준보다 Classification 정확도에 초점을 두었다는 특징이 있다. 그림 9는 YOLO의 구조이다.

그림 10은 세 가지 네트워크의 특징을 비교하기 쉽게 도식화한 그림이다.

3.2 Deep Learning 학습

학습은 300 Epoch로 시작하였다. 300 Epoch 이후에도 과적합이 발생하지 않으면 600 Epoch, 1200 Epoch까지 학습을 진행하였다. 학습 진행 중 학습 데이터에 대해 Validation 결과 Loss가 가장 낮은 결과를 기준으로 테스트를 진행하였다.

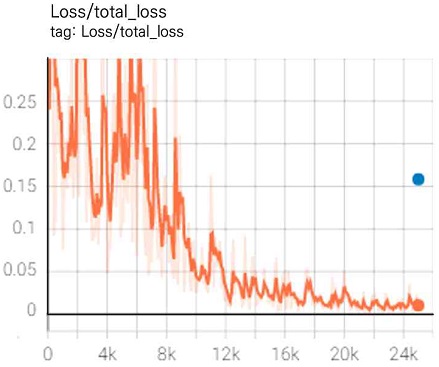

학습과 테스트는 Tensorflow 기반으로 진행하였다. Tensorboard를 사용하여 Learning Rate와 Loss를 모니터링하였다. Pretrained Model은 Faster RCNN ResNet50 V1으로 두고 학습을 진행하였다.

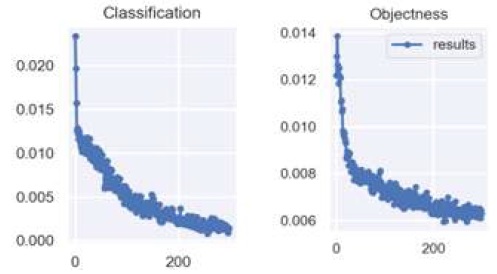

학습은 약 500 epoch에서 loss의 변화가 0에 가깝게 수렴하여 학습이 충분히 되었다고 판단하여 종료하였다. Training total loss 0.022가 나왔으며 Test total loss는 0.157이 나왔다. 검증 시 검출 속도는 전처리 포함 약 1.6초가 소요되었다. 그림 11은 Faster-RCNN의 loss이다.

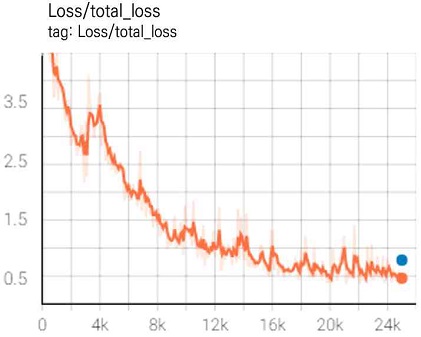

학습과 테스트는 Tensorflow 기반으로 진행되었다. Tensorboard를 사용하여 Learning Rate와 Loss를 모니터링하였다. Pretrained Model은 SSD ResNet50 V1 FPN으로 두고 학습을 진행하였다.

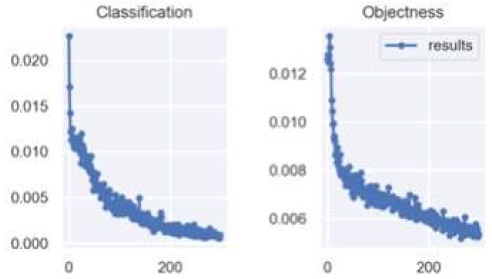

학습은 Faster RCNN과 마찬가지로 약 500 epoch에서 종료되었다. Training Total Loss 결과 0.334가 나왔으며 Test Total Loss는 0.783이 나왔다. 검증 시 검출 속도는 전처리 포함 약 1.6초가 소요되었다. 그림 12는 SSD의 loss이다.

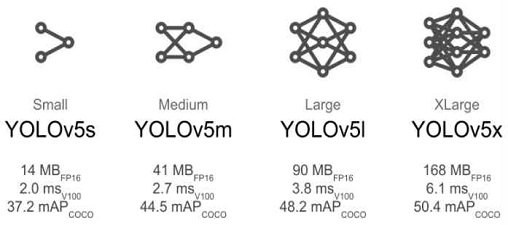

Yolo의 경우 Torch 환경에서 학습을 진행하였다. Pretrained Model은 경량화된 모델인 YoloV5s와 네트워크가 복잡한 모델인 YoloV5x로 진행하였다. 모델의 평가는 YoloV5 내부의 평가 지표를 사용하였다. 그림 13은 YoloV5 Model 성능 지표이다.

YoloV5s의 경우 처음 300 Epoch 학습 후 추가로 1200 Epoch까지 학습을 진행하였으나 400 epoch 이상 학습 시 Loss의 변화가 0에 수렴하였고 Overfitting이 발생하여 300 epoch 학습으로 통일하였다. 그림 14는 YoloV5s의 loss이다.

YoloV5x의 경우도 YoloV5s와 같은 경향을 보였다. 검증 시 검출 속도는 Yolov5s의 경우 전처리 포함 약 1.5초, Yolov5x의 경우 역시 전처리 포함 약 1.5초가 소요되었다. 그림 15는 YoloV5x의 loss이다.

3.3 테스트 결과

학습에 참여하지 않은 테스트 데이터 110장을 테스트한 결과 YoloV5s, YoloV5x의 경우 거의 같거나 YoloV5x가 약간 우세한 성능을 보였다. 두 모델 모두 Confusion Matrix에서 Matter, Stain 각각 98%, 96%의 정확도(Accuracy)를 보였다. 정확도 정의는 식 (1)과 같다.

| (1) |

표 3은 Faster RCNN, SSD, YoloV5의 종합적인 mAP 성능 평가 비교 표이다. mAP로 비교해 보았을 때, mAP [IoU=0.50:0.95]에서 가장 높은 정확도를 보여준 모델은 Faster CNN(51.4%)이었으며, 뒤이어 YoloV5x(46.1%), YoloV5s(45.2%), SSD(39.9%) 순이였다. mAP [IoU=0.50]에서 가장 높은 정확도를 보여준 모델은 YoloV5x (76.4%)이었으며, 뒤이어 YoloV5s (76.3%), Faster RCNN (76.2%), SSD (64.6%) 순이였다.

mAP [IoU=0.50:0.95]에서 YoloV5 보다 Faster-RCNN의 정확도가 더 높았으나, YoloV5의 경우 mAP [IoU=50]의 정확도가 가장 높았다. 이는, 일정 Ground Truth 이상에서 IoU 기준보다 Classification 정확도에 초점을 둔 YOLO의 특성이 반영된 결과이다[9]. 학습한 모델로 테스트해 본 결과 그림 16과 같이 준수한 성능을 나타냈다. 다만 10픽셀 미만의 아주 작은 객체의 경우 전체적인 정확도 저하의 원인이 되었다.

Ⅴ. 결론 및 향후 과제

본 연구에서는 소성가공 냉간단조 절단 공정에서 수집된 RAW 데이터에서 이물질 여부를 판별하기 위해 절단 봉 외경 검출(Contour), 적응형 이진화(Adaptive thresholding), 허프 변환(Hough transform), 캐니 엣지 검출(Canny edge detection) 등의 전처리 과정을 통해 학습 데이터를 추출하여 Faster RCNN, SSD, YoloV5에 적용할 수 있는 방법을 제안하고 학습에 참여하지 않은 데이터를 통해 평가하였다. 그 결과 작은 객체에 대한 성능이 좋은 Faster RCNN의 정확도가 mAP [IoU=0.50:0.95]에서 51.4%로 가장 좋았으며, YoloV5x의 성능이 mAP [IoU=0.50]에서 76.4%로 가장 좋았다. 또한, 모든 모델에서 정확도 95% 이상, 가장 좋은 모델(YoloV5x, Faster-RCNN)의 경우 Matter 98%, Stain 97%의 정확도를 얻었다. 또한, 학습된 모델의 검출 속도는 YoloV5 사용 시 전처리를 포함하여 약 1.5초 미만으로 기존의 패턴 매칭 및 영상처리만을 이용한 고해상도 영상 내 이물질 검출 방법보다 빠르고 강건하다.

본 연구에서는 기존 영상처리를 이용한 이물질 검출보다 빠르고 정확하며, 강건한 이물질 검출기를 구현하여 그 가능성을 입증하였다. 현재 10픽셀 미만의 작은 객체는 정확도 저하의 원인이 된다. 향후 Hyper parameter 설정 및 FPN(Feature Pyramid Network) 기술 적용 등 연구를 통해 10픽셀 미만 작은 객체에 대한 정확도를 높인다면, 소성가공 분야에 최적화된 스마트 팩토리 구축을 앞당길 수 있을 것으로 기대된다.

Acknowledgments

본 연구는 중소벤처기업부의 현장수요형 스마트공장 기술개발사업의 일환으로 수행하였음. [S2931470, AI와 ROBOT을 이용한 소성가공분야의 Tool-Life 예측 및 품질 측정시스템 개발] / This work was supported by the Smart Factory Technological R&D Program(S2931470) funded by Ministry of SMEs and Startups(MSS, Korea)

References

- Latest Finning Technology for Surface Modification of Metal Parts http://gift.kisti.re.kr/, [accessed: Jul. 05, 2021]

- Jong-Do Kim, Muneharu KUTSUNA, and Yuji SANO, "Laser Peening Process and Its Application Technique", Journal of Welding and Joining, Vol. 33, No. 4, pp. 309-314, Aug. 2015.

-

Seunghyeok Shin, Jongmin Lee, Sangwook Lee, Taeseok Yang, and Whoi-Yul Kim, "High-Speed Satellite Detection in High-Resolution Image Using Image Processing", Journal of the Korean Society for Aeronautical & Space Sciences, Vol. 46, No. 5, 427-435, May 2018.

[https://doi.org/10.5139/JKSAS.2018.46.5.427]

- https://github.com/tzutalin/labelImg, . [accessed: July. 25, 2021]

-

Ren, S., He, K., Girshick, R., and Sun, J., "Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks.", IEEE Transactions on Pattern Analysis and Machine Intelligence, Budapest, Hungary, Vol. 39, No. 6, pp. 1137-1149, Jun. 2016.

[https://doi.org/10.1109/TPAMI.2016.2577031]

-

Wei Liu, Dragomir Anguelov, Dumitru Erhan, Christian Szegedy, and Scott Reed, "SSD: Single Shot Multi Box Detector", European Conference on Computer Vision(ECCV), Amsterdam, Netherlands, Dec. 2016.

[https://doi.org/10.1007/978-3-319-46448-0_2]

-

Joseph Redmon, Santosh Divvala, Ross Girshick, and Ali Farhadi, "You Only Look Once: Unified, Real-Time Object Detection", 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA, pp. 779-988, Jun. 2016.

[https://doi.org/10.1109/CVPR.2016.91]

- https://github.com/ultralytics/yolov5/wiki/Train-Custom-Data, . [accessed: Jul. 21, 2021]

- Yong-Hwan and Youngseop Kim, "Comparison of CNN and YOLO for Object Detection", Journal of the Semiconductor & Display Technology, Vol. 19, No. 1. pp. 85-92, Mar. 2020.

2006년 02월 : 인천대학교 산업공학과(학사), 물류학(학사)

2021년 10월 : 한국산업기술대학교 컴퓨터공학과 (석사)

2017년 03월 ~ 현재 : ㈜채움아이티 대표이사

관심분야 : 스마트공장, 산업인공지능

2022년 02월 : 한국산업기술대학교 컴퓨터공학과(학사)

관심분야 : 인공지능, 빅데이터

2022년 02월 : 한국산업기술대학교 전자공학과(학사)

관심분야 : 머신러닝, 스마트공장

2022년 02월 : 한국산업기술대학교 전자공학과(학사)

관심분야 : 머신러닝, 스마트공장

2020년 02월 : 한국산업기술대학교 전자공학과(학사)

2021년 03월 ~ 현재 : 한국산업기술대학교 스마트팩토리융합학과(석사)

관심분야 : 컴퓨터비전, 스마트

2006년 02월 : 한국산업기술대학교 컴퓨터공학과(공학사)

2008년 02월 : 한국산업기술대학교 컴퓨터공학과(공학석사)

2012년 02월 : 한국산업기술대학교 컴퓨터공학과(공학박사)

2020년 04월 ~ 현재 : 한국산업기술대학교 인공지능기술사업화연구소 연구교수

관심분야 : 스마트공장, 신호처리, 임베디드시스템, AI

1993년 02월 : 서울대학교 전기공학과(공학사)

1995년 02월 : 서울대학교 전기공학과(공학석사)

2000년 02월 : KAIST 전자공학과(공학박사)

2003년 09월 ~ 현재 : 한국산업기술대학교 컴퓨터공학부 교수

관심분야 : 인공지능, 스마트공장, 패턴인식, 신호처리