실시간 모션캡처를 사용한 VR 원격 교육시스템

초록

가상훈련 시스템은 시간과 공간의 제약이 없다는 점에서 기존의 실제 훈련 시스템과의 차별성을 가진다. 최근에는 실시간 모션캡처를 활용하여 가상훈련 속에서 사용자의 다중감각을 자극해 몰입감을 확장 시키는 개발이 이루어지고 있다. 하지만 대부분의 가상현실 시뮬레이션 프로그램은 대부분 1인용 VR 개인 훈련에 초점이 맞춰져 있다. 전 세계적 COVID-19의 영향으로 인해 비대면 원격 협업 교육 기술의 중요성이 커지고 있고, 이에 다양한 기업에서 VR / AR 실감 콘텐츠 기반의 원격 협업 시스템 개발을 시도하고 있다. 이에 본 논문에서는 다중감각 체험과 비대면 원격 교육을 동시 진행 시킬 수 있도록 실시간 모션캡처를 활용한 원격 교육시스템을 제안한다. 그리고 본 시스템을 제조업 원격 교육 콘텐츠로 제작하여 기존 제조업 시뮬레이션에서 경험할 수 없었던 숙련자와 비숙련자의 다양한 원격 소통교육을 실시했다.

Abstract

The virtual training system is different from the existing real training system in that there is no time and space limitation. Recently, real-time motion capture has been used in virtual training to stimulate multiple senses of the user and expand the immersive feeling. However, most virtual reality simulation programs are mostly focused on one-person VR personal training. The importance of non-face-to-face remote collaboration education technology is increasing due to the COVID-19 situation all over the world, and various companies are trying to develop VR / AR real-life content-based remote collaboration systems. Therefore, in this paper, we provide a remote education system that utilizes real-time motion capture so that multiple sensory experiences and non-face-to-face remote education can proceed at the same time. In addition, we produced this system with manufacturing remote learning content and conducted various remote communication education for skilled and unskilled people who could not experience it in the simulation of the existing manufacturing industry.

Keywords:

motioncapture, unity, interaction, virtual reality, remote educationⅠ. 서 론

가상현실(VR, Virtual Reality)은 인공 생성된 가상환경을 현실 세계같이 표현하는 기술, 특정 환경이나 상황 등을 의미한다. 가상현실은 HMD(Head Mounted Display)로 시야를 차단해 현실과 다른 가상공간에서 새로운 디지털 세계의 경험을 극대화한다. 현재 가상현실은 교육이나 게임 등의 산업뿐만 아니라 제조업, 의료, 국방 등의 특수분야에서도 다양하게 활용되고 있다.

1960년 HMD가 개발된 이후 가상현실에서 물리적 움직임을 제어하면서 청각과 촉각을 포함한 사용자의 오감 만족을 위한 가상현실 기반의 입력 처리 기술이 연구 개발되기 시작했다. 그 결과 가상현실에서 몰입감을 더해서 시각적으로 뛰어난 그래픽과 청각을 자극하는 3D 입체 사운드와 손가락의 움직임을 그대로 가상현실에서 구현하는 데이터 글러브 등이 개발되며 다중감각 체험의 확장으로 이어지고 있다[1]-[4].

가상현실 속 다중감각 확장 기술과 함께 가상현실 속 원격 기술의 중요성도 커지고 있다. 전 세계적 COVID-19 사태로 비대면(Untact) 생활은 전 산업 부분에서 급속하게 디지털화를 촉진하고 있다. 특히 언택트(Untact)문화를 넘어 온택트(Ontact) 문화의 확산으로 비대면 원격 기술의 수요가 증가하기 시작했다[5]. 원격 협업 시스템은 일반적으로 Microsoft Teams, Zoom Video Communications의 Zoom 등 웹캠 기반의 원격 화상 회의가 일반적이다. 하지만 Microsoft의 Holoportation과 같은 홀로그램 통신 등으로 시작하여 다양한 기업에서 VR/AR 실감 콘텐츠 기반의 원격 협업 시스템이 등장하고 있다. 정부에서도 원격 교육/산업 정책을 발표하며 비대면 VR 원격 직업교육 활성화 등을 지원하고 있다[6]. 이에 가상현실 기술을 접목한 교육방식이 등장하고 있으며, 기존 교육방식을 혁신하는 신기술로 주목받고 있다[7]. 제조, 항공 및 국방 분야의 교육과 훈련을 위한 VR/AR 기술 응용 시장은 2030년에 약 2,942억 달러에 이를 것으로 예상한다[8].

하지만 현재 개발되어있는 가상현실 교육 프로그램들은 대부분 1인용 VR 기기의 개인별 훈련에 초점이 맞춰져 있어 협업 시스템으로의 개선점이 필요하다.

이에 본 논문에서는 다중감각 체험과 비대면 원격 교육을 동시 확장 시킬 수 있는 실시간 모션캡처를 활용한 원격 교육시스템을 제안한다. 이 시스템은 실시간 모션캡처 장비와 모션 글러브로 전신 트래킹을 진행한다. Axis Studio 을 통해 모션캡처로 얻어지게 되는 신체 동작 데이터는 Unity 환경에서 실시간으로 캐릭터에 입혀진다. VR과 연동시켜 가상현실 속에서 1인칭 시점으로 캐릭터 전신이 상호작용하게 되면 신체 소유감(Body ownership)을 강하게 느끼게 된다. 신체 소유감은 인지 신경 과학 분야에서 신체가 자기에게 소속됨을 느끼는 감각으로 정의되고 있다[9]. 신체 소유감은 사용자가 가상현실 속에서 가상 캐릭터의 신체를 자신의 신체처럼 생각하는 현상으로 볼 수가 있고, 이는 콘텐츠의 깊은 몰입감으로 이어질 수가 있다[10]. 연동된 가상 캐릭터들은 Photon PUN2를 사용하여 원격으로 협업을 진행하게 된다. 가상 원격 교육은 실제로 현장에 방문하여 교육받던 기존의 교육방식과 다르게 시공간의 제약을 받지 않는다는 장점이 있다. 모션캡처 장비와 VR을 활용하여 실시간 원격 교육 진행한 결과와 시스템적으로 보완해야 할 점을 추가로 서술한다.

Ⅱ. 관련연구

2.1 모션캡처

모션캡처는 사람, 동물 등 움직임이 있는 물체를 상대적 관찰 대상자로 설정하고, 대상의 움직임, 위치, 속도, 방향 등의 정보를 알고리즘을 활용하여 특정 정보를 추출하는 시스템을 총괄하는 포괄적 의미이다[11]. 초창기 영상 매체에서 3D 그래픽 영상 제작자가 만든 영상들이 부자연스러웠던 이유는 동작을 일일이 수작업으로 만들기 때문에 팔이 뒤로 꺾이는 물리적인 오류가 생겨 사실적으로 보이지 않았기 때문이다. 또한, 키 프레임(Key frame) 작업을 위해서는 많은 시간과 비용이 들어가게 된다. 이러한 단점을 보완하기 위해 카메라나 센서를 통해 사람이나 물체의 움직임을 촬영하여 컴퓨터로 데이터화 시키는 기법이 모션캡처 기술이다[12].

대표적인 모션캡처 장비로는 광학식 마커 기반(Marker-based) 측정 장비와 마커리스(Marker-less) 측정 장비, IMU(Inertial Measurement Unit) 관성 측정 장치가 대표적이다[13]. 마커 기반의 광학식 모션캡처 장비는 촬영 중 마커가 보이지 않으면 데이터가 손실되기 때문에 수십 대의 카메라를 사용하여 촬영을 진행한다. 이는 정확도가 높은 방식이지만 비용이 많이 들기 때문에 개인적으로 활용하기 어렵다. 대표적인 마커리스 장비로는 Microsoft의 Kinect가 있다. Kinect는 마커를 부착하지 않아도 모션 데이터를 얻을 수 있으며 저렴하다는 장점이 있지만, Kinect와 추적 대상 사이에 간섭이 있거나 인원이 늘어나면 오차가 심할 수 있다[14]. IMU 관성 측정 장비는 휴대성이 높으며 간편하게 모션캡처가 가능하다는 장점이 있지만, 자이로 센서의 구조적 문제로 캡처 시간이 길어지면 오차 범위가 넓어진다는 단점이 있다.

2.2 가상훈련 시스템

가상훈련 시스템은 기존의 실제 훈련 시스템보다 시간과 공간적인 제약이 없으며 안전하다는 점에서 차별점이 있다[15]. 최근의 가상훈련 시스템은 모션캡처 웨어러블 햅틱 장비, VR 트레드밀 등을 활용한다. 가상훈련 시스템은 짧은 기간에 훈련을 반복 숙달할 수 있으며, 초기 시스템 구축 비용 이외의 추가 비용 없이 양질의 교육 효과를 볼 수 있다. 경찰 대테러 훈련에도 가상훈련 시스템이 사용되는 것을 볼 수가 있다. 미국에서는 국토 안보부와 루이지애나 주립대학교 대테러 연구소의 지원을 받아 V-Armed라는 대테러 훈련 시뮬레이션을 개발했다. 이 시스템은 가상환경 속에서 테러 공격에 대응하여 임무를 해결하게 되며, 해결 후 각 팀의 임무 지시 및 실행을 평가하고 팀과 개인의 테러 대응 능력을 파악하여 그 부분을 보완할 수가 있다[16]. 국내의 솔트웍스에서는 산업현장에서 일어날 수 있는 사례를 4D로 체험하고, 산업재해 사례 예방과 대책까지 교육할 수 있도록 체감형/실감형 건설 현장체험 가상훈련 시스템을 개발하였다[17]. 그 외에도 가상훈련 시스템은 화력발전 보일러 유지 보수 훈련, 뇌졸중 환자 정적/동적 균형 향상 훈련, 건설 작업자 훈련 등 다양한 특수 훈련 분야에도 사용할 수 있어 사회적 활용가치가 높아지고 있다[18]-[20].

Ⅲ. 실시간 모션캡처 가상 원격 교육시스템

본 장에서는 모션캡처 장비를 장착한 작업자의 데이터를 가상환경 속 캐릭터의 움직임과 연동시켜 몰입감을 높이는 실시간 모션캡처 가상 원격 교육시스템을 소개한다. 모션캡처 장비 Perception Neuron Studio와 Vive 및 Oculus HMD 장비, Unity와 Photon의 PUN2를 이용하여 시스템을 제작한다. 시스템 설계를 위해 시스템 사용 목적이 담긴 시나리오 정의가 우선시 되어야 한다. 실시간 모션캡처 가상 원격 교육시스템은 VR HMD와 모션캡처 장비를 착용한 숙련자와 비숙련자가 가상환경에서 서로 의사소통하며 원격 교육을 실행할 수 있도록 한다. 이를 진행하는 시나리오는 다음과 같다.

- (1) 작업자들은 HMD와 모션캡처 중 하나를 선택하게 된다.

- (2) HMD를 선택한 작업자는 HMD만 착용하고, 모션캡처를 선택한 인원은 추가적으로 모션캡처 장비도 착용하여 Axis Studio를 통해 Unity로 움직임과 위치 데이터를 보낸다.

- (3) 원격 통신을 통해 작업자들은 한 공간에서 협업을 진행할 수 있다.

이러한 과정을 통해서 숙련자와 비숙련자 작업자들은 자유롭게 의사소통하며 원격 시뮬레이션을 진행할 수 있다. 숙련자는 HMD를 착용하여 움직임과 위치 데이터를 Unity로 보낸다. 비숙련자는 모션캡처 장비와 HMD를 착용하며 실시간 모션캡처를 통해 Unity 가상공간으로 움직임과 위치 데이터를 보낸다. 비숙련자는 캐릭터와 동기화되어 캐릭터의 시선으로 화면을 볼 수 있게 된다. Photon 원격 통신으로 숙련자와 비숙련자 모두 같은 가상공간에서 만나게 된다. 비숙련자는 숙련자의 교육에 따라 제조 시뮬레이션을 진행하게 된다. 숙련자는 실시간으로 모션캡처가 되는 비숙련자의 캐릭터를 보고 작업 자세를 판단하여 올바른 자세와 행동절차를 PhotonVoice를 통해 음성으로 교육할 수 있게 된다.

Ⅳ. 사례 연구

전술된 실시간 모션캡처를 이용한 가상 원격 교육시스템을 제조업 원격 교육 콘텐츠로 제작하여 숙련자와 비숙련자의 다양한 원격 소통교육을 실시했다.

표 1에서는 앞서 예시를 든 V-Armed나 솔트웍스의 4D Simulation 가상훈련 시스템, 그리고 가상 원격 협업 시스템인 Spatial과 Engage와 제안하는 시스템을 비교하였다. 원격협업이 가능한지, 전신 아바타를 사용하는지, 가상의 물체와 인터랙션이 가능한지, 마지막으로 신체 모션 분석이 가능한지 4가지 요소로 비교하였다. 모든 시스템은 가상환경에서 물체와 상호작용이 가능했다. Soltworks와 같은 기존의 1인용 개인 VR 제조업 시뮬레이션과 다르게 다른 시스템들은 원격 멀티플레이가 가능했다. Engage 가상 원격 시스템도 전신 캐릭터를 사용하지만 HMD와 컨트롤러를 사용한 IK(Inverse Kinematics) 애니메이션 방식을 사용한다는 단점을 가지고 있다. IK 방식은 계층 구조 내의 하위 오브젝트 이동을 상위 오브젝트가 따라오는 방식이다. 컨트롤러를 원하는 곳에 위치시키면 어깨와 팔꿈치가 손의 이동에 맞추어 회전하므로 상대방의 위치에서 보면 관절 구조가 물리적으로 맞지 않는 부분에 위치할 수가 있어 가상현실 시뮬레이션에서 몰입도가 떨어질 수가 있다. 제안된 시스템은 관절 마디마다 센서를 부착해서 사용하는 모션캡처 장비를 사용하기 때문에 전신 캐릭터를 사용할 수 있다는 점과 신체 데이터 분석을 진행할 수 있다는 점에서 타 시스템과 차이점이 있다.

4.1 시스템 개발 환경

표 2는 실시간 모션캡처를 활용한 원격 교육시스템 개발을 위해 사용된 구현 환경을 보여준다. Unity는 Unity Technologies에서 개발한 멀티플랫폼 게임 엔진으로 VR, AR 등 다양한 애플리케이션 개발을 지원한다. Unity는 아티스트, 디자이너와 개발자가 협업하여 몰입형 인터랙티브 환경을 만들 수 있다. Unity의 가장 큰 특징은 하나의 애플리케이션 개발을 통해 다양한 디바이스에 배포할 수 있는 멀티 플랫폼을 지원한다는 것이다[21][22]. 본 연구에서는 Unity 2019.4.18. f1 버전을 사용하였다.

4.2 모션캡처 장비와 Unity 연동

본 논문에서는 실시간 모션캡처를 위해서 Noitom의 PNS를 사용하였다. PNS는 비 광학식 모션캡처 장비로 IMU 관성 측정 단위 기술을 가지고 있으며 내장된 임베디드 데이터 융합, 인체역학, 물리적 엔진 알고리즘을 사용하여 사용자의 움직임을 측정할 수 있다[23]. PNS는 다른 마커 기반의 모션캡처 장비에 비해 신체를 인식하는 카메라가 필요하지 않다는 장점이 있으며, 인식 중인 장치와 사용자 간에 다른 물체가 있더라도 방해 없이 모션캡처가 가능하다. 하지만 자성을 이용한 장비이므로 캡처 시간이 길어지면 오차 범위가 넓어지며, 주변에 자기장이 강하게 작용하는 공간에서는 정밀한 모션캡처가 힘들다는 한계점이 있다.

본 연구에서는 모션캡처 시에 주변의 자기장 영향을 주는 요소들을 제거한 환경에서 실험을 진행하여 가상 원격 교육시스템으로 충분히 활용 가능함을 확인했다.

Ryan Sers는 Perception Neuron 모션캡처 장비의 정확도 유효성을 상체의 자세 각도 ROM(Range Of Motion : 관절가동범위)을 측정하는 능력 측면에서 실험하였다. 연구에 따르면 해당 장비는 평균적으로 ROM 차이가 5° 아래였다. 그리고 예측 결괏값과 실제 환경에서 관찰되는 값의 차이를 다룰 때 사용되어 정밀도를 표현하는데 적합한 RMSD(Root Mean Square Deviation : 평균제곱 근 편차)가 4° 아래로 적절하게 수행되어 오차 범위가 낮고 측정 정밀도가 상체 운동을 평가하는 유효한 방법임을 입증하였다[24]. 이에 PNS는 위험성이 높고 정밀한 작업에 관한 교육 시뮬레이션에도 적합한 장비임을 알 수가 있고, 외과 의사의 자세를 객관적으로 정량화하는 실험에서도 사용되었다[23].

Noitom 사에서 제공하는 Axis Studio는 PNS Transceiver를 통해 받은 센서 데이터를 쉽게 탐색하고 캡처하고 보정하여 FBX나 BVH 파일로 변환하는 기능을 가지고 있다. 또한 하나의 컴퓨터에서 한 번에 최대 3명의 작업자를 모션캡처 할 수 있고, PNS 센서와 Studio Gloves로 신체와 손가락에 대해 최대 23개의 센서를 관리한다[25]. PNS Transceiver의 IP Adress와 Axis Studio의 IP Adress를 일치시켜주어 연결해 주면 Axis Studio에서 PNS 센서 데이터를 가지고 올 수 있다.

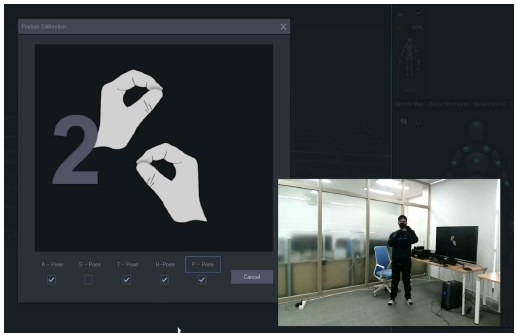

이후 그림 2처럼 연결 과정에서 A-Pose, T-Pose, B-Pose, P-Pose 네 단계의 Posture Calibration을 거쳐 주면 몸에 부착된 PNS 센서가 몸 전체에 있는 방향과 위치를 이해할 수 있게 된다. Data Process 과정을 거쳐 보정된 모션데이터는 아바타에 동기화되어 그림 3처럼 Axis Studio 인터페이스에 나타나게 된다. 초기화 과정과 Posture Calibration 과정을 제대로 진행해 주지 않는다면 Axis Studio에 캐릭터가 뒤틀린 모양으로 생성되게 된다. BVH로 전환된 데이터는 TCP/IP 통신을 통해 실시간으로 Unity 게임 엔진으로 전달되며, 모션데이터는 FBX 파일로 저장하여 가상현실 속의 캐릭터 움직임으로도 사용할 수 있다.

모션캡처 장비의 데이터를 Axis Studio에서 보정한 후, Unity 게임 엔진에서 사용할 수 있도록 연결하는 과정이 필요하다. PNS와 Unity 연동을 위해서는 Axis Studio와 Unity 캐릭터에 부착된 Perception NeuronTransformsInstance.cs의 IP Adress를 127.0.0.1, Port를 7001로 TCP 통신으로 통일한다. Axis Studio를 거쳐서 받아오는 모션데이터를 Unity 아바타에 넣기 위해서는 캐릭터 리타게팅 과정이 필요하다.

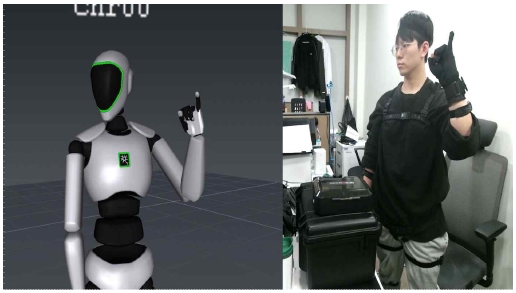

캐릭터 리타게팅은 모션캡처 과정을 거친 원본의 신체 관절 데이터와 캐릭터의 관절 값 오류를 최소화하여 옮기는 과정을 뜻한다[26]. Connect To Axis와 Bind 과정으로 리타게팅 후 플레이를 시키면 그림 4처럼 Unity 게임 화면 속 캐릭터가 신체 움직임에 따라 실시간으로 똑같이 움직임을 확인할 수 있다.

본 논문에서는 Unity에서 VR을 쉽게 사용할 수 있도록 제작한 XR Interation Toolkit을 사용하였다. 사용자 접근성을 높이기 위해서 Vive와 Oculus 두 장비를 모두 사용할 수 있도록 ProjectSettings - Player에서 Virtual Reality Supported에 체크하고 Oculus와 OpenVR을 둘 다 추가했다. XR Rig로 HMD와 Unity Camera를 연결하면 Unity에서 VR을 사용할 수 있게 된다. 가상현실 속에서 가상 캐릭터의 신체를 자신의 신체처럼 생각하게 만드는 신체 소유감을 생성하기 위해서는 캐릭터의 눈이 바라보고 있는 시점과 HMD를 착용했을 때 보고 있는 시점이 똑같아야 한다. HMD와 연결된 XR Rig의 Camera가 실시간 모션캡처로 움직이는 캐릭터의 눈을 따라가도록 한다. 이후 HMD를 착용하면 카메라가 캐릭터의 눈의 되어 움직이기 때문에 가상 캐릭터의 신체가 자신의 신체처럼 느껴지는 효과를 받을 수 있어 큰 몰입감을 더해줄 수 있다.

4.3 원격 교육 실시간 동기화 환경 구현

본 논문에서는 원격 교육 실시간 동기화 환경을 구현하기 위해서 Photon Server의 PUN2(Photon Unity Networking)를 사용한다. PUN2는 Unity를 이용하는 모든 타입의 룸 기반 멀티플레이어 게임용 유니티 패키지이며 모바일과 데스크톱, 웹 등으로 출력하여 사용 가능한 크로스 플랫폼(Cross-platform) 서비스이다[27]. Photon 네트워크 로그인 후 계정 내 App ID로 네트워크를 접속한 사용자들이 공동 서버를 공유하게 된다. 네트워크 동기화는 2가지 타입으로 분류하여 사용하게 된다. 첫 번째로 연속적으로 캐릭터의 위치 정보를 계속 받아와야 하는 경우 Photon View Component를 캐릭터에 적용하여 객체 동기화를 사용하는 방식이다. 두 번째로 이벤트 함수에 [PUNRPC]를 적용하여 각 사용자의 함수를 호출하는 방식을 사용해야 한다.

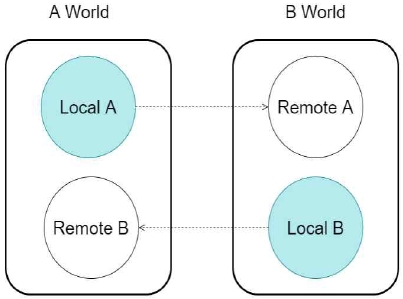

그림 5는 2명의 사용자가 원격 멀티플레이를 진행하는 월드의 동기화 방식을 도식화한 것이다. A사용자의 A World의 Local A는 A 사용자의 오브젝트를 표현한 것이다. A와 B의 네트워크가 연결되면 B World에는 Local A와 다르지만 동일한 식별자를 부여받은 Remote A가 생성되게 된다. A World 입장에서 보았을 때 Remote A가 생성되었을 때 photonView의 Ismine 구문을 통해 이 오브젝트가 본인과 같은 오브젝트라는 것을 판단하게 되면 동기화가 된다. PNSModel 캐릭터 동기화를 위해서는 Photon Transform View Component를 각 오브젝트에 적용하여 움직임과 크기, 회전 등을 동기화시켜야 한다. photonView Photon Server에서 생성되는 Prefab은 Assets/Resources 폴더에서만 생성할 수 있으므로 VR에 사용할 NetworkPlayer와 MOCAP으로 사용할 PNSModel의 Prefab을 Resources 폴더에 위치시킨다.

지연시간(Latency)은 하나의 데이터가 다른 지점으로 전송되어 발생하는 시간을 의미하며, ㎳(1/1000초)를 단위로 사용한다. 원활한 가상 원격교육 진행을 위해서는 지연시간이 100㎳ 이하로 짧게 나올수록 좋으며, 300㎳ 이상이 나오면 사용자는 실시간 상호작용에 어려움을 느낀다[27]. 본 실험에서는 모션캡처 데이터와 HMD를 착용한 사용자와 HMD만 착용한 사용자가 PUN2로 동기화하여 원격 활용하였을 때 지연시간을 측정하였다. 한국지능정보사회진흥원(NIA)으로 인터넷 속도 측정을 진행하였으며 인터넷 평균속도는 433.16Mbps였다. 두 명의 사용자가 Photon Server에 접속하면 화면에 지연시간이 2초 간격으로 생성되도록 하였으며 지연시간 측정 실험을 100회 이상 진행하였을 때 평균값은 31㎳로 측정되었다.

4.4 제조 원격 교육 콘텐츠

제조업 작업 현장에서는 장시간 동일 작업을 진행하기 때문에 정확하고 안전한 동작으로 작업을 진행해야 한다. 장비 운용 중 맞닥뜨릴 수 있는 다양한 위험 상황을 실감 나게 시뮬레이션할 수 있는 가상훈련 콘텐츠들도 늘어나고 있다. 이런 가상훈련 콘텐츠는 위험 작업을 매일 수행하는 작업자의 안전 기술 향상을 높이기 위한 훈련 프로그램에 적용할 수 있다[28]. 제조업 원격 교육 콘텐츠에서 비숙련자는 모션캡처 장비와 HMD를 착용하고, 숙련자는 HMD를 착용하여 가상 제조업 환경에서 원격으로 협업을 진행한다.

그림 6을 보면 콘텐츠를 시작했을 때 HMD만으로 접속할 것인지, 모션캡처와 HMD를 착용하고 접속할 것인지 선택하게 되는 버튼이 나타나게 된다. HMD를 선택하면 룸에서 공장 안전모를 착용한 모습의 NetworkPlayer Prefab이 생성되고, 모션캡처를 선택하면 PNSModel Prefab이 생성되어 한 공간에서 동기화된다.

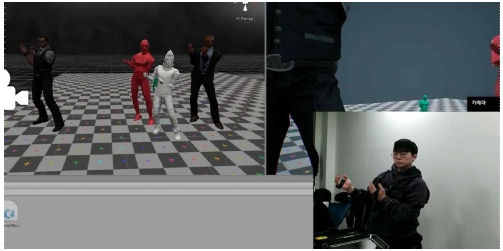

표 3에서는 실시간 동기화를 통해 가상 원격 훈련을 진행하는 모습을 볼 수 있다. 숙련자와 비숙련자는 같은 룸으로 접속한다. 숙련자는 비숙련자에게 일정한 과업을 지시하고, 비숙련자의 캐릭터 행동을 관찰하며 관리자 관점에서 비숙련자에게 여러 가지 자세를 수정해주고 효과적인 동선을 알려준다. 비숙련자는 숙련자에게 모르는 부분이나 궁금한 점을 추가로 질문하고 답을 얻으며 의사소통을 진행하며 교육을 받게 된다.

가상현실 표현 기술은 시각, 청각, 촉각 등 인간의 감각을 기반으로 개발되고 있다. 시각 관련 기술은 컴퓨터 그래픽 기술의 발달로 실시간 렌더링이 가능해져서 실제 세계와 가상세계를 구분하기 어려울 정도로 발전했다. 원격협업 시에 시각 관련 기술만큼 중요한 것은 청각 관련 기술이다. 현실에서 들을 수 있는 소리의 방향감과 거리감, 공간감을 표현하는 입체적인 가상 음향 환경은 가상현실 구축에서 필수적으로 요구된다[4]. 가상 음향 환경을 구축하여 원활한 사용자 의사소통을 진행하기 위해 Photon Voice를 활용하여 사용자 의사소통을 진행하였다.

Photon Voice는 Skype와 공동 개발한 오푸스 코덱을 이용하여 높은 수준의 오디오 퀄리티를 제공하며, 3D 오브젝트에 보이스 소스를 추가할 수 있기 때문에 생성되는 캐릭터 모델에 오디오를 추가하여 사용할 수 있다.

또한, 전 세계에 있는 Photon Cloud에 호스팅 되고 있으므로 낮은 레이턴시와 최단 RTT(Round Trip Time, 왕복 시간)을 보여주어 자연스러운 의사소통이 가능해지도록 도와준다[27]. 원격교육을 진행하면 비숙련자는 시뮬레이션을 진행하게 되며, 모션캡처 캐릭터를 보고 비숙련자의 작업 자세를 판단한 숙련자는 올바른 자세와 행동절차를 PhotonVoice를 통해 음성으로 교육하며 의사소통을 진행할 수 있다.

Ⅴ. 결론 및 기대효과

본 논문에서는 최근 COVID-19 사태 이후 비대면 원격 교육 서비스의 수요 증가로 인해 주목받고 있는 가상현실 기술에 모션캡처 기술을 더하여 뛰어난 몰입감으로 실제처럼 훈련 가능한 가상 원격 교육시스템을 제안하였다. 본 시스템에 사용되는 모션캡처 장비는 이동성이 좋으며 케이블이나 추가적인 카메라가 필요 없으므로 전 세계 어느 위치에서든지 원격으로 접속할 수 있다. 실제로 체험하며 훈련하던 시뮬레이션 교육과 비교했을 때 비용과 시간을 절약할 수 있는 효과적인 교육시스템이다.

본 시스템은 고위험 고비용 분야의 장비들이 고가화, 대형화됨에 따라 제조나 의료, 국방 등의 분야에 우선 도입이 필요하다. 하지만 기술 완성도와 산업 생태계 구축의 부족함으로 현업에 바로 적용하기 어렵다는 점이 있다. 또한, 비광학식 모션캡처 장비의 특성상 캡처 시간이 길어지면 정밀도가 떨어진다는 점이 있다. 모션캡처 장비와 VR HMD 기기의 동시 착용으로 인한 불편함이 완벽하게 해소되기 어렵다. 이런 불편함으로 인해 장시간 교육의 활용성이 떨어지는 문제점은 오큘러스 퀘스트2 등의 무선 HMD 장비연동을 통해 해결해 나갈 것이다. 추후 모션캡처 장비를 세 대 이상 추가하여 다중 원격 협업 시스템 개발연구로 이어질 것이다.

Acknowledgments

이 논문은 2021년도 창원대학교 학생주도 창의연구프로젝트 지원사업으로 수행된 연구결과임

References

- I. E. Sutherland, "A head-mounted three dimensional display", Fall joint computer conference, San Francisco California, USA, pp. 757-764, Dec. 1968.

-

S. H. Han and J. M. Kim, "A study on immersion of hand interaction for mobile platform virtual reality contents", Symmetry, Vol. 9, No. 2, Feb. 2017.

[https://doi.org/10.3390/sym9020022]

-

S. J. Park, W. J. Park, H. Y. Heo, and J. M. Kim, "A Study on Presence of Collaboration based Multi-user Interaction in Immersive Virtual Reality", Journal of the Korea Computer Graphics Society, Vol. 24, No. 3, pp. 11-20, Jul. 2018.

[https://doi.org/10.15701/kcgs.2018.24.3.11]

-

J. H. Lee, "VR System Environment Technologies and User Input Elements", The Korean Society Of Design Cu, Vol. 24, No. 2, pp. 585-596, Jun. 2018.

[https://doi.org/10.18208/ksdc.2018.24.2.585]

- D. W. Lee, "Virtual/Augmented Reality Application Trends in Education", IITP, pp. 2-14, Jun. 2021

- https://www.moe.go.kr/boardCnts/viewRenew.do?boardID=294&boardSeq=81865&lev=0&searchType=null&statusYN=W&page=3&s=moe&m=020402&opType=N, . [accessed: Sep. 28, 2021]

-

E. J. Song, "Scenario Planning for Fire Disaster Response Virtual Training System Reflecting Trainee behavior Cases", Journal of DCS, Vol. 20, No. 12, pp. 2565-2571, Dec. 2019.

[https://doi.org/10.9728/dcs.2019.20.12.2565]

- J. W. Moon and H. J. Kang, "Analysis of usage in education/training field using virtual/augmented reality (XR)", National IT Industry Promotion Agency, Vol. 19, pp. 1-23, Dec. 2020.

-

S. Gallagher, "Philosophical conceptions of the self: implications for cognitive science", Trends in cognitive sciences, Vol. 4, No. 1, pp. 14-21, Jan. 2000.

[https://doi.org/10.1016/S1364-6613(99)01417-5]

- S. U. Lee and D. H, Chung, "The Influence of Additional Haptic Feedback on Interactivity and Body Ownership in Virtual Real", Journal of Korea Game Society, Vol. 20, No. 5, pp. 31-40, Oct. 2020.

- S. J. Gong, "Motion capture and video motion analysis", Sports science, pp. 40-45, Feb. 2019.

- G. S. Byeon, "Development of motion capture technology and application of sports science", Sports science, pp. 40-45, Nov. 2020.

-

Tee. Kian Sek et al., "A study on the ergonomic assessment in the workplace", AIP Conference Proceedings. AIP Publishing LLC, Johor, Malaysia, Vol. 1883, No. 1, Sep. 2017.

[https://doi.org/10.1063/1.5002052]

-

M. Naeemabadi, B. Dinesen, O. K. Andersen, and J. Hansen, "Influence of a Marker-Based Motion Capture System on the Performance of Microsoft Kinect v2 Skeleton Algorithm", IEEE Sensors Journal, Vol. 19, No. 1, pp. 171-179, Jan. 2019.

[https://doi.org/10.1109/JSEN.2018.2876624]

- Y. B. Kim and B. H. Park, "VR/AR/MR virtual training system technology trend", The Journal of The Korean Institute of Communication Sciences, Vol. 36, No. 10, pp. 72-78, Sep. 2019.

-

S. N. Haam, J. Lee, and S. H. Lee, "Research on necessity and applicability of virtual training for effective police counterterrorism drills", International journal of highway engineering, Vol. 22, No. 2, pp. 69-78, Apr. 2020.

[https://doi.org/10.7855/IJHE.2020.22.2.069]

- http://www.soltworks.com/solution/simulation, . [accessed: Sep. 29, 2021]

-

J. M. Shin, S. H. Lee, J. E. You, C. H. Roh, J. A. Oh, and S. Y. Kim, "Development and Evaluation of a Virtual Maintenance Training System for Thermal Power Plant Boiler", Journal of Digital Contents Society, Vol. 22, No. 5, pp. 791-800, May 2021.

[https://doi.org/10.9728/dcs.2021.22.5.791]

- Y. I. Shing and H. Y. Lim, "The Effect of Training Using Virtual Reality System On Balance and Gait for Stroke Patients", Journal of Coaching Development, Vol. 9, No. 1, pp. 126-135, Mar. 2007.

- S. J. An, "Virtual reality (VR) based construction worker safety training", Construction Engineering and Management, Vol. 21, No. 1, pp. 28-31.

- https://unity.com/kr, . [accessed: Sep. 29, 2021]

-

E Kučera, O. Haffner, and R. Leskovský. "Multimedia Application for Object-oriented Programming Education Developed by Unity Engine", In : 2020 Cybernetics & Informatics (K&I), Velke Karlovice, Czech Republic, pp. 1-8, Feb. 2020.

[https://doi.org/10.1109/KI48306.2020.9039853]

-

H. S. Kim, N. Hong, and M. Kim et al., "Application of a perception neuron® system in simulation-based surgical training", Journal of clinical medicine, Vol. 8, No. 1, pp. 124, Jan. 2019.

[https://doi.org/10.3390/jcm8010124]

-

R. Sers, et al., "Validity of the Perception Neuron inertial motion capture system for upper body motion analysis", Measurement, Vol. 149, Jan. 2020.

[https://doi.org/10.1016/j.measurement.2019.107024]

- https://www.neuronmocap.com/, . [accessed: Sep. 29, 2021]

-

M. Gleicher, "Retargetting motion to new characters", In Proceedings of the 25th annual conference on Computer graphics and interactive techniques, New York, USA, pp. 33-42, Jul. 1998.

[https://doi.org/10.1145/280814.280820]

- https://www.photonengine.com/en-US/Photon, [accessed: Sep. 30, 2021]

- S. J. Ahn, "Virtual reality (VR) based construction worker safety training", Korea Institute of Construction Engineering and Management, Vol. 21, No. 1, pp. 28-31, Feb. 2020.

2020년 2월 : 창원대학교 문화테크노학과 학사

2020년 3월 ~ 현재 : 창원대학교 문화융합기술협동과정 석사과정

관심분야 : 문화기술융합, 컴퓨터비전, 증강/가상현실, HCI

2006년 2월 : 연세대학교 컴퓨터공학과(공학석사)

2011년 2월 : 연세대학교 컴퓨터공학과(공학박사)

2016년 3월 ~ 현재 : 강남대학교 소프트웨어응용학부 교수

관심분야 : 가상현실, 증강현실, 모바일컴퓨팅, 기계학습, HCI

2003년 8월 : 고려대학교 전자정보공학(공학사)

2006년 2월 : 연세대학교 생체인식공학(공학석사)

2011년 2월 : 연세대학교 전기전자공학(공학박사)

2011년 ~ 2012년 : LG전자기술원 미래IT융합연구소 선임연구원

2012년 ~ 2013년 : 연세대학교 전기전자공학과 연구교수

2013년 ~ 2016년 : 제주한라대학교 방송영상학과 조교수

2016년 ~ 2019년 : 동명대학교 디지털미디어공학부 부교수

2019년 9월 ~ 현재 : 창원대학교 문화테크노학과 부교수

관심분야 : 컴퓨터비전, 증강/가상현실, HCI