영상처리 및 딥러닝을 이용한 레미콘 슬럼프 질기 식별 및 분석

초록

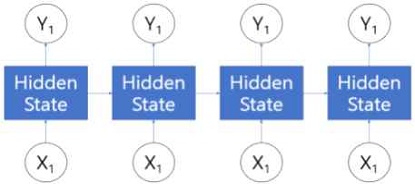

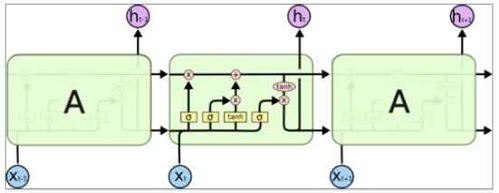

레미콘의 슬럼프 품질관리는 현재 샘플링으로 검사되어 전량검사보다 정확도가 떨어지며 현재의 방법으로는 시간도 오래 걸린다. 본 논문에서는 슬럼프 콘을 이용한 현재의 방식 대신 카메라를 통해 획득한 비디오 영상을 기반으로 콘크리트 슬럼프의 질기를 파악하는 방법을 기술하였다. 이 방법은 LBP(Local Binaray Pattern), GLCM(Gray-Level Co-occurrence Matrix)의 기본적인 영상처리와 Optical Flow를 사용하여 영상에서의 속력을 계산한 뒤 LSTM(Long Short-Term Memory Recurrent Neural Network)을 활용하여 구현하였으며 비디오 데이터를 통해 슬럼프 질기를 분석하였다.

Abstract

The quality management of the slump of ready-mixed concrete is currently inspected by sampling, which is less accurate than the full-scale inspection, and it takes longer to use the current method. In this paper, instead of the current method using a slump cone, a method of grasping the toughness of a concrete slump based on video images acquired through a camera was described. This method was implemented using basic image processing and Optical Flow of Local Binaray Pattern (LBP) and Gray-Level Co-occurrence Matrix (GLCM), and then a long short-term memory current neural network (LSTM) was used to analyze the slump.

Keywords:

slump, ready-mixed concrete, image processing, deep-learning, image-basedⅠ. 서 론

콘크리트의 품질을 일정하게 유지하기 위해 슬럼프의 반죽 질기 정도 분석은 필수 항목이다. 콘크리트는 화학 혼화제, 물, 굵은 골재, 잔골재, 시멘트를 혼합하여 만들어지며 이들의 비율을 통해 콘크리트 슬럼프의 점도가 결정된다.

슬럼프는 본래 슬럼프 콘을 통해 분석된다. 이러한 슬럼프 콘을 통해 만들어진 영상을 분석하여 레미콘의 품질관리를 하는 연구로는 김수연 등 2명의 논문[1]과 딥러닝 및 스테레오 비전 기법을 기반으로 슬럼프 콘을 통해 슬럼프를 시험한 다음 이를 위에서 찍어 3가지 슬럼프로 분류한 논문[2]이 있다. 하지만 이는 콘크리트의 슬럼프 시험 방법을 한국 국가표준인 KS F 2402[3]에 나온 슬럼프 단위측정 방법으로 매번 모든 레미콘의 슬럼프를 측정하는 데에는 무리가 있다. 또한 매번 슬럼프 단위측정 방법으로 슬럼프를 측정하게 되면 시험자마다 다른 결과 값이 나올 수 있다.

또한, 레미콘은 가만히 두면 굳는다는 특수한 성질 때문에 다른 액체처럼 센서를 사용하여 측정하기가 쉽지 않다. 따라서 우리는 실시간으로 레미콘의 슬럼프를 측정하고 액체에 직접 닫지 않는 센서를 사용하여 보다 객관적인 슬럼프 측정 방법이 필요하다.

콘크리트의 재활용을 위해 물과 시멘트, 거친 골재, 화산재 대체 비율 등으로 딥러닝을 통해 압축강도를 예측하는 논문[4]과 슬럼프 재료의 혼합 비율을 통해 고성능 콘크리트의 슬럼프를 예측하는 논문[5]도 있다. 그리고 콘크리트를 배합하는 영상을 통해 CNN과 LSTM(Long Short-Term Memory)으로 분석하여 슬럼프를 측정한 논문[6][7]이 있다.

기존에 슬럼프 콘을 통해 슬럼프를 측정하는 방식을 실시간 측정하는 방향으로 연구를 하고자 하여 LBP와 GLCM(Gray-Level Co-occurrence Matrix), Optical Flow의 영상처리를 통해 슬럼프를 분류하고자 하였다.

본 논문은 레미콘을 배합하는 영상으로 목측을 통해 슬럼프를 판단할 수 있으므로 영상을 통해서도 콘크리트의 질기에 대한 특징점 검출이 가능하다고 판단하여 레미콘을 배합하는 영상을 통해 슬럼프의 질기 정도 분석을 하려고 한다. 어두운 레미콘 배합기계 내부를 촬영하기 위해 적외선 카메라를 사용하였고, 이를 통해 얻은 영상으로 콘크리트 슬럼프의 점도를 파악할 수 있는 알고리즘을 고안하였다.

콘크리트의 표면을 보고 LBP, GLCM의 영상처리 알고리즘으로 질감을 분석한 이전 논문[8]의 방법과 영상에서의 물체의 속도를 구하는 Optical Flow의 방법으로 패치 대응에 대한 역 검색, 여러 크기의 패치 집계를 통한 밀도 높은 변위 필드 생성, 변이 정교화의 3가지 특징으로 계산 속도를 더 빠르게 한 DIS(Dense Inverse Search) Optical Flow[9]의 방법으로 속력 및 속도를 분석하여 KS F 4009[10]규격으로 명시된 80, 120, 150, 180, 210의 콘크리트의 슬럼프 규격을 검출하였다. 몇 몇의 실험은 슬럼프 품질의 선형적인 특징이 두드러지는 일부의 데이터만으로 실험을 진행하였다.

Ⅱ. 연구 내용

2.1 데이터

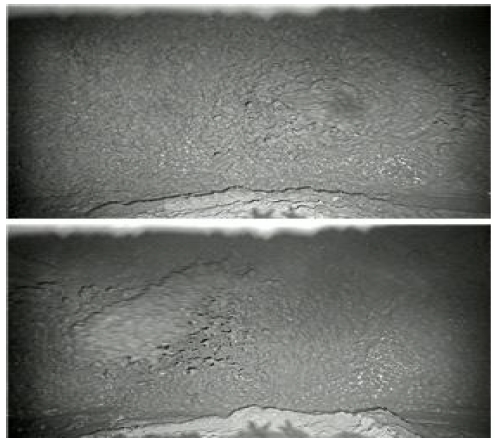

연구로 쓰인 데이터는 콘크리트 재료들을 혼합한 뒤 콘크리트 믹서 내부의 믹싱과정을 30FPS로 촬영한 5초 동영상으로서 총 150프레임이다. 영상의 Gain은 47dB로 하였고 노출 값은 1/60초로 하였다.

레미콘의 한국 규격을 명시한 KS F 4009의 80, 120, 150, 180, 210의 슬럼프를 기준으로 하고 80, 100, 120, 130, 140, 150, 160, 170, 180, 200, 210의 슬럼프를 슬럼프 단위 측정 방법(KS F 2402)을 이용하여 콘크리트 슬럼프 데이터를 라벨링 하였다. 80, 120, 150, 180, 210 단위별 각 48개의 데이터를 학습으로 사용하였다. 하나의 값만을 찍어도 정확도가 높지 않도록 데이터의 개수를 맞추었다. 이 동영상은 그림 1에 나와 있는 예시와 같다.

영상의 전처리는 따로 하지 않았고 다만 카메라에서 Gain을 47dB를 주어 영상을 밝게 하였다. 딥러닝 학습에 쓰인 데이터는 그림 1과 같고 표 1과 같이 분류하여 학습시켰다.

2.2 이론적 배경

3번에 걸쳐 슬럼프 콘에 슬럼프를 넣은 후 슬럼프 봉을 통해 다져준다. 이후 슬럼프 콘을 위로 올려 남아있는 레미콘의 무너진 정도를 기존의 슬럼프 콘의 높이인 300mm와 비교하여 슬럼프를 구한다. KS F 2402[3]에 따라 슬럼프를 80, 120, 150, 180, 210으로 분류하였다. KS F 2402에 나와있듯이 오차범위는 ±25mm이다. 이에 대한 자세한 내용은 KS F 2402에 서술되어 있다.

DIS Optical Flow[9]는 영상의 특징점의 밝기 값은 변화하지 않고 그 주변 픽셀의 밝기 값도 변화하지 않는다고 가정한 후에 이를 테일러 급수를 통해 전개하여 영상의 전체적인 속도를 계산하는 방식이다. 하지만 계산한 영역에서의 전체적인 속도만을 구할 수 있으므로 영상을 여러 조각으로 자른 뒤 계산하여 영상의 속도들을 계산하는 방식이다.

2.3 슬럼프 판별 방법

기본적인 질감 및 패턴을 판별할 수 있는 영상처리방법과 영상처리를 기반으로 속력, 속도, 차영상 등의 특징을 검출하여 딥러닝으로 학습시키는 방법을 사용하였다. LBP[13]와 GLCM[14]은 Kim Seong-kyu등 4명이 연구한 논문[8]의 내용으로 간략하게 설명하겠다.

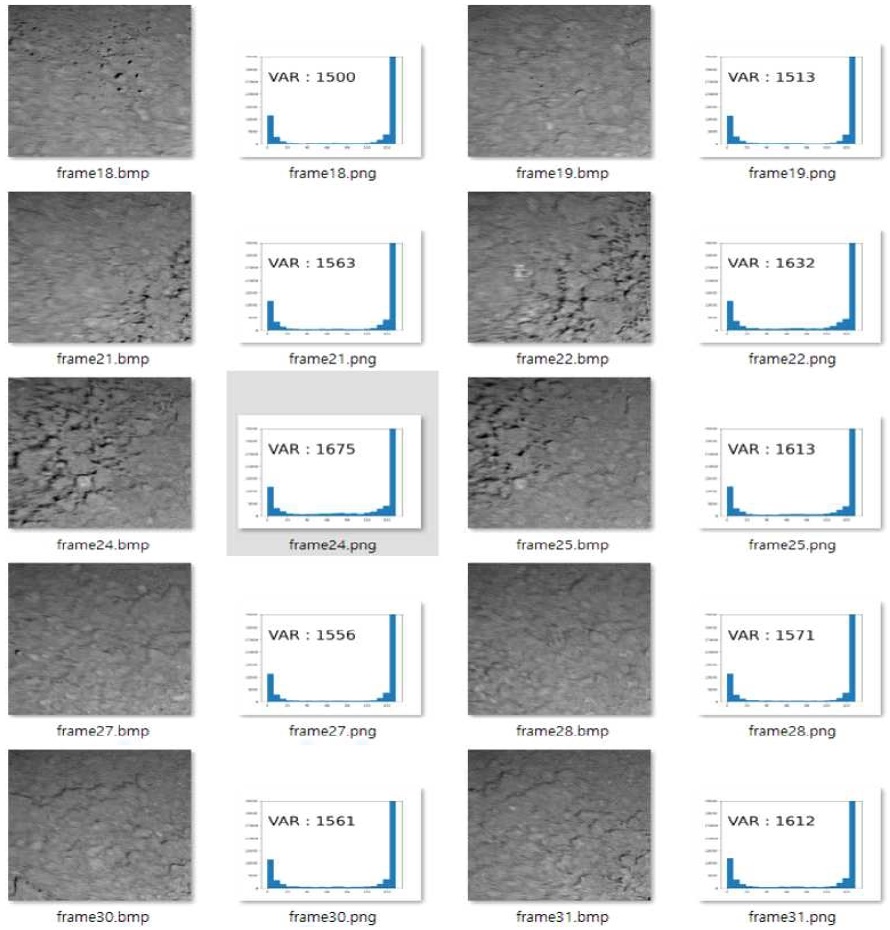

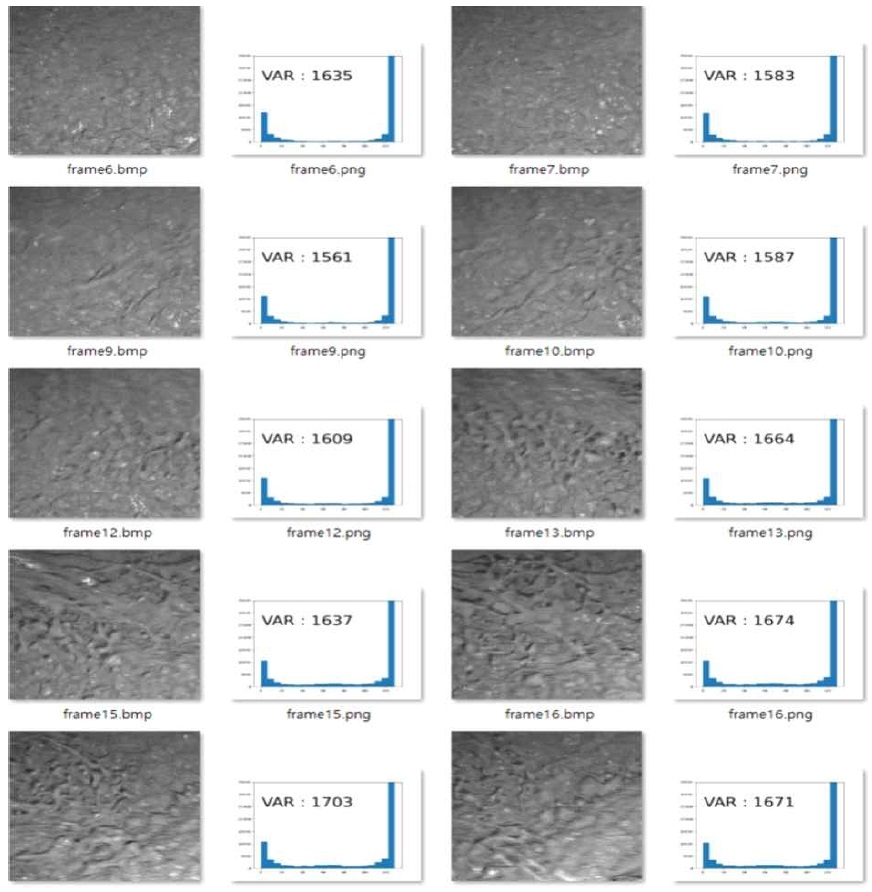

블레이드에서 영상의 특정지점 [500:800, 200:500]을 각 프레임별로 추출하여 LBP 히스토그램을 만들었다. 원의 반경은 6로 하였고 원형 대칭 인접 설정 점의 수는 128로 하였다. 이때, 60슬럼프의 데이터와 210슬럼프의 데이터를 비교한 결과로 특징점 검출이 어렵다고 판단되었다. 또한 히스토그램에서의 분산을 측정해 보았지만 딱히 차이점은 없었다. 이에 대한 내용은 그림 4와 그림 5에 나와 있다.

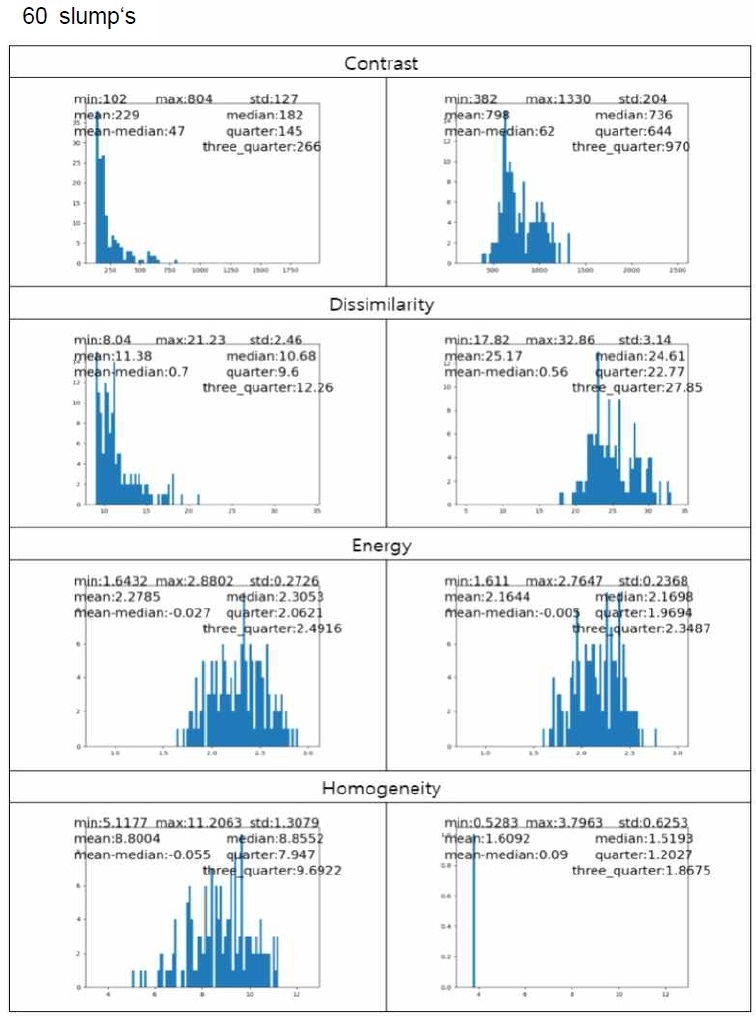

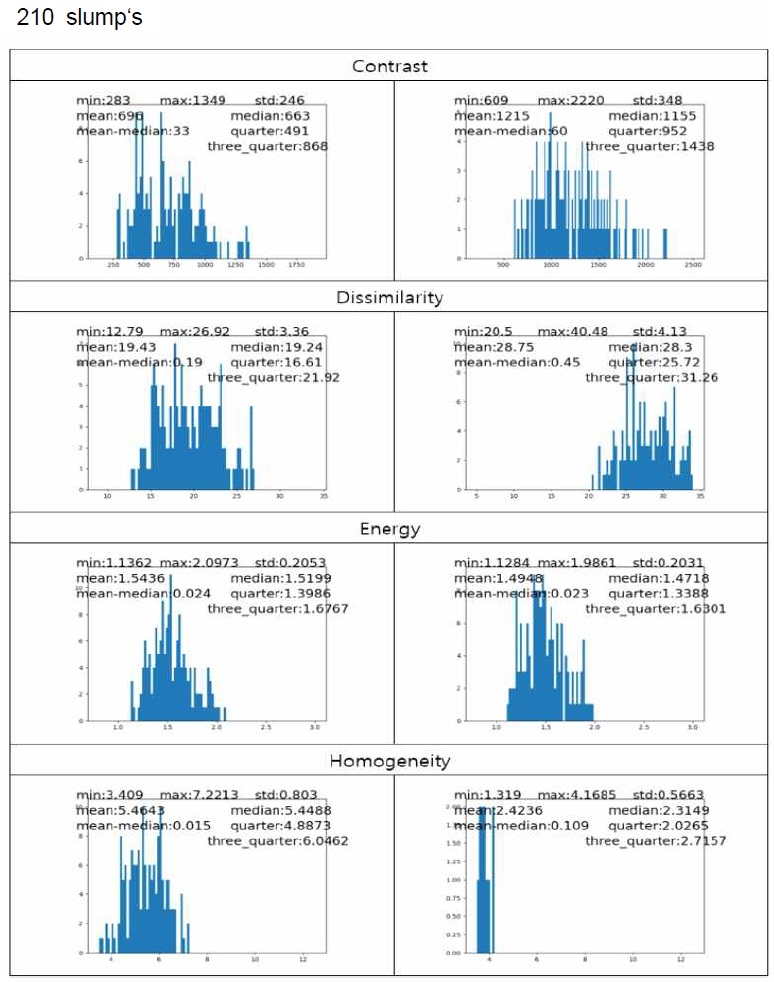

블레이드의 영향이 없을 때 슬럼프에 따라서 속도가 가장 많이 영향 받는 영상의 특정지점 [x축 : 500~800, y축 : 200~500]을 각 프레임별로 추출하여 GLCM을 만든 후 여러 가지의 특징을 뽑을 수 있다. 여기서는 식 (1) ~ (4)의 4가지 특징을 뽑아 콘크리트의 점도를 계산하였다.

a) Contrast Feature

| (1) |

b) Dissimilarity

| (2) |

c) Energy

| (3) |

d) Homogeneity

| (4) |

이들의 특징을 뽑아 표 2에 정리해 비교하였다.

그림 6과 그림 7은 GLCM에서 뽑아낸 각각의 특징들의 최소값, 평균값, 평균값에서 중앙값을 뺀 값, 최대값, 표준편차, 중앙값, 1/4값, 3/4값들을 추출하여 계산한 결과이다. 각각 하나의 영상을 가지고 비교하였을 때 선형성을 가지는 특징이 있지만 영상의 초점이 맞을 때와 약간 흐릿할 때가 있기 때문에 피라미드 이미지를 적용하였으나 단순히 영상에서의 질감을 가지고 슬럼프를 나누는 것은 한계가 있어 보인다.

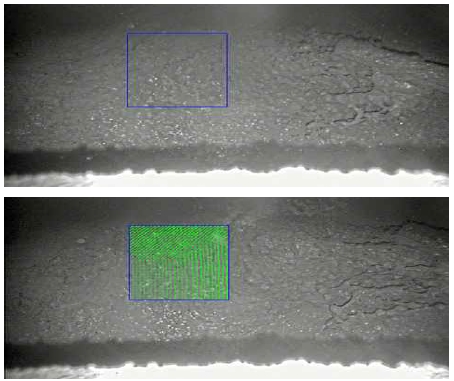

슬럼프의 점도가 높으면 콘크리트의 속력이 느렸고 점도가 낮으면 속력이 높은 점을 이용해 영상에서 콘크리트의 속력을 검출하여 학습시켰다. 그림 8은 Optical Flow를 통해 얻은 속력을 나타낸 것이다.

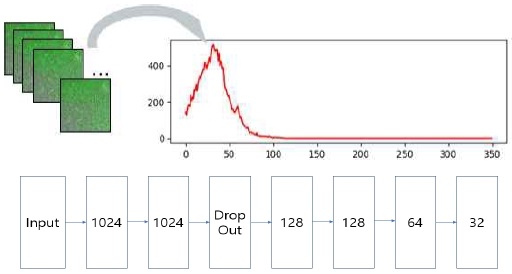

먼저, 영상의 ROI를 설정하였고 여기에 DIS Optical Flow방법을 적용하여 콘크리트 표면의 속력을 얻어 이를 일정한 영역으로 분할 뒤 각 속력을 얻어내 이를 누적시켜 값을 얻은 속력 히스토그램을 학습시켰다.

데이터 구조와 딥러닝 네트워크 구조는 그림 9에 나타내었다.

이를 80과 210의 2개의 클래스를 60프레임으로 학습시켜 분류하였을 때는 91%의 확률로 분류를 하였다. 하지만 실제로 3클래스와 5클래스로 분류하였을 때는 정확도가 떨어지므로 속력 합산 신경망은 적합하지 못하다고 할 수 있다.

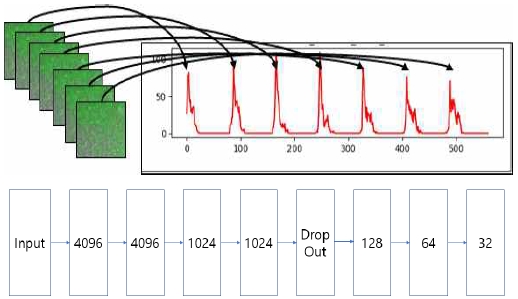

속력 합산 신경망과 같이 영상의 ROI를 설정하였고 여기에 Optical Flow방법을 적용하여 매 프레임마다 속력을 구하였고 속력 히스토그램을 일렬로 나열한 데이터를 학습시켰다. 이 신경망에 쓰인 데이터 구조는 그림 10과 같다.

이를 80, 150, 210의 3개의 클래스로 분류하였을 때는 86%의 확률로 분류하였고, 80, 120, 150, 180, 210의 5개의 클래스로 분류하였을 때는 81%의 정확도로 분류하였다.

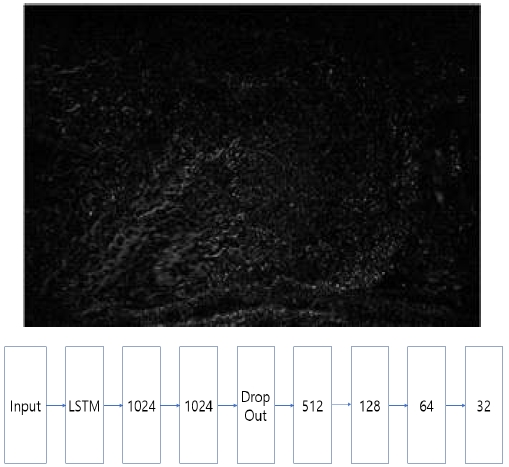

믹서 날이 동일한 시점을 지나도록 설계하였으므로 믹서 날에 붙은 콘크리트나 물결의 파형과 흐름을 통해 학습할 수 있다. 이를 위해 차영상을 만들어 이를 학습할 수 있다. 또한 차영상을 사용함으로써 조명의 영향을 덜 받게 된다. 차영상 신경망에 사용한 데이터는 그림 11의 예시로 나타내었다.

ROI를 설정하여 영상의 일부분을 취득하였고 60 프레임만을 학습데이터로 사용하였다. 결과적으로 80, 150, 210의 3클래스를 분류하였을 때 62%의 확률로 분류를 하여 이는 적합하지 않다고 볼 수 있다.

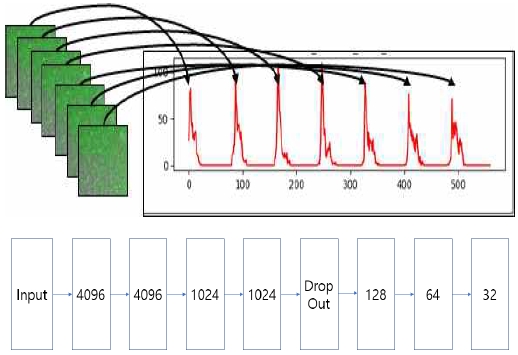

슬럼프의 속력과 방향을 학습한 신경망이다. 속력은 이전과 같이 일정한 영역(ROI)에서의 각 속력을 구했고 방향은 30도씩, 45도씩, 60도씩 분할하여 이 값을 각 프레임 마다 학습하였다. 이 값들을 일렬의 시계열 데이터로 얻어와 학습시켰다. 학습시킨 데이터의 구조는 그림 12와 같다.

이는 80, 150, 210의 3가지 클래스를 82%의 분류 정확도로 분류하였다.

Ⅲ. 실험 및 결과

LBP의 경우 이미지의 히스토그램이 거의 비슷하게 나왔다. 이는 너무 고전적인 알고리즘을 사용했기 때문이고 또한 이미지의 특징점이 크게 다르지 않았기 때문으로 보인다. 이는 GLCM을 사용한 알고리즘에서도 나타난다. 하지만 GLCM에서는 각각 하나의 영상을 가지고 비교하였을 때 선형성을 가지는 특징이 발견되기도 하였다. 하지만 몇몇의 데이터들은 선형적인 특징이 발견되지 않았다. 이는 영상의 초점이 맞을 때와 약간 흐릿할 때가 있기 때문이었다. 이는 피라미드 이미지를 적용해도 마찬가지였다. 따라서 단순히 영상에서의 질감을 판단하는 알고리즘을 가지고 슬럼프를 나누는 것은 한계가 있어 보인다.

Liu Yang 외 3명의 논문[6]에는 약 25개씩의 6개 그룹으로 학습하였고 TestData를 24개의 데이터밖에 쓰지 못하여 충분히 많은 데이터로 학습이 되었는지 또는 TestData의 개수가 적다고 생각된다.

Ahongcong Ding and Xuehui An의 논문[7]에는 31개의 데이터로 학습 및 Test를 하여 데이터가 충분하지 않다고 생각된다. 하지만 본 논문에서는 48개의 11개 클래스로 총 396개의 데이터를 학습시키고 66개를 Validataion set으로 사용하였고 66개를 Testset으로 사용하여 더 신뢰성이 있다.

속력 합산 신경망으로 학습을 하였을 때는 2개의 클래스를 60프레임 학습시켰을 때 91%의 정확도를 보였다. 또한, 속력-시간 동기화 신경망으로 학습을 하였을 때는 80, 150, 210의 3개의 클래스로 학습시켰을 때는 86%의 정확도로 분류를 하였고 80, 120, 150, 180, 210의 5개의 클래스로 학습을 시켰을 때는 81%의 정확도로 분류하였다. 차영상 신경망은 3가지 클래스를 62%의 확률로 분류하였다. 속도-시간 동기화 신경망은 82%의 분류 정확도로 분류하였다. 이를 표 3으로 정리하였다.

Kim Seong-kyu 외 4명 논문의 방식인 영상처리만으로 슬럼프를 판별하는 방식보다는 영상의 초점이 잘 맞지 않아도 분류를 잘 해내었다.

속력 합산 신경망은 영상에서의 모든 프레임에서 추출된 속력 히스토그램을 계산한 것으로 클래스를 분류하기에는 적합하지 않은 것으로 보이나 속력-시간 동기화 신경망과 속도-시간 동기화 신경망은 슬럼프에서의 특정 구간의 선형성이 눈에 띄었지만 잘 학습되지 않았다. 차영상 신경망은 높은 슬럼프에서는 레미콘이 물의 성질을 갖기 때문에 실제 슬럼프의 값과 전혀 다른 튀는 값을 추론한 사례가 많이 보인다.

기존의 슬럼프 콘으로 슬럼프 품질을 샘플링 검사하는 방식보다는 본 논문의 적외선 카메라를 통한 전량 검사를 통해 슬럼프 품질을 측정하는 방식이 실시간성을 보장해준다.

본 논문에 나온 분류방식으로 학습을 시켜보았지만 학습이 더 이상 진행되지 않는 수준의 정확도에 머물렀다. 속력-시간 동기화 신경망의 경우 3가지 클래스로 86%의 정확도로 분류할 수 있었고 속력-시간 동기화 신경망의 경우 5가지 클래스를 81%의 정확도로 분류하였다.

Ⅳ. 결 론

본 논문은 레미콘이 믹싱되는 과정을 영상으로 획득하여 슬럼프를 분석하는 방법이 제안되었다. 영상만으로 슬럼프를 예측하기 위한 방법들로 LBP와 GLCM의 영상처리를 사용하였고 또한 OpticalFlow를 사용하여 얻어낸 특징데이터를 딥러닝 모델에 넣어 학습시키기도 하였다.

사용된 데이터 수집방식은 고정된 카메라를 통해 일정한 촬영 각도 및 구도를 유지하여 촬영하였다. 또한, 본 논문의 모델은 다른 유형의 믹서에서도 동일한 방식으로 데이터를 수집하여 학습시킨다면 비슷한 결과가 나올 것으로 예상된다.

본 논문의 알고리즘으로는 KS규격에 나온 5가지 클래스로 분류하여 현장에서 이를 활용하여 실시간 슬럼프 품질 검사에 사용하여 스마트팩토리의 중간 2단계에 해당하는 실시간 모니터링이 가능하게 된다. 성능이 80%대에서 머물렀는데 이는 슬럼프를 분류하기 위해 적합한 특징 추출이 잘못되었을 수 있으며 이를 회귀 방식으로 학습을 시키거나 다른 방식으로 연구를 하여야 할 것으로 보인다. 이는 추후 연구를 통해 연구할 예정이다.

Acknowledgments

이 논문은 2021년도 정부(산업통상자원부)의 재원으로 한국산업기술진흥원(KIAT)의 지원을 받아 수행된 연구임(N0002429, 산업혁신인재성장지원사업)

References

- Suyeon Kim and Ki Bum Park,, "Design of mobile management program and real-time analysis of slump iamge for the quality control of concrete mixer", Korea Information Processing Society, Vol. 51, No. 67, pp. 231-234, May 2019.

-

Nguyen Manh Tuan, Quach Van Hau, Sangyoon Chin, and Seunghee Park, "In-situ concrete slump test incorporating deep learning and stereo vision", Automation in Construction, Vol. 121, Jan. 2021.

[https://doi.org/10.1016/j.autcon.2020.103432]

- https://e-ks.kr/streamdocs/view/sd;streamdocsId=72059226393090409, . [accessed: Dec. 14, 2021]

-

Fangming Deng, Yigang He, Shuangxi Zhou, Yun Yu, Haigen Cheng, and Xiang Wu, "Compressive strength prediction of recycled concrete based on deep learning", Construction and Building Materials, Vol. 175, pp. 562-569, Jun. 2018.

[https://doi.org/10.1016/j.conbuildmat.2018.04.169]

- Ramazan Ünlü, "An assessment of machine learning models for slump flow and examining redundant features", Computers and Concrete, Vol. 25, pp. 565-574, Jun. 2021.

-

Liu Yang, Xuehui An, and Sanlin Du, "Estimating workability of concrete with different strength grades based on deep learning", Measurement, Vol. 186, Dec. 2021.

[https://doi.org/10.1016/j.measurement.2021.110073]

-

Zhongcong Ding and Xuehui An, "Deep Learning Approach for Estimating Workability of Self-Compacting Concrete from Mixing Image Sequences", Hindawi, Vol. 2018, Nov. 2018.

[https://doi.org/10.1155/2018/6387930]

- Kim Seong-kyu, Park Jeong-min, Lee Won-gok, and Bae You-suk, "Slump Viscosity Recognition and Analysis Using Image-based Image Processing Of Concrete Dough", Journal of MITA, Jul. 2021.

-

T Kroeger, R Timofte, D Dai, and L Van Gool, "Fast optical flow using dense inverse search", European Conference on Computer Vision, Amsterdam, The Netherlands, pp. 471-488, Mar. 2016.

[https://doi.org/10.1007/978-3-319-46493-0_29]

- https://e-ks.kr/streamdocs/view/sd;streamdocsId=72059208339091495, . [accessed: Dec. 14, 2021]

-

K. Cho et al., "Learning phrase representations using RNN encoder-decoder for statistical machine translation", Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP), Doha, Qatar, pp. 1724–1734, Jun. 2014.

[https://doi.org/10.3115/v1/D14-1179]

- Has¸im Sak, Andrew Senior, Franc, and oise Beaufays, "Long Short Term Memory Recurrent Neural Network Architectures for Large Scale Acoustic Modeling", google, pp. 338-342, 2014.

-

Timo Ojala, Matti Pietikainen, and Topi Maenpaa "Multiresolution Gray-Scale and Rotation Invariant Texture Classification with Local Binary Patterns", IEEE Explore, Vol. 24, No. 7, pp. 971-987, Jul. 2002.

[https://doi.org/10.1109/TPAMI.2002.1017623]

-

A. Baraldi and F. Parmiggiani, "An investigation of the Textural Characteristics Associated with Gray Level Cooccurrence Matrix Statistical Parameters", IEEE Explore, Vol. 33, No. 2, pp. 293-304, Mar. 1995.

[https://doi.org/10.1109/tgrs.1995.8746010]

1998년 2월 : 가천대학교 응용통계학과(공학사)

2000년 10월 : 숭실대학교 산업정보시스템공학과(공학석사)

2014년 09월 ~ 현재 : 스마트제조혁신추진단 기술위원

관심분야 : 스마트공장구축, 산업인공지능

2020년 02월 : 한국산업기술대학교 전자공학과 (학사)

2021년 03월 ~ 현재 : 한국산업기술대학교 스마트팩토리융합학과 (석사)

관심분야 : 컴퓨터비전, 스마트공장

2006년 02월 : 한국산업기술대학교 컴퓨터공학과(공학사)

2008년 02월 : 한국산업기술대학교 컴퓨터공학과(공학석사)

2012년 02월 : 한국산업기술대학교 컴퓨터공학과(공학박사)

2020년 04월 ~ 현재 : 한국산업기술대학교 인공지능기술사업화연구소 연구교수

관심분야 : 스마트공장, 신호처리, 임베디드시스템, AI

1989년 02월 : 단국대학교 컴퓨터공학과(공학사)

1990년 03월 : 원우아스콘

1997년 12월 ~ 현재 : 주식회사 산하인더스트리

관심분야 : 스마트공장

1993년 02월 : 서울대학교 전기공학과(공학사)

1995년 02월 : 서울대학교 전기공학과(공학석사)

2000년 02월 : KAIST 전자공학과(공학박사)

2003년 09월 ~ 현재 : 한국산업기술대학교 컴퓨터공학부 교수

관심분야 : 인공지능, 스마트공장, 패턴인식, 신호처리