산불의 효과적 진압을 위한 인공지능 및 영상기반 드론 임무제어 시스템

; Sung-Gyun Shin**

; Sung-Gyun Shin** ; Joo-Yeon Kim**

; Joo-Yeon Kim** ; Seungsoo Jang*

; Seungsoo Jang* ; Sangsoo Han**

; Sangsoo Han** ; Chan-Ho Choi**

; Chan-Ho Choi** ; Woo-Sung Cho*

; Woo-Sung Cho* ; Janghee Lee*

; Janghee Lee* ; Song-Hyun Kim***

; Song-Hyun Kim***

초록

산림지역은 다양한 지형, 장애물 등의 요인에 따라 산불 발생 시에 비가시권에서 드론의 수동 조작을 통한 화재진압은 상당히 어렵다. 특히, 야간의 경우 안전상의 이유로 헬기 등의 항공지원이 불가능하며, 사람 또한 접근이 어려워 드론을 통한 화재진압의 필요성이 점차 커지고 있다. 본 연구에서는 비전문가도 쉽게 드론을 산불진압에 활용할 수 있는 드론 제어 기술을 제안하였다. 제안된 기술은 영상-열화상 이미지 정보 기반의 딥러닝을 활용하여 사용자가 지정한 화재원점을 지속적으로 추적하며, 화재원점으로 유도 비행을 수행한다. 유도 비행 시, 충돌 회피 기능이 적용되었다. 또한, 유도기술은 영상기반 정밀착륙에 동시 적용되어 딥러닝으로 인한 임무 컴퓨터에서의 메모리 소모를 최소화하였다. 본 연구는 산불진압용 드론에 직접 활용될 수 있을 것으로 기대되며, 향후 사용자 친화적 드론 제어 시스템의 기술로 활용될 수 있을 것으로 기대된다.

Abstract

Suppression of forest fire with beyond visual line of sight drone operation is difficult because of factors including forest topography, obstacles and others. Since air support and human access at night are difficult for safety reason, drone has paid attention. This study proposes the drone control system which nonprofessional humans also use the drone for forest fire suppression. This system continuously tracks the fire origin selected by operator with deep-learning technique and guides drone to fire origin with collision avoidance. Additionally, this guidance technique apply to vision-based precision landing for minimizing the memory consumption of mission computer. it is expected that this system can be utilized for suppression of forest fire and non professional people also easily use in the future.

Keywords:

drone, forest fire, UAV, collision avoidance, target tracking, deep learningⅠ. 서 론

대한민국 국토의 70%는 산림지역으로 구성되었으며, 최근 산불의 발생빈도가 지속적으로 증가 및 대형화하는 추세이다. 특히 야간에는 시야 등의 문제와 더불어 안전 측면에서 소방용 헬기 투입이 어려우며, 사람 또한 야간 사고 위험에 의해 투입되기 어렵다. 이에 정부 및 소방 관계자는 대형 드론을 이용한 야간 산불진압에 대해 다양한 관심을 나타내고 있으며, 해당 진압 시스템의 도입을 시도 중이다. 하지만, 산림지역의 특성상 드론을 시야 내에서 제어 및 통제하기 어려워 원거리에서 드론 제어 및 임무 수행이 요구된다.

드론을 이용한 야간 산불 진화 작업은 1) 이륙 가능 구간에서의 드론 이륙, 2) 산불 진화를 위한 목표 위치로의 이동, 3) 소화탄 투하, 4) 이륙지점으로의 복귀, 5) 착륙의 순서로 이루어진다. 여기서 야간 산불 진화는 산불의 명확한 GPS(Global Positioning System) 지점을 파악하기 어렵고 드론으로부터 실시간으로 얻어지는 영상으로는 주행 중인 드론 주변의 장애물 판별이 어려우며, 복귀 이후에도 GPS 센서의 부정확성 등에 기인하여 이륙지점에 착륙 실패할 가능성이 상존한다. 특히 야간에 장거리에 위치한 목표물을 대상으로 임무를 수행하는 것은 육안상 확인이 거의 불가능함으로 이를 수용하기 위한 최적 시스템이 필요하다.

최근 자율주행 기술의 발달은 야간 산림지역에서의 드론 운영 및 활용에 따르는 문제점을 극복할 수 있으며, 충돌 회피 기술은 야간에서도 사고를 예방하고 안정적으로 임무를 수행할 수 있도록 발전되어왔다. 충돌 회피를 수행하기 위한 거리 측정 센서는 초음파(Sonar)방식, 전파(Radar)방식, 레이저(Lidar)방식, 영상방식(Camera) 등이 있다. 이러한 센서를 이용하여 거리를 측정한 이후 충돌 회피를 수행하는 방식은 Geometric 방법, Force-field 방법, Optimized 방법, Sense and Avoid 방법 등으로 분류할 수 있다[1].

충돌 회피를 위해서는 장애물과의 거리 측정이 필연적인데, 이를 측정하기 위한 방법은 드론과 주변 지역에서의 장애물과의 거리를 직접 측정하는 방법과 간접 센서를 이용하는 방법으로 나뉜다. 직접 측정에 이용되는 센서는 초음파, 라이다(Lidar), 레이더(Radar) 등이 있으며, 간접 측정에 활용되는 센서는 화상카메라(Camera) 및 열화상카메라(IR) 등이 있다[2]. 이중 충돌 회피를 위해 드론의 거리 측정에 다수 활용되는 센서는 초음파센서(Sonar sensor), 깊이카메라(Depth camera), 양안카메라(Stereo camera), 라이다센서(Lidar sensor)가 있다. 초음파센서는 가격이 저렴하고 단거리의 장애물 감지에 유용하여 촬영용 드론에 다수 탑재된다. 크기가 작고 가벼우며 장착이 쉬우나, 장거리의 장애물 탐지가 어렵고 거리센서 정확성이나 신뢰도의 문제가 다수 보고되어 산불진압용 대형 드론에 활용하기 어렵다. 양안카메라 및 깊이카메라 또한 최대 측정거리가 10m 수준으로 고속으로 운영이 필요한 드론 기체에 탑재하기 어렵다. 전파를 발사해서 거리를 측정하는 방식인 레이더센서는 외부환경 변화나 비용에 장점이 있으나 정확한 형체 인식 및 거리탐지가 어렵기 때문에 드론에는 자주 사용되지는 않는다. 이에 비해 라이다센서는 레이저를 발사 후 되돌아오는 시간을 측정하는 방식(ToF, Time of Flight)을 이용하며 강한 직진성을 가지는 레이저를 사용하기에 정확한 거리 측정이 가능하다.

또한, 영상기반의 드론 추적(Tracking)기술은 촬영용 드론에서 피사체의 추적 기반 촬영에 다수 활용되고 있다. 특히, 최근 딥러닝 기술의 발달로 추적기술의 정확성이 지속적으로 향상되고 있어 산불진압에 있어서도 활용 가능한 수준이다. 실시간 목표물 추적이 가능한 최신 기술 중 대표적인 방법으로는 Bertinetto 외 4인이 제안한 “Fully-convolutional siamese networks for object tracking”[3]이 있으며, 이는 딥러닝 기술을 활용하여 ILSVRC15 dataset을 이용해 무작위 객체에 대한 추적을 성공적으로 수행하였다. Boyu Chen 외 4인은 ‘Actor-Critic’ 프레임워크 기반의 연속 변동을 학습하는 시스템을 제안하였으며[4], 이는 Actor 모델이 개별 프레임에서 추적하고자 하는 객체를 오프라인으로 강화학습에 기반하여 추적하고 ‘Critic’ 네트워크가 온-오프라인에 대해 검증하는 방식으로 결과를 도출하는 방식으로 추적을 수행한다. Ilchae Jung 외 3인이 제안한 MDNET[5]은 특징점 추출 및 학습을 보다 가속화하기 위해 차별적 모델 및 새로운 Loss 텀을 제안하였으며, 이를 통해 추적 성능을 향상시켰다. Wang 외 5인이 발표한 “Learning Attentions: Residual Attentional Siamese Network for High Performance Online Visual Tracking” 논문[6]에서는 RASNet(Residual Attentional Siamese Network)을 발표하였으며, 이는 추적 성능과 정확성 측면에서 진보한 방법으로 평가받고 있다. 기존의 목표물 추적기술은 지도학습 기반의 학습이 주로 활용되었다면, Wang 외 5인이 발표한 UDT(Unsupervised Deep Tracking)[7]은 다수의 라벨링되지 않은 데이터를 기반으로 추적을 위한 학습을 수행하며, Forward-Backward 추적을 동시에 활용해서 기존 방식의 문제점을 해결하였다. 해당 특정되지 않은 사물을 정확히 추적할 수 있다는 점에서 중요 장점을 가지고 있다.

상기 기술된 사전 연구 결과들은 드론 비행 시에 장애물 회피나 특정 객체의 추적에 활용되는 기술이나, 산불진압에 특화되지 않아 산불진압 임무에 직접 활용되기는 어려웠다. 본 연구에서는 산불을 효과적으로 진압하기 위한 라이다 및 화상-열화상 카메라의 하드웨어 구성, 짐벌 제어, 통신 시스템 구축, 영상기반의 드론 유도 주행 및 충돌 회피 기술을 도입하였다. 먼저 원거리에서 화상 기반의 추적은 실패 가능성이 높고 화재지점에 드론의 유도 비행이 어렵기 때문에 화상-열화상 카메라를 연동한 영상 선별 시스템을 구축하였다. 해당 시스템에서 화재지점으로의 유도 성능을 향상하기 위해 열화상카메라 기반의 추적 모드로 변동할 수 있는 시스템을 구축하였다. 영상/열화상 이미지로부터 특정 위치로의 지속적인 추적을 위해 딥러닝 기반의 영상추적 시스템을 도입하였으며, 추적 과정 중의 충돌을 방지하기 위한 충돌방지 시스템을 병합하였다. 이를 기반으로 대상 위치의 상부에 정확히 드론이 위치할 수 있도록 드론-짐벌 제어 시스템을 구축하였다. 이를 통해 소화탄을 탑재한 드론은 영상 대상 지점으로 정확히 유도하고 소화탄을 투척할 수 있는 시스템 및 복귀 후 착륙 시스템을 제안한다.

Ⅱ. 본 론

산불에서 화재지점은 다수가 존재하며, 일반적으로 산불 제압을 위해서는 기상 및 지역 정보 등을 고려하여 사람이 직접 진압 지점을 결정해야 한다. 하지만 산불은 가시권 이외 지역에서 주로 발생하며, 산불의 정확한 GPS 지점을 파악하기 힘든 상황에서 비숙련자가 드론을 활용한 산불진압을 수행하기에는 다소 어려움이 따른다. 제안된 시스템은 실시간 스트리밍 영상을 기반으로 목표 화재지점을 충돌 없이 이동 및 임무 수행이 가능하며, 영상을 기반으로 임의의 착륙지점에 유도 착륙이 가능하다. 이를 위해 본 연구에서는 드론 제어 및 운용 시스템의 개요, 산불 추적 시스템, 충돌 회피 시스템, 복귀 및 착륙유도 시스템을 설명한다.

2.1 산불진압용 드론 시스템 개요

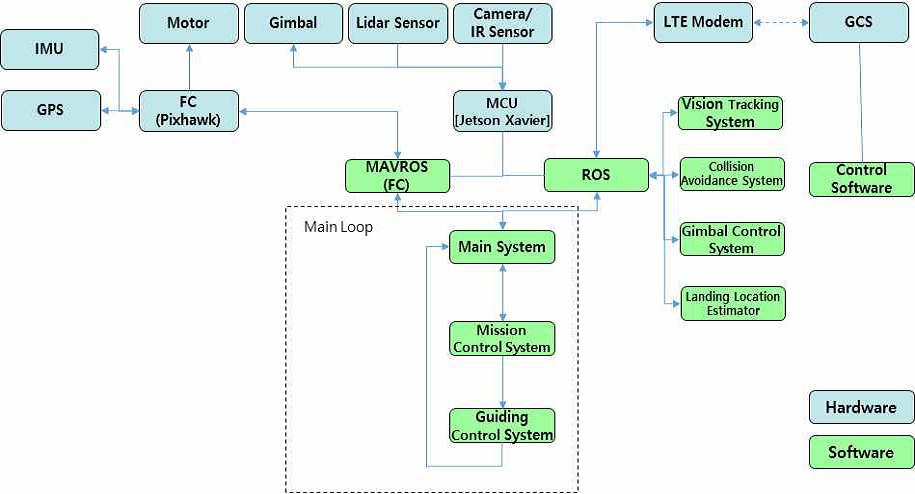

본 시스템에 기반한 드론 기반의 산불진압은 1) 이륙, 2) 짐벌 제어, 3) 영상 내 목표지점 지정, 4) 목표지점으로의 이동, 5) 소화탄 투하, 6) 복귀 및 착륙으로 진행된다. 이를 위한 드론 제어 시스템의 개요는 그림 1에 나타내었다.

먼저 Pixhawk 기반의 FC(Flight Controller)를 선정하였으며, MCU(Mission Computer Unit)는 MAVROS를 이용하여 FC와의 통신 및 드론 제어를 수행한다. MCU는 FC로부터 위치 정보 등을 수신받으며, 이를 기반으로 하여 드론의 상세 제어가 수행된다. MCU에는 짐벌, 라이다센서, 화상/열화상 겸용 카메라가 장착되어 있으며 해당 정보를 통해 자동비행이 가능하다.

MCU에 장착된 모든 센서 정보는 ROS(Robot Operating System)를 기반으로 서로 공유하며, 총 4개의 핵심 모듈로 구성되어 있다. 이는 1) 영상/열화상 기반 추적 시스템, 2) 충돌 회피 시스템, 3) 짐벌 제어 시스템, 4) 착륙 위치 평가 시스템이다. 영상/열화상 기반 추적 시스템은 특정 위치로 드론의 유도 비행(Guided mode 이용) 및 착륙유도를 위해 사용되는 모듈이다. 충돌 회피 시스템은 특정 위치로의 유도 비행 중 장애물을 감지 시 이를 회피하는 경로를 생성하고, 이를 기반으로 유도 비행을 수행한다. 짐벌 제어 시스템은 사용자가 지정된 영상/열화상 위치의 상부에 드론이 위치하도록 짐벌의 위치를 제어한다. 착륙 위치 평가 시스템은 하부에 지정된 착륙지점의 상대 위치를 추정하고 해당 위치로 유도하기 위한 시스템이다.

상기 소프트웨어 모듈을 이용하여 계산된 위치는 ROS를 통해 메인시스템에 전달되고 메인시스템은 임무 제어 시스템에 기반하여, 다음 순서의 임무를 배정한다. 배정된 임무 및 상기 모듈에서 결정된 위치 정보를 기반으로 유도제어시스템은 FC에 드론을 제어하기 위한 상세 위치를 결정하여 전달한다. 전달된 정보를 바탕으로 FC는 모터 제어를 수행하며 드론을 특정 위치로 이동하도록 제어한다.

또한 사용자에 의한 제어 명령은 LTE 모뎀을 통해 통신 되며, 실시간 스트리밍 영상은 MCU로부터 지상제어시스템(GCS, Ground Control Station)으로 전송된다. 사용자는 GCS의 스트리밍 영상을 통해 드론의 목표 이동 및 착륙 위치를 지정하며 해당 기능을 통해 드론의 유도 주행 및 착륙이 가능하다. 또한 이동 중에는 충돌 회피 기능이 적용되어 안전한 임무 수행이 가능하다.

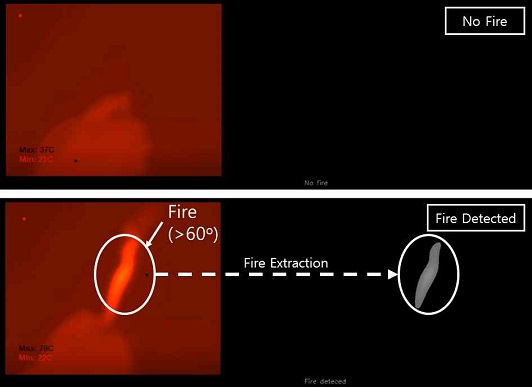

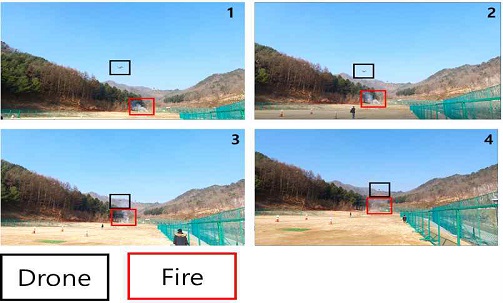

2.2 산불위치 및 착륙지점 영상추적기술

산불지점의 영상추적을 위한 핵심 기술로는 화상-열화상 전환 시스템 및 UDT[7] 기반의 딥러닝 기반 추적기술의 적용이다. 먼저 영상 및 열화상 이미지를 동시에 활용하기 위해 FLIR사의 DUO PRO R을 선정하였고 선정된 카메라는 설정된 PWM(Pulse Width Modulation) 값에 따라 일반/열화상 모드로 전환되도록 MCU에서 제어되어진다. 선정된 열화상카메라는 최대 소형 화재 시 200m 거리에서 화재를 감지할 수 있는 것으로 알려져 있으며, 대형 산불의 발생 시 이보다 먼 거리에서도 활용 가능하다. 본 연구에서는 열화상카메라로 측정된 각 픽셀별로 특정 온도 이상(60℃)의 열이 감지되었을 때 화재로 인식하고 화재 지역만을 추출하여 표시하도록 프로그램을 개발하였다. 이는 화재 지역만을 특정적으로 추출할 수 있어 화재 지역 유도 알고리즘의 정확도를 향상시킬 수 있다. 상기 소프트웨어를 이용하여 화재 인식 테스트를 수행한 결과를 그림 2에 나타내었다.

본 시스템에서는 일반적으로 영상 이미지를 통해 특정 지점의 추적이 이루어진다. 하지만 산불에서의 추적 기능을 보다 강화하기 위해 해당 영상/열화상 이미지를 지속적으로 MCU에서 받아들이며 상기 화재구역 추출 프로그램을 통해 화재구역이 특정화될 수 있으며, 해당 위치로의 추적 기능이 활성화된다.

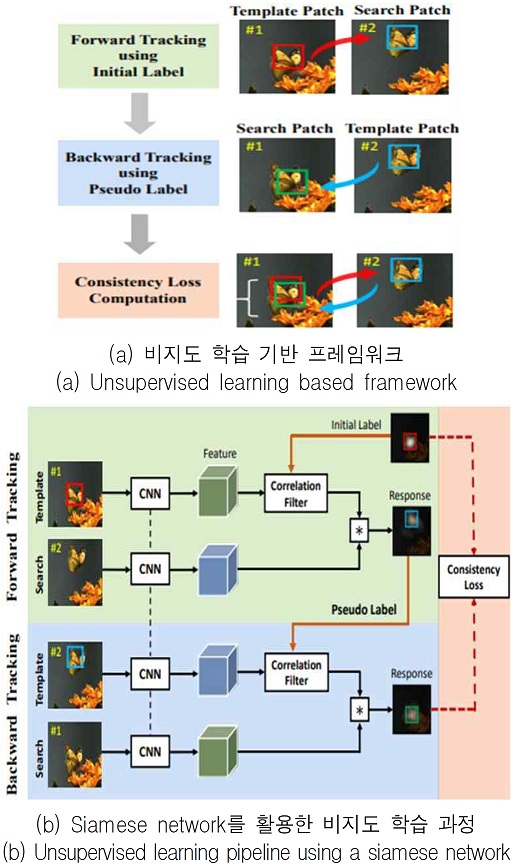

영상/열화상 이미지로부터 목표지점을 지속적으로 추적하기 위해 활용된 방법은 UDT[7]이다. 이는 특정한 목표물이 아닌 임의의 목표물에 대해서도 추적이 가능하며, 상대적으로 높은 정확성 및 평가 속도를 가지고 있다. 이에 따라 영상/열화상 이미지의 어떠한 목표물에 대해서도 활용이 가능하며, 상대적으로 높은 성능을 보유하고 있기에 이를 채택하였다. UDT 알고리즘은 Siamese Network를 활용한 Unsupervised Learning 방식으로 Network를 학습하기 위한 방법은 그림 3과 같다.

- 가. Forward Tracking에서는 초기 라벨정보가 포함된 첫 번째 이미지와 다른 시간에 촬영된 두 번째 이미지를 CNN(Convolutional Neural Network)을 통과 시킨 후 특징점을 찾고 해당 특징점들을 이용하여 두번째 이미지에서의 Pseudo Label을 생성한다.

- 나. Backward Tracking에서는 두 번째 이미지와 Pseudo Label을 통해 첫 번째 이미지에서의 라벨을 찾는다.

- 다. 초기 라벨정보와 Backward Tracking으로부터의 라벨정보를 최소화 하는 방향으로 네트워크를 업데이트하여 학습한다.

영상추적을 위해 GCS내 이미지는 1920×1080 이미지로 고정하며, 객체의 크기는 GCS 영상에서 사용자가 지정한 위치의 픽셀값이 드론으로 전송된다. 전송된 픽셀 위치를 중심으로 50×50 크기의 박스를 생성하며, 이를 초기값으로 하여 추적이 시작된다. 영상기반 추적은 사용자가 임무를 강제 종료시키거나 추적 목표물이 영상 범위 내에서 나타나지 않을 때 종료된다.

2.3 산불 위치 및 착륙지점 유도제어 알고리즘

본 연구에서 제안된 시스템은 GCS로부터 얻어지는 스트리밍 영상에서 사용자는 특정 위치나 착륙 위치를 지정할 수 있다. 영상을 통해 지정된 위치는 2.2에서 제안된 방법을 통해 이미지상으로 지속적인 추적이 수행되며, 이미지상에 객체의 위치를 기반으로 드론의 제어가 수행된다. 산불 위치 및 착륙지점 유도제어는 1) 영상기반의 목표지점 특정화, 2) 충돌 회피 알고리즘 기반 국부 이동 위치 특정화, 3) 드론 제어, 4) 짐벌 제어의 순서로 이루어진다.

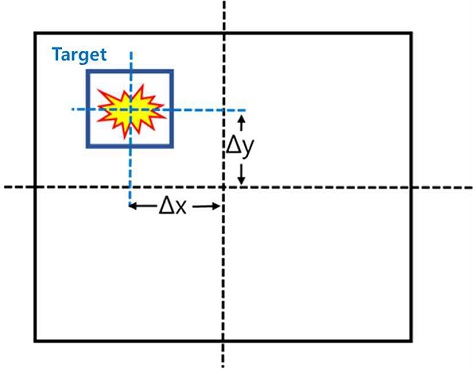

2.2 절에서 언급된 바와 같이 영상을 통해 목표지점이 이미지상으로 특정화되면, 아래와 같은 알고리즘으로 목표지점의 위치반환 및 제어를 수행한다.

- 가. 영상의 중심 좌표와 추적하고 있는 목표물의 중심좌표의 픽셀 차이를 그림 4와 같이 계산한다. 이와 같이 계산된 픽셀 차이는 각도 차이로 환산된다.

- 나. 목표물의 고도 정보가 부족하여 실제 위치를 확정하기 어려우나, 앞서 계산된 △x와 짐벌 각도를 통해서 목표물에 대한 방향벡터를 구할 수 있다.

- 다. △y가 기준치(±10 pixel) 이상일 때 짐벌의 수직 각도를 △y * 0.1 속도로 PWM 신호를 조정하여 기준치 이내로 도달할 때까지 지속 제어한다.

- 라. 식 (1)과 (2)를 통해 드론과 목표물 사이의 상대 위치를 반환하며 목표지점으로 지정한다. 드론의 속도와 비례관계에 있는 방향벡터의 크기는 사용자가 지정한 값으로 설정된다.

- 마. 짐벌 방향이 수직방향(89.9°- 90.1°)이며, △x 및 △y가 기준치 이내일 때, 추적을 종료하고 드론을 정지한다.

| (1) |

| (2) |

여기서, v는 방향벡터 크기 ,(xt, yt)는 목표 지점, θgimbal는 현재 짐벌 수직 각도, Rz는 현재 드론의 yaw, c는 pixel 정보를 radian으로 변환해주는 계수이다.

또한, 정밀착륙의 경우 GCS를 통해 지정된 목표물을 UDT 추적 알고리즘을 통해 지속적으로 추적하며, 아래의 식으로 목표지점을 지정하여 정밀착륙이 수행된다. 또한, z축의 속도(vz)는 0.5 m/s로 착륙하도록 설정한다.

| (3) |

| (4) |

여기서, (px, py)는 목표로 인식된 중신 픽셀값, (pcx, pcy)는 영상의 중심 픽셀값, (plx, ply)는 영상의 픽셀길이, (lx, ly)는 화각을 이용해 예측된 높이 ht에서의 관측 범위, (xd, yd)는 현재 드론의 위치이다.

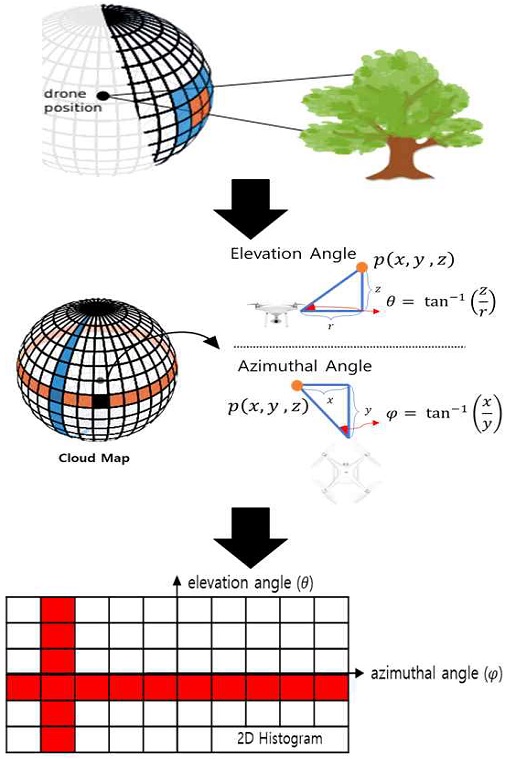

상기 위치유도 알고리즘에 기반하면 목표지점은 항상 드론의 정면 방향으로 식 (1)과 (2)에 기반하여 위치가 설정된다. 해당 경로에 드론이 라이다 센서를 통해 충돌 가능한 장애물이 발견되면 충돌 회피 알고리즘을 통해 충돌이 발생 되지 않는 안전한 국부 목표 위치가 반환된다. 본 연구에서 적용한 충돌 회피 알고리즘은 Swiss Federal Institude of Technology Zurich의 Tanja Baumann이 제안한 “Obstacle Avoidance for Drones Using a 3DVFH* Algorithm” 논문[8]에서 고안된 방법이다. 해당 알고리즘은 다음과 같은 원리로 작동된다.

- 가. 라이다센서로부터 획득한 3D Cloud Map을 2D Histogram에 투영하여 2차원의 장애물 정보 맵을 구성한다. 2D histogram의 개요는 그림 5에 나타내었다.

- 나. 목표지점의 위치, 장애물의 유무, 이동 가능지역 등을 고려하여 2D Histogram에 Cost를 계산한다. 이때 안정적인 충돌 회피의 구현을 위해 현재의 Point Cloud 정보뿐만 아니라 일정 시간 동안 과거의 Point Cloud 데이터들을 저장하여 이를 통해 Cost를 획득한다.

- 다. Cost가 가장 낮은 지역으로 목표 위치를 수정한다.

상기 알고리즘을 요약하면 GCS로부터 목표지점을 획득하고, 해당 지점으로 UDT 기반의 영상추적이 시작되며 화재를 통해 목표지점에 화재가 감지되면 열화상 이미지로 전환하여 추적을 수행할 수 있다. 추적이 수행되는 동안에 장애물이 이동 경로에 확인되면, 충돌 회피 알고리즘이 적용되어 국부 이동 위치를 결정하고 지속적인 이동 위치의 반환 및 제어를 통해 목표지점의 상부에 드론이 위치하게 된다.

Ⅲ. 평가 및 검증

3.1 하드웨어 구성

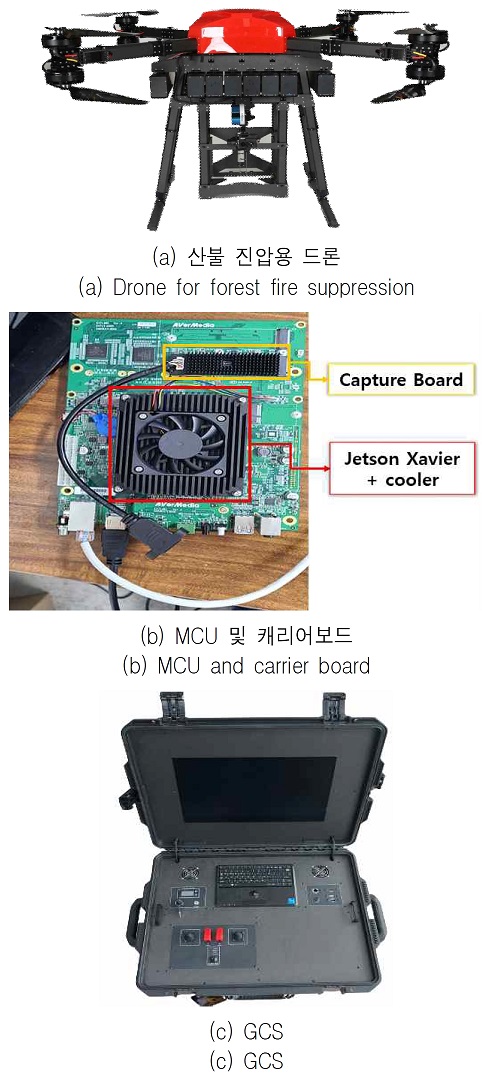

본 연구에서 사용된 드론 기체는 그림 6과 같이 카본복합재 기반의 드론으로 임무 중량은 30 kg 이상이며, 최대 체공 시간은 20분 이상이다. 비행제어를 위한 FC는 Pixhawk2 CUBE이며, MCU는 Jetson Xavier이다. 캡쳐보드는 Eco Capture HDMI 4K M.2로 선정했다. 화상/열화상 카메라는 FLIR Duo Pro R을 탑재하였으며, 카메라 짐벌은 Gremsy PIXY U를 사용하였다.

라이다센서는 VLP-16 Puck Lite로 최대 100m의 거리 측정이 가능하며, 산림지역의 운영에 특화되도록 라이다를 수직 방향으로 부착하였다. 드론과 GCS간의 통신은 LTE를 통해 수행되며 MQTT(Message Queuing Telemetry Transport) 메시징 프로토콜을 사용하였다.

3.2 성능평가 및 검증

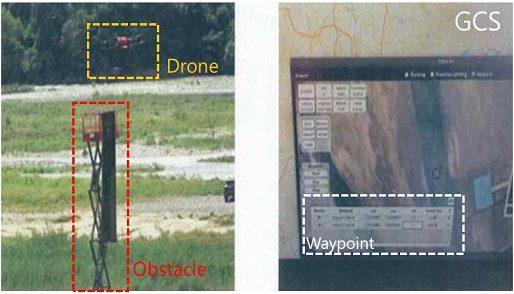

2장에서 기술한 시스템 및 하드웨어를 바탕으로 다음과 같은 산불진압용 드론의 성능 평가를 수행하였다. 본 성능 평가는 높은 신뢰도를 보유한 외부 GPS 센서(GRX-3)와 FCU 내 로그 데이터를 비교함에 따라 진행되었기 때문에 성능 평가결과는 높은 수준의 신뢰도를 보여준다. 먼저 장애물 회피 성능을 평가하기 위하여 10.5m의 장애물을 그림 7과 같이 설정하고 장애물 최대 회피 고도를 평가하였다.

총 3회의 실험 결과 회피 고도는 14.74m, 16.74m, 12.52m로 나타났으며, 모두 실패 없이 성공적인 회피비행을 수행하였다.

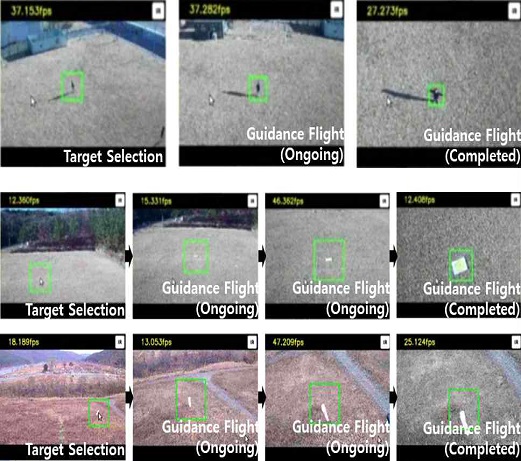

다음으로 해당 드론을 이용한 테스트 수행 내용은 추적 및 유도 비행기술이다. 본 드론에 탑재된 미션 컴퓨터인 Jetson Xivier에서 사람을 대상으로 수행한 UDT알고리즘 실험 및 테스트의 결과, 추론속도가 평균 30 FPS(Frame Per Second)로 실시간 추적 및 유도분석이 가능하다는 것을 검증하였다. 또한 사람뿐만 아니라 정사각형 형태의 착륙 패드 및 임의의 객체에 대해 5번의 반복 테스트를 수행하였으며, 모든 유도 비행 테스트 결과 반경 2.5m 이내에 GCS에서 목표로 지정한 객체로의 유도 비행이 가능한 것으로 평가되었다. 그림 8은 객체유도비행 테스트 과정을 보여준다.

해당 드론을 이용하여 화재지점의 유도 테스트를 수행하였다. 임의의 화재를 발생시키고 GCS의 영상 스트리밍을 통해 얻어진 이미지에서 화재지점을 지정하여 화상-열화상기반의 유도 비행을 테스트하였다. 특히 해당 지점으로의 직선 경로에는 산림구역을 설정하여 충돌 회피 기능도 동시에 테스트하였다. 그 결과 드론이 장애물을 스스로 판단하고 회피를 수행하며, 반경 2.25m 이내에 드론이 화재지점으로 유도되어 정지하는 것으로 평가되었다. 화재 지점 유도 테스트 결과는 그림 9에 나타내었다.

드론이 소화탄을 탑재하고 지정된 지점으로 비행하여 탑재된 소화탄을 투하할 수 있는지 확인하기 위한 테스트를 수행하였다. 모형 소화탄을 탑재하고 임의로 지정된 투하지점으로 이동하여 제자리 비행하였을 때, 제자리 비행 동안 위치의 변동 없이 안정적으로 제자리 비행할 수 있음을 확인하고, 소화탄 투하 명령에 따라 소화탄이 정상적으로 투하되는지 확인한다.

본 시험은 3회 시험하며, 제자리비행 시의 수평/수직 최대 변화값은 제시된 성능 기준을 만족하고, 정상적으로 소화탄 투하가 가능한지를 검증하였다. 평가 결과 투하 목적지점과 투하지점의 거리가 0.58m, 2.03m, 2.40m로 평가되었으며, 모두 목표로 정한 10m 이내에서 정확히 작동하는 것을 확인하였다. 그림 10은 소화탄 투하 테스트 결과 일부를 보여준다.

마지막으로 본 연구에서는 개발된 유도착륙기술을 이용하여 드론을 임의의 설정된 지점으로 착륙시킬 때, 착륙정확도를 확인하였다. 드론이 임의의 4개 지점에서 이륙하여 설정된 지점에 정확히 착륙하는지 확인하였다.

4회에 걸쳐 실시된 목표 착륙지점과 드론이 실제 착륙한 지점과의 오차는 1.7m, 1.86m, 0.74m, 1.74m로서 모두 2m 이내의 오차로 임의의 위치에 유도 착륙이 가능하다는 결과를 얻었다. 본 성능 평가 결과는 표 1에 요약되어있다.

Ⅳ. 결 론

본 연구에서는 드론을 이용한 효과적 산불진압을 위한 드론 제어 시스템을 제안하였다. 제안된 시스템은 드론의 원격 스트리밍을 통해 얻어진 영상정보를 바탕으로 사용자가 지정한 화재원점까지 드론의 유도 비행을 수행하는 기능을 포함한다. 특히 화재지점까지의 화상-열화상 이미지를 동시에 활용하고 비지도학습 기반의 딥러닝 기술을 적용하여 유도 성능을 향상시켰으며, 유도제어 기술을 착륙에 동시에 적용함으로써 시스템에 요구되는 메모리를 최소화하였다.

또한 산림지역에서 산불 원점으로의 유도 과정에서 발생할 수 있는 장애물과의 충돌 등을 방지하기 위한 충돌 회피 기술을 비행 시에 적용함으로써 안전성과 조종 편의성을 대폭 향상시켰다. 제안된 방법을 통해 충돌 회피성능, 위치유도성능, 화재지점 유도 성능, 소화탄 투하 정확성 등을 평가하였으며, 산불진압을 위한 최소 기준성능을 상회하는 결과를 도출하였다. 제안된 방법은 화재지점으로부터 반경 2.25m 이내로 드론을 유도하였으며, 최대 2.40m의 투하 오차 및 1.74m의 유도 착륙 오차를 보였다. 본 시스템은 향후 산불진압용 드론에 직접 활용될 수 있으며 향후 SOC(Social Overhead Capital) 시설점검, 위험 제거, 실종자 탐색 등의 다양한 분야에 활용될 수 있을 것으로 기대된다.

Acknowledgments

본 연구는 과학기술정보통신부/산업통상자원부/국토교통부/국토교통과학기술진흥원/한국산업기술진흥원의 지원으로 수행되었음 (과제번호 19DPIW-C153675-01, P0002073, 21DPIW-C164947-01).

References

-

Jawad N. Yasin, Sherif A. S. Mohamed, Mohammad-Haghbayan, Jukka Heikkonen, Hannu Tenhunen, and Juha Plosila, "Unmanned Aerial Vehicles (UAVs): Collision Avoidance Systems and Approaches", IEEE Access, Vol. 8, pp. 105139-105155, Jun. 2020.

[https://doi.org/10.1109/ACCESS.2020.3000064]

-

Aaron Mcfadyen and Luis Mejias, "A survey of autonomous vision-based See and Avoid for Unmanned Aircraft Systems", Progress in Aerospace Sciences, Vol. 80, pp. 1-17, Jan. 2016.

[https://doi.org/10.1016/j.paerosci.2015.10.002]

-

Luca Bertinetto, Jack Valmadre, Joao F. Henriques, Andrea Vedaldi, and Philip H. S. Torr, "Fully-convolutional siamese networks for object tracking", Computer Vision–ECCV 2016 Workshops, Amsterdam, The Netherlands, Vol. 9914, pp. 850-865, Nov. 2016.

[https://doi.org/10.1007/978-3-319-48881-3_56]

-

Boyu Chen, Dong Wang, Peixia Li, Shuang Wang, and Huchuan Lu, "Real-time’actor-critic’tracking", Proceedings of the European Conference on Computer Vision (ECCV), Munich, Germany, Vol. 11211, Munich, Germany, pp. 328-345, Sep. 2018.

[https://doi.org/10.1007/978-3-030-01234-2_20]

-

Ilchae Jung, Jeany Son, Mooyeol Baek, and Bohyung Han, "Real-time MDNET", Proceedings of the European Conference on Computer Vision (ECCV), Munich, Germany, pp. 89-98, Sep. 2018.

[https://doi.org/10.1007/978-3-030-01225-0_6]

-

Qiang Wang, Zhu Teng, Junliang Xing, Jin Gao, Weiming Hu, and Stephen Maybank, "Learning attentions: Residual attentional siamese network for high performance online visual tracking", Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Salt Lake City, Utah, USA, pp. 4854-4863, Jun. 2018.

[https://doi.org/10.1109/CVPR.2018.00510]

-

Ning Wang, Yibing Song, Chao Ma, Wengang Zhou, Wei Liu, and Houqiang Li, "Unsupervised Deep Tracking", Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach, California, USA, pp. 1308-1317, Jun. 2019.

[https://doi.org/10.1109/CVPR.2019.00140]

- Tanja Baumann, "Obstacle Avoidance for Drones Using a 3DVFH* Algorithm", Swiss Federal Institute of Technology Zurich, Master Thesis, 2018.

2017년 2월 : 경희대학교 원자력공학과(공학사)

2019년 2월 : 경희대학교 원자력공학과(공학석사)

2019년 9월 ~ 현재 : 포항공과대학교 첨단원자력공학부 박사과정

관심분야 : 딥러닝, 실내 및 자율주행 드론

2012년 2월 : 경희대학교 원자력공학과(공학사)

2017년 2월 : 포항공과대학교 첨단원자력공학부(공학박사)

2021년 2월 ~ 현재 : 주식회사 시에라베이스 이사

관심분야 : 딥러닝, 실내 및 자율주행 드론

1992년 2월 : 한양대학교 원자력공학과(공학사)

1994년 2월 : 한양대학교 원자력공학과(공학석사)

2009년 2월 : 한양대학교 원자력공학과(공학박사)

2021년 2월 ~ 현재 : 주식회사 시에라베이스 이사

관심분야 : 방사선안전, 방사선융합기술

2016년 2월 : 경북대학교 물리학과(이학사)

2018년 2월 : 포항공과대학교 물리학과(이학석사)

2019년 9월 ~ 현재 : 포항공과대학교 첨단원자력공학부 박사과정

관심분야 : 딥러닝, 컴퓨터 비전

2011년 2월 : 영남대학교 기계설계학과(공학사)

2020년 2월 : 포항공과대학교 첨단원자력공학부(공학박사)

2021년 3월 ~ 현재 : 주식회사 시에라베이스 이사

관심분야 : 딥러닝, 방사성폐기물

2010년 2월 : 경일대학교 경영학과(학사)

2021년 2월 ~ 현재 : 주식회사 시에라베이스 과장

관심분야 : 드론 자율 주행

2020년 4월 : 한국기술교육대학교 메카트로닉스공학부(공학사)

2021년 2월 ~ 현재 : 포항공과대학교 첨단원자력공학부 석박통합과정

관심분야 : 딥러닝, 실내 및 자율주행 드론

2020년 8월 : 경북대학교 수학과(이학사)

2020년 9월 ~ 현재 : 포항공과대학교 첨단원자력공학부 석박통합과정

관심분야 : 딥러닝, 이상탐지

2008년 2월 : 한양대학교 원자력공학과(공학사)

2014년 2월 : 한양대학교 원자력공학과(공학박사)

2021년 2월 ~ 현재 : 한국전력 국제원자력대학원대학교 에너지정책학과 조교수, 주식회사 시에라베이스 대표이사

관심분야 : 딥러닝, 실내 및 자율주행 드론