드론 기반 해안 쓰레기 식별을 위한 클라우드 이미지 분류 모델의 비교 평가

초록

해안 쓰레기는 해양 생태계와 사람 건강에 많은 문제를 발생시키기 때문에 빠른 수거를 위한 정확한 분포 파악이 요구된다. 기존 연구에서 육안 검사의 문제점을 해결하기 위해 드론과 영상처리 기법을 이용한 시스템들이 개발되었지만, 여전히 낮은 인식률, 높은 비용 등의 문제점을 지닌다. 따라서 이 논문에서는 앞서 언급한 문제점을 해결하기 위해 드론을 이용하여 해안 쓰레기를 수집하고, 해안 쓰레기 분류를 위한 클라우드 이미지 분류 모델 간의 비교 평가를 수행한다. 비교 평가를 위해 단일 객체 실험 및 다중 객체 실험을 진행하였다. 실험 결과에서, Custom Vision 모델이 정확도, 재현율 및 AP(Average Precision) 등 모든 기준에서 가장 우수한 성능을 보였다.

Abstract

Coastal waste causes many problems with the marine ecosystem and human health, and thus accurate distribution for rapid collection is required. In previous studies, the systems using drones and image processing techniques have been developed for resolving the visual inspection, but they still have problems such as low recognition rate and high cost. Therefore, to solve the aforementioned problems, this paper uses drones to collect coastal waste and conducts the comparative evaluations between cloud image classification models for coastal waste classification. The single object experiments and multi-object experiments have been conducted the comparative evaluation. In the experimental results, the Custom Vision model showed the best performance in all criteria of accuracy, recall, and AP.

Keywords:

drone, cloud service, image classification models, coastal wasteⅠ. 서 론

해양 쓰레기는 인간이 인공적으로 만든 물질이 해양환경에 있는 것을 의미한다[1]. 해양 쓰레기로 인한 해양 생태계 피해 및 환경 문제가 전 세계적으로 증가하고 있다. 또한, 어업 생산량이 줄어들거나 선박사고가 발생하고 관광지의 오염으로 인한 해안 주민들의 경제 활동에 피해를 준다. 특히, 해양 쓰레기 내의 미세플라스틱은 해산물을 통해 인체 내에 유입이 된다는 문제점을 지닌다.

해양 쓰레기의 종류는 3가지로 분류할 수 있다. 바다를 표류하는 쓰레기는 ‘부유 쓰레기’, 해저에 가라앉는 쓰레기는 ‘침적 쓰레기’, 해안가에 표착된 쓰레기는 ‘해안 쓰레기’라고 한다. 이 중, 해안 쓰레기는 육상이나 강으로부터 쓰레기 유입이 쉽게 일어나고 인간의 활동으로 인해 쓰레기가 많이 발생한다. 따라서 해안 쓰레기를 수거하기 위해 분포 파악의 정확한 방법이 필요하다.

해안 쓰레기 파악을 위해 많은 연구가 진행되고 있으며, 국내에서는 해양수산부에서 진행하는 해안 쓰레기 모니터링 사업[2]이 진행되고 있다. 이 사업은 사람이 육안 검사를 실시하여 정기 조사한다. 그러나 해안 쓰레기를 조사할 때 많은 인력이 필요하고 사람이 접근할 수 없는 지형 환경은 조사할 수 없는 문제점을 지닌다.

앞서 언급한 문제점을 해결하기 위해 드론을 사용하여 다양한 연구가 진행 중이다[3]-[6]. 드론을 활용하여 해안 쓰레기 이미지를 수집하고 다양한 영상처리 기법과 딥러닝을 사용하여 해안 쓰레기를 분류한다. 드론을 활용하여 해안 쓰레기 수집할 때 많은 인력이 필요하지 않고 다양한 지형에서도 수집할 수 있는 장점이 있다. 그러나 여전히 해안 쓰레기 분류에서 낮은 인식률을 보이고, 드론으로부터 수집되는 대용량 해안 쓰레기 사진들을 저장하는 스토리지와 이러한 사진들을 실시간으로 분류할 수 있는 딥러닝 서버 등의 높은 인프라 구축 비용이 요구된다. 이러한 문제는 클라우드 이미지 분류 모델을 사용함으로 해결할 수 있다. 클라우드 이미지 분류 모델은 자체적인 인프라를 구축할 필요 없으므로 비용 절감이 된다.

또한, 식물 질병 감지, 질환 감지 등 다양한 분야에서 클라우드 이미지 분류 모델이 상용화되고 다른 영상처리 기법보다 높은 인식률을 보여주고 있다[7]-[14]. 특히, [7]은 드론을 이용해 일반 쓰레기 이미지를 수집하고 클라우드 이미지 분류 모델을 사용하여 드론의 고도 및 속도가 영상 획득에 미치는 영향을 분석하였다. 또한, [8]은 이 연구의 사전연구로서 클라우드 이미지 분류 모델을 사용하여 캔, 플라스틱병, 비닐봉지에 대한 단일 객체 성능 평가를 진행한다. 그러나 해안 쓰레기를 식별할 때 다양한 종류의 쓰레기 식별이 필요하고, 실제 해안 쓰레기는 단일 객체 실험뿐만 아니라 다중 객체 실험이 필요하다.

따라서 이 논문에서는 [8]을 확장하여 클라우드 이미지 분류 모델을 구축하고, 단일 객체와 멀티 객체 실험을 진행하여 비교 평가를 수행한다. 클라우드 이미지 분류 모델의 구축을 위해 쓰레기 이미지를 수집하고, 수집한 이미지들을 사용하여 이미지 분류 모델을 구축한다. 이미지 분류 모델은 Microsoft의 Custom Vision, Google의 AutoML Vision, AWS(Amazon Web Services)의 Amazon Rekognition을 사용한다. 클라우드 이미지 분류 모델의 비교 평가를 위해 드론을 이용해 [7]에 사용한 고도 및 속도를 고려하여 실제 해안 쓰레기 이미지를 수집한다. 실험은 5가지 종류의 이미지를 단일 객체와 다중 객체 실험을 통해 클라우드 이미지 분류 모델을 비교 평가한다.

이 논문의 구성은 다음과 같다. 제2장에서는 관련 연구를 소개 및 분석한다. 제3장에서는 제안 시스템의 프로세스와 구현 결과를 기술하며, 제4장에서는 실험 및 평가를 기술한다. 마지막으로, 제5장에서는 결론 및 향후 연구를 서술한다.

Ⅱ. 관련 연구

2.1 해양 쓰레기 분류 연구

드론을 이용하여 해양 쓰레기 분류 연구가 진행되어 왔다[3]-[6]. [3]은 드론으로 해안 쓰레기를 촬영하고 배경 차감 기법, 문턱치 기법, 모폴로지 기법을 사용해서 이미지에서 물체를 추출한다. 이미지에서 배경을 상쇄해서 물체 인식만 하기 때문에 정확한 종류 식별에 어려움이 있다.

[4]는 드론과 딥러닝을 이용하여 해안 쓰레기를 실시간으로 모니터링할 수 있는 시스템을 제안한다. Mask R-CNN(Mask Region-based Convolutional Neural Network)과 SegNet 알고리즘을 적용하여 객체를 식별하고 탐지할 수 있다. 그러나 이 연구에서는 일정한 높이에서 촬영한 이미지이기 때문에 어구, 쓰레기 무더기 등과 같은 크기가 큰 해안 쓰레기를 대상으로 실험을 진행하여 크기가 작은 캔, 비닐봉지는 식별할 수 없다. 또한, 시스템 구축을 위한 높은 비용의 인프라가 필요하다.

[5]는 무인항공기를 이용하여 해양 쓰레기 이미지를 수집하고 CNN 기반의 분류 모델을 제안한다. 하지만, 이 연구는 이미지에서 초목, 바다, 모래가 아닌 물체를 쓰레기로 인식한다. 이 과정에서 분류 모델은 물체 인식은 가능하지만, 쓰레기의 종류 식별은 사람이 직접 해야 한다는 문제점을 지닌다.

[6]은 Python의 Keras을 이용하여 3층 인공신경망을 사용하여 머신 러닝을 수행한다. 이 연구에서 사용된 영상처리 방법은 해변의 HSV 값을 훈련해서 쓰레기가 해변 색상과 유사한 색상을 갖는 경우에 제한될 수 있다. 또한, 크기가 큰 플라스틱 쓰레기 검출은 용이하지만, 비닐봉지와 같은 얇은 물체는 감지할 수 없다는 문제점을 보인다.

2.2 클라우드 이미지 분류 모델 응용 연구

물체 식별을 위해 클라우드 이미지 분류 모델 구축에 관련된 다양한 연구들이 진행되어 왔다.

Custom Vision은 Microsoft의 머신 러닝 알고리즘을 이용하는 이미지 분류 서비스이다. 사용자가 이미지를 고유의 레이블로 지정하면 이를 감지하고 지정 모델을 학습할 수 있다[15]. [9]는 모바일 기기로 이미지를 촬영하면 손톱의 색이나 모양을 인식해 어떤 손톱 질환인지 예측하는 시스템이다. 12가지의 손톱 질환을 세밀하게 분류하고 높은 정확도를 보인다. [10]은 Raspberry Pi 3에 Custom Vision을 사용해서 백미 부패를 감지하는 시스템이다. 이 연구는 백미 부패 감지의 정확도가 85%이다. 또한, 클라우드 서비스를 사용해서 대규모의 장비 구축을 하지 않아 편리성이 뛰어나다.

AutoML Vision은 Google의 머신러닝 모델 클라우드 서비스이다. 사용자가 라벨링을 한 이미지로 모델을 구축하고 성능 평가를 자체적으로 진행하고 라벨링이 안된 이미지가 포함된 세트는 수동라벨링을 진행하여 학습을 도와준다[16]. [11]은 사과의 부패 상태나 저품질 사과를 분류하는 시스템이다. 기존 시스템보다 좋은 품질의 사과를 분리하는 시간이 단축된다. 또한, 일관성이 있는 분류가 가능해 경제성이 있다. [12]는 침윤성 유관암을 식별하는 시스템이다. 이 시스템은 이전 연구보다 암을 진단하는 성능이 뛰어나고 인프라와 배포가 유연하다는 장점을 보인다.

AWS의 Amazon Rekognition은 딥러닝 기술을 이용하여 이미지를 분류할 수 있는 모델이다. Custom Labels를 사용하여 사용자가 요구하는 객체의 이미지를 라벨링 하여 학습을 진행한다. 이미지는 물론 비디오에서도 객체 및 장면을 인식한다[17]. [13]은 드론으로 촬영한 이미지로 산불 인식을 하는 연구이다. 실시간으로 상황을 수집하고 산불 인식을 진행하여 빠른 산불 인식을 통해 신속한 진화 작업과 구조를 수행할 수 있다. [14]는 카셰어링의 문제점인 면허증 도용과 사용자 식별 문제를 해결하기 위해 사용자 확인 시스템을 제안한다. 이 시스템은 사용자별로 사진 저장 및 관리가 용이해 정확성이 높고, 빠른 인식이 가능하다는 장점을 보인다.

Ⅲ. 제안 시스템 및 구현

3.1 제안 프로세스

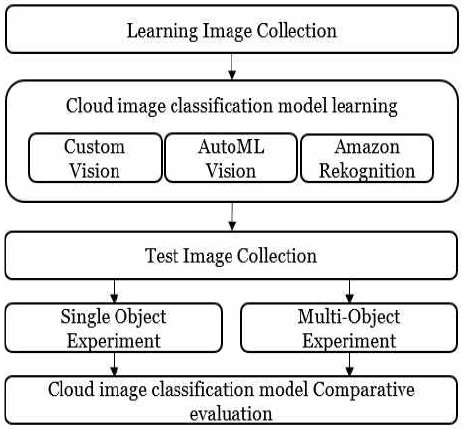

그림 1은 이 논문에서 제안하는 클라우드 이미지 분류 모델 비교 평가 프로세스를 보인다. 첫 번째 단계는 클라우드 이미지 분류 모델의 학습을 위한 일반적인 쓰레기 이미지를 웹 크롤링과 쓰레기 이미지 수집 및 저장 모듈을 사용해서 수집한다. 이후, 클라우드 이미지 분류 모델을 구축한다. 이미지 분류 모델은 Microsoft의 Custom Vision, Google의 AutoML Vision, AWS의 Amazon Rekognition을 사용한다. 다음 단계는 이미지 분류 모델의 평가를 위하여 드론을 이용한 실제 해안 쓰레기를 촬영한다.

해안 쓰레기 이미지 수집 시 더 정확한 이미지 식별 환경을 설정하기 위하여 고도와 속도별로 이미지를 수집한다. 실험은 단일 쓰레기 객체와 다중 쓰레기 객체를 구분하여 각각 진행한다. 마지막으로 실험 결과를 바탕으로 3가지의 이미지 분류 모델을 비교 평가하여 해안 쓰레기 식별에 가장 성능이 우수한 모델을 찾는다.

3.2 구현 환경

구현 환경은 표 1과 같다. 학습 이미지를 저장하고 클라우드 이미지 분류 모델을 구축하기 위해 서버 운영체제는 Windows 10 Pro를 사용하며, 데이터베이스는 MariaDB 10.3.8를 사용한다. 학습 이미지 수집과 GCC 앱의 모바일 운영체제는 Android 4.1을 사용한다. 드론의 모델명은 DJI Phantom 4 Pro V2.0이고, 카메라는 드론에 달린 1“CMOS를 사용한다.

3.3 학습 이미지 수집 및 모델 학습

클라우드 이미지 분류 모델을 구축하기 위해서 쓰레기 이미지를 수집한다. 쓰레기 이미지 수집 방법은 두 가지로 웹 크롤링과 자체적으로 개발한 모바일 앱을 사용한다. 웹 크롤링을 통해 일부 학습 이미지를 수집한다. 그러나 모델을 학습하기 위해 많은 양의 실제 이미지 수집이 필요하고, 사람들이 수집에 참여하여 다수의 이미지를 서버에 저장하는 방법이 필요하다. 또한, 수집된 이미지의 상세 정보를 체계적으로 관리할 필요가 있다. 따라서 자체적으로 모바일 앱을 사용해 쓰레기 이미지를 수집하고 데이터 모델을 생성하여 관리한다.

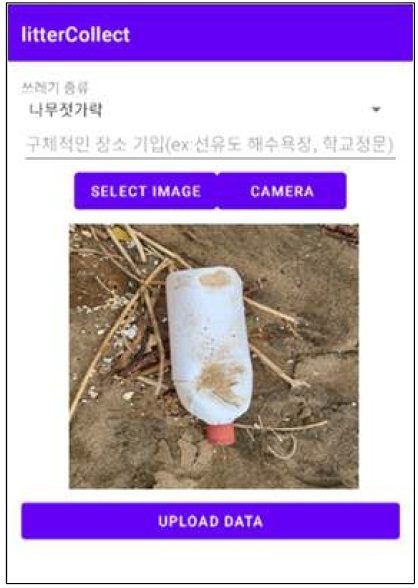

그림 2는 학습 이미지 데이터베이스이다. 데이터베이스에는 위치 정보, 쓰레기 종류, 이미지 경로, 날짜, 위도, 경도, 고도, 속도가 저장된다. 데이터베이스에 정보를 저장하기 위해 그림 3을 이용한다.

그림 3은 학습 이미지를 수집하기 위한 모바일 앱 화면을 보여준다. 사용자가 쓰레기 종류를 선택하고 위치 정보인 경도와 위도도 전송이 되지만, 상세 주소를 작성한다. 사진을 촬영하거나 선택해서 서버에 전송한다. 서버에 지정된 폴더 내에 이미지가 저장된다.

그림 4는 일부 학습 이미지이다. 학습 이미지는 2020년 국가 해안 쓰레기 모니터링 보고서[2]의 통계자료를 바탕으로 해안 쓰레기의 종류들을 선정하였으며, 해안 쓰레기의 대부분을 차지하고 있는 플라스틱류의 플라스틱병과 비닐봉지, 목재류의 나무젓가락, 종이류의 종이컵, 금속류의 캔과 같이 총 5가지를 선정하였다. 수집 이미지의 양은 종류별 500개씩 총 2,500개이며, 각 이미지에 라벨링을 진행하였다. 그 후, 클라우드 이미지 분류 모델인 Custom Vision, AutoML Vision, Amazon Rekognition을 학습하였다.

3.4 실험 이미지 수집

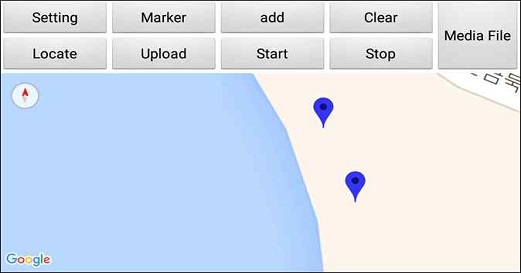

구축된 클라우드 이미지 분류 모델을 비교 평가하기 위하여 실험 이미지의 수집이 요구된다. 실험 이미지 수집을 위해 드론 GCS(Ground Control System)앱을 제작한다. 그림 5는 GCS 앱의 화면을 보인다. GCS 앱은 드론의 자율주행을 하기 위해 만든 앱이다. 앱 화면에서 고도와 속도를 지정하고 자율주행 경로를 지정한다. 비행이 시작되면 1초에 한 장씩 경로를 따라 이미지 촬영을 진행한다.

해안 쓰레기 이미지 수집을 위한 장소는 선유도해수욕장과 변산해수욕장으로 진행하였다. 실험을 위하여 드론 원스톱 민원서비스를 통하여 항공사진 촬영을 허가받았다. 쓰레기 이미지의 수집 방법은 [7]에서의 실험 요인인 고도, 속도를 사용하여 고도와 속도별로 이미지를 수집하고, 단일 객체와 다중 객체를 구분하여 각각 촬영하였다.

단일 객체 실험 이미지를 수집하기 위해 고도는 3m에서 10m까지, 속도는 2m/s에서 4m/s까지로 총 24가지의 종류를 비행하였다. 고도와 속도를 달리하여 10장씩 쓰레기 이미지를 수집하여 총 1,200장의 이미지를 수집하였다. 다중 객체 실험 이미지는 고도 3m에서 5m까지, 속도는 2m/s에서 4m/s까지로 총 9가지의 종류를 고도와 속도를 다르게 비행하여 총 450장의 실험 이미지를 수집하였다.

Ⅳ. 실험 및 평가

4.1 실험 방법

논문에서는 단일 객체 실험과 다중 객체 실험을 구분하여 진행한다. 실험 항목은 플라스틱병, 비닐봉지, 나무젓가락, 종이컵, 캔으로 총 5가지 항목을 선정하였다. 클라우드 이미지 분류 모델은 Custom Vision, AutoML Vision, Amazon Rekognition을 사용한다.

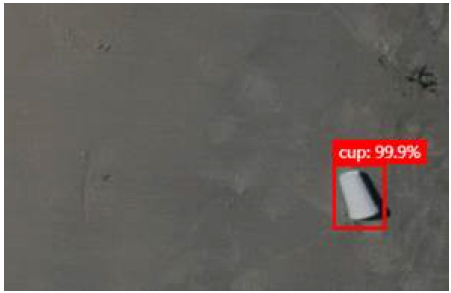

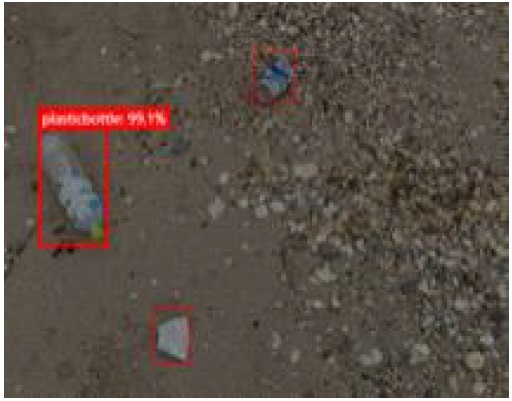

첫 번째 실험은 단일 객체 실험으로 한 장의 이미지에 쓰레기가 한 개 있을 때 정확도를 실험한다. 그림 6은 단일 객체 실험 이미지이다. 고도 3m부터 10m까지 8가지, 속도 2m/s부터 4m/s까지 3가지, 실험 항목 5가지로 총 120가지를 10번씩 반복해서 고도별 속도별 평균 정확도를 계산한다.

두 번째 실험은 다중 객체 실험으로 한 장의 이미지에 여러 개의 쓰레기가 있을 때 정확도를 실험한다. 그림 7은 다중 객체 실험 이미지이다. 고도 3m부터 5m까지 3가지, 속도 2m/s부터 4m/s까지 3가지, 실험 항목 5가지로 총 45가지를 10번씩 반복해서 고도별 속도별 평균 정확도를 계산한다.

4.2 단일 객체 실험 결과

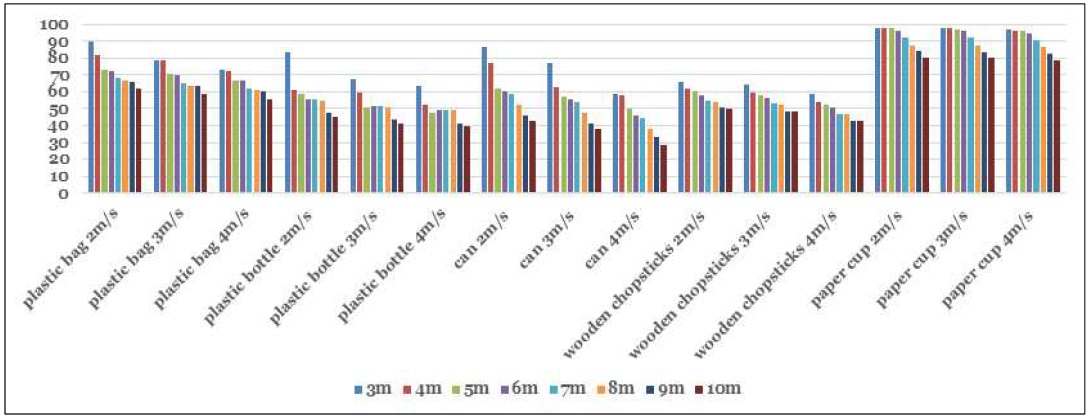

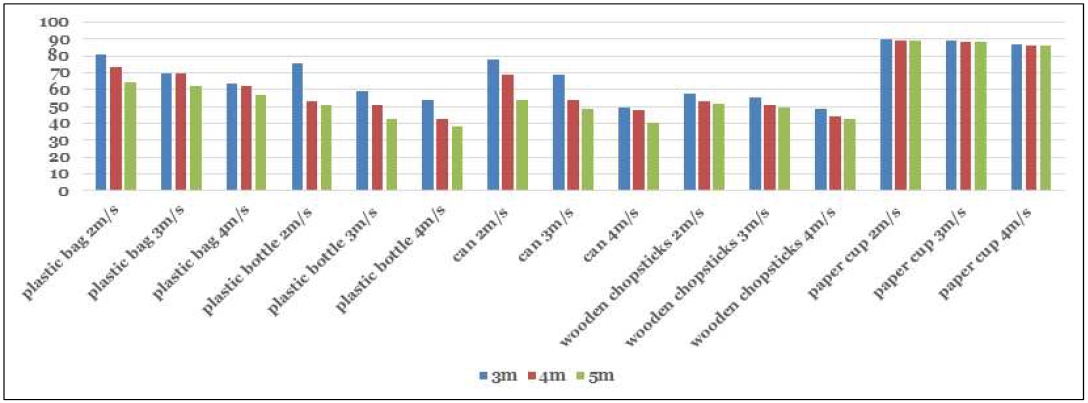

그림 8은 Custom Vision을 이용한 단일 객체 실험 결과이다. 실험 항목인 비닐봉지, 플라스틱병, 캔, 나무젓가락, 종이컵 총 5가지의 항목에서 모두 낮은 고도인 3m에서 높은 정확도를 보였고 4m~10m로 1m씩 올라갈 때마다 정확도가 낮아지는 것을 알 수 있다. 또한, 속도도 제일 낮은 2m/s에서 높은 정확도를 보였고 그다음으로 3m/s, 4m/s 순으로 정확도가 높았다.

그림 9는 AutoML Vision을 이용한 단일 객체 실험 결과이다. 5가지 항목에서 모두 고도 3m, 속도 2m/s에서 높은 정확도를 보였다.

그림 10은 Amazon Rekognition을 이용한 단일 객체 실험 결과이다. 고도 3m, 속도 2m/s에서 높은 정확도를 보였다.

3가지 클라우드 이미지 분류 모델에서 기존 연구[7]과 다르게 모두 고도 3m, 속도 2m/s가 제일 높은 정확도를 보였다. 나무젓가락에 대한 정확도가 3가지 모델에서 낮은 정확도를 보였는데 그 이유는 나무젓가락이 해안가와 비슷한 색상을 가지고 있어서 오인식하는 경우가 발생했다. 또한, 종이컵의 인식률은 3가지 모델에서 다 높았다. 그 이유는 종이컵은 해안가 색상과 대비되는 흰색 아니면 고채도 색상을 가지고 있기 때문에 높은 정확도를 보였다.

표 2는 단일 객체 실험 비교 평가 결과를 보여준다. 제일 높은 정확도를 보인 고도 3m, 속도 2m/s일 때의 정확도와 이미지 분류 모델의 성능 평가를 위해 재현율과 AP(Average Precision)를 비교한다. AP는 물체 검출 알고리즘의 성능지표로 정밀도와 재현율을 사용하여 값을 구한다. AP의 값이 클수록 물체 검출 알고리즘이 우수하다. 쓰레기 종류 5가지의 정확도, 재현율, AP를 평균을 계산하여 비교하였다. Custom Vision이 다른 두 모델보다 3가지의 비교 평가에서 우수한 성능을 보였다.

또한, 표 3은 실행 시간을 보여준다. 실행 시간은 이미지 한 장을 실험했을 때 물체 검출까지의 시간을 측정한 값으로 Custom Vision이 가장 빠른 결과를 보였다.

4.3 다중 객체 실험 결과

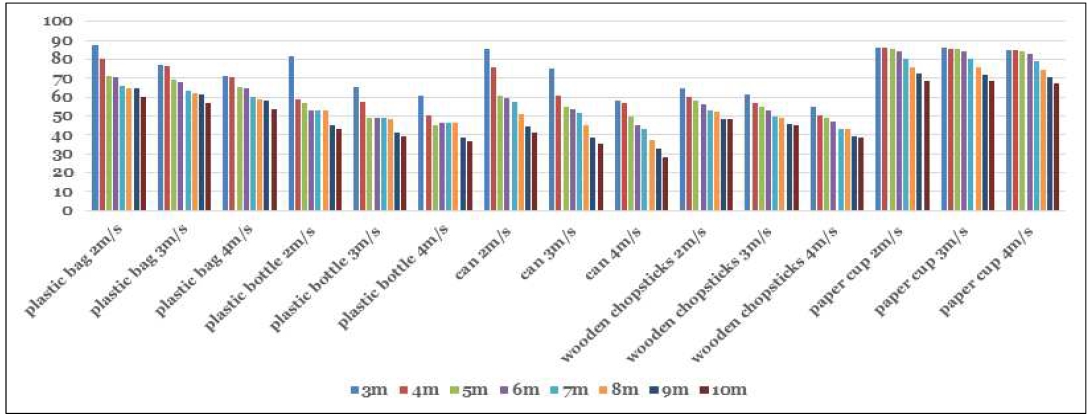

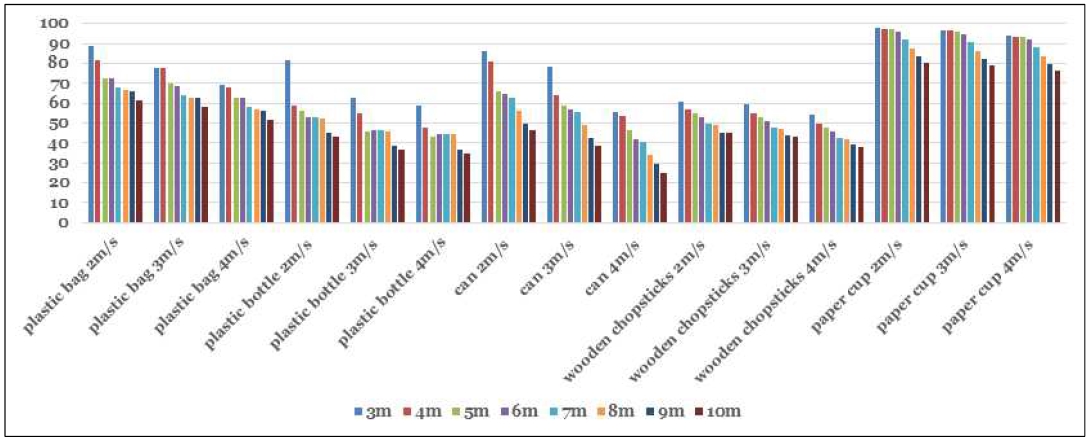

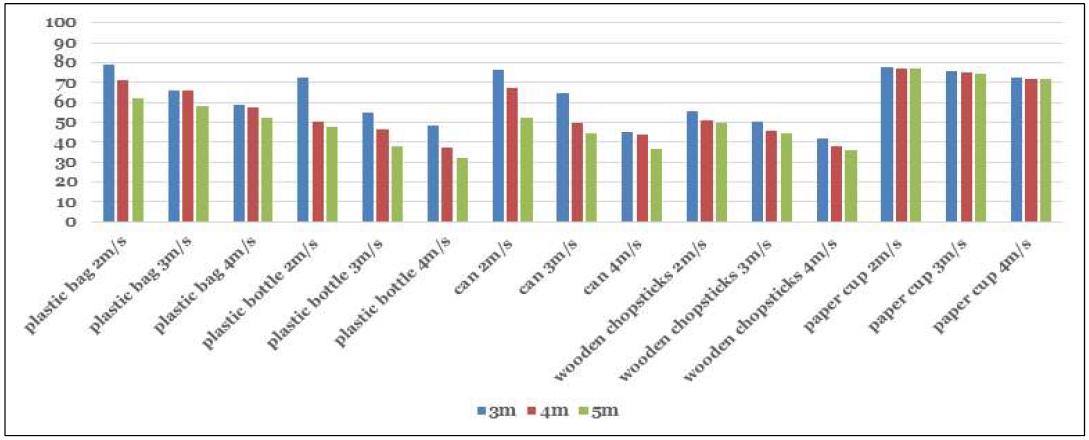

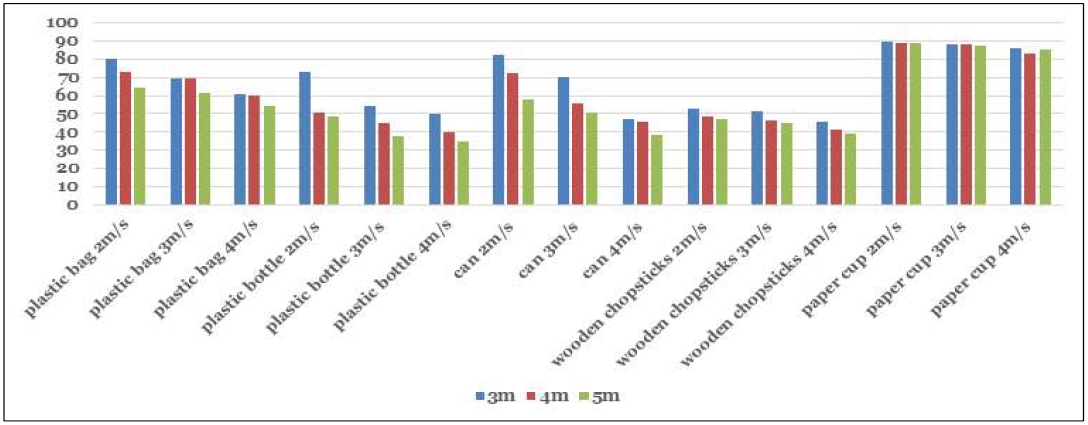

그림 11은 Custom Vision을 이용한 다중 객체 실험 결과이다. 실험 항목인 비닐봉지, 플라스틱병, 캔, 나무젓가락, 종이컵 총 5가지의 항목에서 모두 낮은 고도인 3m에서 높은 정확도를 보였고 4m, 5m 순으로 정확도가 높았다. 또한, 속도도 제일 낮은 2m/s에서 높은 정확도를 보였고 그다음으로 3m/s, 4m/s 순으로 정확도가 높았다.

그림 12는 AutoML Vision을 이용한 다중 객체 실험 결과이다. 5가지 항목에서 모두 고도 3m, 속도 2m/s에서 높은 정확도를 보였다.

그림 13은 Amazon Rekognition을 이용한 다중 객체 실험 결과이다. 이 실험 결과도 고도 3m, 속도 2m/s의 결과가 제일 높은 정확도를 보였다.

표 4는 다중 객체 실험 비교 평가를 보여준다. 정확도와 이미지 분류 모델의 성능 평가를 위해 재현율과 AP를 비교한다. 단일 객체 실험 결과와 동일하게 Custom Vision의 정확도, 재현율, 그리고 AP가 쓰레기 종류 5가지에서 모두 높은 결과를 보인다. 또한, 표 5에서 실행 시간을 비교했을 때 Custom Vision이 가장 빠른 실행 시간을 보였다. 따라서, 단일 객체 실험과 다중 객체 실험 모두 Custom Vision 모델이 우수하다.

Ⅴ. 결 론

이 논문은 드론을 이용하여 해안 쓰레기 식별을 위한 클라우드 이미지 분류 모델을 비교 평가를 수행한다. 드론으로 수집한 이미지를 분류하기 위해 클라우드 이미지 분류 모델을 사용하고 비교 평가하였다. 학습 이미지를 수집 및 저장하는 모듈을 구현하여 클라우드 이미지 분류 모델인 Custom Vision, Amazon Rekognition, AutoML Vision을 구축하였다. 또한, 드론을 이용해 해안 쓰레기를 수집하여 단일 객체 실험과 다중 객체 실험을 진행하고 비교 평가를 하였다. 그 결과 Custom Vision이 단일 객체와 다중 객체 실험 모두에서 정확도, 재현율, AP가 높고, 실행 시간이 가장 짧아 우수한 성능을 보였다.

향후 연구에서는 Custom Vision을 활용하여 해안 쓰레기를 모니터링할 수 있는 시스템을 제작하여 실험 결과를 바탕으로 시각화를 진행할 예정이다.

Acknowledgments

이 연구는 2019년도 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(NRF-2019R1I1A3A01060826)

2021년도 한국정보기술학회 하계종합학술대회에서 발표한 논문(해안쓰레기 식별을 위한 클라우드 기반 이미지 분류 모델의 비교 평가)을 확장한 것임.

References

- H. K. Min, "Current status of domestic marine litter and government policies related to marine litter", Korean Society for Environmental Edudation Conference, Busan, Korea, pp. 176-186, Dec. 2019.

- Korea Marine Environment Management Corporation, https://www.koem.or.kr/site/koem/ex/board/View.do?cbIdx=370&bcIdx=30182, . [acessed: Sep. 10, 2021]

-

S. W. Jang, S. K. Lee, S. Y. Oh, D. H. Kim, and H. J. Yoon, "The Application of Unmanned Aerial Photograpy for Effective Monitoring of Marine Debris", Journal of the Korean Society of Marine Environment & Safety, Vol. 17, No. 4, pp. 307-314, Dec. 2011.

[https://doi.org/10.7837/kosomes.2011.17.4.307]

- D. K. Chung, M. H. Lee, H. Y. Kim, and I. P. Lee, "Development of the Real Time Marin Debris DetectionSystem base on the Deep Learning and Drone Image", Korean Society for Geospatial Information Science, Seoul, Korea, pp. 136-138, Nov. 2019.

-

L. Fallati, A. Polidori, C. Salvatore, L. Saponari, A. Savini, and P. Galli, "Anthropogenic Marine Debris assessment with Unmanned Aerial Vehicle imagery and deep learning: A case study along the beaches of the Republic of Maldives", Science of The Total Environment, Vol. 693, No. 133581, pp. 1-12, Nov. 2019.

[https://doi.org/10.1016/j.scitotenv.2019.133581]

-

S. Kako, S. Morita, and T. Taneda, "Estimation of plastic marine debris volumes on beaches using unmannedaerial vehicles and image processing based on deep learning", Marine Pollution Bulletin, Vol. 155, No. 111127, pp. 1-9, Jun. 2020.

[https://doi.org/10.1016/j.marpolbul.2020.111127]

-

D. W. Jeong, Y. J. Lee, and S. H. Lee, "A Study on Trash Recognition Rate and Drone Speed", Journal of KIIT, Vol. 19, No. 5, pp. 39-50, May 2021.

[https://doi.org/10.14801/jkiit.2021.19.5.39]

- J. H. Lee, S. H. Lee, and D. W. Jeong, "Comparison of Cloud-based Image Classification Models for Coastal Trash Identification", Korean Institute of Information Technology, Jeju, Korea, pp. 317-319, Jun. 2021.

-

Sholomon. L. Pinoliad, Duanne. Austin. N. Dichoso, Arlene. R. Caballero, and Erlito. M. Albina, "onyxRay: A Mobile-Based Nail Diseases Detection Using Custom Vision Machine Learning", International Conference on Information and Education Innovations, New YorkNYUnited States, pp. 126-133, Jul. 2020.

[https://doi.org/10.1145/3411681.3411698]

-

C. L. Batugal, J. M. P. Gupo, K. K. Mendoza, A. S. Santos, F. A. Malabanan, J. N. T. Tabing, and C. B. Escarez, "EyeSmell: Rice Spoilage Detection using Azure Custom Vision in Raspberry Pi 3", IEEE region 10 conference, Osaka, Japan, pp. 738-743, Nov. 2020.

[https://doi.org/10.1109/TENCON50793.2020.9293915]

-

Kiron Deb, Shobhin Basu, Vamshi Krishna Palakurthy, and N. Bhattacharyya, "Accelerated Sorting of Apples Based on Machine Learning", Fourth International Conference on Smart Computing and Informatics, pp. 765-771, Jul. 2021.

[https://doi.org/10.1007/978-981-16-0878-0_75]

-

Y. Zeng and J. Zhang, "A machine learning model for detecting invasive ductal carcinoma with Google Cloud AutoML Vision", Computers in Biology and Medicine, Vol. 122, No. 103861, pp. 1-8, Jul. 2020.

[https://doi.org/10.1016/j.compbiomed.2020.103861]

- S.-E. Choi and J.-H. Bang, "The Design and Implementation of Mobile Application Solution for Forest Fire based on Drone Photography and Amazon Web Service (AWS)", Journal of Internet Computing and Services, Vol. 21, No. 5, pp. 31-37, Oct. 2020.

- B. E. Ahn, H. D. Lee, and D. S. Cho, "User Authentication System Using Amazon Recognition", The HCI Society of Korea, Jeongseon, Korea, pp. 844-846, Jan. 2018.

- Microsoft Azure, https://azure.microsoft.com/ko-kr/services/cognitive-services/custom-vision-service/#overview, . [acessed: Aug. 17, 2021]

- Google Cloud, https://cloud.google.com/vision/automl/docs, . [acessed: Aug. 17, 2021]

- Aws, https://aws.amazon.com/ko/rekognition/?blog-cards.sort-by=item.additionalFields.createdDate&blog-cards.sort-order=desc, . [acessed: Aug. 17, 2021]

2018년 3월 ~ 현재 : 군산대학교 소프트웨어융합공학과 학부생

관심 분야 : 데이터베이스, 프로그래밍, 사물인터넷

2009년 2월 : 고려대학교 전자및정보공학부(학사)

2011년 2월 : 고려대학교 컴퓨터·전파통신공학과(공학석사)

2016년 2월 : 고려대학교 컴퓨터·전파통신공학과(공학박사)

2016년 3월 ~ 2017년 3월 : 아주대학교 의료정보학과 연구강사

2017년 4월 ~ 현재 : 군산대학교 소프트웨어융합공학과 부교수

관심 분야 : 사물인터넷, 메타데이터, 센서 레지스트리, 시맨틱 웹, 경로 예측

1997년 : 군산대학교 컴퓨터과학과(학사)

1999년 : 충북대학교 전산학과(석사)

2004년 : 고려대학교 컴퓨터학과(박사)

2005년 ~ 현재 : 군산대학교 소프트웨어융합공학과 교수

관심분야 : 데이터베이스, 시맨틱 서비스, 빅데이터, 사물인터넷, 엣지컴퓨팅, 지능형 융합 서비스