얼굴의 깊이 정보를 이용한 실제 얼굴 여부를 판단하는 생-얼굴 검사 방법

초록

기존의 얼굴 인식 시스템은 카메라로 캡처된 얼굴 이미지를 분석 대상으로 하므로, 종이에 인쇄되었거나 스마트 기기 화면에 표출된 얼굴 사진 등 실제 사람 얼굴이 아니더라도 정상적으로 식별 또는 유효성 검사를 수행한다. 이것은 종이 또는 스마트 기기 화면에 표출된 얼굴 이미지를 이용한 도용의 가능성이 있다. 이러한 문제를 해결하기 위해 본 논문에서는 얼굴 표면의 깊이 정보의 분포를 이용하여 캡처 대상이 실제 얼굴인지를 판단하는 생-얼굴 검사 방법을 제안한다. 또, 본 본문에서 제안한 방법의 구현을 통해 실제 얼굴, 종이에 인쇄된 사진 및 구부려서 의도적으로 깊이를 준 사진 등을 대상으로 실험하여 본 논문에서 제안한 방법이 실제 얼굴 여부 결정에 유효하며, 안면 인식 시스템의 전처리 단계로 사용될 수 있음을 보인다.

Abstract

Because previous face recognition systems analyze a face image captured by a camera, these systems successfully carry out identification or verification process even though using a non-live face, such as images printed on paper or presented on a smart device screen. In this case, it is possible to deceive face recognition systems using a non-live face. To solve this problem, in this paper, we propose a live face test method that decides whether a captured face is live or not by using of distribution depth information on a face. And, we implement our live face test method, and experimentally run our implementation using a live face, an image printed on paper, and a slightly wrapped image. From a result of experimental runs, we show that our method proposed in this paper is effective and can contribute as a preprocessing step of a face recognition system.

Keywords:

live face, face, liveness detection, face recognition, depth, depth distributionⅠ. 서 론

얼굴, 지문, 홍채 등의 신체적 특성은 사람마다 다르므로 이를 이용한 각종 생체인증 시스템이 관련 센서 기술의 발달과 함께 대중화되고 있다. 특히 카메라 성능의 향상과 얼굴 인식(Face recognition) 기술의 발전은 얼굴 이미지를 인증에 활용하는 응용 분야를 증가시켰다[1].

카메라가 캡처하는 얼굴 이미지는 지문, 홍채 등 다른 신체적 특성에 비해 비교적 쉽게 위·변조가 되므로 인증 과정에 보안 취약점이 되고 있다[1][2]. 특히, [3]의 연구에서는 기계학습의 GAN[4] 모델을 이용하여 유명인의 사진을 학습시켜 사람 얼굴을 생성하는 기술을 소개하였다. 따라서 실제 영상과 생성되거나 조작된 가짜 영상을 구별하기 위한 기술이 인증 시스템에 필요하게 되었다.

또 진짜 얼굴이 아닌 얼굴 이미지를 출력한 종이 또는 얼굴 이미지가 출력된 스마트 기기의 화면을 이용하여 얼굴 인식 시스템을 속이는 스푸핑 공격도 있다[5][6]. 이것은 앞서 기술한 생성 또는 조작한 얼굴 이미지가 아니고 실제 얼굴을 캡처한 이미지를 이용한다는 점에서 차이가 있다. 인터넷 등 여부 매체에 공개된 유명인의 사진을 이용하여 인증 시스템을 통과했다면 이것은 사진을 조작한 것이 아니므로 스푸핑에 해당이 된다. 이러한 스푸핑은 얼굴 인식 알고리즘이 실제 얼굴, 사진 또는 스마트 기기 화면에 표현된 사진을 카메라가 캡처한 이미지를 대상으로 처리하기 때문에 발생하는 문제이다. 즉, 얼굴 인식 알고리즘은 입력 이미지가 실제 얼굴 또는 종이에 인쇄된 얼굴인지를 판단할 수 없기 때문이다.

이러한 스푸핑 공격을 탐지하기 위한 다양한 안티 스푸핑(Anti-spoofing) 방법이 연구되고 있으며, 이들 방법의 핵심은 대상이 실제 사람 얼굴인가를 판단하는 생-얼굴 검사(Liveness detection, Live face test)이다. 생-얼굴 검사는 캡처된 생체 정보―본 논문에서는 얼굴로 한정―가 캡처되는 시점에 실제 사람을 대상으로 한 것인가를 판단하는 것이다[7].

생체 여부 검출을 기반으로 한 안티 스푸핑은 정적 기반과 동적 기반 탐지로 나눌 수 있다[1]. 정적 기반 탐지기법은 Wavelet[8], HOG[9] 등의 알고리즘을 이용하여 종이에 출력된 이미지에 있을 수 있는 흐릿하거나 희미한 줄을 감지하여 실제 얼굴과 출력된 사진을 구분하는 질감 분석(Texture analysis)을 통해 탐지한다. 하지만 이런 방법들은 조명, 배경 등의 주변환경과 의도적인 왜곡에 영향을 받을 수 있다.

동적 기반 탐지는 실제 얼굴에서 발생할 수 있는 미묘한 움직임 및 색상 변화를 통해 실제 얼굴인지를 결정하는 것이다. [10]은 얼굴의 OFL(Optical Flow of Lines)를 통해 얼굴 움직임을 검출한다. 하지만 스마트 기기 화면에 동영상으로 재생되는 얼굴이면 이 방법은 스푸핑 검출의 한계를 가진다.

본 논문에서는 조명, 배경 등 주변 환경에 영향을 받지 않으며, 스마트 기기 화면에 표현되는 동영상에 영향을 받지 않고 생체 여부 검출을 할 수 있는 방법을 제안한다. 사람의 얼굴은 다양한 형태의 굴곡을 가지고 있고, 이것은 얼굴 위의 각 지점과 카메라 등의 캡처 장치 사이의 거리―본 논문에서는 깊이라고 정의―를 다르게 한다. 이를 이용하여 본 논문에서 제안하는 생체 여부 검출 방법은 얼굴 위 다수의 지점에 대한 깊이 정보를 검출하고, 이 정보의 분포를 기반으로 하고 있다. 본 논문에서 제안하는 n-DLiveFT는 네 방향으로 검출된 n개의 깊이 정보 검출하고, 각 방향의 깊이 정보의 분포를 이용하여 대상의 생체 여부 검출을 수행한다.

본 논문의 구성은 다음과 같다. 2장에서는 깊이 정보를 이용한 얼굴 검출 또는 인식과 관련된 연구를 소개하고, 3장에서는 깊이 정보를 기반으로 한 생체 여부 검출 방법을 기술한다. 4장에서는 제안한 방법의 구현 및 실험 결과를 기술하며, 5장에서는 결론 및 향후 연구과제를 기술한다.

Ⅱ. 관련 연구

얼굴 검출, 인식 분야에서 깊이 정보는 다양한 목적으로 사용되고 있다. [11]은 얼굴은 사람의 식별하기 위한 중요한 생체 측정(Biometric)의 특징으로 정의하고 있으며, 이를 얼굴 식별 또는 검증에 활용하고 있으며, 카메라를 이용하여 캡처한 2차원 이미지를 주된 대상으로 하고 있다. 특히, [11]은 공공장소에 설치된 디지털 광고판(Digial signage)에서 게시되고 있는 광고와 관련된 정보 즉, 어떤 광고에 사람들이 관심을 가지며, 그 사람의 위치를 분석하기 위해 카메라로 캡처한 이미지에서 사람의 얼굴을 검출하는 방법을 제안하였다. 특히 캡처된 이미지에 존재하는 모든 얼굴을 검출하는 것이 아니라 디지털 광고판에서 0.5m에서 2.5m 내에 있는 사람 중 얼굴이 광고판을 향해 있는 사람의 공간적 위치를 분석하기 위해 깊이 정보를 사용하였다. 즉, [11]에서 사용된 깊이 정보는 얼굴 검출 대상의 범위 축소를 위한 목적으로 사용되었다.

카메라를 이용하여 캡처된 이미지에 내에 있는 얼굴 이미지는 대상과 거리, 촬영 방법 등 여러 요인으로 인해 그 크기가 다양하다. 따라서, 이러한 이미지에서 얼굴을 검출하는 것은 상대적으로 긴 실행 시간이 필요하며, 잘못 검출되는 비율도 높다. 이러한 문제를 해결하기 위해 [12]의 저자는 얼굴 검출에 필요한 서브 이미지의 수를 감소시키기 위해 깊이 정보를 이용하였다. 즉, [12]에서 제안한 방법은 깊이 정보를 이용하여 얼굴이 존재할 가능성이 있는 영역을 찾음으로써 처리해야 하는 서브 이미지의 수를 감소시킴과 함께 잘못된 얼굴 검출 비율도 감소시키고 있다. 깊이 정보를 검출하기 위해 이 문헌에서 사용한 방법은 스테레오 카메라를 이용하였다. 스테레오 카메라를 이용하여 캡처된 이미지에서 깊이 정보를 추출하기 위한 처리 시간이 추가로 필요하므로 깊이 정보를 이용한 처리 시간 단축의 효과는 다소 감소될 것으로 판단된다.

[13]은 얼굴 이미지를 얼굴 인식 또는 식별 등의 생체 인식 시스템에 입력하기 전 단계로 얼굴 안티 스푸핑이 필요함을 기술하고, 이를 위해 깊이 정보를 이용하였다. 기존에는 생-얼굴과 프린터로 출력된 사진 등 도용된 얼굴 사이의 질감의 차이 또는, 기계학습 모델인 CNN을 이용하였으나 2차원 이미지를 이용하는 이 방법들은 주변 배경, 조명, 촬영 조건 등에 영향을 많이 받는다[13]. 이러한 문제를 해결하기 위해 [13]은 RGB 이미지를 이용하여 깊이 기반 CNN 학습 모델을 이용하여 깊이 정보를 예측하고 이를 안티 스푸핑에 활용하였다. 하지만 2차원 이미지를 입력으로 하는 학습 모델을 이용하여 깊이 정보를 예측하므로 깊이 정보 추출에 한계가 있는 것으로 판단되며, 학습 모델을 이용한 예측을 이해 추가 시간이 필요하다.

Ⅲ. 깊이 기반 얼굴 생체 여부 검사 방법

3.1 얼굴 깊이 정보

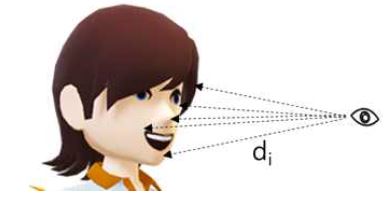

사람의 얼굴은 눈, 코, 입 등의 구성요소를 포함하고 있으며, 이 구성요소들이 얼굴 표면의 굴곡을 만든다. 얼굴의 구성요소에 의한 굴곡은 그림 1과 같이 얼굴을 바라보고 있는 눈과 얼굴 표면의 지점 사이의 거리 di(i=1…n, n은 거리 측정을 위한 얼굴 표면 지점의 수)를 다르게 한다. 본 논문에서는 얼굴의 굴곡에 의해 생성되는 거리 di를 깊이(Depth)라고 정의한다.

깊이는 얼굴 구성요소의 입체감을 판단할 수 있는 정보를 제공하지만, 얼굴 식별 또는 얼굴 검증 등의 안면 인식 시스템 적용에 요구되는 충분한 특징 정보를 제공하지 못한다. 하지만 깊이 정보는 안면 인식 대상이 실제 얼굴(Live face, 이하 생-얼굴)인가를 판단할 수 있는 생-얼굴 검사에 사용될 수 있는 핵심 정보를 제공할 수 있다. 인텔사의 RealSense 등의 깊이 카메라(Depth camera)는 캡처한 각 픽셀의 깊이 정보를 제공하며, 이를 이용하여 카메라와 캡처된 이미지 내에 있는 얼굴의 각 요소까지의 거리 di를 알 수 있다.

실제 얼굴을 대상으로 깊이 정보를 검출하면 얼굴의 각 지점을 위한 깊이는 다르다. 반면 안면 인식의 대상이 되는 사람의 얼굴을 촬영하여 종이 매체에 인쇄하거나 스마트 기기 화면에 표출된 이미지는 2-차원 표면에 표출된 얼굴이므로 이것을 대상으로 검출된 깊이 정보는 유의미한 차이를 보이지 않는다.

이처럼 얼굴을 대상으로 검출된 여러 지점의 깊이 정보 사이의 유의미한 차이를 이용하여 대상의 생체 여부를 판단할 수 있다.

대상 얼굴의 생-얼굴 검사는 조작 또는 생성된 이미지를 대상으로 하는 것과 다르게 인식 대상이 실제 얼굴인가를 판단하기 위한 것이므로 안면 인식 시스템의 가짜 탐지(Fake detection)와 다르다. 즉, 인식 대상의 얼굴을 촬영한 이미지는 조작 또는 생성한 것이 아니므로 가짜 탐지 절차를 통과할 수 있지만, 실제 얼굴이 아니므로 생-얼굴 검사에서는 부정(Negative) 결과가 도출된다.

3.2 얼굴 깊이 정보의 분포

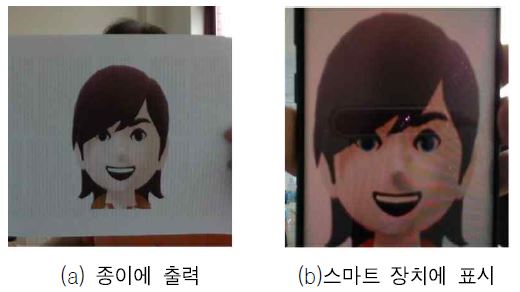

그림 1에서 나타낸 것과 같이 실제 사람의 얼굴을 대상으로 측정한 깊이 di는 얼굴 표면의 굴곡으로 인해 다양한 값을 갖는다. 반면 그림 2와 같이 종이에 인쇄되었거나 스마트 기기 화면에 표현된 얼굴 이미지는 비슷하거나 같은 깊이를 갖는다. 이처럼 실제 사람 얼굴과 2차원 얼굴 이미지에 대한 깊이 정보의 분포에 차이가 있으므로 깊이 정보의 분포는 대상의 생체 여부를 판단할 수 있는 중요한 요소이다.

본 논문에서 제안하는 생-얼굴 검사 방법은 대상 얼굴에서 측정된 깊이 정보의 분포를 기반으로 하고 있다. 즉, 얼굴 생체 여부 검사 방법은 측정된 대상 얼굴이 실제 얼굴인지를 판단하기 위해 대상으로부터 깊이 정보를 검출하고, 그 깊이의 분포를 이용하여 생-얼굴 여부를 결정한다.

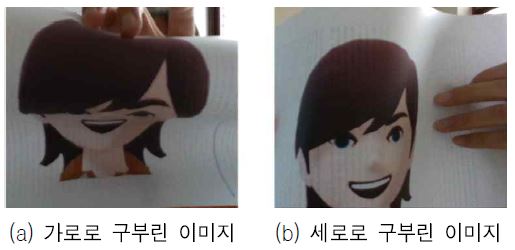

하지만 생-얼굴 검사에 인식 대상 얼굴의 전체 깊이 정보에 대한 분포를 사용하면 그림 3에서 보인 것과 같이 종이에 인쇄된 얼굴 이미지를 가로 또는 세로로 굽힌 왜곡된 이미지에 대해 생체 여부 결정 방법은 잘못된 결정을 도출할 수 있다. 즉, 얼굴이 인쇄된 종이 등을 가로, 세로, 또는 대각선 방향으로 굽히면 측정된 깊이가 다양하게 되어 분포가 증가하게 된다. 따라서, 깊이 정보 전체의 분포를 기반으로 하는 생체 인식 결정 방법은 구부려져 왜곡된 이미지를 실제 얼굴인 것으로 결정하는 오류를 가질 수 있다.

3.3 n-지점 깊이 정보 기반 생체 여부 검사

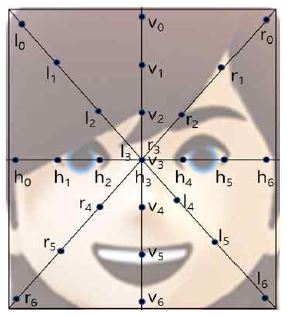

본 논문에서 제안하는 n-지점 깊이 정보 기반 생체 여부 검출 방법(n-DLiveFT, n-location Depth based Live Face Test method)은 얼굴을 대상으로 측정된 전체 깊이 정보 중 네 방향, 각 방향당 n개 지점의 깊이 정보를 이용하여 생-얼굴 여부를 검사한다. 그림 4는 7-DLiveFT이 생체 여부 검사를 위해 깊이를 검출하는 한 방향당 7개 지점을 나타내고 있다.

그림 4에서 가로 방향, 세로 방향, 두 개의 대각선 방향에서 검출하는 7개의 깊이 정보는 식 (1)과 같이 표현할 수 있다.

| (1) |

본 논문에서 제안하는 n-DLiveFT은 측정된 각 방향의 n-개 깊이 정보의 표준 편차를 계산하고, 이를 사전 설정된 임계값과 비교하여 깊이 정보 사이의 차이가 있는가를 판단한다. 이 방법에서는 네 방향의 깊이 정보 h, v, l, r의 표준 편차 stdh, stdv, stdl, stdr을 계산하고, 식 (2)와 같이 임계값 th보다 큰 표준 편차의 수 c를 계산하여, 이를 생체 여부를 판단에 사용한다. 네 방향 7개 지점의 깊이 정보를 이용하는 7-DLiveFT에서는 네 그룹의 깊이 정보에 대한 c의 값이 3 이상이면 실제 얼굴이라고 판단할 수 있다. 생-얼굴 판단 기준으로 c의 값이 3이상인 경우로 설정한 것은 검출된 얼굴 영역에 머리카락 등으로 일부 영역이 가리거나 마스크 등을 착용하고 있는 경우 생-얼굴이더라도 4방향 중 최대 한 방향에서 깊이의 표준 편차가 임계값보다 낮을 가능성이 있기 때문이며, 도용된 사진 또는 인쇄본의 경우 얼굴 검출이 가능한 정도의 변형을 가하더라도 표준 편차가 임계값보다 큰 경우는 4 방향 중 최대 2방향을 넘지 않았다.

| (2) |

본 논문에서 제안한 n-DLiveFT은 네 방향의 n 개 지점에 대한 깊이 정보를 이용하여 생체 여부를 검사하고 있지만, 응용에 따라 측정하는 n개 지점의 그룹 수를 결정할 수 있다. 즉, mxn-DLiveFT으로 확장할 수 있으며, 생-얼굴 여부는 c ≥ (m-p)로 결정할 수 있다. 이때, p의 값은 각 응용에서 결정할 수 있는 파라미터이다. 그림 4에 보인 것은 네 방향, 7개 지점의 깊이 정보를 이용하여 생-얼굴 검사를 하므로 4x7-DLiveFT으로 표현할 수 있으며, 파라미터 p는 1로 하여 대상의 생-얼굴 여부를 결정한다.

Ⅳ. n-DLiveFT의 구현 및 샘플 실험

4.1 구현 환경 및 구성

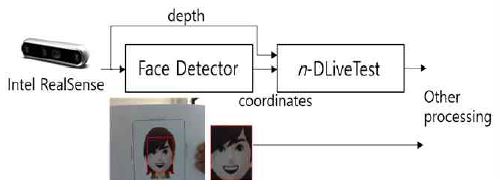

대상의 깊이 정보를 이용하여 실제 얼굴 여부를 판단하는 n-DLiveFT은 대상에 대한 영상 정보와 깊이 정보를 모두 검출할 수 있는 영상 캡처 기기가 필요하다. 본 논문의 n-DLiveFT 구현은 얼굴 이미지와 깊이 검출을 위해 인텔사의 RealSense Depth Camera D435i를 사용하였고, 이미지와 깊이를 각각 640x480의 해상도로 캡처하였다. 또, n-DLiveFT은 얼굴 영역 내에서 네 방향으로 각 n개 지점의 깊이 정보를 이용하므로 얼굴 영역을 검출하는 전처리 단계가 필요하다. 본 논문에서 얼굴 검출을 위해 사용한 것은 공개된 학습 모델인 SSD ResNet-10을 이용하였다.

그림 5는 본 논문에서 제안하는 n-DLiveFT을 위해 구성한 환경이다. 이미지와 깊이를 캡처하는 것외 얼굴 영역 검출과 n-DLiveFT은 nVidia AGX Xavier에서 실행되었다. 인텔 RealSense는 캡처한 이미지를 얼굴 검출 모듈(Face detector)로 전달한다. 이 모듈은 이미지에서 얼굴을 검출하여 얼굴의 영역의 사각형 좌표를 결정하여 n-DLiveFT 모듈에게 전달한다. n-DLiveFT 모듈은 인텔 RealSense로부터 전달받은 640x480 해상도의 깊이 정보 중 앞 단계에서 전달한 얼굴 영역의 좌표에 해당하는 깊이 정보만을 이용하여 캡처 대상이 실제 얼굴인지 즉, 생체 여부를 결정한다. 이 모듈의 결과와 얼굴 검출 모듈의 결과인 이미지는 안면 인식 등 다음 단계의 응용에서 사용된다.

4.2 실험 및 결과 분석

대상의 생체 여부 결정을 위해 본 논문에서 제안한 깊이 정보의 분포를 이용하는 방법 n-DLiveFT이 유효함을 보이기 위해 실제 얼굴, 종이에 출력된 이미지 및 스마트 장치 화면에 표현된 이미지를 대상으로 실험을 하였다.

표 1은 얼굴이 인쇄된 종이를 각각의 방법으로 변형을 주어 앞서 기술한 네 방향으로 측정된 깊이의 표준 편차를 나타낸 것이다. 인쇄된 종이를 바르게 하여 측정한 깊이(정면으로 표기)는 아주 작은 표준 편차를 갖는다. 위쪽 당기기와 아래쪽 당기기는 종이의 위쪽과 아래쪽을 카메라 쪽으로 당겨 깊이를 검출한 것이다. 이 두 경우 수평 방향의 깊이가 다른 방향이 깊이보다 표준 편차가 적음을 나타내고 있다. 왼쪽 당기기와 오른쪽 당기기는 종이의 왼쪽과 오른쪽을 카메라 쪽으로 당겨 깊이를 검출한 것으로 수직 방향의 깊이가 다른 방향이 깊이보다 표준 편차가 적음을 나타내고 있다. 세로 말기와 가로 말기는 각각 수직 방향과 수평 방향으로 구부려 깊이 차이를 둔 것이다. 이 두 경우 각각은 수직, 수평 방향의 깊이가 다른 방향의 깊이보다 표준 편차가 적다.

표 2는 얼굴 이미지를 표시하고 있는 스마트 기기 화면을 대상으로 측정한 깊이 정보의 표준 편차를 나타낸 것이다. 캡처 기기와 바르게 정렬하여 측정한 것으로 모든 방향의 깊이는 아주 작은 표준 편차를 갖는다.

표 3은 실제 얼굴을 대상으로 깊이를 검출했을 때의 결과를 나타낸 것으로 표 1과 표 2에 나타낸 표준 편차보다 모든 방향에서 상대적으로 큰 표준 편차를 갖는다. 마스크를 착용한 상태로 이 방법을 적용한 표 3의 경우 2와 경우 3도 표준 편차가 크다는 것을 알 수 있다. 경우 1과 경우 2는 경우 3보다 큰 표준 편차를 갖는데 이것은 경우 1과 경우 2의 사각 영역 중 일부 가장자리 부근에서 뒤쪽 벽까지 거리를 측정하는 경우가 있지만, 경우 3은 머리카락으로 가려져 있기 때문이다.

본 논문에서 제안하는 n-DLiveFT은 네 방향의 깊이 정보 표준 편차와 임계값 th를 이용하여 생체 여부를 판단한다. 표 4는 임계값 th를 20으로 설정하여 각각의 경우 표준 편차가 임계값보다 큰 경우의 수를 나타낸 것이며, 7-DLiveFT은 이를 기반으로 가장 아래 행에 표시한 경우만 실제 얼굴이라고 판단하여 생체 여부 검사에 정(Positive)으로 결정하고, 나머지의 경우는 모두 부(Negative)로 결정한다.

본 논문에서 실시한 실험 결과는 안면 인식 등을 위해 캡처한 대상이 실제 얼굴인가를 판단하는 생체 여부 검사에 깊이 정보의 분포를 이용하는 것이 타당함을 보였다. 본 논문에서는 n-DLiveFT은 응용에 따라 깊이 정보를 검출하는 지점의 수 n, 깊이 정보를 검출하는 그룹의 수(m, 7-DLiveFT에서는 네 개의 방향 즉, 네 그룹을 사용), 임계값 th, 생체 여부 결정에 사용할 p의 값을 파라미터로 사용할 수 있다. 본 논문에서 제안한 n-DLiveFT은 안면 검출의 다음 단계로 사용될 수 있으며, 안면 검출 결과와 생체 여부 결정 결과를 이용하는 다양한 응용에서 사용될 수 있다.

Ⅴ. 결론 및 향후 과제

생체인증 시스템 중 얼굴을 이용한 시스템은 비접촉식 인증 시스템으로 출입 관리 등에 많이 이용되고 있다. 기존의 시스템은 카메라로 캡처한 안면 이미지를 이용하여 식별 또는 검증하므로 얼굴을 출력한 종이 또는 얼굴 이미지를 표시한 스마트 기기 화면을 이용해도 정상적으로 안면을 검출하고 인식하는 문제가 있다.

본 논문에서는 얼굴을 구성하고 있는 요소들로 구성되는 굴곡에 의해 생성되는 깊이의 차이를 이용하여 캡처 대상이 실제 얼굴인지를 결정하는 생체 여부 검사 방법을 제안하였다. 본 논문에서 제안한 n-DLiveFT은 검출된 안면에서 네 방향(또는 그룹)으로 n개 지점의 깊이를 검출하고, 설정된 임계값보다 큰 표준 편차를 갖는 방향의 수를 이용하여 생체 여부를 결정하였다. 깊이 정보의 분포를 이용한 생체 여부 검사 방법이 타당함을 보이기 위해 각 방향 7개 지점을 사용하는 7-DLiveFT을 구현하고, 얼굴이 출력된 종이, 얼굴이 표시된 스마트 기기 화면, 실제 얼굴, 마스크를 착용한 얼굴을 대상을 실험을 수행하였다. 실험 결과는 대상의 생체 여부를 검사할 때 본 논문에서 제안한 것과 같이 깊이 정보를 이용하는 것이 타당함을 보였다.

향후 과제로는 n개 저점에서 측정된 깊이 정보 중 안면 영역의 가장자리 부근에서 측정된 깊이의 드롭 아웃을 결정하는 것이다. 즉, 깊이가 다른 깊이에 비해 비정상적으로 변화가 있으면 이 깊이 정보를 제거하여 표준 편차의 왜곡을 감소시킬 수 있다. 본 논문의 실험에서 사용한 임계값은 애드호크(Ad-hoc)으로 결정하였으나 향후 이 값을 결정하는 방법을 도출해야 한다. 또, 본 논문에서 제안한 방법은 얼굴 형상을 한 3D 마스크를 착용하면 생-얼굴로 판단하는 문제가 있는데 이는 32x32 해상도의 열화상 센서를 이용하면 해결될 수 있을 것으로 예상되며, 향후 깊이 카메라와 열화상 센서를 연동하여 생-얼굴 검사 방법을 도출할 예정이다.

Acknowledgments

충북바이오헬스산업혁신센터지원 한국교통대학교 정밀의료사업단의 2020년 프로젝트랩 지원을 받았음.

References

- S. H. Lee, S. R. Cho, S. H. L Kim, and S. H. Jin, "Trends of Spoofing Detection in the field of Face Recognition", Weekly ICT Trends, Ministry of Science and ICT, No. 1870, pp. 17-26, Oct. 2018.

-

D. H. Kim, S. W. Choi, and S. Y. Kwak, "Deep Learning Based Fake Face Detection", Journal of KIISR, Vol. 23, No. 5, pp. 9-17, Oct. 2018.

[https://doi.org/10.9723/jksiis.2018.23.5.009]

- T. Karras, T. Aila, A. Laine, and J. Lehtinen, "Progressive Growing Of Gans For Improved Quality, Stability, And Variations", Final ICLR 2018 version, http://arxiv.org/abs/1710.10196, .

- I. J. Goodfellow, J. Pouget-Adadie, M. Mirza, B. Xu, D. Warde-Farley, S. Ozair, A.c. Courville, and Y. Bengio, "Generative Adversarial Nets", In Proc. of NIPS, pp. 2672-2680, 2014.

- A. Greenberg, "Hackers say they’ve broken face id a week after iphone X release", CIRED, No. 2017.

- J. S. Yu, "It is possible to Unlock Galaxy S8 using Face Photo : Issues in Youtube", IT Chosun, Mar. 2017.

-

S. A. Schuckers, "Spoofing and Anti-Spoofing Measures", Information Security Technical Report, Vol. 7, No. 4, pp. 56-62, Dec. 2002.

[https://doi.org/10.1016/S1363-4127(02)00407-7]

-

I. J. Jun, K. Y. Chung, and Y. H. Lee, "Gabor Wavelet Analysis for Face Recognition in Medical Asset Protection", Journal of The Korea Contents Association, Vol. 11, No. 11, pp. 10-18, Nov. 2011.

[https://doi.org/10.5392/JKCA.2011.11.11.010]

- M. S. Choi, J. H. Lee, T. M. Roh, and J. C. Sim, "Vehicle Detection Scheme Based on a Boosting Classifier with Histogram of Oriented Gradient(HOG) Features and Image Segmentations", Journal of Korean Institute of Information Scienists and Engineers, Vol. 16, No. 10, pp. 955-961, Oct. 2010.

-

K. Kollreider, H. Fronthaler, and J. Bigun, "Non-intrusive Liveness Detection by Face Images", Image and Vision Computing, Vol. 27, No. 3, pp. 233-244, Feb. 2009.

[https://doi.org/10.1016/j.imavis.2007.05.004]

-

C. C. Low, L. Y. Ong, and V. C. Koo, "Experimental Study on Multiple Face Dectection with Depth and Skin Color", 2019 IEEE 9th Symposium on Computer Applications & Industrial Electronics (ISCAIE), pp. 114-119, Apr. 2019.

[https://doi.org/10.1109/ISCAIE.2019.8743890]

-

K. Suzuki, H. Wu, T. Wada, and Q. Chen, "Accelerating Face Detection by Using Depth Information", PSIVT 2009: Advances in Image and Video Technology, pp. 657-667, Jan. 2009.

[https://doi.org/10.1007/978-3-540-92957-4_57]

-

Y. Atoum, Y. Liu, A. Jourabloo, and X. Liu, "Face Anti-Spoofing Using Patch and Depth-Based CNNs", 2017 IEEE International Joint Conference on Biometrics (IJCB), Denver, CO, USA, pp. 319-328, Oct. 2017.

[https://doi.org/10.1109/BTAS.2017.8272713]

1998년 2월 : 경북대학교 컴퓨터공학과(공학박사)

1998년 4월 ~ 현재 : 한국교통대학교 컴퓨터공학과 교수

관심분야 : 고성능시스템구조, 기계학습, 임베디드 시스템