하이브리드 영상 인식 기반의 터널 돌발 상황 감지 기술

초록

본 논문은 실시간 돌발 상황 정보 인식이 어려운 터널 내에서 CCTV를 통해 실시간으로 돌발 상황을 인식할 수 있는 시스템을 개발하였다. 돌발 상황은 차량의 역주행 및 정지, 사람의 보행, 화재 및 낙하물의 총 5가지 상황으로 정의하였다. 돌발 상황을 효율적으로 인식하기 위해 화재와 낙하물은 배경제거 알고리즘을 활용하고, 차량 및 사람은 YOLOv3를 기반으로 한 Deep-sort 알고리즘을 활용하는 하이브리드 방식의 영상인식 기술을 사용하였다. 각 돌발 상황에 대한 총 175번의 상황을 부여하여 실험을 진행하였고, 이 중 160번의 돌발 상황을 인식하여 91%의 정확도를 보였다.

Abstract

This paper proposes a system that can recognize unexpected situations in real time through CCTV in a tunnel where real time emergency information is difficult to recognize. Unexpected situations were defined as a total of five situations, including car reverse driving and stopping, human walking, fire and falling objects. To efficiently recognize unexpected situations, fire and falling objects use a background removal algorithm and car and people recognize objects use a hybrid image recognition technology that uses a deep-sort algorithm based on YOLOv3. The experiment was conducted by giving a total of 175 situations to each emergency, and 160 of them were recognized, showing an accuracy of 91%.

Keywords:

unexpected situations detecting in tunnel, deep-learning, deep-sort, background removalⅠ. 서 론

차량의 증가에 따른 무인시스템이 증가하면서 도로위에 설치된 카메라에서 획득한 영상으로 실시간 교통정보를 산출하며 실시간 교통 상태를 자동으로 감지하는 지능형 교통 시스템(ITS)에 대한 연구가 진행되고 있다. 특히 터널 내부에서 돌발 상황을 예측하기가 어렵고 터널 내부에서 발생한 돌발 상황을 외부로 전달하는 것은 2차 사고를 방지하기 위해 중요한 일이다. 터널 내부에서의 돌발 상황은 여러 가지가 존재하고, 이 중 차량의 역주행, 차량이 정지해 있는 상황, 사람이 보행을 하는 상황, 화재, 낙하물이 떨어져 있는 상황 등을 돌발 상황으로 정의하였다[1][2].

터널 내에서 발생하는 돌발 상황은 터널 내에 설치된 CCTV를 통해 인식할 수 있다. CCTV를 통해 얻은 영상은 감지기 장비로 보내지고 감지기는 영상인식 알고리즘을 통해 차량의 역주행 및 정지 상태, 사람의 보행, 화재 및 낙하물을 감지한다. 이를 위한 영상인식 알고리즘으로는 딥러닝 알고리즘 및 배경제거 알고리즘을 동시에 활용하는 하이브리드영상 인식 알고리즘을 사용한다. 딥러닝 알고리즘은 객체 인식의 정확도가 높지만 객체 인식 속도가 느리다는 단점과 목표 객체를 인식하기 위한 학습 데이터가 많이 필요하다는 단점이 있다. 배경제거 알고리즘은 객체 인식의 정확도는 딥러닝 알고리즘에 비해 낮지만 전경에 나타나는 객체를 빠르게 찾을 수 있고 데이터가 적게 필요하다는 장점이 있다.

본 논문에서는 사람 및 차량은 딥러닝 알고리즘을 통해, 화재 및 낙하물은 배경제거 알고리즘을 통해 인식한다. 사람 및 차량은 데이터가 풍부하고, 특징이 명확하기 때문에 적은 파라미터를 보유하는 가벼운 딥러닝 모델로도 빠른 시간 내에 정확한 객체 인식이 가능하다. 화재 및 낙하물의 경우에는 각 클래스마다 특징들이 다르게 나타나며 종류가 많기 때문에 높은 파라미터의 딥러닝 모델을 요하며 이는 객체 인식 속도가 증가하는 원인이 된다. 실시간 객체 인식이 필요한 본 연구에서는 화재 및 낙하물을 배경제거 알고리즘을 기반으로 한 영상처리 알고리즘을 통해 인식하여 객체 인식 속도를 줄이는 방법을 제안한다.

Ⅱ. 관련 연구

2.1 배경제거 알고리즘

동영상에서 지속적으로 움직이는 객체를 검출하는 방법론을 객체 추적이라고 한다. 객체 추적 방법에는 다양한 방법론이 제안되고 있으며, 그 중 하나인 배경제거 알고리즘이 높은 성능을 보여주고 있다. 객체 추적을 위해 객체가 무엇인지, 어디에 존재하는지를 명확히 파악해야 한다. 또한 실시간 영상에서 움직이는 객체 및 갑작스러운 조명변화를 고려하여 깨끗한 배경영상을 생성해야 하는데, 이에 대한 방법으로 모수적(Parametric) 방법과 비모수적 방법이 있다.

모수적 배경영상 생성방법으로 대표적인 모델은 GMM(Gaussian Mixture Model)이다. GMM은 픽셀단위로 확률 분포를 모델링 하는 방법으로 실시간으로 각 화소의 평균과 분산을 업데이트하여 배경, 객체, 그림자로 구분하는 것을 의미한다. 비모수적 방법은 각 화소에서 그레이 레벨의 히스토그램을 생성하여 빈도수가 가장 큰 그레이 레벨이 해당 화소에서의 배경이라고 간주하는 방법으로 각 프레임에서 가장 많은 픽셀의 값을 갖는 영역들을 배경이라고 간주하는 방법이다.

모수적 방법의 경우 각 화소별로 해당 모델을 업데이트하기 때문에 연산량이 많아 배경영상 생성 속도가 느리지만 메모리를 적게 사용한다는 장점이 있고, 비모수적 방법의 경우 메모리 사용량이 많지만 연산의 양이 적어 배경영상 생성 속도가 빠른 장점이 있다. Xiaofei는 비모수적 방법에서 배경영상 생성 시에 필요한 메모리 공간을 줄이기 위해 0~255인 히스토그램을 N개로 분할하여 저장하는 방법을 사용하기도 하였으며, 본 연구에서도 Xiaofei의 방법을 사용하였다[3]-[5].

2.2 객체 인식 딥러닝 알고리즘

객체 인식 딥러닝 알고리즘은 객체 후보 영역을 검출하고 해당 영역에서 객체 유무 및 객체의 종류를 분류하는 방식이다. 객체 인식 딥러닝 알고리즘은 크게 1차 객체 인식 알고리즘과 2차 객체 인식 알고리즘으로 나눌 수 있다. 1차 객체 인식 알고리즘으로는 YOLO, SSD 등이 있으며, 정확도는 낮지만, 빠른 객체 인식 속도를 통해 실시간 객체 인식이 가능하다. 2차 객체 인식 알고리즘으로는 Faster-RCNN, SppNet 등이 있으며, 객체 인식 속도는 느리지만 정확한 객체 정보를 얻을 수 있다는 장점이 있다[6]-[8].

2.3 칼만 필터

칼만 필터는 최소자승법을 사용하여 실시간으로 잡음 운동방정식을 가진 시간에 따른 방향을 추적하는 재귀 계산법으로 시스템이 시간에 따른 변화를 적절하게 예측할 수 있도록 잡음으로부터 신호를 찾아내기 위해 사용된다. 칼만 필터는 이전 프레임에서 추정한 값을 토대로 현재 프레임 내에서 객체가 존재하는 영역을 추정하여, 객체 추적이 가능하도록 하는 알고리즘이다. 각 추정 계산은 예측과 보정 두 단계로 나눠진다. 예측은 이전 시간에 추정된 상태에서 사용자 입력을 추가하였을 때 예상되는 상태를 계산하는 단계이며, 보정은 앞서 계산된 예측 상태와 실제로 측정된 상태를 토대로 정확한 상태를 계산하는 단계로, 식 (1)은 예측 단계, 식 (2)는 보정 단계의 식을 보여준다.

| (1) |

| (2) |

는 객체가 존재한다고 추정된 상태를 나타낸다. y, F는 각각 측정 변수 및 상태이행변수를 나타내고, H, B, u는 측정 행렬, 제어 행렬, 제어 변수를 의미한다. R은 측정분산행렬로 측정에 의한 오류를 나타낸 행렬이며, P는 상태분산행렬로 추정 오류를 나타내고 K는 칼만 이득, Q는 프로세스 분산행렬을 의미한다. 칼만 필터는 객체 추적을 위한 알고리즘으로 딥러닝 객체 검출을 동시에 활용하는 객체 추적 알고리즘에 관한 연구들이 진행되고 있다[9].

Ⅲ. 터널 내에서의 돌발 상황 인식 시스템

3.1 배경제거 알고리즘을 통한 객체 감지

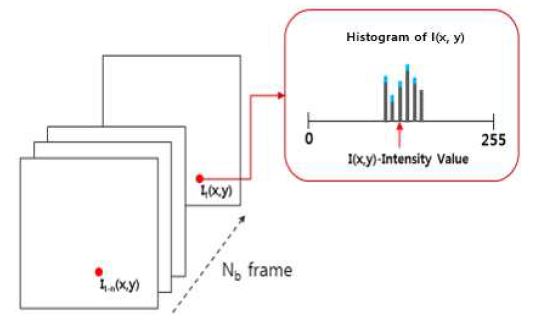

배경제거 알고리즘으로는 비모수적 배경영상 알고리즘을 사용한다. 비모수적 방법은 그림 1과 같이 각 화소에서 그레이 레벨의 히스토그램을 생성하여 빈도수가 가장 큰 그레이 레벨이 해당 화소에서의 배경이라고 간주하는 방법이다.

식 (3)의 Hi(x, y, m)는 화소 (x, y)에서 그레이 레벨 m의 히스토그램 값을 나타내며, i는 프레임, N은 히스토그램 생성에 사용되는 영상의 수, Bi(x, y)는 배경을 나타낸다. 가장 빈도수가 많은 픽셀 값으로 해당하는 빈도수 값에 1을 더해주고 이를 Intensity 히스토그램이라 하며, 이를 통해 배경 영역에 가중치를 부여할 수 있게 된다. 각 프레임에서 배경으로 나오는 영역의 픽셀 값에 1의 가중치가 더해지면 배경과 전경 영역을 더 잘 나눌 수 있게 된다. 그림 1에서 Nb는 배경영상 생성에 사용되는 버퍼의 크기이며 버퍼의 크기에 따라 현재 영상이 배경영상에 반영되는 정도를 조절할 수 있다.

| (3) |

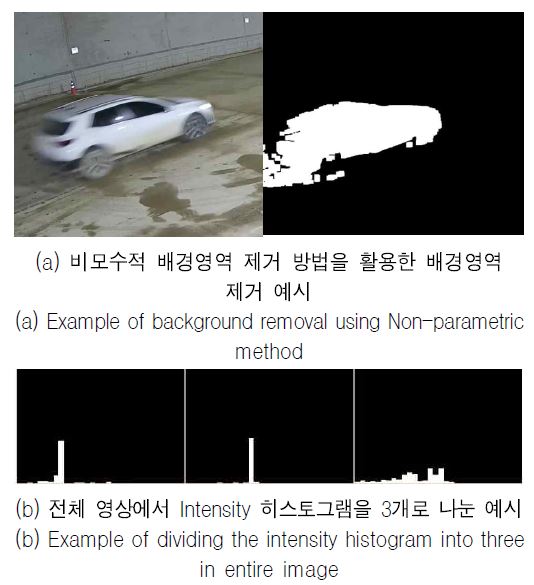

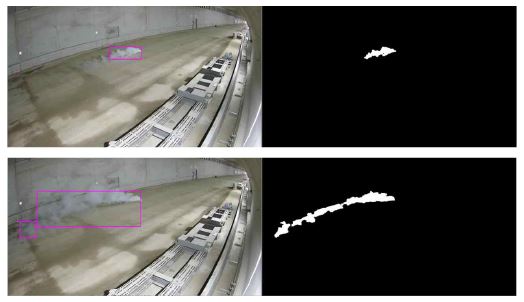

비모수적 방법은 영상 내의 모든 픽셀에서의 히스토그램을 N 프레임동안 생성해야 하고, 배경영상 생성에 필요한 N 프레임의 수와 모든 화소에 대해 0~255의 Intensity 히스토그램을 저장해야 하므로 많은 양의 메모리 공간을 차지하게 된다. 이런 메모리 공간을 줄이는 방법으로 0~255인 히스토그램을 k개 씩 분할하는 방법을 사용하였다. k개씩 분할된 히스토그램에서 가장 많은 빈도를 나타내는 구간의 평균값은 해당 화소에서의 배경영상으로 간주된다. 본 논문에서는 정지한 객체가 배경영상에 등록되는 시간을 모수적 방법과 비슷하게 하기 위한 N 프레임의 수를 150, k 히스토그램 분할 수를 64로 설정하였다. 그림 2의 좌측 그림은 원본 영상, 우측 그림은 배경이 제거된 전경의 영역을 보여준다[10].

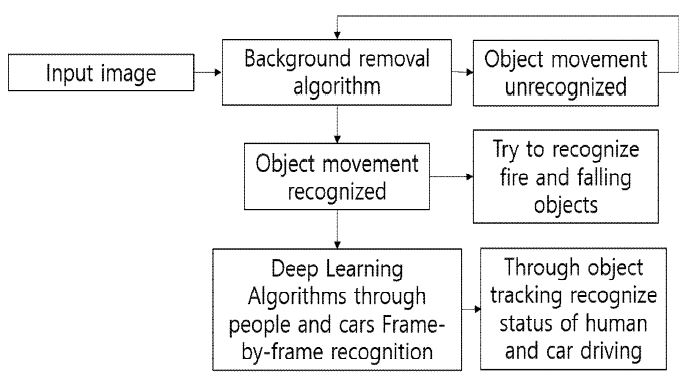

비모수적 방법을 통해 배경을 구한 뒤 영상에서 배경을 제거하면 움직이는 객체의 영역 정보를 알 수 있게 된다. 객체로 예측할 수 있는 영역이 인식되면 딥러닝 알고리즘을 활용하여 객체를 인식하고 해당 영역이 차량, 사람 또는 기타 객체로 인식에 실패하면, 해당 영역을 분리하여 RGB 색상 모델에서 HSI(Hue-Saturation-Intensity) 색상 모델로 변환한다.

HSI 색상 모델은 RGB 색상 모델에 비해 명도에 덜 민감하기 때문에 조명의 변화나 장면의 변환에도 강인함을 갖는다. HSI 색상 모델 내에서 연기의 색상에 해당하는 명도와 채도 값의 영역을 지정해주고 이를 통해 객체의 후보 영역의 색이 연기에 가까운 색인지 아닌지를 판단한다. HSV 값을 0~1 사이의 값으로 나타낼 때, 연기에 해당하는 색상과 채도 값은 0에서 0.2 사이와 0.5에서 0.7 사이의 범위에 밀집되어 분포된다. 해당 영역이 제시한 연기의 색상과 채도 범위 안에 들어온다고 판단되면 해당 영역의 변화를 감지하고 계속해서 영역이 커질 경우 연기로 판단한다. 만약 차량, 사람, 기타 학습이 된 객체로 판단되지 않고, 해당 영역이 변화하지 않고 계속 유지가 될 경우 이를 낙하물로 인식한다. 그림 3은 제안한 시스템의 전체적인 구조를 나타낸다[11][12].

3.2 YOLO 알고리즘을 통한 차량 및 사람 감지

본 논문에서는 오픈소스 기반의 YOLOv3를 사용한다. YOLOv3는 이미지 내의 바운딩 박스와 클래스 확률을 한 개의 희귀 문제로 간주하여, 이미지를 한 번 보는 것으로 객체의 종류와 위치를 추측하는 네트워크 모델이다. YOLOv3에서 백본 네트워크로 사용하는 Darknet 네트워크는 적은 파라미터를 보유하여 높은 정확도를 가지면서 동시에 매우 빠른 처리가 가능하다. 실시간으로 객체를 인식해야 하는 본 연구의 특성상 YOLOv3를 차량 및 사람 객체 인식 딥러닝 알고리즘 모델로 사용하였다.

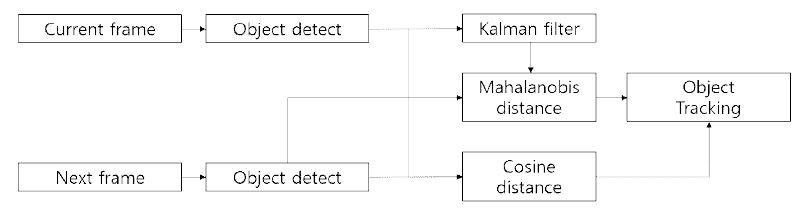

3.3 Deep-sort 알고리즘을 통한 객체 추적

YOLO를 통해 객체를 인식하는 것은 가능하지만 객체를 추적할 수는 없다. 본 연구에서는 Deep-sort 알고리즘을 사용하여 YOLO를 통해 인식된 객체를 추적하는 방법론을 제안한다. Deep-sort는 이전 프레임에서 추출한 객체 정보들을 칼만 필터를 이용하여 각 객체들의 현재 값을 추정하고, 이 정보와 현재 프레임에서 추출한 객체들의 정보를 이용하여 마할라노비스(Mahalanobis) 거리를 구한다.

동시에 이전 프레임의 객체들의 특징값과 현재 프레임의 특징 값을 이용하여 코사인(Cosine) 거리를 구한다. 이전 프레임과 현재 프레임의 마할라노비스 거리 값과 코사인 거리 값을 합쳐 객체들의 일치성을 판단할 수 있게 되며 일치성 판단 식은 식 (4)와 같다.

| (4) |

Dm: 마할라노비스 거리 Dc: 코사인거리

위 식에서 D의 값이 정해진 임계값을 넘으면 각각 다른 프레임에 존재하는 해당 두 객체는 같은 객체로 인식된다.

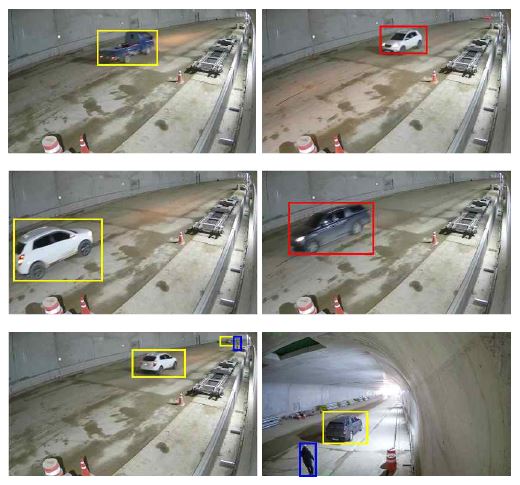

그림 4는 Deep-sort의 전체 구조를 나타내며 해당 모델을 통해 사람 및 차량 객체를 추적한다. 추적된 객체의 박스 좌표 정보를 이용하여 해당 객체 박스의 중심점을 찾아냈고, 60프레임 이상 중심점의 변화가 없다면 객체가 정지 상태라 판단하였고, 차선의 정주행 방향의 반대로 객체의 중심점의 좌표가 이동하면 이는 역주행이라고 판단하였다[13]-[15].

Ⅳ. 실험 및 결과

실시간 객체 검출을 요하는 본 연구 특성상 빠른 객체 인식이 가능한 낮은 파라미터의 모델로는 인식의 한계가 있다. 데이터 확보가 어려운 화재 및 낙하물 인식은 영상처리 기술을 사용하고, 낮은 파라미터의 모델로 정확한 인식이 가능한 사람 및 차량 인식은 딥러닝 알고리즘을 사용하는 하이브리드 영상 인식 방법을 통해 실험을 진행하였다. 딥러닝 알고리즘 학습은 공용 데이터 집합인 COCO 데이터 집합을 사용하였으며, 총 20가지의 클래스를 분류하는데 본 실험에서는 이 중 차량 및 사람 2가지 클래스만 분류 결과를 표시하도록 모델을 설계하였다[16][17].

실험을 위한 실험 데이터로는 실제 현장에 적용할 세종시 외곽도로의 터널 내에 설치된 CCTV를 통해 얻었으며 차량이 진행 중 정지하는 상황 40번, 역주행하는 상황 45번, 사람이 보행하는 상황 50번, 화재 또는 낙하물이 생기는 상황 20번 등 각각의 영상을 통해 실험을 진행하였다. 표 1은 각 상황에 따른 인식 정확도를 나타낸다. 정확도는 각 상황의 샘플 수에서 인식에 성공한 수를 통해 산출한다.

정지된 차량을 인식한 경우에는 노란색 박스를, 역주행하는 차량을 인식한 경우에는 빨간색 박스를, 보행자를 인식한 경우에는 파란색 박스를, 화재를 인식한 경우에는 보라색, 낙하물을 인식한 경우에는 초록색 박스를 통해 각 상황에 따른 인식 결과를 표시하도록 설계를 진행하였다.

그림 5는 상황별 차량의 상태 및 보행자를 인식한 결과를 보여주고 있으며, 그림 6은 연기를 인식하는 결과를 보여주고 있다. 그림 7은 낙하물을 인식하는 결과로 영상대비 적은 영역을 차지하는 낙하물도 잘 인식하는 결과를 보여주고 있다.

Examples of car stopping status(yellow box), Reverse driving(red box), human walking(blue box) recognition

Ⅴ. 결론 및 향후 과제

본 연구에서는 효율적인 방법으로 터널 내에서의 위험 상황을 인식하는 돌발 상황 인식 시스템을 제안하였다. 적은 파라미터를 갖는 실시간 객체 인식딥러닝 모델로 예측이 가능한 차량 및 사람은 YOLOv3로 객체 인식 및 Deep-sort 알고리즘을 통한 객체 추적을 진행하여 객체의 상황을 판단하고, 학습 데이터 확보가 힘들고 높은 파라미터를 갖는 고성능 객체 인식 알고리즘을 요구하는 화재 및 낙하물 감지는 실시간 객체 인식이 가능한 영상처리 기법을 활용하는 방법론을 제안하였다. 이를 통해 차량의 정지 및 역주행 상태, 사람의 보행, 화재 및 낙하물 감지를 실시간으로 예측하는 시스템을 제안하였고, 총 175가지 상황에 대해 160가지 상황을 인식하고 인식 정확도 91%의 성능을 보여주었다.

상용화되는 딥러닝 시스템의 경우 기본적으로 시스템 고성능 스펙을 요구하고 있고 다양한 학습용 데이터가 필요한 실정이나, 제안한 하이브리드 영상 인식 기술의 경우 딥러닝과 고전 방법인 영상 처리 기술의 융합을 통해 시스템 단가를 낮추며 효율적인 객체 인식이 가능할 것으로 기대된다.

References

-

S. H. Jeong and J. H. Lee, "Detection algorithm of crossroad traffic accident using the sequence of traffic lights", Journal of KIPS, Vol. 16-B, No. 1, pp. 17-24, Feb. 2009.

[https://doi.org/10.3745/KIPSTB.2009.16-B.1.17]

-

H. S. Lee, S. H. Jeong, and J. H. Lee, "Real-time lane violation detection system using feature tracking", Journal of KIPS, Vol. 18-B, No. 4, pp. 201-212, Aug. 2011.

[https://doi.org/10.3745/KIPSTB.2011.18B.4.201]

-

Julien Pilet, Christoph Strecha, and Pascal Fua, "Making Background Subtraction Robust to Sudden Illumination Changes", European Conference on Computer Vision, Marseille, France, Vol. 5305, No. 3, pp. 567-580, Oct. 2008.

[https://doi.org/10.1007/978-3-540-88693-8_42]

-

Tatsuya Tanaka, Atsudhi Shimada, Rin-ichiro Taniguchi, Takayoshi Yamashita, and Dasaku Arita, "Towards robust object detection: integrated background modeling based on spatio-temporal features", Proceedings of the 9th Asian Conference on Computer Vision, Xi’ an, China, Vol. Part-I, pp. 201-212, Sep. 2009.

[https://doi.org/10.1007/978-3-642-12307-8_19]

-

Suchendra M. Bhandarkar, and Xingzhi Luo, "Fast and Robust Background Updating for Real-time Traffic Surveillance and Monitoring", Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, San Diego, CA, USA, Vol. 3, pp. 55-60, Sep. 2005.

[https://doi.org/10.1109/CVPR.2005.458]

-

Joseph Redmon and Ali Farhadi, "YOLO9000: better, faster, stronger", In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Honolulu, HI, USA, pp. 7263-7271, Jul. 2017.

[https://doi.org/10.1109/CVPR.2017.690]

-

Wei Liu, Dragomir Anguelov, Dumitru Erhan, ChristianSzegedy, Scott Reed, Cheng-Yang Fu, and Alexander C. Berg, "SSD: Single shot multibox detector", In Proceedings of the European Conference on Computer Vision (ECCV), Amsterdam, The Netherlands, pp. 21-37, Oct. 2016.

[https://doi.org/10.1007/978-3-319-46448-0_2]

-

Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun, "Faster R-CNN: Towards real-time object detection with region proposal networks", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 39, No. 6, pp. 1137-1149, Jun. 2017.

[https://doi.org/10.1109/TPAMI.2016.2577031]

-

A. Andriyenko, K. Schindler, and S. Roth, "Discretecontinuous optimization for multi-target tracking", in CVPR, Providence, RI, USA, pp. 1926-1933, Jun. 2012.

[https://doi.org/10.1109/CVPR.2012.6247893]

-

Li Xiaofei, "A New Fast Hybrid Algorithm of Background Extraction Suitable for the DSP Platform", 2009 World Congress on Computer Science and Information Engineering, Vol. 7, pp. 1-4, 2009.

[https://doi.org/10.1109/CSIE.2009.406]

-

J. H. Ku, "A study on characteristics analysis for detection performance of a video-based automated fire detection system", Journal of KOSHAM, Vol. 13, No. 5, pp. 239-245, Oct. 2013.

[https://doi.org/10.9798/KOSHAM.2013.13.5.239]

-

H. S. Jeon, D. H. Yeom, and Y. H. Joo, "Video-based intelligent unmanned fire surveillance system", Journal of KIIS, Vol. 20, No. 4, pp. 516-521, Aug. 2010.

[https://doi.org/10.5391/JKIIS.2010.20.4.516]

-

S. J. Yang, I. H. Jeong, D. H. Kang, and H. B. Baek, "Real-time multi-object tracking using mixture of SORT and DeepSORT", Journal of KIIT, Vol. 19, No. 10, pp. 1-9, Oct. 2021.

[https://doi.org/10.14801/jkiit.2021.19.10.1]

-

Z. Zeng, Q. Gong, and J. Zhang, "CNN Model Design of Gesture Recognition Based on Tensorflow Framework", Proc. 2019 IEEE 3rd Information Technology. Networking, Electronic and Automation Control Conference. ITNEC 2019, ITNEC, Chengdu, China, pp. 1062-1067, Mar. 2019.

[https://doi.org/10.1109/ITNEC.2019.8729185]

-

M. I. H. Azhar, F. H. K. Zaman, N. M. Tahir and H. Hashim, "People Tracking System Using DeepSORT", Proc. - 10th IEEE Int. Conf. Control Syst. Comput. Eng. ICCSCE 2020, Penang, Malaysia, pp. 137-141, Aug. 2020.

[https://doi.org/10.1109/ICCSCE50387.2020.9204956]

-

T. M. Choi, C. H. Son, and D. H. Lee, "Attention-Enhanced YOLO model via region of interest feature extraction for leaf diseases detection", Journal of KIIT, Vol. 19, No. 4, pp. 83-93, Apr. 2021.

[https://doi.org/10.14801/jkiit.2021.19.4.83]

-

M. F. Haque, H. Y. Lim, and D. S. Kang, "Real time object detection based on YOLO with feature filter bank", Journal of KIIT, Vol. 17, No. 5, pp. 91-97, May 2019.

[https://doi.org/10.14801/jkiit.2019.17.5.91]

2020년 8월:전북대학교 전자정보공학부(공학석사)

2020년 8월 ~ 현재: 한국전자기술연구원 연구원

2021년 9월 ~ 현재:전북대학교 융합기술공학부 박사과정

관심분야 : 스마트팜, 인공지능, 영상처리

2006년 2월:전북대학교 의용생체공학과(공학석사)

2012년 8월:전북대학교 컴퓨터공학과(공학박사)

2012년 5월 ~ 현재: 한국전자기술연구원 선임연구원

관심분야 : 스마트팜, 자율주행, 교통정보수집 및 예측, 로봇응용기술, 영상처리, 인공지능

2015년 2월:전북대학교 전자정보공학부(공학석사)

2019년 8월:전북대학교 전자정보공학부(공학박사)

2019년 12월 ~ 2020년 12월 : 한국전자기술연구원 박사후과정

2021년 1월 ~ 현재: 한국전자기술연구원 선임연구원

관심분야 : 머신비전, 인공지능, 딥러닝

2017년 2월 : 전북대학교 전자정보공학과(공학석사)

2018년 2월 ~ 현재 : 전북대학교 전자정보공학과(박사과정)

2021년 1월 ~ 현재: 한국전자기술연구원 연구원

관심분야 : 영상.음성분석, 감성 인식, 인공지능

1986년 2월 : 전남대학교 전산통계학과(이학석사)

1994년 2월 : 전북대학교 전산통계학과(이학박사)

1997년 3월 ~ 현재: 전북대학교 소프트웨어공학과 교수

관심분야 : 소프트웨어 개발 프로세스, 소프트웨어 품질, 소프트웨어 테스팅, 컴포넌트 기반 소프트웨어, 지능형로봇 소프트웨어, 멀티미디어 소프트웨어 등

1991년 2월: 충북대학교 전산통계학과(이학석사)

1999년 2월 : 충북대학교 전자계산학과(이학박사)

1992년 3월 ~ 현재 : 전북대학교 소프트웨어공학과 교수

관심분야 : 멀티미디어 DBMS, 임베디드 시스템, 소프트웨어공학