Residual 3D U-Net 기반 다발성 경화증 병변의 의미론적 분할

초록

임상에서 의료 영상은 병리사들이 분석하므로 인적 및 시간적 자원을 필요로 한다. 최근의 딥러닝 기술은 의료 영상 내에서 특정 질병의 위치를 예측할 수 있는 수준으로 올라왔고, 데이터 부족 문제를 해결하기 위한 정규화, 제약, 증강 방법들이 소개되었다. 본 논문에서는 Residual 3D U-Net을 기반으로 다발성 경화 병변을 분할하기 위한 알고리즘을 제안한다. 특히, 전처리 및 랜덤 패치 증강을 통하여 분할 정확도 향상을 모색하였다. 제안하는 알고리즘의 성능 검증을 위해 2008 MICCAI MS Lesion Segmentation Challenge의 MS Lesion 데이터셋을 활용하였고 3D U-Net과 비교하였다. 그 결과 70% DSC와 52% IoU를 달성하였고, 3D U-Net 대비 5.9% DSC와 6.9% IoU 정확도가 상승하였다. 정성적으로도 예측 결과 전체 MRI 영상 중 국소 부위를 제외하고 준수한 성능을 보였다.

Abstract

Medical images in clinical practice are analyzed by pathologists, requiring human and time resources. Recently, deep learning methods that can predict the location of specific diseases in medical images has been developed. Also, regularization, constraints, and augmentation are introduced to solve data scarcity problems. This paper proposes an algorithm to detect multiple sclerosis lesions using Residual 3D U-Net. In particular, detection accuracy is improved through preprocessing and random patch enhancements. To verify the performance of the proposed algorithm, MS lesion datasets from 2008 MICCAI MS lesion segmentation challenge was used and compared with 3D U-Net. As a result, 70% DSC and 52% IoU were achieved, and 5.9% DSC and 6.9% IoU accuracy were improved. Quantitatively, detection results showed satisfactory performance except for local areas within the entire MRI image.

Keywords:

multiple sclerosis lesion, deep learning, 3D U-Net, residual 3D U-Net, MRIⅠ. 서 론

다발성 경화증(MS, Multiple Sclerosis)이란 뇌, 척수, 시신경으로 구성된 중추신경계에 발생하는 만성 질환으로, 환자의 면역체계가 건강한 세포와 조직을 공격하는 자가 면역 질환이다[1]. 이와 같은 질환의 진단을 위해서 임상에서 의료 영상은 병리사들이 분석하므로 인적 및 시간적 자원을 필요로 한다.

딥러닝 기술은 영상 분류와 의미론적 분할에서 높은 성능을 보이고 있다. 최근에는 의료 영상의 분석에도 활용하면서, 특정 질환을 분류하거나, 병변(Lesion)의 위치를 찾는 등 다양한 분야로 발전하고 있다. 하지만 지도 기반의 딥러닝 기술은 모델 학습에 필요한 데이터와 그에 따른 레이블이 필요하다. 레이블은 전문 병리사들이 판단하여 직접 작업을 하므로 데이터양이 부족하다[2]. 또한 개인 정보 문제로 다량의 데이터를 수집하기 어렵고, 질환 등의 불균형 문제가 있다. 이와 같은 데이터 부족은 학습 과정에서 모델의 과적합을 일으킨다.

따라서, 데이터 증강 기법은 데이터의 다양한 변이를 만들어 모델에 학습을 시켜서 과적합을 방지할 수 있다. 데이터 증강 기법에는 영상 처리 기반의 데이터 증강 기법이 있다. 블러링, 노이즈, 감마 변환과 같은 밝기 정보 변형과 반전, 탄성 변형과 같은 공간 정보 변형이 있다. 대부분의 영상 처리 기법들은 2D 영상에 대해 이뤄진다. 따라서, 데이터 증강 시에 2D 영상 처리 방법들이 사용되나, MRI와 같은 의료 영상은 3D로 구성되어서 3D를 고려한 데이터 증강 기법의 도입이 필요하다.

본 논문에서는 3D U-Net의 수축 경로(Contracting path)에 잔차 신경망을 추가한 Residual 3D U-Net을 이용하여 3D 뇌 MRI 영상에 대하여 다발성 경화 병변의 의미론적 분할 알고리즘을 제안한다. 제안한 알고리즘을 통하여 모델의 깊이를 유지하면서 학습을 최적화(Optimizer)하여 기존의 3D U-Net을 사용한 알고리즘보다 성능을 향상하였다. 특히, 3D 의료 영상에 적합한 탄성 변형, 어파인 등의 전처리 및 랜덤 패치 증강 기법의 적용을 통하여 분할 정확도 향상을 모색하였다.

본 논문의 구성은 다음과 같다. 2장은 관련 연구로 데이터 증강 방법과 의미론적 분할 모델을 설명한다. 3장에서는 Residual 3D U-Net 기반의 제안하는 모델과 증강 기법을 기술한다. 4장에서는 실험 결과를 제시하고, 5장에서는 결론과 본 연구의 한계점 및 향후 연구를 설명한다.

Ⅱ. 관련 연구

의료 영상 분야에서 영상에 대한 레이블링 작업은 인적 및 시간적 소모가 크고 익명화 문제 때문에 데이터의 수가 적은 문제가 있다. 이는 불충분한 학습 및 평가 데이터로 인해 딥러닝 모델의 과적합(Over-fitting) 문제를 발생시킨다. 이와 같은 문제를 해결하기 위해 딥러닝 모델에 정규화를 적용하거나 드랍아웃(Drop-out)을 적용하는 방법들이 제안되었다[3][4]. 드랍아웃은 학습 과정에서 각 계층에서 확률적으로 특정 뉴런 간의 연결을 끊는 방법이다.

그러나 이와 같은 방법들도 한계가 있어서 과적합 문제를 해결하는데 중요한 것은 많은 양의 데이터를 학습에 사용하는 것이다. 이를 위해 인위적으로 영상을 증강 방법들이 제안되었다.

2.1 TorchIO

데이터 증강은 학습 데이터의 양을 인위적으로 증가시켜 모델의 과적합을 줄이는 방법이다. 기본적인 데이터 증강 기법 중에 하나는 영상 처리를 이용한 방법이다. 기존에 2D 영상 기반의 다양한 증강 방법들이 제시되었지만, MRI와 같은 3D 의료 영상에 적용하기에는 효율적이지 않다. 따라서, 3D 기반의 신경망 훈련에 일반적인 영상 처리 파이프라인을 적용하기 어려운 점을 해결하고자, 3D 영상에 대한 파이토치 기반의 증강 및 전처리를 포함한 딥러닝 프레임워크인 TorchIO가 제안되었다[5].

2.2 의미론적 분할 모델

의료 영상 분류 이외에도 의료 영상 내 병변의 위치를 파악하는 의미론적 분할 모델에 관한 연구가 많이 이루어졌다. 객체 분할은 주어진 영상에 대해 모든 픽셀마다 클래스 분류를 하여 영역을 구분하는 것이고, 의미론적 분할은 객체 분절화를 통해 같은 클래스마다 영역이나 색으로 구분하는 것이다.

초기의 객체 검출 모델인 R-CNN(Regions with Convolutional Neural Networks)은 일정한 경계 박스 크기로 픽셀을 분류하는 비효율적인 방식이다[6]. Mask R-CNN은 Faster R-CNN[7]에 마스크 브렌치를 추가하여 픽셀 단위로 인스턴스 분할하지만 성능이 낮다[8]. 인스턴스 분할에서는 같은 클래스에 속하더라도 다른 객체로 인식한다. 그러나, 컨볼루션을 이용한 FCN(Fully Convolutional Networks)과 같은 모델이 등장하면서 분할의 성능이 크게 향상되었다[9]. 하지만 FCN은 복원하는 과정에서 영상의 구체성이 떨어지는 문제가 있었다. 이를 해결하기 위해 U-Net과 같은 얕은 층의 특징맵과 깊은 층의 특징맵을 결합한 skip architecture 개념이 제안되었다[10].

U-Net은 수축 경로와 확장 경로(Expanding path)로 구성되어있다. 수축 경로는 네트워크 계층이 깊어질수록 의미론적 정보를 잘 파악한다. 확장 경로는 업 컨볼루션된 특징맵과 수축 경로에서 테두리가 잘린 특징맵을 결합하여 분할맵으로 복원한다.

많은 연구들에서 더 깊은 신경망일수록 더 좋은 성능을 보인다고 제안했지만 기울기 소실과 같은 문제가 발생하여 학습하기가 어렵다[11][12]. 이러한 문제를 해결하기 위해 He et al.은 잔차 신경망을 제안하였다[13]. Zhang et al.은 차선 검출을 위해 잔차 신경망과 U-Net을 결합한 Deep Residual U-Net을 제안하였다[14]. 잔차 유닛을 사용한 단축 연결이 성능 저하를 줄이고 특징 전달을 촉진해 적은 매개 변수로도 신경망을 설계할 수 있었다. 결과적으로 다른 분할 모델에 비해 성능이 높을 수 있었다.

그러나 의료 영상에서는 3D 데이터가 많이 존재하며, 이와 같은 3D 특징을 활용하기 위해 U-Net의 2D 연산을 3D 연산으로 확장한 3D U-Net이 제안되었다[15]. 3D U-Net은 컨볼루션 연산 과정에서 배치 정규화를 추가함으로써 기존 2D U-Net보다 성능을 향상했다. Ballestar et al.은 V-Net[16], 3D U-Net, Residual 3D U-Net을 이용하여 뇌종양 분할을 수행하였다[17]. Residual 3D U-Net 모델에 다중 스케일 방법을 적용해 MRI 영상에서 두 개의 서로 다른 크기의 패치를 학습에 사용하였고, 사용된 네 가지의 모델을 앙상블하여 단일 모델에 비해 높은 성능을 보였다. Xiao et al.은 3D U-Net에 3D Res2Net을 결합한 3D-Res2UNet을 이용하여 폐 결절 분할을 제안하였다[18]. Res2Net을 적용함으로써 모델을 더 깊게 하면서 특징의 디테일을 잘 추출하였다. Valverde et al.은 두 단계의 3D CNN을 이용하여 뇌에서 다발성 경화 병변을 분할하였다[19]. 첫 번째는 병변의 가능성이 있는 부분을 강조하고, 두 번째는 잘못 분류된 부분의 수를 줄였다.

Ⅲ. Residual 3D U-Net 기반 MS Lesion의 의미론적 분할 알고리즘

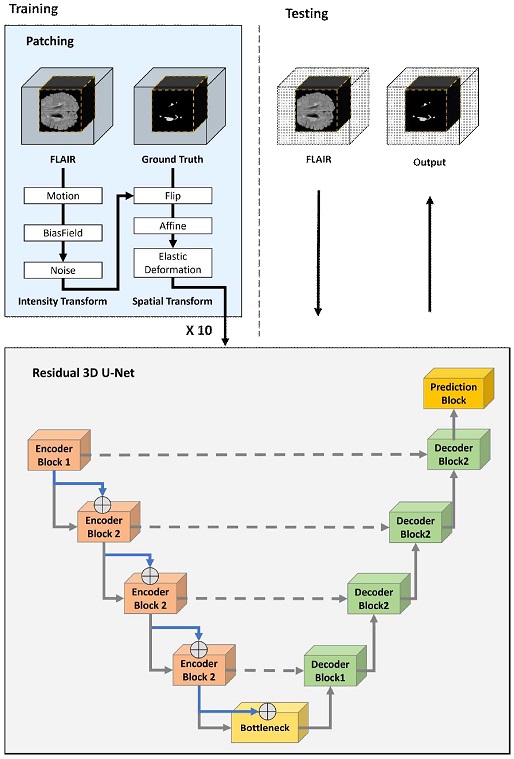

다발성 경화 병변 분할을 위하여 제안하는 모델의 학습과 평가 과정, 전처리와 증강 등 전반적인 구조도를 그림 1에 도시하였다. 딥러닝 모델은 크게 학습하는 과정과 평가하는 과정으로 구성된다. 학습 과정에서 전체 해상도의 MRI 영상 중 촬영 대상물이 포함된 영역(점선 사각형)만 사용하며, 밝기값 변형과 공간 변형의 순서로 영상 처리가 이뤄진다.

하나의 MRI 영상에 대하여 10번의 패치를 반복하여 랜덤하게 증강한 데이터를 Residual 3D U-Net 모델의 학습을 위하여 사용한다. 평가 과정은 학습 과정과 마찬가지로 촬영 대상물이 포함된 영역만을 사용하며, 전처리 없이 학습된 Residual 3D U-Net 모델의 입력으로 예측된 MS Lesion의 결과를 얻을 수 있다.

3.1 Residual 3D U-Net

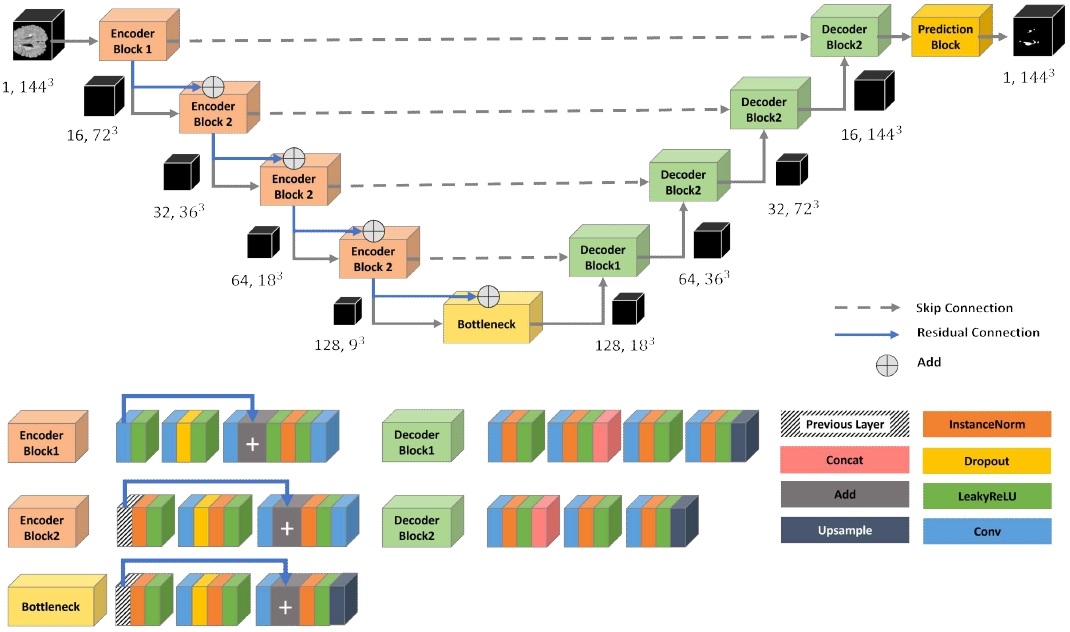

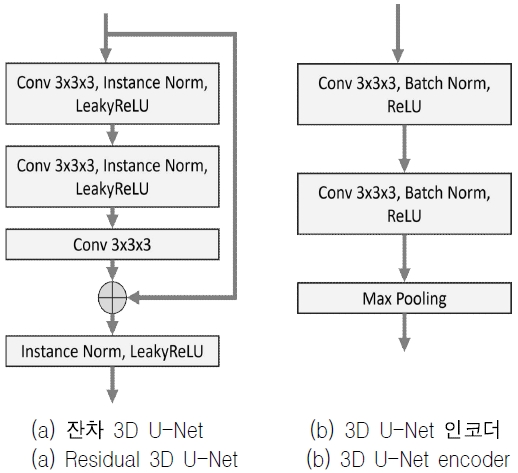

다발성 경화 병변 분할을 위한 Residual 3D U-Net의 모델 구조를 그림 2에 나타내었다. 일반적인 U-Net 구조[20]와 같이 수축과 확장 경로로 구성되며, 3D U-Net에서 제안된 3D 컨볼루션 계층[15]와 leakyReLU[20][21], 드랍아웃, 인스턴스 정규화[22]을 반복적으로 사용하는 구조로 구성된다.

인코더 블록(Encoder block)의 좌측 및 디코더 블록(Decoder block)의 우측 검은색 박스는 각 인코더와 디코더의 출력 채널과 차원을 의미한다. 그리고 수축 경로는 ResNet에서 제안된 잔차 신경망 구조를 이용함으로써, 신경망이 깊어질수록 최적화가 잘되지 않는 문제를 해결한다[13]. 그림 3은 인코더의 잔차 구조와 일반적인 3D U-Net의 블록을 비교한 그림이다.

3.2 인스턴스 정규화

3D U-Net에서 사용된 배치 정규화는 각 배치의 평균 및 표준 편차를 사용하여 특성을 스케일링한다[15]. 하지만 배치 정규화는 작은 배치 크기에서 정규화를 할 수 없는 문제가 있다. 기존의 2D 영상과 다르게 3D MRI 영상을 학습하기에는 큰 배치 크기를 사용하기 어렵기 때문에 인스턴스 정규화를 사용한다. 인스턴스 정규화는 각 특징의 평균과 표준 편차를 각 데이터의 채널마다 정규화를 하므로 배치 크기에 상관없이 정규화를 수행한다[22].

3.3 인코더 블록

수축 경로는 4개의 인코더 블록으로 구성되며, 인코더 블록 1은 4번의 컨볼루션 연산과 첫 번째 컨볼루션의 출력값이 세 번째 컨볼루션과 합쳐지는 잔차 구조를 가진다.

인코더 블록 2는 3번의 컨볼루션을 수행하며, 컨볼루션 이후 인스턴스 정규화와 leakyReLU 처리를 수행한다. 인코더 블록 1과 마찬가지로 이전 계층의 출력값이 중간에 합쳐지는 구조이다.

전환 구간(Bottleneck)의 컨볼루션 과정은 인코더 블록 2와 같으며, 마지막 계층에서 NN(Nearest Neighbor) 방법의 업샘플링을 수행한다.

3.4 디코더 블록

확장 경로는 4개의 디코더 블록으로 구성되며, 1x1x1 커널 크기의 컨볼루션, leakyReLU, 인스턴스 정규화, 그리고 NN 방법 보간의 업샘플링을 통해 분할맵으로 복원하는 과정이다.

이때 디코더 블록에 대칭되는 디코더 블록의 특징 정보를 전달해서, 복원 과정에서 손실되는 픽셀을 보강한다.

3.5 데이터 전처리 및 증강

Residual 3D U-Net 모델의 실행을 위한 하드웨어적인 한계를 극복하고, 효율적인 모델의 학습을 위해 하나의 MRI 영상에 대해 랜덤으로 144x144x144 크기의 패치로 만들었으며, 각 패치에는 다발성 경화 병변 영역이 포함되도록 하였다. 데이터가 부족한 문제로 각 MRI 영상마다 데이터 증강을 통해 10개의 패치를 생성하였다.

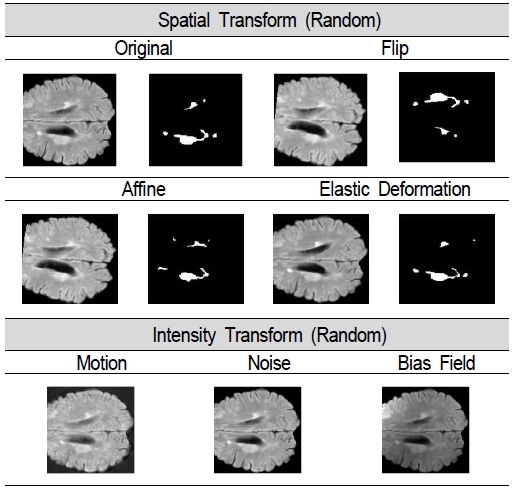

먼저 데이터셋에 대해 Z 정규화(Z-normalization)를 적용하고, 밝기 변형과 공간 변형을 통하여 증강을 수행하였다. 데이터 증강 과정에서 밝기 변형은 MRI 영상에 대해서만 수행되고, 공간 변형은 MRI 영상과 레이블 데이터에 모두 적용하였다.

데이터셋의 전처리와 증강은 TorchIO를 활용하였으며, 증강 함수로는 플립(Flip), 모션(Motion), 바이어스 필드(Bias field), 노이즈(Noise), 어파인(Affine), 탄성 변형(Elastic deformation) 처리를 순차적으로 랜덤한 확률로 실행하였다.

그림 4는 사용된 증강 함수들의 예이다. 학습 데이터셋에 대해서는 상기 기술한 함수들을 모두 적용하였으며, 평가 데이터셋은 정규화와 전처리만을 적용한다.

Ⅳ. 실험 결과 및 분석

제안하는 Residual 3D U-Net 모델의 성능 평가를 위하여 2008 MICCAI MS Lesion Segmentation Challenge의 MS Lesion MRI 데이터셋[23]를 사용하였고, 일반적인 3D U-Net 모델[15]와 성능을 비교 분석하였다.

4.1 실험 데이터셋

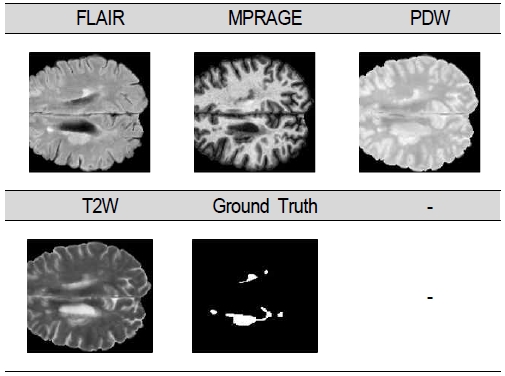

2008 MICCAI MS Lesion Segmentation Challenge의 MS Lesion MRI 데이터셋은 FLAIR, MPRAGE, PDW, T2W로 4개의 채널과 MS lesion과 background의 2개 레이블로 구성된 1개의 ground truth 채널이 포함되어 있다.

데이터셋 크기는 181x218x181로 전처리가 되어서 제공된다. 다발성 경화 병변을 가진 21명 환자의 MRI 영상과 레이블된 마스크가 있다. 그림 5는 실험에 사용한 데이터셋의 각 채널별 영상의 단면 영상 예이다.

4.2 제안하는 모델 구현 및 실험

다발성 경화 병변을 가진 21명 환자의 실험 데이터셋에 대하여 학습, 검증과 평가 과정의 데이터셋 비율은 0.8 : 0.1 : 0.1로 하였으며, 데이터 증강 함수는 학습 데이터셋에만 적용하였다.

Residual 3D U-Net 모델에 대해 배치 크기는 1로 설정하고 학습 과정에서는 단일 채널만을 사용하였다. 최적화 알고리즘은 Adam을 사용하였고, 학습률(Learning rate)은 1-4, 가중치 감쇠(Weight decay)는 1-10로 설정하였다.

다발성 경화 병변과 배경을 분할하는 것이므로 손실 함수는 일반적인 분할 모델에 사용되는 binary cross-entropy와 dice 결합한 BCE-Dice를 사용하였다. 표 1에는 학습에 사용한 파라미터를 정리하였다.

비교 분석을 위한 일반적인 3D U-Net 모델에 대해서도 유사한 파라미터 설정을 수행하였다.

분할된 결과의 정확도를 판단하기 위한 유사도 메트릭은 DSC(Dice Similarity Coefficient)와 mean IoU(Intersection over Union)를 사용하였다. 학습은 최대 100 epoch으로 진행하였으며, 조기 멈춤을 사용하여, 5번 동안 검증 데이터셋의 최소 loss에 변화가 없으면 모델 훈련을 종료하였다.

실험에 사용한 모델 및 데이터셋은 파이토치를 이용하여 구현되었고, NVIDIA TITAN Xp 환경에서 실험하였다.

4.3 실험 결과

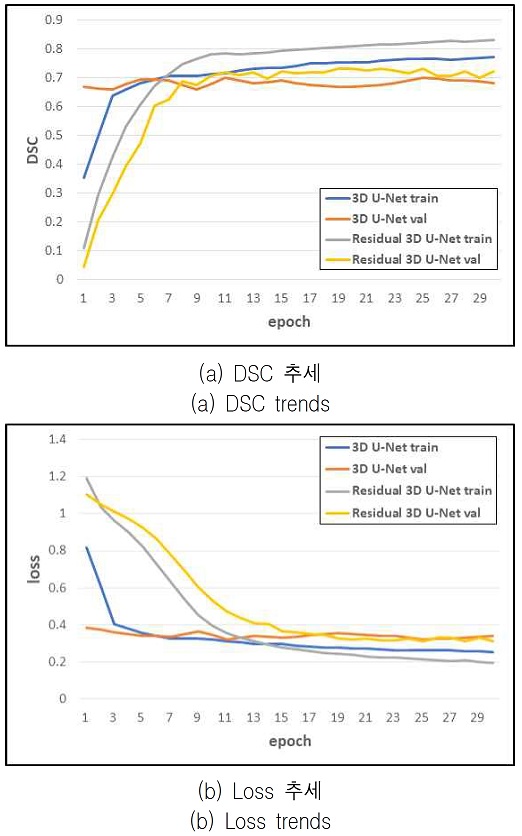

그림 6은 3D U-Net과 Residual 3D U-Net에 대한 FLAIR 채널 영상의 epoch 변화에 대한 훈련 지표이다. 표 2에는 3D U-Net과 Residual 3D U-Net에 대한 MRI 채널별 정확도 성능을 정리하였다. 해당 수치는 테스트 데이터셋에 대한 결과이다.

3D U-Net 모델이 T2W와 PDW 채널 영상에서 DSC와 IoU 정확도가 더 높게 나타났고, 잔차 신경망을 추가한 Residual 3D U-Net 모델이 MPRAGE와 FLAIR 채널 영상에서 DSC와 mean IoU 정확도가 더 높게 나타났다.

두 모델 모두 FLAIR 채널 영상에 대해 가장 높은 DSC를 보였으며, 3D U-Net과 Residual 3D U-Net의 DSC는 각각 64.70%와 70.68%로 나타났다.

따라서 MS lesion 분할을 위해서는 FLAIR 채널이 가장 적합하며 Residual 3D U-Net 모델을 적용하는 것이 높은 정확도를 달성할 수 있는 것을 확인할 수 있다.

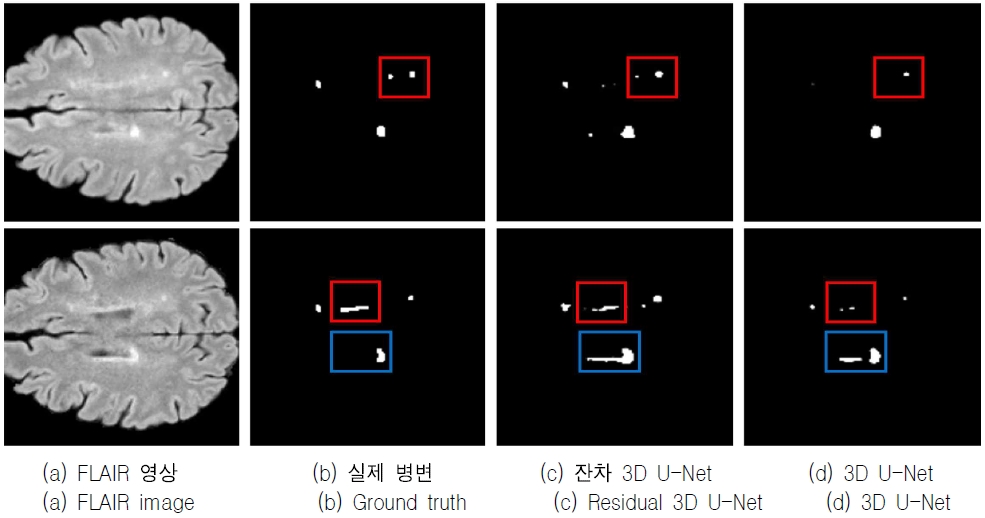

그림 7에는 2개의 FLAIR 채널 평가 영상의 단면, 이에 부합하는 ground truth 및 Residual 3D U-Net과 3D U-Net 모델을 사용하여 다발성 경화 병변을 예측한 결과의 예를 도시하였다. 빨간색 사각형 영역과 같이 기존 3D U-Net에 비해서 잔차 신경망이 추가된 Residual 3D U-Net 모델이 다발성 경화 병변을 더 잘 예측한 것을 확인할 수 있다. 하지만 파란색 사각형 영역처럼 FLAIR 영상에 밝게 표시된 부분을 그대로 다발성 경화 병변으로 과다 추정하는 문제가 있다.

Ⅴ. 결론 및 향후 과제

MRI 의료 영상에서 다발성 경화증을 병리사들이 분석하는 것은 인적 및 시간적 자원을 필요로 하며, 최근 딥러닝 기술의 발전으로 이와 같은 분석을 자동화하는 연구가 진행되고 있다.

본 논문에서는 기존 3D U-Net에 잔차 신경망을 추가한 Residual 3D U-Net 모델을 이용하여 다발성 경화 병변의 의미론적 분할을 위한 알고리즘을 제안하였다. 특히, 의료 영상이 가지고 있는 데이터 부족의 문제를 해결하기 위하여 전처리 및 데이터 증강을 적용하여 정확도 향상을 모색하였다.

또한, 2008 MICCAI MS Lesion Segmentation Challenge의 MS lesion 데이터셋을 이용하여 제안한 알고리즘이 기존 3D U-Net 모델보다 높은 의미론적 분할 정확도를 갖고 있음을 보였다.

추후 연구로 단일 채널이 아닌 다수 채널을 이용하여 성능을 향상하는 방법을 모색할 계획이다. 또한, 다양한 데이터 증강 기법 외에도, 최근 연구들에서 사용된 GAN을 이용한 방법이나 mix-up 등을 활용하여 분할 성능을 높일 수 있는 방법을 연구할 계획이다.

Acknowledgments

This work was supported by the Basic Science Research Program through the National Research Foundation of Korea (NRF) funded by the Ministry of Education (2020R1F1A1057742).

References

- Seoul National University Hospital, Multiple Sclerosis in N Medical Information, http://www.snuh.org/health/nMedInfo/nView.do?category=DIS&medid=AA000105, , [accessed: Jul. 13, 2021]

- J. J. Lee, H. T. Han, Y. U. Choi, B. H. Choi, C. M. Kim, H. S. Kim, S. J. Eom, and H. Y. Lee, "Multiple Sclerosis Lesion Segmentation using Deep Learning", Proceedings of the 2021 KIIT Conference, Jeju, Korea, pp. 523-525, 2021.

- B. Wang and D. Klabjan, "Regularization for Unsupervised Deep Neural Nets", Proc. of the AAAI Conf. on Artificial Intelligence, Vol. 31, No. 1, San Francisco California USA, pp. 2681, Feb. 2017.

- N. Srivastava, G. Hinton, A. Krizhevsky, I. Sutskever, and R. Salakhutdinov, "Dropout: A Simple Way to Prevent Neural Networks from Overfitting", Journal of Machine Learning Research, Vol. 15, No. 56, pp. 1929-1958, Jan. 2014.

-

F. Perez-Garcıa, R. Sparks, and S. Ourselin, "TorchIO: a Python library for efficient loading, preprocessing, augmentation and patch-based sampling of medical images in deep learning", Computer Methods and Programs in Biomedicine, Vol. 208, Sep. 2021.

[https://doi.org/10.1016/j.cmpb.2021.106236]

-

R. Girshick, J. Donahue, T. Darrell, and J. Malik, "Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation", Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition, pp. 580-587, 2014.

[https://doi.org/10.1109/CVPR.2014.81]

-

S. Ren, K. He, R. Girshick, and J. Sun, "Faster R-CNN: Towards real-time object detection with region proposal networks", IEEE Trans. on Pattern Analysis and Machine, Vol. 39, No. 6, pp. 1137-1149, Jun. 2017.

[https://doi.org/10.1109/TPAMI.2016.2577031]

- K. He, G. Gkioxari, P. Dollár, and R. Girshick, "Mask R-CNN", Proc. of the IEEE Int. Conf. on Computer Vision, Venice, Italy, pp. 2961-2969, Oct. 2017.

-

J. Long, E. Shelhamer, and T. Darrell, "Fully Convolutional Networks for Semantic Segmentation", Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition, pp. 3431-3440, Jan. 2015.

[https://doi.org/10.1109/CVPR.2015.7298965]

-

O. Ronneberger, P. Fischer, and T. Brox, "U-Net: Convolutional Networks for Biomedical Image Segmentation", Proc. of the Int. Conf. on Medical Image Computing and Computer-Assisted Intervention, pp. 234-241, May 2015.

[https://doi.org/10.1007/978-3-319-24574-4_28]

-

C. Szegedy, W. Liu, Y. Jia, P. Sermanet, S. Reed, D. Anguelov, D. Erhan, V. Vanhoucke, and A. Rabinovich, "Going deeper with convolutions", Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition, Boston, MA, USA, pp. 1-9, Jun. 2015.

[https://doi.org/10.1109/CVPR.2015.7298594]

- K. Simonyan and A. Zisserman, "Very deep convolutional networks for large-scale image recognition", Prof. of the Int. Conf. on Learning Representations, San Diego, CA, May 2015.

- K. He, X. Zhang, S. Ren, and J. Sun, "Deep Residual Learning for Image Recognition", Proc. of the 2016 IEEE Conf. on Computer Vision and Pattern Recognition, Las Vegas, NV, USA, pp. 770-778, Jun. 2016.

-

Z. Zhang, Q. Liu, and Y. Wang, "Road Extraction by Deep Residual U-Net", IEEE Geoscience and Remote Sensing Letters, Vol. 15, No. 5, pp. 749-753, May 2018.

[https://doi.org/10.1109/LGRS.2018.2802944]

-

O. Cicek, A. Abdulkadir, S. S. LienKamp, T. Brox, and O. Ronneberger, "3D U-Net: Learning Dense Volumetric Segmentation from Sparse Annotation", Proc. of the Int. Conf. on Medical Image Computing and Computer-Assisted Intervention, pp. 424-432, Oct. 2016.

[https://doi.org/10.1007/978-3-319-46723-8_49]

-

F. Milletari, N. Navab, and S. Ahmadi, "V-Net: Fully Convolutional Neural Networks for Volumetric Medical Image Segmentation", Proc. of the Int. Conf. on 3D Vision, Stanford, CA, USA, pp. 565-571, Oct. 2016.

[https://doi.org/10.1109/3DV.2016.79]

-

L. M. Ballestar and V. Vilaplana, "MRI brain tumor segmentation and uncertainty estimation using 3D-UNet architectures", Proc. of the Int. MICCAI Brainlesion Workshop, pp. 376-390, 2020.

[https://doi.org/10.1007/978-3-030-72084-1_34]

-

Z. Xiao, B. Liu, L. Geng, F. Zhang, and Y. Liu, "Segmentation of Lung Nodules Using Improved 3D-UNet Neural Network", Symmetry, Vol. 12, No. 11, pp. 2411-2502, Oct. 2020.

[https://doi.org/10.3390/sym12111787]

-

S. Valverde, M. Cabezas, E. Roura, S. G. Villà, D. Pareto, J. C. Vilanova, L. R. Torrentà, À. Rovira, A. Oliver, and X. Lladó, "Improving automated multiple sclerosis lesion segmentation with a cascaded 3D convolutional neural network approach", NeuroImage, Vol. 155, pp. 159-168, Feb. 2017.

[https://doi.org/10.1016/j.neuroimage.2017.04.034]

- A. L. Maas, A. Y. Hannun, and A. Y. Ng, "Rectifier Nonlinearities Improve Neural Network Acoustic Models", Proc. of the Int. Conf. on Machine Learning, Atlanta, USA,, pp 3-8, Jun. 2013.

- B. Xu, N. Wang, T. Chen, and M. Li, "Empirical Evaluation of Rectified Activations in Convolutional Network", Proc. of the Int. Conf. on Machine Learning, Lille, France, Jul. 2015.

- D. Ulyanov, A. Vedaldi, and V. Lempitsky, "Instance Normalization: The Missing Ingredient for Fast Stylization", arXiv:1607.08022v3, , Nov. 2017.

-

A. Carass, S. Roy, A. Jog, J. L. Cuzzocreo, E. Magrath, A. Gherman, J. Button, J. Nguyen, P. L. Bazin, P. A. Calabresi, C. M. Crainiceanu, L. M. Ellingsen, D. S. Reich, J. L. Prince, and D. L. Pham, "Longitudinal multiple sclerosis lesion segmentation data resource", Data in Brief, Vol. 12, pp. 346-350, Jun. 2017.

[https://doi.org/10.1016/j.dib.2017.04.004]

2016년 2월 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 학사과정

관심분야 : 이미지 처리, 딥러닝, 컴퓨터 그래픽스

2017년 2월 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 학사과정

관심분야 : 이미지/자연어 처리, 딥러닝

2017년 2월 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 학사과정

관심분야 : 이미지/영상 처리

2017년 3월 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 학사과정

관심분야 : 이미지 처리, 딥러닝

1997년 : 성균관대학교 정보공학과 (학사)

1999년 : KAIST 전산학과 (공학석사)

2006년 : KAIST 전자전산학과 (공학박사)

2008년 ~ 현재 : 금오공과대학교 컴퓨터소프트웨어공학과 교수

관심분야 : Digital Forensics, Image Processing, IoT