U-OLANet : 이미지 디노이징을 위한 저해상도 단층 어텐션 신경망

초록

이미지 처리 분야에서 딥러닝이 적용된 다양한 연구 개발이 이루어지고 있다. 이미지의 특징을 직접적으로 추출해야하는 기존의 기술을 딥러닝 기술을 적용함으로써 이미지 공간 정보 학습을 통해 한계점을 극복하였다. 하지만 이미지 생성 및 전송 과정에서 노이즈가 포함될 수밖에 없다. 그로 인해 딥러닝 모델들의 성능이 학습 시 사용되는 입력 이미지에 포함되는 노이즈에 의해 저하될 수 있다. 본 논문에서는 Autoencoder의 압축 기능으로 저해상도에서의 큰 특징을 추출하고 이전 값을 참조하는 skip connections을 통해 더 많은 특징을 추출하는 U-Net 기반 One-LANet(One-Layer Attention Network)의 조합으로 성능 개선된 이미지 디노이징 모델 U-OLANet(U-Net based One-Layer Attention Network)을 제안한다. 제안하는 방법은 Set12에서 PSNR=30.48 / SSIM=0.9306, BSD68에서 PSNR=29.29 / SSIM=0.9030으로 기존의 모델보다 좋은 성능을 보여준다.

Abstract

Various research and development with deep learning is taking place in the field of image processing. We overcome the limitations through image spatial information learning by applying deep learning technique, to existing techniques that require direct extraction of features of images. However, noise can only be included in the process of image creation and transmission. As a result, the performance of deep learning models can be degraded by the noise contained in the input image used in learning. In this paper, we propose a performance-enhanced image denoising model U-OLANet(U-Net based One-Layer Attention Network) with a combination of U-Net-based One-LANet(One Layer Attention Network) that extracts large features at low resolution and extracts more features via skip connections referencing prior values. The proposed method outperforms existing models with PSNR=30.48 / SSIM=0.9306 on Set12 and PSNR=29.29 / SSIM=0.9030 on BSD68.

Keywords:

image denoising, deep learning, attention, u-net, autoencoderⅠ. 서 론

최근 수많은 분야에서 딥러닝이 적용되어 이미지, 음성, 자연어 처리 등 다양한 연구 및 개발을 통해 성능 개선이 이루어지고 있다. 그리고 이미지 처리 기술에 대한 급격한 발전으로 이미지 분류, 물체 인식 등 이미지 처리 전반적인 분야에서 활발한 연구가 진행되고 있으며, 딥러닝이 적용되어 성능이 개선된 기법들이 많이 발표되고 있다. 기존의 알고리즘들은 이미지의 특징을 직접적으로 추출해야하며, 특징에 따라 성능에 영향을 많이 주며 한계가 존재한다. 하지만 이미지 처리 분야에 가장 흔히 사용되는 딥러닝 기술은 인공신경망의 한 부류이며, 이미지 공간 정보를 그대로 이용하여 학습 가능하다. 기존의 이미지 처리 방식에 비해 전처리 과정이 적다는 장점을 가지고 있으며, 이미지의 특징을 자동 추출이 가능하다.

CNN(Convolutional Neural Network)의 기본적인 구성은 합성곱 계층, 풀링 계층과 완전 연결 계층 등으로 구성되어있다. 입력 데이터가 각 필터를 거치면서 합성곱을 계산하며, 결과를 이용하여 이미지 특징을 추출한다. CNN 기반으로 활용한 대표적인 딥러닝 기술은 AlexNet, VGGNet, GoogLeNet, ResNet 등 수많은 딥러닝 모델들이 발표되었고[1], 눈에 띄는 성과를 보이고 있다. 이러한 모델들의 성능은 학습 시 사용되는 입력 이미지에 포함되어있는 여러 노이즈에 의해 저하될 수 있다. 그리고 이미지 생성 및 전송 과정에서 노이즈가 포함될 수밖에 없다. 입력 데이터에 의해 학습하는 딥러닝 모델은 학습 시에 노이즈도 포함하여 계산하기 때문에 입력 데이터가 노이즈에 의해 열화가 발생하면 성능 저하가 발생한다. 그래서 실제 사용되는 환경에서 평가 시 노이즈 제거는 필수 요소이다[2].

이미지 디노이징 기술은 이미지의 디테일을 복원시켜 이미지를 입력으로 사용하는 여러 분야에서 필수적이라고 볼 수 있다. 현재 이미지 디노이징 기술 또한 성능 향상을 위해 딥러닝 기술을 적용한 연구가 활발히 진행되고 있다[3].

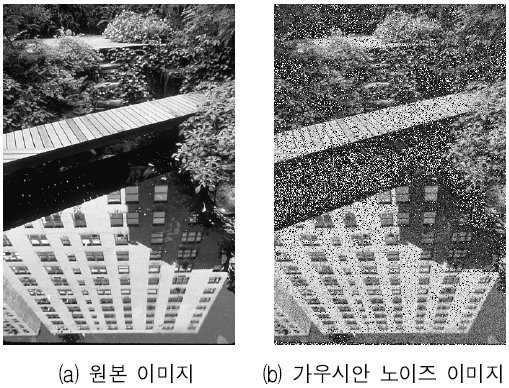

노이즈가 포함된 이미지에서 최대한 원본 이미지와 같게 하는 것이 이미지 디노이징의 목표이며, 딥러닝이 적용된 대표적인 이미지 디노이징 기술은 DnCNN(Denoising CNN)[4]으로 학습을 위해 그림 1과 같이 원본 이미지에 가우시안 노이즈를 포함하여 가우시안 노이즈 이미지를 만들고 노이즈를 예측하도록 학습이 진행된다. 예측값을 가우시안 노이즈 이미지에서 차를 취하면 원본에 가까운 선명한 이미지를 만든다. 딥러닝 기술이 적용된 일반적인 디노이징 기술들은 이러한 방식으로 학습 및 노이즈 제거를 수행한다. 하지만 이미지 디노이징의 성능 개선을 위해서는 단순히 심층 신경망의 깊이만 증가시킨다면 연산량이 너무 많아지고 오히려 성능 저하나 성능 포화 상태에 도달하게 되는 어려움을 겪는다.

본 논문에서는 단순히 신경망의 깊이를 증가하지 않고 2가지의 신경망 모델을 병렬로 구성하여 모델의 폭을 넓혔다. 각 모델의 입출력단에 단순한 어텐션 기능만 수행하는 단층 어텐션 모듈을 추가하여 더 많은 이미지 특징 추출하며 성능 포화 상태를 개선하였고 기존의 연구한 모델인 One-LANet[5]에서 Autoencoder의 압축 기능과 skip connections을 통해 성능 개선을 이루었다.

Ⅱ. 관련 이론

2.1 DnCNN

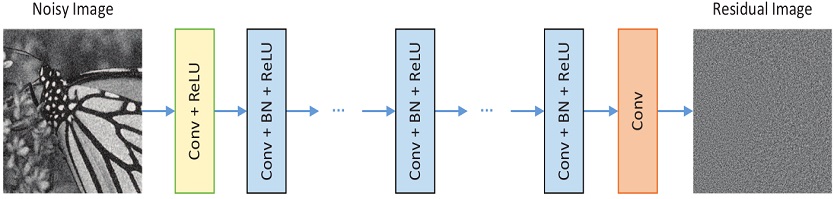

딥러닝 기술을 적용한 대표적인 노이즈 제거 모델로 feed-forward CNN을 통해 노이즈 이미지와 노이즈를 분리한다. 그림 2와 같이 노이즈 제거된 이미지를 바로 예측하지 않고 관찰된 노이즈에서 원본 이미지를 차이를 통해 노이즈 분포를 먼저 예측한다. 학습 시 추가되는 노이즈는 AWGN(Additive White Gaussian Noise)이다.

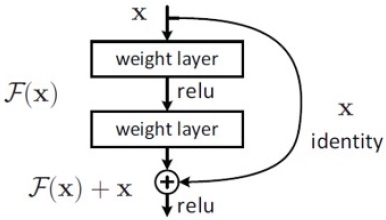

기존의 딥러닝 구조는 성능 개선을 위해 신경망의 층을 증가시킨다. 하지만 깊게 구성한다고 무조건 성능 개선이 이루어지지 않으며, 한계가 존재한다. ResNet(Residual Neural Network)은 Residual Block을 통해 기존의 신경망과 다른 구조를 보여준다. 입력값과 출력값을 단순히 매핑하는 것이 아닌 그림 3과 같이 skip connections를 통해 해결책을 제시했다[6]. 그래서 DnCNN에서 Residual Leaning과 BN(Batch Normalization)을 결합하여 학습 속도를 증가시켜 노이즈 제거 성능을 높였다.

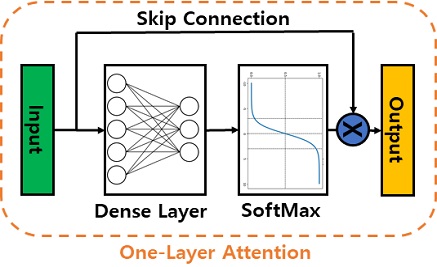

2.2 Attention Module

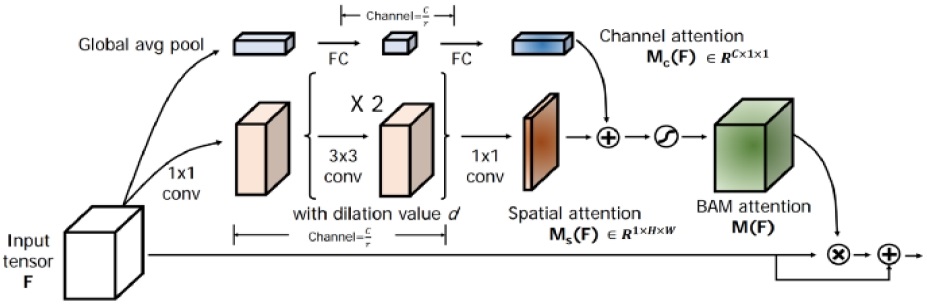

어텐션 모듈은 그림 4와 같이 크게 두 가지로 나눌 수 있다. 하나는 채널 어텐션으로 GAP(Global Average Pooling)을 통해 공간적인 정보를 제거하여 채널의 정보만 남은 특징을 결과로 추출한다. 다른 하나는 공간적 어텐션으로 채널 정보를 삭제하고 공간적 중요도만 가지는 특징맵을 생성한다. 이를 통해 초해상도, 열화 이미지 복원 등 이미지 관련 분야에서 우수한 성능을 보여준다. 본 논문에서 이미지 디노이징 성능 향상에 도움이 되는 기초 모듈이며, 단순화를 통해 적용하였다[7][8].

2.3 U-Net

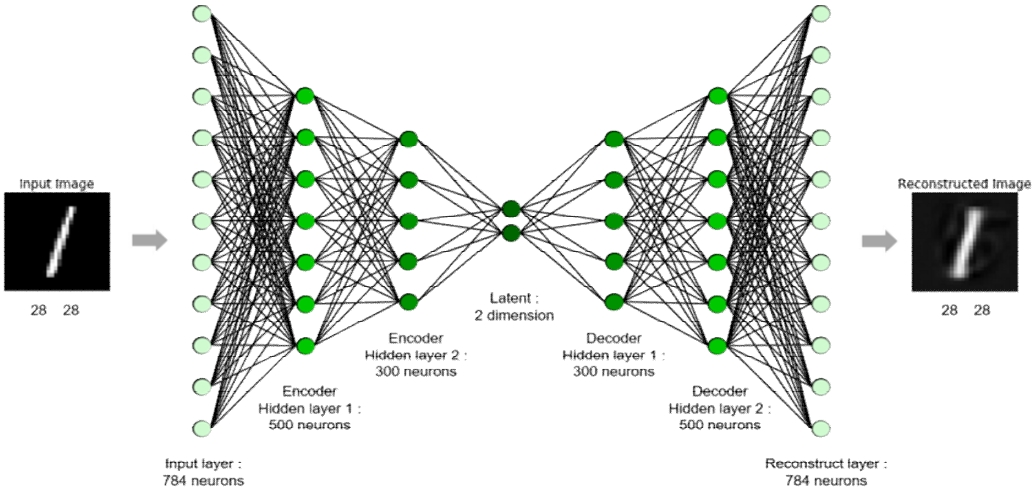

U-Net을 말하기 전에 Autoencoder에 대한 정보가 필요하다. 기본적으로 입출력 관계가 Borttlemeck 구조로 되어있어 여러 제약을 통해 그림 5와 같이 원본으로 복원하도록 학습할 수 있다.

크게 인코더, 디코더 두 가지로 구성되어 있다. 인코더는 인지 네트워크로 입력을 압축하는 역할을 하며, 디코더는 생성 네트워크로 압축된 데이터를 복원하는 역할을 한다. 입력 데이터를 고차원에서 저차원으로 축소하는 방법과 여러 제약 조건을 입력 데이터에 추가하여 학습한다면 제약 조건에 따른 다양한 모델 생성이 가능하다[9].

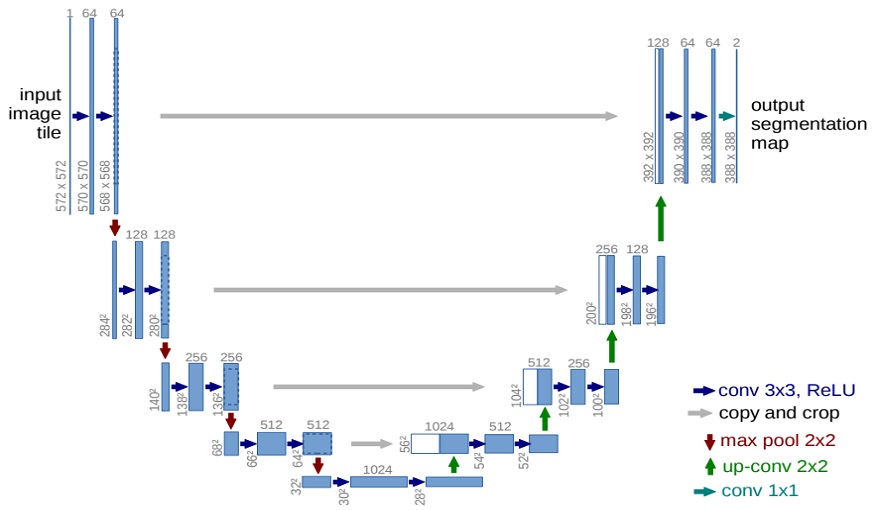

이러한 장점을 이용하여 U-Net은 ResNet과 Autoencoder의 개념을 조합한 그림 6과 같이 U자 형태의 구조를 가지며, 크게 세 부분으로 나눌 수 있다. 첫 번째는 전진적으로 넓은 범위에서 이미지 픽셀에 대한 의미 정보를 추출하는 수축 경로이고, 두 번째는 의미 정보를 픽셀 위치 정보와 매칭시켜 각 픽셀의 객체를 구분하는 확장 경로이며, 마지막은 수축 경로에서 확장 경로로 변화되는 전환 구간이다. 이러한 구조로 기존의 문제점인 겹치는 패치의 불필요한 중복성을 제거하여 성능 개선이 이루어졌다[10].

Ⅲ. 제안하는 방법

딥러닝 모델은 신경망의 깊이에 따라 성능이 달라진다. 하지만 깊이만 증가하면 성능 포화 상태에 도달하거나 오히려 성능이 저하될 수 있다. 본 논문에서는 단순히 신경망의 깊이를 증가시키지 않고 Autoencoder의 압축 기능과 이전 값을 참조하여 더 많은 특징을 추출할 수 있는 ResNet의 skip connections을 사용하여 U-Net의 구조 기반 One-LANet의 조합을 통한 이미지 디노이징 모델 U-OLANet을 제안한다.

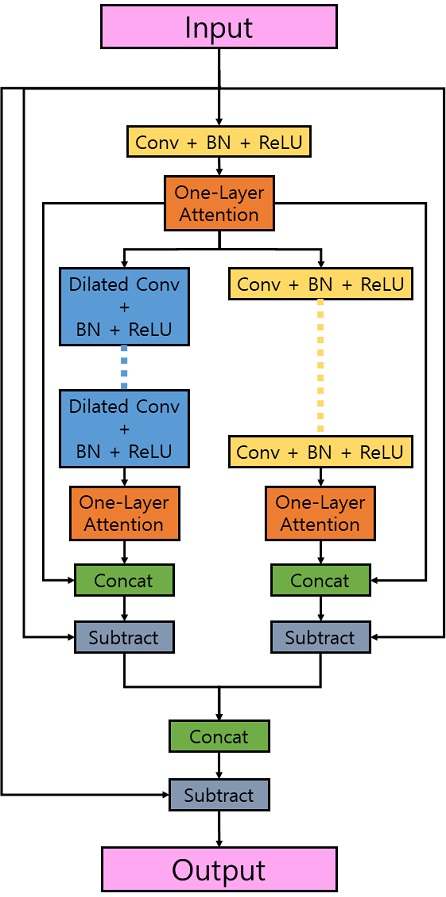

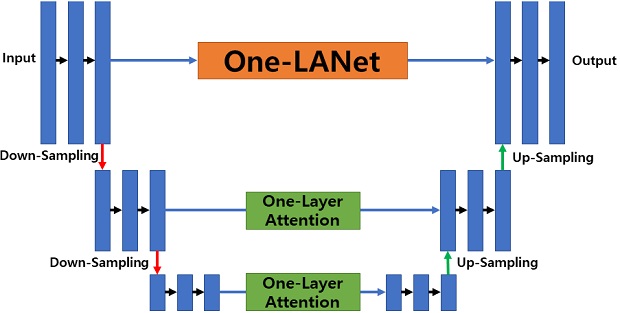

우선, 기존의 One-LANet는 그림 7과 같이 DnCNN과 Convolution Layer의 확장형인 Dilataed Layer가 추가된 모델이 병렬로 구성되어 있으며, 네트워크의 확장성을 부여되어 있다.

그리고 Residual Learning를 통해 기울기 손실에 대비하고 이전 특징과의 참고함으로써 성능 개선을 이루었다.

One-LANet 구조는 크게보면 직렬 형태로 구성되어있는 것으로 볼 수 있다. 여기서 깊이만 증가된다고 성능 개선을 이루지 못하기 때문에 구조적 변화가 필요하다. 기존의 U-Net은 Autoencoder와 ResNet의 핵심 기술인 shortcut이 적용되어 있다. 이것을 기반으로 기존의 U-Net은 다운 샘플링을 네 번 수행하였지만 제안하는 방법은 저해상도에서의 공간적 특징 손실을 막기 위해 두 번만 수행하였다.

첫 입력 부분과 마지막 출력 부분의 연결 부위에 기존의 One-LANet을 연결하고 다운 샘플링된 부분에서의 연결 부위는 입출력 관계를 그림 8과 같은 단층 어텐션 모듈을 추가하여 단순히 이전값을 전달하는 것이 아닌 어텐션 모듈의 기능을 수행하면서 연산량을 늘이지 않고 다양한 특징을 전달한다.

모델의 구조가 더 확장되었지만 깊이가 아닌 폭으로 증가되었고 다운 샘플링은 통한 연결이기 때문에 기존 모델과의 연산량 차이가 적어 학습 속도의 감소는 작다.

그림 9를 보면 원본 이미지에 가우시안 노이즈를 추가하여 제안하는 모델의 입력으로 들어간다. 처음은 One-LANet에 적용하고 다운 샘플링 과정을 한번 거쳐 사이즈가 반으로 줄어든 입력 이미지를 skip connections을 통해 출력과 연결하고 그 사이에 어텐션 모듈을 적용하였다. 다운 샘플링 과정을 두 번 거친 이미지를 다운 샘플링을 한번 거친 부분과 동일하게 수행하고 사이즈가 작아진 이미지들의 결과를 원본 이미지와 같은 사이즈로 업샘플링을 하여 최종단에 합쳐 출력하는 구조로 되어있다.

Ⅳ. 실험 방법 및 결과

본 논문에서 학습 데이터셋은 180*180 사이즈의 400개의 이미지를 사용하였다. 테스트 데이터셋은 그레이 스케일 이미지로 Set12와 BSD68를 사용하여 테스트를 진행하였다. 실험 환경은 구글 코랩에서 제공하는 Tesla P100을 사용하여 학습을 수행하였다. 가우시안 노이즈 레벨은 σ=25이며, 압축된 영상 화질에 대한 손실된 정보를 평가하기 위해 고안된 PSNR(Peak Signal-to-Noise Ratio)과 인간의 시각적 화질 차이를 고려한 SSIM(Structural Similarity Index Map)을 통해 다른 모델과 비교하여 개선된 성능을 보여준다[11]. 표 1은 BSD68 데이터셋을 사용하여 다른 모델과 비교하여 디노이징 성능을 평균 PSNR 수치로 성능을 비교한 것으로 제안하는 방법이 다른 모델보다 좋은 성능을 보여준다.

표 2는 데이터셋 Set12와 BSD68을 통해 제안하는 방법과 다른 모델을 PSNR과 SSIM 수치로 비교한다. 제안하는 모델은 Set12에서 PSNR=30.48 / SSIM=0.9306의 성능을 보여주며, BSD68에서 PSNR=29.29 / SSIM=0.9030으로 가장 좋은 성능을 보여준다. 특히, SSIM이 다른 모델에 비해 아주 좋은 성능을 보여준다. SSIM는 사람의 시각적 화질 차이 및 유사도를 평가하기 위해 두 이미지의 휘도, 대비, 및 구조를 비교하는 방법으로 실제 사람이 느끼는 화질 개선의 정도를 알 수 있어 더 사실적인 성능 비교가 가능하다.

표 3은 Set12 데이터셋의 12장을 PSNR 성능 수치로 모델별 비교한 것이다. 특정 이미지들에서 다른 모델에 비해 성능이 떨어지는 것을 볼 수 있으나 12장의 이미지 중 9장이 제안하는 방법에서 가장 좋은 성능을 보여주며, 평균 PSNR이 가장 높은 수치를 가지기 때문에 전체적으로 보았을 때 비교 모델 중에서 가장 좋은 성능을 보여준다고 할 수 있다.

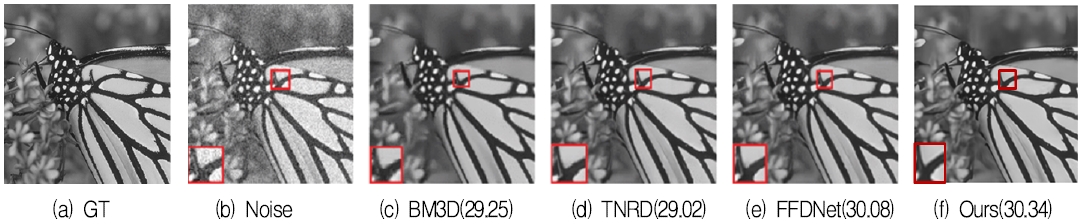

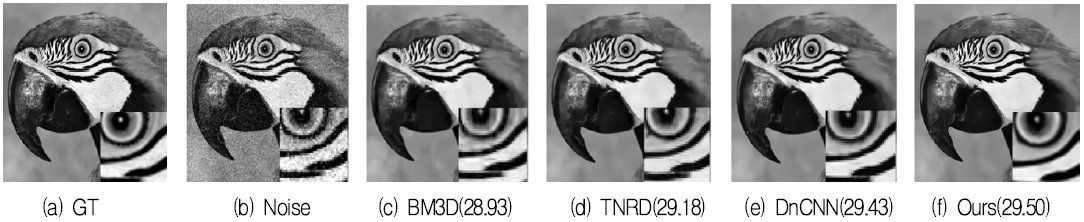

그림 10, 11은 Set12 데이터셋 이미지를 통해 노이즈가 제거된 이미지를 비교한 것으로 확대한 부분을 보면 제안하는 모델이 노이즈가 제거되어 더 선명한 이미지로 복원한 것을 알 수 있다.

Ⅴ. 결 론

본 논문에서는 Autoencoder의 압축 기능으로 저해상도에서의 큰 특징을 추출하고 이전 값을 참조하는 skip connections을 통해 더 많은 특징을 추출하며 전체적인 구조를 U-Net과 기존의 One-LANet의 조합으로 성능 개선된 이미지 디노이징 모델 U-OLANet을 제안하였다. Set12, BSD68 데이터셋을 통해 제안하는 방법과 다른 모델들을 PSNR, SSIM 성능 수치를 비교하였고 데이터셋의 이미지 일부를 통해 노이즈 제거의 정도를 확인하였다. Set12에서 PSNR=30.48 / SSIM=0.9306, BSD68에서 PSNR=29.29 / SSIM=0.9030으로 기존의 모델보다 좋은 성능을 보여준다. 제안하는 방법은 U-Net 구조를 통해 파라미터 수를 많이 늘리지 않고 저해상도에서의 단층 어텐션 모듈의 역할로 다른 모델보다 공간적인 특징맵을 생성하여 PSNR 뿐만 아니라 특히 SSIM의 수치를 통해 매우 개선된 성능을 확인하였다. 추후 다른 모델의 기술과 여러 실험 데이터를 통해 성능을 비교하고 더 개선된 성능을 이끌어내기 위한 연구가 필요하다.

Acknowledgments

이 논문은 2017 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임 (No.2017R1D1A1B04030870)

"2021년도 한국정보기술학회 종합학술대회에서 발표한 논문(One-LANet: Image Denoising Neural Networks with One-Layer Attention Modules)을 확장한 것임"

References

-

F. Emmert-Streib, Z. Yan, H. Feng, S. Tripathi, and M. Dehmer, "An Introductory Review of Deep Learning for Prediction Models With Big Data", Frontiers in Artificial Intelligence, Vol. 3, pp. 4, Feb. 2020.

[https://doi.org/10.3389/frai.2020.00004]

- J. Lehtinen, J. Munkberg, J. Hasselgren, S. Laine, T. Karras, M. Aittala, and T. Aila, "Noise2Noise: Learning Image Restoration without Clean Data", International Conference on Machine Learning, ICML, Vol. 7, No. 12, pp. 4620-4631, Jan. 2018.

-

C. Tian, Y. Xu, and W. Zuo, "Image denoising using deep CNN with batch renormalization", Neural Networks, Vol 121, pp. 461-473, Jan. 2020.

[https://doi.org/10.1016/j.neunet.2019.08.022]

-

Zhang K, Zuo W, Chen Y, Meng D, and Zhang L, "Beyond a Gaussian Denoiser: Residual Learning of Deep CNN for Image Denoising", IEEE, Vol 26, No. 7, pp. 3142-3155, Feb. 2017.

[https://doi.org/10.1109/TIP.2017.2662206]

- J. Han and D. S. Kang, "One-LANet: Image Denoising Neural Networks with One-Layer Attention Modules", Proceedings of KIIT Conference, Jeju, Korea, pp. 165-168, Jun. 2021.

- K. He, X. Zhang, S. Ren, and J. Sun, "Deep Residual Learning for Image Recognition", CVPR, Vol. 1, pp. 770-778, Jun. 2016.

- A. Vaswani, N. Shazeer, N. Parmar, J. Uszkoreit, L. Jones, A. N. Gomez, L. Kaiser, and I. Polosukhin, "Attention is all you need", 31st Conference on Neural Information Processing Systems, NIPS, Long Beach, CA, USA, pp. 6000-6010, Dec. 2017.

- J. C. Park, S. H. Woo, J. Y. Lee, and I. S. Kweon, "BAM: Bottleneck Attention Module", BMVC, Sep. 2018. https://arxiv.org/abs/1807.06514, .

- P. Baldi, "Autoencoders, Unsupervised Learning, and Deep Architectures", UTLW, Vol. 27, pp. 37-50, Jul. 2011.

-

O. Ronneberger, P. Fischer, and T. Brox, "U-Net: Convolutional Networks for Biomedical Image Segmentation", MICCAI, Vol. 9351, pp. 234-241, Nov. 2015.

[https://doi.org/10.1007/978-3-319-24574-4_28]

-

C. Tian, L. Fei, W. Zheng, Y. Xu, W. Zuo, and C. W. Lin, "Deep Learning on Image Denoising: An overview", Neural Networks, Vol. 131, pp. 251-275, Nov. 2020.

[https://doi.org/10.1016/j.neunet.2020.07.025]

-

K. Dabov, A. Foi, V. Katkovnik, and K. Egiazarian, "Image Denoising by Sparse 3-D Transform-Domain Collaborative Filtering", in IEEE Transactions on Image Processing, Vol. 16, No. 8, pp. 2080-2095, Aug. 2007.

[https://doi.org/10.1109/TIP.2007.901238]

-

M. Karimi-Ghartemani, B. Ooi, and A. Bakhshai, "Application of Enhanced Phase-Locked Loop System to the Computation of Synchrophasors", in IEEE Transactions on Power Delivery, Vol. 26, No. 1, pp. 22-32, Jan. 2011.

[https://doi.org/10.1109/TPWRD.2010.2064341]

-

Q. Wu, W. Ren, and X. Cao, "Learning Interleaved Cascade of Shrinkage Fields for Joint Image Dehazing and Denoising", in IEEE Transactions on Image Processing, Vol. 29, pp. 1788-1801, Sep. 2019.

[https://doi.org/10.1109/TIP.2019.2942504]

- S. Gu, L. Zhang, W. Zuo, and X. Feng, "Weighted Nuclear Norm Minimization with Application to Image Denoising", CVPR, Columbus, OH, USA, pp. 2862-2869, Jun. 2014.

-

Y. Chen and T. Pock, "Trainable Nonlinear Reaction Diffusion: A Flexible Framework for Fast and Effective Image Restoration", IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 39, No. 6, pp. 1256-1272, Jun. 2017.

[https://doi.org/10.1109/TPAMI.2016.2596743]

-

K. Zhang, W. Zuo, S. Gu, and L. Zhang, "Learning Deep CNN Denoiser Prior for Image Restoration", CVPR, Honolulu, HI, USA, pp. 2808-2817, Jul. 2017.

[https://doi.org/10.1109/CVPR.2017.300]

-

K. Zhang, W. Zuo, and L. Zhang, "FFDNet: Toward a Fast and Flexible Solution for CNN-Based Image Denoising", IEEE Transactions on Image Processing, Vol. 27, No. 9, pp. 4608-4622, Sep. 2018.

[https://doi.org/10.1109/TIP.2018.2839891]

-

Klomp, Sander, van de Wouw Dennis, B.V., ViNotion, and de With Peter H. N, "ECDNet: Efficient Siamese Convolutional Network for Real-Time Small Object Change Detection from Ground Vehicles", Electronic Imaging, Butlingame, USA, Vol. 2019, No. 7, pp. 458-1-458-7, Jan. 2019.

[https://doi.org/10.2352/ISSN.2470-1173.2019.7.IRIACV-458]

-

C. Tian, Y. Xu, Z. Li, W. Zuo, L. Fei, and H. Liu, "Attention-guided CNN for image denoising", Neural Networks, Vol. 124, pp. 117-129, Apr. 2020.

[https://doi.org/10.1016/j.neunet.2019.12.024]

2020년 2월 : 동아대학교 전자공학과 (공학사)

2020년 3월 ~ 현재 : 동아대학교 전자공학과 석사과정

관심분야 : 영상처리, 인공지능

1994년 5월 : Texas A&M 대학교 전자공학과 (공학박사)

1995년 ~ 현재 : 동아대학교 전자공학과 교수

관심분야 : 영상처리, 패턴인식, 인공지능