최적화된 학습데이터를 통한 머신러닝 기반의 안개 제거 알고리즘의 성능개선

초록

자율주행 자동차는 카메라를 통해 차선과 도로표지판, 신호등 등의 주변 환경 인식하여 자동으로 운전하기 때문에 주변의 정보를 정확하게 수집하는 기술이 중요하다. 그러나 카메라는 안개가 낀 날씨와 같은 악조건 상황에 정확한 인식을 하지 못하는 문제가 있다. 최근에는 이러한 문제를 해결하기 위하여 머신러닝에 기반을 둔 안개를 제거하는 알고리즘을 활용한 기술에 대한 연구가 활발히 진행되고 있다. 본 논문에서는 기존의 머신러닝 기반의 안개 제거 알고리즘에서 깊이 맵 추정을 위한 학습데이터로 영상의 특징들의 관계를 분석한다. 최적화된 학습데이터를 이용한 선형모델로 개선된 깊이 맵을 추정하여 알고리즘의 성능을 개선하는 방법을 제안하고, O-HAZE와 I-HAZE 영상에 대한 정량적 수치결과 약 4.0%를 개선하여 성능의 우수성을 검증했다.

Abstract

In autonomous cars, it is crucial to collect accurate information because they operate by recognizing surrounding objects such as lanes, road signs, and traffic lights through a camera or laser. However, cameras may not work properly in severe conditions such as foggy weather. Recently, to solve this problem, research on an algorithm for removing fog based on machine learning has been actively conducted. In this paper, we propose a method to improve the dehazing performance by optimizing learning data that is used for depth map estimation in the existing machine learning-based haze removal algorithm. The proposed method improved about 4.0% of the quantitative numerical results for O-HAZE and I-HAZE images, and the superiority of the performance was verified.

Keywords:

haze removal, optimal training data, haze-related features, machine learning, image processingⅠ. 서 론

최근 자율주행 자동차의 개발이 활발히 이루어지면서 영상처리 기술에 관한 연구가 주목받고 있다[1][2]. 자율주행 자동차는 카메라나 레이더를 통해 차선과 도로표지판, 신호등과 같은 주변 환경을 인식하여 자율적으로 운행하는 시스템이다. 그러나 카메라나 레이더는 날씨에 영향을 받기 때문에 안개가 낀 날씨와 같은 악조건에서 중요한 정보를 정확하게 인식하지 못하는 문제가 발생한다. 이러한 문제를 해결하기 위해 영상처리 기법 중 안개 제거 기술에 관한 연구가 필요하다. 안개 제거 알고리즘에 관한 연구는 과거에서 현재까지 꾸준히 진행되고 있다[3]-[6]. 최근에는 데이터를 기반으로 문제를 해결하는 머신러닝 알고리즘을 활용한 안개 제거 기술 연구가 진행되고 있다. 머신러닝 알고리즘을 활용한 안개 제거 연구 동향은 다음과 같다. 첫 번째로 Zhu의 방법에서는 영상의 채도와 밝기는 깊이 맵과 선형관계에 있다는 가정에 기반하여 선형모델에 대한 깊이 맵을 추정하여 안개를 제거하는 방법을 제안하였다[7]. 두 번째로 Ngo은 Zhu의 방법에서 합성 안개 영상을 생성할 때 균일성이 보장되는 등분포를 사용하여 알고리즘을 개선한 방법을 제안했다[8]. 마지막으로 Lee는 Ngo의 방법에서 하이퍼 파라미터인 learning rate를 자동으로 조절하는 적응적 학습률을 사용하여 알고리즘의 성능을 개선하는 방법을 제안했다[9].

대표적인 머신러닝 기반의 안개 제거 알고리즘들에서는 모두 깊이 맵을 추정하기 위한 학습데이터로 영상의 선명도를 나타내는 채도(saturation)와 영상의 색이 지니는 밝기를 나타내는 명도(value)만 사용하였다. 기존의 방법으로 추정한 깊이 맵을 사용하여 안개를 제거하는 방법에서 성능을 향상시키기 위해서는 더 정확한 깊이 맵을 추정하는 기술이 필요하다. 깊이 맵 추정 기술의 성능은 학습데이터에 의해 영향을 받는다는 가정하에 우리는 영상의 특징들 간의 관계에 대해 분석하고 최적화된 학습데이터를 선택한다.

본 논문에서는 머신러닝 안개 제거 알고리즘의 개선된 깊이 맵을 추정하기 위한 학습데이터로 영상의 saturation, value, local entropy, DCP(dark channel prior)를 사용하고 변형한 선형모델을 통해 알고리즘의 성능을 개선하는 방법을 제안한다.

본 논문은 다음과 같이 구성되었다. 머신러닝 기반의 안개 제거 알고리즘에 대해 간략하게 소개하고, 학습데이터로 사용되는 영상의 특징들 간의 관계에 대하여 분석해본다. 그리고 개선된 깊이 맵을 추정하기 위해 제안한 방법에 대해 소개한다. 최종적으로 알고리즘의 성능 검증을 위해 정량적 수치평가와 가시적 결과 영상을 제시하고 마지막으로 본 논문의 결론을 서술한다.

Ⅱ. 관련 연구

안개 제거 알고리즘에서 안개가 제거된 영상을 얻기 위하여 사용되는 Atmospheric Scattering Model은 식 (1)과 식 (2)로 표현한다. 식에서 (x, y)는 영상 픽셀들의 위치를 나타낸다. 식 (1)에서 t(x,y)은 안개 전달량을 나타내는 전달 맵(Transmission map)이고 d(x,y)은 영상의 깊이(Depth map), β은 산란계수를 의미한다. 식 (2)에서 I(x,y)은 안개가 있는 영상, J(x,y)은 안개가 제거된 영상, A는 대기강도를 나타낸다.

| (1) |

| (2) |

입력 안개 영상으로부터 안개가 제거된 결과 영상을 얻기 위해서는 안개 전달 량인 t(x,y)을 구해야 한다. t(x,y)을 구하기 위해서는 영상의 깊이 d(x,y)의 값을 구해야 한다. 기존의 머신러닝 기반 안개 제거 알고리즘들에서는 깊이 맵은 영상의 채도와 밝기와 선형적인 관계에 있다는 가정에 기반하여 식 (3)과 같은 선형모델을 사용하였다[7]-[10]. 식 (3)에서 θ0, θ1, θ2은 선형 모델의 매개변수이다. d(x,y)은 깊이 맵, v(x,y)은 밝기 그리고 s(x,y)은 채도를 의미한다. ε(x,y)은 랜덤 오차로 0에 근사한 값을 가지므로 무시한다.

2.1 학습 데이터의 생성

학습데이터를 생성할 때 사용되는 안개 영상은 Zhu의 논문에서 제안한 방법을 이용하고 생성과정은 다음과 같다[7]. 첫 번째로 500x400의 동일한 크기의 고해상도의 안개가 없는 영상 500장을 인터넷에서 수집한다. 두 번째로 (0, 1)의 랜덤 안개 강도와 (0.8, 1)의 랜덤 대기강도를 사용하여 합성 깊이 맵을 생성한다. 그러나 깊이 맵을 생성할 때 Zhu가 사용한 pseudo random number generators 방법을 사용하여 생성하면 랜덤 안개강도와 랜덤 대기강도 분포의 균일성을 보장하지 못한다. 그래서 Ngo의 논문에서 제안된 균일 분포가 보장되는 enhanced equidistribution 방법을 사용하여 합성 깊이 맵을 생성한다[8]. 두 단계를 통해 얻은 500장의 안개가 없는 영상과 합성 깊이 맵을 사용하여 식 (1), 식 (2)를 통해 합성 안개 영상 500장을 얻을 수 있다.

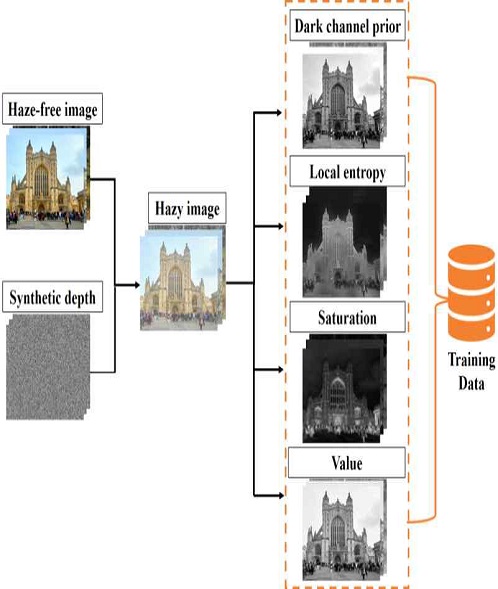

선형모델의 매개변수들을 추정하기 위해 학습데이터는 합성 안개 영상에서 saturation, value, local entropy, DCP를 추출하여 사용한다. 그림 1은 합성 안개 영상을 생성하는 과정과 학습데이터로 사용되는 특징을 추출하는 과정에 대해 나타낸 이미지이다.

2.2 학습 데이터의 최적화

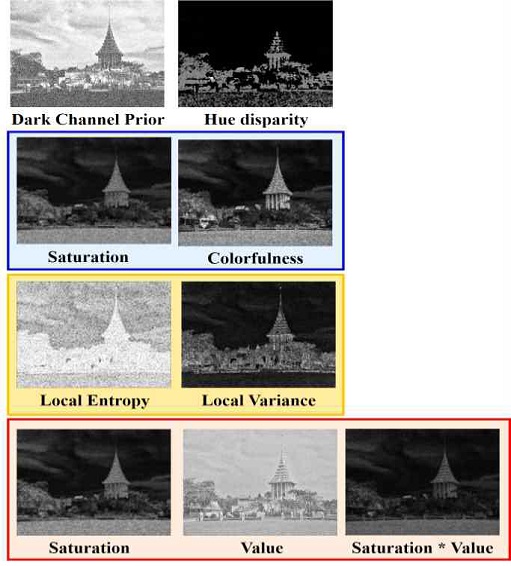

대표적인 머신러닝에 기반한 안개 제거 알고리즘들에서 깊이 맵을 추정하기 위해 학습데이터로 영상의 채도와 밝기만 사용하였다. 본 논문에서는 개선된 깊이 맵을 추정하기 위하여 학습데이터를 최적화하는 방법을 제안한다. 안개영상은 다양한 특징들을 가지고 각각의 특징들은 관계가 있다[10]. 그림 2는 안개 관련 영상의 각 특징 중 매개변수 추정을 통해 얻은 값을 분석하여 서로 관계있는 특징들은 동일한 색상의 선으로 분류하여 나타냈다.

표1~표3은 기본 영상특징으로 feature4(DCP, local entropy, saturation, value)를 사용하고 feature4에 colorfulness, sat*val, local variance를 각각 추가한 feature5로 학습시켰을 때 추정된 매개변수 값을 나타낸 표이다. 머신러닝 학습을 통해 추정되는 매개변수 값을 분석하였을 때 서로 추정된 매개변수의 값에 영향이 큰 것으로 표 1의 colorfulness는 saturation, 표 2의 sat*val는 saturation과 value, 표 3의 local variance는 local entropy와 value로 확인하였다. 8개의 영상특징들 중 추정 된 hue disparity값은 0에 근사한 값이므로 깊이 맵 추정에 영향을 주지 않다고 판단하여 학습데이터에서 제외한다.

본 논문에서는 영상 특징들의 관계에 대한 분석을 통해 8가지의 영상특징 중 saturation, value, local entropy, DCP 4가지를 학습데이터로 선택하여 사용한다. 최적화된 학습데이터는 깊이 맵 추정을 위한 머신러닝 학습에 사용된다.

2.3 깊이 맵 추정 선형 모델

본 논문에서는 개선된 깊이 맵을 구하기 위해 식 (3)의 선형모델을 식 (4)과 같이 변형하여 깊이 맵을 추정한다. 식 (4)에서 θ0, θ1, θ2, θ3, θ4은 선형 모델의 매개변수이고 d(x,y)은 깊이 맵을 나타낸다. v(x,y)은 명도, s(x,y)은 채도, le(x,y)은 local entropy, dcp(x,y)은 DCP, ε(x,y)은 선형모델의 랜덤오차를 의미한다.

| (3) |

| (4) |

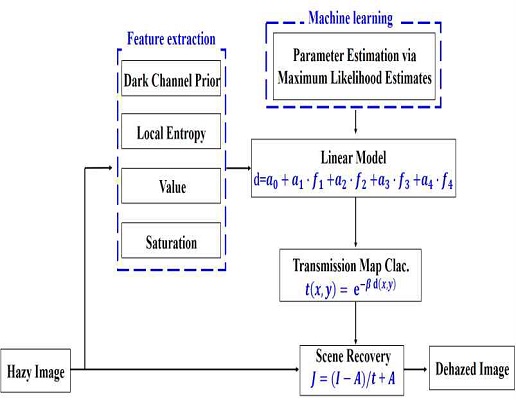

머신러닝 학습을 이용하여 식 (3)의 선형모델에 대한 매개변수를 추정하는 학습을 진행한다. 본 논문에서는 MLE(Maximum likelihood estimates)방법을 이용하여 추정한 매개변수를 이용하여 선형모델에 대한 깊이 맵을 얻을 수 있다. 그림 3은 머신러닝 기반의 안개 제거 과정의 순서도를 나타낸다. 입력 안개 영상을 사용하여 머신러닝 학습데이터인 영상의 특징 추출 하고 MLE방법을 이용하여 선형모델의 매개변수들을 추정하는 학습을 진행한다. 학습을 통해 얻은 매개변수들을 이용하여 깊이 맵을 추정하고 이를 이용하여 안개 전달 량을 계산하여 안개가 제거된 영상을 얻고 알고리즘의 성능 평가를 한다.

Ⅲ. 성능 평가

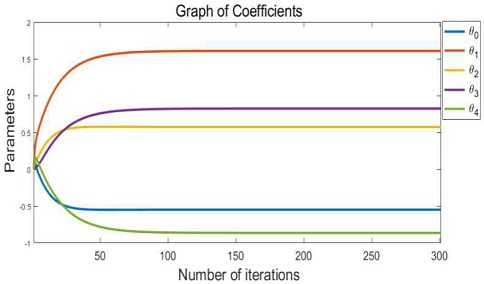

제안하는 방법의 성능검증을 위해 본 논문에서 Zhu의 선형수식을 변형한 선형 모델을 이용하고 우리가 생성한 학습 데이터를 사용하여 머신러닝 학습을 진행한다[7]. 특징에 관한 매개변수들의 초기 값은 모두 0으로 하고, learning rate는 10-8, stop condition은 10-5로 설정하여 학습시킨다. 그림 4는 제안한 선형모델에 대한 매개변수들을 추정하는 그래프를 나타낸다.

성능평가는 대표적인 머신러닝 기반의 안개 제거 알고리즘 Zhu[7], Ngo[8], Lee[9] 논문의 정량적 수치와 비교한다. 성능평가를 위해 real dataset 영상인 I-HAZE(실내 안개 영상)와 O-HAZE(실외 안개 영상)를 테스트 영상으로 사용한다.

표 4는 Zhu[7], Ngo[8], Lee[9]와 제안하는 방법에 대한 I-HAZE 영상의 정량적 수치 결과를 정리하였고, 표 5은 O-HAZE 영상의 정량적 수치 결과를 정리하였다. 평가 기준으로는 안개 제거 알고리즘의 품질 평가에 쓰이는 영상의 구조 유사성(SSIM), 톤 맵핑된 이미지의 품질(TMQI), 특징의 유사성(FSIMc)을 나타내는 지수들을 사용한다. SSIM, TMQI, FSIMc는 값이 클수록 안개영상의 ground-truth영상과 유사하다는 것을 의미한다. 본 논문에서 제안한 선형모델은 기존의 Zhu[7], Ngo[8], Lee[9]의 머신러닝 기반의 안개 제거 알고리즘들과의 정량적 수치 비교에서 우수한 결과를 나타냈다. 그림 5는 입력안개영상, 안개없는영상, 대표적인 머신러닝 기반 방법의 결과영상, 제안한 방법을 통해 얻은 결과 영상을 순서대로 나타냈다. 그림 5를 통해 본 논문에서 제안한 방법을 통해 얻은 결과 영상은 기존의 방법보다 안개가 효과적으로 제거되었고, 안개가 제거된 최종 결과영상의 화질이 개선된 것을 확인할 수 있다.

Ⅳ. 결 론

본 논문에서는 머신러닝 기반의 안개 제거 알고리즘의 성능을 개선하기 위하여 개선된 깊이 맵 추정을 위한 학습데이터를 최적화하는 방법을 제안했다. 영상 특징간의 관계 분석을 통해 최적화된 학습데이터로 saturation, value, local entropy, DCP를 사용하여 깊이 맵에 대한 선형모델의 매개변수들을 머신러닝의 MLE방법으로 학습했다. 제안하는 방법은 대표적인 머신러닝 기반의 안개 제거 알고리즘과의 정량적 수치 평가에서 SSIM, TMQI, FSIMc이 동등 이상인 결과를 통해 안개가 제거된 결과 영상에서 가시성이 개선된 것을 확인했다. I-HAZE영상에 대한 정량적 수치는 대표적인 머신러닝 방법의 평균수치보다 3.15% 개선되었고, O-HAZE영상에 대한 정량적 수치는 5.07% 개선되었다. 정량적 수치평가와 정성적 결과 영상평가를 통해 제안한 방법의 우수한 성능을 증명하였다.

Acknowledgments

This paper was supported by research funds from Dong-A University.

References

-

C. Park and Seok-Cheol Kee, "Implementation of Autonomous Driving System in the Intersection Area Equipped with Traffic Lights", Transactions of Korean Society of Automotive Engineers, Vol. 27, No. 5, pp. 379-387, May. 2019.

[https://doi.org/10.7467/KSAE.2019.27.5.379]

-

J. S. Oh, K. I. Lim, and J. H. K, "A Research of Obstacle Detection and Path Planning for Lane Change of Autonomous Vehicle in Urban Environment", Institute of Control, Robotics and Systems, Vol. 21, No. 2, pp. 115-120, Feb. 2015.

[https://doi.org/10.5302/J.ICROS.2015.14.9006]

-

Ngo. D, Lee. S, Nguyen Q.-H, Ngo. T.M, Lee. G.-D, and Kang. B. "Single Image Haze Removal from Image Enhancement Perspective for Real-Time Vision-Based Systems", Sensors, Vol. 20, Iss. 18, 5170, Sep. 2020.

[https://doi.org/10.3390/s20185170]

-

B. Cai, X. Xu, K. Jia, C. Qing, and D. Tao, "DehazeNet: An End-to-End System for Single Image Haze Removal", IEEE Trans. Image Process, Vol. 25, No. 11, pp. 5187-5198, May. 2016.

[https://doi.org/10.1109/TIP.2016.2598681]

-

K. He, J. Sun, and X. Tang, "Single Image Haze Removal Using Dark Channel Prior", IEEE Trans. Pattern Anal. Mach. Intell, Vol. 33, No. 12, pp. 2341-2353, Dec. 2011.

[https://doi.org/10.1109/TPAMI.2010.168]

-

R. Tan, "Visibility in bad weather from a single image", Proc. IEEE Conf. Computer Vision and Pattern Recognition, Anchorage, AK, USA, pp. 1-8, Jun. 2008.

[https://doi.org/10.1109/CVPR.2008.4587643]

-

Q. Zhu, J. Mai, and L. Shao, "A Fast Single Image Haze Removal Algorithm Using Color Attenuation Prior", IEEE Trans. Image Process, Vol. 24, No. 11, pp. 3522-3533, Nov. 2015.

[https://doi.org/10.1109/TIP.2015.2446191]

-

D. Ngo, G. D. Lee, and B. S. Kang, "Improved color attenuation prior for single-image haze removal", Appl. Sci, Vol. 9, No. 19, pp. 4011, Sep. 2019.

[https://doi.org/10.3390/app9194011]

-

J. H. Lee and B. S. Kang . "Improving Performance of Machine Learning-Based Algorithms with Adaptive Learning Rate", Journal of IKEEE, Vol. 18, No. 10, pp. 9-14, Oct. 2020.

[https://doi.org/10.14801/jkiit.2020.18.10.9]

-

Y. Jiang, C. Sun, Y. Zhao, and L. Yang, "Fog Density Estimation and Image Defogging Based on Surrogate Modeling for Optical Depth", in IEEE Transactions on Image Processing, Vol. 26, No. 7, pp. 3397-3409, Jul. 2017.

[https://doi.org/10.1109/TIP.2017.2700720]

2019년 2월 : 동아대학교 전자공학과(공학사)

2019년 3월~현재 : 동아대학교 전자공학과(공학석사)

관심분야 : 머신러닝/딥러닝, 영상처리

1985 : 연세대학교 전자공학과(공학사)

1987 : 미국 University of Pennsylvania 전기공학과(공학석사)

1990 : 미국 Drexel University 전기 및 컴퓨터공학과(공학박사)

1989 12월 ∼ 1999 2월 : 삼성전자 반도체 수석연구원

1999 3월 ∼ 현재 : 동아대학교 전자공학과 교수

관심분야 : 영상신호처리, SoC설계 및 무선 통신