이미지 특징점 탐지 및 특징량 추출 알고리즘 추천 모델 개발

초록

본 연구에서는 주로 사용되는 SIFT, SURF, ORB, AKAZE 알고리즘을 데이터 세트를 통해 비교 분석하는 실험을 통하여 사용자 요구에 맞는 특징점 검출기를 추천하는 모델을 개발하고 신뢰성을 검증하였다. 이를 위해, 특징점 검출기 추천 모델을 설계하고 모델 검증을 위하여 동일 이미지를 선택하여 추천된 모델과 실제 매칭율을 비교하는 실험을 수행하였다. 이를 통해 최적의 특징점 검출기 계산 산식을 개발하였다. 또한 산식의 신뢰성을 검증하기 위하여 동일 이미지를 선택하여 검출기 별 매칭률을 기반으로 합계값을 비교함으로써 추천 결과와 결과가 일치함을 확인하였다. 본 연구는 사용자가 분석하고자 하는 대상에 적합하고, 사용자가 원하는 도구의 중요한 특성을 반영할 수 있는 보다 정교한 도구 선택의 기회를 제공한다는데 그 의의가 있다.

Abstract

In this study, we compared and analyzed the algorithms of SIFT, SURF, ORB, and AKAZE, which are mainly used. Based on the results of the experiment, we implemented and verified the model to recommended keypoint detection and descriptor extraction algorithm that meets user needs through data sets. To do this, an experiment was conducted in which a recommended model of the keypoint detector was designed, and the same image was selected for model verification, and the recommended model and the actual matching rate were compared. Through this, an optimal point detector calculation formula was developed. In addition, in order to verify the reliability, it was confirmed that the suggested result and each detector's result were identical by selecting the same image and comparing the total value based on the matching rate for each detector. This study is meaningful in that it provides an opportunity for more sophisticated tool selection that is suitable for the object to be analyzed by the user and reflects the important characteristics of the tool desired by the user.

Keywords:

computer vision, keypoint detection, descriptor extraction, image processingⅠ. 서 론

컴퓨터 비전 분야에서 이미지나 영상의 희소 특징 추출의 가장 일반적인 접근 방식은 탐지 후 설명 접근 방식(The detect-then-describe approach)으로 먼저 특징점을 탐지한 후 다음에서 특징 설명자(Descriptor)를 추출하는 것을 의미한다[1]. 특징점은 Keypoint 또는 Feature point로 칭하며 영상이나 이미지 등에서 특징이나 중요한 정보를 포함하고 있는 점의 영상좌표로 (x,y)나 scale space를 포함하는 경우 (x,y,s)를 의미한다. 이 특징점 위치에서 추출한 지역적 영상이나 이미지에 대한 특징 정보는 지역 불변 특징량(Local invariant descriptor)을 의미한다. 희소 일치에서 가장 중요한 것은 강력한 특징점을 찾는 것[1]이다.

이상적인 특징점은 이미지가 회전하거나 크기나 형태가 변하거나 위치가 변하거나 노이즈가 있을 때도[1][2] 강건하게 검출되어야 한다. 또한 카메라의 조명과 시점이 달라져도 쉽게 찾아낼 수 있어야 한다. 이미지 정보에서 특징이 되는 지역적 정보를 점으로 검출하기 위하여 특징점 탐지 및 특징량 검출 알고리즘(Keypoint detection and descriptor extraction algorithm)을 사용한다.

이러한 대부분의 지역 불변 특징량 방법들은 이상적인 특징점을 뽑아 특징량을 계산하기 때문에 알고리즘들 모두 최소한의 고유의 특징점 추출 방법을 포함한다. 그러나 특징점 탐지와 특징량 검출은 명확히 구분되는 기술이므로 특징점 탐지 기법과 특징량 검출 기법은 상이하게 조합하여 활용할 수 있다.

그러나 지역 불변 특징량 방법들은 강한 외관 변화로 인해 탐지가 불안정하며[1] 특징점 탐지 및 검출의 정확도 및 수준에 있어 모든 조건이나 상황에 따라 상이하다. 따라서 사용자의 목적이나 검출하고자 하는 대상의 특징이나 성격에 따라 어떤 알고리즘을 활용하는지에 따라 탐지 및 검출 성능에 차이가 발생한다. 따라서, 모든 알고리즘이 실제 모든 상황에 충분히 강력한가에 대한 논의가 필요하다. 그러나 대부분의 알고리즘에 대한 연구는 각 알고리즘의 성능 평가 지표를 비교하여 어떤 알고리즘이 강력한지에 집중되어 왔다[3][4].

본 연구에서는 이미지 및 영상의 특징점 탐지 및 특징량 검출을 위한 주요 속성을 도출하고 detect-then-describe approach 방법을 기반으로 성능 평가 지표와 실제 특징점 매칭 알고리즘을 통해 상황에 맞는 특징점 탐지 및 특징량 검출 알고리즘을 추천하는 시스템을 설계한다. 이를 위해 이미지 데이터 세트에 다양한 변환을 적용하는 실험을 수행하며, 알고리즘 간 평가를 위하여 특징점 매칭 알고리즘을 개발하고 그 신뢰성을 검증하였다.

본 연구는 사용자가 분석하고자 하고자 하는 대상에 적합하면서도 사용자가 원하는 특징점 참지 및 특징량 추출 도구의 중요한 특성을 반영할 수 있는 보다 정교한 도구 선택의 기회를 제공 보였다.

본 논문의 구성을 다음과 같다. 2장은 관련연구로 특징점 탐지 및 특징량 추출 알고리즘에 대하여 기술하고, 알고리즘 관련 선행 연구를 살펴본다. 3장에서는 연구 절차와 연구 방법을 설명한다. 4장에서는 특징점 검출기 추천 시스템을 설계하고 설계 내용을 기반으로 샘플 데이터 이미지를 생성하고 실험한다. 마지막으로 5장에서는 결론에 대해 기술하고 본 연구의 의의와 향후 연구 방향을 제시한다.

Ⅱ. 관련 연구

2.1 특징점 탐지 및 특징량 추출 알고리즘

여기에서는 본 연구의 실험에서 다루는 전통적인 매칭 파이프라인 기법으로 지역 불변 특징량 검출 알고리즘인 SIFT(Scale Invariant Feature Transform), SURF(Speeded Up Robust Features), KAZE, ORB(Object Request Broker)에 대해 살펴본다.

SIFT는 Lowe에 의해 2004년에 제안되었으며, DoG(Difference of Gaussian)를 기반으로 한다. 스케일 축으로도 코너성이 극대인 지점을 탐색하기 때문에 이미지 스케일에 특히 강건하며 회전과 아핀 변환 등에도 강건한 특징을 보인다[5]. SIFT는 총 4단계로 구성되는데, 먼저 가우시안 커널을 이용하여 스케일 스페이스를 만들고, 두 번째로 스케일 스페이스의 차를 이용하여 극대값을 뽑는다. 세 번째로 후보군으로부터 적합하지 않은 특징점들을 제거한 후 히스토그램을 이용하여 특징점이 가지고 있는 방향을 결정한다[5]. 마지막으로 주변 값들의 방향을 히스토그램을 통해 결정하여 기술자(Descriptor)를 생성한다[5].

SURF는 H. Bay에 의해 2008년에 제안되었다. SIFT를 베이스로 하며, 특징점 추출 과정에서 헤시안 행렬의 행렬식과 적분 이미지를 활용하여 속도의 향상을 보였다[5][6]. 이미지 스케일과 이미지 회전에는 강건하지만 아핀 변환에는 약한 특성을 보이는 대신 SIFT보다 속도적인 측면에서 강점을 가진다[5][6].

KAZE는 P. F. Alcantarilla에 의해 2012년에 제안되었다[7]. SIFT와 동일하게 4단계 구조를 지니며, 이미지 스케일 스페이스를 만들기 위해서 선형 필터를 사용하지 않고 비선형 필터를 사용한다[7]. 비선형 필터를 사용함으로써 노이즈를 제거하고 에지 영역을 좀 더 부각시키는 효과를 제공한다[7]. 한편, P. F. Alcantarilla은 2013년에 KAZE의 성능을 보장하면서 고속화한 AKAZE 알고리즘을 제안하였다[8][9]. KAZE와 마찬가지로 비선형 필터를 사용하며, 비선형 필터를 필터링하기 위해 FED(Fast Explicit Diffusion)라 불리는 효율적인 프레임워크를 사용한다[9]. 서술자를 계산하기 위해 MLDB(Modified Local Difference Binary) 알고리즘을 사용하여 효율을 높였다[9].

2.2 선행연구

본 연구는 성능 비교를 기반으로 하는 활용 모델 제안의 성격을 갖는다. 따라서 본 절에서는 컴퓨터 비전 분야에서 특징점 탐지 및 특징량 검출과 관련한 성능 평가와 활용에 대한 연구를 중심으로 살펴보았다. 먼저 성능 평가와 관련된 연구들을 살펴보면, Karami E et al.[3]은 SIFT, SURF, ORB를 사용하여 왜곡된 이미지에 대해 이미지 매칭 알고리즘을 수행하고 각 특징점 검출 알고리즘의 성능을 비교하는 연구를 통하여 속도적인 측면에서는 ORB가 가장 좋고, SIFT가 이미지 매칭 알고리즘에서 가장 높은 매칭률을 보였음을 밝혔다[3]. Suaib NM 등은 Visual Odometry를 위해 SIFT 및 SURF 특징점 검출 및 특징점 매칭 알고리즘의 성능을 평가하였다[15]. S. Tareen 등은 SIFT, SURF, KAZE, AKAZE, ORB, BRISK의 각 검출기의 성능을 비교하였다[16].

한편, 이러한 특징점 탐지 및 특징량 추출 알고리즘을 적용 및 활용한 다양한 연구들을 살펴보면, 임혜연과 강대성은 컬러 확률 분포에 기반을 두는 Meanshift의 단점을 보완하여 움직이는 객체 추적의 정확성을 높이기 위하여 SIFT 알고리즘을 기반으로 가변적인 탐색 윈도우를 생성하여 추적하는 알고리즘을 제안[17]하였고, SURF 알고리즘을 기반으로 적응적인 탐색 윈도우를 생성하고 객체를 적응적으로 추적하는 검출 기법을 제안[18]하였다.

박찬일과 문승진[19]은 SIFT 알고리즘 기술을 이용하여 모바일 플랫폼 기반에서 클라이언트-서버 구조 형태의 이미지 매칭 시스템을 구현하고 바이오 이미지 객체를 통해 새로운 구현 아키텍처의 정확성과 신뢰성을 검증하였다. 또한 강석천 등[20]은 위성 영상을 위한 위성사진 정합 시스템으로 SIFT를 이용한 특징점 기반의 이미지 정합 시스템을 구현하고, 다른 정합 비교 도구와의 성능을 비교함으로써 다양한 상황에서 활용이 가능함을 검증하였다. 그 외 이승빈과 낭종호[21]는 그래픽 콘텐츠가 객체, 색상, 레이아웃 등에 있어 쉽게 변조됨으로써 지적 재산권 보호를 받는데 한계가 존재하는 문제를 해결하기 위한 방안으로 SIFT를 이용한 근-복사 이미지 검출 시스템을 제안하였다.

본 연구에서는 지금까지 살펴본 선행 연구와 유사한 이미지 매칭을 기반으로 특징점 검출기의 성능을 비교하고, 비교 정보를 바탕으로 사용자의 사용 의도에 맞는 특징점 검출기를 추천하는 시스템을 개발하고 추천 결과의 신뢰성을 검증한다.

Ⅲ. 연구 절차 및 방법

3.1 연구 절차

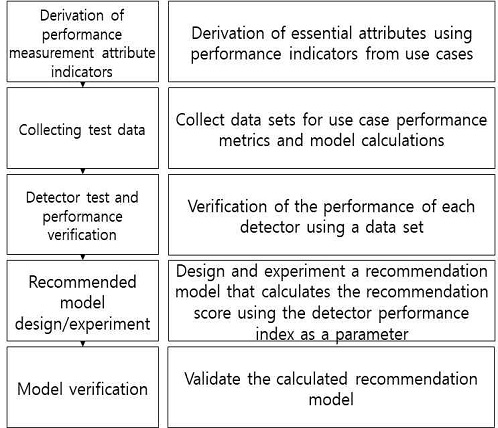

본 연구의 연구 절차는 그림 1과 같다. 먼저 사례 연구들에서 특징점 검출기가 유의미하게 사용되는 사례들을 조사하였다. SLAM과 같은 실제 환경에서 사용되는 특징점 검출기의 경우[22] ORB와 같은 고속의 성능을 보이는 특징점 검출기가 필요함을 보였다. 반대로 속도가 정확도보다 중요시되는 3D 재구성 문제의 경우에는 SIFT와 같은 높은 정확도를 특성으로 가지고 있는 특징점 검출기가 주로 사용되었다[23]. 색상은 이미지 속성을 구별하는데 매우 중요한 특징이다[24].

이들 중 색상을 포함한 해상도의 경우 속도와 정확성에 직접적 영향을 끼치므로 독립적인 속성이라고 생각하기 어렵고, 장비 의존성이 높아 본 연구 성능 지표에서는 제외하였다. 이러한 사전 연구를 반영하여 이미지 특징점 및 특징량 산출을 위한 성능 지표로 속도, 정확도를 선정하여 SIFT, SURF, AKAZE, ORB 검출기를 연구 대상으로 비교하였다.

3.2 연구 방법

본 연구의 성능 지표로 정의한 속도, 정확도 중 특히 정확도의 경우는 이미지의 변형된 형태에 따라 다르게 나타날 수 있다. 따라서 본 추천 시스템 설계 및 실험을 위해 여러 가지 변형된 이미지를 수집하기 위하여 총 9가지의 변환을 만들어 데이터 세트를 형성하였다. 데이터 세트의 정확도 비교는 이미지 매칭 알고리즘을 통하여 진행하였다.

표 1은 데이터 세트의 종류를 나타내고, 표 2는 데이터 세트의 변환 종류를 나타낸다. 표 1에 나타낸 것과 같이 총 67장의 원본이미지를 표 2에 나타난 변환 방법을 활용하여 각 원본 별로 9가지의 변형된 이미지를 9장씩 추가로 생성하여 실제 실험에는 총 670장의 이미지가 활용된다.

데이터 수집 후 실제 검출기 알고리즘을 수행하여 각 데이터로부터 성능을 확인한다. 그 후 확인된 성능으로부터 수준을 정하였다. 검출기 검증을 통해 도출된 수준들로부터 추천 모델을 정하였다. 그 후 완성된 추천 모델을 검증을 통해서 올바른지 확인하였다.

Ⅳ. 특징점 검출기 추천시스템 설계 및 실험

4.1 데이터 세트를 활용한 검출

특징점을 추출하는 속도를 측정하여 픽셀사이즈로 나누어 값을 도출하였다. 표 3은 데이터 세트를 활용하여 실험한 각 검출기의 속도이다. ORB, SURF, AKAZE, SIFT 순으로 고속으로 검출되었다.

데이터 세트 총 670장에 대하여 각 특징점 검출 알고리즘을 수행하여 나온 이미지들을 대상으로 원본 이미지의 특징점과 변환 이미지의 특징점의 유사도를 비교하였다. 이를 통해 특징점이 매칭된 정도를 기반으로 정확도를 측정하였다. 총 9가지 변환 종류에서 자르기와 사이즈 변환의 경우 두 가지로 나뉘어져 있지만 하나로 표현이 가능하기 때문에 정확도 모델은 총 7가지 종류로 사용한다. 표 4는 카테고리 별 평균 일치율을 측정한 결과이다. ORB 검출기의 정확도가 전반적으로 높게 나타난 반면 SURF 검출기의 정확도가 가장 낮게 나타났다. SIFT 검출기의 경우 과일과 사람 데이터에 대해서 가장 높은 정확도를 나타났다.

한편, 표 5와 같이 이미지 변환 정확도를 비교하였다. 부분 추출의 경우 대부분 비슷한 결과를 나타냈고, 크기 변환의 경우 AKAZE가 가장 좋은 성능을 보였다. 왜곡과 회전의 경우 SIFT가 가장 좋은 성능을 보였고, 가우시안 흐림과 모션 흐림, 소금 후추 노이즈의 경우에는 ORB가 가장 좋은 성능을 보였다. 또한 ORB의 경우 이미지 변환별 데이터 및 이미지 카테고리별 데이터에 일정한 경향을 보이는 것으로 대부분의 상황에 대해 강건성이 뛰어남을 알 수 있다.

4.2 특징점 검출기 추천 모델 설계

특징점 검출기를 추천 모델은 크게 사용자의 요구를 입력하는 단계와 이 입력값을 활용하여 추천 모델을 계산하는 과정으로 크게 구분된다.

- ◦ Step 1: 추천 모델 사용자 요구사항 입력

사용자는 변환의 우선순위 정확도 선택 속성을 7가지 중 3가지 선택한다. 즉, 렌즈 왜곡, 가우시안 흐림, 움직임 흐림, 부분 추출, 이미지 회전, 소금 후추 노이즈, 크기 변환 중 높은 정확도를 요구하는 세 개의 항목을 선택한다.

- ◦ Step 2: 최적의 특징점 검출기 도출

사용자 입력으로부터 실험을 통해 도출된 성능값을 기반으로 점수를 계산하여 점수가 가장 높은 검출기를 추천한다. 이 때 추천을 위한 점수는 식 (1)을 통해 계산된다.

| (1) |

- S : 모델 측정 점수

- a : 1순위 정확도, b : 2순위 정확도, c : 3순위 정확도,

- accuracy : 사용자가 응답한 정확도의 중요도(1~5),

- TPP:검출기의 픽셀 당 연산시간(sec),

- speed : 사용자가 응답한 속도의 중요도

즉, 임의로 주요하게 생각하는 정확도를 우선순위 매개변수로 입력하고, 정확도와 속도의 중요도를 입력하여 도출된 결과와 그 결과를 기반으로 특정 이미지에 대해 실제 특징점 검출기를 통해 추천 결과와 같은지를 검증하는 실험을 반복하여 실시하였다. 그 결과 추천의 정확도가 가장 높은 식 (1) 계산식을 도출할 수 있었다. 본 알고리즘은 최적의 알고리즘에 대한 순서를 제공하는 것이 주요 목적이므로, 순위를 명확히 하기 위하여 우선 순위 가중치는 차순위 가중치에 2배의 가중치를 부여하도록 설계하였다.

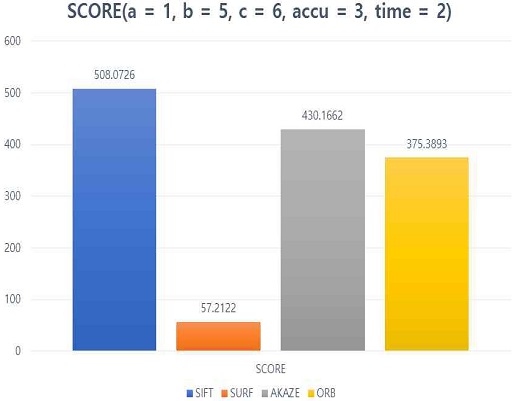

모델 검증 실험을 위하여 특징점 탐지 및 특징량 추출 알고리즘 추천 모델의 설계를 기반으로 프로토타입을 개발하였다. 모델 검증 실험을 위해 임의의 이미지를 선택하고 시제품의 추천 프로그램을 수행하였다. 입력 변수로 정확도와 속도의 중요도, 정확도는 한 단계 더 상세화하여 선호하는 우선순위 변환 기법 세 개를 순위를 입력 하도록 기능을 구현하였다. 검증 실험을 위해 정확성 중요도 가중치를 3, 속도 중요도 가중치를 2로 입력하였다. 또한 변환의 정확도에 대한 우선순위는 1순위 렌즈 왜곡, 2순위 이미지 회전, 3순위는 소금후추 노이즈를 선택하였다. 추천 수행 결과 그림 2와 같이 SIFT가 추천되었다.

다음으로 추천 모델의 신뢰성을 검증하기 위하여, 결과값가 동일하게 SIFT가 최적의 특징점 검출기인지를 확인하기 위한 실험을 수행하였다. 이를 위해 추천 프로그램 실험과 동일한 이미지를 선택하여 추천 모델 수행 시 선택한 변환 종류와 동일하게 SIFT, SURT, AKAZE, ORB 검출기의 렌즈 왜곡, 이미지 회전, 소금 후추 노이즈를 각각 개별적으로 측정하고 검출기 별 합계값을 비교하였다. 합계 값은 검증 이미지에서 시간과 이미지 매칭율을 계산하여 산출하였으며, 그 결과 표 6과 같이 SIFT가 579.98 점수로 가장 적합도가 높게 나타났다.

합계값은 추천 프로그램의 결과값 과는 약간의 차이가 있으나, 검출기는 정확하게 동일함을 확인할 수 있었다. 표 5에서 SURF는 전체 이미지에서 평균적으로 낮은 정확도를 가지고 있지만, 표 6에서 사용한 검증 이미지의 경우 SURF를 사용하였음에도 평균대비 높은 정확도를 보임을 알 수 있다. 이는 랜덤으로 설정되어 생성되는 데이터 세트의 부족으로 특이값에 의한 영향이라 할 수 있다.

Ⅴ. 결론 및 향후 과제

컴퓨터 비전 분야에서 최근 많이 활용되고 있는 특징점 탐지 및 특징량 추출 알고리즘 도구들은 특정 상황에 따라 속도와 정확도의 차이를 보이며 특징점 탐지와 특징량 검출은 성능을 위해 개별적으로 선택되어 질 수 있다. 이러한 점에 착안하여 본 연구에서는 분석 특성에 맞는 특징점 검출기를 추천하는 모델을 개발하였다. 또한 모델의 신뢰성을 검증하기 위하여 추천된 모델과 실제 이미지를 선택하여 실제 매칭율을 비교하여 추천값과 일치함을 보였다.

본 연구는 다수의 특징점 검출기를 대상으로 사용자가 분석하고자 하는 대상에 적합하고, 사용자가 원하는 중요도를 도구 선정의 특성에 반영할 수 있는 보다 정교한 도구 선택의 기회를 제공한다는데 그 의의가 있다.

한편, 본 모델의 정확도를 높이고 특징점 탐지 및 특징량 추출 알고리즘 별 우선순위가 아닌 적합도를 가중치 형태로도 추천하는 형태의 설계를 위해서는 더 다양한 검출기를 대상으로 하여 알고리즘 성능 속성 지표들을 추가하고, 더 많은 데이터 세트를 통한 최적화 실험이 요구된다.

References

-

M. Dusmanu, I. Rocco, T. Pajdla, M. Pollefeys, J. Sivic, A. Torii, and T. Sattler, "D2-net: A trainable CNN for joint description and detection of local features", In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach, CA, USA, pp. 8092-8101, Jun. 2019.

[https://doi.org/10.1109/CVPR.2019.00828]

-

A. S. Mian, M. Bennamoun, and R. Owens, "Keypoint detection and local feature matching for textured 3D face recognition", International Journal of Computer Vision, Vol. 79, No. 1, pp. 1-12, Aug. 2008.

[https://doi.org/10.1007/s11263-007-0085-5]

- E. Karami, S. Prasad, and M. Shehata, "Image matching using SIFT, SURF, BRIEF and ORB: performance comparison for distorted images", arXiv preprint arXiv:1710.02726, , Oct. 2017.

-

D. G. Lowe, "Distinctive image features from scale-invariant keypoints", International Journal of Computer Vision, Vol. 60, No. 2, pp. 91-110, Nov. 2004.

[https://doi.org/10.1023/B:VISI.0000029664.99615.94]

-

H. Bay, A. Ess, T. Tuytelaars, and L. Van Gool, "Speeded-up robust features (SURF)", Computer vision and image understanding, Vol. 110, No. 3, pp. 346-359, Jun. 2008.

[https://doi.org/10.1016/j.cviu.2007.09.014]

-

H. Bay, T. Tuytelaars, and L. Van Gool, "Surf: Speeded up robust features", In European conference on computer vision, Springer, Berlin, Heidelberg, pp. 404–417, May 2006.

[https://doi.org/10.1007/11744023_32]

-

P. F. Alcantarilla, A. Bartoli, and A. J. Davison, "KAZE features", In European Conference on Computer Vision, Springer, Berlin, Heidelberg, pp. 214-227, Oct. 2012.

[https://doi.org/10.1007/978-3-642-33783-3_16]

- P. F. Alcantarilla and T. Solutions, "Fast explicit diffusion for accelerated features in nonlinear scale spaces", IEEE Trans. Patt. Anal. Mach. Intell Vol. 34, No. 7, pp. 1281-1298, Oct. 2011.

-

S. K. Sharma and K. Jain, "Image Stitching using AKAZE Features", Journal of the Indian Society of Remote Sensing, Vol. 48, No. 10, pp. 1389-1401, Oct. 2020.

[https://doi.org/10.1007/s12524-020-01163-y]

- D. G. Viswanathan, "Features from accelerated segment test (fast)", In Proceedings of the 10th workshop on Image Analysis for Multimedia Interactive Services, London, UK, pp. 6-8, May 2009.

-

M. Calonder, V. Lepetit, C. Strecha, and P. Fua, "Brief: Binary robust independent elementary features", In European conference on computer vision, pp. 778-792, Sep. 2010.

[https://doi.org/10.1007/978-3-642-15561-1_56]

-

E. Rublee, V. Rabaud, K. Konolige, and G. Bradski, "ORB: An efficient alternative to SIFT or SURF", In 2011 International conference on computer vision, IEEE, pp. 2564-2571, Nov. 2011.

[https://doi.org/10.1109/ICCV.2011.6126544]

-

R. Mur-Artal and Ju. D. Tardos, "Orb-slam2: An open-source slam system for monocular, stereo, and RGB-d cameras", IEEE Transactions on Robotics, Vol. 33, No. 5, pp. 1255-1262, Oct. 2017.

[https://doi.org/10.1109/TRO.2017.2705103]

-

N. M. Suaib, M. H. Marhaban, M. I. Saripan, and S. A. Ahmad, "Performance evaluation of feature detection and feature matching for stereo visual odometry using SIFT and SURF", In 2014 IEEE REGION 10 SYMPOSIUM, IEEE, pp. 200-203, Apr. 2014.

[https://doi.org/10.1109/TENCONSpring.2014.6863025]

-

S. A. K. Tareen and Z. Saleem, "A comparative analysis of sift, surf, kaze, akaze, orb, and brisk", In 2018 International conference on computing, mathematics and engineering technologies (iCoMET), IEEE, pp. 1-10, Mar. 2018.

[https://doi.org/10.1109/ICOMET.2018.8346440]

- H. Y. Lim and D. S. Kang, "A Study of VSW Algorithm using Feature Points for the Accurate Tracking of Objects", The Journal of Korean Institute of Information Technology, Vol. 9, No. 1, pp. 201-206, Jan. 2011.

- H. Y. Lim and D. S. Kang, "A Study of Enhanced Moving Object Detection Method based on Speeded up Robust Feature Points", The Journal of Korean Institute of Information Technology, Vol. 10, No. 4, pp. 179-184, Apr. 2012.

- C. Park and S. Moon, "The design and implementation of Object-based bioimage matching on a Mobile Device", The Journal of Internet Computing and Services, Vol. 20, No. 6, pp. 1-10, Dec. 2019.

- S. C. Kang, I. Whoang, and K. N. Choi, "A Scheme for Matching Satellite Images Using SIFT", The Journal of Internet Computing and Services, Vol. 10, No. 4, pp. 13-23, Aug. 2009.

-

S. Lee and J. Nang, "A Near-Duplicate Image Detection System for Design Contents Using SIFT", KIISE Transactions on Computing Practices Vol. 25, No. 5, pp. 257-262, May 2019.

[https://doi.org/10.5626/KTCP.2019.25.5.257]

-

R. Mur-Artal, J. M. M. Montiel, and J. D. Tardos, "ORB-SLAM: a versatile and accurate monocular SLAM system", IEEE transactions on robotics, Vol. 31, No. 5, pp. 1147-1163, Aug. 2015.

[https://doi.org/10.1109/TRO.2015.2463671]

-

K. Peng, X. Chen, D. Zhou, and Y. Liu, "3D reconstruction based on SIFT and Harris feature points", In 2009 IEEE International Conference on Robotics and Biomimetics (ROBIO), IEEE, pp. 960-964, Dec. 2009.

[https://doi.org/10.1109/ROBIO.2009.5420735]

-

C. Ancuti and P. Bekaert, "More effective image matching with scale invariant feature transform", In Proceedings of the 23rd Spring Conference on Computer Graphics, pp. 71-78, Apr. 2007.

[https://doi.org/10.1145/2614348.2614359]

- G. WYSZECKI and W. S. Stiles, "Color Science: Concepts and Methods, Quantitative Data and Formulae, 2nd Edition", Wiley-Interscience, Aug. 2000.

2020년 2월 : 한국기술교육대학교 컴퓨터공학과(공학사)

2020년 3월 ~ 현재 : 한국기술교육대학교 컴퓨터공학과(석사과정)

관심분야 : 병렬처리, 이미지 프로세싱, 컴퓨터 비전, 가상증강현실

2008년 2월 : 성균관대학교 정보통신공학부(공학사)

2014년 8월 : KAIST 전산학과(공학박사)

2014년 7월 ~ 2018년 2월 : 한국과학기술정보연구원 선임연구원

2018년 3월 ~ 현재 : 한국기술교육대학교 조교수

관심분야 : 고성능컴퓨팅, 그래픽스/가시화, 인공지능

2003년 : 동국대학교 컴퓨터 멀티미디어공학과(공학사)

2005년 8월 : 연세대학교 산업정보경영(공학석사)

2014년 2월 : 서울과학기술대학교 산업정보시스템(공학박사)

2016년 2월 ~ 현재 : 한국기술교육대학교 조교수

관심분야 : SW 품질공학, SW 공학관리, IT 서비스 최적화, 블록체인, 정보 시스템