철근 사출 궤적 추적을 위한 시작지점 검출 방법

초록

최근 제조 공정을 개선하려는 기업들은 스마트 팩토리를 도입, 이에 따른 도약이 특별히 눈에 띈다. 이는 최소한의 수동 제어를 통해 완벽하게 생산시설의 프로세스를 수행하는 스마트 팩토리의 영역을 최대화하고 추론의 오차를 최소화 하는 것이 최종 목적이다.

본 연구는 무인 생산, 관리, 포장, 배송 관리를 위한 프로젝트의 일부로써 무인생산의 자동화 설비의 철근 추적을 통해 롤러의 자동 교정을 수행하기 위해 철근 추적 시작점 검출에 대한 연구이며, 시작지점부터 끝점까지의 위치를 정확히 추적해야 하는 요구사항을 만족해야 한다. 추적성능을 높이기 위해서는 시작점 설정이 주요한데 기존의 시간 기반 검출방법을 통해서는 조도, 분진 등 환경에 따라 추적오류의 발생 확률이 높다.

본 논문에서는 환경에 따른 오차를 줄이기 위해 고속 IR카메라의 평균 밝기 변화를 이용한 시작점 검출 방법을 제안하며, 제안 사항을 통해 15%이상의 성능 향상을 확인하였다.

Abstract

Companies that want to improve their manufacturing processes have recently introduced the smart factory, which is particularly noticeable. The ultimate goal is to maximize the area of the smart factory that performs the process of the production facility completely with minimal manual control and to minimize errors of reasoning.

This research is a part of a project for unmanned production, management, packaging, and delivery management and the detection of the start point of rebars to perform the automatic calibration of the rollers through the tracking of the automated facilities of unmanned production. It must meet the requirement to accurately track the position from the start point to the end point. In order to improve the tracking performance, it is important to set the accurate start point. However, the probability of tracking errors is high depending on environments such as illumination and dust through the conventional time-based detection method.

In this paper, we propose a starting point detection method using the average brightness change of high speed IR camera to reduce the errors according to the environments, As a result, its performance is improved by more than 15%.

Keywords:

adaptive detection, smart factory, industry automation, object detection, tracking preprocessingⅠ. 서 론

이미 각국은 4차 산업 혁명에 발을 들여놓았다. 지능정보기술은 정보의 혁명에서 한 걸음 더 나아가 A.I., 빅데이터 분석 등 기존 산업에 융합하고 있다. 지능정보기술은 ICT 분야와 같이 표면적으로 보이는 산업을 넘어서 최근에는 제조업과 같은 기저 산업의 패러다임 또한 급격하게 변화시키고 있다. 이는 우리 산업 전반이 지능정보기술에 상당 부분 몰입하고 있음을 뜻한다. 노동력 감소와 3D업종 기피 등의 이유로 생산력 저하가 우려되는 가운데, 제조 공정을 개선하려는 기업들이 스마트 팩토리를 도입함으로써 그 도약이 특별히 눈에 띈다[1].

스마트 팩토리는 최소한의 수동 제어를 통해 완벽하게 생산시설의 프로세스를 수행하는 것을 목표로 한다. 기존 생산과정에서 인력이 필수였던 영역은 기계화로 대체할 수 없는, 사람의 판단이 필요한 부분이었다. 지금 도입하고자 하는 스마트 팩토리는 이 판단을 자동화의 영역에 속하도록 하여 기계화의 판단이 사람 수준의 인지능력을 갖출 수 있도록 하는 것이다. 즉, 스마트 팩토리의 영역을 최대화하고 추론의 오차를 최소화하는 것이 최종 목적이다.

본 연구는 대한제강의 무인 생산 및 관리, 포장, 배송 관리를 위한 스마트 팩토리 프로젝트 ARON SOLUTION의 일부로써 무인 생산에 있어서 자동화 설비의 철근 추적을 통해 롤러의 자동 교정을 수행하기 위해 철근 추적 시작점 검출에 대한 연구이다.

이는 설비로부터 사출되어 절곡된 철근 두 가닥을 로봇 팔이 집어 적재하는 철근의 자동 생산, 적재 과정 중 로봇 팔이 집을 수 없는 위치에 생산된 철근을 사출 롤러의 자동 교정을 통해 로봇 팔이 다시 집을 수 있도록 하는 것을 목표로 한다.

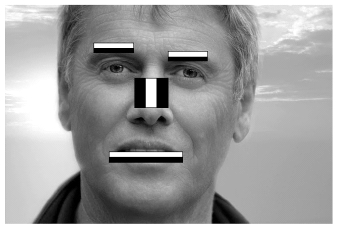

그림 1과 같이 정면에서 본 철근의 위치가 사출구 원점을 기준으로 어느 위치에 존재하는지 2차원 좌표를 인덱싱하고 인덱스에 해당하는 롤러 교정값을 전달하여 롤러 교정을 시도한다. 철근 사출이 1개인 경우에는 최종 지점의 검출만으로도 교정을 수행 할 수 있지만 2개의 철근이 동시에 사출되기 때문에 시작지점부터 끝점까지의 위치를 정확히 추적해야 자동화 설비가 요구하는 교정과정을 수행할 수 있다. 추적의 과정에서 가장 중요한 것은 언제 어떤 공간의 객체를 추적할지 설정하는 것이다[2].

생산시설에서는 환경적인 문제점과 기계적인 문제점을 이유로 추적 가능한 형태의 철근의 상이 무작위로 나타나기 때문에 단순한 시간 정보를 통해서는 추적해야 할 철근의 시작지점을 정확히 판별할 수 없다.

본 논문에서는 위의 문제점을 시간적, 환경적, 기계적 영향을 최소화하는 해결 방안을 제시한다.

Ⅱ. 객체 검출 관련 이론

철근의 영상을 획득하기 위해 절곡 설비 사출구로부터 일정 거리에 떨어진 위치에 카메라를 설치하고, 이를 기반으로 추적 시작점을 검출한다. 객체를 검출하는 방법에는 아래와 같은 방법이 존재한다.

2.1 템플릿 매칭(Templeate Matching)

템플릿 매칭은 참조영상(Reference Image)에서 템플릿(Template) 영상과 매칭되는 위치를 탐색하는 방법이다. 일반적으로 템플릿 매칭은 템플릿 객체의 이동(Translation) 문제는 해결할 수 있는 반면, 회전, 크기변화(Scaling) 객체의 매칭은 어려운 문제이다.

템플릿 매칭에서 영상의 밝기를 그대로 사용할 수도 있고, 엣지, 코너, 푸리에변환 등의 특징 공간으로 변환하여 템플릿 매칭을 수행 할 수 있으며, 영상의 밝기 등에 덜 민감하도록 정규화(Normalize)과정이 필요하다[3].

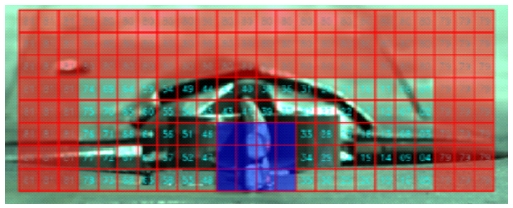

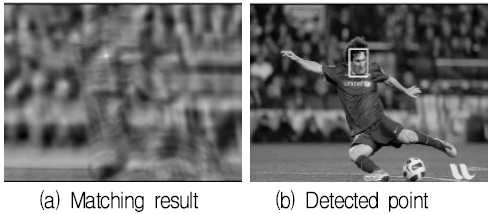

그림 2는 템플릿 매칭 방식의 예이다.

2.2 배경 분리(Background Subtraction)

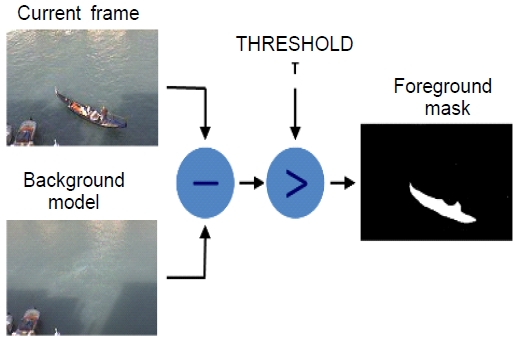

비디오 감시 시스템에서는 카메라의 위치가 고정되어 있기 때문에 영상에서 움직이지 않는 배경부분과 변화가 있는 전경부분으로 분리할 수 있다.

차분 영상 기법, 가우시안 혼합모델 등이 있다[4].

차분 영상 기법은 현재 프레임에서 이전의 다른 한 프레임을 뺀 값을 기반으로 큰 변화가 있는 부분을 전경으로 추출하는 방법이다[5]. 이는 알고리즘 구현이 간단하고 속도가 빨라 실시간 구현에 용이하지만, 실제 환경에서는 정밀도가 높지 않으며 정확한 객체의 검출 판단이 어렵다. 그림 3은 차분 영상으로 배경 분리 결과이다.

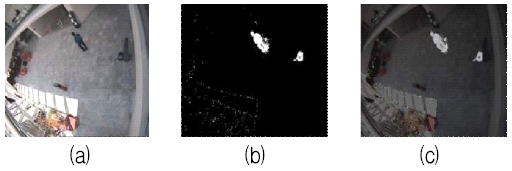

가우시안 혼합모델[6]은 K개의 가우시안 분포 믹스쳐를 배경 픽셀에 적용함으로써 배경과 전경을 분리한다. K값이 3 혹은 5인 가우시안 분포 믹스쳐를 배경 픽셀에 적용하여 배경제거를 수행한다[7].

믹스쳐에 대한 가중치는 배경 제거를 위한 특정 픽셀이 동일한 장소에 머무는 시간 비를 나타낸다.

그림 4는 가우시안 혼합모델을 통한 배경분리 결과이다.

2.3 HAAR 특징점 추출(HAAR Feature Extraction)

HAAR 특징점 추출은 영상의 영역과 영역의 밝기차를 이용한 특징으로서 다양한 형태의 기본 요소들을 조합하여 객체의 특징을 추출한다[8].

HAAR 특징점은 영역 사이의 밝기차를 이용하기 때문에 검출 객체의 특성에 잘 부합하는지 잘 판단해서 적용해야 한다. 영역의 밝기차가 거의 없는 경우에는 그림 5의 특징점을 추출하기가 어려우며, 객체의 형태변화 및 위치 변화를 어느 정도 커버할 수 있는 특성이 있으나, 대비(Contrast)변화, 광원의 방향 변화와 같은 밝기 변화에 영향을 받는다.

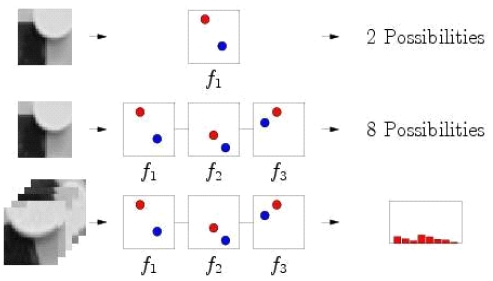

2.4 FERNS

물체 모델 특징 벡터와 입력 특징 벡터들 사이의 매칭에서 생기는 문제를 일종의 분류로 간주하여 추출한 특징점을 기반으로 각각의 특징점을 클래스로 간주하고 입력 특징점 각각을 분류를 수행한다. 이후 그림 6의 방법과 같이 동일 클래스에 포함되는 입력 특징점과 모델 특징점을 비교하여 가장 유사한 특징점을 기반으로 객체 검출을 한다[9].

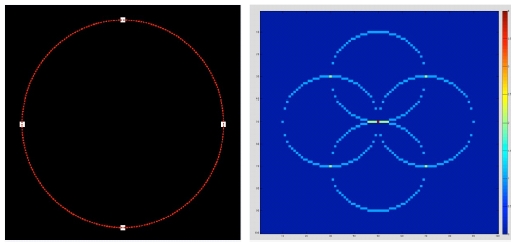

2.5 허프 변환(Hough-Transform) 원 검출

입력 영상을 소벨 미분을 통하여 x방향과 y방향의 국지적 기울기를 구한 후 이 기울기로 부터 엣지의 방향을 구하고, 이 방향을 따라 지정된 최소 거리부터 최대 거리까지의 직선을 그어 해당 직선 위에 있는 점들의 값을 축적 평면에 누적한다.

이와 동시에 엣지 영상에서 0이 아닌 픽셀이 존재하는 위치를 저장하여 2차원 국지 평면에서 국지적 최대값을 찾고, 이 값이 지정된 임계값보다 큰 점은 원 중심의 후보지로 선정한다. 이러한 원 중심 후보들의 축적된 값을 기준으로 내림차순으로 정렬하여 누적된 값이 가장 많은 원의 중심을 선택하여 그림 7과 같이 원을 검출한다[10].

철근의 끝점이 원형이라는 점을 감안하여 원 검출방식을 시도하여 시작지점을 검출하였으나, 커팅 형태에 따라서 완전한 원의 모습을 보이지 않는 경우와 아직 상이 맺히지 않은 경우에 원을 검출하는 경우가 있어 정상적인 추적은 불가능하였다.

Ⅲ. 픽셀 평균값 변화 기반 시작지점 검출

자동화 설비에 접목하기 위해서는 환경적인 요소와 기계적인 요소를 모두 충족해야 하며, 마찬가지로 검출 속도 또한 실시간 처리를 할 수 있을 수준을 요구한다.

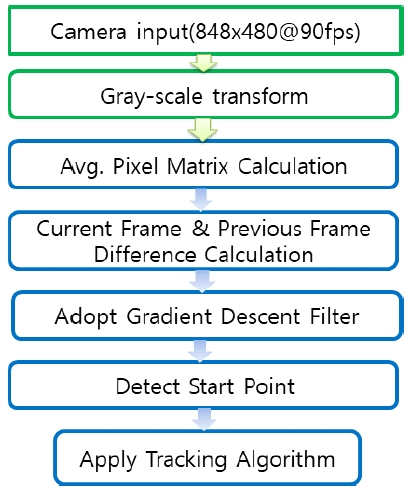

2장에서 제시한 방법들은 객체 검출에 뛰어난 방법이지만 철근 사출 끝점은 조도, 회전, 크기변화에 종속적이지 않아야 하고, 처리속도가 빨라야 하며, 사출구 주변에 큰 이동벡터가 존재하는 등의 환경적 요인이 크게 작용하며, 생산설비의 기계적 영향에 최대한 종속되지 않기 위해 그림 8의 절차를 통해 사출 시작지점을 검출하고자 한다.

이를 이유로 본 항목에서 제안하는 방법은 픽셀 행렬의 평균값의 그레이 스케일 수치 변화를 이용하여 추적 시작 지점을 검출하고자 한다.

| (1) |

(Pavg : 픽셀 행렬의 평균값)

철근 사출 지점에 n*m 크기의 대기 윈도우를 설정하고 픽셀 행렬의 평균값을 확인한다.

끝점은 상대적으로 밝고 다른 부분은 어둡다는 철근의 특성상 대기 윈도우의 픽셀 평균값이 가장 밝은 경우가 추적 시작 지점임을 알 수 있다.

식 (1)을 토대로 현재 프레임과 이전 프레임의 픽셀 행렬의 평균값의 차가 일정 임계값 이상이 되는 지점이 사출을 시작하는 시점이며, 프레임 간 평균값 차이가 0이하가 되는 지점이 대기 윈도우에 철근 끝점 추적 시작점으로 판단할 수 있다.

| (2) |

식 (2)를 통해서 시작 지점을 검출할 수 있으나, 먼지나 진동과 같은 환경 잡음에 따라 시작점이 극소적 지점인지 전역적 지점인지 판별하는 처리가 필요하다.

| (3) |

식 (3)의 수식으로 x프레임 이전의 평균값의 미분을 통해 픽셀의 평균값이 증가 추세인지, 단순 잡음으로 인한 순간 증가인지 판단이 가능하며, 이를 이용하여 사출 지점 및 시작점의 정확한 위치를 판단하는 기준으로 삼을 수 있다.

Ⅳ. 실험 방법 및 결과

실험은 그림 9의 MEP사의 FORMAT 16 HS 스터럽 절곡기의 통해서 진행하였다. 실험에 사용한 카메라는 그림 10의 INTEL RealSense D435 IR 카메라를 이용하여 사출구의 정면에서 사출되는 실시간 영상을 848x480@90fps으로 설정하고 이 영상을 기반으로 시작지점 검출에 대해서 위 제안 방식을 토대로 결과값을 도출하였다.

컬러영상을 쓰지 않고, IR 카메라를 이용한 이유는 철근 사출 속도가 매우 빠르며, 조도의 영향을 최소화하기 위해서 저해상도 그레이 스케일의 고속IR 카메라를 사용하였다[11].

본 실험의 성공률은 사출 영상에서 제안하는 방법으로 도출한 시작지점을 기준으로 5프레임 이상 객체를 추적하는 경우 성공으로 판단한다.

| (4) |

식 (4)의 수식을 통해 성공률을 측정하고, 폐색영역의 중첩 혹은 간섭을 통해 도중에 추적이 실패한 경우는 시험 결과상에서 실패로 간주한다.

기존의 추적 시작점의 검출은 철근 교정신호가 발생 한 후 PLL을 통해 신호 발생 후 시작시간을 검출하고, 이를 토대로 시작점을 지정하였다[12].

기존 방법의 수행 성공률은 표 1과 같다.

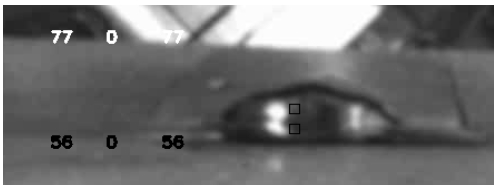

픽셀 평균값 변화를 측정하기 위해 우선 그림 11과 같이 철근 사출 지점에 대기 윈도우를 설정한다. 그림 11에서 표시되는 수치는 왼쪽부터 현재 윈도우의 평균 픽셀값, 이전 평균 픽셀값, 현재-이전 평균 픽셀값 차 순이다.

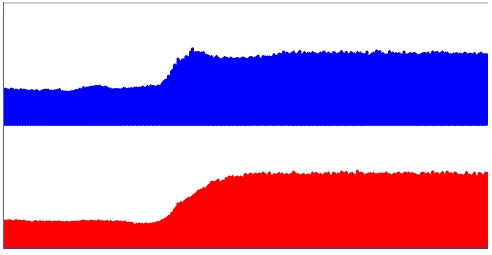

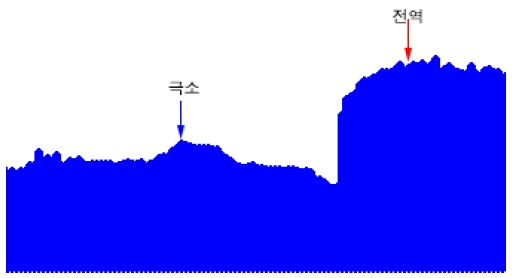

대기 윈도우 상의 평균 픽셀값을 시간 순으로 표시하면 그림 12와 같은 특성을 가진다.

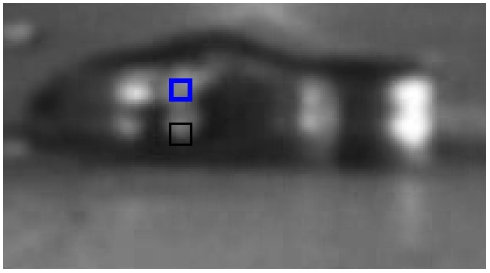

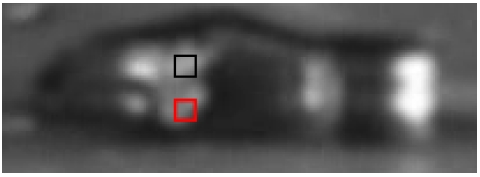

시뮬레이션 결과는 표 2와 같으며, 상단과 하단 사출구의 최대 픽셀값이 다르게 나오며, 이는 상단 철근의 간섭으로 인해 하단 철근의 밝기에 영향을 끼치기 때문이다. 철근 사이의 간섭과 그래프를 기반으로 보면 상단, 하단 사출구에서 추적 시작점 설정 시점이 다름을 알 수 있다.

그림 13과 그림 14에서는 간섭으로 인해 추적 시작점 설정 시점이 다름을 확인 할 수 있다.

위 실험을 기반으로 도출한 사출지점과 시작지점의 임계값은 표 3과 같다.

폐색을 포함한 100회 성공률은 표 4와 같다.

또한 사출 과정에서 진동이나 환경 잡음이 개입할 여지가 있다. 그림 15에서는 진동이나 환경 잡음이 개입하였을 경우의 그래프 파형을 나타낸다. 이러한 경우에는 시작지점이 극소 지점인지 전역 지점인지에 대한 판단을 필요로 한다.

이 경우 현재와 일정 시간 이전의 프레임 사이의 픽셀 밝기 평균값을 미분하고 도출한 기울기를 기반으로 보정하여 정확한 전역지점을 찾아내면 표 5와 같이 조금 더 좋은 결과를 얻을 수 있다.

시작 신호의 시간 기반 검출 방법과 픽셀 평균값의 변화 및 최종 보정을 통한 시작점 검출 방법의 최종 결과는 표 6과 같다.

Ⅴ. 결 론

픽셀 평균값 변화 기반 추적 시작점 검출방법은 기존의 시간 변화를 통한 검출방법에 비해 추적 성공률 면에서 15% 이상의 성능향상을 보여준다.

실험에 사용한 90Hz로 동작하는 고속 프레임 적외선 카메라와 60Hz로 동작하는 조명의 플리커 현상에 따라 그림 16와 같이 시작점 검출에 대한 실패사례가 존재하지만, 예외적으로 임계값을 변형시키는 방식을 통하여 보정이 가능하였다[13].

위 연구 결과를 최신 추적 알고리즘에 접목했을 때 추적 정확도가 눈에 띄게 증가하며, 이는 앞으로 철근 영상추적을 수행할 때 폐색 영역 중첩 처리 기술을 접목하면 실제 필드에서 바로 적용 가능하다는 점에서 유의미하다[14].

본 논문은 철근생산의 시작점을 공간적 시간적 관점에서 가장 적합하게 검출하여 철근의 추적궤적과 끝점의 위치를 정확하게 판단하는 데 초석이 된다. 이를 통해 철근 생산 설비의 롤러를 정확히 교정하고 자동화 장비와 연계하여 실시간으로 현장에 투입하는 것이 추후 연구의 목표이다.

Acknowledgments

이 논문은 2017 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No.2017R1D1A1B04030870)

References

- G. S. Kim, Y. K. Choi, and K. K. Kim, "4th Industrial Revolution and Manufacturing Innovation: Introduction of Smart Factories and Changging Manufacturing Paradigm", Samjong INSIGHT, 55, p2-15, Dec.), (2017.

- F. Yin, "Real Time Imaging Verification and Tracking for Moving Targets", The International Journal of Medical Physics Research and Practice, 42, p3738-3739, Jun.), (2015.

- K. Briechle, and U. D. Hanebeck, "Template matching using fast normalized cross correlation", The International society for Optics and Photonics Optical Pattern Recognition, 4387, p95-102, Mar.), (2001.

- G. Bradski, and A. Kaehler, "Background Substraction", O’Reily Learning OpenCV, p362-368, Sep.), (2009.

- S. W. Lee, T. K. Kim, J. H. Yoo, and J. K. Paik, "Arnormal Behavior Detection Based on Adaptive Background Generation for Intelligent Video Analysis", Journal of the Institute of Electronics and Information Engineers, 48(1), p111-121, Jan.), (2011.

- P. Kaew TraKuPong, and R. Bowden, "An Improved Adaptive Background Mixture Model for Real-time Tracking with Shadow Detection", Advanced Video Based Surveillance Systems, 2nd European Workshop, Sep.), (2001.

- OpenCV Documentation Background Subtraction, https://docs.opencv.org/3.1.0/db/d5c/tutorial_py_bg_subtraction.html [Accessed: Jan. 22. 2019].

-

P. Viola, and M. Jones, "Rapid object detection using a boosted cascade of simple features", IEEE Computer Society Conference on Computer Vision and Pattern Recognition, p511-514, Dec.), (2001.

[https://doi.org/10.1109/cvpr.2001.990517]

-

M. Ozuysal, M. Calonder, V. Lepetit, and P. Fua, "Fast Keypoint Recognition Using Random Ferns", IEEE Transaction on Pattern Analysis and Machine Intelligence, 32, p450-454, Mar.), (2010.

[https://doi.org/10.1109/tpami.2009.23]

- G. Bradski, and A. Kaehler, "Hough circle transform", O’Reily Learning OpenCV, p227-232, Sep.), (2009.

- A. Barsamian, V. H. Berk, and G. Cybenko, "Target Tracking and Localization Using Infrared Video Imagery", SPIE Unattended Ground Sea and Air Sensor Technologies and Applications, 6231, p1-7, May), (2006.

-

D. Xie, D. Zhang, and P. Gao, "Research on phase-locked loop control and its application", IEEE Confference on Information Technology Networking Electronic and Automation Control, p818-821, May), (2016.

[https://doi.org/10.1109/itnec.2016.7560475]

-

W. Kihara, and T. Yendo, "A Communication Method for Asynchronous Visible Light Communication Based Image Sensor", IEEE GLOBECOM Workshop on Optical Wireless Communications, p1-6, Dec.), (2017.

[https://doi.org/10.1109/glocomw.2017.8269145]

-

J. Pan, and B. Hu, "Robust occlusion handling in object tracking", IEEE Conference on Computer Vision Pattern Recognition, p1-8, Jun.), (2007.

[https://doi.org/10.1109/cvpr.2007.383453]

2008년 2월 : 동아대학교 컴퓨터공학과 (공학사)

2018년 9월 ~ 현재 : 동아대학교 전자공학과 석사과정

관심분야 : 영상처리, AI

1994년 5월 : Texas A&M 대학교 전자공학과(공학박사)

1995년 ~ 현재 : 동아대학교 전자공학과 교수

관심분야 : 영상처리, 패턴인식