감정예측을 위한 심박변이도 변수의 상대적 중요도 분석: Valence-Arousal 기반의 인공신경망 관점으로

초록

범주화된 감정예측을 이용한 기존연구는 각 입력 변수가 예측에 기여하는 상대적 중요도를 정확히 파악하기 어렵다. 본 연구는 연속형인 Valence-Arousal 기반의 예측모형을 생성하고, Garson의 알고리즘을 적용하여 감정예측 입력변수에 대한 상대적 중요도를 제시한다. 이를 위해 피험자 50명으로부터 수집한 심박변이도(HRV, Heart Rate Variability) 변수와 인공신경망을 사용하여 감정예측 모형을 생성하였다. 실험결과 다양한 심박변이도 중 Mean RR의 상대 중요도가 35.6%으로서 감정예측에 가장 높은 기여를 하는 것으로 확인되었다. 한편, 주파수 영역 심박변이도 지표인 VLF, LF, HF의 감정예측시 상대적 중요도는 각각 3.2%, 3.6%, 3.0%로 낮은 것으로 확인되었다.

Abstract

Previous emotion prediction methods based on the categorized emotions have shown difficulty in recognizing relative importance of the input variables. This study proposes a new emotion prediction mechanism in which HRV (Heart Rate Variability) metrics and continuous valence-arousal scores are used to formulate the emotion prediction neural network. The Garson’s algorithm was adopted to compute relative importance of input HRV metrics. The physiological data collected from 50 participants was used to obtain that the relative importance of Mean RR is 35.6%, the best among a number of input HRV metrics. Meanwhile. the frequency domain HRV metrics such as VLF, LF, and HF have low relative importance of 3.2%, 3.6%, and 3.0%, respectively.

Keywords:

emotion prediction, heart rate variability (HRV), valence-arousal model, neural network, relative importanceⅠ. 서 론

감정은 학습능력, 인지능력 그리고 순간순간의 의사결정에 영향을 미쳐 인간이 삶을 영위하는데 있어서 매우 중요한 요소이다. 다른 사람의 감정 이해와 감정의 공유는 원활한 의사소통과 업무성과에영향을 미치는 요인이다[1]. 감정은 개인별로 느끼는 것이 다르고 반응하는 것이 다르다. 감정은 개인마다 다양한 차이가 존재하여 판단하기 어렵지만, 감정을 인식하는 것은 매우 중요한 이슈이다[2][3]. 심리학, 인지과학, 공학 등의 다양한 학문분야에서도 인간의 감정예측을 중요 연구 주제로 다루고 있고, 많은 연구자들이 더 나은 감정예측 체계를 만드는 연구에 중점을 맞추고 있다.

감정예측방법은 얼굴 표정, 말, 행동 등을 이용한 방법[4]-[6]과 사람의 심장박동, 뇌파, 피부전도도와 같은 생체신호를 계측하고 신호에서 추출한 특징 정보으로 부터 감정을 인식하는 방법이 있다[7]-[11]. 생리신호 중 심박변이도(HRV, Heart Rate Variability)는 심전도(ECG, Electrocardiogram)로 측정된 심장박동을 기반으로 계산되며, 심장박동의 변화를 나타낸다[12]. 일반적으로 행복, 기쁨 등의 긍정감정을 느끼는 경우 심장 박동이 느려져 심장박동 간격이 커진다. 분노, 공포 등의 부정감정을 느끼는 경우 심장 박동이 빨라져 심장박동의 간격이 짧아진다[13]. 심박변이도는 스트레스와 심리적 안정성의 정도를 잘 나타내는 자율신경계, 즉 교감 신경과 부교감 신경의 활동 양상과 밀접한 관련이 있다[14].

최근 IT기술의 발달로 간편하게 심장박동을 수집할 수 있는 기기들이 속속 개발되고 있으며, 심박변이도를 이용한 감정예측에 대한 활발한 연구가 진행되고 있지만[15]-[17], 기쁨, 슬픔, 놀람과 같은 범주화된 감정을 예측하는 연구가 대부분 수행되어 사람이 가지는 더 다양하고 세분화된 감정을 예측하지 못하는 한계를 가진다. 따라서 보다 세밀하고 유연한 감정 모델인 Valence-Arousal 점수를 예측하는 모형에 대한 연구가 필요하다. 또한, 심박변이도를 사용하는 감정예측에 대한 연구들은 랜덤 포레스트(Random Forest), 인공신경망(Artificial Neural Network), 서포트 벡터 머신(Support Vector Machine) 등의 비선형적인 학습 모형을 주로 적용하여 감정의 예측의 정확도는 높였지만, 다양한 심박변이도중 어떤 지표가 감정예측에 주요한 영향을 미치는지는 제시하지 못하였다.

본 연구는 개인 생리 신호 중 간편하게 수집이 용이한 심장박동을 사용하여 효율적인 개인 감정예측 모형의 제시와 해석을 목적으로 다음과 같은 연구 문제(RQ, Research Question)를 다룬다.

- RQ1. 심박변이도와 인공신경망을 사용해 감정의 2가지 차원인 Valence, Arousal을 동시에 예측하는 모형을 생성한다.

- RQ2. 심박변이도 기반의 감정예측 인공신경망 모형으로부터 감정예측에 상대적 중요한 요인을 분석한다.

Ⅱ. 관련 연구

2.1 심박변이도를 이용한 감정예측 모형

생체신호를 사용한 감정예측 모형은 심박변이도, 호흡주기, 뇌파와 같은 생체신호 변수를 입력으로 하고, 개인이 자기 보고한 감정 상태를 예측하는 모형을 의미한다. 감정예측 모형이 예측하는 감정 상태는 범주화된 감정유형[18]과 차원감정[19]으로 나눌 수 있다. 감정유형(Discrete Emotion)은 행복, 슬픔, 화남, 놀람과 같이 명확한 감정 상태을 나타내기에 용이하다. 그러나 기쁨, 후회와 같은 새로운 감정 유형이나 복합적인 감정 상태를 나타내기는 어렵다. 차원감정(Dimensional Emotion)은 감정의 긍·부정 수준을 의미하는 Valence와 감정이 느껴지는 강도를 의미하는 Arousal의 두 가지 점수로 감정을 나타낸다. 차원감정은 Valence-Arousal 점수로 다양한 감정 유형으로 변환이 가능하지만, 예측하기 어렵다는 단점이 있다[20]. Nicolaou et al.는 사람과 컴퓨터 상의 아바타가 대화하는 상황에서 수집된 얼굴 표정, 어깨 동작과 같은 비언어적 행동으로 Valence-Arousal 점수를 예측하는 인공신경망 모형에 대한 연구를 수행하였다. Lee et al.은 사람의 뇌파를 측정하는 EEG(Electroencephalogram)신호를 사용해 4단계로 구분된 Valence-Arousal 점수를 예측하기 위해 EMD(Empirical Mode Decomposition)와 서포트 벡터 머신을 이용하는 연구를 하였다[11].

심박변이도 중 시간 영역 분석(Time Domain Analysis)의 MeanRR은 심장박동 최고치(R peak) 사이 간격의 평균값으로, 값이 작을수록 간격이 좁다는 것을 의미한다. 따라서 MeanRR 값이 클수록 안정된 상태라고 할 수 있다. SDNN은 심장박동 간격의 표준편차 값으로, 높은 값이 외부 환경 변화에 대한 자율신경계의 적응 능력이 좋아 건강하고 스트레스에 대한 저항력이 뛰어남을 의미한다. RMSSD는 인접한 심장박동 간격 차이의 평균 편차를 나타내는 값으로 스트레스가 높을수록 부교감 신경의 상태를 나타내는 RMSSD가 감소한다[21].

Valence-Arousal 점수와 심장변이도를 사용하는 감정예측에 대한 대부분의 연구의 범주화된 감정유형을 예측하는 것을 목표로 수행되었다. Valence와 Arousal 점수를 각각 “높음”-“중간”-“낮음”의 3단계로 범주화된 차원감정을 예측하는 모형을 만들었다. Swangnetr et al.는 전기 피부 반응(GSR, Galvanic Skin Response)과 2가지 심박변이도를 입력으로 하는 인공신경망 감정예측 모형을 생성했다[22]. Valenza et al.는 서포트 벡터 머신으로 감정예측 모형을 만들어 Valence는 약 80%, Arousal은 83%의 예측 정확도를 달성하였다[23]. 또 다른 연구로 Nardelli et al.은 Valence는 2단계, Arousal은 4단계로 구분하고 2차 판별 분석(QDC, Quadratic Discriminant Classifier)으로 감정을 예측하였다[24].

한편, 본 연구와 유사한 연구를 추가로 더 살펴보자. 우선, 23명의 실험참가자들에게 시각자료를 이용하여 감정자극을 한 후에 심박변이도 변수를 측정하고 이를 토대로 Valence를 출력값으로 하는 감정예측 인공신경망을 구축한 연구가 있다[25]. 특히 해당 연구에서는 감정이 예측되는 과정을 함수를 화이트박스화 하여 제시한 것이 공헌점이다. 또한, 머니게임을 이용하여 25명의 참가자들을 감정을 유도한 후에 이들의 심박변이도 측정치를 토대로 감정을 예측하는 인공신경망을 제시한 연구도 있다[26]. 이러한 기존 연구들과 달리 본 연구에서는 음악을 이용한 청각자극으로 64명의 참가자들에게 감정을 유도하고 Valence와 Arousal을 출력값으로 하는 감정예측 인공신경망을 구축하였다. 그리고 본 연구가 갖는 또 하나의 차별화 포인트는 11개의 심박변이도 입력변수 간 상대적 중요도를 측정하는 방법을 제시한다는 점이다.

Ⅲ. 연구 방법

3.1 연구 대상

본 연구는 서울소재 대학교에 재학 중인 총 64명의 피험자를 대상으로 청각적 감성자극으로 감성을 유발하고 심전도를 측정하여 분석에 사용하였다. 실험에 참가한 피험자는 남성 32명, 여성 32명이고, 연령대는 19~27세로 평균연령은 22.96(SD=2.18)이다. 어떤 실험 참가자도 의학적 병력이나 향정신성 의약품 및 심혈 관계, 호흡기, 중추 신경계에 영향을 줄 수 있는 약물의 복용이 없었다.

3.2 감성 자극

본 연구 실험의 감성자극을 위해 긍정, 부정 감성을 유발하는 청각자극을 개발하였다. 긍정감성 청각자극은 차분하면서도 경쾌한 클래식 음악으로 구성되었다. 부정감성 청각자극은 귀에 거슬리는 환경소음과 슬픈 클래식 음악으로 구성되었다. 긍·부정 청각자극은 각각 6분 가량의 192k BPS의 소리파일로 만들어졌다.

- 긍정감정: 바흐 G선상 아리아, 비발디 사계-봄, 모차르트-두 대의 피아노

- 부정감정: 사이렌 소리, 여자 비명소리, 드릴 소리, 호랑이 소리, 베르디-레퀴엠

만들어진 청각자극은 전문가 검토 및 피험자 10명의 파일럿 테스트로 목표한 감정유발 효과를 검증하였다. 이후 본 연구의 실험에 활용하였다.

3.3 측정 도구

본 연구의 감정 측정은 피험자가 지각한 Valence 와 Arousal의 수준을 자기보고 방식으로 측정하였다. 측정도구는 SAM(Self-Assessment Manikin)을 사용하고[27], 측정 척도는 Valence는 불쾌한 정도에서 기분 좋은 정도를 1에서 9사이의 숫자로 선택하고, Arousal은 평온한 정도에서 흥분되는 정도를 1에서 9사이로 나타내도록 했다.

심전도 데이터 수집을 위해 Einthoven의 표준사지유도법[28]에 따라 양쪽 손목과 왼쪽 발목에 전극을 부착하고 5분간 안정을 취한 뒤 실험을 시작하였다. 표준사지유도에서 유도 Ⅰ은 왼손과 오른손의 전위차, 유도 Ⅱ는 오른손과 왼발의 전위차, 유도 Ⅲ은 왼발과 왼손의 전위차에 의해 기록된다. 심전도 신호는 BIOPAC MP150 하드웨어를 통해 증폭시키고 MP150 A/D 변환기와 AcqKnowledgev 4.1 프로그램을 이용하여 저장하였다. 안정적인 심전도 데이터를 얻기 위해 주파수가 1Hz ~ 35Hz인 밴드 패스필터를 적용하여 노이즈를 제거하였다.

3.4 실험 과정

실험은 그림 1과 같이 외부의 소음이 차단 된 공간에서 수행하였으며, 실험실에는 실험용 장비만 배치 피험자의 집중력을 방해하지 않도록 하였다. 피험자로부터 고품질의 심전도 데이터를 확보하기 위해 실험 참가 전날 피로하지 않도록 하였다. 심전도 센서를 부착 후 신호 왜곡과 노이즈의 발생을 방지하기 위하여 불필요한 얼굴과 몸의 움직임을 제한한 상태에서 실험이 진행 되었다. 실험완료 후 실험 참가자들에게 일정한 금액의 실험 참가비를 지급하였다.

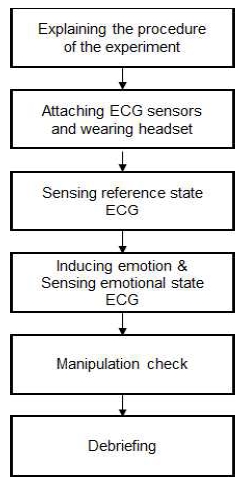

본 연구의 실험 절차는 그림 2와 같으며 구체적인 실험 과정은 다음과 같다.

- ① 실험 설명: 실험 참가자에게 실험에 대한 사전 안내 및 실험 진행 과정에서 필요한 사항을 충분히 숙지시켰다. 이후 피험자의 실험 동의서를 작성받았다.

- ② 심전도 센서 부착 및 헤드폰 착용: 실험 참가자의 양쪽 손목과 왼쪽 발목에 각각 심전도 측정 센서를 부착하였다. 또한, 청각자극을 제시하기 위한 헤드폰을 착용하였다.

- ③ 표준 상태 심전도 측정: 실험 참여자가 21인치 모니터 상에 ‘+’표시가 되어있는 검은색 화면을 바라보며 안정을 취하는 상태에서 5분간 표준 상태의 심전도를 측정하였다.

- ④ 감정 상태 심전도 측정: 실험참가자에 따라 부정적/긍정적 소리 파일을 5분간 청취하여 감정을 유발하고, 감정 상태의 심전도를 측정하였다.

- ⑤ 감정 유발 확인: 감정 자극 직후 유발된 감정의 정도를 SAM으로 Valence와 Arousal을 측정하였다.

- ⑥ 사후 설명: 실험이 종료된 후 실험의 목적과 자극물에 대한 사후 설명(Debriefing)을 하였다.

전체 64명의 피험자 중에서 실험도중 심전도센서가 떨어진 8명과 감정유도가 충분히 되지 않은 6명의 데이터를 제외하였다. 최종적으로 50명(긍정 26명, 부정 24명)의 심전도 데이터 샘플을 획득하였고, 이를 감정예측 모형의 학습데이터로 사용하였다.

3.5 데이터 처리

실험으로 수집된 심전도 데이터에서 감정유발 전의 표준상태 및 감정유발 상태의 심장박동 간격(RR Interval) 데이터를 추출하여 각각 text파일 형태로 저장하였다. 이를 Kubios[29]를 사용하여 심박변이도를 계산하였다. 시간 영역 지표는 mean RR, SDNN, RMSSD를 추출하였다. 주파수 영역 지표는 VLF(ms2), LF(ms2), HF(ms2), Total Power, LF/HF(ms2)와 VLF(%), LF(%), HF(%)를 추출하였다. 총 11가지 표준 및 감정 상태의 심박변이도를 추출하였다. 감정유발에 따른 생체신호 변동을 파악하기 위하여, 다음과 같이 표준상태와 감정상태의 심박변이도의 변동비를 계산하였다[20].

| (1) |

3.6 감정예측 모형 생성

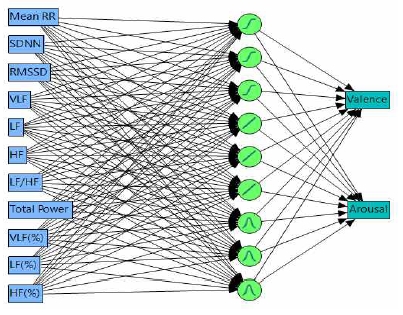

감정예측 모형을 개발하기 위해 11가지 심박변이도 변동비를 입력으로 하고, Valence와 Arousal을 출력으로 하는 인공신경망 모형을 생성하였다. 인공신경망은 인간의 두뇌의 기본 구조 조직인 뉴런과 뉴런이 연결되어 일을 처리하는 것을 모방하여 수학적으로 모형화 한 것이다[30]. 인공신경망은 회귀분석과 달리 변수간의 엄격한 통계적 가정을 요구하지 않고, 학습성과 추론성이 뛰어난 특징이 있다.

인공신경망의 은닉층의 최적의 노드를 찾기 위해 은닉노드 수는 Kolmogrov정의[31]에 따라 1~2n+1(n: 입력노드의 수)개 사이로 설정하여 최적 노드 수를 찾고, 최종 은닉노드 수를 9개로 설정하였다. 본 연구에서 생성된 감정예측 인공신경망 모형은 그림 3과 같다.

입력변수인 심박변이도와 출력변수인 Valence-Arousal 점수 간에 복잡하고 비선형적인 관계를 모형화 하도록 비선형 2가지, 선형 1가지의 전이함수의 조합으로 은닉층을 설계하였다. 은닉노드의 전이함수는 하이퍼탄젠트(노드1~3), 선형(노드4~6), 가우시안(노드7~9)을 각각 3개 씩 설정하였다.

또한 인공신경망의 출력노드에 여러 개의 출력변수를 넣을 수 있는 특성을 활용하였다. 하나의 감정예측 모형에서 Valence와 Arousal이 동시에 예측이 되도록 출력 변수로 Valence와 Arousal를 넣었다. 모형의 과적합 방지 및 타성성을 확보하도록 10 Fold 교차 타당도 방식으로 모형을 학습시켰다.

Ⅳ. 연구 결과 및 분석

표 1에서와 같이 본 연구에서 생성한 감정예측 모형의 설명력(R2)은 Valence가 91.4%, Arousal은 90.3%로 나왔다. 그리고 평균 제곱근 오차(RMSE)는 Valence가 0.505, Arousal은 0.363로 나타났다.

감정예측 모형의 출력변수는 정수로 측정된 Valence, Arousal 점수이지만 모형의 예측값은 실수로 산출되어 모형의 정확도의 산정이 어렵다. 따라서 감정예측값이 실제 Valence, Arousal 점수의 –1과 +1사이에 있을 때(예: 실제 Valence가 6점일 때, 예측값이 5와 7사이에 있는 경우), 예측값이 정분류되었다고 가정하고 정확도를 산출하였다. 표 2와 같이, Valence의 정확도는 80%이고 Arousal의 정확도는 84%로 나왔다. 이 같은 결과는 Valence와 Arousal을 기반으로 감정을 예측할 때 일반적으로 Arousal의 정확도가 더 높은 기존연구 결과와 일치한다[32].

일반적으로 인공신경망 모형은 블랙박스로 되어 생성된 모형의 내부구조에 대해서는 파악하기 어렵고 모형을 해석하기 어렵다고 알려져 있다[30]. 본 연구는 감정예측 인공신경망 모형의 입력 변수로 사용된 11개의 심박변이도 변수의 상대적 중요도를 계산하고자 한다. 이를 위하여 Garson 알고리즘[33]을 적용하고자 한다. Garson 알고리즘은 따라 인공신경망의 입력, 은닉, 출력노드의 가중치를 사용하여 입력변수의 상대 중요도를 계산한다. 입력 i가 출력 o에 대한 기여도를 계산하는 Garson 알고리즘은 다음 식과 같다.

| (2) |

이 식에서 ninputs은 입력노드의 수, nhidden은 은닉노드의 수, noutputs은 출력노드의 수이다. wjl는 입력노드 i와 은닉노드 j간의 가중치이고, woj는 은닉노드 j와 출력노드 o간의 가중치이다. 상대 중요도 계산 결과는 표 3과 같다. 전체적으로 시간영역 지표의 상대 중요도 합은 71.6%이고, 주파수 영역 지표의 합은 28.4%으로 시간영역 지표가 감정예측에 더 크게 영향을 미치는 것으로 나타났다. 시간영역 지표들의 상대 중요도는 최소 15.6%에서 최대 35.6%로 주파수 영역 지표들(최소 2.1%에서 최대 4.8%)에 비해서 상대적으로 높게 나타났다. Mean RR의 상대 중요도가 35.6%으로 가장 높고, SDNN과 RMSSD가 각각 20.4%, 15.6%인 것으로 확인되었다. 시간 영역 지표들에 비해 주파수 영역 지표들의 영향력은 상대적으로 적어 VLF, LF, HF의 상대 중요도가 3.2%, 3.6%, 3.0%로 감정예측 모형에서 총 9.8%의 영향력이 있는 것으로 나타났다. 다만, LF/HF(4.2%)와 Total Power(3.4%)까지 반영하는 경우 주파수 영역 지표들의 상대 중요도 합은 15.9%로 증가하게 된다. 또한, 주파수 영역 지표들의 총합(Total Power)의 비중을 나타내는 변수인 VLF(%), LF(%), HF(%)의 변동비가 감정예측에 각각 4.1%, 3.6%, 4.8%이고 총 12.5%의 영향을 미치는 것으로 나타나 정확한 감정예측을 위해서는 중요하게 고려할 변수인 것이 확인 되었다.

Ⅴ. 결론 및 향후 과제

본 연구는 효과적인 개인 감정예측을 목표로 한다. 감정유발 전·후의 심장박동 데이터와 인공신경망을 이용한 감정예측 모형을 생성하였다. 내부가 복잡하게 연결된 인공신경망 감정예측 모형에서 심박변이도 변수들이 감정예측에 미치는 영향을 파악하였다. 본 연구를 통해 개발된 감정예측 모형의 적합도는 Valence 91.4%, Arousal 90.3%로 나타났고, 감정예측 성능은 Valence 80%, Arousal 84%를 나타내었다. 또한, 개인 감정예측에 중요한 심박변이도 변수는 Mean RR, SDNN, RMSSD이 선정되었다. 이 3가지 변수의 감정예측 영향은 71.6%인 것으로 나타나, 감정예측에 시간 영역 지표를 사용하는 것이 더 효과적인 것을 확인하였다. 주파수 영역 지표들 중에는 VLF(%), LF(%), HF(%)의 변동비가 감정예측에 각각 4.1%, 3.6%, 4.8%의 영향을 나타냈다. 이 변수들이 감정예측에 총 12.5%의 영향을 미치고 있어 감정예측 모형에 중요하게 고려할 주파수 영역변수로 선정이 되었다.

연구의 성과로는 첫째, 심박변이도와 인공신경망을 사용해 감정의 2가지 차원인 Valence-Arousal 점수를 동시에 예측하는 모형을 생성한다. 본 연구의 감정예측 결과는 Valence와 Arousal 두 축의 점수로 산출된다. 이전의 범주화된 감정예측에 대한 연구들은 엄정한 감정예측 정확도를 판정할 수는 있다. 하지만, 기본 감정 이외의 다양한 감정 유형에 대한 인식과 개인의 특성에 따른 맞춤형 감정예측에 대해서는 유연한 대처가 어렵다. 또한, 본 연구에서 제시한 감정예측 모형은 단일 모형으로 Valence-Arousal 점수를 예측하여 인간의 감정 발현에 더 가깝다. 본 연구의 결과는 감정예측 모형이 산출한 Valence-Arousal 점수를 사용하여 세분화된 감정 유형으로 변환이 가능하다. 또한, 예측된 Valence-Arousal 점수에 개인 특성을 반영해서 개인에 따라 다르게 느껴지는 감정 유형을 인식하는데 활용 할 수 있다.

둘째, 인공신경망 감정예측 모형에 대한 입력 변수들의 상대 중요도를 통해 감정예측에 미치는 영향력을 파악하였다. 감정의 인식은 주변적 상황과 개인의 특성들로 인해 생체신호의 값을 직접 사용해서는 일관된 감정예측결과를 얻기가 힘들다[35]. 이전의 연구들은 정확도 높은 감정예측 모형에 초점을 두고 수행되었다. 그러한 결과로 복잡하고 다양한 생체신호들을 사용한 감정예측 모형에 대한 연구를 하였고, 입력 변수들의 중요도에 기반한 선별이 어려웠다. 본 연구에서 밝힌 감정예측 모형의 변수 중요도를 사용하여 생체신호의 선택이나 최적화된 감정예측 모형을 개발하는데 활용한다면, 보다 효과적이고 높은 성능의 모형이 만들어질 것이다.

본 연구는 Valence-Arousal 점수를 예측하는 모델을 형성하여 분석하였는데, 감정을 긍정과 부정으로 나누어 예측 모델을 각각 만들어 분석한 후 이들을 서로 비교 분석한다면 더욱 유의미한 결과 도출 가능할 것이다. 또한, 이번 연구에서 사용되지 않은 추가적인 심박변이도 변수에 대한 연구가 필요하다. 본 연구에서 사용하지 않은 시간 영역 지표인 Mean HR, NN50, pNN50, HRV triangular index 등과 주파수 영역 지표에서 웨이블렛(Wavelet) 변환을 통한 지표들을 사용하여 다양한 지표들에 대한 효과와 영향력에 대한 연구가 필요하다.

Acknowledgments

이 논문은 2017년도 정부(미래창조과학부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임. (No. 2017R1A2B4010956)

References

-

R. W. Picard, "Affective computing: challenges", International Journal of Human-Computer Studies, 59(1), p55-64, Jul), (2003.

[https://doi.org/10.1016/s1071-5819(03)00052-1]

- C. Maaoui, and A. Pruski, "Emotion recognition through physiological signals for human-machine communication", Cutting Edge Robotics, p317-333, Sep), (2010.

- J. S. Park, and Y. H. Seo, "Acoustic Informationbased Emotion Recognition for Human-Robot Interaction,", The Journal of Korean Institute of Information Technology, 9(6), p39-46, Jun), (2011.

-

E. C. Nook, K. A. Lindquist, and J. Zaki, "A new look at emotion perception: Concepts speed and shape facial emotion recognition", Emotion, 15(5), p569-578, Oct), (2015.

[https://doi.org/10.1037/a0039166]

-

C. N. Anagnostopoulos, T. Iliou, and I. Giannoukos, "Features and classifiers for emotion recognition from speech: a survey from 2000 to 2011", Artificial Intelligence Review, 43(2), p155-177, Feb), (2015.

[https://doi.org/10.1007/s10462-012-9368-5]

- M. Soleymani, S. Asghari-Esfeden, Y. Fu, and M. Pantic, "Analysis of EEG signals and facial expressions for continuous emotion detection", IEEE Transactions on Affective Computing, 7(1), p17-28, May), (2016.

-

C. D. Katsis, N. S. Katertsidis, and D. I. Fotiadis, "An integrated system based on physiological signals for the assessment of affective states in patients with anxiety disorders", Biomedical Signal Processing and Control, 6(3), p261-268, Jul), (2011.

[https://doi.org/10.1016/j.bspc.2010.12.001]

-

F. A. Russo, N. N. Vempala, and G. M. Sandstrom, "Predicting musically induced emotions from physiological inputs: Linear and neural network models", Frontiers in Psychology, 4(468), Aug), (2013.

[https://doi.org/10.3389/fpsyg.2013.00468]

-

P. A. Kragel, and K. S. LaBar, "Multivariate pattern classification reveals autonomic and experiential representations of discrete emotions", Emotion, 13(4), p681-690, Aug), (2013.

[https://doi.org/10.1037/a0031820]

-

J. Selvaraj, M. Murugappan, K. Wan, and S. Yaacob, "Classification of emotional states from electrocardiogram signals: a non-linear approach based on hurst", Biomedical engineering online, 12(44), May), (2013.

[https://doi.org/10.1186/1475-925x-12-44]

-

D. Lee, and and S. G. Lee, "The EEG Signal Based Emotion Recognition Using the EMD", The Journal of Korean Institute of Information Technology, 12(6), p47-53, Jun), (2014.

[https://doi.org/10.14801/kiitr.2014.12.6.47]

- M. J. Song, M. Y. Kim, I. S. Sim, and W. S. Kim, "Evaluation of Horticultural Therapy on the Emotional Improvement of Depressed Patients by Using Heart Rate Variability", Korean Journal of Horticultural Science & Technology, 28(6), p1066-1071, Dec), (2010.

-

N. Ravaja, "Contributions of psychophysiology to media research: Review and recommendations", Media Psychology, 6(2), p193-235, Dec), (2004.

[https://doi.org/10.1207/s1532785xmep0602_4]

-

M. S. Kim, Y. N. Kim, and Y. C. Cho, "Electrocardiographic characteristics of significant factors of detected atrial fibrillation using WEMS", Journal of the Korea Industrial Information Systems Research, 20(6), p37-46, Dec), (2015.

[https://doi.org/10.9723/jksiis.2015.20.6.037]

-

S. N. Yu, and S. F. Chen, "Emotion state identification based on heart rate variability and genetic algorithm", 2015 37th IEEE Conference on Engineering in Medicine and Biology Society (EMBC), p538-541, Aug), (2015.

[https://doi.org/10.1109/embc.2015.7318418]

-

R. Rakshit, V. R. Reddy, and P. Deshpande, "Emotion detection and recognition using HRV features derived from photoplethysmogram signals", In Proceedings of the 2nd workshop on Emotion Representations and Modelling for Companion Systems, Tokyo, Japan, Nov), (2016.

[https://doi.org/10.1145/3009960.3009962]

-

H. W. Guo, Y. S. Huang, C. H. Lin, J. C. Chien, K. Haraikawa, and J. S. Shieh, "Heart Rate Variability Signal Features for Emotion Recognition by Using Principal Component Analysis and Support Vectors Machine", IEEE 16th International Conference on Bioinformatics and Bioengineering (BIBE), Taichung, Taiwan, p274-277, Oct), (2016.

[https://doi.org/10.1109/bibe.2016.40]

-

P. Ekman, W. V. Friesen, M. O'Sullivan, A. Chan, I. Diacoyanni-Tarlatzis, K. Heider, and K. Scherer, "Universals and cultural differences in the judgments of facial expressions of emotion", Journal of personality and social psychology, 53(4), p712-717, Dec), (1987.

[https://doi.org/10.1037//0022-3514.53.4.712]

-

J. A. Russell, "A circumplex model of affect", Journal of Personality and Social Psychology, 39, p1161-1178, Dec), (1980.

[https://doi.org/10.1037/h0077714]

-

J. Kim, and E. Andre, "Emotion recognition based on physiological changes in music listening", IEEE transactions on pattern analysis and machine intelligence, 30(12), p2067-2083, Feb), (2008.

[https://doi.org/10.1109/tpami.2008.26]

-

T. G. M. Vrijkotte, L. J. P. van Doornen, and E. J. C. de Geus, "Effects of Work Stress on Ambulatory Blood Pressure, Heart Rate, and Heart Rate Variability", Hypertension, 35, p880-886, Apr), (2000.

[https://doi.org/10.1161/01.hyp.35.4.880]

-

M. Swangnetr, and D. B. Kaber, "Emotional state classification in patient-robot interaction using wavelet analysis and statistics-based feature selection", IEEE Transactions on Human-Machine Systems, 43(1), p63-75, Sep), (2013.

[https://doi.org/10.1109/tsmca.2012.2210408]

- G. Valenza, L. Citi, A. Lanata, E. P. Scilingo, and R. Barbieri, "Revealing real-time emotional responses: a personalized assessment based on heartbeat dynamics", Scientific reports, 4(4998), p1-13, May), (2014.

-

M. Nardelli, G. Valenza, A. Greco, A. Lanata, and E. P. Scilingo, "Recognizing emotions induced by affective sounds through heart rate variability", IEEE Transactions on Affective Computing, 6(4), p385-394, May), (2015.

[https://doi.org/10.1109/taffc.2015.2432810]

- S. S. Park, and K. C. Lee, "Emotion prediction neural network to understand how emotion is predicted by using heart rate variability measurements", Journal of The Korea Society of Computer and Information, 22(7), p75-82, Jul), (2017.

- S. S. Park, and K. C. Lee, "Convergence Implementing Emotion Prediction Neural Network Based on Heart Rate Variability (HRV)", Under review in Journal of The Korea Convergence Society, Mar), (2018.

-

M. M. Bradley, and P. J. Lang, "Measuring emotion: the self-assessment manikin and the semantic differential", Journal of behavior therapy and experimental psychiatry, 25(1), p49-59, Mar), (1994.

[https://doi.org/10.1016/0005-7916(94)90063-9]

- U. R. Acharya, K. P. Joseph, N. Kannathal, C. M. Lim, and J. S. Suri, "Heart rate variability: a review", Medical and biological engineering and computing, 44(12), p1031-1051, Dec), (2006.

-

M. P. Tarvainen, J. P. Niskanen, J. A. Lipponen, P. O. Ranta-Aho, and P. A. Karjalainen, "Kubios HRV - heart rate variability analysis software", Computer methods and programs in biomedicine, 113(1), p210-220, Jan), (2014.

[https://doi.org/10.1016/j.cmpb.2013.07.024]

- C. M. Bishop, "Neural Networks for Pattern Recognition", Oxford university press, p77-111, Dec), (1995.

- R. Hecht-Nielsen, "Theory of the Back Propagation Neural Network", In Proceeding of the International Joint Conference on Neural Networks(IJCNN), New York, p593-605, Dec), (1989.

-

A. Haag, S. Goronzy, P. Schaich, and J. Williams, "Emotion recognition using bio-sensors: First steps towards an automatic system", In Tutorial and research workshop on affective dialogue systems, Springer Berlin Heidelberg, p36-48, Jun), (2004.

[https://doi.org/10.1007/978-3-540-24842-2_4]

- G. D. Garson, "Interpreting neural-network connection weights", AI Expert, 6, p47-51, Apr), (1991.

2010년 : 성균관대학교 경영대학원 (경영학석사)

2010년 ~ 현재 : 성균관대학교 경영대 박사과정

관심분야 : 인공지능, 빅데이터, 감성분석 등

1984년 : 카이스트 경영과학과 (공학석사-의사결정지원)

1988년 : 카이스트 경영과학과 (공학박사-인공지능)

1988년 ~ 1990년 : 보람투자자문 (주)

1990년 ~ 1995년 : 경기대학교 경영정보학과 교수

1995년 ~ 현재 : 성균관대학교 경영대학 및 삼성융합 의과학원 (SAIHST) 융합의과학과 교수

관심분야 : 창의성과학, 인공지능, 헬스 인포매틱스, 빅데이터 분석, 감성분석 등