2차사고 방지를 위한 차량 간 커뮤니케이션 시스템 구현

초록

본 논문에서는 클라우드 환경을 기반으로 YOLO와 GPS를 활용하여 차량에서 2차사고 방지를 위한 차량 간 커뮤니케이션 시스템을 구현한다. 사고가 발생하면 클라이언트는 YOLO를 통해 사고를 인식하고, 영상 데이터를 클라우드 서버로 전송한다. 서버에서는 사고 발생 지점의 GPS 좌표를 기반으로 가입된 각 클라이언트들의 거리를 계산한다. 그리고 사고 지점과 가까운 클라이언트들을 그룹화하고, 해당 그룹원들에게만 사고 데이터를 공유한다. 이와 같이 본 논문에서는 영상 인식, GPS, Cloud Server, IoT 네트워킹 등의 기술과 새롭게 제안하는 그룹화기법을 종합적으로 활용하여 이론적으로 연구된 기술들을 실제 차량에 적용할 수 있는 시스템을 구현한다.

Abstract

In this paper, we implement a vehicle-to-vehicle communication system to reduce secondary accidents in vehicles using YOLO and GPS based on a cloud environment. When an accident occurs, the client recognizes the accident through YOLO and transmits the event video data related to the accident to the cloud server. The server calculates the distance of each subscribed client based on the GPS coordinates from the accident location. In addition, clients close to the accident point are grouped, and the accident data is shared within the same group members. In this way, this paper implements a system that can apply the theoretically researched technologies to actual vehicles by comprehensively utilizing technologies such as image recognition, GPS, Cloud Server and IoT networking, as well as the newly proposed grouping technique.

Keywords:

grouping, cloud server, object detection, YOLO, GPSⅠ. 서 론

이동 수단과 통신시스템의 발달로 언제 어디서든 각종 데이터들을 실시간으로 주고받는 것이 가능해졌다. 최근에는 자율주행에 관련된 차세대 차량 시스템이 각광받고 있으며 테슬라, 엔비디아 등과 같은 기업에서 활발히 연구되고 있다. 현재에는 차선유지, 직진 등의 간단한 동작은 이미 상용화되고 있고, 자동주차와 차선이동, 주행과 같은 기술들도 지속적으로 연구되고 있다[1]. 자율주행에서는 차선, 환경, 교통정보, 영상인식 등 다양한 데이터들이 클라우드 서버를 통하여 송수신 및 분석 된다. 현재에는 이러한 분석과정은 머신러닝을 통해 이루어지기 때문에 이러한 폭발적인 데이터들을 효율적으로 송수신하는 기술들도 개발되고 있다.

대표적인 통신 표준으로 개발되고 있는 기술은 V2X가 있다. 현재 우리나라뿐만 아니라 미국이나 EU 등 선진국들이 6G와 V2X 기술 개발에 몰두함으로써 자율주행 기술 개발에 힘쓰고 있다. C-V2X는 V2X의 3GPP 표준화 규격이며 1초에 10회씩 BSM(Basic Safety Message)을 전송한다[2]. BSM은 시간, 위도, 경도, 고도, 속도, 방향 등 기본적인 차량 안전에 필요한 정보를 포함한다.

본 연구에서는 이러한 BSM과 유사하게 위도, 경도와 같은 정보는 GPS로 수집하고, 추가적으로 블랙박스를 이용하여 영상데이터를 수집하였다. 영상정보는 BSM의 정보에 비해 크기가 매우 큰 데이터이기 때문에 서버, 클라이언트 통신 간 트래픽이 높아져 중요한 정보의 송수신이 늦어질 가능성이 있다. 이러한 문제를 해결하기 위해 그룹화 방법을 고안하였다. 그룹화 방법은 거리, 도로구간과 같은 특정 조건을 만족하는 사용자에게만 데이터를 공유한다[3]. 이 방법은 모바일 상에서 기지국이나 서버가 인증된 사용자에게 데이터 전송하는 방법처럼 선별적으로 데이터를 전송할 수 있다.

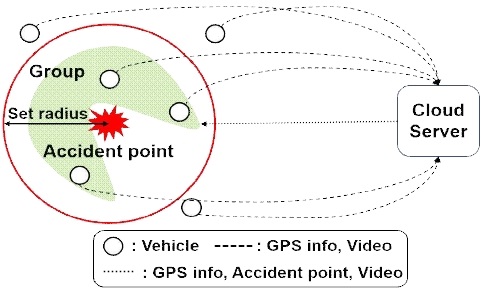

그룹화는 사고가 발생한 차량의 위치와 반경, 도로구간 등의 정보들을 기준으로 그룹을 형성한다. 클라우드 서버에서는 사고 차량에서 수집한 데이터를 분석하여 그룹화된 동일 그룹원들에게 데이터를 공유한다. 이러한 그룹화는 자율주행에서 데이터를 전송할 클라이언트 선별에 도움을 주며 그룹 간 정보를 공유함으로써 2차적인 사고를 방지할 수 있다[4].

예를 들어 건물에 가려져서 앞선 사고를 인식하지 못하고 발생하는 연쇄적인 교통사고나 안개나 자연재해로 인한 운전자의 인식 저하 문제는 그룹화와 클라우드 서버를 이용하면 사고 정보를 주변 차량들과 공유할 수 있어 2차적인 사고를 방지할 수 있다.

본 연구에서는 차량에서 수집된 블랙박스 영상들로부터 사고의 유무를 판별하기 위해 CNN (Convolutional Neural Network)기반 영상인식 기술을 사용한다[5]. CNN은 다양한 방면에서 연구되고 있는데, 모바일을 타겟으로 개발된 MobileNet, Google에서 개발한 Inception 알고리즘이 있다[6][7]. Object Detection에 특화된 알고리즘으로 YOLO(You Only Look Oncce), DoTA(Detection of Traffic Anomaly)등이 개발되어 있다[8]-[10]. CNN의 성능을 개선한 모델로는 VGGNet(Visual Geometry Group Net), AlexNet, ResNet(Residual neural network) 등이 대표적이다[11]-[13]. 이러한 머신 러닝 기법의 활용은 정확하고 빠른 영상 인식, 효율적인 도로 상황 파악, 유지보수 및 사고 예방을 가능하게 한다.

실제 자율주행과 차세대 차량 시스템의 이론적인 부분들은 많은 논문과 연구가 존재하지만 이를 활용하여 실제로 구현한 시스템은 흔하지 않다. 따라서 본 논문을 통해 여러 기술을 통합하여 자율주행에 효율적인 통신 시스템을 구현한다. 본 논문의 구성은 다음과 같다. 2장은 그룹화, 네트워킹과 같은 전반적인 시스템 개요에 대하여 기술한다. 3장은 2장에서는 YOLO를 활용한 자세한 모델구조 및 수행결과에 대하여 설명하고, 4장에서는 차량 간 커뮤니케이션을 위한 그룹화 방법에 대하여 기술한다. 5장에서는 1~4장에서 구성한 시스템을 바탕으로 도출한 결과에 대하여 설명한다. 마지막으로 6장에서는 향후 연구 계획 및 개선방향과 활용 방법에 대하여 기술한다.

Ⅱ. 시스템 개요

그림 1은 본 논문에서 제안하는 그룹화 구성도이다. 클라우드 서버와 다수의 클라이언트가 연결되어 있으며, 서로간의 양방향 통신이 가능하다. 평소 클라이언트는 자신의 GPS정보를 주기적으로 클라우드 서버로 전송한다. 클라이언트는 영상 정보를 지속적으로 수집하고 수집한 영상을 YOLO v3모델을 적용하여 사고를 인식하고 영상으로 수집한다. 이 데이터는 클라우드 서버로 전송된다. 클라우드 서버는 사고 데이터가 전달되면 해당 클라이언트의 GPS좌표 정보를 기반으로 같은 도로구간 내의 클라이언트들을 동일 그룹으로 묶는다. 이후 서버는 사고 데이터를 같은 그룹 내의 다른 클라이언트로 전송하여, 정보를 공유한다.

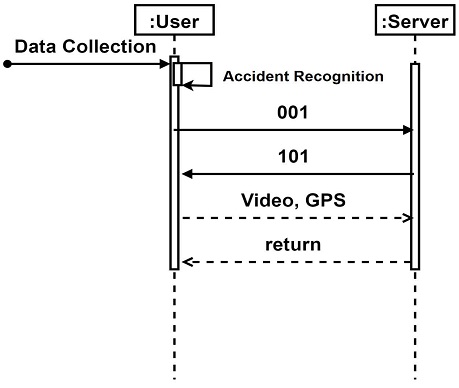

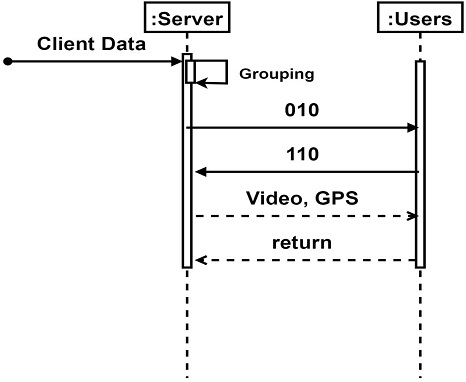

표 1은 서버와 클라이언트 간 통신에서 사용되는 Request와 Acknowledgement를 나타낸 것이다. Request는 데이터 통신을 위한 요청을 보내는 것이고 Ack는 통신 완료 및 수신 준비완료 및 송신 준비완료와 같은 요청에 대한 응답이다.

본 연구에서는 Request 신호와 Acknowledgement 신호를 구별하기 위해 Request 신호는 0으로 시작하며, Acknowledgement 신호는 1로 시작하도록 구성하였다. Request “001”은 이벤트가 발생한 클라이언트에서 영상 데이터와 GPS 좌표를 송신하기 위해 서버에게 수신을 대기하도록 요청을 하는 것이다. Request “010”은 서버에서 클라이언트 그룹으로 분석된 데이터를 전송하기 위해 클라이언트에 데이터 수신을 대기하도록 요청을 하는 것이다.

Acknowledgement “101”은 Request”001”을 받고 클라이언트에 수신 대기상태가 되었음을 알려주는 것이다. Acknowledgement “110”은 Request”010”을 받고 클라이언트에 수신 대기상태가 되었음을 알려주는 것이다.

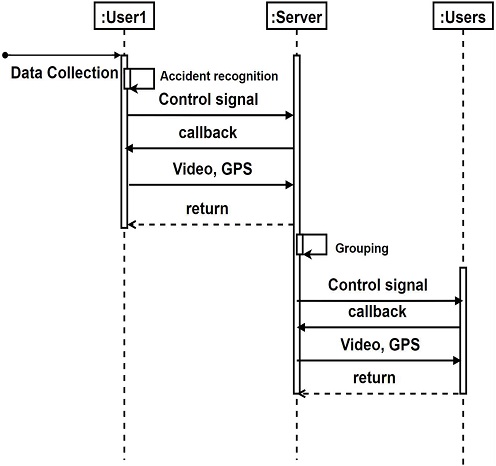

그림 2는 서버가 클라이언트로부터 전송된 데이터를 수신하는 과정을 나타낸 시퀀스 다이어그램이다. 클라이언트가 블랙박스를 통해 수집한 영상을 분석하여 사고의 발생 여부를 판단하고, 사고가 발생했을 경우 클라이언트는 서버에게 Request로 “001”을 보낸다. 이후 서버는 클라이언트로부터 Request로 “001”을 수신 받고 영상 및 GPS정보 수신 가능한 상태이면 Ack로 “101”을 송신한다.

그림 3은 서버에서 클라이언트 그룹으로 영상 및 GPS정보를 송신하는 과정을 설명한 시퀀스 다이어그램이다. 서버에서 사고 데이터가 수집되면 사고지점 인근 클라이언트들을 동일한 그룹으로 묶고 그룹 내의 각 클라이언트로 Request “010”를 보낸다. 클라이언트에서 자료를 수신할 준비가 되었다면 Ack “110”를 수신받고 서버에서 데이터를 송신한다.

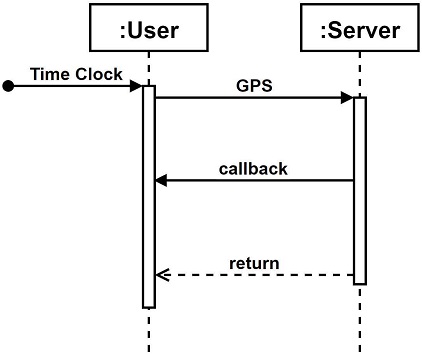

그림 4는 클라이언트에서 GPS 정보를 서버로 보내는 과정을 나타낸 시퀀스 다이어그램이다. 클라이언트는 주기적으로 GPS 좌표 정보를 서버로 전송한다. 서버는 이 좌표 정보를 기반으로 사고 발생 시 인접 클라이언트간의 거리, 도로 구간 정보 등을 판별할 수 있게 되고, 이를 통해 그룹핑을 수행할 수 있다.

그림 5는 전체적인 통신 시스템을 나타내는 시퀸스 다이어그램이다. 이러한 통신 시스템을 구성하는 목적은 1차사고에 대한 예방에 초점을 두기보다는 2차사고를 중점으로 연구하여 앞선 차량에서 사고가 발생했을 경우 주변차량들은 사고가 발생한 차량에 대한 위치와 사고 영상을 서버로부터 전달받고 사고 발생지점을 피해가도록 도움을 주는 것이다. 쓰레딩 TCP 서버를 사용하여 클라이언트의 동시 접속이 가능하도록 구성하였으며, 동시다발적으로 클라이언트에서 서버로 서버에서 클라이언트로 데이터 송수신이 이루어진다. 사고 발생 클라이언트는 그림 2과 같은 시퀀스형태로 통신을 수행하며, 서버는 이러한 데이터를 수집하고 가공한 후 그림 3의 시퀀스 형태로 다른 클라이언트들에게 정보를 전달한다.

Ⅲ. 그룹화를 위한 YOLO v3 객체 인식

본 논문에서는 사고 영상 인식을 위해 YOLO를 활용한다. YOLO를 활용하는 이유는 간단한 처리과정 때문에 기존 객체 인식 모델보다 속도가 빠른편이며 일반화된 객체 학습이 가능하여 자연 이미지로 학습하고 이를 다른 그림에 테스트해도 비교적 높은 성능을 가지고 있다[14][15]. 따라서 차량과 같은 빠른 처리속도를 요구하는 환경에서 YOLO 모델은 다른 모델에 비해 효과적이라 판단하였다. 본 논문에서는 기본적으로 YOLO의 구조를 그대로 사용하고, GoogleLeNet[16]의 초반 20 Layer를 추가하여 특징 추출기로 사용한다. 또한, Convolution Layer 4회, Fully connected layer 2회 후 7×7×30의 형태로 reshape한다. 추출된 7×7×30 크기의 특징 데이터는 바운딩 박스와 클래스 정보를 담고 있다. YOLO의 처리과정은 입력이미지가 네트워크를 통과하면 2개의 데이터를 얻는다. 이 2개의 데이터는 바운딩 박스, 클래스 정보이다. 이후 영상을 그리드로 나눈다. 예를 들어, 100×100의 영상을 10×10의 그리드로 나눈다면 총 100개의 그리드 셀로 나눌 수 있고 각 셀이 3개의 바운딩 박스를 가진다면 해당 셀에 3개의 바운딩 박스가 예측된다. 또한, 각 그리드 셀은Confidence score를 예측하는데 사용된다. 이때 Confidence score는 해당 바운딩 박스에 object가 존재하는 확률이다. 이후 Threshold 값보다 작은 Confidence Score를 가지는 바운딩 박스를 제거한다. 그리고 NMS(non-maximal suppression) 알고리즘을 이용하여 각 object마다 하나의 바운딩 박스를 가지도록 선별한다. 그리고 각 그리드 셀은 해당 영역에서 제안한 바운딩 박스 안의 object가 어떤 클래스인지 컬러로 표현한다. 본 논문에서는 500개의 작업데이터를 사용하였고 이 데이터를 8:2 비율로 학습과 테스트에 사용하였다.

그림 6은 사고 발생 장면이 촬영된 블랙박스 영상에 YOLO v3를 적용하여 사고 발생 영상을 인식하는 모습이다. 사고 발생 차량을 바운딩 박스를 통해 표시하는 모습이다. 실험 결과 50~60%의 정확도를 보이는 것을 확인했다. 학습 데이터는 YouTube 등 다양한 영상 플렛폼을 통해 수집한 영상을 프레임 단위로 전처리를 통해 이미지로 변환하여 구성한 YOLO 모델의 입력으로 사용하였다. 학습 데이터는 500개의 데이터를 사용하였다.

Ⅳ. 네트워크 그룹핑

그림 7은 본 논문에서 사용된 GPS 모듈인 NEO-6M이다. 이 모듈은 UART 통신과 시리얼 통신을 사용하여 GPS 정보를 수집하는 센서이다. 본 연구에서는 GPS 수집을 위해 라즈베리파이에 위 모듈을 장착하여 GPS 정보를 수집하였다.

수집된 GPS 정보들은 시간, 위도, 경도, 고도, 속력 등의 정보와 각 정보의 오차범위와 같은 데이터들을 포함하고 있다. 서버는 이와 같은 지리적 데이터들을 클라이언트로부터 수신하여 위도와 경도를 기준으로 GPS 모듈을 장착한 클라이언트의 위치를 파악할 수 있다. 본 논문에서는 GPS를 통한 클라이언트의 위치를 파악하는 것은 그룹화를 수행하는데 중요한 역할을 한다. 서버에서 그룹화를 위해 각 클라이언트의 위도, 경도 좌표를 이용하여 두 클라이언트 간의 거리 d를 다음과 같이 구한다[17].

| (1) |

| (2) |

식 (2)의 ∅i와 λi는 각 차량의 위도와 경도를 나타내고 식 (1)의 r은 지구의 반지름을 나타낸다. 차량 간 거리를 계산하여 10Km 기준으로 그룹화를 진행한다. 이렇게 그룹이 형성되면 그룹 내에서는 일어난 사고들을 공유할 수 있고, 앞서 발생한 사고에 대하여 인지할 수 있다.

Ⅴ. 시뮬레이션 및 시각화

전체적인 코드는 python 2.7을 이용하였으며 SocketServer, cv2, Watchdog 등의 패키지를 사용한다. SocketServer는 소켓 통신을 위한 패키지이고 cv2는 데이터의 시각화 및 가공을 위한 패키지이다. 또한, 클라이언트에서 주기적으로 데이터가 생성되었는지 확인하기 위해 Watchdog 패키지를 사용하였다.

본 논문에서 제안하는 그룹화는 데이터를 선별적으로 보냄으로써 불필요한 통신을 줄이고 트래픽을 감소시키는 역할을 한다. 하지만 서버에서 그룹화를 수행하는데 상당한 시간이 소요된다면 문제가 발생할 수 있으므로 이에 대한 시뮬레이션이 필요하다.

하지만 그룹화는 본 논문에서 제안된 기술이므로 기준이 되는 수행시간이 존재하지 않아 임의로 최대 수행시간을 설정하고, 시뮬레이션을 수행하였다.

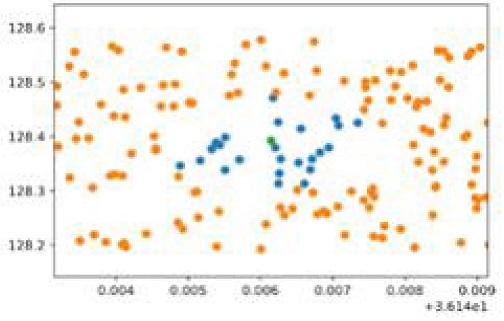

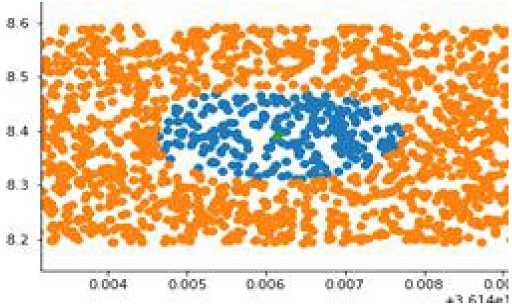

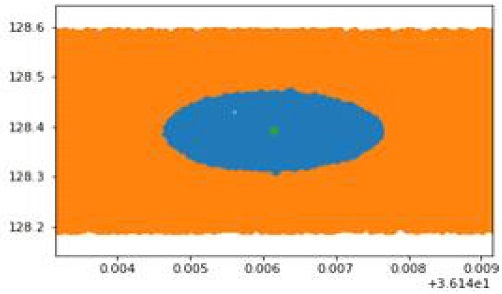

그림 8, 9, 10 클라이언트 개수에 따른 그룹화 시뮬레이션 결과이다. 본 논문에서 통신을 위한 클라이언트들은 라즈베리파이를 이용하였지만 실제 환경에서 더 많은 클라이언트들로 그룹화를 수행하는 과정이 필요하여 임의로 많은 수의 클라이언트들을 생성하고 그룹화를 수행하였다. 수행 결과는 그림 8, 9, 10에서 확인할 수 있으며, 사고 지점 및 사고 목격 지점은 녹색으로 표시하였다. 또한, 사고 지점으로부터의 10Km 반경을 기준으로 파란색으로 그룹화하였다.

그룹화를 수행하지 않을 경우 전체 클라이언트에게 데이터를 보냄으로써 불필요한 데이터 전송이 발생한다. 하지만 그룹화를 수행하면 필요한 클라이언트에게만 데이터를 전송하므로 통신 트래픽을 줄일 수 있다. 표 2에서 각 클라이언트 개수에 따른 그룹화 수행 시간도 확인할 수 있다.

본 논문에서는 임의로 1초를 최대 수행시간으로 설정하였다. 1초 이상의 수행 시간일 경우 처리속도가 느려 실제 교통 환경에서는 활용하기 어렵다고 판단하였다. 10,000개의 클라이언트들을 그룹화하는데 0,0466초가 소요되었으며, 100,000개에서는 0.452초가 소요되었다. 1,000,000개에서는 총 4.081초가 소요되어 100,000개 까지는 1초 이하의 수행 시간을 가지는 것을 확인 할 수 있다. 하지만 이 처리 시간은 처리하는 하드웨어 성능에 따라 달라질 수 있다.

그림 11은 실제 차량 내에서 사용될 상황을 가정하여 차량 운행 중 운전자에게 시각적으로 정보를 제공할 수 있도록 투명 LCD를 이용한 실험 결과이다. 그림과 같이 사고차량이나 사고차량을 목격한 근처 차량으로부터 수집된 데이터가 클라우드 서버를 통하여 수집 및 가공되고 이를 그룹 내에 차량에게 그림 11와 같은 형태로 전달한다. 운전자는 이를 통하여 운전 중에도 주변 교통상황을 손쉽게 확인할 수 있다.

그림 11의 UI 구성은 사고 지점의 영상을 전달하고 사고 지점의 위치를 Google API를 통해 시각적으로 전달한다. 추가적으로 영상 아래 부분에 사고 지점의 도로명이나 지번 주소를 텍스트형태로 출력하도록 구성하였다.

Ⅵ. 결론 및 향후 연구 방향

클라우드와 네트워크 기술의 발달로 모바일 뿐만아니라 차량 간의 데이터 수집 및 공유가 활발하게 일어나고 있으며, 이러한 기술의 발전으로 많은 양의 교통 데이터를 효율적으로 송수신하기 위한 다양한 기술들이 제안되고 있다.

본 논문에서는 클라우드 서버, 객체인식, 그룹화, GPS 등의 기술들을 종합적으로 사용하여 차량 간 효율적 데이터 공유 시스템을 구현하였다. 클라우드 환경에서 모바일 기기 간 소켓 통신을 구성하고 제안한 그룹화를 통하여 데이터 수집과 전송을 용이하도록 시스템을 구성하였다. 서버에서는 모바일에서 수집된 정보들을 취합하고 YOLO와 GoogleLeNet을 결합한 특징 추출기를 사용하여 차량에서의 사고 영상을 인식하였다. 또한, 시뮬레이션을 통해 그룹화를 수행하는데 소요되는 시간을 측정하여 실제 차량 환경에서 그룹화 기법의 적용 가능성을 확인하였으며, 최종적으로 시각화를 통해 데이터 가독성을 높여 운전자들에게 더 신속하게 판단을 내릴 수 있게 하였다.

이는 실제 자율주행에서 데이터 공유와 시각화 활용 방법 구성에도 기여할 수 있을 것으로 예상된다. 향후에는 지속적인 학습을 통하여 YOLO의 성능을 향상시키거나 DoTA와 같은 다른 객체인식 알고리즘을 적용하여 수행할 예정이다. 또한, 본 논문에서는 단순히 거리를 기준으로 그룹화를 수행하였지만 추후 도로구간, 지역 등의 정보들을 추가하여 그룹화를 수행할 예정이다.

Acknowledgments

“이 연구는 금오공과대학교 학술연구비로 지원되었음(2019104014)”

References

- Yeonsik Kang and Kyungjae Ahn, "Road Environment Modeling and Perception Technology Trend for Urban Automated Driving", Journal of the Korean Society of Automotive Engineers, Vol. 42, No. 4, pp. 27-31, Apr. 2020.

- 3GPP TS 22.185 "Service requirements for V2X services", V16.0.0, Jul. 2019.

-

Sung-Hwa Lim, "Secure Broadcasting Delivering Information Only to Authenticated Clients in Mobile Environment", Journal of the Korea Entertainment Industry Association, Vol. 10, No. 1, pp. 313-321, Feb. 2016.

[https://doi.org/10.21184/jkeia.2016.02.10.1.313]

- Young-Joon Song, "Method for cooperating between smart devices and cloud server thereof", US patent, No. 9,848,404 B2, Dec. 2017.

-

Y. LeCun, B. Boser, J. S. Denker, D. Henderson, R. E. Howard, W. Hubbard, and L. D. Jackel, "Backpropagation applied to handwritten zip code recognition", Neural Computation, Vol. 1, No. 4, pp. 541–551, Jan. 1989.

[https://doi.org/10.1162/neco.1989.1.4.541]

- Andrew G. Howard, Menglong Zhu, Bo Chen, Dmitry Kalenichenko, Weijun Wang, Tobias Weyand, Marco Andreetto, and Hartwig Adam, "MobileNets: Efficient Convolutional Neural Networks for Mobile Vision Applications", arXiv:1704.04861, , Apr. 2017.

-

Christian Szegedy, Vincent Vanhoucke, Sergey Ioffe, Jonathon Shlens, and Zbigniew Wojna, "Rethinking the Inception Architecture for Computer Vision", arXiv:1512.00567, , Dec. 2015.

[https://doi.org/10.1109/CVPR.2016.308]

-

Joseph Redmon, Santosh Divval, Ross Girshick, and Ali Farhadi, "You Only Look Once: Unified, Real-Time Object Detection", arXiv:1506.02640, , May 2016.

[https://doi.org/10.1109/CVPR.2016.91]

-

Yu Yao1, Mingze Xu, Yuchen Wang, David J. Crandall, and Ella M. Atkins1, "Unsupervised Traffic Accident Detection in First-Person Videos", arXiv:1903.00618, , Jul. 2019.

[https://doi.org/10.1109/IROS40897.2019.8967556]

- Alexey Bochkovskiy, Chien Yao Wang, and Hog Yuan Mark Liao, "YOLOv4: Optimal Speed and Accuracy of Object Detection", arXiv:2004.10934v1, , Apr. 2020.

- Karen Simonyan and Andrew Zisserman, "Very Deep Convolutional Networks for Large-Scale Image Recognition", arXiv:1409.1556v6, , Apr. 2015.

-

A. Krizhevsky, I. Sutskever, and G. Hinton, "ImageNet classification with deep convolutional neural networks", Communications of the ACM, Vol.60, Issue 6, pp.84-90, Jun. 2017.

[https://doi.org/10.1145/3065386]

- Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun, "Deep Residual Learning for Image Recognition", IEEE CVPR, pp. 770-778, Dec. 2015.

- https://ctkim.tistory.com/91, . [accessed: Jun. 1. 2020]

-

Jae Jung Kim and Chang Bok Kim, "Implementation of Robust License Plate Recognition System using YOLO and CNN", The Journal of Korean Institute of Information Technology, Vol. 19, No. 4, pp. 1-9, Apr. 2021.

[https://doi.org/10.14801/jkiit.2021.19.4.1]

-

Hendrick, C. M. Wang, Aripriharta, C. G Jhe, P. C. Tsu, and G. J. Jong, "The Halal Logo Classification by Using NVIDIA DIGITS", IEEE ICAITI, pp. 162-165, Apr. 2018.

[https://doi.org/10.1109/ICAITI.2018.8686730]

-

T. Monawar, S. B. Mahmud, and A. Hira, "Anti-theft vehicle tracking and regaining system with automatic police notifying using Haversine formula", IEEE ICAEE, pp. 775-779, Jan. 2017.

[https://doi.org/10.1109/ICAEE.2017.8255459]

2016년 2월 : 금오공과대학교 컴퓨터공학과 공학사

2019년 2월 : 금오공과대학교 전자공학과 공학석사

2019년 3월 ~ 현재 : 금오공과대학교 전자공학과 공학박사 과정 재학

관심분야 : 머신러닝, 채널코딩

2018년 8월 : 금오공과대학교 컴퓨터공학과 공학사

2018년 9월: 금오공과대학교 전자공학과 공학석사

2020년 3월 ~ 현재 : 금오공과대학교 전자공학과 공학박사 과정 재학

관심분야 : 머신러닝, 채널코딩

2020년 2월 : 금오공과대학교 컴퓨터소프트웨어공학과 공학사

2020년 3월 ~ 현재 : 금오공과대학교 전자공학과 공학석사 과정 재학

관심분야 : 머신러닝, 채널코딩

2020년 8월 : 금오공과대학교 컴퓨터공학과(공학사)

2020년 9월 ~ 현재 : 금오공과대학교 컴퓨터공학과 대학원(석사과정)

관심분야 : 영상분석, 딥러닝

1987년 2월 : 한양대학교 전자통신공학과 공학사

1994년 2월 : 한양대학교 전자통신공학과 공학석사

1999년 2월 : 한양대학교 전자통신공학과 공학박사

1994년 10월 ~ 2002년 2월 : LG전자 책임연구원

2002년 3월 ~ 현재 : 금오공과대학교 전자공학부 교수 IEEE senior member

관심분야 : 머신러닝, 채널코딩, 이동통신 시스템