멀티센서 카메라 기반의 다중 노출 영상 취득 및 합성 기법

초록

HDR(high dynamic range) 영상 합성은 영상의 동적 범위(dynamic range)를 확장하여 영상의 실제 장면을 디스플레이상에 생생하고 정확하게 재현하기 위해 개발된 기술이다. 본 논문에서는 사일런시 검출(saliency detection)과 채도, 밝기 및 감마 특성을 이용한 멀티센서 카메라 기반 다중 노출 합성 기법을 제안한다. 제안 방법은 영상의 정합 및 합성 두 단계로 구성되며, 기존의 소프트 믹싱(soft mixing)이나 카메라 전달 함수(CRF) 추정 기반의 HDR 알고리즘보다 경계의 분리가 뚜렷하고 휘도와 색 표현력이 우수한 결과 영상을 제공한다. 또한 멀티센서 카메라를 기반으로 경계 노이즈가 없는 영상 정합 및 합성 결과를 시간차 및 시각차 없이 생성할 수 있다. 제안한 방법은 실험결과에서 경계 영역, 어두운 영역의 노이즈, 색 표현에서 기존의 방법보다 우수함을 나타내었다.

Abstract

HDR (High Dynamic Range) image synthesis is a technology developed to vividly and accurately reproduce the actual scene of an image on the display by extending the dynamic range of the image. In this paper, multi-exposure image synthesis technique based on multi-sensor camera using saliency detection, saturation-brightness-gamma characteristics is proposed. The proposed method consists of two stages of alignment and synthesis of images, providing a result image with a clear separation of boundaries and better luminance and color representation than the existing HDR algorithm based on soft mixing or camera transfer function (CRF) estimation. In addition, based on a multi-sensor camera, image matching and synthesis results without boundary noise can be generated without the difference of view angle and capturing time. The proposed method indicates that it is superior to the existing method in boundary lines, dim surround noise, and color expression.

Keywords:

high dynamic range, multi-sensor camera, image blending, homography alignment, saliency detection, saturation mapⅠ. 서 론

일반적으로 인간 시각계의 동적 범위는 약 10,000 nits 정도인데 반해, 기존 디스플레이 장치의 동적 범위는 약 100 nits의 범위를 가져 디스플레이상에 실감영상을 구현하는데 한계가 있다. 이러한 한계를 극복하고, 실제 눈으로 보는 것과 같은 디지털 영상을 구현하기 위해 HDR(High Dynamic Range) 영상 합성 기술이 개발되었다[1]-[4]. HDR 영상 합성 기술은 여러 장의 LDR(Low Dynamic Range) 영상을 적절히 합성하여 더 넓은 시각 밝기 범위를 가지는 영상을 구현할 수 있고, 이를 통해 디스플레이 장치에 실감영상을 구현할 수 있다[3][5].

HDR에 필요한 2장 이상의 LDR 영상들은 동일한 장면을 다른 노출로 여러 번 촬영함으로써 얻을 수 있다. 기존에 Debevec은 5장 이상의 LDR 영상을 통해 추정한 카메라 전달 함수(CRF, Camera Response Function)를 이용한 HDR 알고리즘을 제안하였다[6]. 그러나 Debevec이 제안한 알고리즘은 이중 노출 영상 사용 시 각 RGB 채널의 카메라 전달 함수가 정확하지 않고 이로 인해 색상(Hue)과 화이트 밸런스(White balance)에서 오류가 관찰된다. 또한 레벨 믹싱(Level mixing) 방식의 특성상 객체(Object) 위치이동 발생 시 이중 경계가 발생되고, 블러링(Blurring) 현상이 일어난다. Monobe는 방사 맵(Radiance map)을 이용한 소프트 믹싱(Soft mixing) 방식의 알고리즘을 제안했지만, 레벨 믹싱방식으로 인해 블러링과 노이즈가 맞은편의 노출 영상에 확산 되어 저 대비(Low contrast), 저 채도(Low chromaticity), 색상 이동(Hue shifting)을 일으킨다는 문제점이 있다[7].

본 논문에서는 이러한 한계들을 극복하기 위한 HDR 영상 합성 기법을 제안한다. 먼저 노출이 다른 2장의 LDR 영상(고 노출 영상과 저 노출 영상)의 배경 정보와 세부 정보를 각각 다른 알고리즘으로 합성하기 위해 기저 층(Base layer)과 상세 층(Detail layer)으로 분리한다. 2장의 LDR 영상을 정확히 같은 시각에 얻기 위해 빔 스플리터(Beam splitter)와 CMOS 카메라 2대를 사용해 멀티 센서 카메라를 구현하였다. 이후 2장의 노출 영상에 대해 사일런시 맵(Saliency map)과 채도 맵(Saturation map)을 계산하여 기저 맵 합성을 위한 가중치 맵을 생성한다. 이후 고 노출 영상에 대해 밝기에 따른 국부적 감마 보상을 통한 전처리 과정을 거쳐 두 LDR영상을 합성한다.

제안 방법은 영상 영역의 분리도가 높아 고 노출과 저 노출 영상에서 선명도가 높은 영역에 대해 상대 노출 영상 혼입(Region cross)을 줄이고, 경계 영역 블러링과 어두운 영역의 노이즈 간섭을 감소시켰다. 합성 시 사일런시 맵과 채도 맵을 이용해 가중치 맵을 생성함으로써 각 노출 영상의 중요한 객체에 대한 정보를 유지할 수 있다. 또한, 각 LDR 영상의 색 정보를 보존하여 HDR 영상 합성에 사용하여 색 표현력을 향상시켰다. 멀티센서 카메라를 통해 같은 광 경로의 시각에서 동시에 촬영한 LDR 영상을 얻을 수 있어 촬영 시 이동으로 인한 경계 노이즈 현상이 줄어들었다. 또한 제안 알고리즘을 멀티센서 카메라 시스템에 적용하여 LDR 영상 취득부터 HDR 영상 합성까지의 과정을 하나의 프로세스에서 동작할 수 있도록 하였다.

Ⅱ. 관련 연구

2.1 호모그래피 매칭

영상 처리 분야에서 호모그래피 매칭(Homography matching)이란, 호모그래피 변환을 통해 시점이 다른 두 영상을 동일한 시점을 갖도록 정합하는 것을 의미한다. 이때 호모그래피 변환은 3차원 공간에서 2차원 평면위의 점들을 다른 평면으로 맵핑(Mapping)하는 변환 행렬(Martrix)를 구하고, 이를 이용해 점들을 변환하는 일련의 과정을 의미한다.

| (1) |

여기서 식 (1)은 3차원 공간의 점 (x,y,1)를 (x’,y’,1)로 맵핑하는 호모그래피 변환에 대한 수식이며, H는 호모그래피 행렬을 의미한다. 시점이 다른 두 영상을 호모그래피 정합하기 위해서는 각 영상의 특징점(Key point)을 찾아내고, 이러한 특징점들을 디스크립터(Descriptor)를 통해 매칭하는 과정이 필요하다. 영상의 특징점을 검출 및 매칭하는 기법에는 ORB(Oriented FAST and Rotated BRIEF) 등이 있으며, ORB는 FAST 알고리즘을 통해 특징점을 검출하며 방향 정보를 가진 디스크립터를 통해 두 영상의 정보들을 매칭할 수 있다[8]-[10]. FAST 알고리즘은 영상의 픽셀과 그 주변 픽셀들과의 차이를 통해 특징점을 검출하며, BRIEF 알고리즘은 연산 속도 향상을 위해 디스크립터를 이진화하여 사용한다[11].

2.2 잔여 사일런시 검출

사일런시 검출(Saliency detection)은 영상 속에서 시각적으로 중요하고 두드러지는 객체 또는 영역을 찾아내는 알고리즘이다[12]-[14]. 사일런시 검출 알고리즘을 사용하면 영상의 각 영역에 중요한 객체나 영역이 존재하는 정도 또는 확률을 나타내는 사일런시 맵을 형성할 수 있다[15][16].

우수한 영역 분리도 가지는 잔여(Residual) 사일런시 검출 알고리즘[13]은 영상의 주파수 분석을 통해 배경과 주요 객체를 분리한다. 대체로 영상은 비슷한 주파수 스펙트럼을 가지므로 여러 영상의 주파수 스펙트럼의 평균을 통해 일반적인 경향을 알 수 있고, 이러한 경향과 다른 특징을 보이는 부분을 사일런시 영역으로 간주할 수 있다. 영상은 특징적 부분인 이노베이션 부분(Innovation part), 과 예측 가능한 보편적인 정보를 가진 부분인 사전 정보 부분(Prior knowledge part)으로 구성된다. 따라서 특정 영상에서 사전 정보 부분을 제거함으로써 영상에서 시각적으로 중요한 영역인 이노베이션 부분을 얻어낼 수 있다.

| (2) |

여기서 I는 원 영상을 의미하며 Iinnovation와 Iprior는 각각 영상의 이노베이션 부분과 사전 정보 부분을 의미한다.

잔여 사일런시 검출 알고리즘은 각 영상을 이러한 두 부분으로 분해하기 위해 2D 푸리에 변환을 사용한다. 주파수 도메인에서 복소수의 크기를 분석하면 특정 주파수 성분의 크기나 위상이 입력 신호(영상)에 얼마나 속해있는지 파악할 수 있다[17]. 이후 예측 가능한 주파수 정보를 구하고 이를 통해 중복 구성요소(Redundant component)를 제거함으로써 스펙트럼 잔차(Spectral residual)를 찾아낸다.

마지막으로, 스펙트럼 잔차를 푸리에 역변환(Inverse fourier transform)을 통해 공간 도메인으로 변환함으로써, 영상 내에서 시각적으로 두드러지는 영역에 해당하는 사일런시 맵을 찾아낸다.

Ⅲ. 제안 알고리즘

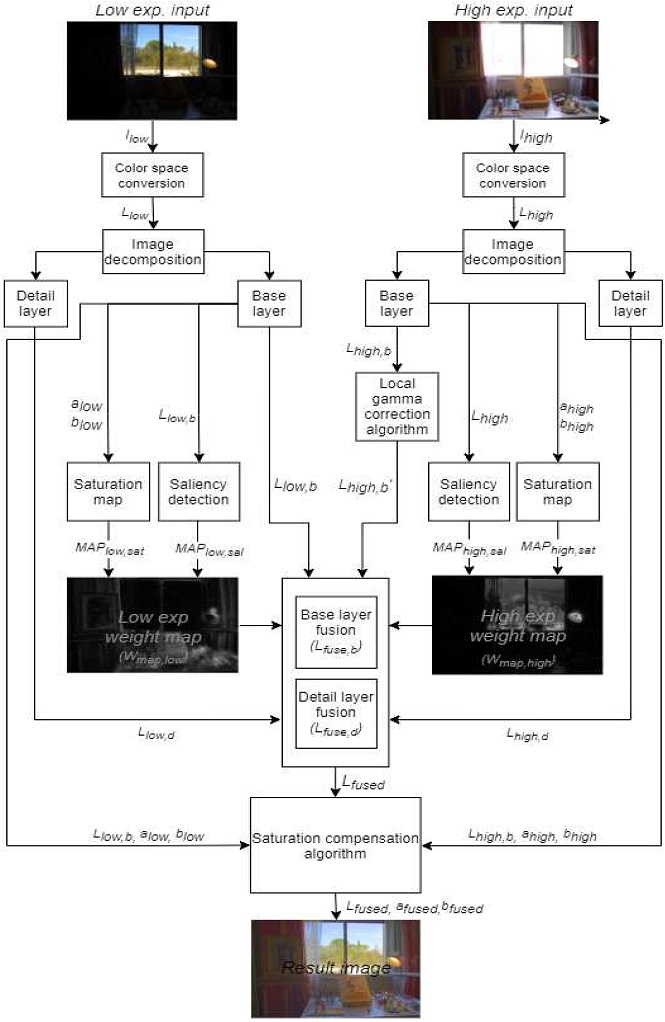

본 논문에서는 멀티센서 카메라 기반 다중 노출 영상 촬영 및 HDR 합성 기법을 제안한다. 그림 1은 제안하는 알고리즘의 단계를 보여준다. 먼저 노출이 다른 2장의 영상은 기저 층과 상세 층으로 분리되고, 기저 영상 및 상세 영상은 사일런시 맵과 채도 맵 등 가중치을 통해 합성된다.

A. 멀티센서 카메라를 이용한 이중 노출 영상 취득

노출이 다른 두 영상을 단일 센서 카메라로 촬영할 경우, 피사체의 이동 등 촬영 환경에 변화가 발생하고 두 영상의 경계가 일치하지 않을 수 있다. 이러한 두 영상을 합성하면 경계 영역에서 고스트(ghost)현상, 이중 경계, 블러링 등 영역 혼입 문제가 발생한다.

경계가 일치하는 이중 노출 사진을 얻기 위해 그림 2와 같이 edmund optics사의 CMOS 카메라 2대로 멀티센서 카메라를 구현해 사용하였다. 두 카메라의 광경로를 동일하게 만들기 위해 3D 프린터를 통해 설계한 전용 카메라 케이스와 빔 스플리터 렌즈를 활용하였다.

B. 호모그래피 매칭을 통한 영상 정합

설계한 멀티센서 카메라는 이상적으로는 입사 광 경로 상에 위치한 빔 스플리터에 의해 각 카메라에 동일한 시점과 시야각의 다중 영상을 얻을 수 있다.

하지만 실제로는 광경로 차이가 발생되고 두 영상간의 정위 오차가 존재하여 경계가 완벽하게 일치하지 않은 영상을 얻게 되므로, 이를 보상하기 위한 정합 알고리즘을 필요로 한다[18]. 광경로 오차 보상을 위해 호모그래피 매칭 기반 정합 알고리즘을 사용하였다[19][20].

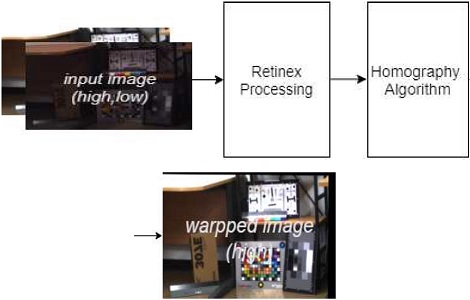

호모그래피 알고리즘은 크게 그림 2와 같이 1) 특징영상 변환처리, 2) 특징점 검출 및 호모그래피 행렬 계산 및 변환의 두 가지 단계로 구성하였다. 먼저 영상의 특징점들을 물체의 형태나 카메라에 시점, 조명 등에 관계없이 정확하게 구하기 위하여 두 영상을 레티넥스(Retinex) 알고리즘을 통해 전 처리하는 과정을 거친다[21]-[23].

이후 ORB 알고리즘을 통해 멀티센서 카메라로 취득한 영상의 특징점을 검출 및 매칭한다. 또한 호모그래피 행렬을 찾아낸 후 영상을 호모그래피 변환한다. 그림 3의 warpped image는 저 노출 영상을 기준으로 한 고 노출 영상의 변환 결과이다. warpped image 바깥쪽의 검은 띠는 영상 정합 시 픽셀들의 맵핑 과정에서 생긴 빈 공간이다.

멀티센서 카메라의 광경로 오차를 보상하기 위한 영상 정합 과정을 거친 후, 아래 그림 3과 같이 색공간 변환(CSC), 영상 분해, 가중치 맵 형성 등의 과정을 거쳐 HDR 영상을 합성한다.

C. 영상 분해

LAB 색 공간의 영상은 색차 채널과 휘도 채널이 분리되어있어 영상의 색 정보와 휘도(luminance) 정보를 독립적으로 처리할 수 있다는 이점이 있다[24][25]. 따라서 LAB 색 공간에서의 L채널과 a, b채널을 독립적으로 합성 및 처리하기 위해 다중 노출 영상을 각각 LAB 색 공간으로 변환한다. 이후 두 LDR 영상의 휘도 채널에 대한 합성 과정을 진행하기 위해 식 (3)-(6)과 같이 각 노출 영상의 휘도 채널을 가우시안 블러(Gaussian blur)를 이용해 기저 층과 상세 층으로 분리한다[26]-[28]. 휘도 채널에 가우시안 블러를 적용하여 기저 층을 얻고, 휘도 채널과 기저 층의 차 영상을 통해 상세 층을 얻는다.

| (3) |

| (4) |

| (5) |

| (6) |

여기서 Lhigh, Llow는 고 노출 및 저 노출 입력 영상의 휘도 채널이다. G(ㆍ)는 가우시안 블러, Lhigh,b, Lhigh,d, Llow,b, Llow,d는 각각 고 노출 영상과 저 노출 영상의 휘도 채널에 대한 기저 층 및 상세 층을 의미한다.

D. 잔여 사일런시 맵 형성

제안 방법은 배경을 제외한 인물, 사물 등 시각적으로 두드러지는 객체들에 대한 합성 우수성을 높이기 위해 잔여 사일런시 검출 알고리즘을 사용하였다. 영상 합성 시 사일런시 맵에 대한 정보를 합성 가중치 맵에 사용하여 주요 객체에 대한 정보를 반영한다면, 합성 영상에서 주요 객체들의 가시성을 향상시킬 수 있으며, 시각적으로 중요한 부분을 선택할 수 있다.

제안 방법에서 휘도 채널이 시각적으로 윤곽인식에 중요한 정보이므로, 두 LDR 영상의 기저 층 휘도 채널을 이용해 사일런시 맵을 형성하고 이를 가중치 맵 생성에 활용하였다.

영상의 휘도 채널은 식 (7)과 같이 이노베이션 부분와 사전 정보 부분으로 구성되어 있다. 먼저 식 (8)-(11)과 같이 고 노출 및 저 노출 영상의 기저 층 대한 휘도 채널을 이산 푸리에 변환(Discrete fourier transform)하여 공간 도메인에서 주파수 영역으로 변환함으로써, 영상을 이노베이션 부분과 사전 정보 부분으로 분해한다.

| (7) |

| (8) |

| (9) |

| (10) |

| (11) |

여기서 F(ㆍ)는 이산 푸리에 변환, , 는 각각 복소수의 실수 및 허수부를 의미한다. Ahigh,b(f), Phigh,b(f)는 고 노출 영상의 기저 층 휘도 채널에 대한 크기 및 위상 스펙트럼을 의미하며, Alow,b(f), Plow,b(f)는 저 노출 영상의 기저 층 휘도 채널에 대한 크기와 위상 스펙트럼을 의미한다.

영상으로부터 사일런시 영역을 분리하는데 사용할 크기 스펙트럼을 시각적으로 더욱 잘 파악할 수 있도록 하고자 아래와 같이 각 노출 영상의 기저 층에 대한 크기 스펙트럼에 로그(Log)를 취한다.

| (12) |

| (13) |

이후 예측 가능한 주파수 정보를 통해 영상 내 주요 객체를 찾아낸다. 주파수 도메인에서의 분석을 통해 이미지에서 중복되는 부분을 제거하기 위해서는 여러 이미지의 로그 스펙트럼의 통계적 유사성에 대해 알고 있어야 한다. 즉, 특정 영상에서 통계적으로 모든 이미지가 공통적으로 가지는 배경 등에 해당하는 로그 스펙트럼을 제거한다면, 해당 영상의 특징적인 부분에 해당하는 로그 스펙트럼만이 남게 된다. 이러한 중복 구성 요소는 통계적인 방법으로 구해질 수 있다. 고 노출 및 저 노출 영상의 휘도 채널에 대한 로그 스펙트럼의 일반적 형태는 아래와 같다.

| (14) |

| (15) |

| (16) |

여기서 H(f)는 로그 스펙트럼의 일반적 형태이고, hn(f)는 n✕n 행렬이다. 이후 로그를 취한 크기 스펙트럼을 로그 스펙트럼의 일반적 형태와 비교하여 스펙트럼 잔차를 찾아낼 수 있다.

로그 스펙트럼의 일반적 형태, H(f)의 지역적 선형성에 착안해 국부 평균 필터인 hn(f)를 사용해 Hhigh,b(f)와 Hlow,b(f)를 근사하여 사용하였다[13].

| (17) |

| (18) |

여기서 Rhigh,b, Hlow,b는 두 LDR 영상의 기저 층 휘도 채널에 대한 스펙트럼 잔차를 의미한다.

마지막으로, 영상에 푸리에 역변환을 적용해 공간 도메인으로 변환함으로써 고 노출 및 저 노출 영상의 기저 층에 대한 사일런시 맵 MAPhigh,sal, MAPlow,sal를 얻는다.

| (19) |

| (20) |

여기서 F-1(ㆍ)는 푸리에 역변환이며 이때 더 나은 시각 효과를 위하여 푸리에 역변환을 적용한 후 σ = 8인 G(ㆍ)(가우시안 블러)를 적용한다.

특정 영역의 사일런시 맵의 값이 크다는 것은 그 영역이 영상에서의 주요 객체부분에 해당하거나 그럴 확률이 높다는 것을 의미한다. 따라서 사일런시 맵을 영상 합성에 필요한 가중치 맵에 반영한다면, 영상에서 시각적으로 중요한 영역에 대해 휘도와 색 표현력이 우수한 HDR 합성 결과를 얻을 수 있다.

E. 채도 맵 형성

합성에 필요한 가중치 맵 형성 시 원 영상의 채도에 대한 정보를 활용한다면, 합성 결과 영상의 색 표현력을 향상할 수 있다. 따라서 고 노출 및 저 노출 기저 층의 LAB 색 공간에서 a채널과 b채널 (ahigh, bhigh alow, blow)을 이용해 채도 맵을 형성하고 이를 가중치 맵에 반영한다. 색차 채널의 특정 픽셀 값의 원점으로부터의 거리가 크다는 것은 해당 픽셀의 채도 정보가 많다는 것을 의미한다고 볼 수 있다. 두 기저 층의 채도 맵을 각 기저 층의 a채널과 b채널의 유클리디안 거리(Euclidean distance)로 정의하였다.

| (21) |

| (22) |

여기서 MAPhigh,sat, MAPlow,sat는 각각 고 노출 영상과 저 노출 영상의 기저 층에 대한 채도 맵을 의미한다. ahigh, bhigh는 각각 고 노출(High exposure) 영상 기저 맵의 LAB 공간에서 a채널과 b채널을 의미하고, alow, blow는 각각 저 노출(Low exposure) 영상의 a채널 b채널의 의미한다. 특정 영역에서 채도 맵의 값이 크다는 것은 그 영역에 채도 정보가 많다는 것을 의미한다.

F. 가중치 맵 형성

서로 다른 두 영상의 합성은 가중 평균을 통해 이루어지며, 각 영상의 가중치를 결정하기 위해서는 가중치 맵이 필요하다[29]. 기저 층 합성을 위한 가중치 맵은 식 (19)-(22)로부터 생성된 각 LDR 영상의 채도 맵과 사일런시 맵의 산술 평균으로 생성된다.

| (23) |

| (24) |

여기서 Wmap은 기저 층 합성에 대한 가중치 맵을 의미하며 MAPsat은 기저 층의 채도 맵, MAPsal은 기저 층의 사일런시 맵을 의미하며 아래 첨자 high, low는 각각 고 노출 영상, 저 노출 영상을 의미한다.

식 (23)-(24)와 같이 채도 맵과 사일런시 맵을 산술 평균하여 가중치 맵을 만든다면, 영상 합성 시 주요 객체 및 채도에 대한 정보들을 보존할 수 있다.

G. 국부 감마 보정(Local gamma correction)

인간의 시각은 밝기에 비선형적으로 응답한다. 디지털 영상 및 이미지 프로세싱 분야에서는 비선형 전달 함수를 통해 이러한 인간의 시각 휘도 특성을 보상하기 위해, 감마보정 알고리즘을 사용한다[30][31]. 감마보정을 적절히 이용하면 빛의 강도를 비선형적으로 변환함으로써 실감 영상을 구현할 수 있다.

HDR 합성 영상의 어두운 부분을 밝게 만듦으로써, 시각적 우수성을 높이기 위해 고 노출 영상의 기저 층에 대해 영상의 밝기 정보에 따라 국부적 감마 보상을 하는 영상 합성 전 처리 과정을 거친다. 고 노출 영상과 저 노출 영상의 기저 층에서 너무 밝거나 어두운 포화 영역(Saturation region)은 가중치를 낮게 하여 합성 시 사용하지 않는 것이 좋고, 포화되지 않은 영역은 가중치를 높여 합성 시 최대한 활용하는 것이 좋다. 이는 고 노출 영상의 과 노출부분인 포화 영역은 더욱 밝아져도 합성 시 사용하지 않으므로, 포화 영역은 더욱 밝아져도 합성 결과에 영향을 미치지 않음을 뜻한다. 따라서 고 노출 영상에 감마 함수(Gamma function)을 적용하면, 포화 영역을 더욱 포화시키며 동시에 상대적으로 어두운 영역을 더욱 밝게 만들 수 있다. 감마 함수를 적용해야할 수준을 결정하는 감마 파라미터(γ-parameter)를 영상의 밝기 정보 등의 특징에 따라 순응적으로 결정하기 위하여 적응적 α파라미터(Adaptive α-parameter)를 정의하였다. 즉, 입력 영상의 밝기 특징에 따라 α값은 달라지며, γ = f(α)의 형태로 정의된다. 따라서 γ값 역시 입력 영상의 밝기 특징에 따라 달라진다. α는 이중 노출 입력 영상에 따라 적응적으로 고 노출 영상이 저 노출 영상에 비하여 밝아졌는지 여부를 판단하는 척도이다.

| (25) |

여기서 histhigh(ㆍ), histlow(ㆍ)는 각각 고 노출 및 저 노출 영상의 인덱스 i에 대한 픽셀의 개수이며, α는 두 LDR 영상의 히스토그램[32]에서 밝기 50%이하(128 이하) 영역의 픽셀 개수의 비로 정의한다.

α값이 크다는 것은 고 노출 영상이 저 노출 영상 대비 여전히 어두운 상태라는 것을 의미하며, 이는 합성 전 고 노출 영상에 감마 보정이 필요함을 뜻한다. α값이 작다는 것은 저 노출 영상에 비해 고 노출 영상의 전체적인 휘도 크기가 증가했음을 의미한다. 따라서 두 입력 영상의 α값이 크다면, 고 노출 영상에 대해 감마 보정을 강하게 적용해야하므로 γ값은 작아져야 한다. 반대로 α값이 작다면 감마 보정을 약하게(γ≃1) 하거나 적용하지 않아야한다. 이중 노출 입력 영상 별로 적응형 파라미터 α 값을 측정했으며, 이에 대해 시각적으로 최적의 γ값을 찾기 위해 γ값을 바꿔가며 반복 실험하였다.

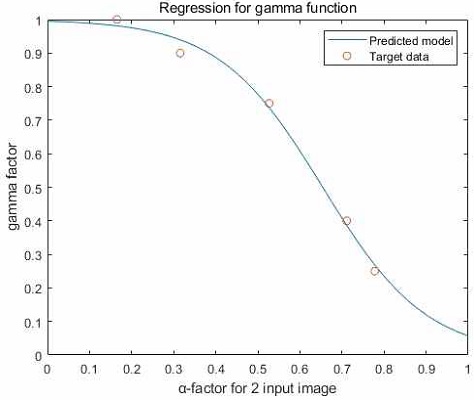

표 1에서 α 값이 작아질수록 γ값이 커지며 이는 감마 보상의 세기가 커짐을 의미한다. 표 1의 데이터 셋을 만족하는 함수의 기본 형태는 시그모이드(Sigmoid) 함수 형태이므로 그림 4와 같이 시그모이드 함수 모델에 대해 적절한 초기 값을 설정한 후 비선형 회귀 분석으로 피팅(Fitting)하여 예측 모델을 찾아냄으로써 입력 영상의 α 값에 따른 γ값을 최적화하였다[33][34].

그림 4와 같이 추정되는 최적 감마값(표 1)에 대한 회귀 분석을 하였으며, 그 결과에 따라 최적 감마 값에 대한 f(α)는 아래와 같이 정의된다.

| (26) |

특정 영역은 과 포화될 것이므로 감마 값은 어두운 영역에만 국부적으로 적용되어야할 것이다. 감마 함수를 영상 내 영역의 밝기가 어두운 부분에만 국부적으로 적용하기 위해 감마 프라임 파라미터(γʹ-parameter)를 아래와 같이 정의하였다.

| (27) |

| (28) |

여기서 bif(ㆍ)는 바이레터럴 필터(Biliteral filter)[28]이며 Lhigh는 고 노출 영상의 휘도 채널이며, 0과 1사이의 범위로 정규화되어 있다. Lhigh,bif는 Lhigh에 바이레터럴 필터를 적용해 생성한 휘도 채널에 대한 기저 층이며 감마 함수를 위한 가중치 맵으로 사용된다.

식 (27)-(28)에 의해 γʹ은 γ와 달리 하나의 정해진 값이 아닌, 각 픽셀의 휘도 값에 대응하는 적절한 감마 값들로 구성된 2차원 배열이 된다. 바이레터럴 필터는 경계 정보를 보존할 수 있으므로 이를 통해 생성 된 기저 층을 가중치 맵으로 사용하면 감마 함수를 국부적으로 적용할 수 있으며 동시에 영역의 경계를 보존함으로써, 경계가 자연스러운 결과를 얻을 수 있다. 식 (28)에서 Lhigh,bif의 특정 픽셀 값이 1에 가까우면 해당 픽셀의 휘도 값이 크다는 의미이며, γ는 1에 가까워지고 감마 보정을 하지 않게 된다. 반대로 Lhigh,bif가 0에 가까우면 해당 픽셀의 휘도 값이 크다는 의미이고 γ는 γʹ에 가까워진다. 이렇게 구한 γ를 통해 고 노출 영상의 기저 층에 국부적이고 경계가 자연스러운 감마 함수를 적용할 수 있고, 고 노출 영상의 어두운 부분을 밝게 만들어 합성 영상의 가시성을 향상시킬 수 있다.

| (29) |

위 식과 같이 감마 보정 된 휘도 채널의 기저 층 Lhigh,bʹ를 Lhigh,b에 감마 함수를 적용한다. 여기서 감마 함수에 쓰이는 γ는 원 영상의 크기와 동일한 2차원 배열이므로 각 픽셀의 밝기에 따라 감마함수의 세기를 달리하게 된다. 이러한 과정을 통해 저 노출 영상과 달리 고 노출 영상에서 더욱 잘 보이는 영역의 가시성을 더욱 극대화할 수 있다.

H. 영상 합성

가중치 맵 생성 및 고 노출 영상에 대한 감마 전처리 과정을 거친 후 영상을 합성하게 된다. 두 LDR 영상의 기저 층은 채도 맵과 사일런시 맵으로 생성한 가중치 맵을 이용하여 합성한다.

| (30) |

| (31) |

여기서 WB는 휘도 채널의 기저 층 합성에 대한 가중치 맵이며, 고 노출 및 저 노출 영상 휘도 채널 각각의 기저 층에 대한 가중치 맵의 차이에 대한 2차원 배열 값들을 [0,1] 범위로 정규화 함으로써 생성된다. Lfused,b는 합성된 휘도 채널 기저 층이며, Lhigh,bʹ는 국부적으로 감마 보정 된 고 노출 영상의 휘도 채널에 대한 기저 층, Llow,b는 저 노출 영상의 휘도 채널에 대한 기저 층이다.

Wmap,high이 Wmap,low보다 크면 WB이 커지고 이는 저 노출 영상에 비해 고 노출 영상에 중요한 객체에 대한 정보와 채도 정보가 많이 있음을 의미한다. 또한 기저 층 합성 시 Bhighʹ의 가중치가 Blow비해 상대적으로 커지는 것을 의미하며 이는 기저 층 합성 시에 고 노출 영상의 기저 층의 정보를 많이 사용하게 됨을 뜻한다. 이와 반대로 Wmap,low가 Wmap,high보다 클 경우에는 1 - WB가 커지고 합성 시 Llow,b의 가중치가 Lhigh,bʹ에 비해 커지게 된다.

휘도 채널의 상세 층은 최대-절대 알고리즘(Max-absolute algorithmn)[15]과 가우시안 블러[26] 맵을 적용하여 합성한다.

| (32) |

| (33) |

여기서 Lhigh,d, Llow,d는 각각 고 노출 영상과 저 노출 영상의 휘도 채널에 대한 상세 층이며, WD, WDʹ는 두 LDR 영상의 휘도 채널 상세 층 합성을 위한 가중치 맵이다.

합성 결과의 연속성을 보장하기 위해 최대-절대 알고리즘을 사용한 후 가우시안 블러 맵을 적용해 가중치 맵을 생성하였다. 휘도 채널 상세 층의 합성은 다음식과 같이 이루어진다.

| (34) |

여기서 Lfused,d는 합성 된 휘도 채널 상세 층이다. 마지막으로 휘도 채널의 합성 된 기저 층과 상세 층을 덧셈 연산하여 최종 합성 휘도 영상을 생성한다.

| (35) |

여기서 Lfused는 최종 합성된 휘도 채널이며 Lfused,b, Lfused,d는 각각 합성 된 휘도 채널의 기저 층 및 상세 층이다.

I. 채도 보상

두 LDR 영상의 휘도 채널에 대한 합성 과정을 거친 후, 최종 합성된 색차 채널인 afused, bfused는 채도 보상(Saturation compensation)[35]의 과정을 거쳐 생성된다. 채도 보상 알고리즘은 식 (36)-식 (42)와 같이 고 노출 및 저 노출 입력 영상의 채도 맵과 LAB 공간에서의 색차 성분인 (ahigh, bhigh),(alow, blow) 그리고 입력 영상의 기저 층에 대한 휘도 채널 Lhigh,b ,Llow,b와 최종 합성 된 휘도 채널 Lfused 값들을 반영하여 이루어진다.

| (36) |

| (37) |

| (38) |

| (39) |

여기서 ahigh, bhigh 및 alow, blow는 각각 고 노출 영상의 색차성분(a,b)과 저 노출의 색차성분이고, Ahigh, Alow 는 고 노출 및 저 노출 영상의 채도 보상을 위한 휘도 변동 비율 값이다. 먼저 식 (36) 및 식 (37)처럼 원본 고 노출 및 저 노출 영상 휘도 채널에 대한 합성 휘도 채널의 비(이득) Ahigh, Alow를 구한다. 분모의 0.001은 Lhigh가 0이 될 경우 식이 수렴하지 않기 때문에 추가한 상수이다. 시각적 관점에서 휘도가 채도에 미치는 영향을 생각해보면, 휘도 성분의 크기가 크거나 작아져 영상이 밝거나 어두워질수록 채도 성분의 크기는 상대적으로 작아지게 된다. 이는 인간의 시각계가 너무 밝거나 어두운 곳에 있는 물체의 색깔을 인지하기 어려운 것과 같은 원리이다. 따라서 채도 보상을 위해 고 노출 및 저 노출 입력 영상의 LAB 공간에서의 휘도 채널과 식 (35)에서 합성된 결과 영상의 휘도 채널의 값의 비를 이용해 채도를 보상한다. 고 노출 입력 영상의 휘도 채널, Lhigh에 비해서 합성 영상의 휘도 채널, Lfused의 값이 커진 정도(Ahigh)에 비례하여 ahigh, bhigh를 ahighʹ, bhighʹ에 반영하게 된다. ahighʹ, bhighʹ는 아래 식 (41)-(42)와 같은 과정들을 거쳐 최종 색성분인 afused, bfused에 반영된다.

| (40) |

| (41) |

| (42) |

채도 보상 시, 특정 픽셀에서 고 노출 영상의 저 노출 영상에 비해 채도 값이 크다면, 해당 픽셀에서는 고 노출 영상의 색차 성분인 ahigh, bhigh를 결과 영상 픽셀의 채도 성분에 많이 반영해야 한다. 그 반대의 경우에는 저 노출 영상의 색차 성분인 alow, blow를 결과 영상 픽셀의 채도 성분에 많이 반영해야 한다. 이와 같은 채도 보상을 모든 2차원 배열에 대해 수행하기 위해 식(40)과 같이 고 노출 영상의 채도 맵과 저 노출 영상의 채도 맵의 차이 값들로 구성된 2차원 매트릭스인 채도 차이 맵(Saturation difference map) MAPsat,diff를 구하였다. 최종적으로 식 (41) 및 식 (42)에서 ahighʹ, bhighʹ는 MAPsat,diff에 비례하여, alowʹ, blowʹ는 1 - MAPsat,diff에 비례하여 ahighʹ, bhighʹ에 반영하는 방식으로 채도를 보상하게 되고, 이러한 과정을 통해 최종 합성 영상의 색차 성분에 해당하는 afused, bfused를 생성하게 된다.

Ⅳ. 실험 결과

제안 합성 기법의 성능 평가를 위해, 다양한 실내외의 고 노출 및 저 노출 영상을 실험에 사용하였다. 또한 LDR 영상의 취득 및 호모그래피 정합부터 HDR 합성까지의 결과를 평가하고자 edmund optics사의 CMOS 카메라를 통해 구현한 멀티 센서 카메라를 통해 직접 촬영한 영상도 사용하였다. HDR 합성 효과를 극대화하기 위해서 밝기 차이가 큰 이중 노출 영상을 사용하였다. 또한 기존의 카메라 전달 함수(CRF) 추정 기반의 합성 방식[6]과 방사맵 및 소프트 믹싱[7] 방식과 동일한 환경 및 조건에서 비교 평가하고자 소프트 믹싱 방식인 Monobe 합성 기법 결과와 CRF 추정 방식의 Debevec 합성 기법 결과를 iCAM06[36]으로 후 처리하였다. 아래는 입력 및 결과 영상과 이에 대한 HDR 합성 결과 영상들을 보여준다.

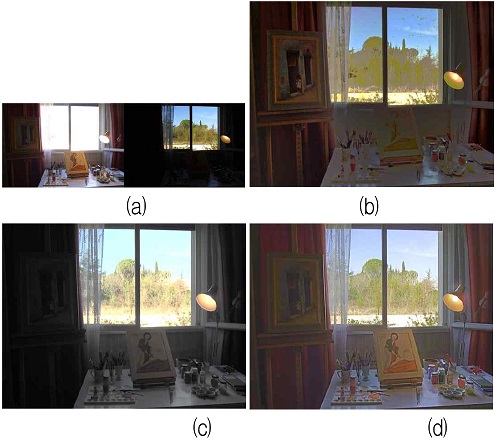

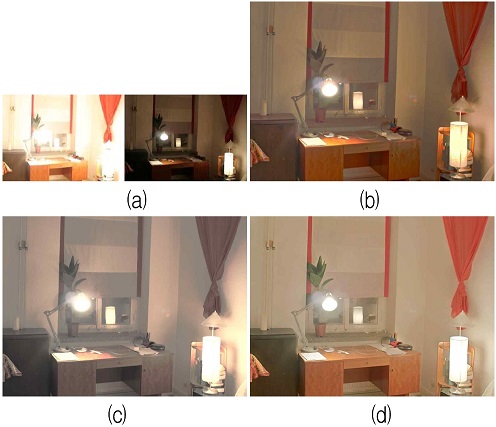

그림 5에서 Debevec의 합성 기법(b)은 과 채도 보상으로 인해 색 표현이 어색하다. 특히 실내 책상 위 물체들과 창밖의 나무 등의 디테일 및 색상 정보가 많이 손상되었다. Monobe 합성 기법(c)는 커튼 및 실내 부분이 여전히 어두워 가시성이 확보되지 않으며, 역시 실외 하늘의 색상 합성 결과가 어색하다. 제안 방법 결과(d)는 실내외의 휘도의 적절한 합성으로 톤 압축이 잘 되었고 실내 커튼 등이 어둡지 않아 높은 가시성을 보인다. 또한 색상이나 화이트 밸런스에서도 오류가 관찰되지 않는다. 실내외 나무 및 물체들의 디테일 정보 역시 보존된다.

Input and result images: (a) High exp. and Low exp. input image, (b) debevec method, (c) monobe method, and (d) proposed method.

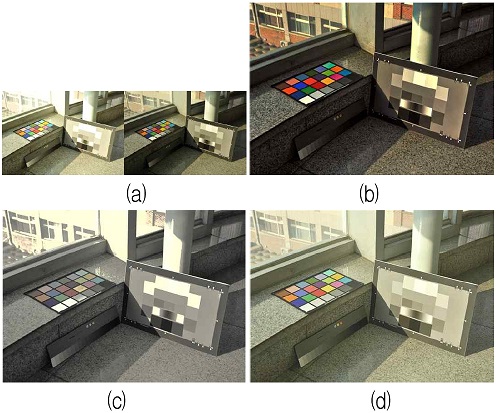

그림 6에서 Debevec의 합성 기법(b)은 합성 시 고 노출 영상의 밝은 부분이 적절히 합성되지 못하여 창문 실내 테두리의 벽돌 부분이 여전히 어둡고, 디테일 정보의 확인이 어렵다.

Input and result images: (a) High exp. and Low exp. input image, (b) debevec method, (c) monobe method, and (d) proposed method.

Monobe 합성 기법(c) 역시 실내 테두리 부분이 여전히 어둡다. 또한 창문의 색상 합성이 적절히 이루어지지 못하여 색 표현력이 떨어진다. 제안 방법 결과(d)는 고 노출 및 저 노출 영상의 밝기 정보를 적절히 합성하였고, 영상의 창문부분의 색상 및 휘도 표현력이 우수하다.

창문뿐만 아니라 실내 테두리 부분 등 영상 내 모든 부분이 잘 보이도록 하였다. 이는 제안 방법이 합성 시 고 노출 및 저 노출 영상 각각의 강점이 되는 채도, 휘도 등의 정보들을 잘 활용하였음을 의미한다.

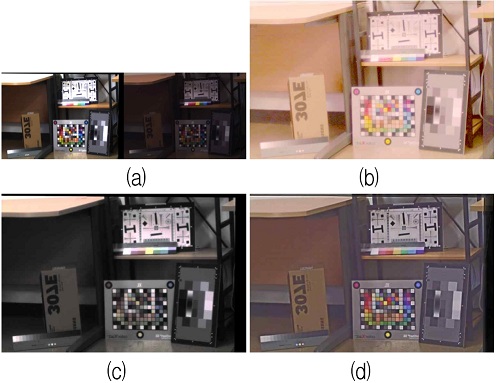

그림 7에서 Debevec의 합성 기법(b)와 Monobe 합성 기법(c)는 물체에 의해 그림자가 있는 부분이 어두워 잘 보이지 않는다. 특히 Monobe기법 결과는 창밖의 건물과 창문이 있는 영역의 휘도 표현이 제대로 되지 못했고, 그레이 컬러판의 밝기가 잘 구분되지 않는다. 제안 방법 결과(d)는 휘도 정보를 적절히 합성하여 톤 압축이 잘 되었고 컬러판의 색깔 역시 구분이 잘된다. 감마 전처리를 통해 음영이 있는 부분의 가시성 역시 우수하다.

Input and result images: (a) High exp. and Low exp. input image, (b) debevec method, (c) monobe method, and (d) proposed method.

그림 8에서 Debevec의 합성 기법(b)와 Monobe 합성 기법(c)는 합성 결과가 여전히 어둡다. 특히 Monobe 기법의 결과는 영상의 색 표현력도 현저히 떨어진다. 반면 제안 방법 결과(d)는 영상의 채도맵과 사일런시 맵을 기반으로 휘도와 채도 정보를 적절히 합성하였고, 그 결과 휘도 표현이 적절하고, 색 표현 역시 우수하다.

Input and result images: (a) High exp. and Low exp. input image, (b) debevec method, (c) monobe method, and (d) proposed method.

그림 9는 Edmund사의 CMOS 카메라 2대를 기반으로 직접 설계한 멀티 센서 카메라를 통해 취득한 영상의 정합 및 합성 결과이다. 여기서 Debevec의 합성 기법(b)은 다중 노출 사진수의 부족으로 잘못된 CRF를 추정하였고, 이로 인해 화이트 밸런스 오류가 관찰된다. Monobe 합성 기법(c)는 책상 아래와 컬러 및 그레이 인식판 등이 여전히 어둡고 잘 보이지 않지만, 제안 방법 결과(d)는 책상 아래 및 인식판 등에서 모두 우수한 가시성을 보여주며 화이트 밸런스 오류가 관찰되지 않는다.

Input and result images: (a) High exp. and Low exp. input image, (b) debevec method, (c) monobe method, and (d) proposed method.

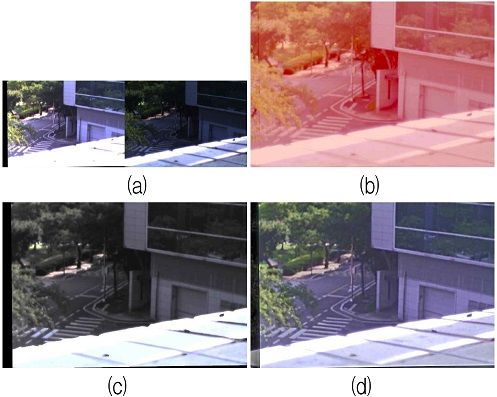

그림 10 역시 Edmund사의 CMOS 카메라 2대를 기반으로 직접 설계한 멀티 센서 카메라를 통해 취득한 영상의 정합 및 합성 결과이다. 여기서 Debevec의 합성 기법(b)은 카메라 전달함수를 잘못 추정하여 화이트 밸런스 오류가 관찰되며, Monobe 합성 기법(c)는 실외 도로 부분이 여전히 어둡다. 제안 방법 결과(d)는 영상의 모든 부분의 가시성이 우수하며, 화이트 밸런스 오류가 관찰되지 않는다.

Input and result images: (a) High exp. and Low exp. input image, (b) debevec method, (c) monobe method, and (d) proposed method.

제안 방법은 높은 영역 분리도를 통해 기존 방법의 노이즈 문제와 경계 혼입(Edge cross) 문제 및 영역 혼입 문제를 개선하였다. 특히 멀티센서 카메라를 통해 같은 시각에 촬영한 LDR 영상을 호모그래피 변환함으로써 피사체의 이동 등의 상황에도 정합된 영상을 획득하여 HDR 합성할 수 있다. 또한 가중치 맵으로 사용한 채도 맵과 사일런시 맵으로 인해 결과 영상의 색상과 가시성을 개선하였으며, 주요 객체에 대한 휘도 및 색 정보를 보존하였다. 기존 방식은 경계에서의 블러링 현상이 존재하며, 저 노출 낮은 계조 신호의 혼입이 크다. 또한 제안 방법은 영상의 밝기 및 채도 정보에 따라 순응적으로 적절하게 HDR 합성함으로써 색 표현력과 저 레벨 노이즈 저감에서 우수함을 확인하였다. 단, 그림 9와 그림 10에서 확인되듯이 제안된 다중 노출 취득 장치의 두 이미지센서의 얼라인먼트(Alignment) 조정에 어려움이 있으며 영상 가장자리의 정보 손실이 발생되는 단점이 있다.

Ⅴ. 결 론

본 논문에서는 멀티센서 카메라 기반 사일런시 검출과 채도 및 밝기 특성을 이용한 HDR 영상 합성 기법을 제안하였다. 제안 방법은 동적 범위가 낮은 이중 노출 영상을 사일런시 검출과 채도 및 휘도 정보를 반영해 합성함으로써 색 표현 및 휘도 표현이 우수한 영상을 제공한다. 또한 휘도 변동에 대한 채도 보상과 시각의 비선형적인 감마 특성을 이용한 국부 감마 보정 및 채도 보상을 통하여 시인성을 최적화 하였다.

최종적으로 구현한 멀티센서 카메라시스템에 알고리즘을 적용하여 같은 시각의 다중 영상 촬영, 영상 정합 및 HDR 합성 결과를 얻을 수 있다. 제안 방법을 FPGA, 마이크로 프로세서, 로봇, CCTV[37] 등의 분야에 활용한다면 멀티센서 카메라를 통해 높은 품질의 HDR 영상을 얻을 수 있을 것으로 기대한다.

Acknowledgments

이 논문은 2019년도 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 기초연구사업임 (NRF-2019R1D1A3A03020225)

References

- S. K. Nayar and T. Mitsunaga, "High dynamic range imaging: spatially varying pixel exposures", Proceedings IEEE Conference on Computer Vision and Pattern Recognition. CVPR 2000 (Cat. No.PR00662), Vol. 1, pp. 472–479, Jun. 2000.

-

Zheng Guo Li, Jing Hong Zheng, and S. Rahardja, "Detail-enhanced exposure fusion", IEEE Trans. Image Process., Vol. 21, No. 11, pp. 4672–4676, Nov. 2012.

[https://doi.org/10.1109/TIP.2012.2207396]

-

T. Jinno and M. Okuda, "Multiple exposure fusion for high dynamic range image acquisition", IEEE Trans. Image Process., Vol. 21, No. 1, pp. 358-365, Jan. 2012.

[https://doi.org/10.1109/TIP.2011.2160953]

-

J. Jung and Y. Ho, "Low‐bit depth‐high‐dynamic range image generation by blending differently exposed images", IET Image Process., Vol. 7, No. 6, pp. 606–615, Aug. 2013.

[https://doi.org/10.1049/iet-ipr.2012.0614]

- J. An, S. H. Lee, J. G. Kuk, and N. I. Cho, "A multi-exposure image fusion algorithm without ghost effect" ICASSP, IEEE International Conference on Acoustics, Speech and Signal Processing, pp. 1565-1568, May 2011.

-

P. E. Debevec and J. Malik, "Recovering high dynamic range radiance maps from photographs", ACM SIGGRAPH 2008 classes on - SIGGRAPH’08, No. 31, pp. 1-10, Aug. 2008.

[https://doi.org/10.1145/1401132.1401174]

-

Y. Monobe, H. Yamashita, T. Kurosawa, and H. Kotera, "Dynamic range compression preserving local image contrast for digital video camera", IEEE Trans. Consum. Electron., Vol. 51, No. 1, pp. 1–10, Feb. 2005.

[https://doi.org/10.1109/TCE.2005.1405691]

-

M. Wang, S. Niu, and X. Yang, "A novel panoramic image stitching algorithm based on ORB", 2017 International Conference on Applied System Innovation (ICASI), pp. 818–821, May 2017.

[https://doi.org/10.1109/ICASI.2017.7988559]

-

E. Rublee, V. Rabaud, K. Konolige, and G. Bradski, "ORB: An efficient alternative to SIFT or SURF", 2011 International Conference on Computer Vision, pp. 2564–2571, Nov. 2011.

[https://doi.org/10.1109/ICCV.2011.6126544]

-

E. Rosten and T. Drummond, "Machine learning for high-speed corner detection", in Lecture Notes in Computer Science, Graz, Austria, pp. 430–443, May 2006.

[https://doi.org/10.1007/11744023_34]

-

M. Calonder, V. Lepetit, C. Strecha, and P. Fua, "BRIEF: Binary robust independent elementary features", in Lecture Notes in Computer Science, Crete, Greece, pp. 778–792, Sep. 2010.

[https://doi.org/10.1007/978-3-642-15561-1_56]

-

S. Goferman, L. Zelnik-Manor, and A. Tal, "Context-aware saliency detection", IEEE Trans. Pattern Anal. Mach. Intell., Vol. 34, No. 10, pp. 1915–1926, Oct. 2012.

[https://doi.org/10.1109/TPAMI.2011.272]

-

X. Hou and L. Zhang, "Saliency detection: A spectral residual approach", 2007 IEEE Conference on Computer Vision and Pattern Recognition, Minneapolis, MN, USA, pp. 1–8, Jun. 2007.

[https://doi.org/10.1109/CVPR.2007.383267]

-

Q. Yan, L. Xu, J. Shi, and J. Jia, "Hierarchical saliency detection", 2013 IEEE Conference on Computer Vision and Pattern Recognition, Portland, Oregon., pp. 1155–1162, Jun. 2013.

[https://doi.org/10.1109/CVPR.2013.153]

-

J. Ma, Z. Zhou, B. Wang, and H. Zong, "Infrared and visible image fusion based on visual saliency map and weighted least square optimization", Infrared Phys. Technol., Vol. 82, pp. 8–17, May 2017.

[https://doi.org/10.1016/j.infrared.2017.02.005]

- Y. H. An, H. Ju. Kwon, and S. H. Lee, "Multi-exposure image synthesis technique based on saliency detection and saturation-brightness characteristics using a multi-sensor camera", Proceedings of KIIT Conference, pp. 186-192, Oct. 2020.

-

H. J. Nussbaumer, "Fast fourier transform and convolution algorithms", Springer Berlin Heidelberg, 1981.

[https://doi.org/10.1007/978-3-662-00551-4]

- M. Irani and P. Anandan, "Robust multi-sensor image alignment", Sixth International Conference on Computer Vision (IEEE Cat. No.98CH36271), pp. 959-966, Jan. 1998.

- J. J. Lee and G. Kim, "Robust estimation of camera homography using fuzzy RANSAC", in Computational Science and Its Applications – ICCSA 2007, Springer Berlin Heidelberg, pp. 992–1002, 2007.

-

T. Watanabe, T. Kamai, and T. Ishimaru, "Robust estimation of camera homography by fuzzy RANSAC algorithm with reinforcement learning", J. Adv. Comput. Intell. Intell. Informatics, Vol. 19, No. 6, pp. 833–842, Nov. 2015.

[https://doi.org/10.20965/jaciii.2015.p0833]

-

Wen Wang, Bo Li, Jin Zheng, Shu Xian, and Jing Wang, "A fast multi-scale retinex algorithm for color image enhancement", 2008 International Conference on Wavelet Analysis and Pattern Recognition, pp. 80–85, Aug. 2008.

[https://doi.org/10.1109/ICWAPR.2008.4635754]

-

E. H. Land and J. J. McCann, "Lightness and retinex theory", J. Opt. Soc. Am., Vol. 61, No. 1, pp. 1-11, Jan. 1971.

[https://doi.org/10.1364/JOSA.61.000001]

-

D. J. Jobson, Z. Rahman, and G. A. Woodell, "Properties and performance of a center/surround retinex", IEEE Trans. Image Process., Vol. 6, No. 3, pp. 451–462, Mar. 1997.

[https://doi.org/10.1109/83.557356]

-

P. J. Baldevbhai, "Color Image segmentation for medical images using L*a*b* color space", IOSR J. Electron. Commun. Eng., Vol. 1, No. 2, pp. 24–45, 2012.

[https://doi.org/10.9790/2834-0122445]

-

S. Bansal and D. Aggarwal, "Color image segmentation using CIELab color space using ant colony optimization", Int. J. Comput. Appl., Vol. 29, No. 9, pp. 28–34, Sep. 2011.

[https://doi.org/10.5120/3590-4978]

- E. S. Gedraite and M. Hadad, "Investigation on the effect of a Gaussian blur in image filtering and segmentation", Proceedings Elmar - International Symposium Electronics in Marine, pp. 393-396, Sept. 2011.

-

W. Tan, H. Zhou, J. Song, H. Li, Y. Yu, and J. Du, "Infrared and visible image perceptive fusion through multi-level Gaussian curvature filtering image decomposition", Appl. Opt., Vol. 58, No. 12, pp. 3064-3073, Apr. 2019.

[https://doi.org/10.1364/AO.58.003064]

-

Z. Zhou, B. Wang, S. Li, and M. Dong, "Perceptual fusion of infrared and visible images through a hybrid multi-scale decomposition with Gaussian and bilateral filters", Inf. Fusion, Vol. 30, pp. 15-26, Jul. 2016.

[https://doi.org/10.1016/j.inffus.2015.11.003]

-

A. V. Vanmali and V. M. Gadre, "Visible and NIR image fusion using weight-map-guided Laplacian–Gaussian pyramid for improving scene visibility", Sādhanā, Vol. 42, No. 7, pp. 1063–1082, Jul. 2017.

[https://doi.org/10.1007/s12046-017-0673-1]

-

H. Farid, "Blind inverse gamma correction", IEEE Trans. Image Process., Vol. 10, No. 10, pp. 1428–1433, Oct. 2001.

[https://doi.org/10.1109/83.951529]

-

S. C. Huang, F. C. Cheng, and Y. S. Chiu, "Efficient contrast enhancement using adaptive gamma correction with weighting distribution", IEEE Trans. Image Process., Vol. 22, No. 3, pp. 1032-1041, Mar. 2013.

[https://doi.org/10.1109/TIP.2012.2226047]

-

S. M. Pizer, E. P. Amburn, J. D. Austin, R. Cromartie, A. Geselowitz, T. Greer, B. ter Haar Romeny, J. B. Zimmerman, and K. Zuiderveld, "Adaptive histogram equalization and its variations", Comput. Vision, Graph. Image Process., Vol. 39, No. 3, pp. 355-368, Sep. 1987.

[https://doi.org/10.1016/S0734-189X(87)80186-X]

-

D. M. Bates and D. G. Watts, "Nonlinear regression analysis and its applications", Wiley, 1988.

[https://doi.org/10.1002/9780470316757]

- L. G. Grimm and P. R. Yarnold, "Reading and understanding multivariate statistics", American Psychological Association, 1995.

-

S. C. Su, "Efficient intensity-hue-saturation-based image fusion with saturation compensation", Opt. Eng., Vol. 40, No. 5, pp. 720-728, May 2001.

[https://doi.org/10.1117/1.1355956]

-

J. Kuang, G. M. Johnson, and M. D. Fairchild, "iCAM06: A refined image appearance model for HDR image rendering", J. Vis. Commun. Image Represent., Vol. 18, No. 5, pp. 406–414, Oct. 2007.

[https://doi.org/10.1016/j.jvcir.2007.06.003]

-

Su-Bong Ryu and Min-Sup Kang, "Implementation of Image Security System for CCTV Using Analysis Technique of Color Informations", JIIBC, Vol. 12, No. 5, pp. 219–227, Oct. 2012.

[https://doi.org/10.7236/JIWIT.2012.12.5.219]

2015년 3월 ~ 현재 : 경북대학교 IT대학 전자공학부 학부생

관심분야 : HDR, Machine Learning, Object detection, 영상 처리, 이미지 센서, 아날로그 회로, 디지털 회로

2010년 2월 : 경북대학교 전자전기 컴퓨터학부(공학사)

2012년 2월 : 경북대학교 전자전기컴퓨터학부(공학석사)

2017년 9월 : 경북대학교 전자공학부(박사후 연구원)

2019년 8월 : 아진산업 선행연구팀 연구원

2019년 8월 ~ 현재 : 경북대학교 전자공학부 계약교수

관심분야 : Color Image Processing, Color Management HDR 영상처리, 적외선 영상처리, 인공지능

1997년 2월 : 경북대학교 전자공학과(공학사)

1999년 2월 : 경북대학교 전자공학과(공학석사)

1999년 2월 ~ 2004년 6월 : LG전자 영상제품연구소 선임연구원

2008년 2월 : 경북대학교 전자공학과(공학박사)

2009년 8월 ~ 2017년 7월 : 경북대학교 IT대학 전자공학부 연구초빙교수

2018년 3월 ~ 현재 : 경북대학교 IT대학 전자공학부 교수

관심분야 : Color Image Processing, Color Appearance Model, Color Management, HDR 영상처리, 영상융합, 딥러닝영상처리